立体视差调整的快速估计方法

2013-06-01侯春萍

岳 斌,侯春萍

(天津大学电子信息工程学院,天津 300072)

立体视差调整的快速估计方法

岳 斌,侯春萍

(天津大学电子信息工程学院,天津 300072)

立体图像的视差调整多用于会聚调节和视差校正.为准确地计算出立体图像视差调整量的取值范围,建立了立体视差调整的快速估计方法.算法首先将人类立体视觉的Panum融合区应用于立体显示空间,给出计算立体显示屏幕Panum融合区的方法,然后推导出立体显示屏幕Panum融合区对视差调整量的限定,最后通过对立体图像深度线索的稀疏匹配快速估计出Panum融合区限定下视差调整量的适用范围.经实验验证,本方法可以快速、准确地得到视差调整量的适用范围,最大限度地避免立体图像中出现双眼复视的情况.

视差调整;Panum融合区;图像分割;特征提取;特征点匹配

近年来随着立体技术的持续火热,立体显示和立体编码两方面的研究已经取得了许多重大成果.立体显示方面,目前市场上应用最多的视差式立体显示设备可以提供较好的立体效果,让人们能够体验近乎真实的立体影像.立体编码方面,通过众多视频编码专家的努力工作,已经建立起多视点视频编码(multiview video coding,MVC)标准[1].MVC标准可以使立体节目在较大压缩比下仍保持良好的效果.在立体显示技术和立体编码技术快速发展并不断取得进步的同时,立体节目的匮乏变成了影响立体产业快速发展的一块短板,其质量的好坏对观看舒适度有着较大的影响.

立体节目可以通过电脑绘制、2,D转3,D、双(多)相机拍摄和深度相机拍摄等多种方式获取.笔者仅讨论由最基本的双视点立体相机获取的立体节目视差调整问题.双视点摄像系统是模拟人类视觉系统用两只眼睛从自然界真实三维景物中获取信息的方式,通过使用在水平方向上相隔一定距离的两部相机(与左、右眼相对应,分别称为左视点相机和右视点相机),来实现对三维场景即拍摄空间信息的采集和记录.根据两部相机光轴交点位置不同,可将立体信息采集系统分为不同配置模式.如果光轴交于相机镜头前方,称为会聚配置模式[2](convergence configuration);如果光轴夹角为零,即两部相机的光轴平行,称为平行配置模式(parallel configuration).

将会聚配置模式和平行配置模式进行比较,会聚配置模式拍摄的节目具有同时存在交叉视差和非交叉视差(即同时具有2个方向的深度)的优点,但也有深度平面弯曲失真[3]和梯形失真[4-5]的缺点;平行配置模式拍摄的节目虽然没有上述2种失真,但是只存在单一方向的视差,即或者只有交叉视差(凸出屏幕方向的深度),或者只有非交叉视差(凹进屏幕方向的深度),深度表现范围较会聚配置模式小.平行配置模式和会聚配置模式各有优劣.在实际应用中,平行配置模式因其易于实现、调整简单等优点而被广泛采用.

立体视差调整可以改善平行配置模式拍摄的节目只存在一个方向深度的缺点,使经过调整的立体节目同时存在交叉视差和非交叉视差,形成等效会聚.立体视差调整需要限定范围,不恰当的视差调整量可能会使立体节目在观看时产生部分景物无法融合、出现重影等现象,因此在视差调整前必须计算好视差调整量的范围.笔者提出了一种立体视差调整的快速估计算法,使用这种算法可以快速准确地算出视差调整量的范围,经过算法调整的立体节目可以较舒适地融合,从而获得较好的立体观看效果.

1 平行配置模式立体视差调整的基本方法

平行配置模式立体视差调整主要有2种方法:一种是实时获取的离轴平行法,主要用于视差的会聚调整;另一种是后处理的视差平移调整法,该方法既可用于视差的会聚调整,也可以用于视差的舒适量调整,即视差校正.

离轴平行法[6]采用一种特殊结构的立体相机系统,结构模型如图1所示.这种系统的两部相机的光轴相对(charge-coupled device,CCD)成像面中心在水平方向上有一定的偏移量.在拍摄时,两部相机控制各自的CCD成像面中心,使相对应的相机光心的连线相交于一点,形成等效会聚.这种方法通过硬件来实现平行配置摄像系统的视差会聚调整,其主要缺点是对相机本身提出了特殊要求,操作复杂,价格昂贵,不具有普遍适用性.

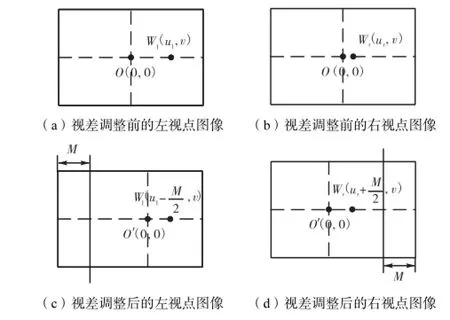

视差平移调整法是对已获取的立体图像进行视差调整,利用图像处理方法完成,本文所做的研究都是针对此方法.视差平移调整通常的做法是先确定视差调整量,再根据调整量对不同视点的图像进行剪切、平移处理,达到视差会聚调整和视差校正的目的.图2以两视点立体图像为例说明视差平移调整过程.首先确定视差调整量M,然后将左视点图像左侧宽度为M的一部分图像剪切掉,同时将右视点图像右侧宽度也为M的一部分图像剪切掉,最后将处理后的左、右视点图像平移对齐,生成新的立体图像对.Wl( ul, v)、Wr( ur, v)分别为左、右视点图像中的一对对应点,在视差调整前以各自视点图像中心O为原点的坐标系中横坐标分别为ul和ur,水平视差为ul-ur.在视差调整后的新左、右视点图像中以图像中心O′为原点生成新坐标系,Wl和Wr的横坐标分别变为ul-M/2和ur+M/2,水平视差变为ul-ur-M.通过视差平移调整法,左、右视点图像对应点的视差减小M.

图1 离轴平行相机模型Fig.1 Horizontal-moving stereoscopic camera model

图2 视差平移调整法Fig.2 Disparity parallel moving adjustment metho d

尽管视差平移调整法使立体图像在水平方向上损失了一部分信息,但损失的信息对立体图像视场影响不大.因为首先如图3所示,平行配置的双视点相机存在同时可视区(图3中阴影部分)和非同时可视区(图3中非阴影部分),左视点图像左侧和右视点图像右侧各有一部分区域无法在另一视点图像中找到对应.视差平移调整法剪切掉的区域包括对立体感没有贡献的非同时可视区;其次视差调整量M通常取值较小,剪切掉的部分相对整幅图像的视场只占很小一部分.

图3 平行配置双视点相机视区Fig.3 Visual area of parallel configuration stereoscopic camera

2 Panum融合区界定的视差调整范围

视差平移调整法如果没有选取适当的视差调整量M,会使立体图像中某些景物的视差过大,在观看时无法融合成一个单一的像,形成双眼复视.为了最大限度地避免这种现象,需要引入Panum融合区对视差调整量M进行限定.

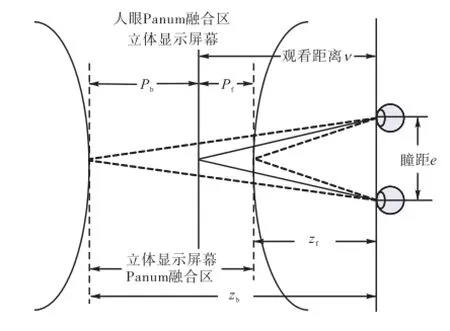

一般而言,双眼复视和双眼单视与人类立体视觉基本机理[7]有关.视觉生理学指出,在双眼注视点上的物体,其刺激作用到双眼视网膜的对应点上,产生单一的像;注视点附近一定范围的物体,尽管没有刺激到双眼视网膜的对应点上,也可以形成单像.但这时如果某物体与注视点的距离超出一定范围则无法融合成单像,只会观察到双像.这一现象是Panum发现并提出的[8].如图4所示,在注视点周围可以形成单像的区域被称为Panum融合区(Panum's fusional area).在Panum融合区内的物体均能形成双眼单视,超出Panum融合区的物体则会形成双眼复视.

图4 Panum融合区Fig.4 Panum’s fusional area

当人们在观看立体显示屏幕上的节目时,双眼的注视点在屏幕上.通常注视点不是固定在屏幕上一点,而是随着节目中的景物在屏幕上移动,所以立体显示屏幕上的Panum融合区不能定义为如图4所示的马鞍形区域,而应该定义成如图5虚线所示的、以前后2条直线为界的区域,这样定义立体显示屏幕的Panum融合区,即使注视点在屏幕边缘时仍然能保证Panum融合区的准确性.

文献[9]测量出人眼Panum融合区的水平视差界,文中用视差角θ 来表示Panum融合区界.一般情况(短时间观察获得双眼单视)稳定情况(长时间观察获得双眼单视)因为观看立体节目是一个长时间持续的活动,所以为了保证在观看时间内都能形成双眼单视,Panum融合区的水平视差界取θ=±42.

图5 立体显示屏幕的Panum融合区Fig.5 Panum’s fusional area of stereo screen

如图5所示,可分别计算出人眼分别与立体显示屏幕Panum融合区前界和后界的距离fz和bz,即

Panum融合区前界与屏幕之间的距离Pf和Panum融合区后界与屏幕之间的距离Pb的计算式分别为

由式(1)~式(4)可以看出,当观看者与屏幕之间的距离不同时,Panum融合区的范围也不同.假设观看距离v=2 000 mm ,计算出立体显示屏幕Panum融合区的前界距离屏幕Pf=547 mm,后界距离屏幕Pb=-1205 mm.因此由左、右视点图像对应点视差引起的感知深度凸出屏幕不应超过547 mm,凹进屏幕不应超过1205 mm.

观看者感知到的深度,与显示在屏幕上左、右视点图像的对应点视差有关,立体显示屏幕Panum融合区前后界Pf=547 mm ,Pb=-1205 mm,由视差式立体显示原理可以推导出Panum融合区对应点的视差范围为[-24.44 mm,24.47 mm].在立体图像处理和立体显示时,为了更好地表述以及处理立体图像,一般选用像素距离表示视差,根据立体显示屏幕的像素密度(pixels per inch,PPI),可以将视差从欧氏距离转换为像素距离.目前市场上常见的平板立体电视PPI的典型值为56,即相邻像素点距离为0.45 mm,当观看距离v=2 000 mm时,计算出双视点立体电视上Panum融合区的视差像素范围为[-54,54].

为了视差调整处理方便,本文之后的立体显示屏幕Panum融合区表示由以Panum融合区前后界与屏幕的距离范围[Pb, Pf]转换为以Panum融合区在左、右视点图像的视差范围[Pmin,Pmax],其中Pmin为Panum区最小融合视差,Pmax为Panum区最大融合视差.

综上所述,在进行视差平移调整前必须充分考虑Panum融合区对视差调整量M的限制,以保证在观看立体图像时不会出现双眼复视.此外,需要注意针对不同像素密度的显示器以及不同观看距离,Panum融合区的视差范围是不同的.

3 Panum融合区内视差调整量的计算

为了确定视差调整量M的取值范围,除了需要计算立体显示屏幕的Panum融合区范围[Pmin,Pmax],还需要计算显示的立体图像左右视点最大视差Smax和最小视差Smin.通过视差平移调整后,立体图像的视差范围由[Smin,Smax]变为[Smin-M, Smax-M],在尽量保证调整后视差范围在Panum融合区范围内的前提下,可计算出视差调整量M的范围为[Smax-Pmax,Smin-Pmin].

计算立体图像最大和最小视差最容易想到的方法是将左、右视点图像中每个点做匹配,然后逐一比较视差,最终确定整个图像的最大视差和最小视差.这种稠密匹配并比较视差的方法,需要计算左、右视点图像的全部对应点,计算量非常大;另外稠密立体匹配算法[10]在计算视差有跳跃的边缘轮廓处的点,以及在平滑区域内特征不明显的点时,容易出现误匹配,得到错误的视差值.但是对于估计视差调整量的算法,最重要的需求是对应点匹配的准确性.

本文提出了一种快速计算立体图像最大和最小视差的方法.该方法不用对左、右视点图像进行逐点匹配,只需在左、右视点图像中找出少量对应特征点,即可计算出图像最大和最小视差,同时还显著地降低对应点的误匹配率.

3.1 最大和最小视差的快速计算方法

本文提出的立体图像最大和最小视差快速计算方法是通过对立体图像的分析,逐步缩小最大和最小视差点的搜索范围,最大限度地剔除不可能出现最大和最小视差点的区域.因为不需要对剔除区域内的点进行匹配运算,所以可显著减少计算量,降低时间复杂度.

在人类立体视觉中,物体表面的形状轮廓、明显纹理特征和光影等都是产生立体感的重要线索[11],利用这些信息可以对立体图像进行分割.如图6所示,立体图像左、右视点图像被分割成许多个对应的图像块.这样就可以将在左、右视点图像中逐一寻找对应点然后比较视差的问题转化为:首先进行左、右视点图像的分割,然后求左、右视点图像中每个对应图像块的最大和最小视差,最后逐一比较图像块的最大和最小视差问题.

图6 立体图像的分割结果Fig.6 Result of stereo image segmentation

可以看出在分割后的每个图像块内部纹理都是平滑的.根据立体视觉原理,如果排除由经验产生的心理暗示,纹理平滑表面对立体感的贡献很少.在只有生理立体视觉作用的情况下,人类通常将纹理平滑表面感知成在一个平面上.因此可以将立体图像中物体的表面表示成由许多个被分割出来的小平面图像块组成的.左、右视点图像间对应的图像块,其最大视差和最小视差只会分布在图像块的边缘,因此在搜索最大和最小视差时可以将对应图像块内部的点剔除,此时最大和最小视差点的搜索范围缩小为左、右视点图像分割出的对应图像块边缘.

然而,经过分割的图像块对应边缘仍然有数量众多的点,全部寻找对应点,计算量也很大,同时匹配这些对应点时还存在一定的误匹配率,因此有必要进一步缩小最大和最小视差的搜索范围.

根据边缘曲线可以按曲率变化用许多直线段近似描述,这样就将分割出的边缘用直线段近似描述,比较对应边缘视差近似成比较对应直线段的视差.由直线段映射原理可知,当2条直线段非平行时最大和最小视差点分布在线段端点;2条线段平行时所有对应点视差相同.因此在搜索最大和最小视差时,可以进一步把对应边缘直线上的非端点剔除,这样就将最大和最小视差点的搜索范围进一步缩小为立体图像分割边缘上的曲率变化剧烈的特征点.

综上所述,立体图像的最大和最小视差搜索范围可最终缩小为根据立体视觉线索对立体图像进行分割的边缘上的特征点,在左、右视点图像中逐一寻找对应点然后比较视差的方法可简化为逐一寻找特征点的对应点然后比较视差的方法,将稠密立体匹配问题简化成稀疏立体匹配问题.这个方法的优点是能快速准确地计算出立体图像的最大和最小视差,大大减少了计算量,同时因所挑选的特征点具有较好的匹配特性,降低了误匹配率.

3.2 算法实现

计算立体图像最大和最小视差的步骤为:首先在立体图像的右视点图像中寻找特征点,然后在左视点图像中对特征点进行匹配,最后比较各对对应点视差,找出最大和最小视差.

步骤1 使用CSS(curvature scale space)算法[12]在右视点图像寻找特征点.CSS算法寻找到的点是在给定的边缘上的曲率极大值点(即角点),CSS检测的思想是首先在尺度空间粗糙尺度上检测角点,然后向精细尺度跟踪这个点,对它进行修正.在根据立体图像中景物轮廓、纹理和光影特征提取的边缘上使用CSS算法获取的角点是最大和最小视差快速估计中需要搜索的特征点.

特征点提取的方法如下.

1) 检测边缘并提取T形角点

第1步:选取适当的参数,使用canny算子[13]对右视点图像景物的轮廓、纹理和光影等特征进行边缘提取.

第2步:填补提取边缘的间隙,形成闭合曲线.

第3步:寻找并记录下边缘上的T形角点.

2) CSS角点检测与跟踪

第1步:在最高尺度上计算边缘的曲率绝对值,并选择局部极大值点作为角点候选点.候选点满足:大于阈值t(去除圆形角和噪声);至少2倍于两侧相邻的某个曲率极小值点.

第2步:跟踪候选点到最低(细)尺度以获得更好的位置精度.对于在高尺度上检测到的极大值点,在其低一级尺度的邻域搜索极大值点.如此不断向更低的尺度进行跟踪,对候选点进行修正.

3) 去除重复标记的角点

将1)、2)中得到的T形角点与CSS角点作比较,如果两者非常临近则去掉该T形角点.最终得到的角点即为提取的特征点.由右视点图像最终提取的特征点如图7所示.

图7 右视点图像提取的特征点Fig.7 Feature points of right viewpoint image

步骤2 对右视点图像中得到的特征点使用归一化互相关法(NCC)[14-15]在左视点图像中寻找匹配点.

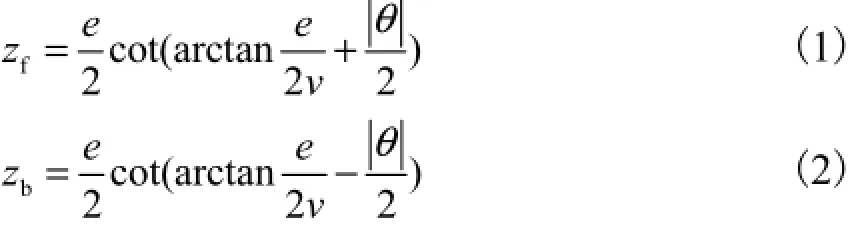

归一化互相关法首先在特征点图I1中定义以特征点I1( x, y)为中心(2,n+1)(2,m+1)的区域,然后设定滑动距离d在搜索图I2中定义以I2(x, y+d)为中心(2,n+1)(2,m+1)的区域,计算这2个区域的相关系数,即I1( x, y)与I2(x, y+d)的相关度,通过改变滑动距离d在I2中搜索与I1( x, y)相关度最高的点,此点即为1(,)I x y的对应点.

文献[15]中提供了计算NCC(,,)x y d的公式,即

其中

特征点匹配时,本文对相关系数NCC(x, y, d)进行限定,相关系数必须高于一定阈值,否则认为此点匹配失败,同时将这组对应点剔除,这样做明显降低了误匹配率.匹配后的左、右视点图像如图8所示.

图8 匹配后的立体图像对Fig.8 Pair of stereo images after matching

步骤3 寻找最大和最小视差.

在匹配过程中,对每对匹配点的视差进行记录并比较,最后寻找出立体图像最大视差maxS和最小视差minS.

步骤4 确定视差调整量M的范围.

为使立体图像视差平移调整后的新视差范围[Smin-M, Smax-M]尽量在立体显示屏幕的Panum融合区[Pmin,Pmax]内,需要Smin-M≥Pmin,同时Smax-M≤Pmax,则M∈[Smax-Pmax,Smin-Pmin].

需要注意的是,对有些最大视差Smax和最小视差Smin相差过大的立体图像(即在立体图像中近景与远景距离过大),存在Smax-Pmax>Smin-Pmin的情况,此时视差调整量M取Smax-Pmax.这样取值保证了凸出屏幕的近景部分在立体显示屏幕Panum融合区内,不会出现双眼复视.在立体节目中,近景多为主要景物,背景多为次要景物,人们在观看时会将注意力更多地集中在主要景物上,而忽视次要景物.所以当立体图像中近景与远景出现融像冲突时,首先需要保证近景在立体显示屏幕的Panum融合区内.

4 实验结果和分析

本文使用来自middlebury网站的标准图库中的tsukuba[16]作为测试图,选取第1视点图像和第5视点图像分别作为左视点图像和右视点图像.所做实验均是在Intel I3 2.4,GHz CPU、2,G内存的PC平台上进行的.立体观察平台为分辨率800×600的双视点立体显示器,观察距离2,000,mm.为了立体电视观察方便,将图像分辨率增大到800×600.

首先对本文提出的最大和最小视差快速计算算法进行实验与分析,选用稠密立体匹配BVZ算法[17]作为对比,同时用middlebury网站提供的真实视差图分析误差.

图9为使用BVZ算法计算出的视差图.从图中可以看出,亮度最高(即视差最大)区域为误匹配区域,亮度最低(即视差最小)区域为图像最左侧非同时可见区,因此该算法得到的最大和最小视差并不是真实值.由此可见,误匹配对视差平移量的估计有很大的影响.

图9 BVZ算法视差图Fig.9 Disparity map with BVZ algorithm

表1中误差为计算得到视差与真实视差差距占真实视差百分比.实验结果表明,本文提出的算法可以快速准确地计算出最大和最小视差;BVZ算法得到的最大和最小视差误差较大,而且耗费大量计算时间.

表1 maxS和minS的计算结果Tab.1 Calculated results ofmaxS andminS

经本文最大和最小视差快速计算算法得到立体图像tsukuba最大视差Smax为117像素,最小视差Smin为37像素.在2,000,mm的观察距离,为获得稳定的双眼单视,需要将视差控制在Panum融合区[-54,54]像素范围内.可以看到未经过视差平移调整前立体图像的最大视差超过了Panum融合区,图像中的台灯、石膏像等近景会出现双眼复视,严重影响观看效果,因此必须要通过视差调整对原视差进行校正.

为保证经过调整的新图像视差范围[37-M, 117-M]在[-54,54]像素范围内,得到视差调整量M∈[63,91].

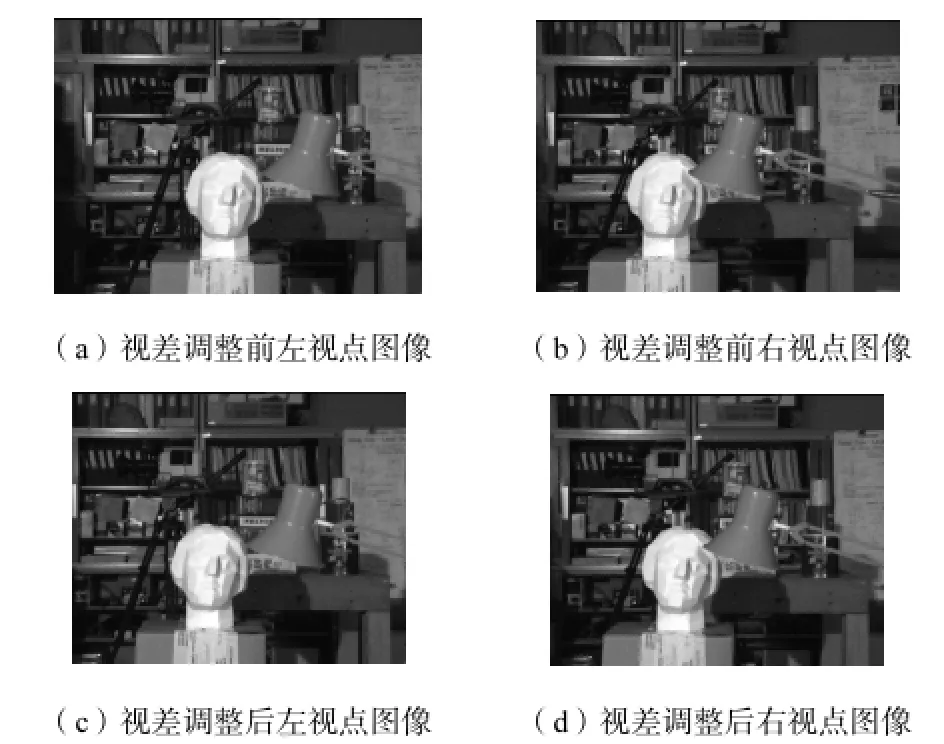

现取视差调整量M为70像素,图像tsukuba左、右视点调整结果如图10所示.

由图10可见,视差调整剪切掉原左、右视点图像中对立体感无贡献的非同时可见区域,同时立体图像视场损失不大.由人眼主观评价[18]调整后的立体图像,没有出现双眼复视.

图10 视差调整结果Fig.10 Results of disparity adjustment

5 结 论

(1) 根据Panum融合原理,计算了立体显示屏幕Panum融合区的视差范围,得出了Panum融合区界限与视差调整量之间的关系.提出了一种立体视差调整的快速估计算法,可以快速准确地计算视差调整范围.经过实验证明选用本方法得到的视差调整量调整的立体图像消除了影响立体感的双眼复视.

(2) 所提出的立体视差调整的快速估计方法还适用于多视点(视点数大于2)立体图像的视差调整,不同的是多视点立体显示器通常利用子像素建立立体感,因此像素距离需要变成子像素距离,同时需要考虑由Panum融合区界限计算得到的像素视差是相邻视点还是间隔视点视差.

[1] Vetro A,Wiegand T,Sullivan G J. Overview of the stereo and multiview video coding extensions of the H. 264/MPEG-4 AVC standard[J]. Proceedings of the IEEE,2011,99(4):626-642.

[2] Son J Y,Yeom S,Lee D S,et al. A stereoscopic camera model of focal plane detector array[J]. Journal of Display Technology,2011,7(5):281-288.

[3] Woods A J,Docherty T,Koch R. Image distortions in stereoscopic video systems[C]//IS&T/SPIE’S Symposium on Electronic Imaging:Science and Technology,International Society for Optics and Photonics. San Jose,USA,1993:36-48.

[4] Lee S W,Kim N. A method for precise depth detection in stereoscopic display[J]. Journal of the Optical Societyof Korea,2006,10(1):37-41.

[5] Allison R S. The camera convergence problem revisited[C]//Electronic Imaging 2004,International Society for Optics and Photonics. San Jose,USA,2004:167-178.

[6] Kwon K C,Choi J K,Kim N,et al. Automatic control of horizontal-moving stereoscopic camera by disparity compensation[J]. Journal of the Optical Society of Korea,2002,6(4):150-155.

[7] 吴 夕,刘玉华,颜少明. 正常人双眼视觉的Panum融合区[J]. 眼科新进展,1999,19(5):375-376 Wu Xi,Liu Yuhua,Yan Shaoming. Panum’s fusional area of normal human’s binocular vision[J]. Recent Advances in Ophthalmology,1999,19(5):375-376(in Chinese)

[8] Panum P L. Physiologische Untersuchungen über das Sehen mit zwei Augen[M]. Charleston,SC:Nabu Press,2010.

[9] Fender D,Julesz B. Extension of Panum's fusional area in binocularly stabilized vision[J]. Journal of the Optical Society of America,1967,57(6):819-826.

[10] Scharstein D,Szeliski R. A taxonomy and evaluation of dense two-frame stereo correspondence algorithms[J]. International Journal of Computer Vision,2002,47(1):7-42.

[11] 马尔D. 视觉计算理论[M]. 姚国正,刘 磊,汪云九,译. 北京:科学出版社,1988. Marr D. Vision:A Computational Investigation into the Human Representation and Processing of Visual Informaution [M]. Yao Guozheng,Liu Lei,Wang Yunjiu,Trans. Beijing:Science Press,1988(in Chinese).

[12] Mokhtarian F,Suomela R.Robust image corner detection trough curvature scale space[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(12):1376-1381.

[13] Canny J. A computational approach to edge detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,1986,8(6):679-698.

[14] Lewis J P. Fast template matching[J]. Vision Interface,1995,95:120-123.

[15] Zhang Z,Deriche R,Faugeras O,et al. A robust technique for matching two uncalibrated images through the recovery of the unknown epipolar geometry[J]. Artificial Intelligence,1995,78(1):87-119.

[16] Scharstein D,Szeliski R. Middlebury Stereo Vision Research Page[EB/OL]. http://vision. middlebury. edu/stereo/data/scenes2001,2011-02-11.

[17] Boykov Y,Veksler O,Zabih R. Fast approximate energy minimization via graph cuts[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2001,23(11):1222-1239.

[18] 沈丽丽,侯春萍. 应用人类视觉特性的立体图像质量评价方法[J]. 天津大学学报,2012,45(8):682-687. Shen Lili,Hou Chunping. Objective assessment of stereo images based on full human visual characteristics[J]. Journal of Tianjin University,2012,45(8):682-687(in Chinese).

A Rapid Stereo Disparity Adjustment Estimate Method

Yue Bin,Hou Chunping

(School of Electronic Information Engineering,Tianjin University,Tianjin 300072,China)

Disparity adjustment is usually used for convergence changing and disparity correcting. The rapid stereo disparity adjustment estimate method was proposed for accurately calculating the disparity adjustment range of the stereo image. The algorithm first applied the Panum’s fusional area of human vision to the modeling of threedimensional display space,calculated the Panum’s fusional area of stereo screen,then deduced the range of disparity adjustment of the Panum’s fusional area,and finally rapidly estimated the range of suitable disparity adjustment in the Panum’s fusional area using the sparse matching depth clue of stereo image. Experimental results indicate that the algorithm can calculate the range of disparity adjustment fast and accurately,and maximally reduce the binocular diplopia of stereo image.

disparity adjustment;Panum’s fusional area;image segmentation;feature extraction;feature points matching

TN919.81

A

0493-2137(2013)07-0571-08

DOI 10.11784/tdxb20130701

2012-12-17;

2013-02-21.

国家高技术研究发展计划(863计划)资助项目(2012AA03A301);国家自然科学基金重点资助项目(60932007,61201179);教育部博士点基金资助项目(20110032110029);天津市科技支撑计划资助项目(11ZCKFGX02000).

岳 斌(1982— ),男,博士研究生,yuebin0615@hotmail.com.

侯春萍,hcp@tju.edu.cn.