生成式人工智能赋能批判性思维测评

2024-12-03冷静卢弘焕代琳

摘要:以生成式人工智能技术赋能教育评价创新,已成为数字时代教育评价改革的热点话题。为了能真实地反映个体的批判性思维水平,其测评已逐渐由单纯的技能评估转向在真实情境中进行推理、提供论据以及信息可信度等综合能力的评估。将ChatGPT应用于批判性思维测评,有助于丰富评估内容、创新交互模式以及提升评估效率和精度,为批判性思维的多维度评估提供新视角和方法。基于批判性思维框架及五维测评量规,利用基于ChatGPT的在线平台对31名大学生在186篇论证作文中反映出的批判性思维水平进行评价发现,作为写作辅助工具的ChatGPT能够显著提升学生对“说明利弊类”“图文情境类”和“对立观点类”三类主题作文的论证写作能力;并且利用ChatGPT进行的批判性思维评估也表现出较高的精准度,但在不同主题任务的测评中存在细微差异。这一结果表明,ChatGPT在捕捉和评估具有直接性和明确性的批判性思维要素方面较为高效,但在评估逻辑推理和论证深度方面仍存在局限。未来可进一步优化提示词设计,引导ChatGPT深入理解人机对话中体现出的批判性思维水平,提升其在复杂认知任务处理中的适应性和准确性,进而实现个性化批判性思维评价与培育。

关键词:生成式人工智能;ChatGPT;教育评价;批判性思维测评;提示工程技术

中图分类号:G434 文献标识码:A 文章编号:1009-5195(2024)06-0102-10 doi10.3969/j.issn.1009-5195.2024.06.011

一、引言

批判性思维作为一种具有合理性、批判性、反思性等特质的思考方式,旨在增强个体对信息进行深入分析、评估和推理的能力,并形成独立和批判的观点。批判性思维能力在培养高水平的创新人才方面起着重要作用,受到国际社会的广泛关注(方中雄等,2023)。然而,在评估教学干预对学生批判性思维提升的作用方面,元分析结果显示:技术的使用并未对教学效果产生显著影响(冷静等,2020a)。2020年,国务院印发的《深化新时代教育评价改革总体方案》强调,充分利用信息技术提升教育评价的科学性、专业性和客观性(新华社,2020)。2021年,教育部等六部门联合发布《关于推进教育新型基础设施建设构建高质量教育支撑体系的指导意见》,也强调要通过“人机共教、人机共育”提高教育教学质量(中华人民共和国教育部,2021)。随着人工智能技术的发展和教育数字化的深入,人工智能有望为教育评价带来更高效、更客观的策略方案,以弥补传统评价手段的不足。例如,将自然语言处理、预测分析、语音识别等引入测评,可以更全面、精准地评估学生的学业表现和思维能力;教师基于智能测评的结果实施相应的教学干预,以更好地提供基于数据的有效反馈(况姗芸等,2021)。

当前,生成式人工智能在教育领域的应用潜力被越来越多的教育研究者和从业者所重视(陈向东等,2023)。生成式人工智能作为一种具备智能化、个性化、便捷化等特性的教育工具,可以被用于情感智能整合、智能教学辅助、跨学科与跨文化支持等多种教育实践场景,并展现出实时反馈和全面性评估的价值。同时教育研究者也需要全面审视生成式人工智能产品在教育评估中的潜在风险,并确保其在教育场景下的公平应用(王炜等,2024)。在此背景下,以ChatGPT为代表的生成式人工智能产品是否会对学生批判性思维能力的提升产生影响,引发了学界广泛的关注与思考。有研究者认为ChatGPT能够促进学生的批判性思维、阅读、写作能力(王佑镁等,2023)。同时,教师可以通过优化提问设计来充分发挥ChatGPT应用于教学评价与反馈的潜力(王丽等,2023)。然而,也有研究者指出ChatGPT可能会降低学生对信息的批判性分析和过滤能力,阻碍学生批判性思维能力的培养(Else,2023)。基于此,如何将以ChatGPT为代表的生成式人工智能技术转变为驱动学生学习变革和思维能力培养的重要手段,已经成为数字时代教育评价改革的热点话题。

本研究通过梳理批判性思维测评的发展历程,探讨生成式人工智能在批判性思维测评中的方式转变、内容创造、场景应用的可能性,构建了ChatGPT赋能的批判性思维测评模型,并将其应用于批判性思维评估实践,以期推动生成式人工智能在教育测评中的创新应用,为批判性思维测评提供技术路线与实践参考。

二、批判性思维测评的发展趋势

作为21世纪学生必备的核心能力之一,批判性思维的培养已经成为各国教育的重要目标(Supena et al.,2021)。批判性思维最早由美国哲学家、教育家和心理学家杜威提出,本质上是为了决定相信什么或做什么而进行的合理的、反省性的思维(Ennis,1989)。对学生批判性思维能力的培养离不开批判性思维测评,随着智能技术的发展与教育评价目标的转变,传统测评工具的局限性日益凸显(姜力铭等,2022)。对批判性思维测评发展趋势的分析有助于对其进行适应性改进。

传统的批判性思维测评主要关注批判性思维技能,强调对推理演绎、论证分析等技巧的评估。如沃森—格拉泽批判性思维评估(Watson-Glaser Critical Thinking Appraisal)将批判性思维分为推断、假设识别、演绎推理、解释和论证评估5个维度(Watson et al.,1980)。相比结果取向的测评工具,也有一些批判性思维测评工具更聚焦于批判性思维的动态过程。例如,Newman等人(1995)提出的批判性思维分析框架包含相关性、拓展性、合理性等10个指标;Ennis和Weir(1985)共同编制的《恩尼斯—韦尔批判性思维作文测验》着眼于评估被试者的要点把握、假设提出、推论能力、理由发现等能力,以及情绪性语言运用等特质。但从测评情境来看,传统测评工具大多与情境无关,鲜有基于真实情境的测评工具。

1.测评形式注重情境化

近年来,对批判性思维的测评越来越强调情境性,测评题目的形式逐渐从封闭式向开放式转变。例如,Halpern(1998)提出的《Halpern批判性思维测试》,就是一种基于日常生活场景将批判性思维人格倾向和技能融合在一起的综合测评。当前,越来越多的基于真实问题情境的测评工具不断涌现,能够让学生在真实的问题情境中进行思考,权衡各方利弊后作出判断,从而反映更为真实、全面的批判性思维能力。例如,Zlatkin-Troitschanskaia等人(2019)强调批判性思维的整体性和分析方法的互补性,注重在构建的现实生活情境中考查学生的批判性思维;Wang等人(2022)使用Toulmin模型开发了一种基于游戏的交互式自动化评估方法,学生通过在两个真实的模拟故事中完成互动任务,并获得批判性思维的分数;冷静等人(2020b)基于问题情境的批判性思维测评,开发了一款面向中小学生的批判性思维测评游戏——“星球历险记”。开放性测评工具虽能够较为全面地体现批判性思维能力,但其测评成本较高。因此,教育领域亟需更为全面且精准的批判性思维测评工具。

2.生成式人工智能支持下的测评范式转变

生成式人工智能能够以自动化的方式创造信息,满足用户个性化的需求(Du et al.,2023),使内容生成过程越来越自动化和智能化(蒋华林,2023)。ChatGPT作为生成式人工智能的典型代表,展现了高度拟人化的交互体验、强大的自主学习能力,并在增进学生深度参与方面具有显著特点(朱永新等,2023),为设计科学、可靠、客观的批判性思维能力测评工具提供了新的思路。

(1)创新测评方式

基于生成式人工智能所具备的交互问答和智能推荐等技术优势,其支持下的批判性思维测评可实现以下三方面的创新。

一是实时反馈和精细指导。ChatGPT有较强的联系上下文的能力,擅长在与学生的交互中不断分析其对批判性思维的理解和运用。由于ChatGPT的交互问答是基于规则推理而并非预设答案的简单匹配,学生需要根据自己的需求进行追问,表露自身最真实的想法,使测评者从人机交互中获得更为精细的可评估数据(沈成等,2023)。此外,以智能技术为基础的教学反馈还可以提供个性化指导,促进学生反思改进,在有效提高反馈效率的同时对学生的认知、情感等带来积极的影响(于文轩等,2023)。

二是更为自然的评价过程。伴随知识社会对人才批判性思维能力需求的日益增长,传统的问答和测试方式已难以满足学生批判性思维测评的多元化评价指标。ChatGPT具有的强大信息搜索与整理能力,能够为学生的疑问提供更丰富的答案(Aljanabi,2023)。特别是,很多生成式人工智能产品能够以对话的形式为学生提供方法、资料和论述支持,以针对性反馈消除学生在知识背景上的障碍,弥合学生认知水平与思维延伸之间的“鸿沟”,促使学生在探究模式下自由地进行深层次的问题剖析,更能全面地体现学生对问题批判性解决的深度认知加工过程。由此,在智能技术的推动下,通过构建明确具体的应用测评场景,建立基于无打扰评价的测评实施框架,能够保障内隐批判性思维过程的可视化与可测量,进而实现更为全面的测评。

三是生成式人工智能结合大数据技术有望全面刻画批判性思维能力。教育测评技术,如自适应出题、智能推荐等,能够有效提升测评精度和效率。在生成式人工智能产品支持下,教师还可以采用更加科学、客观和直观的评价方式,兼顾终结性评价与过程性评价,通过对学生项目作业、角色扮演、实际场景模拟等数据的监测、挖掘和分析,更好地了解学生的学习过程和效果(张峰等,2023)。例如,可以通过创设一系列真实的问题情境,让学生在多学科领域中对知识和信息进行鉴别、分析和综合评估,最终形成自己的理解和判断。除此之外,生成式人工智能技术不仅能够识别学生的思维偏差和错误,还有能力生成详细的解答和分析,从而更深入地梳理复杂思维,帮助教育者更好地了解学生的需求,制定更有针对性的教学策略。

(2)生成多样化测评内容

当前,生成式人工智能技术能够理解并分析复杂的语言结构,已具备生成文本、图像、音频、视频、3D模型等多种模态内容的能力(万力勇等,2023)。同时,随着生成式人工智能技术不断地拓展知识边界,其具备的海量知识将迁移到教育测评领域,强化批判性思维测评的深度。将ChatGPT有效地引入教育测评,除了能够突破传统测评的局限性以及革新测评内容,还能帮助学生在各个学科领域乃至跨学科领域中将课程知识与现实情境相结合,运用多学科知识与方法解决问题,进而帮助研究者更加准确、有效地评估学生的批判性思维能力。

(3)衍生多功能应用场景

相比传统的测评手段,生成式人工智能技术有助于诊断学生思维发展水平的现状,能在多个测评场景下为个体和组织发展提供重要的支持。一是作为智能化教育辅助工具。在写作场景下,生成式人工智能可以为学生提供实时、个性化的反馈,不仅涵盖学生语法和拼写错误识别,还可包括批判性思维的要素提示。二是作为情感智能整合工具。生成式人工智能产品具备情感智能的功能,可以分析学生的情感状态,有助于教育者更好地捕捉学生的情感状况并提供针对性的支持,以促进批判性思维的稳步发展。三是作为跨学科和跨文化支持的工具。生成式人工智能能够适应不同领域和不同种类的文化背景,这一突破将大力推动批判性思维教育的普及化发展。

三、批判性思维测评模型构建

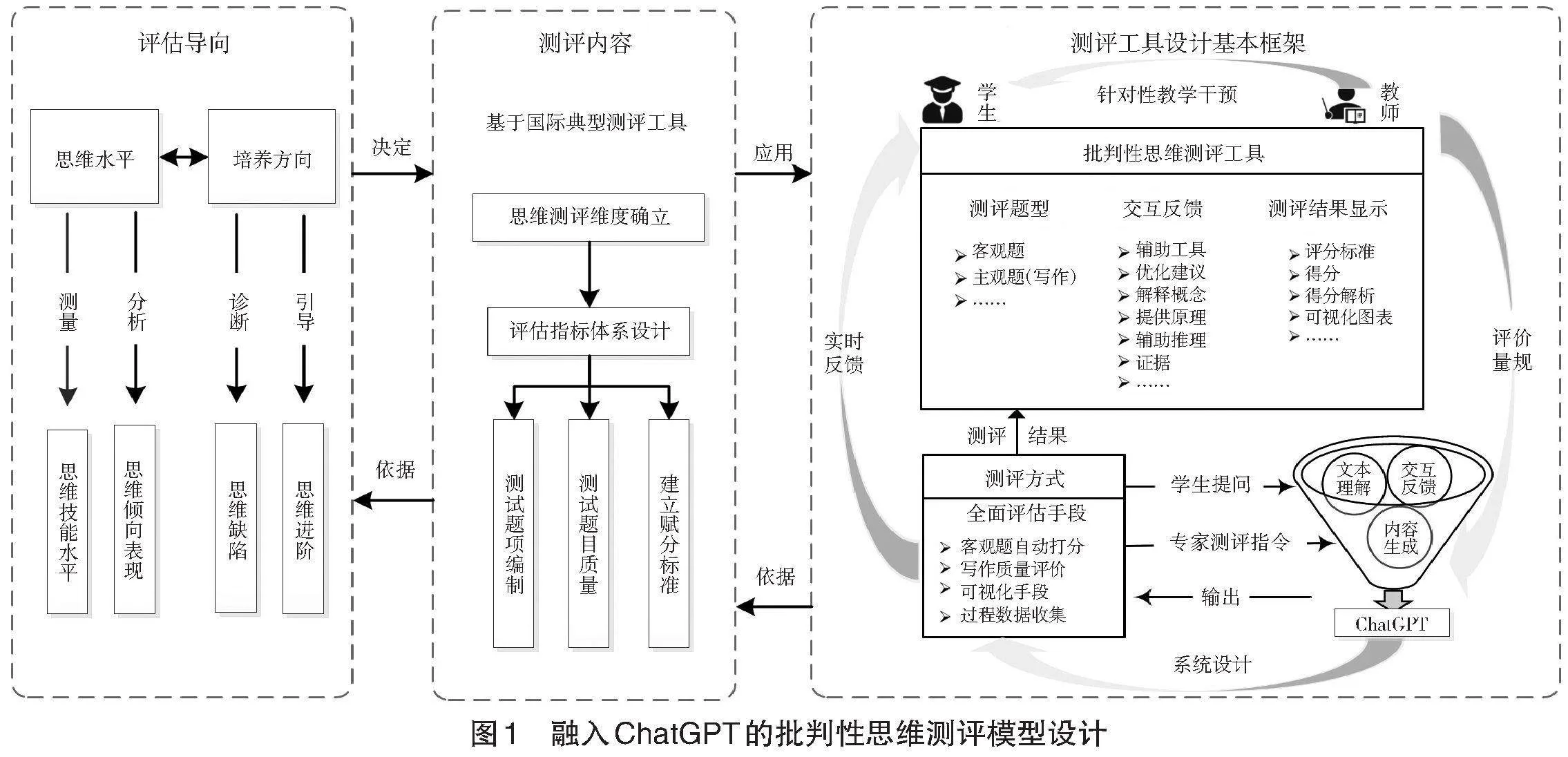

本研究以测评目标为逻辑起点,通过融入ChatGPT作为测评工具,旨在建立一个科学、合理的批判性思维测评模型(如图1所示)。在评估导向方面,本测评模型通过对学生的批判性思维水平与思维倾向表现进行测量与分析,并基于测评结果培养与提升他们的思维能力。在测评内容方面,明确测评维度和可量化的批判性思维能力测评指标,并设计批判性思维测试题,明确测评内容。从学习者评价的角度看,除了评价目的、评价内容等方面,基于ChatGPT开展的批判性思维测评还需要特别考虑两类内容的设计,即提示语设计和测评工具设计。

1.提示语设计

学术界普遍认为,良好的提问设计有助于利用ChatGPT生成高质量、可靠的反馈,并适应特定的任务场景(Liu et al.,2023)。当前,提示工程(Prompt Engineering)已成为与大语言模型(如ChatGPT)进行有效对话不可或缺的交互方式。如何充分利用ChatGPT的潜力,理解和掌握提示工程的技术至关重要,设计和优化输入提示可提升大语言模型响应效能(Giray,2023)。本研究参考Ekin(2023)提出的有效提示工程策略(即任务约束—清晰说明—实验尝试),将写作任务作为其应用场景。为增强生成内容的相关性和深度,本研究为ChatGPT指定具体的角色来丰富其输出,经过广泛的实验测试与不同类型问题比较,最终根据以下步骤展开提示语设计:(1)提供相关材料。将相关材料提供给ChatGPT,并使用提示词引导ChatGPT仅回答与文本材料有关事实性知识。(2)制定交互原则。设计简单、合理的提示链,实现互动内容与测试情境材料的强相关,进而提供知识层面问题的解决方案。(3)选取测评量规。通过简洁清晰的方式组织量规,以确保ChatGPT能够理解并有效应用。(4)输入样例库。根据Hattie等人(2007)提出的有效反馈原则,让ChatGPT扮演批判思维领域测评专家,提供具体的测评任务的范围和要求,以及高质量的点评范例,说明ChatGPT应输出的评分与评语格式,从而实现有效的评估和反馈。

2.测评工具设计

在测评工具设计方面,本研究初步设计了批判性思维智能测评平台。此平台引入生成式人工智能(ChatGPT)作为思维测评辅助工具,本质上是为了发挥生成式人工智能产品在文本理解和互动反馈方面的优势,识别学生的批判性思维水平,进而为培养学生的批判性思维能力提供技术支撑。测评过程中,学生根据给定的信息,评估不同观点,为证据寻求可靠支持,最终作出判断与评价。因此,在本研究的测评中,批判性思维测评不再仅仅关注结果,而是将批判性思维看作是一个连续、动态的交互过程。综上,本研究拟进一步探究以下两个方面:

一是根据ChatGPT支持下的批判性思维测评结果,判断学生的批判性思维能力是否有所提高。

二是ChatGPT在不同主题写作任务下的测评性能(精确度)是否存在差异。

四、实验设计

1.研究对象和工具

本研究以华东某高校修读《专业英语文献精读》课程的31名本科生为研究对象,该课程中设置了三个主题(包括说明利弊类、图文情境类以及对立观点类)的写作任务。这些学生使用基于ChatGPT的批判性思维测评平台进行在线阅读和写作,共产生186份论证写作文本,共计约5.6万词。

2.实验环境

本研究的批判性思维测评平台基于开源的Moodle平台进行开发,将测评内容文本作为学生与ChatGPT交互的切入点,融合基本阅读写作功能和大语言模型的实时问答,实现基于ChatGPT的实时反馈与评价。在该平台上,教师可以设置相应的写作任务,学生可以进行文本阅读标注、使用翻译功能以及在写作的过程中与ChatGPT实时互动。所有的在线数据都可以从后台导出并进行分析。

本研究中教师采用了雅思写作评价量规(包括任务响应、连贯性与衔接、词汇丰富性以及语法范畴与准确性)来衡量学生的写作质量。此量规综合考虑了文章的多个关键方面,以确保全面而准确的评估,即不仅关注学生表达能力的各方面,也强调了批判性思维和论点阐述的重要性。此外,本研究参照文秋芳等人(2009)构建的作文测评量规来分析学生的批判性思维论证能力,由此构建出批判性思维能力评测量规(见表1)。该量规包含5个维度的批判性思维核心能力:阐释、分析、评估、推断和自我调节,每一维度又可分为5个等级(见表1)。为提高评分的准确性和可靠性,本实验向ChatGPT提供了详尽的批判性思维能力测评量规描述、高质量的阅读材料和作文范例,依据提示词设计进行输入,并预先测试了ChatGPT的有效性。

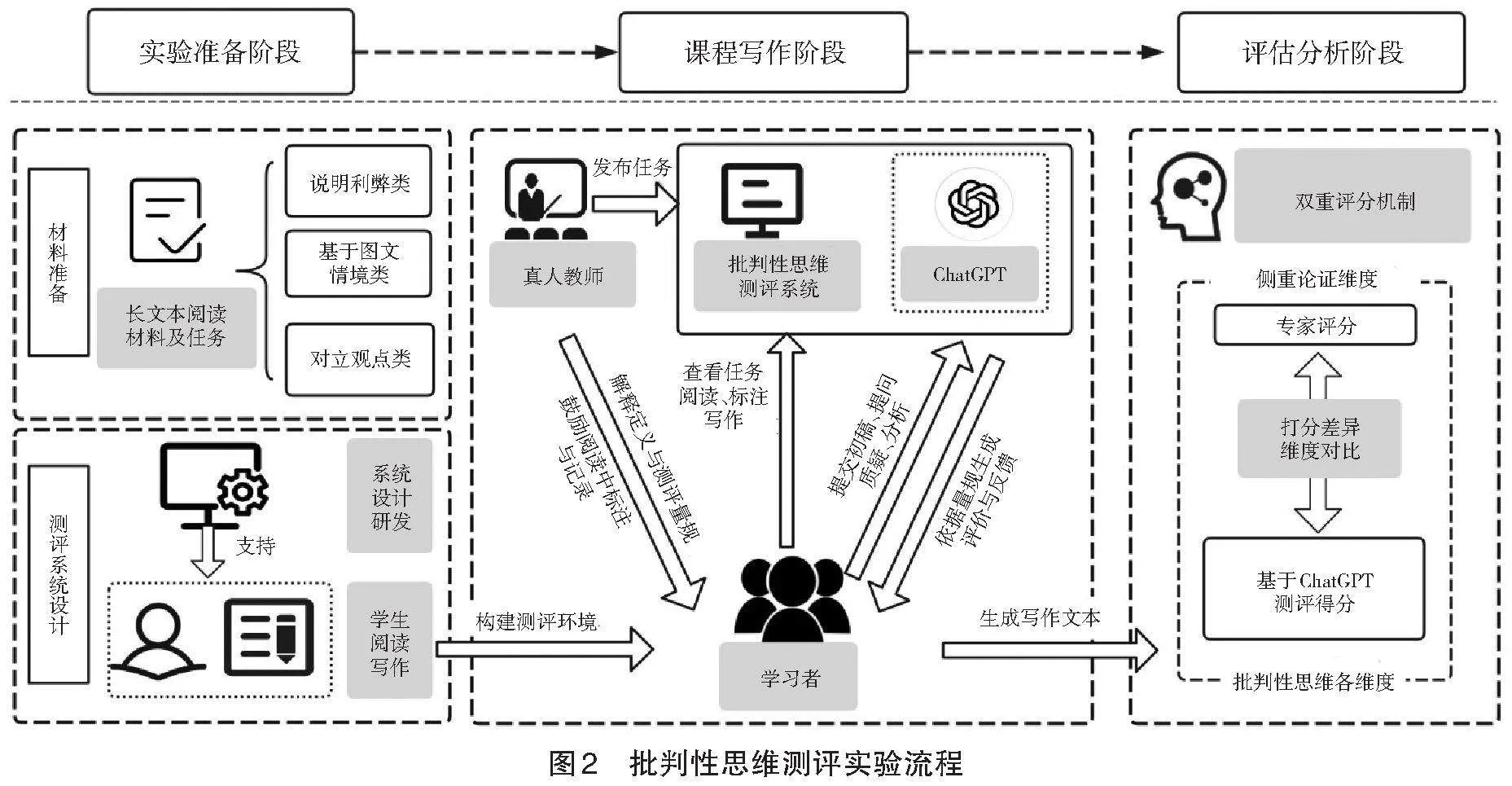

3.实验流程

本研究依托批判性思维测评系统展开实验,图2展示了本实验的具体实施过程。课程中学生共需要完成6个写作任务(每一类别有2个写作任务)。在课程之初,教师会向学生解释批判性思维的定义以及作文的双重评分机制。开始写作之前,学生需要先在线阅读长文本材料,并可以利用ChatGPT进行提问,同时可以质疑信息来源、探索不同观点、总结和归纳,在此基础上进行论证式文本写作,ChatGPT会在限定范围内合理反馈,学生可以随时根据反馈修改文章内容,最终提交平台。

随后,本研究采用双重评分机制进行测评,即由两位经验丰富的教师对雅思写作评价量规和批判性思维测评量规进行充分结合和校准。雅思写作评价量规主要用于评估作文的语言表达能力,包括任务响应、连贯性与衔接、词汇丰富性及语法准确性、论证能力等方面。其中,论证能力维度侧重评估学生在阐释、分析、评估、推断和自我调节等关键批判性思维维度上的表现。两位英语教师按照批判性思维能力测评量规(见表1)分别对25%的文章进行论证维度的评分,通过充分讨论和协商,最终一致性系数达到0.88,接着由其中一位教师完成剩余所有文章的评分。同时,本研究利用ChatGPT基于不同的评价维度对所有文章进行独立评分。根据阐释、分析、自我调节等5个维度进行分类统计,计算不同主题下ChatGPT对于论证文本测评的精确度和召回率。本研究以专家测评打分评级结果为标准,用ChatGPT正确测评出的专家打分项数除以ChatGPT测评的总项数计算精确度,用ChatGPT正确识别出的专家打分项数除以专家打分总项数计算召回率。最后,随机抽取13位学生进行半结构化访谈,访谈内容包含测评体验、ChatGPT提供的支持以及受访者对测评结果的认识三个方面。

五、数据分析与发现

1.学生的批判性思维测评结果前后测比较

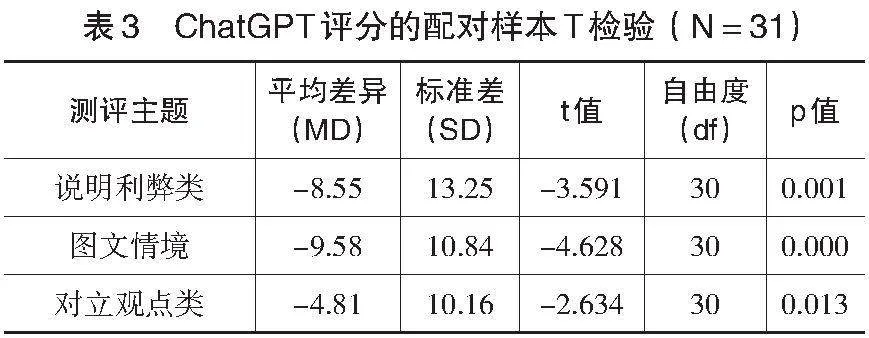

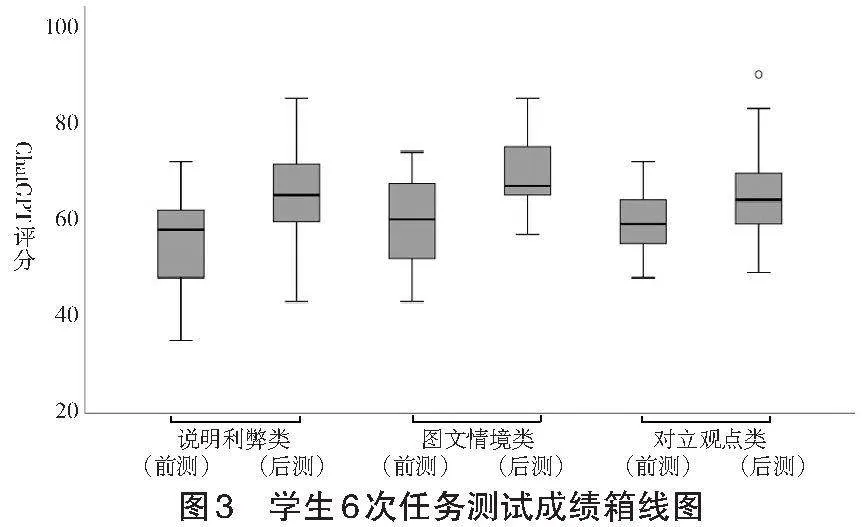

本研究基于ChatGPT对31名高校学生的作文(共6次写作任务)进行分析,有效个案数为186个,并对测评结果进行了描述性统计(见表2)与配对样本T检验(见表3)。如表2所示,百分制标准下ChatGPT评分显示学生批判性思维的整体表现处于中等偏上水平(M=62.50)。而ChatGPT评分存在一定的变异性(SD=9.47),表明学生之间在批判性思维能力上存在差异。从批判性思维的5个测评维度可以发现,学生的批判性思维各维度的发展并不均衡,尽管学生在阐释维度上的平均评分最高(M=14.04),这表明他们在解释观点方面表现较好,但在评估(M=11.75)和自我调节(M=11.99)等维度上的表现则相对较弱。图3的箱线图展示了三类写作主题下学生6次作文测评任务的ChatGPT评分结果,展示了学生在批判性思维写作测试中成绩的差异度。表3中的T检验数据结果表明,每一类写作主题中学生的第二次得分均高于第一次,且存在显著差异(p<0.05)。其中,学生作文得分在图文情境类中的前、后测差异最显著(MD=-9.58,t=-4.628,p<0.001)。

2.ChatGPT在不同主题任务中测评精准度比较

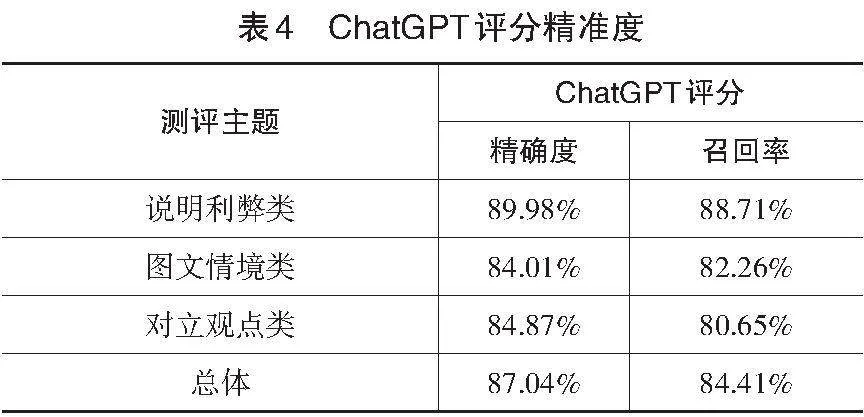

基于批判性思维能力测评量规,ChatGPT对于学生写作论证测评得分的精确度如表4所示。综合各类写作任务来看,ChatGPT的总体评分精确度(87.04%)与召回率(84.41%)均较高。这一结果表明,ChatGPT作为测评辅助工具,在评估学生批判性思维能力方面表现出较高的准确性和全面性。

具体而言,在不同主题的测评任务中存在细微的精确度差异。在评估涉及明确立场和论点的“说明利弊类”写作任务中,ChatGPT展现出了较高的评分精确度(89.98%),可见ChatGPT在捕捉和评估具有直接性和明确性的批判性思维要素方面体现出高效性。“对立观点类”写作任务的评分精确度(84.87%)次之,这表明ChatGPT在评估学生对复杂论证的理解和评价方面具有一定的效能,但在处理高度复杂和多维度的批判性思维时,其对论证内容测评的精确度还有待提高。对于“图文情境类”写作任务,ChatGPT的评分精确度(84.01%)相对稍低,这一结果表明ChatGPT在处理复杂认知任务时存在潜在局限性,尤其是在需要深层次数据解释和推理的情境中。可见,ChatGPT可以作为一个有效的测评工具,辅助教师在批判性思维教学和写作教学中评估学生的思维水平。

从测评的召回率来看,“说明利弊类”写作任务的测评召回率最高(88.71%),这一任务要求学生明确地阐述一个观点或立场的正反两面,ChatGPT在这类任务中的高召回率表明,它能够有效地捕捉到学生在论证过程中的关键点,包括对利弊的分析、证据的列举以及结论的合理性。这可能是因为这类任务的结构相对明确,学生在表达时更容易遵循一定的逻辑结构,从而使ChatGPT能够较为准确地识别和评价学生的批判性思维。召回率排在其后的是“图文情境类”写作任务(82.26%)和“对立观点类”写作任务(80.65%),这两类任务通常涉及对多个观点、图表数据的深入分析和比较,这意味着学生可能需要进行更复杂的逻辑推理和解释。因此从召回率的差异来看,ChatGPT在全面捕捉批判性思维要素方面仍有提升空间。

六、研究结论与展望

1.研究结论

通过比较不同主题任务下ChatGPT对于学生论证写作中批判性思维水平的测评结果,分析以ChatGPT为代表的生成式人工智能技术在批判性思维能力测评中的应用潜能,本研究得出以下结论:

第一,ChatGPT作为应用批判性思维开展论证写作的辅助工具,能够有效评估学生论证语言表达和写作的准确性,但在评估学生逻辑推理和论证深度方面存在局限。本研究通过应用ChatGPT工具支持学生进行论证写作及修改,学生的批判性思维能力后测结果相较于前测得到显著提升。以上实验结果验证了持续使用大语言模型辅助学生论证写作能够有效提升他们的批判性思维能力。对学生的访谈分析发现,学生对使用ChatGPT作为测评工具的接受度总体上是积极的。多数受访者表示,ChatGPT作为论证写作测评工具,主要为学生提供了语法和用词、修改建议以及评价反馈三方面的支持。然而,也有受访者反映,ChatGPT在识别观点表达和逻辑结构方面的作用有限。后续研究如能通过使用提示技术为大语言模型提供具体的逻辑思维指令,将会进一步优化测评效果。

第二,ChatGPT在批判性思维测评中表现较好,但是测评精确度在不同主题写作任务中存在差异。因此,预先考察ChatGPT在不同主题任务下的适应性和限制性,有助于确保ChatGPT的测评准确性和有效性。首先,ChatGPT在评估学生的批判性思维能力方面显示出了较高的效能。尤其是在“说明利弊类”写作任务中,ChatGPT的评分精确度和召回率均超过85%,这表明在处理结构较为明确的写作任务时,经提示词下达指令,ChatGPT能够有效地捕捉和评估学生的批判性思维要素,展现出与专家评价相近的效果。其次,在处理“图文情境类”与“对立观点类”写作任务时,ChatGPT的评分精确度稍低于“说明利弊类”任务,这说明在相同提示词设计条件下,处理需要深层次分析和推理的任务时,ChatGPT还存在局限性,其在复杂认知任务处理上仍有提升空间。不可忽视的是,ChatGPT赋能的批判性思维测评在不同主题任务下存在差异,也体现出ChatGPT除了依赖于提示词设置,其在数据偏差、对于特定上下文的含义或复杂图表中的细节理解仍存在问题,甚至间或出现知识盲点或常识性谬误,因而生成错误的测评反馈(杨俊蕾,2023)。

2.研究启示

本研究构建了ChatGPT赋能的批判性思维测评模型,将ChatGPT作为写作辅助工具以及批判性思维评价工具,基于实验发现得出如下启示:

(1)ChatGPT赋能个性化教育评价

在技术迭代与社会变革进程中,生成式人工智能技术与教育评价的融合将进一步促进教、学、评应用生态的全方位升级(张绒,2023)。研究者需要促进以ChatGPT为代表的生成式人工智能技术与现有教育教学平台深度融合,形成适用于多个教育场景的测评工具。首先,ChatGPT作为结果性测评工具,能够基于对话数据和学习数据,快速处理大量文本,减少人为偏差,提供更加完善、精确的个人数字画像,增强评价的客观性和公正性(杨宗凯等,2023)。其次,ChatGPT作为过程性测评工具,可以根据不同场景下学生的回答和表现,提供实时的学习反馈和评价,帮助学生了解自身学习进展及思维,并进行反思和改进,调整学习进度,进而优化个性化学习体验。总而言之,基于生成式人工智能技术支持批判性思维测评将进一步改变原有评价方式,激励学生进行自主学习,并使他们学会如何在理解和应用知识的同时解决现实问题,进而培养其创新思维和独立解决问题的能力。

(2)提升ChatGPT的适应性与情感智能

首先,未来应鼓励多方参与共同推进ChatGPT语境感知和深度推理能力的研发。实证研究下的生成式人工智能产品在复杂语境中理解和推理能力仍存在不足,有可能是受到模型训练数据的有限性、对深层逻辑和复杂关系的理解不足、学生批判性思维运用等因素影响(令小雄等,2023)。基于此,ChatGPT评价性能的提升不仅需要创设具体的理解语境,增强深度推理能力,还可以从评估指标的精细化、知识库的丰富化以及领域专家的深度参与等方面进行深入探究,不断优化生成式人工智能产品,提高其测评适应性和准确性。其次,研究者应努力探索ChatGPT的潜能以实现情感智能。批判性思维不仅涉及思维技能,还涉及思维倾向等情感因素(Facione et al.,1994)。因此,ChatGPT赋能的批判性思维测评应引入情感分析技术,逐步实现批判性思维倾向的识别等情感智能。一方面,可深化ChatGPT与学生之间的良性互动,如适时鼓励用户进行自我反思与分析,有助于全面评估学生的批判性思维水平表现。另一方面,应尽可能理解学生的情感背景,如是否存在过度偏见或情感强度,以便于教师及时地介入批判性思维测评过程。如此,基于生成式人工智能技术的批判性思维测评才能摆脱传统批判性思维测评困境。此外,教师群体应该加强伦理和公平性考量。本研究建议引入公平性审查和伦理指南,增强ChatGPT在评估过程中的透明度,保证评估的公平性和合规性;同时,教师应当积极开展伦理教育,引导学生在使用ChatGPT过程中能够遵守伦理准则,促使其成为更具信任度和教育成效的批判性思维测评工具,而不是代替学生思考的工具。

本研究聚焦于构建ChatGPT支持下的批判性思维测评模型,并基于测评模型开展不同主题下的大学生批判性思维测评。由于批判性思维大规模测试的时间成本、分析复杂性等,实验主要集中在批判性思维测评的可行性评估,因此本研究还存在一定的局限性:一是研究样本数量较少,未来研究可以进一步通过准实验设计、扩大样本量,增加不同学科、不同文化背景和不同教育水平的被试以增强研究的普遍性,全面评估生成式人工智能技术产品在不同教学环境中的适用性。二是测评平台中人机交互Pw6K6ptJjThS8NY3Nkxby75+1HVl2/mZjl0Xloaytvk=的对话尚未展开深度分析,后续研究可以依托自动化话语编码与分析技术等,研究生成式人工智能技术在教育测评中的长期影响,进一步挖掘其在测评场景的潜在效益。

参考文献:

[1]陈向东,褚乐阳,王浩等(2023).教育数字化转型的技术预见:基于AIGC的行动框架[J].远程教育杂志,41(2):13-24.

[2]方中雄,刘继青(2023).论习近平关于“人才自主培养”重要论断的生成逻辑、理论内涵和实践指向[J].中国教育学刊,(5):1-8,69.

[3]姜力铭,刘玉杰,骆方(2022).基于真实问题情境的批判性思维测评:现状与挑战[J].中国远程教育,(12):58-67,77,83.

[4]蒋华林(2023).人工智能聊天机器人对科研成果与人才评价的影响研究——基于ChatGPT、Microsoft Bing视角分析[J].重庆大学学报(社会科学版),29(2):97-110.

[5]况姗芸,蓝琰,何敏等(2021).学业智能测评:现状和趋势[J].教育信息技术,(Z2):8-14.

[6]冷静,路晓旭(2020a).批判性思维真的可教吗?——基于79篇实验或准实验研究的元分析[J].开放教育研究,26(6):110-118.

[7]冷静,路晓旭(2020b).题库型游戏评测批判性思维能力研究[J].开放教育研究,26(1):82-89.

[8]令小雄,王鼎民,袁健(2023).ChatGPT爆火后关于科技伦理及学术伦理的冷思考[J].新疆师范大学学报(哲学社会科学版),44(4):123-136.

[9]沈成,柏毅(2023).大语言模型在小学生计算思维评测中的应用——以ChatGPT为例[J].中小学数字化教学,(6):25-28.

[10]万力勇,杜静,熊若欣(2023).人机共创:基于AIGC的数字化教育资源开发新范式[J].现代远程教育研究,35(5):12-21.

[11]王丽,李艳,陈新亚等(2023).ChatGPT支持的学生论证内容评价与反馈——基于两种提问设计的实证比较[J].现代远程教育研究,35(4):83-91.

[12]王炜,赵帅,黄慕雄(2024).生成式人工智能教育创新应用的人本主义追求——对UNESCO《教育与研究领域生成式人工智能指南》的解读[J].现代远程教育研究,36(1):3-11.

[13]王佑镁,王旦,梁炜怡等(2023).“阿拉丁神灯”还是“潘多拉魔盒”:ChatGPT教育应用的潜能与风险[J].现代远程教育研究,35(2):48-56.

[14]文秋芳,王建卿,赵彩然等(2009).构建我国外语类大学生思辨能力量具的理论框架[J].外语界,(1):37-43.

[15]新华社(2020).中共中央 国务院印发《深化新时代教育评价改革总体方案》[EB/OL].[2023-12-20].https://www.gov.cn/zhengce/2020-10/13/content_5551032.htm.

[16]杨俊蕾(2023).ChatGPT:生成式AI对弈“苏格拉底之问”[J]. 上海师范大学学报(哲学社会科学版), 52(2):14-21.

[17]杨宗凯,王俊,吴砥等(2023).ChatGPT/生成式人工智能对教育的影响探析及应对策略[J].华东师范大学学报(教育科学版),41(7):26-35.

[18]于文轩,马亮,王佃利等(2023).“新一代人工智能技术ChatGPT的应用与规制”笔谈[J].广西师范大学学报(哲学社会科学版),59(2):28-53.

[19]张峰,陈玮(2023).ChatGPT与高等教育:人工智能如何驱动学习变革[J].重庆理工大学学报(社会科学),37(5):26-33.

[20]张绒(2023).生成式人工智能技术对教育领域的影响——关于ChatGPT的专访[J].电化教育研究,44(2):5-14.

[21]中华人民共和国教育部(2021).教育部等六部门关于推进教育新型基础设施建设构建高质量教育支撑体系的指导意见[EB/OL].[2023-12-20].http://www.moe.gov.cn/srcsitenMKi7j9w6bo1VhP9KvI9BQ==/A16/s3342/202107/t20210720_545783.html.

[22]朱永新,杨帆(2023).ChatGPT/生成式人工智能与教育创新:机遇、挑战以及未来[J].华东师范大学学报(教育科学版),41(7):1-14.

[23]Aljanabi, M. (2023). ChatGPT: Future Directions and Open Possibilities[J]. Mesopotamian Journal of Cyber Security, (3):16-17.

[24]Du, H., Li, Z., & Niyato, D. et al. (2023). Enabling AI-Generated Content Services in Wireless Edge Networks[J]. IEEE Wireless Communications, 31(3):226-234.

[25]Ekin, S. (2023). Prompt Engineering for ChatGPT: A Quick Guide To Techniques, Tips, and Best Practices[J]. TechRxiv,(9):1-10.

[26]Else, H. (2023). Abstracts Written by ChatGPT Fool Scientists[J]. [EB/OL]. [2023-12-20]. https://www.nature.com/articles/d41586-023-00056-7.

[27]Ennis, R. H. (1989). Critical Thinking and Subject Specificity: Clarification and Needed Research[J]. Educational Researcher, 18(3):4-10.

[28]Ennis, R. H., & Weir, E. E. (1985). The Ennis-Weir Critical Thinking Essay Test: An Instrument for Teaching and Testing[M]. Pacific Grove: Midwest Publications:1-14.

[29]Facione, N. C., Facione, P. A., & Sanchez, C. A. (1994). Critical Thinking Disposition as a Measure of Competent Clinical Judgment: The Development of the California Critical Thinking Disposition Inventory[J]. The Journal of Nursing Education, 33(8):345-350.

[30]Giray L. (2023). Prompt Engineering with ChatGPT: A Guide for Academic Writers[J]. Annals of Biomedical Engineering, 51(12):2629-2633.

[31]Halpern, D. F. (1998). Teaching Critical Thinking for Transfer Across Domains: Dispositions, Skills, Structure Training, and Metacognitive Monitoring[J]. The American Psychologist, 53(4):449-455.

[32]Hattie, J., & Timperley, H. (2007). The Power of Feedback[J]. Review of Educational Research, 77(1):81-112.

[33]Liu, P., Yuan, W., & Fu, J. et al. (2023). Pre-Train, Prompt, and Predict: A Systematic Survey of Prompting Methods in Natural Language Processing[J]. ACM Computing Surveys, 55(9):1-35.

[34]Newman, D. R., Webb, B., & Cochrane, C. (1995). A Content Analysis Method to Measure Critical Thinking in Face-to-Face and Computer Supported Group Learning[J]. Interpersonal Computing and Technology, 3(2):56-77.

[35]Supena, I., Darmuki, A., & Hariyadi, A. (2021). The Influence of 4C (Constructive, Critical, Creativity, Collaborative) Learning Model on Students’Learning Outcomes[J]. International Journal of Instruction, 14(3):873-892.

[36]Wang, D., Liu, H., & Hau, K. (2022). Automated and Interactive Game-Based Assessment of Critical Thinking[J]. Education and Information Technologies, 27(4):4553-4575.

[37]Watson, G., & Glaser, E. M. (1980). Watson-Glaser Critical Thinking Appraisal[M]. San Antonio, TX: Psychological Corporation:24-31.

[38]Zlatkin-Troitschanskaia, O., Shavelson, R. J., & Schmidt, S. et al. (2019). On the Complementarity of Holistic and Analytic Approaches to Performance Assessment Scoring[J]. British Journal of Educational Psychology, 89(3):468-484.

Empowering Critical Thinking Assessment with Generative Artificial Intelligence:

An Experiment Based on ChatGPT

Abstract: Empowering the innovation of education assessment with generative artificial intelligence technology has become a hot topic in the education evaluation reform of the digital age. In order to authentically reflect individuals’ critical thinking levels, the assessment have gradually shifted from mere skill evaluation to comprehensive assessment of reasoning, argumentation and information credibility in real-world contexts. The appI0B25dg8Sp11p0WNQz9bSYpJk871qe9xm0SKHVDNUJU=lication of ChatGPT in critical thinking assessment helps enrich the evaluation content, innovate the interaction modes, and enhance the efficiency and accuracy of assessment, providing new perspectives and methods for multi-dimensional critical thinking evaluation. Based on the critical thinking assessment framework and a five-dimensional assessment rubric, a ChatGPT-based online platform is used to assess the critical thinking levels reflected in 186 argumentative essays from 31 university students. The findings reveal that ChatGPT, as a writing aid, significantly improve students’ argumentative writing abilities in three themes of writing, which are “weighing the pros and cons”, “graphics-based contexts” and “opposing viewpoints”. Moreover, the critical thinking assessment conducted with ChatGPT demonstrates a high degree of precision, with subtle differences in assessments across different thematic tasks. This result indicates that ChatGPT is highly efficient in capturing and evaluating direct and explicit elements of critical thinking but still has limitations in assessing logical reasoning and the depth of argument. In the future, the design of prompt words should be further optimized to guide ChatGPT to deep understand the critical thinking levels demonstrated in human-machine dialogues, enhancing its adaptability and accuracy in handling complex cognitive tasks, thereby achieving personalized critical thinking evaluation and cultivation.

Keywords: Generative Artificial Intelligence; ChatGPT; Education Evaluation; Critical Thinking Assessment; Prompt Engineering Techniques