基于风险矩阵的教育人工智能应用伦理风险评估

2024-12-03王佑镁倚杨莹柳晨晨

摘要:人工智能伦理风险评估是确保教育领域中人工智能技术安全、合规与可持续应用的有效途径。然而受限于评估方法,当前的相关研究仍处于初步阶段,尚缺乏全面且系统的评估机制和流程。风险矩阵作为一种可视化的风险评估工具,通过将风险的发生概率和影响程度映射到一个矩阵中,可以帮助组织和个体更直观、清晰地识别、评估潜在的风险,进而做出更有针对性的应对策略。从风险管理视角出发,采用风险矩阵构建的教育人工智能应用伦理风险评估方法,包括环境构建、风险识别、风险分析、风险评价和风险处置五个关键步骤。经案例验证,该方法易于操作,且能较为准确地识别、评估人工智能产品在教育领域应用带来的可能风险。但需看到,伦理风险评估是一个动态的过程,需要随着教育和人工智能技术的演进不断完善评估流程,并与教育领域各利益相关者共同努力,协同推动人工智能在教育中的可持续发展。

关键词:教育人工智能;伦理风险;风险矩阵;风险评估;风险管理

中图分类号:G434 文献标识码:A 文章编号:1009-5195(2024)06-0003-08 doi10.3969/j.issn.1009-5195.2024.06.001

一、问题的提出

随着技术迭代创新,人工智能在教育领域的应用从智能辅助教学、教育数据分析到个性化学习不断拓展,深刻地改变着教育教学的面貌。人工智能技术为师生带来了更高效、个性化的学习方式和教学工具,也带来了一系列新的伦理挑战和社会问题,个人数据安全、算法歧视、技术依赖等日益受到广泛关注(白钧溢等,2024)。2021年,联合国教科文组织193个会员国一致通过了《人工智能伦理问题建议书》,该建议书提出了在教育领域使用人工智能时需要考虑的伦理原则,包括透明度、可解释性、公平性、隐私和数据保护等(UNESCO,2021)。国家新一代人工智能治理专业委员会发布的《新一代人工智能伦理规范》中也明确提出,要加强风险防范,及时开展系统的风险监测和评估,建立有效的风险预警机制,提升人工智能伦理风险管控和处置能力(中华人民共和国科学技术部,2021)。

尽管人工智能教育应用伦理问题已经引起了社会的广泛重视,但相关研究仍处于初步阶段,缺乏全面且系统的评估机制与流程。这一方面是由于伦理问题的复杂性和多样性,制定统一且适用的评估标准和方法有一定难度;另一方面,专业评估机构和人员的缺乏,也导致评估结果的信度和效度受到质疑。因此,预测和评估教育领域人工智能应用的伦理风险问题,并采用科学合理方法对伦理风险进行防范,是当前教育人工智能应用过程中亟待解决的问题。本文借鉴风险管理的方法,采用风险矩阵,对教育领域人工智能应用的伦理风险进行评估,通过识别和量化各种潜在风险的发生概率和影响程度,更准确地评估其严重性,并确定应对策略的优先级。这种系统性的评估方法能够为教育实践和政策制定提供更具体和可操作的建议,从而更好地保障人工智能技术在教育领域的可持续、安全和规范化应用。

二、风险矩阵及其风险评估应用

风险矩阵(Risk Matrix)是一种可视化的风险评估工具,它通过将风险的发生概率和影响程度映射到一个矩阵中,以便更清晰地理解和优先处理不同风险(李素鹏,2013)。风险矩阵最早可以追溯到20世纪中期,其初衷是为了帮助企业和组织更好地理解和处理不同风险的复杂性,之后在项目管理和决策制定领域得到了广泛应用。风险矩阵通常由风险发生概率和风险影响程度两个维度组成(Garvey et al.,1998),每个维度划分为若干等级,以便更好地分类和评估风险。等级的划分可以是定量的(如概率的百分比或数字),也可以是定性的(如低、中、高等级)。矩阵的交点处,通过将发生概率和影响程度等级相乘,可以计算出每种风险的综合得分,从而确定哪些风险更为严重,以便有针对性地制定风险应对措施。该方法相较于专家直接判断,由于事先对风险影响和风险概率进行了等级划分(常虹等,2007),评估的准确性更高。

为解决传统风险评估中存在的复杂性、主观性和难以全面考虑不同维度等问题,国内外已有许多学者将风险矩阵应用于风险评估研究中。例如,李梦薇等(2023)在服务机器人领域的人工智能伦理风险评估设计与实践中,将风险发生的可能性与算法风险影响相结合,构建风险矩阵,得出风险评级;杜文静等(2022)通过风险矩阵分析法和Borda序值法,对“双减”政策实施关键期的风险进行了评估与赋值,并结合政策实践深入分析了潜在的风险隐患,并成功识别出高风险致灾因子;Acramel等(2024)利用风险矩阵方法,通过确定故障模式、影响及相关原因,对注射用抗癌药物的影响进行严重性及原因发生概率评分,从而得到注射用抗癌药物使用的关键性指数。也有学者基于风险矩阵理论构建相关的风险评估流程。例如,徐自强等(2022)基于国家标准《风险管理 风险评估技术》(GB/T27921—2011)构建了包括风险识别、风险分析和风险评价等主要步骤的师范生公费教育政策执行的风险评估框架;陈蔚等(2020)运用改进风险矩阵法对学校体育竞赛风险进行结构性评估,初步建立了包括风险识别、风险评估、风险应对三个环节的评估流程。由此可知,风险矩阵作为一种有效的风险评估工具,已被广泛应用于教育领域的研究与实践中。

风险矩阵的优势在于其可以通过将风险发生的可能性与风险影响相结合,实现对风险的量化评估,同时提供一种直观的方式来识别那些可能对教育组织产生较大影响的风险,促使组织对风险进行更系统化、有序的管理,进而更好地分配资源和控制风险。将风险矩阵应用于教育领域人工智能应用伦理风险评估的理由包括:首先,风险矩阵作为一种有效的风险评估工具,能够提供一个系统的框架,帮助组织或个体全面、细致地分析教育领域在引入和应用人工智能时可能带来的潜在风险。其次,利用风险矩阵对人工智能在教育领域广泛应用带来的伦理问题进行风险评估,可以更加清晰地了解这些问题的潜在影响,为制定有效的应对策略提供科学依据。最后,教育领域的人工智能应用伦理风险评估是一个复杂而系统的过程,需要综合考虑技术、伦理、法律等多方面的因素。风险矩阵作为一种结构化的评估方法,能够将这些因素有机地结合在一起,提供一个全面、系统的风险评估框架。然而,需要注意的是,风险矩阵是一种简化工具,对于某些复杂的风险情境可能需要结合其他风险管理工具和方法一起进行评估,特别是涉及众多变量和多样化利益相关者的教育场景中,风险管理可能受到多元变量和主体的影响,评估的复杂度较高,仅依靠单一工具,较难做出准确评估。

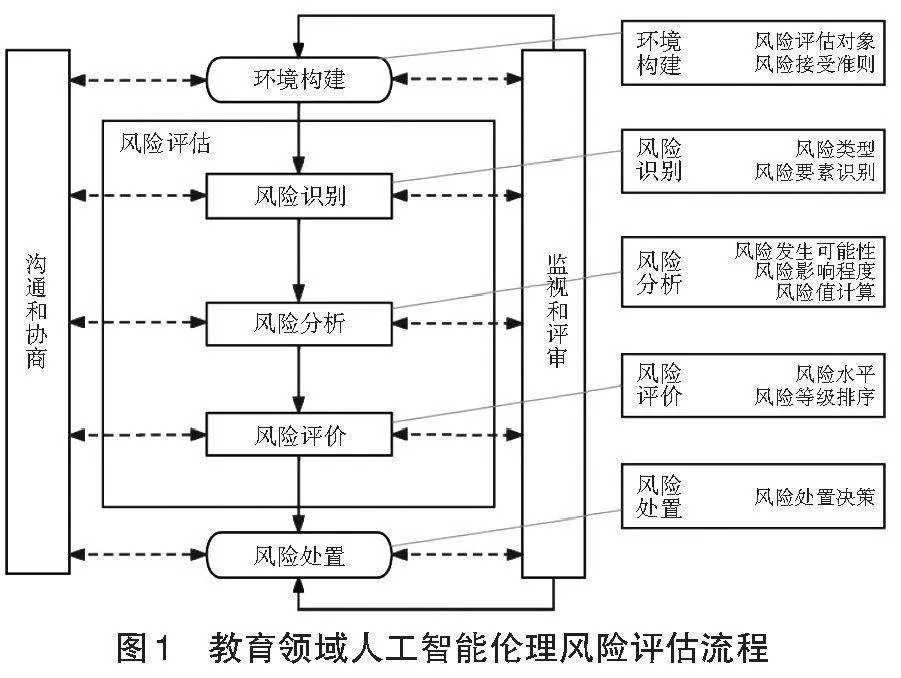

三、教育人工智能伦理风险评估方法与流程

ISO 31000是国际标准化组织(International Organization for Standardization,ISO)于2009年发布的一系列标准,旨在帮助组织管理风险(ISO,2009)。该标准的最新版本是2018年发布的一套风险管理准则,全称《ISO 31000:2018 风险管理——原则和指南》(ISO 31000:2018 Risk Management—Principles and Guidelines)。在这个版本中,ISO 31000标准进行了一些修订,重点指导风险管理框架的设计和实施,以更好地满足风险管理的实践和需要。本文采用ISO 31000标准来设计教育领域人工智能应用的伦理风险评估方法与流程,具体包括环境构建、风险识别、风险分析、风险评价以及风险处置等环节,全面覆盖整个风险评估过程,如图1所示。

1.环境构建

环境构建涉及对风险评估环境的全面认知,包括明确风险评估对象及风险接受准则,目的在于为后续评估工作提供一个清晰、明确且符合实际需求的背景,确保整个评估过程能够有的放矢,并取得切实有效的成果。因此,在正式的风险评估开始之前,需要对环境进行全面的了解和分析。当前人工智能在教育中的具体应用场景,包括智能教学过程、智能教育评价、智能教育管理与服务等(徐和祥等,2023)。这些应用不仅带来了巨大的益处,例如,满足多样化学习需求的教学环境、精准支持学生的人性化学习过程、提升教师工作效率、促进教育评价的增值以及实现学习管理智能化等,同时也伴随着一系列潜在的风险和挑战。为了更好地理解这些风险和挑战,评估者需要明确风险评估对象及风险接受准则。

(1)风险评估对象

风险评估对象一般包括数据、软件、硬件、人员、服务五大类别(郭宁,2006)。如表1所示,教育领域人工智能伦理风险评估范围限定于人工智能技术在教育领域的应用安全,评估依据主要有《信息安全技术 信息安全风险评估方法》(GB/T 20984—2022)和《信息安全技术 信息安全风险评估实施指南》(GB/T 31509—2015)。通过界定明确的评估对象及范围,可以更精确地识别与之相关的潜在伦理风险,为不同评估对象所涉及的伦理问题制定差异化、针对性的管理策略。第一,数据。教育系统中涉及大量的敏感数据,风险可能源于数据泄露、数据滥用、数据质量问题或数据处理的不当行为。不准确的数据可能导致基于错误信息的决策,影响教学管评(冯锐等,2020)。第二,软件。软件的安全性和稳定性直接关系到教育过程的顺利进行。风险可能来自软件漏洞、未经授权的访问、恶意软件或不稳定的系统。例如,一款学习监控软件在未经学生同意的情况下收集了大量学生的行为数据,可能引发隐私保护和伦理道德争议。第三,硬件。硬件包括教育系统中的智能设备、机器人助教、一卡通、智慧门禁、智能安防等教学、管理和服务设备。硬件风险可能来自过度依赖设备、算法偏见与歧视。例如,智能设备的便捷性可能导致教育过程过度依赖技术,而忽略了教育过程中其他重要的因素,如教师的角色、学生的需求以及情感交流等。第四,人员。人员是指与教育系统相关的所有人,包括教育工作者、学生、管理员、家长等。风险一方面可能来自自身,如丧失自主权、过度依赖人工智能技术、忽视技术局限等;另一方面可能来自外部威胁,如受到监视与监管、隐私泄露、算法歧视与偏见等。第五,服务。服务这一类别包括提供人工智能辅助教育服务的技术支持和维护。风险可能来自教学资源质量低下、行为受限、思维创新受限以及人工智能算法的偏见等。例如,一款人工智能辅助学习平台使用的算法在学生评估中表现出性别偏见,可能导致对学生的不公平评估,影响学生的学业发展。通过综合评估这些目标类别,教育组织能够制定有效的风险管理策略,最大程度地保护利益相关方的权益,确保教育系统的顺利运行。

(2)风险接受准则

风险接受准则是基于法律法规、行业规范以及社会普遍期望,为评估提供的一个判断风险是否可接受的基准,是评价风险重要程度的依据(丁辉,2020)。在环境构建的过程中,教育组织需要明确定义其在面对伦理风险时的风险接受水平,建立一套明确的标准,以便通过评估风险值来量化评估潜在伦理风险的等级。一般而言,风险值的计算公式为:风险值=风险发生概率×风险影响程度。其中,风险值的取值范围根据风险发生概率和风险影响程度的取值范围而有所变化。本研究将风险发生概率和风险影响程度的取值范围限定在1到5之间,通过计算可得到如表2所示的风险接受准则。

2.风险识别

风险识别是指发现、承认和描述风险要素的过程。该过程旨在全面、系统地辨识可能对教育系统、学生和教育工作者造成不利影响的潜在伦理风险。教育人工智能伦理风险的识别主要包括风险类型的确定、风险诱因的分析以及风险因素的描述。本文通过梳理相关文献和探究人工智能技术在教育领域的实际应用现状,依据风险源、技术流、效应期三条路径构建伦理风险分类体系,形成技术本体、教育数据、机器算法、教育应用四大伦理风险类型,并将其划分为一级维度(王佑镁等,2023)。在二级维度中,技术本体伦理风险分为技术“拜物教”与技术依赖两类;教育数据伦理风险分为泄露数据与隐私、数据失真与数据滥用三类;机器算法伦理风险分为算法歧视与偏见、算法同质推荐、算法固化与算法不透明四类;教育应用伦理风险分为重构师生关系、丧失自主权、破坏教育公平与反馈避责四类,最后共计形成13个风险因素,分别编号C1~C13,每个风险因素的描述见表3。在整个风险识别过程中,构建风险分类体系有助于系统性地理解潜在伦理挑战,为制定有针对性的风险管理策略提供指导。

3.风险分析

风险分析是考虑风险发生的可能性及后果严重程度的过程,其核心目标是在风险识别的基础上,深入挖掘各个风险类型的潜在威胁,以全面洞察其可能产生的影响。风险的影响因素可以划分为发生概率与影响程度两个维度,教育领域人工智能应用的伦理风险值也由风险发生概率与风险影响程度两个因素共同决定。按照前文提及的风险值计算公式,二者与整体风险大小均为正比关系。本文采用国际标准化组织提倡的5×5阶矩阵,将风险的发生概率与影响程度分别划分为5个等级(ISO,2008)。其中,风险发生概率按照风险可能发生的概率,划分为极低、低、中等、高、极高5个等级尺度,分别对应数字1~5级;风险影响程度按照风险可能产生的严重后果,也划分为5个等级尺度,分别是极小、小、中等、大、极大,对应数字等级1~5级,二者形成的风险矩阵如表4所示。风险评估的结果由二者的乘积得出。因此,要计算风险大小,就要分别对发生概率与影响程度进行评估。

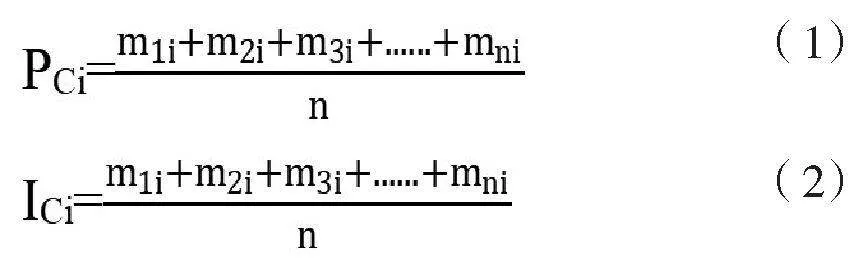

本研究采用专家评估法对上述所识别的风险因素进行评分。基于专家等权的原则,风险发生概率和风险影响程度的计算公式分别为:

其中,m代表专家的打分结果,n代表打分的专家数量,Ci代表第i个风险因素,PCi代表Ci风险因素的发生概率,ICi代表Ci风险因素的影响程度。

4.风险评价

风险评价是确定每个风险因素风险等级的过程。依据已经设定的评价准则,利用风险矩阵判断各种潜在风险的大小是否处于可接受或可容忍的范围之内,以此确定每个风险因素的级别(高昕欣,2014)。风险评价涉及将风险分析中获得的风险值与事先设定的风险接受准则进行比对,包括对风险影响程度、发生概率等因素的全面评估,旨在确保所设定的风险接受准则充分覆盖了教育组织关注的各个方面。确定好风险值后,根据风险接受准则中定义的风险等级,将风险值小于5的记为低风险,低风险存在较小的安全威胁和潜在损害,为不需要评审即可接受的风险;将风险值大于等于5且小于等于12的记为中风险,中风险存在一定的安全威胁和潜在损害,需要进一步评估再决策;将风险值大于12的记为高风险,高风险存在严重的安全威胁和潜在损害,必须进行处置以降低风险。这一阶段是风险管理的关键步骤,为教育组织提供了决策的基础,使其能够在权衡风险和收益的同时,合理配置资源、采取措施,从而实现对风险的有效管理。

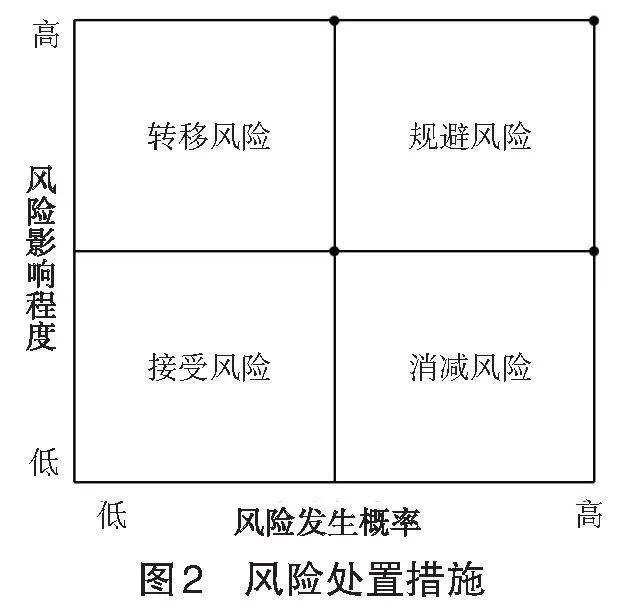

5.风险处置

风险处置是指针对不同等级的风险,依照风险接受准则的要求制定不同的处置策略,具体可采用转移风险、规避风险、接受风险和消减风险四种处置措施(陈蔚等,2020),如图2所示。各类风险处理方式的选择应该兼顾管理与技术,具体处置措施应根据人工智能技术应用的实际情况慎重考虑。

第一,转移风险。转移风险是4dd1f00f6b560ea9d1fc3e0f716744f5指通过购买保险、外包等方法把风险转移到外部机构的风险应对策略。转移风险策略主要针对那些发生概率较低但影响较大的潜在风险。在应用人工智能技术时,可以寻找符合教育行业需求的保险产品,并与相应的保险公司合作,通过风险转移的方式,确保在应对伦理问题时有适当的经济支持。例如,为教育组织购买专门的责任保险,以应对可能出现的学生隐私、教育公平性被侵犯等风险。

第二,规避风险。规避风险是指采取措施或行动,以减少或避免可能发生的不利事件或损失的风险处置策略,如在开发和实施人工智能技术时,规避可能引起伦理问题的活动,包括限制某些敏感数据的使用和避免实施可能导致歧视的算法等。例如,在人工智能应用的开发阶段,对算法进行严格审查,确保其遵循道德和法规标准,通过制定清晰的政策禁止或限制特定类型的数据使用来预防潜在的伦理问题。规避风险策略主要针对那些影响较大且发生概率也较大的风险。

第三,接受风险。接受风险是指针对风险值不高的风险,采取直接接受的处置策略。对于风险值相对较低的情况,教育组织可以通过建立监测和应对机制来接受这些风险。但在此过程中,要确保能够迅速识别风险并即时采取行动,从而将潜在的负面效应降至最低。

第四,消减风险。风险消减有两方面的含义:一是降低风险发生的概率;二是一旦风险事件发生,尽量降低其损失(丁辉,2020)。消减风险主要针对影响较小,但发生概率较大的风险,指通过适当的控制措施降低风险发生的可能性的应对策略。我们可以通过采取适当的控制措施来降低人工智能系统引起的伦理风险,包括增加透明度、建立审查机制、采用公平的算法等。例如,可引入伦理审查小组,负责审查和监督人工智能应用的设计和实施。

在风险处置措施实施后,需持续开展沟通与协商工作,并加强监视与评审活动,以确保所采取的措施达到预期效果。首先,需要在教育组织各个层面建立恰当的治理机制和有效的沟通流程,确保关键信息能够在内外部利益相关者之间流通,从而支持有效的决策制定和实施。制定专门的沟通计划是确保教育组织内外部利益相关者充分理解风险处置措施、实施过程以及最新的伦理风险评估结果的关键步骤。其次,设立监测和评估机制,对实施的风险控制措施进行持续跟踪和评估,以便及时发现新的风险或明确已有措施的有效性,确保处置计划的可持续性和适应性。最后,进行定期的审查和更新,以确保伦理风险评估和处置计划持续适应新的技术、法规或伦理标准的变化。通过建立强有力的监测和评估机制,以及定期审查和更新风险处置计划,教育领域可以更好地应对不断变化的伦理挑战,确保人工智能在教育中安全和负责任的应用。

四、教育人工智能伦理风险评估应用案例

1.实例选取

本文以温州市某中学引入智能监控系统为例,进行教育人工智能应用伦理风险评估。该系统由于利用人脸识别技术实现校园出入管理,可能引发伦理风险,需要进行伦理风险评估。按照风险评估流程,研究者首先从环境角度,充分考虑学校、教师、学生、家长等利益相关者的意见和建议,确保风险评估的全面性和公正性;其次,风险识别部分,选取教育人工智能应用伦理风险评估指标体系中的二级指标作为风险因素(见表3);最后,通过问卷的方式邀请5位专家,基于该中学人脸识别技术应用的实际情况,对上述13个风险因素的发生概率及影响程度分别进行评分。

2.数据计算

根据公式(1)和(2)分别计算出风险发生概率和风险影响程度的专家打分结果,再取5位专家打分的平均值,得到如表5、表6所示结果;然后根据风险值计算公式,可得到13个伦理风险因素的风险等级情况(如表7所示)。

3.评估结果分析

通过风险评估结果可以看出,所识别风险中技术本体伦理风险类别下的“技术拜物教”(C1)、机器算法伦理风险类别下的“算法固化”(C8)、教育应用伦理风险类别下的“破坏教育公平”(C12)风险较小;技术本体伦理风险类别下的“泄露数据与隐私”(C3)风险很高,可重点考虑该类风险事件,并针对性地进行管理及维护。例如,制定严格的数据保护政策和流程,明确数据的收集、存储、处理、传输和销毁等各个环节的安全要求。其余因素均为中风险因素,表明需进一步监控和管理以确保风险的控制和降低。例如,针对“技术依赖”(C2)风险,可选择转移风险应对策略,即不依赖单一的人脸识别技术,而是采用多元化的身份验证方法,如指纹识别、声纹识别、虹膜识别等,降低系统受单一技术故障影响的风险。针对“数据滥用”(C5)风险,可选择消减风险策略,对收集到的人脸数据进行加密和匿名化处理,以有效保护数据的安全,防止未经授权的访问和滥用;同时明确数据的使用范围应仅限于特定的、合法的领域,禁止将数据用于其他未经授权的领域。

五、结语

在教育领域应用人工智能技术时进行科学有效的伦理风险评估,对于确保技术的合理应用与教育的健康发展至关重要。本文参考了国际标准化组织(ISO)的风险管理框架,并结合风险矩阵,对伦理风险评估的各个环节进行了详尽的探讨,包括环境构建、风险识别、风险分析、风险评价、风险处置等。通过这一流程,研究者可以快速评估人工智能产品在教育领域应用可能引发的潜在伦理风险及其影响,进而制定合理的风险处置计划和决策策略,确保人工智能在教育中的合理、负责任应用。同时我们也要认识到,伦理风险评估是一个动态的过程,随着教育领域和人工智能技术的不断演进,新的伦理问题可能随之而来。因此,需要在实践中积累经验,不断完善评估流程,并与教育领域的各方利益者共同努力,协同推动人工智能在教育中的可持续发展。只有通过持续的合作和创新,才能更好地应对伦理挑战,确保人工智能在教育领域中的应用能够为教育带来实质性的益处。

参考文献:

[1]白钧溢,于伟(2024).教育人工智能伦理原则的有限性及其补正——兼论“原则—美德—法律”框架[J].中国电化教育,(2):23-31.

[2]常虹,高云莉(2007).风险矩阵方法在工程项目风险管理中的应用[J].工业技术经济,(11):134-137.

[3]陈蔚,李燕燕,黄明明等(2020).基于改进风险矩阵法的学校体育竞赛风险评估研究[J].武汉体育学院学报,54(10):72-79.

[4]丁辉(2020).安全风险术语辨析(连载之六)[J].中国应急管理科学,(6):94-99.

[5]杜文静,姜晨(2022).“双减”背景下校外培训治理风险评估[J].现代教育论丛,(4):63-72,111.

[6]冯锐,孙佳晶,孙发勤(2020).人工智能在教育应用中的伦理风险与理性抉择[J].远程教育杂志,38(3):47-54..

[7]高昕欣,叶惠,康永博(2014).基于风险矩阵的企业技术创新风险管理研究[J].科技管理研究,34(16):8-11,17.

[8]郭宁(2006).信息安全风险评估指标体系研究[J].信息技术与标准化,(5):17-21.

[9]李梦薇,徐峰,晏奇等(2023).服务机器人领域人工智能伦理风险评估方法的设计与实践[J].中国科技论坛,(10):74-84.

[10]李素鹏(2013).风险矩阵在企业风险管理中的应用:详解风险矩阵评估方法[M].北京:人民邮电出版社:23-24.

[11]王佑镁,王旦,王海洁等(2023).基于风险性监管的AIGC教育应用伦理风险治理研究[J].中国电化教育,(11):83-90.

[12]徐和祥,申利侠(2023).“智能+教育”:应用场景、风险挑战与治理对策[J].复旦教育论坛,21(2):24-30.

[13]徐自强,赵焱鑫(2022).师范生公费教育政策执行风险评估与应对[J].黑龙江高教研究,40(12):33-40.

[14]中华人民共和国科学技术部(2021).《新一代人工智能伦理规范》发布[EB/OL].[2023-10-12].https://www.most.gov.cn/kjbgz/202109/t20210926_177063.html.

[15]Acramel, A., Blondee-Gomes, S., & Dupré, M. et al. (2024). Advanced Prescription of Injectable Anticancer Drugs: Safety Assessment in a European Comprehensive Cancer Centre Using the Risk Matrix Approach[J]. British Journal of Clinical Pharmacology, 90(5):1333-1343.

[16]Garvey, P. R., & Lansdowne, Z. F. (1998). Risk Matrix: An Approach for Identifying, Assessing, and Ranking Program Risks[J]. Air Force Journal of Logistics, 22(1):18-21.

[17]ISO (2008). ISO/IEC 27005: 2008. Information Technology—Security Techniques—Information Security Risk Management[S]. Geneva, Switzerland: International Standards Organization:32-57.

[18]ISO (2009). ISO 31000: 2009. Risk Management— Principles and Guidelines[S]. Geneva, Switzerland: lnternational Organization for Standardization:5-33.

[19]UNESCO (2021). Draft Text of the UNESCO Recommendation on the Ethics of Artificial Intelligence[EB/OL].[2023-10-01]. https://unesdoc.unesco.org/ark:/48223/pf0000378426.