基于多特征融合时差网络的带式输送机区域违规行为识别

2024-10-01马天姜梅杨嘉怡张杰慧丁旭涵

摘要:现有的煤矿井下带式输送机区域违规行为(如攀爬、跨越、倚靠带式输送机等)识别方法对特征提取不充分、难以考虑到行为时间差异,导致违规行为识别准确率不高。针对该问题,基于ResNet50 模型,提出了一种基于多特征融合时差网络(MFFTDN)的带式输送机区域违规行为识别方法,将多特征融合和时间差分进行结合,对不同时间段的行为进行多特征融合。首先在原始模型ResNet50 的第2 和第3 阶段引入短期多特征融合(STMFF) 模块,将来自多个连续帧的时间和特征拼接在一起,再对融合后的特征进行时间差分计算,即相邻帧的特征差值,以在短期内捕捉局部动作变化。然后在原始模型ResNet50 的第4 阶段引入长期多特征融合(LTMFF) 模块,将来自连续帧的短期多特征拼接在一起,再对相邻时间点的特征进行时间差分计算,以获取行为的长期多特征。最后将融合后的特征进行分类,输出识别结果。实验结果表明:① 该方法的平均精度和准确率较原始模型ResNet50 分别提高了8.18% 和8.47%,说明同时引入STMFF 和LTMFF 模块能够有效提取到不同时间段的多特征信息。② 该方法在自建煤矿井下带式输送机区域违规行为数据集上的准确率为89.62%,平均精度为89.30%,模型的参数量为197.2 ×106。③ Grad−CAM 热力图显示,该方法能够更有效地关注到违规行为的关键区域,精确捕捉到井下带式输送机区域的违规行为。

关键词:带式输送机;不安全行为;违规行为识别;短期多特征融合;长期多特征融合;多特征融合时差网络;时间差分

中图分类号:TD634 文献标志码:A

0 引言

大量的数据统计表明,由于煤矿井下作业人员的违规行为所引发的死亡事故占煤矿安全事故的80% 以上, 其中带式输送机区域的安全事故占27%[1]。识别带式输送机区域的违规行为可减少人员伤亡,具有重要的实际意义。通过参考煤矿安全管理条例,概括出几种带式输送机区域频繁发生的典型矿工不安全行为:攀爬、跨越、倚靠带式输送机等。当前对矿工违规行为的识别主要通过人工观看视频的方式,极易造成工作人员视觉疲劳而引发漏判或误判现象。随着计算机技术的发展,使用计算机技术代替人工识别违规行为成为研究热点之一。

目前井下违规行为的主要识别方式包括物联网监测[2-3]和计算机视觉识别。物联网监测是通过在矿工身上佩戴传感器,采集由不同行为引发的运动数据,然后分析数据的差异来进行识别。但传感器随着使用次数的增加会逐渐老化,矿井下复杂的环境会导致传感器信号带有许多噪声,从而影响识别结果,不能满足实际需求。基于计算机视觉的井下行为识别以端到端的方式从数据中学习特征,再进行分类。按照网络结构的不同可分为基于卷积神经网络(Convolution Neural Networks,CNN)的行为识别[4-5],基于循环神经网络(Recurrent Neural Networks,RNN)的行为识别[6]、基于双流卷积神经网络的行为识别[7-8]和基于混合深度学习网络的行为识别[9-10]。这些方法能更准确地识别复杂行为模式,具有更高的识别准确性和可靠性。按照卷积的不同,将CNN 分为2D 卷积网络和3D 卷积网络,其中,2D 卷积网络提取空间特征,但对时间信息不够敏感,而3D 卷积网络则在保留通道信息的同时处理时间信息,能更有效地捕捉视频动态行为。基于RNN 的行为识别方法能够有效地捕捉各帧之间的相关性,但数据量较大时,调参的过程相对复杂。双流卷积神经网络可以有效地融合2 个独立网络的输出,但融合过程可能增加模型设计的复杂性。混合深度学习网络结合了不同网络模型的优点,提高了模型的适应性和泛化性,但也面临着计算成本的挑战。在井下行为识别中,不同场景的行为识别需求和挑战有所不同,而带式输送机通常处于狭窄、通风条件有限的环境中,容易受到煤尘、光照等因素的影响,现有方法在识别该区域的行为时可能会对部分行为的特征提取不完全,从而影响识别效果。

针对带式输送机区域,文献[11]提出了一种基于改进运动历史图描述矿工行为过程的方法,该方法的识别准确率较高,但只适合较为简单的场景,当存在遮挡时会影响准确率。在解决带式输送机区域复杂多变的环境和动作问题时,使用单一特征建模可能会面临一些限制,没有考虑到动作的多样性、动作变化的实时性,导致难以捕捉到动作的更细粒度的特征。使用多特征融合建模时,能够很大程度地提高模型的准确率。文献[12]提出了一种组合注意力机制和密集残差的方法来改进模型,以识别矿工安全、违规乘坐带式输送机,在行为较相似时也能够较好地识别出来。然而,这种方法在制作基于关键点的行为识别数据集时存在一定的难度。文献[13]提出了基于双流模式的高层场景特征融合方法,对Gist 特征进行更高层次的学习并实现对原始图像的语义抽象,对井下带式输送机区域的抛扔杂物、跨越、攀爬等不安全行为进行识别,该方法具有较高的识别率,但需要将多种网络进行融合,复杂度较高,处理速度不足以满足要求,且未能考虑到动作在不同时间内的变化差异,使用单一的时间尺度不能进行更加精细的区分。

针对目前煤矿井下带式输送机区域违规行为识别方法在特征提取方面存在的不足,且难以有效考虑行为的时间变化,本文提出一种基于多特征融合时差网络(Multi-feature Fusion for Time-difference Networks,MFFTDN)的带式输送机区域违规行为识别方法,将多特征融合[14]和时间差分[15]结合,对不同时间段的行为进行多特征融合。首先在原始模型Res-Net50 的第2 和第3 阶段引入短期多特征融合(ShorttermMulti-featur Fusion,STMFF)模块,将来自多个连续帧的时间和特征拼接在一起,再对融合后的特征进行时间差分计算,即相邻帧的特征差值,以在短期内捕捉局部动作变化。然后在ResNet50 的第4 阶段引入长期多特征融合(Long-term Multi-feature Fusion,LTMFF)模块,将来自连续帧的短期多特征拼接在一起,再对相邻时间点的特征进行差分计算,以获取行为的长期多特征。最后将融合后的特征进行分类,输出识别结果。

1 MFFTDN 架构

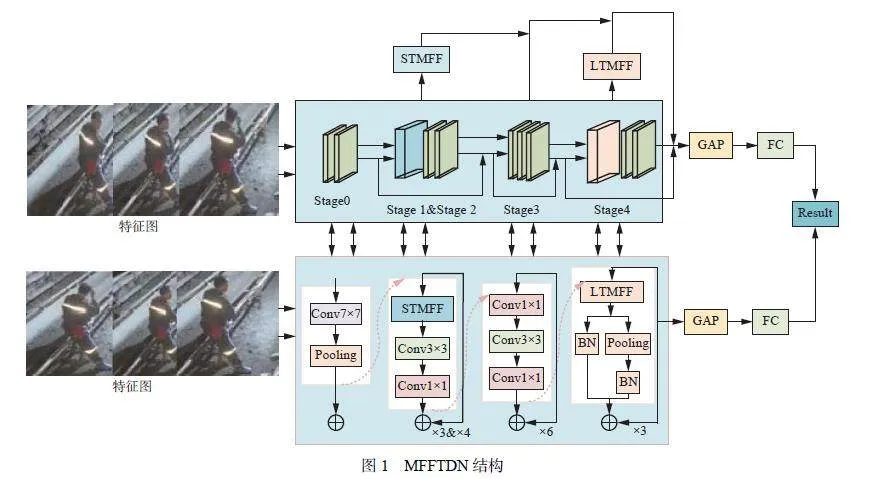

单特征建模忽略了全局信息,无法彻底捕捉到动作特征。MFFTDN 则能充分利用完整的视频信息来学习动作的多个特征,并使用视频帧均匀采样来提高效率,结构如图1 所示。MFFTDN 基于ResNet50模型,在stage0 到stage4 这5 个阶段中插入STMFF和LTMFF 模块。其中,stage0 阶段和stage3 阶段为ResNet50 网络的原始模块,stage0 阶段由7×7 的卷积层和最大池化层组成, stage3 阶段由1×1 的卷积层和3×3 的卷积层堆叠而成(这种堆叠重复6 次)。在stage1 阶段和stage2 阶段中,将第1 个1×1 的卷积层替换为STMFF 模块,其余保持不变,并分别重复堆叠3 次和4 次。将stage4 阶段替换为LTMFF,并重复堆叠3 次。

首先,对于一组给定的行为帧序列,经stage0 阶段对视频帧进行下采样并降低维度。其次, 经stage1 和stage2 阶段提取行为的短期多特征,再将这种特征输入到stage3 阶段提取更深层次的信息。然后,将更深层次的信息输入到stage4 阶段以提取行为的长期多特征信息。最后,将所提取的特征信息经全局平均池化层和全连接层输出行为预测结果。

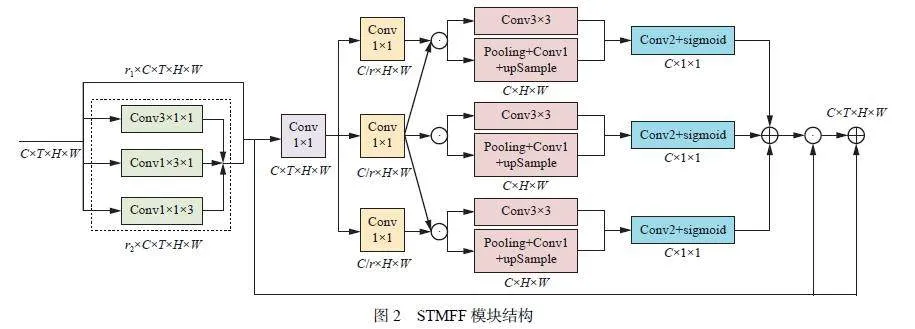

1.1 STMFF 模块

由于相邻帧在局部窗口中差别不大,模型对视频中的帧进行了采样,平均每8 帧采样1 帧。STMFF在网络的早期提取局部的短期多特征信息, 如图2 所示。

首先将大小为H ×W ×C ×T的特征图Fin沿着通道进行分裂,其中H 为高度,W 为宽度,T 为时间。设沿着c1方向的分裂系数为r1, 分裂后的特征为F1 = r1 · Fin。沿着c2方向的分裂系数为r2, 使用3×1×1的卷积核对特征图的高度−宽度特征进行建模,得到FH×W。使用3×1×1的卷积核对特征图的高度−时间进行建模,得到FH×T。使用1×1×3的卷积核对特征图的宽度−时间进行建模, 得到FW×T。将FH×W,FH×T,FW×T融合, 得到初步融合后的特征F2 ∈ RH×W×C×T,接着将F2与F1融合得到帧的细节融合特征Fcon ∈ RH×W×C×T。

式中:KH×W,KH×T,KW×T分别为特征图在高度−宽度、高度−时间、宽度−时间方向上的卷积核;i 为特征图帧数;concat 为拼接操作。

其次,为了解决相邻帧之间位置不对齐的问题,使用跨段信息来增强帧之间的关联。使用1×1的卷积将Fcon及其前后帧的特征维度压缩为RH×W×C/r。计算第i-1帧特征图Fi-1和第i 帧特征图Fi之间的对齐时间差D(Fi-1,Fi)、第i帧特征图Fi 和第i+1帧特征图Fi+1 之间的对齐时间差D(Fi,Fi+1),并使用1×1 的卷积核计算第i 帧特征图Fi 与第i-1帧特征图Fi-1 和第i+1帧特征图Fi+1 之间的对齐卷积G(Fi-1)和G(Fi+1)。

D(Fi-1,Fi) = Fi -G(Fi-1) (6)

D(Fi,Fi+1) = Fi -G(Fi+1) (7)

然后,使用时间对齐的多尺度模块来提取短距离运动信息。这一过程主要包括多尺度模块融合操作、卷积和激活卷积结果。多尺度融合模块由conv3×3和“Pooling+Conv1+upSample”构成,其中Conv1×1代表1×1 的卷积,Pooling代表平均池化,up-Sample 代表双线性上采样,在多尺度融合之后特征维度变为RC×H×W。再将RC×H×W的特征使用“Conv2+sigmoid” 进行压缩和激活卷积结果, 即可得到第i−1 帧特征图Fi-1 和第 帧特征图Fi 的短期运动的多尺度运动信息M(Fi-1,Fi) ∈ RC×1×1、第i 帧特征图Fi 与第i+1 帧特征图Fi+1 的短期多尺度运动信息M(Fi,Fi+1) 2 RC×1×1。

式中:s(·) 为sigmoid 函数;N(·) 为1×1 的卷积;Hj 为从不同的感受野j 提取的运动信息。

最后,将短距离运动信息和细节融合特征Fcon融合,得到短期多特征融合信息F ∈ RH×WC×T。

F = Fcon ⊙1=2 [M(Fi-1,Fi)+M(Fi,Fi+1)] (10)

式中⊙为同或运算。

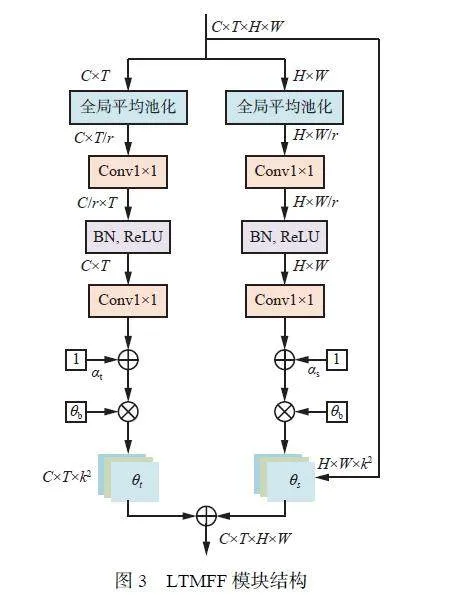

1.2 LTMFF 模块

STMFF 模块能够有效捕捉动作序列的短期特征,但在捕捉动作序列的长期特征时会受到限制。在网络后期,不同行为的时间尺度和空间特征差异更为明显,而LTMFF 模块能够将不同时空段的特征相关联,以更好地利用上下文信息,将该模块同时作用于空间和时间上,对局部多特征进行增强,通过全局角度学习每个特征点的时空信息。为了适应变化粒度更大的时空尺度,将卷积重新设置为自适应时空卷积,如图3 所示。

首先,将大小为H ×W ×C ×T的帧通过时间平均池化和空间平均池化计算得到2 种不同的帧描述向量Vt = P(Xt) Vs = P(Xs)。其中, Xt和Xs分别为第 i帧原始的时间和空间特征,P(·)为全局平均池化,Vt ∈ RC×T Vs ∈ RH×W。

其次,通过采用2 层一维卷积将局部上下文向量Vt和Vs进行堆叠,并以比率r进行维度压缩。同时为了能够获取更大的感受野,进一步纳入全局时空信息,将线性映射函数A(g)添加到局部向量中,得到全局时间信息B(Xt,g)和全局空间信息B(Xs,g),其中g为空间和时间维度上的全局平均集合值。

B(Xt,g) = N(δ(m(N(Vt + A(g))))) (11)

B(Xs,g) = N(δ(m(N(Vs + A(g))))) (12)

式中 (·) 和m(·) 分别为ReLU 函数和batchnorm 函数。

将全局时间信息B(Xt,g)和全局空间信息B(Xs,g)中最后一个卷积的权重初始化为0,再添加常数1,即可得到校准权重αt和αs。

αt = 1+ B(Xt,g) (13)

αs = 1+ B(Xs,g) (14)

然后,将校准权重αt和αs分别与基本权重θb乘,即可得到第i帧的时间权重θt∈RT×C×k2和空间权θs∈RH×W×k2。

Xt = θtXt = (αtθb)Xt (15)

˜Xs = θsXs = (αsθb)Xs (16)

式中Xt和X s分别为校准之后时间和空间特征。

最后,将校准后的时间特征、空间特征和原始特征融合,得到长期多特征融合信息B ∈ RH×W×C×T。

2 实验分析

2.1 数据集构建

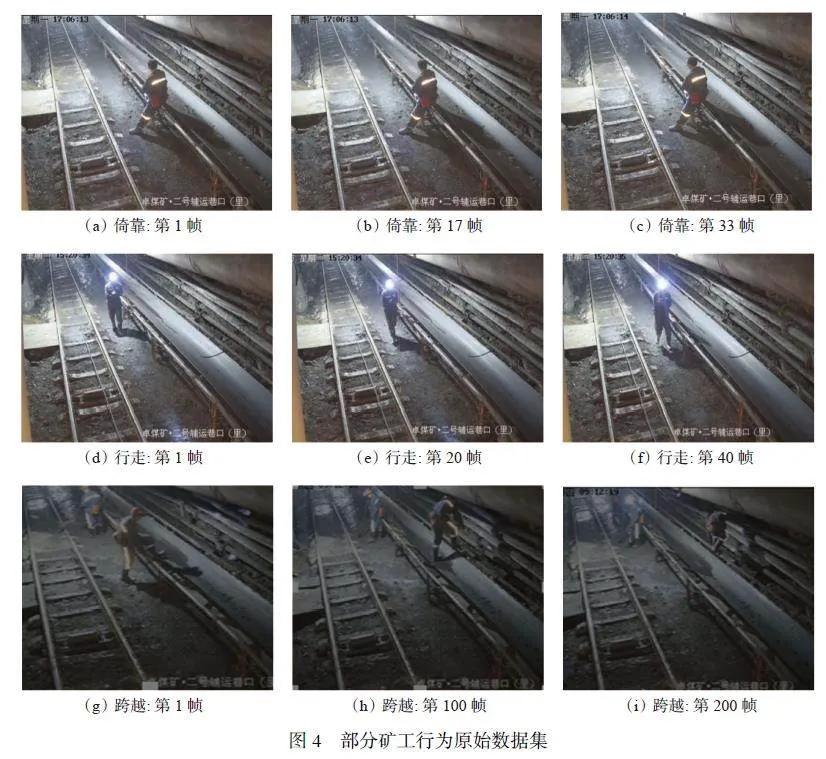

数据集来源于煤矿现场的摄像视频, 涵盖了3 类动作,其中一类是正常行为,另外两类是频繁出现的违规行为,包括攀爬、跨越和倚靠带式输送机。共采集到460 个视频,如图4 所示。为了解决类别间不平衡的问题,采用随机擦除、色彩抖动和镜像翻转对数据集进行增强处理,获得1 230 个视频样本。每个视频的时长为4~7 s,以确保每个行为类别的样本相对平衡。对每个视频进行了分类标注,并按照6∶2∶2 的比例将数据集划分为训练集、验证集和测试集。

2.2 实验设置

选择具有简单和模块化结构的ResNet 作为主干网络,将STMFF 集成到ResNet 的第2 和第3 阶段,以提取行为的短期多特征信息。将LTMFF 集成到ResNet 的第4 阶段, 以提取行为的长期多特征信息。为了加快模型的训练速度,在多特征融合模块中使用可分离卷积。选择PyTorch 框架作为实验的训练模型,并在RTX 3090 硬件平台上进行训练。

训练过程中,设置学习率为0.01,进行25 轮训练, 每隔10 轮学习率衰减为原来的50%, 共进行150 轮训练。为了优化训练过程,采用动量为0.9、动量衰减为10−4 的SGD 优化器,并且每个GPU 处理一小批包含8 个视频剪辑的数据。为了提高训练速度,在视频的时间轴上均匀采样多个片段,并使用softmax 概率的平均值作为最终预测结果,采用准确率和参数量来衡量模型的性能。其中,top1_acc 表示与实际结果相符的类别准确率,mean_acc 表示平均精度,params 表示模型的参数量。

2.3 消融实验

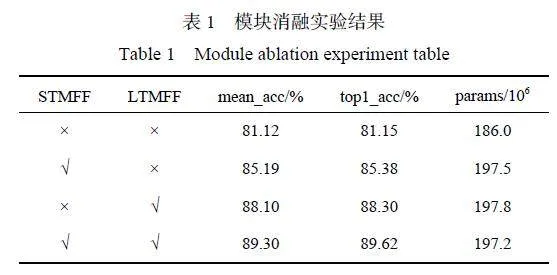

为了证明本文引入STMFF 和LTMFF 模块的有效性,进行消融实验,结果见表1。可看出单独添加STMFF 模块时, mean_acc 和top1_acc 较原始模型ResNet50 分别提升了4.07% 和4.23%,这是由于在早期使用STMFF 模块能有效提取到短期多特征。单独添加LTMFF 模块时,mean_acc 和top1_acc 较原始模型ResNet50 分别提升了6.98% 和7.15%,这是由于在网络后期关联了上下文特征信息,扩大了感受野。当同时添加STMFF 和LTMFF 模块时,mean_acc 和top1_acc 较原始模型ResNet50 分别提高了8.18% 和8.47%,达到89.30% 和89.62%,这是由于同时引入STMFF 和LTMFF 模块能够有效提取不同时间段的多特征信息。

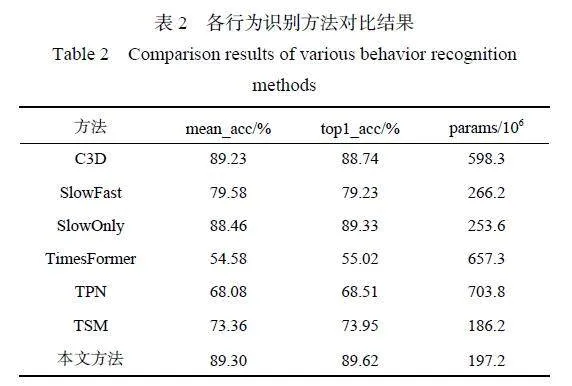

2.4 对比实验

为了验证本文方法的性能,选择现阶段具有代表性的行为识别方法进行比较,包括三维卷积网络(Convolutional 3D,C3D)[16]、仅慢速网络(Slow-OnlyNetwork, SlowOnly) [17]、快慢速网络 (SlowFast Network,SlowFast) [18]、时间偏移网络(Temporal ShiftModule, TSM) [19]、时间敏感变压器 (Time-SensitiveTransformer, TimesFormer)[20]、时间金字塔网络(TemporalPyramid Network,TPN)[21]。各行为识别方法对比结果见表2。

由表2 可看出,本文的参数量为C3D 的1/3,这是因为C3D 同时对动作的三维特征进行建模,提高了识别精度,但需要大量参数,增加了计算量。本文方法的mean_acc 和top1_acc 较SlowFast 方法分别提高了9.72% 和10.39%,参数量较SlowFast 方法减少了25.93%,这是因为SlowFast 方法虽然结合了慢速路径和快速路径的特征,但其时间尺度选择可能不适合井下行为的识别。本文方法的参数量较Slow-Only 减少了28.6%,这是因为SlowOnly 方法使用了较多的卷积层和更大的卷积核,以更高的分辨率来捕捉空间和时间信息。本文方法的mean_acc 和top1_acc 较TimesFormer 方法分别提高了34.72% 和34.6%, 参数量较TimesFormer 方法减少了71.99%,这是因为TimesFormer 方法需要大量的数据集进行训练,本文的数据集无法适应该模型。本文方法的mean_acc 和top1_acc 较TPN 和TSM 方法分别提高了21.22%,15.94% 和21.11%,15.67%,这是因为TPN和TSM 方法主要对空间特征进行建模,而对时间特征的提取很弱。本文方法能够有效将多特征融合和时间差分结合,在提高行为识别准确率的同时,还能保持较低的参数量,更适用于带式输送机区域的违规行为识别。

2.5 可视化结果

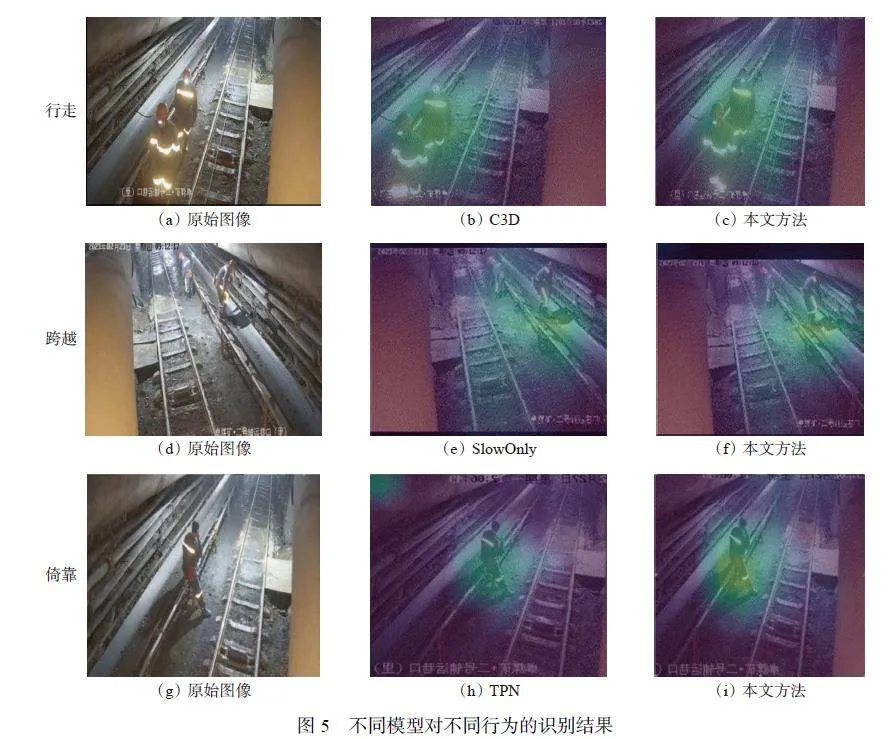

选用可视化工具Grad−CAM 对本文方法和C3D,SlowOnly,TPN 方法进行可视化展示,如图5 所示。

从图5 可看出,对于行走和跨越行为,本文方法、C3D 和SlowOnly 的热力图显示模型主要关注在人物动作上,其中本文方法覆盖范围较为集中,C3D和SlowOnly 覆盖范围较为分散。对于倚靠行为,本文方法的热力图显示其关注点集中在倚靠的姿势上,而TPN 的关注区域相对分散,无法准确捕捉到倚靠动作的细节。这说明本文方法能够更有效地关注到违规行为的关键区域,更精确地捕捉到井下带式输送机区域的违规行为。

3 结论

1) 针对目前煤矿井下带式输送机区域违规行为识别方法准确率不高的问题, 提出了一种基于MFFTDN 的带式输送机区域违规行为识别方法。在早期使用STMFF 模块提取行为的短期多特征,在后期使用LTMFF 模块提取行为的长期多特征,这2 种模块采用可分离卷积的设计方式,从而提高了识别准确率并降低了计算量。

2) 所提方法在自建井下带式输送机区域违规行为数据集上的准确率为89.62%,平均精度为89.30%;与代表性方法C3D,SlowOnly,TPN 和TSM 等相比,该方法能够更有效地识别出带式输送机区域的违规行为;Grad−CAM 热力图显示,该方法能更有效地关注违规行为的关键区域,精确捕捉井下带式输送机区域的违规行为。

3) MFFTDN 在捕捉帧与帧之间动作关联性时的计算时间较长,下一步将研究使用更少的时间来捕捉帧之间的关联特征,在更短的时间内分析出时间差。

参考文献(References):

[ 1 ]张培森,李复兴,朱慧聪,等. 2008—2020 年煤矿事故统计分析及防范对策[J]. 矿业安全与环保, 2022,49(1):128-134.

ZHANG Peisen, LI Fuxing, ZHU Huicong, et al.Statistical analysis and prevention countermeasures ofcoal mine accidents from 2008 to 2020[J]. Mining Safety & Environmental Protection, 2022, 49(1) :128-134.

[ 2 ]赵小虎,黄程龙. 基于Kinect 的矿井人员违规行为识别算法研究[J]. 湖南大学学报(自然科学版),2020,47(4):92-98.

ZHAO Xiaohu, HUANG Chenglong. Research onidentification algorithm of mine person's violationbehavior based on Kinect[J]. Journal of HunanUniversity(Natural Sciences),2020,47(4):92-98.

[ 3 ]PIENAAR S W, MALEKIAN R. Human activityrecognition using visual object detection[C]. IEEE 2ndWireless Africa Conference, Pretoria,2019:1-5.

[ 4 ]梁晨阳,华钢. 基于信道状态信息的井下人员行为识别方法研究[J]. 煤炭技术,2022,41(11):182-186.

LIANG Chenyang, HUA Gang. Research onidentification method of underground personnel behaviorbased on channel state information[J]. CoalTechnology,2022,41(11):182-186.

[ 5 ]ZHANG Xin, ZHU Yan, DENG Li, et al. A slowfastbehavior recognition algorithm incorporating motionsaliency[C]. 2nd International Conference on ComputerGraphics, Artificial Intelligence, and Data Processing,Guangzhou,2022. DOI:10.1117/12.2674969.

[ 6 ]王璇,吴佳奇,阳康,等. 煤矿井下人体姿态检测方法[J]. 工矿自动化,2022,48(5):79-84.

WANG Xuan, WU Jiaqi, YANG Kang, et al. Humanposture detection method in coal mine[J]. Journal ofMine Automation,2022,48(5):79-84.

[ 7 ]党伟超,张泽杰,白尚旺,等. 基于改进双流法的井下配电室巡检行为识别[J]. 工矿自动化,2020,46(4):75-800.

DANG Weichao,ZHANG Zejie,BAI Shangwang,et al.Inspection behavior recognition of underground powerdistribution room based on improved two-stream CNNmethod[J]. Industry and Mine Automation, 2020,46(4):75-80.

[ 8 ]LIU Xiaoyang, LIU Jinqiang, ZHENG Haolin. Gaitrecognition method of coal mine personnel based ontwo-stream neural network[J]. Journal of MiningScience and Technology,2021,6(2):218-227.

[ 9 ]刘斌,侯宇辉,王延辉. 基于井下轨迹数据的煤矿人员违规行为识别[J]. 煤炭与化工,2021,44(10):82-85.

LIU Bin, HOU Yuhui, WANG Yanhui. Recognition ofillegal behavior of coal mine personnel based onunderground trajectory data[J]. Coal and ChemicalIndustry,2021,44(10):82-85.

[10]WANG Zheng, LIU Yan, DUAN Siyuan, et al. Anefficient detection of non-standard miner behavior usingimproved YOLOv8[J]. Computers and ElectricalEngineering, 2023, 112. DOI: 10.1016/J.COMPELECENG.2023.109021.

[11]仝泽友,[11] 丁恩杰. 矿井皮带区矿工违规行为识别方法[J]. 河南科技大学学报(自然科学版),2020,41(2):40-46,6-7.

TONG Zeyou, DING Enjie. Identification method ofminer violation behavior in mine belt area[J]. Journal ofHenan University of Science and Technology(NaturalScience),2020,41(2):40-46,6-7.

[12]李善华,肖涛,李肖利,等. 基于DRCA−GCN 的矿工动作识别模型[J]. 工矿自动化, 2023, 49(4) : 99-105,112.

LI Shanhua, XIAO Tao, LI Xiaoli, et al. Miner actionrecognition model based on DRCA-GCN[J]. Journal ofMine Automation,2023,49(4):99-105,112.

[13]陈天,闫雨寒,徐达伟,等. 基于改进双流算法的矿工行为识别方法研究[J]. 河南科技大学学报(自然科学版),2021,42(4):47-53,7.

CHEN Tian, YAN Yuhan, XU Dawei, et al. Researchon miner behavior recognition method based onimproved two-stream algorithm[J]. Journal of HenanUniversity of Science and Technology(NaturalScience),2021,42(4):47-53,7.

[14]WU Wenhao, HE Dongliang, LIN Tianwei, et al.MVFNet: multi-view fusion network for efficient videorecognition[C]. AAAI Conference on ArtificialIntelligence,Vancouver,2021. DOI:10.48550/arXiv.2012.06977.

[15]XIE Zhao, CHEN Jiansong, WU Kewei, et al. Globaltemporal difference network for action recognition[J].IEEE Transactions on Multimedia,2023,25:7594-7606.

[16]TRAN D, BOURDEV L, FERGUS R, et al. Learningspatiotemporal features with 3D convolutionalnetworks[C]. IEEE International Conference onComputer Vision,Santiago,2015:4489-4497.

[17]FEICHTENHOFER C, FAN Haoqi, MALIK J, et al.SlowFast networks for video recognition[C]. IEEE/CVFInternational Conference on Computer Vision, Seoul,2019:6201-6210.

[18]LIN Ji,GAN Chuang,HAN Song. TSM:temporal shiftmodule for efficient video understanding[C]. IEEE/CVFInternational Conference on Computer Vision, Seoul,2019:7082-7092.

[19]WANG Limin, XIONG Yuanjun, WANG Zhe, et al.Temporal segment networks:towards good practices fordeep action recognition[C]. Computer Vision andPattern Recognition,Amsterdam,2016:20-36.

[20]BERTASIUS G, WANG Heng, TORRESANI L. Isspace-time attention all you need for video understanding?[C]. International Conference on Machine Learning,Vienna,2021. DOI:10.48550/arXiv.2102.05095.

[21]YANG Ceyuan, XU Yinghao, SHI Jianping, et al.Temporal pyramid network for action recognition[C].IEEE/CVF Conference on Computer Vision and PatternRecognition,Seattle,2020:588-597.

基金项目:国家重点研发计划项目(2021YFB4000905);国家自然科学基金项目(62101432,62102309);陕西省自然科学基础研究计划项目(2022JM-508)。