PIRLS 2021阅读素养测试群体自适应设计原理、方法及启示

2024-06-30张所帅黄志军

张所帅?黄志军

摘 要 群体自适应设计是国际阅读素养进展研究(PIRLS)在2021年第五轮评估周期中的最大亮点,尤其值得关注。群体自适应设计采用有针对性的题册抽样做法使测试题目的能力分布与测试群体的能力分布相匹配,从而提高测试结果的精确度,减少不应答现象的发生。群体自适应设计与计算机自适应测试互为表里、相辅相成,具有传统纸笔测验无可比拟的优越性。PIRLS 2021阅读素养测试采用纵向自适应设计的做法,根据不同国家和地区学生阅读成就水平的不同,将相同内容、不同难度的阅读材料和测试题目按照一定的比例进行灵活分配,朝着智能化、个性化、适应性的测试方向迈出了坚实的一步。这无论是对大规模学业水平测试,还是对日常过程性教学评价,都有启发意义。

关键词 PIRLS 2021 阅读素养测试 群体自适应设计

2021年,国际阅读素养进展研究(Progress in International Reading Literacy Study,以下简称PIRLS)迎来了第五轮评估周期,在保持阅读素养测试理念和框架结构稳定不变的前提下,借助现代教育评价理论和测量技术在“数字化评价方式”“测试文本类型”“背景问卷内容结构”“群体自适应设计”和“ePIRLS和digital PIRLS整合”等方面呈现出新的发展动向,体现了与时俱进、开拓创新的价值追求。其中,“群体自适应题册设计”变化最大,最能体现大规模测试评价的发展走向,尤其值得关注。

一、PIRLS 2021阅读素养测试群体自适应设计原理

在以往的测试评价中,为了确保结果的公平与公正,无论测试目标对象的能力如何,所有人都要接受难度等级相同、题目数量也相同的试题。虽然以往的测试评价在形式上保证了测试结果的一致性,但是难以做到“量体裁衣”,因人施测,不能真正反映测试目标对象的真实能力水平,也不利于后续的改进提升。随着教育测量理论和技术的发展,在大规模测试评价中,通常会采用不同的测试题册(booklets)以平衡测试内容的覆盖面和学生作答的负担量,同时兼顾题册难度与学生能力之间的匹配度,这便涉及测试群体的自适应问题。

测试群体的自适应问题是大规模适应性评价的核心问题。虽然测试评价的结果很重要,但是全面反映测试目标对象的真实能力水平更重要。其背后的基本指导思想是实现测试评价的目的,测试题目对于目标对象来说不能太难,也不能太简单:如果分配给应试者的任务太难,没有人(或几乎没有人)能够作答,那么题目本身就毫无意义;如果任务太简单,每个人都能正确作答,即便所得到的观察分数都一样,也无法掩饰其在相关技能方面的不同。以上两种情况都无法获得有价值的作答信息,尤其对于低利害的学业水平测试评价来说意义不大。

基于此,在大规模阅读素养测试评价中,施测者通常试图设计出符合目标群体能力水平的任务,并通过引出高技能水平和低技能水平应试者作答的不同响应来区分彼此之间的能力差异。在国家或地区层面,阅读素养测试群体自适应设计中,通常采用对测试题册进行有针对性的抽样,以便更好地涵盖测试中遇到的各种能力分布范围,使题册的能力分布与应试者的能力分布相匹配,从而提高应试者作答的积极性,减少测试题目水平上不应答现象的发生。

测试群体的自适应设计与计算机自适应测试(computerized adaptive testing,CAT)互为表里、相辅相成,其背后的机理是一致的,并且测试群体的自适应设计离不开计算机自适应测试的辅助,试题的呈现和被试对试题的解答都是通过计算机完成的,而不是像传统的纸笔测验那样通过被试能正确回答题目的多少来评价其能力。在这里,计算机不仅是媒体工具,还是智能化的决策者:它是以项目反应理论为基础建立大型题库,由计算机根据被试能力水平自动选择测试题目,最终对被试能力作出精确估计的一种新型测验,其目的是通过被试正确回答题目难度的高低来评价其能力。计算机自适应测试的过程大致可分为两个阶段,即试验性探查阶段和精确估计真值阶段。试验性探查阶段主要是根据被试的随机作答情况初步估计其能力初值;精确估计真值阶段则是在前一阶段的基础上继续施测,累积信息量,进一步修正能力估计值,最终实现精确考查被试能力的目的。

与传统的纸笔测验和一般的计算机化测验相比,计算机自适应测试具有无可比拟的优越性。概括而言,其优越性主要表现在以下几个方面:一是可适当减少考生作答试题的数量,二是能够有效提高测量精度,三是有利于提高考试的安全性,四是能为考生提供个性化服务,五是可以增加考生参加考试的灵活性,六是能实现计分与分数报告的即时性。正是基于以上考虑,PIRLS阅读素养测试积极探索群体自适应设计,采用纵向自适应设计(Adaptive Longitudinal Designs)(这种设计是利用所在国家或地区学生之前评价周期中的能力表现信息,自适应地将较难的测试内容分配给高分组国家或地区的学生,将较容易的测试内容分配给低分组国家或地区的学生。)进行题库开发与题册合成。

二、PIRLS 2021阅读素养测试群体自适应设计方法

PIRLS测试评价的目标对象是代表正式学校教育第四年的学生(在大多数国家和地区是四年级学生)。然而,随着参与测试评价的国家和地区越来越多,彼此之间教育发展水平的差异性表现得越来越明显,有的国家和地区大多数四年级学生仍处于发展基本阅读技能阶段,尚不能达到参与PIRLS阅读素养评价的认知发展水平。如何在更大范围内解决测试题册难度与学生能力发展水平相匹配的问题,便成了一个巨大的挑战。为了应对这一挑战,PIRLS在2011年开发了prePIRLS(可理解为PIRLS的预备版),2016年又开发了PIRLS Literacy,通过提供难度较低评价版本的办法来解决这一难题。该举措虽然确保了能力分布处在低端发展水平学生能力覆盖范围,但是并没有解决能力分布处在高端发展水平的学生对更具挑战性测试材料和题目的需求问题,同时另需单独的评价版本,既增加了测试的成本,也提高了评价的复杂程度。

为了更好地解决参与国家和地区测试难度与学生成就水平相匹配的问题,PIRLS 2021测试题册采用了群体自适应设计。所有参与国家和地区都采用统一的评价内容,使用相同的阅读材料和测试题目,但是不同难度的阅读材料和测试题目在一个国家和地区的分配比例将根据学生的阅读成就水平进行灵活安排。简言之,新的题册设计是基于难、中、易三个等级的阅读材料和测试题目,将其合并成两个不同难度等级的测试题册。每个国家和地区都使用所有的题册进行测试,但难度较大和难度较小题册的分配比例会随着该国和地区学生阅读成就水平的变化而变化。

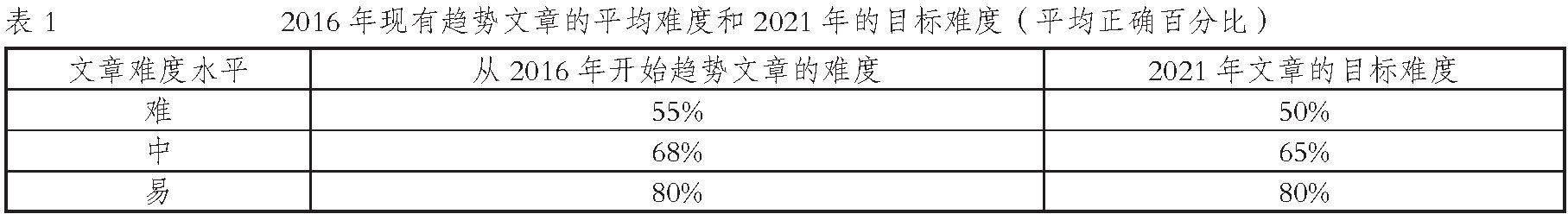

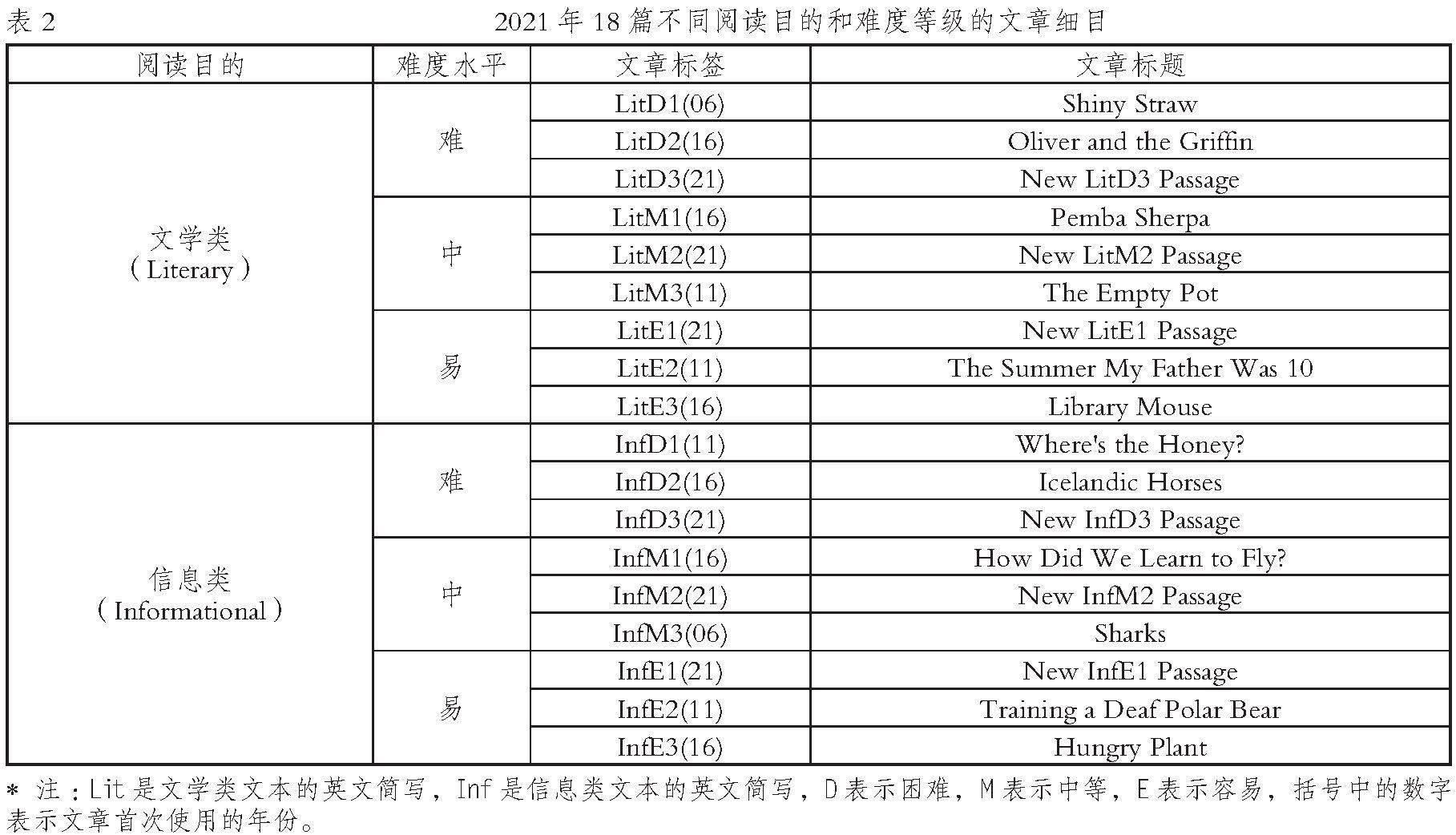

具体来说,PIRLS 2021的测试题册由18篇文章组成,其中有12篇文章来自PIRLS 2016(含PIRLS Literacy测试中的文章),作为纵向链接用作对阅读发展趋势的测量,另外6篇文章是2021年开发的。这18篇文章根据难易程度被划分成难、中、易三个等级,每个等级分别包括3篇文学类文章和3篇信息类文章。文章难易程度的区分依据的是学生群体对其正确作答的平均百分比,理想中合理的平均百分比:水平等级“难”组为40%,水平等级“中”组为60%,水平等级“易”组为80%。PIRLS 2021新开发的文章有意识地呼应了以上难度级别要求,而之前已有文章的难度表现则稍显逊色,特别是“难”和“中”等级的文章其难度值明显偏高(见表1)。当然,这只是过渡时期的暂时表现,随着更多趋势性文章被更新的、更有针对性的文章取代,这样的情况会有所改变。

如表2所示,PIRLS 2021中的18篇文章被编排成18本题册,每本题册均包含两篇文章,一篇是文学类文本,一篇是信息类文本。每一篇文章都会出现在两本题册中,每次与不同的文章相匹配。测试中,每名学生会被随机分派一本题册进行作答。

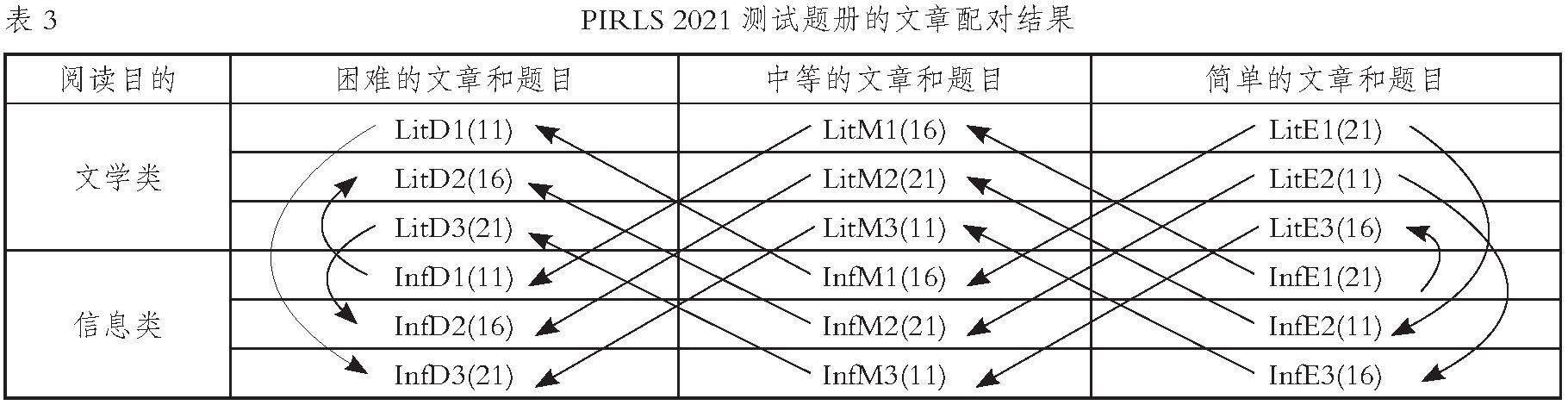

表3呈现了每本题册中文章配对的结果,箭头的方向表示题册中哪一篇文章会先出现,例如箭头从文章InfM1(16)指向LitD1(11),表明这两篇文章会共同组成一本题册,文章InfM1(16)在LitD1(11)之前。另外,当不同难度的文章在同一本题册中配对时,两者中较容易的总是先出现。

18本题册被分成两个难度等级:难度较大的题册(9本)和难度较小的题册(9本)。其中,难度较大的题册由两篇难度大的文章或一篇中等难度的文章和一篇难度大的文章组成;难度较小的题册由两篇容易的文章或一篇容易的文章和一篇中等难度的文章组成。

表4显示了18本题册的难度等级分配。其中,题册1—题册9的难度较大,题册10—题册18的难度较小。

由18篇文章所编排成的18本题册会分发到每个国家和地区,以确保所有参与评价的国家和地区测试的内容相同。根据PIRLS先前周期测试结果或首次参与国家和地区实地试测表现中学生的平均阅读能力,难易程度不同的题册在分配中所占的比例是不同的。比如,学生成就表现较好的国家和地区,难度较大题册的分配比例更高;学生成就表现较差的国家和地区,难度较小的题册的分配比例更高。其最终目的是使每个国家和地区的测试难度与当地学生的阅读能力更好地匹配。

根据阅读成就量表得分情况,PIRLS把所有参与测试的国家和地区分成高、中、低三个水平层级,以此确定不同难度等级题册的分配比例:总体平均阅读成就为550分或更高的国家和地区,将随机分配更多难度较大等级的题册(70%),较少难度较小等级的题册(30%);总体平均阅读成就在量表中点、500分的国家和地区,将分配相同比例难度较大等级的题册(50%)和难度较小等级的题册(50%);总体低于平均表现水平、450分或更低的国家和地区,将分配较少比例难度较大等级的题册(30%)和更多比例难度较小等级的题册(70%)。具体如表5所示。

测试题册群体自适应设计可以说是PIRLS 2021阅读素养评价的最大亮点。这种创新的、自适应的题册设计彻底改变了PIRLS之前评价周期对不同阅读水平国家和地区各类阅读水平测试的做法,将所有的国家和地区统一到相同的模板中,提高了测试内容的灵活性和测试结果的准确性,值得推广。

三、PIRLS 2021阅读素养测试群体自适应设计启示

PIRLS积极面对现实诉求,顺应时代发展潮流,以计算机自适应测试理论和网络信息技术为基础,在2021年阅读素养测试题册中采取群体自适应设计,降低阅读素养评价的复杂程度,提高阅读素养测试的精确程度,朝着智能化、个性化、适应性的方向迈出了坚实的一步。这无论是对大规模学业水平测试,还是对日常过程性教学评价,都有启发意义。

为了全面实施素质教育,着力提升教育质量,强化教育督导监管,确保教育投入和课程改革达到预期目标,近年来,从国家到地方陆续开展了义务教育质量监测活动。国家层面,教育部基础教育质量监测中心自2015年起开展国家义务教育质量监测工作。作为我国义务教育健康发展的“体检仪”和“指挥棒”,国家义务教育质量监测在开展过程中立足中国国情及教育教学实际,不断发展特色,开拓创新,根据监测工作实际需要,充分运用信息技术和人工智能,不断促进监测方法和手段升级。基于此,我国有关部门可以借鉴PIRLS 2021阅读素养测试群体自适应设计理念和做法,充分考虑不同地区教育质量发展水平的差异性,因地制宜,使测试内容和题目更具针对性。

除了“低利害”的义务教育质量监测以外,即便是“高利害”的中高考,也可借鉴其测试的理念和做法。目前每年的高考试卷仍是以“国家卷+地方卷”的格局呈现。即便是“国家卷”,每年也会面向不同地区命制不同的试题,具有了测试群体自适应设计的雏形,但还有一定的进步空间。根据相关文件要求,中考命题将“进一步强化省级统筹,落实初中学业水平考试命题管理省级主体责任”,“积极创造条件稳步推进省级统一命题”。随着命题权限的上移和试题覆盖范围的扩大,为了提高命题测试的有效性,群体自适应设计亦显得尤为必要。

《深化新时代教育评价改革总体方案》明确提出:“坚持科学有效,改进结果评价,强化过程评价,探索增值评价,健全综合评价,充分利用信息技术,提高教育评价的科学性、专业性、客观性。”评价具有多重功能,随着课程改革的深入发展,教育评价的理念也在不断更新,评价是动态的、多元的、形成性和教育性的,评价的根本目的是促进学生学习,核心伦理在于让学生受益。日常的过程性评价在学生的课程学习中居于重要地位,课堂教学、课后作业和阶段性测验都应秉持“教育性”“发展性”的原则,促进学生的全面发展。因此,在日常的过程性测试评价中,同样可以参照群体自适应设计的模式,以便更好地促进学生核心素养的发展。