基于增量加权的不平衡漂移数据流分类算法

2024-05-24蔡博张海清李代伟向筱铭于曦邓钧予

蔡博 张海清 李代伟 向筱铭 于曦 邓钧予

摘 要:

概念漂移是数据流学习领域中的一个难点问题,同时数据流中存在的类不平衡问题也会严重影响算法的分类性能。针对概念漂移和类不平衡的联合问题,在基于数据块集成的方法上引入在线更新机制,结合重采样和遗忘机制提出了一种增量加权集成的不平衡数据流分类方法(incremental weighted ensemble for imbalance learning,IWEIL)。该方法以集成框架为基础,利用基于可变大小窗口的遗忘机制确定基分类器对窗口内最近若干实例的分类性能,并计算基分类器的权重,随着新实例的逐个到达,在线更新IWEIL中每个基分器及其权重。同时,使用改进的自适应最近邻SMOTE方法生成符合新概念的新少数类实例以解决数据流中类不平衡问题。在人工数据集和真实数据集上进行实验,结果表明,相比于DWMIL算法,IWEIL在HyperPlane数据集上的G-mean和recall指标分别提升了5.77%和6.28%,在Electricity数据集上两个指标分别提升了3.25%和6.47%。最后,IWEIL在安卓应用检测问题上表现良好。

关键词:数据流;不平衡数据;概念漂移;增量加权;集成学习

中图分类号:TP391 文献标志码:A 文章編号:1001-3695(2024)03-031-0854-07doi: 10.19734/j.issn.1001-3695.2023.08.0330

Imbalanced drift data stream classification algorithm based on incremental weight

Cai Bo1a, Zhang Haiqing1a, 1b, Li Daiwei1a,1b, Xiang Xiaoming2, Yu Xi3, Deng Junyu1a

(1.a.School of Software Engineering, b. Sichuan Province Informationization Application Support Software Engineering Technology Research Center, Chengdu University of Information Technology, Chengdu 610255, China; 2.Sichuan Meteorological Observation & Data Center, Chengdu 610072, China; 3.Stirling College, Chengdu University, Chengdu 610106, China)

Abstract:

Concept drift is a difficult problem in the field of data stream learning, while the class imbalance problem existing in the data stream can seriously affect the classification performance of the algorithm. To address the joint problem of concept drift and class imbalance, this paper proposed an incremental weighted ensemble for imbalance learning (IWEIL) method for classifying unbalanced data streams by introducing an online update mechanism on the method based on the integration of data chunks, combined with the resampling and forgetting mechanism. The IWEIL method utilized a variable-size window-based forgetting mechanism to determine the classification performance of base classifiers for a number of recent instances within the window, and calculated the weights of the base classifiers. It updated each base classifier and its weight in IWEIL online as a new instance reached every time. The IWEIL used an improved adaptive nearest-neighbor SMOTE method to generate new minority class instances that conformed to the new concept to solve the class imbalance problem in the data stream. The experimental results show that compared with the DWMIL algorithm, IWEIL method improves the G-mean and recall on the synthesized HyperPlane dataset by 5.77% and 6.28% respectively, and the two metrics on the real-world Electricity dataset by 3.25% and 6.47% respectively. Finally, IWEIL has performed well in the Android app detection problem. Key words:data streams; imbalance data; concept drift; incremental weight; ensemble learning

0 引言

在许多实际应用中,如在线购物、疾病诊断和欺诈检测,以顺序方式生成的大量数据称为数据流。由于工作条件或环境随时间的变化,新到达的数据可能表现出与之前数据不同的分布,这被称为概念漂移[1,2],在这种情况下根据历史数据创建的分類器可能无法识别新概念,甚至导致分类错误。此外,属于不同类别的样本数量可能会发生倾斜,形成不平衡的数据流[3],而传统分类方法通常偏向于多数类,导致分类结果不准确。

受集成学习思想的启发,能够同时处理概念漂移与类不平衡问题的数据流分类算法可以分为在线集成和基于数据块的集成[4]。在线集成方法通过每个传入的样本更新预测模型,并使用漂移检测器来监视数据流。一旦检测到任何概念的漂移,现有的预测模型就会被重置,并为新的概念建立一个新的模型。Wang等人[5]将重采样技术与在线装袋相结合,形成过采样在线装袋OOB(oversampling online bagging)和欠采样在线装袋UOB (undersampling online bagging),根据实时不平衡率动态调整重采样实例的数量,有效解决了数据流中类不平衡问题。在线集成方法能够与解决数据流不平衡问题的漂移检测方法相结合,Wang等人[6]提出的在线不平衡漂移检测方法DDM-OCI(drift detection for online class imbalance learning)结合在线装袋,通过监测少数类召回率的变化来检测不平衡数据流中的概念漂移,但DDM-OCI假设数据流服从高斯分布,因而在实际应用中存在较高的误报率[7]。随后Wang等人[8]提出了线性四率HLFR (hierarchical linear four rate),该方法监控混淆矩阵中的四种比率,即少数类召回率和精度以及多数类召回率和精度,并具有统计支持的漂移检测界限,如果四个速率中的任何一个超过界限,则将确认漂移,有效降低了DDM-OCI的误报率。

基于数据块的方法是通过使用循环缓存数组,从数据流中捕获每个新到达的实例,一旦循环数组已满,就在数据块上构建基分类器。第一个基于块的不平衡数据流方法是不相关装袋UCB(uncorrelated bagging)[9],UCB不断累积历史数据块中的少数类实例,然后添加到当前数据块中,同时对当前数据块进行欠采样,从而平衡数据分布。但是这种方法需要大量内存空间来保存先前数据块中的少数类实例,且未考虑少数类实例可能发生概念漂移的问题,存在着较大的局限性。选择性递归方法SERA(selectively recursive approach)[10]和递归集成方法REA(recursive ensemble approach)[11]使用距离度量来选择与当前数据块中的实例具有相似特征的少数实例,用于平衡当前数据块中的类别分布,同时解决了少数类实例中的子概念问题。上述基于数据块的集成方法都隐含地假设少数类实例的概念不会发生变化,先前数据块中的少数类实例可以继续使用,然而对于具有概念漂移的数据流,尤其是同时存在类不平衡问题时,类的先验概率会随着时间发生变化,导致这一假设很难成立。Ditzler等人[12]提出了Learn++CDS和Learn++NIE方法,该方法无须保存任何历史数据,为每个块创建一个单独的基分类器,基分类器通过时间衰减函数及其在当前块上的性能进行加权。Learn++CDS将合成少数类过采样技术(synthetic minority over-sampling technique,SMOTE)[13]与概念漂移处理算法Learn++.NSE相结合,在发生漂移时生成新的少数实例;在Learn++.CDS的基础上,Learn++.NIE 修改了带有惩罚约束的权重机制,并用基于Bagging的子集替换了SMOTE,有效平衡了不同类别的重要性。

基于块的集成方法学习固定大小的数据块,缺点在于对数据块内发生的突然概念漂移的响应效率低下。尽管减小数据块大小有助于解决突然漂移问题,但该方式会增加计算成本,并降低稳定状态下基分类器的性能[14]。在线集成方法由新到达的实例动态更新,优点在于可快速适应突然的概念漂移。与基于块的训练相比,该方法在训练的初始阶段可能表现较差,因为每个时间步仅使用一个实例。为此,本文基于数据块集成方法引入在线更新机制,提出了一种增量加权集成的不平衡数据流分类方法(IWEIL),用于具有类别不平衡的漂移数据流。IWEIL以集成框架为基础,基分类器随着每个新到达的实例而增量更新,目的是在概念漂移后学习最新的数据特征,基分类器的权重会根据估计窗口的性能进行在线更新,估计窗口的大小根据基分类器产生不同误分点之间的间隔和分布自适应调整,以准确反映基分类器在每个时刻的准确率,同时采用一种改进的自适应最近邻SMOTE方法生成符合新概念的新少数类实例,以解决数据流中类不平衡问题。与同类方法相比,本文主要贡献有三个方面:a)提出了一种基于可变大小窗口的遗忘机制,通过在线方式评估基分类器的性能,以删除表现不佳的基分类器,保证基分类器的分类性能;b)构建了增量加权集成模型来解决基于数据块集成方法中的自适应延迟问题,该模型根据所提出的遗忘机制,随着新实例的逐个到达,增量更新每个基分类器及其权重,能够迅速响应突变漂移和渐变漂移,有效解决了数据流中的概念漂移问题;c)采用一种改进的自适应最近邻SMOTE方法生成少数类最近邻参数k,该方法根据两个相邻数据块的分布变化生成适应新概念的新少数样本,无须保存历史数据块的少数类实例,有效解决了数据流中的类不平衡问题。

1 相关概念

1.1 不平衡问题

类不平衡一直是分类问题中的一个棘手问题,针对于此,研究人员对机器学习中的传统分类器(如SVM、KNN、贝叶斯等)进行了大量研究,提出了许多改进后能适应于类不平衡问题的分类算法。在数据流领域中,类不平衡指的是一个类别的实例数量远远超过其他类别。假设给定数据流为〈S1,S2,…,St-1,St,St+1…〉,其中St(xt,yt),xt表示时刻t到达实例的特征向量,yt表示该实例的类标签,少数类样本实例集合记为P,多数类样本实例集合记为N,则S=N∪P。因此,不平衡数据分类可以看作一个二分类问题,少数类通常称为正类,多数类称为负类,不均衡的数据分布会导致分类器偏向于更容易建模的多数类,因为分类器可以通过选择多数类来实现高精度。然而从数据推理的角度来看,少数类往往是更重要的类别,因为其可能携带更多的相关信息。在不平衡数据流分类中,如果少数类样本实例极少且出现的频率低,不同类别之间的数据样本比达到1∶99,将造成分类模型根本无法预测到少数类,但最终分类准确率却高达99%的情况,这种分类结果对更重要的少数类来说毫无意义。例如在医疗健康领域中,患病人群远远少于健康人群,但正确地检测出患病人群比检测出正常人群更有价值。

数据流中的不平衡比率可以理解为:少数类样本在整个样本集合中所占的数量[15],即IR=P/S。当IR=0.5时,数据类别分布平衡,当IR的值小于某一特定阈值时,则当前数据存在类不平衡问题。

目前处理不平衡数据的分类方法可以分為数据方法和算法方法。数据方法包括各种重采样技术,对少数类样本进行过采样,对多数类样本进行欠采样,通过操作训练数据以纠正倾斜的数据分布;算法方法通过修改分类器训练机制来解决类不平衡问题,其直接目的是提高少数类的准确性。

1.2 概念漂移

在数据流中,实例是根据底层概率分布Pt(X,Y)随着时间推移而生成的[2],其中X对应于特征向量,Y对应于类标签。如果流中的所有实例都基于相同的概率分布而生成,那么数据流是固定的;如果流中的概念和数据分布随着时间的推移而变化,那么数据流中存在概念漂移[16]。下面从概率的角度来定义概念漂移,当在时间t和t+1的联合概率发生变化时就会产生概念漂移,即Pt(X,Y)≠Pt+1(X,Y)。根据贝叶斯定理[17],联合概率P(X,Y)可以分解为P(X,Y)=P(Y)P(Y|X),因此这种漂移可以分为真实漂移和虚拟漂移。在不影响P(Y)的情况下改变后验分布P(Y|X),将导致真正的概念漂移,这可能会改变决策边界并降低分类模型的性能。在不影响P(Y|X)的情况下改变先验概率P(Y),会导致虚拟概念漂移,这不会改变决策边界,但会改变不同类别实例的比例,与类不平衡现象有关。

如果发生概念漂移,根据历史数据创建的分类器可能无法识别新概念,从而导致错误分类。概念漂移根据概念变化的速度可分为突变型概念漂移和渐变型概念漂移[18]。突变漂移指的是新旧概念过渡很快,旧概念立即变为数据分布完全不同的新概念,导致分类模型性能急剧下降;渐变漂移则是新旧概念过渡较慢,旧概念逐渐变为新概念,使分类模型有一个适应新概念的调整期。当类不平衡与概念漂移相结合时,不平衡比率不再是静态的,而是随着流的变化而变化,并且随着时间的推移,多数类与少数类的身份可以相互转换。

目前处理概念漂移主要可以分为主动检测方法和被动适应方法[2]。在主动方法中,采用概念漂移检测机制,通过监控性能指标(如准确率和召回率)的变化来检测是否发生概念漂移。一旦监测指标出现较大波动,就会触发概念漂移警报,并更新分类器。被动方法中没有漂移检测机制,随着数据的不断输入,通过不断更新分类器来适应概念漂移。构建集成分类器是被动方法的常见选择,其中每个基分类器都构建在新到达的数据块上,可以通过修改结构、调整基分类器的权重来适应新概念[19]。

2 增量加权集成的不平衡数据流分类方法

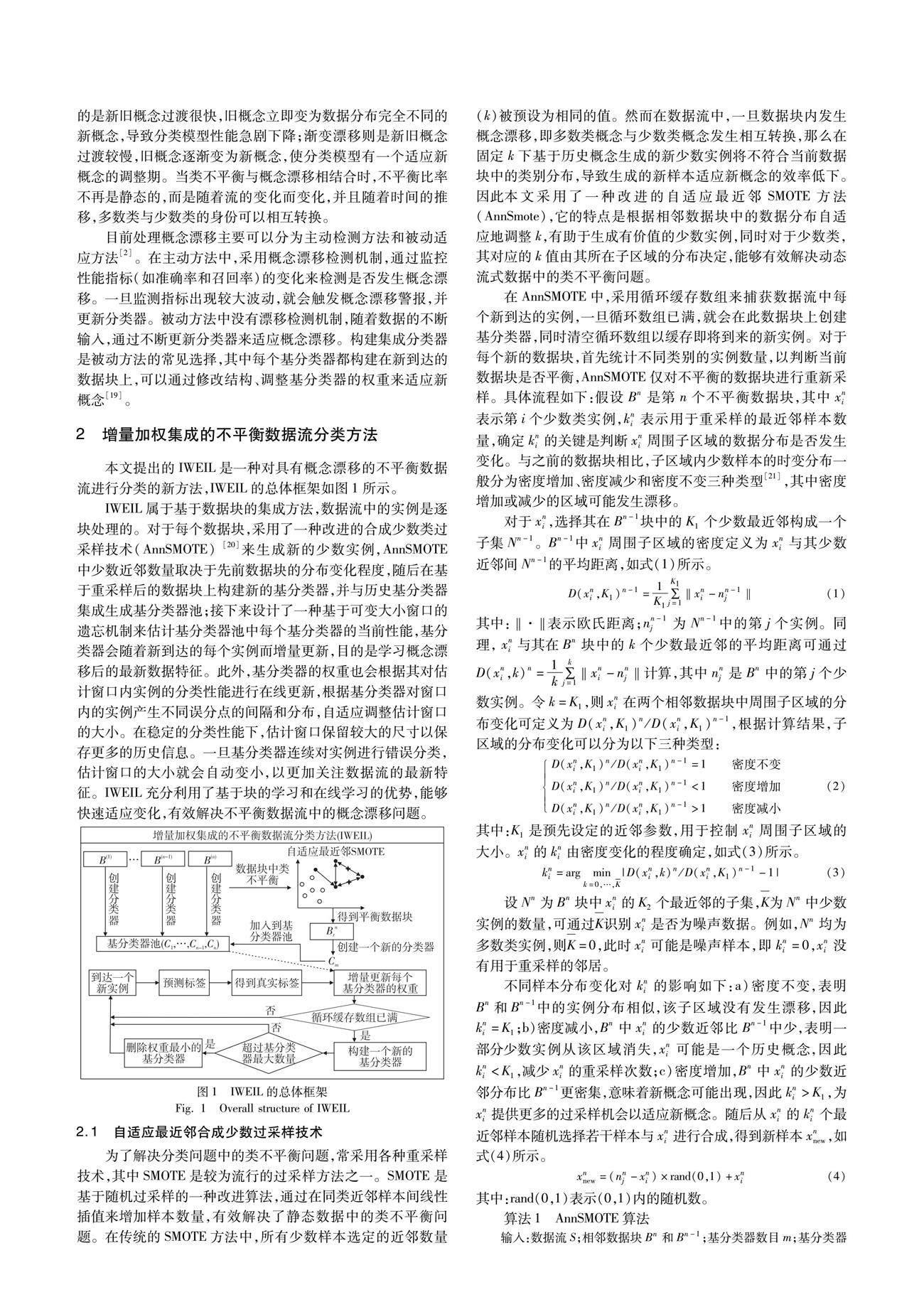

本文提出的IWEIL是一种对具有概念漂移的不平衡数据流进行分类的新方法,IWEIL的总体框架如图1所示。

IWEIL属于基于数据块的集成方法,数据流中的实例是逐块处理的。对于每个数据块,采用了一种改进的合成少数类过采样技术(AnnSMOTE) [20]来生成新的少数实例,AnnSMOTE中少数近邻数量取决于先前数据块的分布变化程度,随后在基于重采样后的数据块上构建新的基分类器,并与历史基分类器集成生成基分类器池;接下来设计了一种基于可变大小窗口的遗忘机制来估计基分类器池中每个基分类器的当前性能,基分类器会随着新到达的每个实例而增量更新,目的是学习概念漂移后的最新数据特征。此外,基分类器的权重也会根据其对估计窗口内实例的分类性能进行在线更新,根据基分类器对窗口内的实例产生不同误分点的间隔和分布,自适应调整估计窗口的大小。在稳定的分类性能下,估计窗口保留较大的尺寸以保存更多的历史信息。一旦基分类器连续对实例进行错误分类,估计窗口的大小就会自动变小,以更加关注数据流的最新特征。IWEIL充分利用了基于块的学习和在线学习的优势,能够快速适应变化,有效解决不平衡数据流中的概念漂移问题。

2.1 自适应最近邻合成少数过采样技术

为了解决分类问题中的类不平衡问题,常采用各种重采样技术,其中SMOTE是较为流行的过采样方法之一。SMOTE是基于随机过采样的一种改进算法,通过在同类近邻样本间线性插值来增加样本数量,有效解决了静态数据中的类不平衡问题。在传统的SMOTE方法中,所有少数样本选定的近邻数量(k)被预设为相同的值。然而在数据流中,一旦数据块内发生概念漂移,即多数类概念与少数类概念发生相互转换,那么在固定k下基于历史概念生成的新少数实例将不符合当前数据块中的类别分布,导致生成的新样本适应新概念的效率低下。因此本文采用了一种改进的自适应最近邻SMOTE方法(AnnSmote),它的特点是根据相邻数据块中的数据分布自适应地调整k,有助于生成有价值的少数实例,同时对于少数类,其对应的k值由其所在子区域的分布决定,能够有效解决动态流式数据中的类不平衡问题。

在AnnSMOTE中,采用循环缓存数组来捕获数据流中每个新到达的实例,一旦循环数组已满,就会在此数据块上创建基分类器,同时清空循环数组以缓存即将到来的新实例。对于每个新的数据块,首先统计不同类别的实例数量,以判断当前数据块是否平衡,AnnSMOTE仅对不平衡的数据块进行重新采样。具体流程如下:假设Bn是第n个不平衡数据块,其中xni表示第i个少数类实例,kni表示用于重采样的最近邻样本数量,确定kni的关键是判断xni周围子区域的数据分布是否发生变化。与之前的数据块相比,子区域内少数样本的时变分布一般分为密度增加、密度减少和密度不变三种类型[21],其中密度增加或减少的区域可能发生漂移。

对于xni,选择其在Bn-1块中的K1个少数最近邻构成一个子集Nn-1。Bn-1中xni周围子区域的密度定义为xni与其少数近邻间Nn-1的平均距离,如式(1)所示。

3 实验结果及其分析

为了验证IWEIL方法的有效性,本章将IWEIL的分类性能与四种最先进的方法在人工数据集和真实数据集上进行比较。对比算法可分为基于数据块的集成方法(Learn++.NIE、DWMIL)和在线集成方法(OOB、DDM-OCI)。实验的硬件环境是Intel CoreTM i7-10875H,内存为16 GB的PC机,操作系统是Windows 10,编程语言为Python 3.7,每个实验独立运行10次。IWEIL的参数设置为:基分类器根据Scikit-Multiflow库中的Hoeffding tree使用默认设置;少数邻居数量K1和重采样的最大邻居数K2参照文献[20],分别设定为5和7;数据块大小L根据大量实验确定,设定为500;基分类器最大数量Kmax设定为20。

3.1 实验数据集

在实验中采用了五个人工数据集和两个真实数据集来验证算法的有效性。其中SEA、Sine、HyperPlane、Gaussian使用概念漂移生成器生成,Electricity和Weather为真实数据集。IWEIL算法主要以二分类数据流为主。为了更好地研究不平衡数据流中的概念漂移问题,人工数据集分为突变型(abrupt)漂移和渐变型(gradual)漂移,具体数据集特征如表1所示。

3.2 算法评估指标

准确率作为传统指标并不能全面评价分类器在不平衡数据集上的实际表现。相比之下,曲线下面积(AUC)、F-score、G-mean和recall可以更客观地衡量不平衡分类方法。本文中,几何平均值G-mean 和少数类召回率recall用于分析分类器的性能,G-mean衡量非平衡数据集的分类性能,recall衡量少数类别的分类性能。G-mean和recall用表2所示的混淆矩阵来定义,其具体定义如式(10)(11)所示。

3.3 块大小对IWEIL算法的影响

IWEIL是基于数据块的集成分类算法,流中的实例是逐块处理的,因此数据块的大小直接影响算法的分类效果。

本节使用不同大小的数据块L对算法的G-mean性能进行了实验,结果如表3所示。

3.4 实验结果分析

为了验证IWEIL的分类性能,本节在7组数据集上与4种同类算法进行了对比实验,算法评估指标为几何平均值G-mean 和recall,结果如表4和5所示。由表4可知,IWEIL算法在7个数据集上的平均排名(average rank)最高,仅在Sea_abrupt数据集上与DWMIL算法相差2.17%,表明IWEIL中所提出的增量加权机制在对概念漂移数据流分类时表现良好,通过缩小估计窗口大小,使得连续产生误分类的过时分类器的权重迅速下降,同时新创建的分类器被分配更高的权重,以提供对新概念更准确的预测;而DDM-OCI的G-mean性能很差,在Sea_abrupt上仅为48.69%,虽然该算法能够检测概念漂移,但在处理快速变化的不平衡数据流时容易出现误报甚至漏检的情况,特别在面对突变型漂移时,容易将少数类实例误分为多数类。recall的结果如表5所示,IWEIL算法在5个数据集上的recall值高于其他算法,在Sea_abrupt和Weather數据集上排名第2,分别与DWMIL算法相差1.95%和1.72%。从表4和5可以得出,IWEIL在G-mean和少数类召回率recall上的整体性能均优于DWMIL,表明IWEIL在少数类上取得较好表现的同时,没有以牺牲多数类的分类性能为代价,在二分类数据流中达到了最佳平衡。

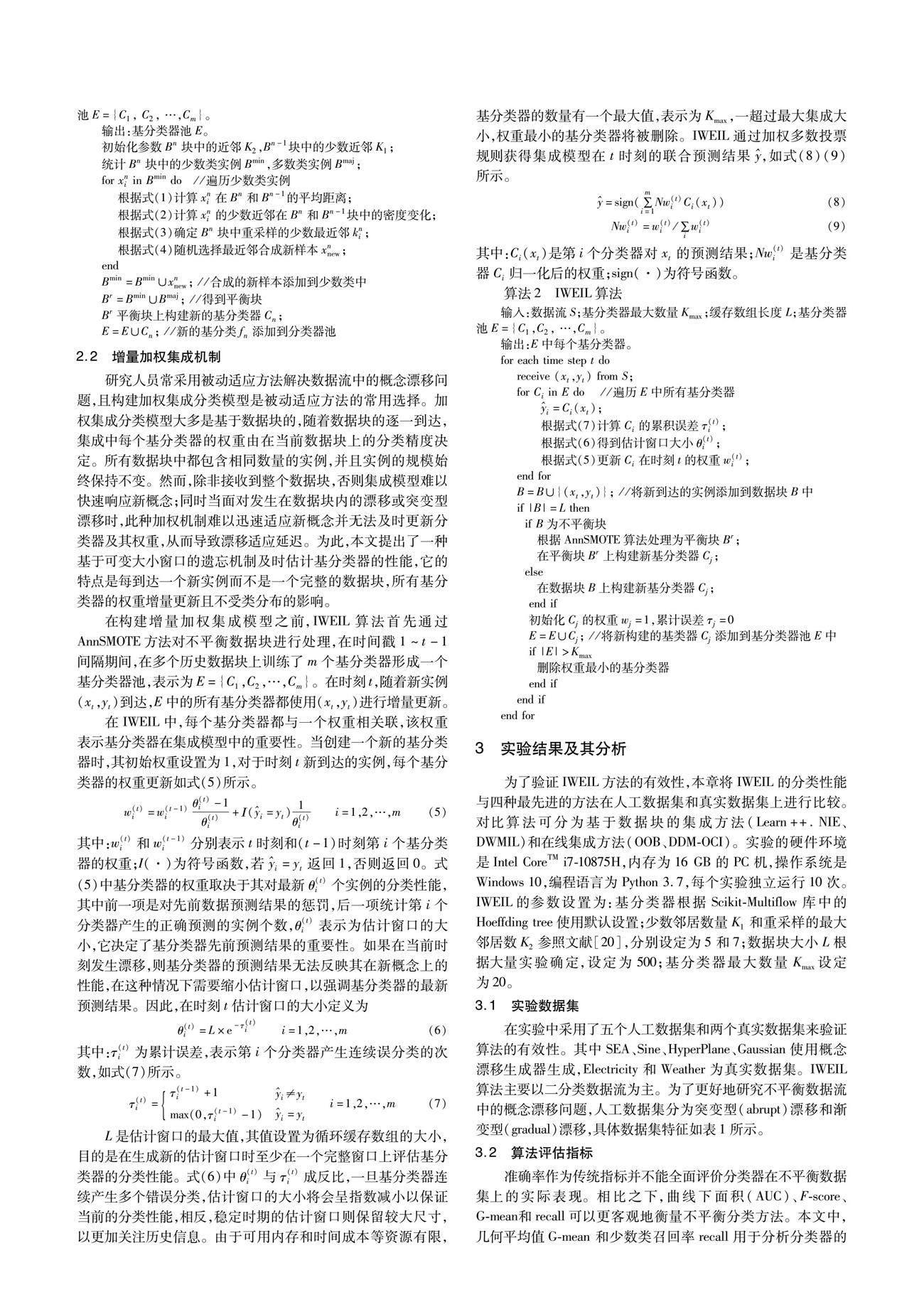

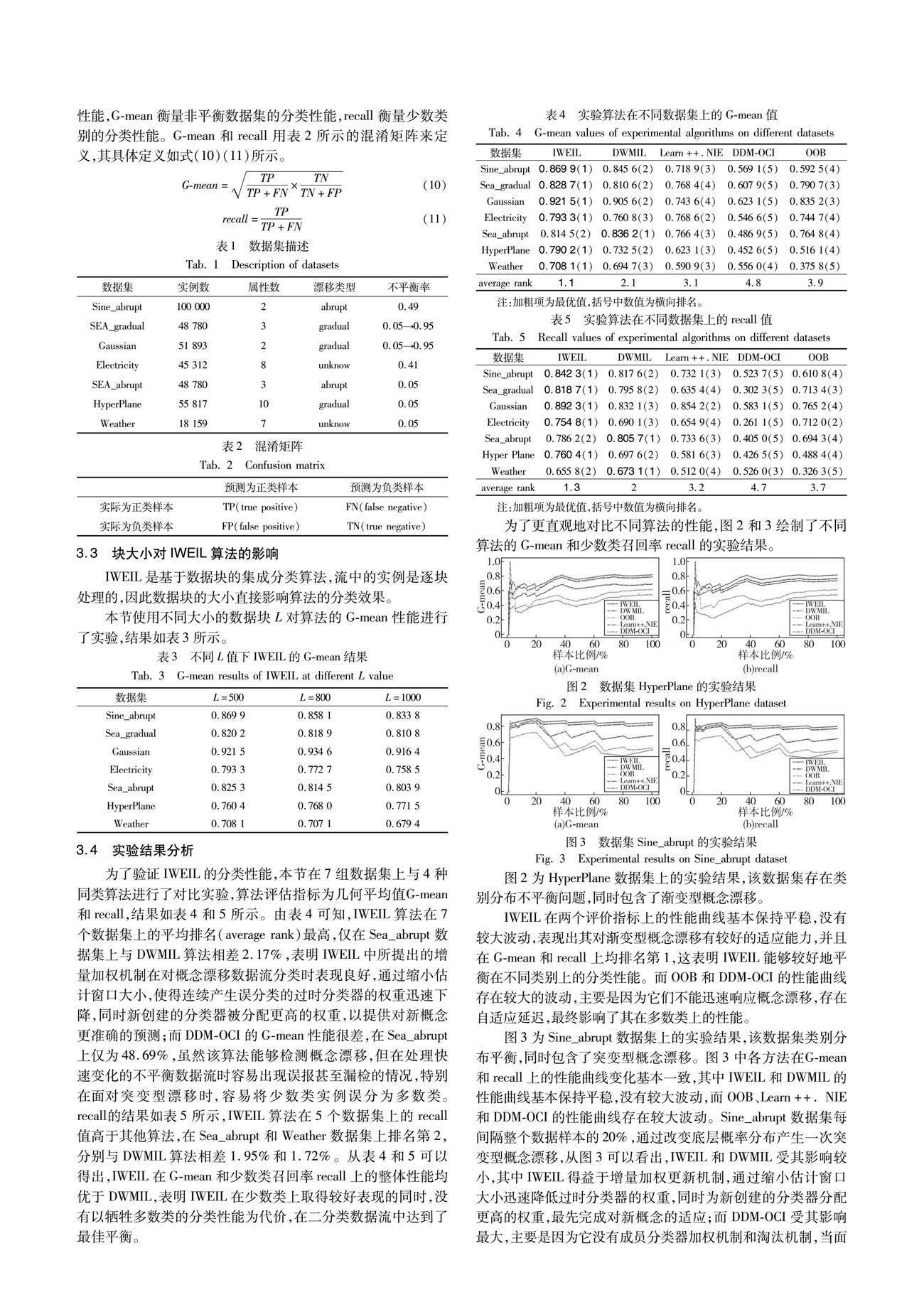

为了更直观地对比不同算法的性能,图2和3绘制了不同算法的G-mean和少数类召回率recall的实验结果。

图2为HyperPlane数据集上的实验结果,该数据集存在类别分布不平衡问题,同时包含了渐变型概念漂移。

IWEIL在两个评价指标上的性能曲线基本保持平稳,没有较大波动,表现出其对渐变型概念漂移有较好的适应能力,并且在G-mean和recall上均排名第1,这表明IWEIL能够较好地平衡在不同类别上的分类性能。而OOB和DDM-OCI的性能曲线存在较大的波动,主要是因为它们不能迅速响应概念漂移,存在自适应延迟,最终影响了其在多数类上的性能。

图3为Sine_abrupt数据集上的实验结果,该数据集类别分布平衡,同时包含了突变型概念漂移。

图3中各方法在G-mean和recall上的性能曲线变化基本一致,其中IWEIL和DWMIL的性能曲线基本保持平稳,没有较大波动,而OOB、Learn++. NIE和DDM-OCI的性能曲线存在较大波动。Sine_abrupt数据集每间隔整个数据样本的20%,通过改变底层概率分布产生一次突变型概念漂移,从图3可以看出,IWEIL和DWMIL受其影响较小,其中IWEIL得益于增量加权更新机制,通过缩小估计窗口大小迅速降低过时分类器的权重,同时为新创建的分类器分配更高的权重,最先完成对新概念的适应;而DDM-OCI受其影响最大,主要是因为它没有成员分类器加权机制和淘汰机制,当面对突变型概念漂移时只能通过在线更新机制缓慢适应新概念,存在较大的自适应延迟。

3.5 运行时间比较

本节比较了5种算法在7个数据集上的运行时间,结果如表6所示。总体来说,在线集成方法在运行时间上整体优于基于数据块的集成方法,其中OOB的平均运行时间最短,主要是该方法没有成员分类器的加权和淘汰机制,也不需要额外的开销去保存任何历史数据,在整个分类阶段只需要保持集成模型的在线更新和对少数实例的过采样。Learn++.NIE的平均运行时间最长,主要是在成员分类器权重计算阶段,Learn++.NIE方法不仅考虑该分类器在当前数据块上的分类性能,同时还要兼顾其在历史数据块上的性能,最终导致决策时间消耗变大。IWEIL方法是在基于数据块的集成上引入了在线更新机制,平均运行时间低于基于数据块的集成方法,高于在线集成方法,符合预期结果,其中IWEIL算法在AnnSMOTE方法中寻找前后数据块中的少数最近邻时时间消耗较大。

3.6 算法统计分析

为了验证IWEIL与其他模型之间是否在统计学上存在显著差距,本节对G-mean和recall性能指标进行了置信度为95%的Nemenyi检验,Nemenyi事后检验的临界差(CD)为1.762,结果如图4、5所示。对G-mean的统计检验表明,IWEIL与DWMIL、Leaen++.NIE、DDM-OCI、OOB之间没有显著差异,但在recall指标的统计检验中,IWEIL优于其他方法。同时在两种指标的检验结果中,IWEIL均名列前茅,总体来说,IWEIL在G-mean和recall性能指标上取得了最稳定及最优异的表现。

3.7 算法应用

为了验证IWEIL的实用性,将其用于安卓应用检测问题,帮助用户识别恶意应用。RevealDroid(Reve)是由项目RevealDroid[22]创建的真实安卓恶意应用的数据集,其样本由220个属性和2个类标签组成,包含了22 538个善意样本,2 528个恶意应用样本。该数据集中的善意样本与恶意样本之间存在类不平衡问题,不平衡率为0.11,同时恶意样本存在概念漂移问题,如某种新的恶意样本突然出现所产生的突变型概念漂移,再如某种旧的恶意样本逐渐变化为新的恶意样本所产生的渐变型概念漂移。

图6为IWEIL算法在Reve数据集上的实验结果,其中G-mean平均值为81.45%,表明IWEIL能够较好地平衡善意样本与恶意样本之间的分类性能;recall平均值为78.52%,表明IWEIL能够较好地分类识别出恶意应用样本。IWEIL首先采用AnnSmote方法对不平衡数据块进行处理,该方法与现有基于数据块的集成方法相比,无须保存先前数据块中的少数类实例,因此IWEIL的内存开销较小,可以处理海量数据样本,对真实的安卓恶意样本处理效率较高。同时,IWEIL采用增量加权集成机制,用最新的数据样本更新基分类及其权重,删除表现不佳的分类器,保证了分类器在善意样本与恶意样本之间的分类性能。

4 结束语

本文首先对数据流中的类不平衡问题和概念漂移进行了详细介绍,并对相应的解决方法进行了概述。随后提出了一种新的不平衡数据流分类方法IWEIL,它充分利用了基于块的学习和在线学习的优势,能够快速适应变化,有效解决了不平衡数据流中的概念漂移问题。IWEIL算法中的每个基分类器都是基于数据块创建的,同时由实例逐个增量更新。为了评估基分类器的性能,提出了一种基于可变大小窗口的新型遗忘机制,它根据基分类器在最新实例上的表现来估计基分类器的分类性能,并将估计值作为权重分配给IWEIL中的基分类器。对于不平衡数据块,IWEIL根据少数类实例在前后数据块中的分布变化,自适应调整用于重采样的最近邻样本数量,生成有价值的少数类实例,从而平衡数据块中的类别分布。通过在安卓应用检测问题Reve数据集上的应用,证明了IWEIL的应用价值。

本文将IWEIL与四种主流的同类方法在人工数据集和真实数据集上进行了对比,实验结果表明,该算法在G-mean和recall上都取得了较好的效果,证明了IWEIL方法的有效性,IWEIL在少数类别上保持较好性能的同时没有牺牲在多数类别上的性能。后续研究工作将进一步探究IWEIL在多分类数据流上的应用。

参考文献:

[1]Ditzler G,Roveri M,Alippi C,et al. Learning in nonstationary environments: a survey [J]. IEEE Computational Intelligence Magazine,2015,10(4): 12-25.

[2]Lu Jie,Liu Anjin,Fan Dong,et al. Learning under concept drift: a review [J]. IEEE Trans on Knowledge and Data Engineering,2018,31(12): 2346-2363.

[3]He Haibo,Garcia E A. Learning from imbalanced data [J]. IEEE Trans on Knowledge and Data Engineering,2009,21(9): 1263-1284.

[4]Wang Shuo,Minku L L,Yao Xin. A systematic study of online class imbalance learning with concept drift [J]. IEEE Trans on Neural Networks and Learning Systems,2018,29(10): 4802-4821.

[5]Wang Shuo,Minku L L,Yao Xin. Resampling-based ensemble me-thods for online class imbalance learning [J]. IEEE Trans on Know-ledge and Data Engineering,2014,27(5): 1356-1368.

[6]Wang Shuo,Minku L L,Yao Xin. A learning framework for online class imbalance learning [C]// Proc of IEEE Symposium on Computational Intelligence and Ensemble Learning. Piscataway,NJ: IEEE Press,2013: 36-45.

[7]梁斌,李光輝,代成龙. 数面向概念漂移且不平衡数据流的G-mean加权分类方法 [J]. 计算机研究与发展,2022,59(12): 2844-2857. (Liang Bin,Li Guanghui,Dai Chenglong. G-mean weighted classification method for imbalanced data stream with concept drift [J]. Journal of Computer Research and Development,2022,59(12): 2844-2857.)

[8]Wang Heng,Abraham Z. Concept drift detection for streaming data [EB/OL]. (2015-05-03). https://arxiv.org/pdf/1504.01044.pdf.

[9]Gao Jing,Fan Wei,Han Jing,et al. A general framework for mining concept-drifting data streams with skewed distributions [C]// Proc of SIAM International Conference on Data Mining. [S.l.]: SIAM,2007: 3-14.

[10]Chen Sheng,He Haibo. Sera: selectively recursive approach towards nonstationary imbalanced stream data mining [C]// Proc of the 18th International Joint Conference on Neural Networks. Piscataway,NJ: IEEE Press,2009: 522-529.

[11]Chen Sheng,He Haibo. Towards incremental learning of nonstationary imbalanced data stream: a multiple selectively recursive approach [J]. Evolving Systems,2011,2(1): 35-50.

[12]Ditzler G,Polikar R. Incremental learning of concept drift from strea-ming imbalanced data [J]. IEEE Trans on Knowledge and Data Engineering,2013,25(10): 2283-2301.

[13]Chawla N V,Bowyer K M,Hall L O,et al. Synthetic minority over-sampling technique [J]. Journal of Artificial Intelligence Research,2002,16(1): 321-357.

[14]Brzezinski D,Stefanowski J. Reacting to different types of concept drift: the accuracy updated ensemble algorithm [J]. IEEE Trans on Neural Networks and Learning Systems,2013,25(1): 81-94.

[15]王俊紅,郭亚惠. 面向动态数据块的非平衡数据流分类算法 [J]. 计算机工程与应用,2021,57(13): 124-129. (Wang Junhong,Guo Yahui. Imbalanced data stream classification algorithm for dynamic data chunk [J]. Computer Engineering and Applications,2021,57(13): 124-129. )

[16]许冠英,韩萌,王少峰,等. 数据流集成分类算法研究综述 [J]. 计算机应用研究,2019,37(1): 1-8,15. (Xu Guanying,Han Meng,Wang Shaofeng,et al. Summarization of data stream ensemble classification algorithm [J]. Application Research of Computers,2019,37(1): 1-8,15. )

[17]Kelly M G,Hand D J,Adams N M. The impact of changing populations on classifier performance [C]// Proc of the 5th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York: ACM Press,1999: 367-371.

[18]Lu Ning,Lu Jie,Zhang Guangquan,et al. A concept drift-tolerant case-base editing technique [J]. Artificial Intelligence,2016,230(1): 108-133.

[19]Kolter J Z,Maloof M A. Dynamic weighted majority: an ensemble method for drifting concepts [J]. Journal of Machine Learning Research,2007,8: 2755-2790.

[20]Jiao Botao,Guo Yinan,Gong Dunwei,et al. Dynamic ensemble selection for imbalanced data streams with concept drift [J]. IEEE Trans on Neural Networks and Learning Systems,2022,35(1): 1278-1291.

[21]Liu Anjin,Song Yiliao,Zhang Guanquan,et al. Regional concept drift detection and density synchronized drift adaptation [C]// Proc of the 26th International Joint Conference on Artificial Intelligence. Palo Alto,CA: AAAI Press,2017: 2280-2286.

[22]Garcia J,Hammad M,Malek S. Lightweight,obfuscation-resilient detection and family identification of Android malware [J]. ACM Trans on Software Engineering and Methodology,2018,26(3):1-29.