基于语序知识的双通道图卷积网络方面级情感分析

2024-05-24黄俊刘洋王庆凤陈立伟邱家林黎茂锋

黄俊 刘洋 王庆凤 陈立伟 邱家林 黎茂锋

摘 要:當前大多数基于图卷积网络的方面级情感分析方法利用文本的句法知识、语义知识、情感知识构建文本依赖,但少有研究利用文本语序知识构建文本依赖,导致图卷积网络不能有效地利用文本语序知识引导方面项学习上下文情感信息,从而限制了其性能。针对上述问题,提出基于语序知识的双通道图卷积网络(dual-channel graph convolutional network with word-order knowledge,WKDGCN)模型,该模型由语序图卷积网络(word-order graph convolutional network,WoGCN)和情感知识结合语义知识增强的句法图卷积网络(sentiment and attention-enhanced graph convolutional network,SAGCN)组成。具体地,WoGCN基于文本的语序知识构建图卷积网络,由文本的语序依赖引导方面项特征学习上下文情感信息;SAGCN利用SenticNet中的情感知识结合注意力机制增强句法依赖,利用增强后的句法依赖构建图卷积网络,以此引导方面项特征学习上下文情感信息;最后融合两个图卷积网络的特征用于情感分类。此外,设计了一种权重分配策略,在放大方面项权重的同时保持上下文权重一致,避免错误的计算方面项特征与重要特征的语义相关性。在多个公开数据集上的实验结果表明,所提方法优于对比模型。

关键词:方面级情感分析; 语序知识; 情感信息; 注意力机制; 句法依赖; 图卷积神经网络

中图分类号:TP391 文献标志码:A

文章编号:1001-3695(2024)03-019-0779-07

doi:10.19734/j.issn.1001-3695.2023.07.0310

Dual-channel graph convolutional network with word-orderknowledge for aspect-based sentiment analysis

Huang Jun, Liu Yang, Wang Qingfeng, Chen Liwei, Qiu Jialin, Li Maofeng

(School of Computer Science & Technology, Southwest University of Science & Technology, Mianyang Sichuan 621010, China)

Abstract:At present, most of the aspect-based sentiment analysis methods based on graph convolutional network use the syntactic knowledge, semantic knowledge and sentiment knowledge of text to construct text dependency, but few studies have made use of text word-order knowledge to build text dependency.As a result, graph convolutional networks cant effectively use text word order knowledge to guide aspects to learn contextual sentiment information, thus limiting its performance. Aiming at the above problems, this paper proposed an aspect-based sentiment analysis model of dual-channel graph convolutional network with word-order knowledge(WKDGCN), which consisted of WoGCN and SAGCN. Specifically, WoGCN constructed a graph convolutional network based on the word-order knowledge of text, and learned contextual sentiment information by re-lying on the characteristics of the guiding aspect of the text word order. SAGCN used the sentiment knowledge in SenticNet combined with the attention mechanism to enhance syntactic dependence, and used the enhanced syntactic dependence to construct a graph convolutional network,so as to guide the aspect features to learn contextual emotional information. Finally,it fused the features of two graph convolutional networks for sentiment classification. In addition,it designed a weight allocation strategy to keep the context weights consistent while amplifying the weights of the terms to avoid erroneous calculation of the semantic correlation between the features of the terms and the important features. Experimental results on several public data sets show that the proposed method is superior to the comparison models.

Key words:aspect-based sentiment analysis; word-order knowledge; sentiment information; attention mechanism; syntactic dependence; graph convolutional network

0 引言

在Web 2.0的时代背景下,社交媒体每时每刻都在产生大量带有情感极性的文本信息,为了挖掘其中的有益价值,情感分析、意见挖掘等[1]逐渐成为自然语言处理(natural language processing,NLP)领域的热门研究话题。方面级情感分析(aspect-based sentiment analysis,ABSA)能够对文本中特定方面项的情感极性进行预测,而非单纯预测整条文本的情感极性,所以其又被称为细粒度的情感分析。以“The food is good, but the service is terrible.”为例,文本中有“food”和“service”两个方面项,对应的意见项分别是“good”和“terrible”,ABSA任务的目标就是建立方面项与意见项之间的联系,从而判断出两个方面项的情感极性分别为正向和负向。

当前,大多数基于图卷积网络的方面级情感分析利用文本的句法知识、语义知识、情感知识构建文本依赖[2~6],但是目前利用语序知识构建文本依赖的研究尚有不足,导致图卷积网络不能有效地利用文本的语序知识引导方面项学习上下文情感信息,从而影响模型在ABSA任务上的性能,并且融合蕴涵多种文本知识的特征能有效提升模型的性能[3,4]。为有效融合文本的语序特征以增强模型的分类性能,本文提出基于语序知识的双通道图卷积网络(WKDGCN)方面级情感分析模型。

WKDGCN由语序图卷积网络(WoGCN)和句法增强图卷积网络(SAGCN)组成。首先,利用文本的语序知识构建文本语序依赖,并基于语序依赖构建图卷积网络WoGCN通道;其次,结合SenticNet中的情感知识和注意力机制增强句法依赖,并基于增强的句法依赖构建图卷积网络SAGCN通道;最后融合两个通道的特征用于情感分类。此外,为避免错误的计算方面项特征与重要特征的语义相关性,设计了一种权重分配策略,该策略在放大方面项权重的同时保持上下文权重一致。最终在多个公开数据集上的实验结果表明,本文WKDGCN模型相较于对比模型在ABSA任务上性能更优。

本文主要贡献总结如下:a)提出一种基于文本语序知识的文本依赖构建方法;b)构建WKDGCN模型,其由WoGCN与SAGCN组成,WoGCN利用文本的语序知识引导方面项聚合上下文情感信息,SAGCN利用SenticNet中的情感知识结合注意力机制增强句法依赖,将文本的语义知识和情感知识融入到句法依赖中;c)设计了一种权重分配策略,在放大方面项权重的同时保持上下文权重一致,避免模型错误的计算方面项特征与重要特征的语义相关性。

1 相关工作

方面级情感分析的概念由Thet等人[7]在2010年明确提出。早期受限于硬件条件,大多数研究建立在传统机器学习算法的基础上,如在最大熵、支持向量机等经典机器学习模型的基础上结合情感词典、依赖信息等对情感进行分类[8]。这些方法需要投入较大的人力成本和时间成本,随着硬件设备的改良与升级,深度学习得到良好的应用环境,大大降低了人力成本与时间成本,深度学习逐渐成为主流研究方法。

循环神经网络(recurrent neural network,RNN) [9]擅长处理有序列特性的数据,因此在NLP领域得到了广泛应用,长短时记忆网络(long short term memory,LSTM)[10]和门控循环单元(gated recurrent unit,GRU)[11]是RNN的两个有效变体,两者在传统RNN的基础上引入门控机制,有效克服了传统RNN梯度爆炸和梯度弥散的问题。Tang等人[12]提出TD-LSTM、TC-LSTM两个改进模型用于方面级情感分析,整合了方面项与上下文的相互关联信息,取得了比标准LSTM更好的效果。最近在ABSA任务上也有许多利用注意力机制捕捉上下文语义相关性特征[13]而开展的工作。Wang等人[14]提出基于注意力机制的长短时记忆网络ATAE-LSTM,用于方面级情感分析。Tan等人[15]提出带有双注意力机制的多标签分类模型,提升了模型对带有冲突意见的方面项情感分类性能。另外,Devlin等人[16]提出的基于注意力机制的BERT预训练模型也一度刷新了NLP领域的各大任务成果。Sun等人[17]提出构造NLI_B、NLI_M、QA_B、QA_M四种辅助句,再微调BERT模型,从句子对分类的角度考虑ABSA任务,取得了良好效果。Xu等人[18]针对ABSA任务提出了一种基于BERT的后训练微调方式,提升了BERT预训练模型在微调ABSA任务上的性能。循环神经网络以及注意力机制能有效建模文本的上下文信息,但其不能有效利用外部的文本依赖信息。

而利用文本依赖有助于建立方面项与上下文之间的联系,以此引导方面项学习上下文情感信息。遵循这一思路,基于图数据的图卷积网络被广泛应用于ABSA任务。Lu等人[19]设计了一种星形图,并提出基于节点和基于文档的分类方法,用于情感分析并取得了良好效果; Liang等人[20]提出依赖关系嵌入式图卷积网络DREGCN,并设计了一个有效的消息传递机制以充分利用语法知识,在ABSA任务上取得了良好成果;赵振等人[21]提出基于关系交互的图注意力网络模型,使用一个新的扩展注意力来引导信息从方面项的句法上下文传播到方面项本身;Pang等人[22]通过句法依赖树和多头注意力机制分别生成句法依赖图和语义图,并提出一种动态多通道图卷积网络DM-GCN来有效地从生成的图中学习相关信息;Tang等人[23]利用依赖关系标签构建语法感知潜在图,并设计了一个情感细化策略引导网络捕捉重要的情感线索;杨春霞等人[24]提出基于注意力与双通道的模型TCCM,实现了通道内信息的殘差互补,有效结合了句法与语义关联信息;Li等人[25]提出一种双图卷积神经网络DualGCN,同时对语法知识和语义知识进行学习,并提出了正交正则化器和差分正则化器鼓励句法知识和语义知识相互感知学习;Xing等人[26]提出DigNet模型,设计了一种局部全局交互图,结合句法图和语义图,实现图知识有益交互。

虽然以上基于文本句法知识、语义知识、情感知识构建图神经网络的方法在ABSA任务上取得了良好效果,但它们缺乏对基于语序知识构建图卷积网络的研究。为探究文本语序知识对模型性能的影响,本文提出基于语序知识的双通道图卷积网络方面级情感分析模型。

2 WKDGCN模型构建

本文模型的网络结构如图1所示,主要由四个部分组成:

a)词嵌入与BiLSTM层。输入序列文本,输出富含上下文情感信息的文本词向量矩阵表示H。

b)双通道图卷积网络。基于文本的语序依赖以及注意力机制结合情感知识增强句法依赖分别构建WoGCN与SAGCN,再输出融合两个通道输出的文本特征hGCN。

c)权重分配策略。基于方面项的局部特征和聚合多种文本知识的方面项特征进行注意力计算,在上下文特征权重保持一致的情况下放大方面项权重。

d)输出模块。将经过步骤c)得到的权重反馈到BiLSTM中,以输出最终的文本特征用于分类。

2.1 词嵌入与BiLSTM层

词嵌入与BiLSTM层的目的是获取用于训练模型的词向量表示与富含上下文情感信息的文本特征。实现方法如下:

首先,使用GloVe[27]将文本S={W1,…,Wa+1,…,Wa+m,…,Wn}映射为300维的词向量矩阵E={e1,…,ea+1,…,ea+m,…,en},其中n表示文本S的长度,en是Wn的词向量表示,然后经过BiLSTM训练词向量矩阵E得到文本隐藏向量表示H={h1,…,ha+1,…,ha+m,…,hn}。

2.2 双通道图卷积网络构建

本文WKDGCN由基于语序依赖的WoGCN与基于注意力机制与情感知识增强的句法依赖的SAGCN组成,接下来将逐步实现WKDGCN的构建。

2.2.1 语序图卷积网络WoGCN构建

WoGCN是基于文本语序依赖构建的图卷积网络,其核心是构建语序依赖,文本的语序由单词的语序与单词之间的相对语序构成。其中,单词的语序表示如式(1)所示。

3 实验

3.1 实验数据集

本文选择Twitter、restaurant14(简写为Rest14)、laptop14(简写为Lap14)和restaurant16(简写为Rest16)四个公开数据集作为实验数据集。数据集由正、中、负三种情感极性数据组成。每个样本由一条文本评论、一个或多个单词组成的方面项以及对应的意见项组成。数据集信息如表2所示。

3.2 对比模型

ATAE-LSTM:使用BiLSTM来捕捉上下文信息,并使用方面项特征和注意力机制,将方面词与上下文信息相结合。

IAN:使用BiLSTM来编码句子中的上下文信息,并使用交互式注意力机制建模方面词和上下文之间的关系,以捕捉方面词对情感的影响。RAM:使用多头注意力机制计算方面词和上下文单词之间的关系,并使用记忆网络来学习句子的词嵌入表示。

MGAN:提出多粒度注意力机制以及方面对齐损失来学习方面项与上下文之间的词级交互。

TNet:该模型在CNN和BiLSTM之间添加了一个组件来生成方面项的特征,并使用CNN提取BiLSTM的文本特征。

AEN-GloVe:该模型使用了GloVe预训练词向量来表示单词,使用卷积神经网络(CNN)来提取方面词信息,并使用双向LSTM来编码上下文信息。

ASGCN:该模型首次提出了使用图卷积神经网络GCN来学习用于ABSA任务的特定方面项表示。

CDT:该模型利用BiLSTM学习句子的特征表示,然后使用GCN来增强从BiLSTM中学习到的特征。

BiGCN:该模型使用双层交互式图卷积神经网络来建模方面词和上下文单词之间的交互关系,以便更好地捕捉方面词对情感的影响。

kumaGCN:使用潜在的图结构来补充句法特征。

R-GAT:提出了一种面向方面项的依赖树结构,然后使用关系图注意网络GAT对面向方面项的依赖树进行编码。

DGEDT:设计了一个双向转换结构,以相互增强的方式融合句法依赖知识和具有丰富上下文信息知识。IMA:提出一个基于交互矩阵和全局注意力机制模型,以提高模型性能。

CPA-SA:设计了两个不对称的上下文权重函数来调整方面项的权重。

本文选择的对比模型包括从2016—2022年的经典基线模型,其中ATAE-LSTM、IAN、RAM、MGAN、TNet、AEN-GloVe、IMA、CPA-SA仅考虑文本的上下文语义信息, ASGCN、CDT、BiGCN、kumaGCN、R-GAT、DGEDT在上下文语义信息的基础上加入了文本的结构信息。

3.3 实验环境与参数设置

本文网络模型基于PyTorch深度学习框架搭建,模型具体训练环境如表3所示。

为了防止模型出现过拟合的情况,本文模型在BiLSTM层与图卷积层设置了不同的dropout值,具体参数设置如表4所示。

3.4 评价指标

为便于与模型对比,选择ABSA任务通用评价指标准确率accuracy和宏平均Macro-F1来评价本文模型的性能,表5中分别用Acc和F1代指。

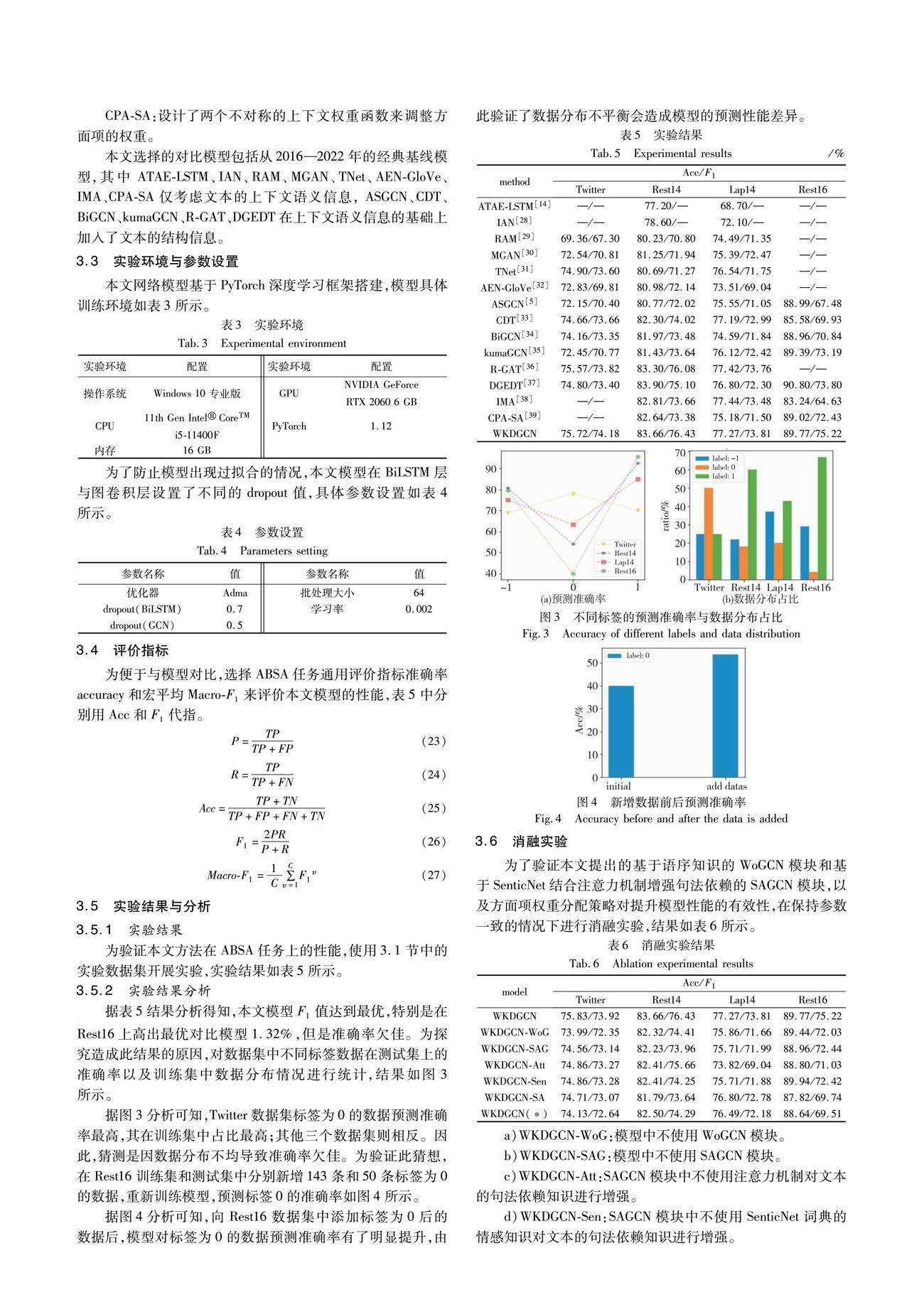

3.5 实验结果与分析

3.5.1 实验结果

为验证本文方法在ABSA任务上的性能,使用3.1节中的实验数据集开展实验,实验结果如表5所示。

3.5.2 實验结果分析

据表5结果分析得知,本文模型F1值达到最优,特别是在Rest16上高出最优对比模型1.32%,但是准确率欠佳。为探究造成此结果的原因,对数据集中不同标签数据在测试集上的准确率以及训练集中数据分布情况进行统计,结果如图3所示。

据图3分析可知,Twitter数据集标签为0的数据预测准确率最高,其在训练集中占比最高;其他三个数据集则相反。因此,猜测是因数据分布不均导致准确率欠佳。为验证此猜想,在Rest16训练集和测试集中分别新增143条和50条标签为0的数据,重新训练模型,预测标签0的准确率如图4所示。

据图4分析可知,向Rest16数据集中添加标签为0后的数据后,模型对标签为0的数据预测准确率有了明显提升,由此验证了数据分布不平衡会造成模型的预测性能差异。

3.6 消融实验

为了验证本文提出的基于语序知识的WoGCN模块和基于SenticNet结合注意力机制增强句法依赖的SAGCN模块,以及方面项权重分配策略对提升模型性能的有效性,在保持参数一致的情况下进行消融实验,结果如表6所示。

a)WKDGCN-WoG:模型中不使用WoGCN模块。

b)WKDGCN-SAG:模型中不使用SAGCN模块。

c)WKDGCN-Att:SAGCN模块中不使用注意力机制对文本的句法依赖知识进行增强。

d)WKDGCN-Sen:SAGCN模块中不使用SenticNet词典的情感知识对文本的句法依赖知识进行增强。

e)WKDGCN-SA:SAGCN模块中不使用注意力机制和SenticNet词典的情感知识对文本的句法依赖知识进行增强,仅使用文本句法依赖。

f)WKDGCN(*):模型中不使用本文提出的权重分配策略。

综上,在移除本文模块的情况下,模型的性能均有明显下降,从而印证了本文方法对提升模型性能的有效性。

3.7 案例分析

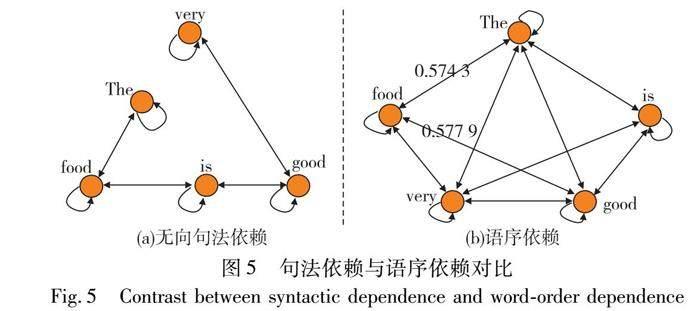

为了更好地分析本文提出的基于语序知识构建的文本依赖对情感分析结果的影响,以“The food is very good”为例进行分析。“food”是该样例的方面项,“good”是表达其情感极性的意见项,据图2可知方面项“food”与意见项“good”没有直接的联系,导致GCN不能直接将意见项的情感信息聚合到方面项,进而增大了模型错误分类情感极性的概率,而使用本文提出的基于语序知识构建文本依赖的方法能够直接在方面项“food”与表达其情感极性的意见项“good”之间建立联系,并且能根据式(3)计算出不同词组之间的依赖程度(例如词组“The-food”和词组“food-good”之间的依赖程度分别是0.574 3和0.577 9),使得GCN能直接将意见项的情感信息聚合到意见项,从而增强模型的性能。两者对比如图5所示。

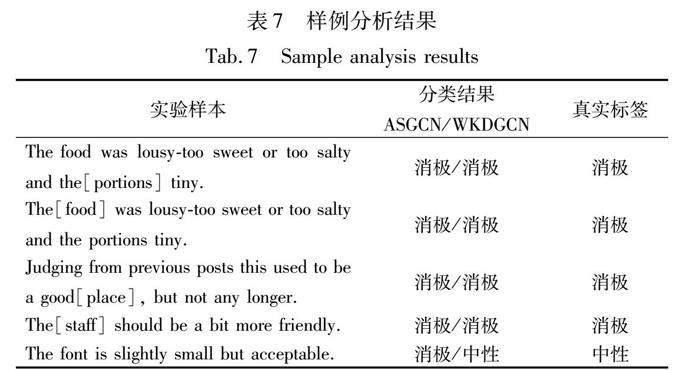

最后,使用五条数据在仅基于句法知识的图卷积网络模型ASGCN[5]与本文提出的基于语序知识双通道图卷积网络WKDGCN模型上验证模型的性能,结果如表7所示。

从表7可以看出,文本中无论是有多个方面项还是单个方面项,本文模型依靠语序依赖都能够捕捉到正确的意见项,相比于对比模型具有更高的可靠性。

使用Twitter评论数据集、关于饭店的评论数据集Rest14和Rest16以及笔记本电脑评论数据集Lap14进行实验,本文模型均有不俗表现,说明模型适用于多种领域类型的文本数据,因此该模型可以扩展应用到各行各业的数据上,为各个行业的运营情况作出针对性的指导,具有较大的应用前景。比如:根据电商产品评论分析出用户对商品具体某些方面的情感极性倾向,进而分析出用户对产品的购买欲,以便商家根据情感倾向制定相应的营销策略;根据人们对某热点事件的网络评论分析出人们对事件某些方面的情感关注点,以便相关部门正确预测由事件引导的舆论走向并制定出相应的政策等。

4 结束语

本文提出基于语序知识构建文本依赖,并基于语序依赖构建双通道图卷积网络模型WKDGCN用于方面级情感分析,模型由基于语序依赖的WoGCN模块与情感知识结合注意力机制增强的句法图卷积网络SAGCN模块组成。此外,设计了一种权重分配策略,在放大方面项权重的同时保持上下文权重一致,避免方面项错误的计算与重要特征的语义相关性,最终在Twitter、Rest14、Lap14、Rest16四个公开数据集上取得了较对比模型更好的效果。同时消融实验的结果与分析也验证了本文方法的有效性。

虽然本文方法在ABSA任务上取得了不错的效果,但在特征融合策略上的工作仍有欠缺;另外,模型的泛化性还有待提升,对预测效果不好的数据类型可以使用过采样、数据增强等方式提升模型在这些类型数据上的泛化性能。以后工作可以围绕这两个方面继续开展,以提升模型的性能。

参考文献:

[1]Liu Bing, Zhang Lei. A survey of opinion mining and sentiment analysis[M]//Aggarwal C C, Zhai Chengxiang. Mining Text Data. Boston, MA: Springer, 2012: 415-463.

[2]Yu Chengze, Wu Taiqiang, Li Jiayi, et al. SynGen: a syntactic plug-and-play module for generative aspect-based sentiment analysis[C]//Proc of IEEE International Conference on Acoustics, Speech and Signal Processing. Piscataway, NJ: IEEE Press, 2023: 1-5.

[3]李帥, 徐彬, 韩祎珂, 等. SS-GCN: 情感增强和句法增强的方面级情感分析模型[J]. 计算机科学, 2023,50(3): 3-11. (Li Shuai, Xu Bin, Han Yike, et al. SS-GCN: aspect-based sentiment analysis model with affective enhancement and syntactic enhancement[J]. Computer Science, 2023,50(3): 3-11.)

[4]Liang Bin, Su Hang, Gui Lin, et al. Aspect-based sentiment analysis via affective knowledge enhanced graph convolutional networks[J]. Knowledge-Based Systems, 2022,235: 107643.

[5]Zhang Chen, Li Qiuchi, Song Dawei. Aspect-based sentiment classification with aspect-specific graph convolutional networks[EB/OL]. (2019-10-13). https://arxiv.org/abs/1909.03477.

[6]陽影, 张凡, 李天瑞. 基于情感知识的双通道图卷积网络的方面级情感分析[J]. 计算机科学, 2023,50(5): 230-237. (Yang Ying, Zhang Fan, Li Tianrui. Aspect-based sentiment analysis based on dual-channel graph convolutional network with sentiment know-ledge[J]. Computer Science, 2023,50(5): 230-237.)

[7]Thet T T, Na J C, Khoo C S G. Aspect-based sentiment analysis of movie reviews on discussion boards[J]. Journal of Information Science, 2010,36(6): 823-848.

[8]Wiebe J, Wilson T, Cardie C. Annotating expressions of opinions and emotions in language[J]. Language Resources and Evaluation, 2005,39: 165-210.

[9]Zaremba W, Sutskever I, Vinyals O. Recurrent neural network regularization[EB/OL]. (2015-02-19). https://arxiv.org/abs/1409.2329.

[10]Hochreiter S, Schmidhuber J. Long short-term memory[J]. Neural Computation, 1997,9(8): 1735-1780.

[11]Dey R, Salem F M. Gate-variants of gated recurrent unit(GRU) neural networks[C]//Proc of the 60th International Midwest Symposium on Circuits and Systems. Piscataway, NJ: IEEE Press, 2017: 1597-1600.

[12]Tang Duyu, Qin Bing, Feng Xiaocheng, et al. Effective LSTMs for target-dependent sentiment classification[EB/OL]. (2016-09-29). https://arxiv.org/abs/1512.01100.

[13]Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need [EB/OL]. (2023-08-02). https://arxiv.org/abs/1706.03762.

[14]Wang Yequan, Huang Minlie, Zhu Xiaoyan, et al. Attention-based LSTM for aspect-level sentiment classification[C]//Proc of Confe-rence on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2016: 606-615.

[15]Tan Xingwei, Cai Yi, Zhu Changxi. Recognizing conflict opinions in aspect-level sentiment classification with dual attention networks[C]//Proc of Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2019: 3426-3431.

[16]Devlin J, Chang M W, Lee K, et al. BERT: pre-training of deep bidirectional transformers for language understanding[EB/OL]. (2019-05-24). https://arxiv.org/abs/1810.04805.

[17]Sun Chi, Huang Luyao, Qiu Xipeng. Utilizing BERT for aspect-based sentiment analysis via constructing auxiliary sentence[EB/OL]. (2019-03-22). https://arxiv.org/abs/1903.09588.

[18]Xu Hu, Liu Bing, Shu Lei, et al. BERT post-training for review reading comprehension and aspect-based sentiment analysis[EB/OL]. (2019-05-04). https://arxiv.org/abs/1904.02232.

[19]Lu Haonan, Huang S H, Ye Tian, et al. Graph star net for genera-lized multi-task learning [EB/OL]. (2019-06-21). https://arxiv.org/abs/1906.12330.

[20]Liang Yunlong, Meng Fandong, Zhang Jinchao, et al. A dependency syntactic knowledge augmented interactive architecture for end-to-end aspect-based sentiment analysis[J]. Neurocomputing, 2021, 454: 291-302.

[21]趙振, 朱振方, 王文玲. 基于关系特征交互的方面级情感分类方法[J]. 计算机技术与发展, 2023,33(3): 187-193. (Zhao Zhen, Zhu Zhenfang, Wang Wenling. An aspect-level sentiment classification method based on relational feature interaction[J]. Computer Technology and Development, 2023,33(3): 187-193.)

[22]Pang Shiguan, Xue Yun, Yan Zehao, et al. Dynamic and multi-channel graph convolutional networks for aspect-based sentiment analysis[C]//Proc of Findings of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2021: 2627-2636.

[23]Tang Siyu, Chai Heyan, Yao Ziyi, et al. Affective knowledge enhanced multiple-graph fusion networks for aspect-based sentiment analysis[C]//Proc of Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computatio-nal Linguistics, 2022: 5352-5362.

[24]杨春霞, 徐奔, 桂强, 等. 基于注意力与双通道网络的方面级情感分析[J]. 南京信息工程大学学报: 自然科学版, 2023,15(1): 42-50. (Yang Chunxia, Xu Ben, Gui Qiang, et al. Aspect-based sentiment analysis based on attention and dual-channel network[J]. Journal of Nanjing University Science & Technology: Natural Science Edition, 2023, 15(1): 42-50.)

[25]Li Ruifan, Chen Hao, Feng Fangxiang, et al. Dual graph convolutional networks for aspect-based sentiment analysis[C]//Proc of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2021: 6319-6329.

[26]Xing Bowen, Tsang I. DigNet: digging clues from local-global interactive graph for aspect-level sentiment classification[EB/OL]. (2022-05-02). https://arxiv.org/abs/2201.00989.

[27]Pennington J, Socher R, Manning C D. GloVe: global vectors for word representation[C]//Proc of Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2014: 1532-1543.

[28]Ma Dehong, Li Sujian, Zhang Xiaodong, et al. Interactive attention networks for aspect-level sentiment classification[C]//Proc of the 26th International Joint Conference on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2017: 4068-4074.

[29]Chen Peng, Sun Zhongqian, Bing Lidong, et al. Recurrent attention network on memory for aspect sentiment analysis[C]//Proc of Confe-rence on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2017: 452-461.

[30]Fan Feifan, Feng Yansong, Zhao Dongyan. Multi-grained attention network for aspect-level sentiment classification[C]//Proc of Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2018: 3433-3442.

[31]Li Xin, Bing Lidong, Lam W, et al. Transformation networks for target-oriented sentiment classification[C]//Proc of the 56th Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2018: 946-956.

[32]Song Youwei, Wang Jiahai, Jiang Tao, et al. Targeted sentiment classification with attentional encoder network[C]//Proc of International Conference on Artificial Neural Networks. Berlin: Springer, 2019: 93-103.

[33]Sun Kai, Zhang Richong, Mensah S, et al. Aspect-level sentiment analysis via convolution over dependency tree[C]//Proc of Confe-rence on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2019: 5679-5688.

[34]Zhang Mi, Qian Tieyun. Convolution over hierarchical syntactic and lexical graphs for aspect level sentiment analysis[C]/Proc of Confe-rence on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2020: 3540-3549.

[35]Chen Chenhua, Teng Zhiyang, Zhang Yue. Inducing target-specific latent structures for aspect sentiment classification[C]//Proc of Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2020: 5596-5607.

[36]Wang Kai, Shen Weizhou, Yang Yunyi, et al. Relational graph attention network for aspect-based sentiment analysis[EB/OL]. (2020-04-26). https://arxiv.org/abs/2004.12362.

[37]Tang Hao, Ji Donghong, Li Chenliang, et al. Dependency graph enhanced dual-transformer structure for aspect-based sentiment classification[C]//Proc of the 58th Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2020: 6578-6588.

[38]Wang Xiaodi, Pan Xiaoge, Yang Tian, et al. Aspect-based sentiment analysis using interaction matrix and global attention neural network[J]. The Computer Journal, 2023, 66(5): 1167-1183.

[39]Huang Bo, Guo Ruyan, Zhu Yimin, et al. Aspect-level sentiment analysis with aspect-specific context position information[J]. Know-ledge-Based Systems, 2022, 243(C): 108473.