基于代理选举的高效异构联邦学习方法

2024-05-24王光辉白天水丁爽何欣

王光辉 白天水 丁爽 何欣

摘 要:物联网多样性终端设备在计算、存储、通信方面的异构性导致联邦学习效率不足。针对上述联邦训练过程中面临的问题,基于代理选举思路,提出了一种高效联邦学习算法。设计了基于马氏距离的代理节点选举策略,将设备的计算能力与闲置时长作为选举因素,选举性价比高的设备作为代理节点,充分发挥设备计算能力。进一步设计了基于代理节点的新型云边端联邦学习架构,提升了异构设备之间的联邦学习效率。基于MNIST和CIFAR-10公开数据集与智能家居设备真实数据的实验表明,该联邦学习方法的效率提高了22%。

关键词:联邦学习;设备异构;代理选举;云边端;高效性

中图分类号:TP301 文献标志码:A

文章编号:1001-3695(2024)03-007-0688-06

doi:10.19734/j.issn.1001-3695.2023.06.0297

Efficient and heterogeneous federated learning based on agent election

Wang Guanghui1,2,Bai Tianshui1,Ding Shuang1,2,He Xin1,2

(1.School of Software,Henan University,Kaifeng Henan 475000,China;2.Henan International Joint Laboratory of Intelligent Network Theory & Key Technology,Kaifeng Henan 475000,China)

Abstract:The heterogeneity of diverse end devices in terms of computation,storage,and communication leads to insufficient accuracy and efficiency in federated learning.To address the issues faced in the aforementioned federated training process,this paper presented an efficient federated learning algorithm based on the idea of device agent election.To select agent nodes from diverse devices,it designed a device agent node election strategy based on Mahalanobis distance by considering the devices computational capabilities and idle time as election factors to fully leverage their computing power.Furthermore,it proposed a novel cloud-edge-end federated learning architecture using the agent node to improve the efficiency of federated learning between heterogeneous devices.Experimental results based on the MNIST and CIFAR-10 public datasets and the practical smart home datasets demonstrate that the proposed efficient federated learning algorithm achieves average improvement about 22% in learning efficiency.

Key words:federated learning;device heterogeneity;agent election;cloud-edge-end;efficiency

0 引言

人工智能作为物联网技术的核心场景,正朝着为人们提供更加舒适、便捷服务的方向发展。物联网终端设备分布在人们生活中的各个场景,同时伴随着互联网的发展逐渐升级为智能化[1]。为了向用户提供更加智能化与更优质的服务,设备厂商需要通过数字化设备产品收集人们的生活数据(如语音交互数据、电力使用数据、家庭情景模式等)以优化服务模型。然而,这些生活數据对于用户往往是私密的,所以智能用户在享受优化模型服务的同时,也面临着隐私数据泄露的风险[2]。

联邦学习技术为解决设备场景中的数据隐私保护问题提供了新颖思路。联邦学习利用原始数据集不出本地的模式保证数据隐私与安全。面向终端设备场景的联邦学习算法让模型的训练在设备端进行,将得到的模型更新传输给服务器,从而进行模型的下一步聚合。由于用户的私密数据不出本地,既可以提供模型优化服务,又可以提升数据隐私与安全等级。

然而,设备场景中设备异构性导致了联邦学习效率方面的不足。设备产品数量与样式不断增加,导致设备节点计算能力与通信能力不一致,因此将联邦学习思想应用在终端设备之上,需要考虑如何提高训练模型的准确率以及训练效率。在训练通信负载上,云端直接与设备产品通信,交换数据的方式会增加通信负载[3],降低训练效率。另一方面,智能设备种类与样式层出不穷,智能设备的计算能力各不相同[4]。此外,无计算能力设备中的数据无法参与到整体模型训练,导致训练结果准确率不足。

现有工作已经关注到了异构设备场景中的联邦学习研究。例如:文献[5]提出一种拓扑优化方案,减少智能家居终端场景中低性能设备参与训练时拖慢整体训练效率问题;为了提高终端设备场景下的联邦学习效率,Wu等人[6]提出在边缘客户端设备添加生成卷积自编码器以降低通信成本;文献[7]提出分层模型训练,并采用从多分支模型出发将全局统一模型拆分为适配不同客户端资源的子模型序列,提高了客户端参与度和资源利用效率。然而,针对真实设备的异构性导致的联邦学习效率不足问题,上述研究方案没有充分考虑设备的不同计算能力,仍然需要进一步完善。

由于设备间异构性原因,终端设备种类和计算力参差不齐,比如设备间计算力不相同时,在多个设备组成的集群中,训练效率往往由计算力最低的设备决定。所以为解决设备间异构的情况,本文在终端设备组成的集群中选取一个代理设备,该代理设备拥有集群内较高计算力,能够通过自身计算力解决集群内的任务下发、模型聚合等工作,减少设备异构性导致训练低的问题,提高训练效率;同时在训练时,代理设备能够使当前集群内的终端设备先进行集群内训练,将已经获得较高准确率的模型通过代理设备再与其他集群或者云端模型聚合,可以减少终端设备的训练压力,并且通过代理设备,可以减少每个终端设备间交互过程,减少通信负载,最终提高整体训练效率。

本文从智能设备代理选举的角度研究提升联邦学习效率的新方法。首先,为了充分利用了异构智能设备的不同计算能力,并且保障无算力节点参与联邦学习,将设备的计算能力与闲置时长作为选举因素,并设定终端设备为集群场景进行分组,从每个小组集群参与训练的设备中选举代理节点,在选举算法上设计了基于马氏距离的设备代理节点选举策略,从多样性智能设备中选举代理节点,选举出的代理节点在计算能力等方面优于其他普通设备,可以让性能高的设备发挥作用,减少计算资源浪费,提高整体训练效率。其次,为了提升智能设备场景中联邦学习效率,基于设备代理节点,设计了一种新型的云边端联邦学习架构,借助区域基站和设备代理对学习训练进行分级逐级聚合,减少了异构性设备的通信与计算开销。此外,设备代理节点可以收集无计算能力设备数据,并将其数据进行聚合,提升了模型训练的准确性。本文的贡献总结如下:

a)从设备代理节点选举的角度,提出了一种基于代理选举的高效联邦学习算法(federated learning with agent election,FedAE),充分利用物联网多样性智能设备的计算能力,提升联邦学习算法的效率。

b)设计了一种基于马氏距离的设备代理节点选举策略。设定以终端设备集群分组,从每个集群内参与训练的终端设备中,根据设备的CPU、空闲时长数据,利用马氏距离计算设备的性能相似度表征设备的闲置计算能力,以进行代理节点选举。

c)基于MNIST公开数据集与智能家居设备的真实数据,开展了对比实验,验证了本文算法的有效性。

1 相关工作

数据隐私安全促使对联邦学习的研究成为一个重要课题,并且也广泛应用于医疗、金融、交通、制造业和其他物联网领域[8~17]。文献[5]提出一种拓扑优化方案以减少低性能设备参与训练时拖慢整体训练效率问题,但是在智能家居场景下未考虑没有计算能力设备的情况;文献[18~20]利用对样本优化算法和模型聚合过程选择方法提出了谷歌联邦学习。这些研究方法若应用到智能设备场景下,由于终端设备数据较多,会增加设备参与训练的计算复杂度。

现有工作已经对设备的异构性进行联邦学习开展研究。Cui等人[21]提出利用聚类思想,探索出一种基于迭代自组织数据分析技术算法(ISODATA)的异构感知客户端调度策略,但是没有考虑客户端数据量的问题,若通过该算法统一调度客户端,会使联邦学习面临效率问题。文献[22]针对智能家居场景,分别提出解决复杂场景架构、区块链与联邦学习结合保证数据隐私[23]、强化联邦学习方法以及提高训练准确性,但这些都没有考虑在密集情况下的联邦训练效率问题。为了提高智能设备场景下的联邦学习效率,文献[21,24~27]在设备参与联邦学习时分别提出解决异构设备影响训练效率或准确率的方法,但是都没考虑无计算能力设备如何处理的情况。Liu等人[28]为解决计算能力不一致的问题提出异构模型融合机制(HFL)方法,根据计算能力不同设备训练不同模型的概念,但如果设备数量很大,需要的模型数量也很大,为最终模型聚合增加了压力。所以对于密集智能设备环境和设备的多样性等因素来讲,仍然需要进行相关研究。

除以上关于提高联邦学习效率的相关研究外,也有基于云边端在联邦学习下提高学习效率的研究。文献[29]提出基于云边端的联邦学习,从实验结果可以明显看出,该架构下对于提升联邦学习效率和准确性有很大的帮助,但是未将模型分在每一层上进行模型聚合和更新。而文献[7]提出分层模型训练,并采用从多分支模型出发将全局统一模型拆分为适配不同客户端资源的子模型序列,提高了客户端参与度和资源利用效率。但是在多样性智能设备场景下,复杂设备中将统一模型拆分会面临很大的压力。文献[30]也采用云边端分级模型训练和聚合,但是没有考虑多样性智能设备的场景。

综上述所,本文提出了一种新型适应多样性智能设备场景下云边端的架构体系。一方面,利用设备地理位置优势,单个基站负责所属设备区域单元,将模型进行分压训练聚合,减少通信负载压力,提高整体联邦学习效率;另一方面,在子端设定的设备代理可以充分利用闲置计算资源,提高学习效率,设备代理收集无计算能力设备的数据,在解决计算力多样化场景的同时提高最终训练的准确性。

2 系统架构和问题设置

2.1 联邦學习架构

基于代理选举的新型云边端架构阐述如下。该架构属于一种分布式边缘计算解决架构,多个区域间利用多基站的位置分布,使集群中众多数量的智能设备终端参与训练,并将最终模型进行聚合与更新。在聚集的社区环境中,以终端设备集群为单位进行分组,众多设备所参与的训练任务由基站发布给设备代理。其次,任务通过设备代理传递给智能训练设备,并将本地更新平均聚合返回给基站。其中,每个设备代理是以设备小组为单位,通过自身设定值和小组其他组成训练设备空闲情况以决定此设备代理状态是否参与任务,并且根据参与者的自身计算能力通过选举算法进行选举,成为设备代理。然后设备代理将初始模型和任务分发给小组内其他设备,每个设备代理接收空闲智能设备本地更新内容,最终聚合接收到的内容模型平均值。最后设备代理将该模型更新返回给基站进行二次聚合模型平均值,最终基站将聚合后的状态传递给设备代理,由设备代理分发最终模型更新给智能设备。最终生成的模型状态在基站之间共享。其中,定义ωi、ωj分别表示智能设备本地训练模型状态和设备代理的模型更新状态,ωk(k=1,2,…,O)表示第k个基站的模型状态,O表示参与训练的基站的个数。本文中使用的主要符号及其解释含义如表1所示。

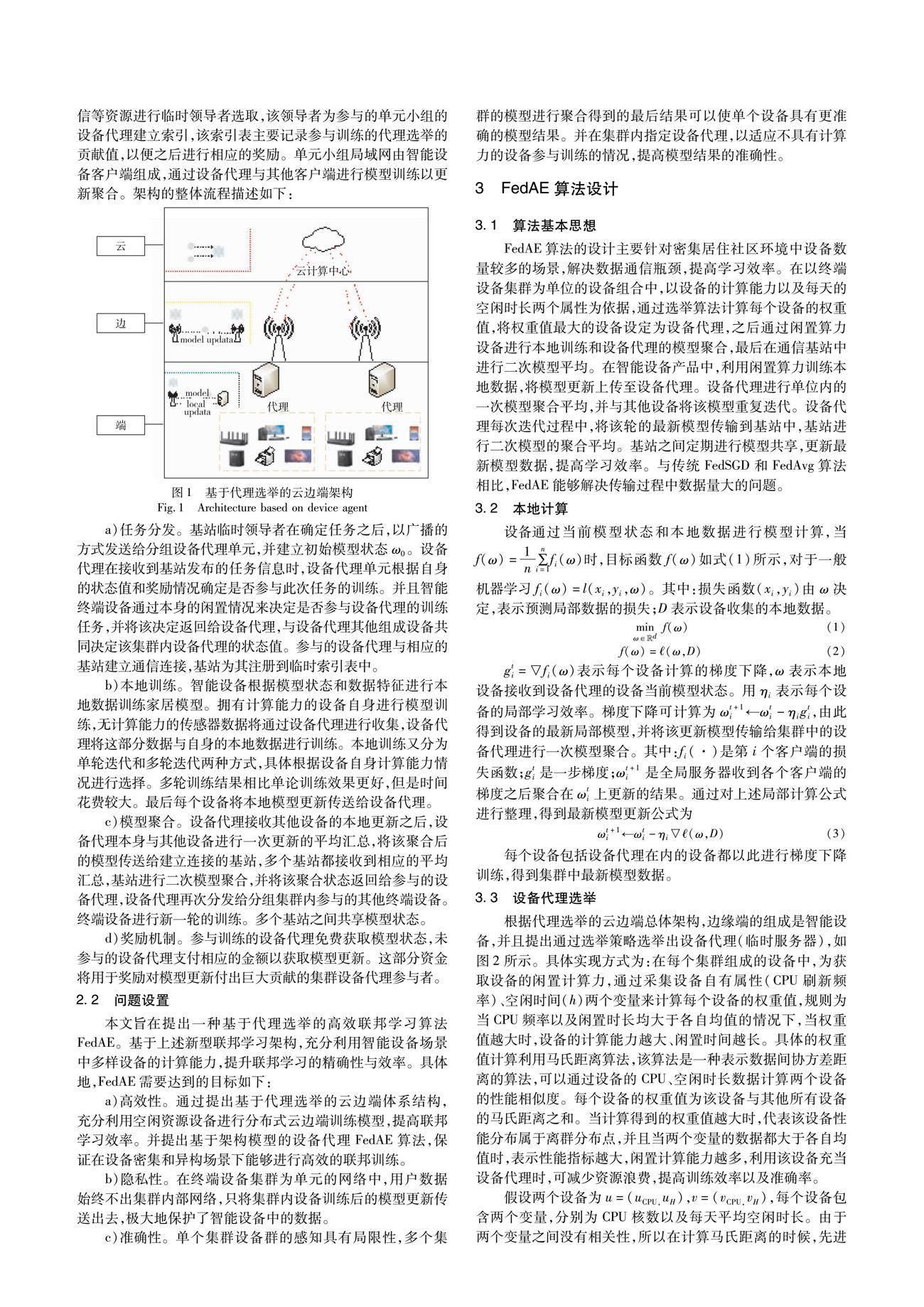

该新型架构的数据交互如图1所示。其中,任务定义和决定由设备厂商或其他上层机构确定。基站利用自身计算和通信等资源进行临时领导者选取,该领导者为参与的单元小组的设备代理建立索引,该索引表主要记录参与训练的代理选举的贡献值,以便之后进行相应的奖励。单元小组局域网由智能设备客户端组成,通过设备代理与其他客户端进行模型训练以更新聚合。架构的整体流程描述如下:

a)任务分发。基站临时领导者在确定任务之后,以广播的方式发送给分组设备代理单元,并建立初始模型状态ω0。设备代理在接收到基站发布的任务信息时,设备代理单元根据自身的状态值和奖励情况确定是否参与此次任务的训练。并且智能终端设备通过本身的闲置情况来决定是否参与设备代理的训练任务,并将该决定返回给设备代理,与设备代理其他组成设备共同决定该集群内设备代理的状态值。参与的设备代理与相应的基站建立通信连接,基站为其注册到临时索引表中。

b)本地训练。智能设备根据模型状态和数据特征进行本地数据训练家居模型。拥有计算能力的设备自身进行模型训练,无计算能力的传感器数据将通过设备代理进行收集,设备代理将这部分数据与自身的本地数据进行训练。本地训练又分为单轮迭代和多轮迭代两种方式,具体根据设备自身计算能力情况进行选择。多轮训练结果相比单论训练效果更好,但是时间花费较大。最后每个设备将本地模型更新传送给设备代理。

c)模型聚合。设备代理接收其他设备的本地更新之后,设备代理本身与其他设备进行一次更新的平均汇总,将该聚合后的模型传送给建立连接的基站,多个基站都接收到相应的平均汇总,基站进行二次模型聚合,并将该聚合状态返回给参与的设备代理,设备代理再次分发给分组集群内参与的其他终端设备。终端设备进行新一轮的训练。多个基站之间共享模型状态。

d)奖励机制。参与训练的设备代理免费获取模型状态,未参与的设备代理支付相应的金额以获取模型更新。这部分资金将用于奖励对模型更新付出巨大贡献的集群设备代理参与者。

2.2 问题设置

本文旨在提出一种基于代理选举的高效联邦学习算法FedAE。基于上述新型联邦学习架构,充分利用智能设备场景中多样设备的计算能力,提升联邦学习的精确性与效率。具体地,FedAE需要达到的目标如下:

a)高效性。通过提出基于代理选举的云边端体系结构,充分利用空闲资源设备进行分布式云边端训练模型,提高联邦学习效率。并提出基于架构模型的设备代理FedAE算法,保证在设备密集和异构场景下能够进行高效的联邦训练。

b)隐私性。在终端设备集群为单元的网络中,用户数据始终不出集群内部网络,只将集群内设备训练后的模型更新传送出去,极大地保护了智能设备中的数据。

c)准确性。单个集群设备群的感知具有局限性,多个集群的模型进行聚合得到的最后结果可以使单个设备具有更准确的模型结果。并在集群内指定设备代理,以适应不具有计算力的设备参与训练的情况,提高模型结果的准确性。

3 FedAE算法设计

3.1 算法基本思想

FedAE算法的设计主要针对密集居住社区环境中设备数量较多的场景,解决数据通信瓶颈,提高学习效率。在以终端设备集群为单位的设备组合中,以设备的计算能力以及每天的空闲时长两个属性为依据,通过选举算法计算每个设备的权重值,将权重值最大的设备设定为设备代理,之后通过闲置算力设备进行本地训练和设备代理的模型聚合,最后在通信基站中进行二次模型平均。在智能设备产品中,利用闲置算力训练本地数据,将模型更新上传至设备代理。设备代理进行单位内的一次模型聚合平均,并与其他设备将该模型重复迭代。设备代理每次迭代过程中,将该轮的最新模型传输到基站中,基站进行二次模型的聚合平均。基站之间定期进行模型共享,更新最新模型数据,提高学习效率。与传统FedSGD和FedAvg算法相比,FedAE能夠解决传输过程中数据量大的问题。

3.2 本地计算

设备通过当前模型状态和本地数据进行模型计算,当f(ω)=1n∑ni=1fi(ω)时,目标函数f(ω)如式(1)所示,对于一般机器学习fi(ω)=l(xi,yi,ω)。其中:损失函数(xi,yi)由ω决定,表示预测局部数据的损失;D表示设备收集的本地数据。

每个设备包括设备代理在内的设备都以此进行梯度下降训练,得到集群中最新模型数据。

3.3 设备代理选举

根据代理选举的云边端总体架构,边缘端的组成是智能设备,并且提出通过选举策略选举出设备代理(临时服务器),如图2所示。具体实现方式为:在每个集群组成的设备中,为获取设备的闲置计算力,通过采集设备自有属性(CPU刷新频率)、空闲时间(h)两个变量来计算每个设备的权重值,规则为当CPU频率以及闲置时长均大于各自均值的情况下,当权重值越大时,设备的计算能力越大、闲置时间越长。

具体的权重值计算利用马氏距离算法,该算法是一种表示数据间协方差距离的算法,可以通过设备的CPU、空闲时长数据计算两个设备的性能相似度。每个设备的权重值为该设备与其他所有设备的马氏距离之和。当计算得到的权重值越大时,代表该设备性能分布属于离群分布点,并且当两个变量的数据都大于各自均值时,表示性能指标越大,闲置计算能力越多,利用该设备充当设备代理时,可减少资源浪费,提高训练效率以及准确率。

假设两个设备为u=(uCPU,uH),v=(vCPU,vH),每个设备包含两个变量,分别为CPU核数以及每天平均空闲时长。由于两个变量之间没有相关性,所以在计算马氏距离的时候,先进行坐标旋转,也可称作主成分分析,坐标旋转时将原始坐标点通过一个正交矩阵旋转到新的坐标中,最后马氏距离的计算可以等价于点u压缩后的坐标值到数据重心v压缩后的坐标值的欧氏距离计算。所以u与v的协方差计算公式为

3.4 模型聚合

本地更新第一次聚合,通过设备代理进行集群內的一次积累本地更新,并且设备代理平均该积累后的模型如式(7)所示。每个设备代理循环迭代出一个最新模型。

ωs= ∑Ni=1ωiN(7)

底层集群设备代理之间聚合模型。设备代理间经过通信定期共享模型状态,设备代理再次聚合获得训练状态ω′。

ω′ = ∑Pj=1ωjP(8)

同样地,通信基站中进行二次更新聚合。基站积累设备代理传入的最新结果模型并且第二次平均积累后的设备代理更新,同样,基站迭代平均设备代理的模型结果如式(9)所示。

ωT= ∑Mj=1ωjM(9)

高层聚合模型状态。与设备代理一样,基站定期共享最新模型状态,聚合最终模型更新,如式(10)所示。

ω″=∑Ok=1ωkO(10)

算法1给出了FedAE相应的伪代码。在数据量巨大的情况下,该算法应用代理选举的云边端架构,利用闲置设备计算时间,提高该模型的学习效率。数据在设备产品本地进行计算,通过设备代理和基站两次模型平均聚合以提高学习效率。

算法1 基于云边端的设备代理选举联邦学习

输入:MINST数据集;初始模型ω0;基站数量O;基站迭代次数M;终端设备数量P;终端设备迭代次数N;学习效率ηi;用于代理设备选举的计算属性u与空闲时长v。

输出:最终全局模型。

云端服务器将训练任务下发,并下发初始模型ω0

4 实验评估

4.1 实验设置

本文为验证FedAE算法的有效性,采用实验环境为:CPU为Intel Core i7-1165G7 @2.80 GHz、GPU为NVIDIA GeForce MX450、RAM为16 GB的配置机器上运行实验流程,软件环境信息为Python 3.9。

采用公开数据集MNIST进行验证,该数据集含有6 000张训练图像数据用于输入联邦训练实验,并且设定该实验的参与设备不存在恶意节点。根据算法1设计2个云端,2个边缘基站,通过总数为50、100、200个设备分别验证。在集群分组上,以家庭为集群进行分组,其中设定每个家庭集群拥有5个终端设备,当进行本地训练时,每次迭代时间为0.5 s,基本通信耗时常量0.02 s;选举由设备在家庭集群节点内完成本地训练以及在家庭集群设备代理上完成模型聚合的任务。

根据实验算法,在该实验中区分设备代理与其他设备,通过增加本地迭代次数表示家庭设备代理收集并训练传感器设备数据来表示设备代理角色;然后将多个设备代理训练好的模型更新再次与基站通信,进行模型平均,完成第二次的训练;最终由多个基站的模型更新在云端进行模型的聚合,完成整个训练流程,得到最终训练结果。

实验对比方案包括经典联邦学习算法的FedSGD、FedAvg以及基于异构分层联邦训练算法[7]。在实验中,为了表现选举算法的有效性,将随机指定代理选举的FedAE-Random算法参与对比。随机指定设备代理算法在实验中只在家庭单元中进行聚合过程,没有收集传感器设备数据参与到训练过程。最终实验通过在参与客户端迭代轮次为200时的情况下,将每次训练后的准确率进行记录。

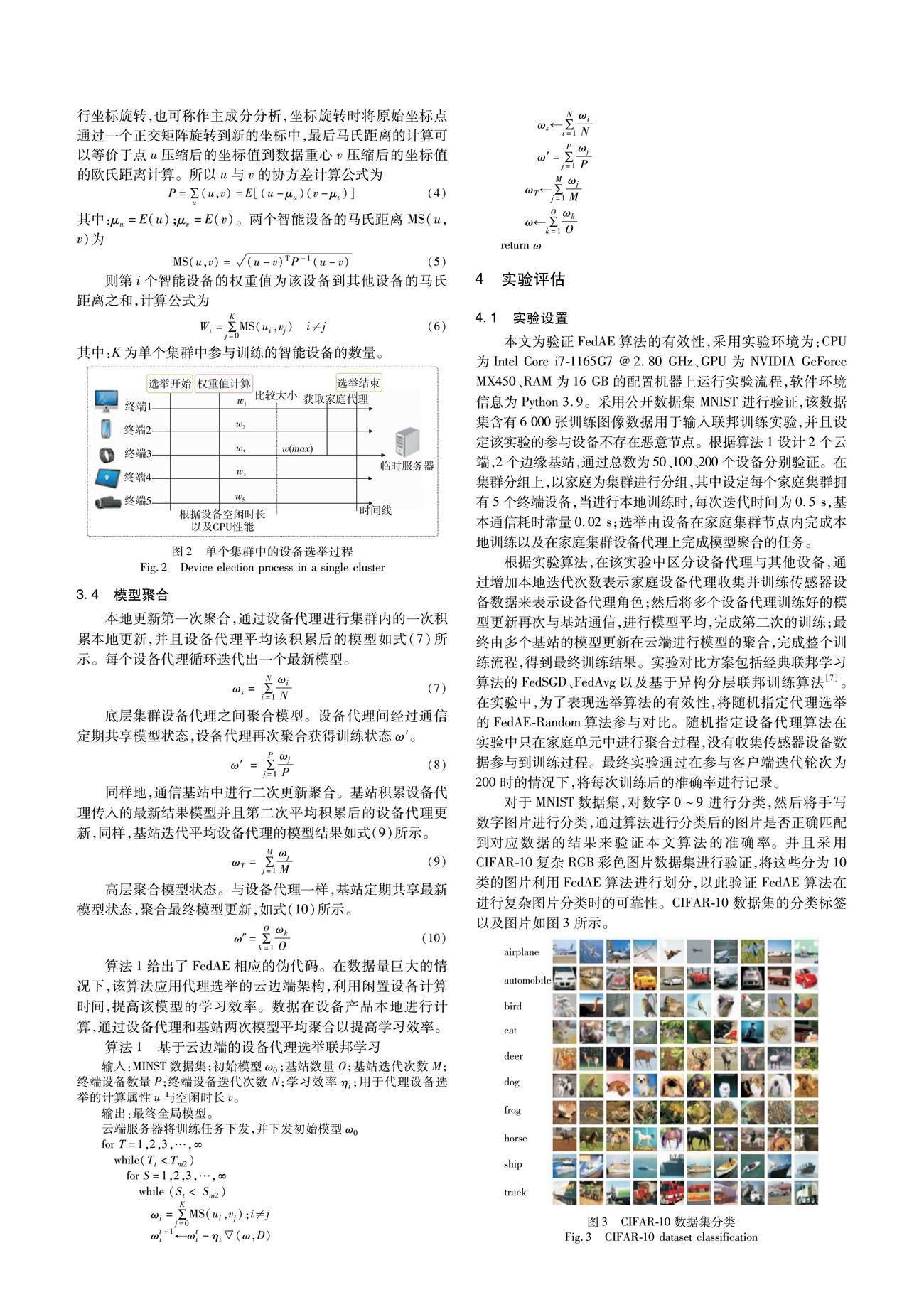

对于MNIST数据集,对数字0~9进行分类,然后将手写数字图片进行分类,通过算法进行分类后的图片是否正确匹配到对应数据的结果来验证本文算法的准确率。并且采用CIFAR-10复杂RGB彩色图片数据集进行验证,将这些分为10类的图片利用FedAE算法进行划分,以此验证FedAE算法在进行复杂图片分类时的可靠性。CIFAR-10数据集的分类标签以及图片如图3所示。

4.2 设备代理设置

引入选举策略,通过选举后的设备代理用于训练过程并与其他算法对比。根据智能家居真实场景下常用的智能设备,假设定义五种设备,通过调查以及统计方法得到对应的CPU刷新频率和设备每天平均空闲时长,真实统计信息如表2所示。

通过权重式(6),计算出各个智能设备的权重值如表3所示。由此得出,在单元家庭中设定电脑PC为设备代理,在每个家庭分组中将采集到没有计算能力的设备数据在电脑PC上进行本地训练,并与其他设备进行更新聚合,最终将训练后的结果与边缘基站通信参与到云边端的架构中。

4.3 实验结果

在不同参与客户设备规模下,利用训练数据集训练后的模型将测试数据集的图片进行分类。例如对于MNIST数据集,输入一张手写图片,对比结果是否匹配到对应的标签下;对于CIFAR-10数据集,输入包含车辆的彩色图片,对比结果是否匹配到车辆标签中,以此对比算法的有效性,并分别统计FedAE算法与对比算法的准确率、效率以及隐私结果,分析FedAE在各个方面对比其他算法表现的差异。

在MNIST数据集上验证训练结果的准确性,通过不同规模的客户端参与量进行对比,结果如图4~6所示。由图4~6可以看出,对应的几种算法所表现的趋势是一致的,但训练的准确率在参与迭代次数的纵向上来看并不相同。在不同参与规模下,准确率均趋于收敛,但对比FedAvg与其他分层算法,FedAvg与FedAvg-Random算法的实验准确率在训练200轮后依然分别平均提高了4‰和5‰,表现优于对比算法。对比分层异构联邦训练结果,FedAE更能反映当在云边端的架构中引入设备代理参与训练后的优越性,表现出FedAE算法在解决异构环境下充分利用对端的计算能力,提高模型训练的整体准确率。并由此可以得到,在训练结果达到同一准确率的同时,FedAE算法所需的训练轮次少于其他算法,说明了FedAE算法的高效性。此外,对比FedAE与FedAE-Random,采用选举后的算法训练后的准确率高于之前随机指定的设备代理,并且在通信轮次达到200时,选举后的算法依然高于选举前2‰,结果表明通过设备的自有属性计算出的权重值可以提高训练效率。

当采用更复杂的数据集CIFAR-10验证训练结果的准确性时,在客户端數量为100,通信为100轮,其他条件不变的情况下,验证FedAE算法在复杂数据集上的表现,将每10轮准确率取平均值绘出折线图,可更直观地看出每种算法的训练趋势,结果如图7所示。由图7可以看出,在训练轮次相同的情况下,FedAE算法优于其他算法。在每轮评估准确率的时候都会有很大的波动,这是由于为设置设定的学习率引起的,过小的学习率会导致收敛速度很慢,所以为适应FedAE算法,将学习率设定为0.01;FedAvg和分层算法在模型更新的时候由于收敛速度过大,导致错过最好的点,会出现了图上的交叉点。从图7可以看出,相较于其他算法,FedAE算法在整体上准确率都处于领先地位。由此,通过在两个数据集上的实验验证了FedAE算法的有效性。由实验结果图4~7并通过分析可知,每轮训练结果的准确率提升平均在7‰,这是由于联邦训练算法的训练结果的准确率都趋于平稳且趋于收敛。通过分析前200轮的结果,对比其他算法,本文提出的FedHA算法在达到相同准确率的情况下,所需的训练轮次更少,由此验证了FedHA的高效性。

此外,本文还通过计算训练消耗时长验证了评估算法的高效性,实验结果如图8所示。通过模拟设备训练场景,在参与客户端进行训练时,将FedAE与FedAvg和异构分层联邦算法在达到一定准确率时的时长消耗作对比。在训练结果准确率达到90%时,FedAE与FedAvg以及对比实验在效率上分别提高了25.7%和18.3%,而异构分层联邦算法并不能很好地适应密集环境下的多样性设备场景。可见相较于其他算法,本文算法在训练过程中时间消耗更短,训练效率更高。由此表明通过引入家庭设备代理,进而充分利用家庭设备计算力,可提高整体训练效率。

在联邦训练过程中,对于数据隐私保护效果如图9所示。由于运用数据不出设备本地的联邦训练思想,所以FedAE算法在FedAvg算法的基础上进行了修改,进而使隐私保护结果与FedSGD与FedAvg算法表现一致。随着参与训练设备的增加,隐私保护效果也在不断增加。在参与训练的智能设备较少时,根据文献[32]可知,数据隐私会存在对应的泄露风险。当参与训练的设备不断增加之后,数据安全性也得到提高,最终会随着参与设备数量的增加接近没有数据从本地传输出去的情况,如图中绿色线条所示(见电子版)。

通过对算法实验结果在各个方面的对比,对于准确率的实验,现有算法在训练达到一定轮次时,准确率会趋于稳定。本文通过分析前200轮训练的结果可知,在保证数据隐私安全的情况下,在训练初始阶段,本文算法在达到与其他算法相同准确率时,所需训练轮次更少,并且耗时最短,所以本文算法在训练效率上有所提高。

5 结束语

联邦学习是智能设备领域中重要的数据隐私保护计算技术。智能设备异构场景中存在多种多样的终端设备,导致了联邦学习客户端的异构性,影响了联邦学习的精确性与效率。本文提出从设备中选举代理节点的思路,研究提升联邦学习效率与精确性的新方法,设计了一种基于代理选举的高效联邦学习算法FedAE。首先,设计了一种基于马氏距离的设备代理节点选举策略,从多样性的智能设备中选出设备代理节点,充分利用设备的计算能力;其次,本文设计了一种基于设备代理选举的新型云边端学习架构,将设备本地数据进行分级迭代聚合,减少了通信压力,提高了联邦学习效率。通过设备代理节点可以收集无计算能力设备的数据进行模型聚合,提高了联邦学习的精确性。基于MNIST和CIFAR-10公开数据集以及智能设备的真实数据进行仿真实验,相比于现有方案,本文提出的高效联邦学习算法在准确率和学习效率方面具有优势。

参考文献:

[1]Razmjoo A,Gandomi A,Mahlooji M,et al.An investigation of the policies and crucial sectors of smart cities based on IoT application[J].Applied Sciences,2022,12(5):2672.

[2]张文平.大数据背景下的物联网智能家居研究[J].电子元器件与信息技术,2022,6(1):85-86.(Zhang Wenping.Research on IoT smart homes in the context of big data[J].Electronic Components and Information Technology,2022,6(1):85-86.)

[3]Lee S,Choi D H.Federated reinforcement learning for energy management of multiple smart homes with distributed energy resources[J].IEEE Trans on Industrial Informatics,2020,18(1):488-497.

[4]Aivodji U M,Gambs S,Martin A.IOTFLA:a secured and privacy-preserving smart home architecture implementing federated learning[C]//Proc of IEEE Security and Privacy Workshops.Piscataway,NJ:IEEE Press,2019:175-180.

[5]Huang Shanfeng,Zhang Zezhong,Wang Shuai,et al.Accelerating federated edge learning via topology optimization[J].IEEE Internet of Things Journal,2023,10(3):2056-2070.

[6]Wu Qiong,Chen Xu,Zhou Zhi,et al.FedHome:cloud-edge based personalized federated learning for in-home health monitoring[J].IEEE Trans on Mobile Computing,2022,21(8):2818-2832.

[7]鐘正仪,包卫东,王吉,等.一种面向云边端系统的分层异构联邦学习方法[J].计算机研究与发展,2022,59(11):2408-2422.(Zhong Zhengyi,Bao Weidong,Wang Ji,et al.A hierarchical heterogeneous federated learning method for cloud edge systems[J].Computer Research and Development,2022,59(11):2408-2422.)

[8]Hegiste V,Legler T,Ruskowski M.Application of federated machine learning in manufacturing [C]//Proc of International Conference on Industry 4.0 Technology.Piscataway,NJ:IEEE Press,2022:1-8.

[9]Wu Guangjun,Wang Shupeng,Ning Zhaolong.Blockchain-enabled privacy-preserving access control for data publishing and sharing in the Internet of Medical Things[J].IEEE Internet of Things Journal,2021,9(11):8091-8104.

[10]Zhang Chi,Liu Yu,Wang Le,et al.Joint intelligence ranking by fede-rated multiplicative update[J].IEEE Intelligent Systems,2020,35(4):15-24.

[11]Pokhrel S R,Choi J.Federated learning with blockchain for autonomous vehicles:analysis and design[J].IEEE Trans on Communications,2020,68(8):4734-4746.

[12]Elbir A M,Soner B,Coleri S,et al.Federated learning in vehicular networks[C]//Proc of IEEE International Mediterranean Conference on Communications and Networking.Piscataway,NJ:IEEE Press,2022:72-77.

[13]Sabuj S R,Elaharief M,Jo H S.A partial federated learning model in cognitive UAV-enabled edge computing networks[C]//Proc of the 13th International Conference on Information and Communication Technology Convergence.Piscataway,NJ:IEEE Press,2022:1437-1440.

[14]Ying Chenchao,Jin Haiming,Wang Xudong,et al.Double insurance:incentivized federated learning with differential privacy in mobile crowdsensing[C]//Proc of International Symposium on Reliable Distributed Systems.Piscataway,NJ:IEEE Press,2020:81-90.

[15]Putjorn P.Designing augmented learning platform with IoT and Chatbot-based learning technology for primary school students in northern Thailand[C]//Proc of the 6th International Conference on Information Technology.Piscataway,NJ:IEEE Press,2022:275-279.

[16]Saranya M,Amutha B,Niranjana T.AI buildings:design of artificially intelligent buildings in the energy sector with an autonomous federated learning approach[C]//Proc of the 6th International Conference on ISMAC.Piscataway,NJ:IEEE Press,2022:686-694.

[17]Su Zhou,Wang Yuntao,Luan T H,et al.Secure and efficient federated learning for smart grid with edge-cloud collaboration[J].IEEE Trans on Industrial Informatics,2021,18(2):1333-134.

[18]Ye Dongdong,Yu Rong,Pan Miao,et al.Federated learning in vehicular edge computing:a selective model aggregation approach[J].IEEE Access,2020,8:23920-23935.

[19]Cai Lingshuang,Lin Di,Zhang Jiale,et al.Dynamic sample selection for federated learning with heterogeneous data in fog computing[C]//Proc of IEEE International Conference on Communications.Pisca-taway,NJ:IEEE Press,2020:1-6.

[20]Cao Jiayu,Zhang Ke,Wu Fan,et al.Learning cooperation schemes for mobile edge computing empowered Internet of Vehicles[C]//Proc of IEEE Wireless Communications and Networking Conference.Pisca-taway,NJ:IEEE Press,2020:1-6.

[21]Cui Yangguang,Cao Kun,Cao Guitao,et al.Client scheduling and resource management for efficient training in heterogeneous IoT-edge federated learning[J].IEEE Trans on Computer-Aided Design of Integrated Circuits and Systems,2021,41(8):2407-2420.

[22]Yu Tianlong,Li Tian,Sun Yuqiong,et al.Learning context-aware policies from multiple smart homes via federated multi-task learning[C]//Proc of the 5th International Conference on Internet-of-Things Design and Implementation.Piscataway,NJ:IEEE Press,2020:104-115.

[23]Zhao Yang,Zhao Jun,Jiang Linshan,et al.Privacy-preserving blockchain-based federated learning for IoT devices[J].IEEE Internet of Things Journal,2020,8(3):1817-1829.

[24]Wang K I K,Ye Xiaozhou,Sakurai K,et al.Federated learning with clustering-based participant selection for IoT applications[C]//Proc of IEEE International Conference on Big Data.Piscataway,NJ:IEEE Press,2022:6830-6831.

[25]Zhang Tao,Song Anxiao,Dong Xuewen,et al.Privacy-preserving asynchronous grouped federated learning for IoT[J].IEEE Internet of Things Journal,2021,9(7):5511-5523.

[26]Salh A,Ngah R,Audah L,et al.Energy-efficient federated learning with resource allocation for green IoT edge intelligence in B5G[J].IEEE Access,2023,11:16353-16367.

[27]Lu Xiaofeng,Liao Yuying,Liu Chao,et al.Heterogeneous model fusion federated learning mechanism based on model mapping[J].IEEE Internet of Things Journal,2021,9(8):6058-6068.

[28]Liu Lumin,Zhang Jun,Song S H,et al.Client-edge-cloud hierarchical federated learning[C]//Proc of IEEE International Conference on Communications.Piscataway,NJ:IEEE Press,2020:1-6.

[29]路松峰,屠向陽,周军龙,等.云边端协同的增量联邦学习算法[J].华中科技大学学报:自然科学版,2023,51(10):12-18.(Lu Songfeng,Tu Xiangyang,Zhou Junlong,et al.Incremental federated learning algorithm for cloud-edge-device collaboration[J].Journal of Huazhong University of Science and Technology:Natural Science Edition,2023,51(10):12-18.)

[30]Zhu Ligeng,Liu Zhijian,Han Song.Deep leakage from gradients[C]//Proc of the 33rd International Conference on Neural Information Processing Systems.Red Hook,NY:Curran Associates Inc.,2019:14774-14784.