基于熵的量化工作系统信息加工能力方法研究*

2023-12-13李存荣龚静雯杨楷模

潘 雄,李存荣,龚静雯※,余 启,杨楷模

(1.东莞艾可迅复合材料有限公司,广东 东莞 523729;2.武汉理工大学机电工程学院,武汉 430070)

0 引言

信息加工是量化和改变不确定性[1],信息加工能力是减少不确定性的能力。高端人才、一流信息系统、前沿管理理论通常不能很好地被企业吸收,不能一劳永逸地解决企业瓶颈问题。即使是企业内部大获成功的实践和优秀的管理经验,也往往面临适应范围快速萎缩、效能剧降的劣化结果。究其原因,是企业管理系统信息加工能力不足(无法准确解读和贯彻先进生产力的运作方式)所致。想要主动避免劣化结果,企业必须先量化信息加工能力,准确识别能力差距。

量化工作系统物质加工能力的方法成熟且流传度广,如过程能力指数(CPK)[2]、质量、效率等。量化信息加工能力的尝试则大多始于信息熵[3],不确定性越低,则熵值越小,能力越强。例如,量化系统随时间演变一致性的传递熵[4]和量化信号表示信息的程度的Kullback-Leibler距离[5]。由于模型复杂、缺少针对性设计等原因,这些尝试在企业管理系统中受众稀少,未能得到推广。可以结合管理活动的规律来简化量化方法,使之浅显易懂,能够被管理人员更好地掌握。

信息加工能力的应用场景是兼顾细节和大局的全员协同管理[6]和全局统筹[7]管理情境,要求量化数据兼具深度和广度优势。因此,需要深入管理系统观测和复现工作系统的自然演变过程,在掌握体现信息加工能力差异性特征的基础上设计工作熵量化模型。并且,在实践中梳理工作熵控制逻辑,以辩证的方式展开量化工作,建立全局性管理视角。从而引导企业管理系统向低熵方向演化,获取突破瓶颈和吸收先进生产力的机会。

1 观测不确定性

1.1 疏忽的信号

不确定性导致工作系统总是可能出现信源信息未准确传递到信宿的失真事件。忽视失真事件,就会向周围散发疏忽和不在意信号,让遵守规矩和不守规矩的人都放宽要求,滋生更大范围和更为严重的破坏秩序行为[8]。尽管如此,这种疏忽行为在加工单元信息[9]的微观过程中却非常普遍。

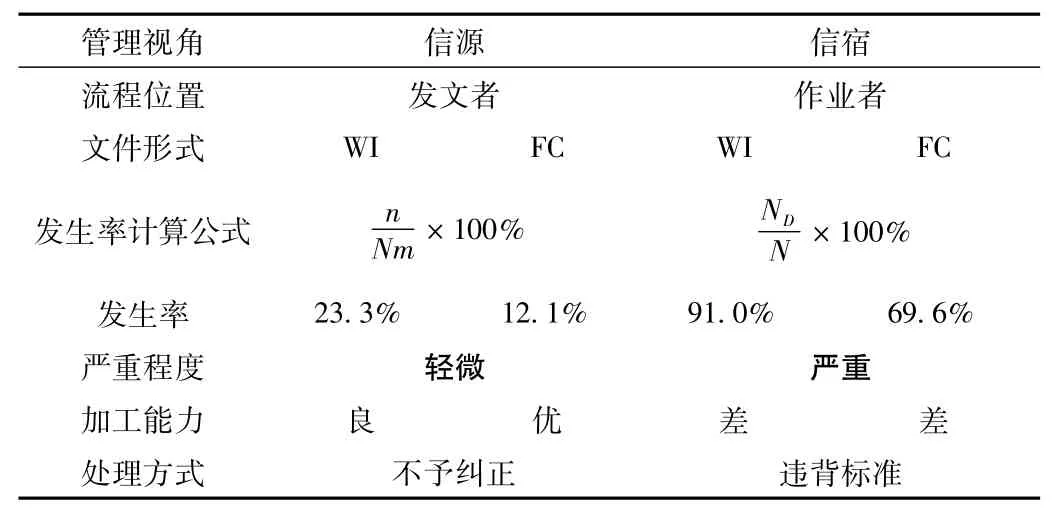

以H公司长达15年的标准文件发行记录为例,作业指导书(WI)和工艺流程图(FC)文件“名称”信息的“可能性”级失真事件发生率最高达91%,如表1 所示。其中“文件遗失”等失真事件从未杜绝,说明疏忽行为并不会因为可能或者已经导致的严重后果而自发地终止。

表1 “可能性”级失真事件发生率

1.2 矛盾的行为

如表2所示,发文者以平均的方式评价整个信息加工过程的失真事件发生率,因“不严重”的结论而忽视失真事件,不予纠正。作业者则以零容忍的方式评价,得出“失真严重”的结论。此时,无论作业者是否遵从失真的标准,都可能导致个人和公司损失。两害取其轻的权衡策略下,违背标准(忽视失真的信息)成为惯例。

表2 过程失真事件发生率

将发文者、文件、作业者以及流通其间的信息视作一个闭环的工作系统,则该系统长期以来重复着既忽视又重视失真事件、高度不确定的矛盾行为:发文者期望作业者既服从文件标准又具备自行纠错的主观能动力;作业者明知违背标准有风险却趋之若鹜。

矛盾的焦点:仅导致轻微后果的失真事件是否应被视为细枝末节而加以忽略?管理活动是否需要严苛到“零缺陷”的程度?通过以下实验厘清细节信息与关键信息失真事件之间的关系,以及这种关系对工作系统的深远影响,将有助于消除矛盾行为。

1.3 实验设置

如图1 所示,观测者对执行生产加工作业的A 工作系统进行动作分析,记录“文件编号”“工艺名称”“产品名称”“物料编号”“视频编号”“作者”等单元信息作为索引。其中,“文件编号”“作者”是细枝末节,“工艺名称”“产品名称”是关键要素。

图1 实验设置

对照组是A工作系统与观测者、观测行为共同构成的B工作系统,实验组是B工作系统与干预者、干预行为共同构成的C工作系统。二者分别用于观测干预前后B工作系统的“信息”级失真事件演变规律。

1.4 实验过程

对照组的观测周期为2016/6-2017/5,干预者只在实验开始时一次性说明记录要求和标准,观测期内不校正任何失真事件。

实验组的观测周期为2017/6-2018/6,干预者除了反复强调记录要求和标准外,还会不定期检查执行情况。在发现失真事件时,纠正观测行为并监督观测者更正历史记录。为保持B工作系统的开放性,实验期间不干涉企业内外其他工作系统与之互动。

1.5 实验结果

1.5.1 耗散特征

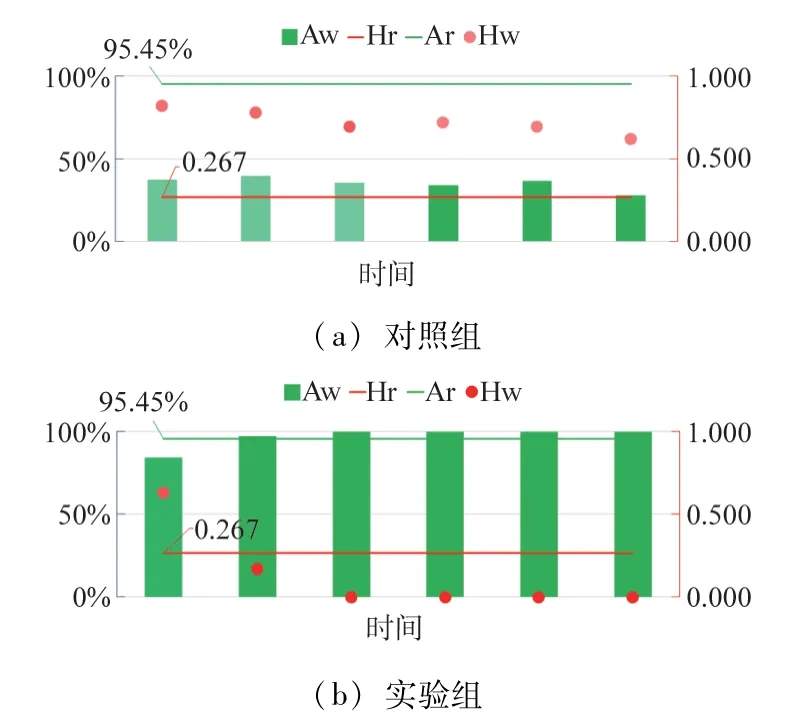

两组实验中,B 工作系统的失真事件发生率均有收敛趋势,为稳定性特征,如图2 所示。图中,实验组在时间上承接对照组,失真事件发生率却骤降,是因为干预行为回溯并修正了过渡态记录。

图2 失真事件发生率(信宿视角)

由图3 可知,实验组的有序性特征是失真事件基本杜绝,信息加工不确定性低、能力强。对照组的有序性特征是失真事件发生率由高到低依次递减,且导致轻微后果的失真事件发生率更高。信息加工过程虽然频发失真事件,但输出结果又非完全失真,不确定性高,能力弱。

图3 “信息”级失真事件发生率

耗散结构是开放系统在与环境交互的过程中自发形成的稳定有序结构[10]。结合该定义与上述特征可知,B工作系统在对照组运作初期骤然形成并延续了高熵耗散结构,在实验组运作期间逐步演化为低熵耗散结构。

鉴于对照组B工作系统未受干预,仍可被视为背景管理环境的一部分,与耗散状态相同,工作熵值相近。据此判断,A公司管理系统处于高熵状态,为内部工作系统提供了高熵环境。

1.5.2 耗散关系

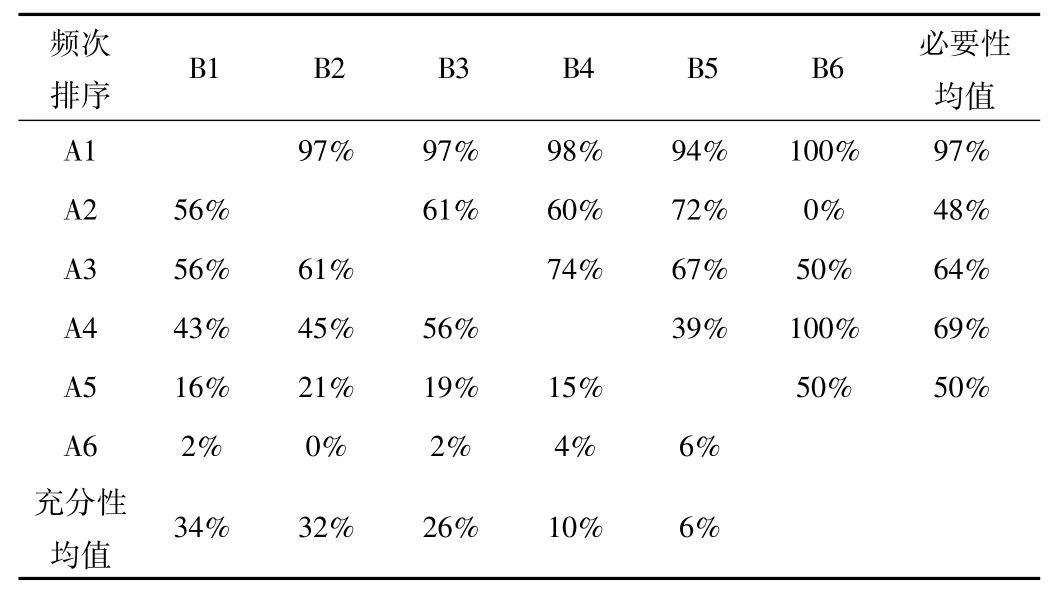

如表3 所示,按失真频次由高到低排序单元信息,以Ai和Bj分别表示信息i和j的失真频次,Ai∩Bj表示i、j同时失真的频次。分别用(Ai∩Bj)/Bj和(Ai∩Bj)/Ai来量化对照组失真事件之间的必要和充分关联程度。

表3 充分必要性分析

设定充要关系成立的阈值为85%,则最高频失真事件与其余失真事件呈必要非充分关系。追溯H公司的单元信息加工案例,发现“可能性”级失真事件之间也存在同样的关系。且最高频失真事件的发生率越高,必要非充分关系越显著,细微问题的影响范围越大,所引起的不确定性增加程度越高。证实了必要非充分的耗散关系、高熵耗散结构以及高熵管理环境具有一定普遍性。

必要非充分耗散关系源于熵增加原理,体现了这一客观因素对执行标准的严苛程度而非标准本身的否定。因此,即使在最高频失真事件发生率达到100%,信息加工能力严重退化的情境中,标准仍将被部分执行,并不会出现完全背离标准(所有信息100%失真)的极端情况。

实验组从逆否命题的角度利用这一耗散关系,以干预行为消除被视为细枝末节的最高频失真事件,成功抑制了其他失真事件的发生,完成了低熵化改造过程。

显然,信息加工能力有别于与信息超载现象[11]负相关的负荷能力。无论是出于避免熵增,还是低熵化的目的,管理系统都必须重视细节,尤其是疏忽和不在意的信号[8]。

1.5.3 耗散规律

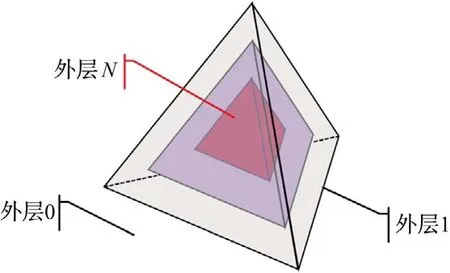

根据前文“可能性”和“信息”级耗散案例推测:在更为复杂的高熵管理情境中,工作系统也将自发性劣化,以必要非充分关系形成更多层级的熵增平衡耗散结构,如图4 所示。其中,外层信息的加工过程受环境影响更大,有着迥异于内层信息的特征,如表4 所示。

图4 高熵耗散结构

表4 高熵耗散结构信息分布规律

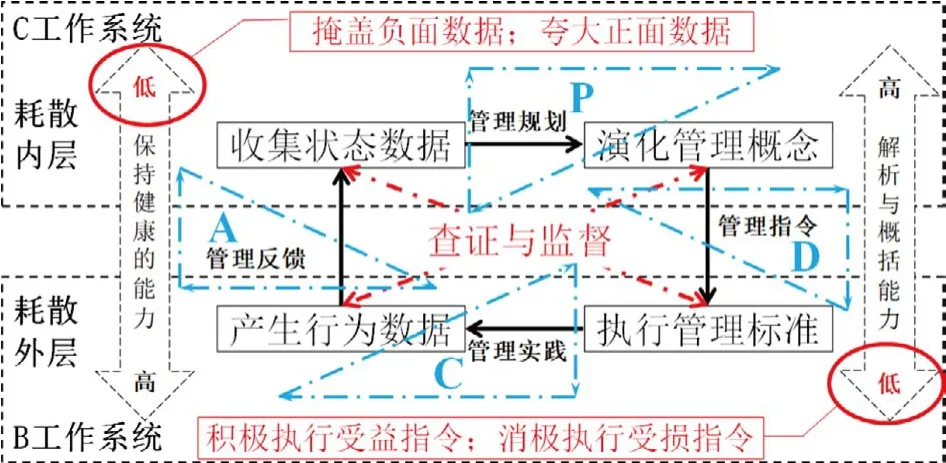

1.5.4 熵变事件

系统思维[121]能力被抑制,主动放弃严格执行标准的理由,是疏忽行为导致工作系统经历破窗效应演变为高熵耗散结构的主观因素。以对照组为例,失去了三级关照[12]的系统性管理视野后,PDCA 各节点管理人员不再关心信息的去向,是否变现了价值;也不关心信息的来源是否科学可信。最终导致了“查证”和“监督”的通信活动中断、能力互补机制失效以及管理缺陷被放大等熵增结果,如图5 所示。

图5 能力互补机制

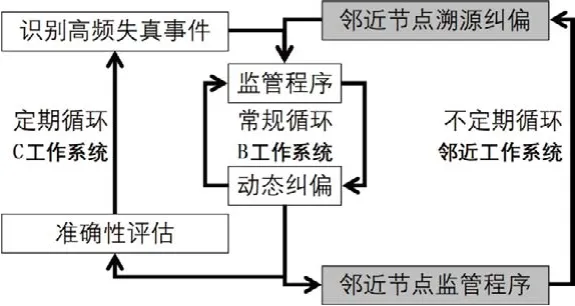

除疏忽行为外,破坏、盲目等消极管理行为也会抑制系统思维能力,有较大可能导致熵增结果,是管理系统必须重视的熵增事件。熵减事件则相反,是指强化系统思维能力,有较大可能达成熵减结果的管理事件。例如实验组通过多重循环降低失真事件发生率,自我校正、溯源互补的积极管理行为,如图6 所示。

图6 控制发生率的管理循环

熵增事件在高熵管理环境中占据主导地位,为必要非充分耗散过程提供了丰富的素材,加快了工作系统的熵增速度,应加以抑制。熵减事件在低熵环境中占主导地位,创建秩序的行为减少了管理系统的整体不确定性,谨守标准的行为缓解了源自父系统和子系统的熵增影响。

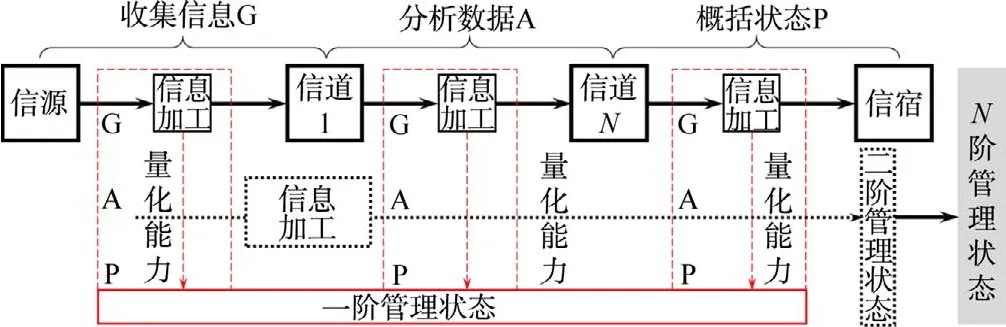

2 工作熵

一般工作系统的信息加工过程如图7所示,信源和信宿之间不同加工阶段的功能模块有序衔接,组成了通信回路。与量化动态系统计算能力[13]的重构输入函数方法不同,工作熵直接采集工作系统信息加工过程的失真事件记录,以输出信息不同于输入信息的程度来量化信息加工能力。

图7 一般信息加工过程

2.1 基本模型

工作熵量化方法源于信息熵公式:

式中:pi为相空间中第i个元的概率。

为达到易于推广的目标,从以下4 个方面着手简化。

(1)缩小观测范围。从图7 的完整过程中截取一段作为目标工作系统,收集指定时间范围内的信息加工结果。通过对比信宿端的加工对象、方法和环境等信息是否与信源端完全一致来辨认失真事件。由失真事件类别,整理得到易发生失真事件的“类别”级易失性信息作为观测对象。

(2)合并概率集合。沿用香农的做法,对于易失性信息的加工过程,无须列举相空间内所有元i的概率pi,而是直接取失真事件发生率的统计结果p,将i 的可能性范围缩小为p和q =1-p两种。

(3)聚焦耗散特征。由图3 可知,失真事件发生频次最高的前5 项易失性信息足以识别耗散特征。

(4)频次决定权重。最高频失真事件出现频次越高,则耗散关系越显著、熵增程度越高。

式中Nj为第j项易失性信息的失真事件频次。

另外,由权重值Wj和易失性信息的准确率qj,可以得到突显细微问题的权重准确率。

2.2 管理状态图

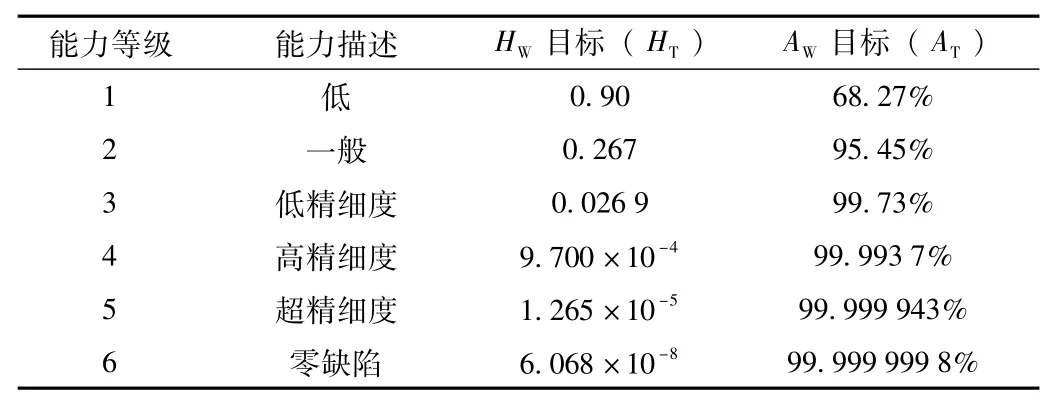

信息加工能力水平由HW和AW评定,分级标准与6σ[14]保持一致,以利推广,如表5 所示。

表5 信息加工能力分级标准

A公司和H公司的量化结果表明,自主运行的工作系统能以较小概率达到2级信息加工能力水平。因此,取2 级能力水平作为一般性管理目标,如图8右下角的阴影部分。

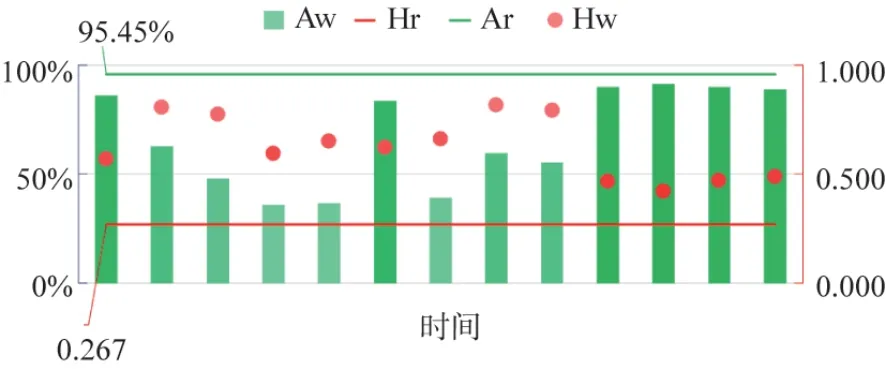

如图9 所示,将目标值AT、HT和实际值AW、HW绘制成图,可直观地辨识工作系统的以下管理状态。

图9 管理状态图

(1)不确定性。工作熵值越小,则信息加工过程执行标准的严苛程度越高,对失真事件控制力越强,不确定性越低,信息加工能力越强。

(2)准确性。权重准确率反映了加工过程的准确性,即信息产品的平均质量。值得注意的是,输出高质和劣质信息的工作系统均具备强信息加工能力,二者只是过程控制方向相反而已。

(3)稳定性。工作熵与权重准确率的变化幅度越小,则工作系统的耗散结构越稳定,越接近能力瓶颈。

B工作系统之所以能够从图9(a)提升信息加工能力到图9(b)的程度,是因为干预行为在促成一系列熵减事件的同时,清除了一系列熵增事件,成为降低B 工作系统熵值的低熵源。显然,低熵源的依存形式是持续性的管理行为与事件,而非管理人员、管理系统等生产力主体。因此,不论是高端人才、前沿理论,还是成功实践,当先进生产力不能创造或维持足以改变企业管理系统的低熵源时,将无法助力企业突破瓶颈,提升信息加工能力。

3 应用案例

一阶工作熵系统是应用工作熵模型量化一般工作系统信息加工能力的系统。二阶工作熵系统是量化一阶工作熵系统信息加工能力的系统。逐层深入,一般工作系统衍生了N阶工作熵,如图10 所示。工作熵分析仅限于结果而非动态过程,因此不考虑从成文记录中拆分出通信回路的反馈部分。

图10 工作熵管理维度图

熵阶越高,量化过程距离管理系统的核心、进行系统性思维的决策行为越近,接触低熵源的机会越多。熵阶越低,量化过程距离发生失真事件的管理现场越近,越容易被高熵环境影响,忽视考证而产生管理错觉。

3.1 一阶管理状态

以A公司自行全检失真事件的OEE业务为例,一阶工作熵评估结果为低熵、高准确性和高稳定性,管理状态良好,如图11 所示。

图11 OEE管理状态图(一阶)

然而,表6 中为测试量化方法可靠性而人为制造的一系列熵增事件却未能引起工作熵值增加。例如切断外部信道,实际已经造成了OEE业务无人问津、数据更新延迟的熵增结果。

表6 熵增事件清单

同时,相关的记录中也未见应对熵增干预的熵减事件,令人更加怀疑“管理状态良好”这一结论只是评估者的管理错觉。因为当工作熵系统进入高熵状态时,评估者很容易将逐渐泛滥的疏于记录失真事件的行为错认作熵减事件,得出低熵量化结果。除熵减错觉外,通过单方面行使权力来进行变革的控制错觉[15]也常见于高熵工作系统,同样容易造成低熵假象。

3.2 二阶管理状态

管理错觉无法避免,但可通过高阶工作熵来溯源、复测,加以考证和克服。

图12的二阶工作熵评估结果显示,一阶工作熵系统高熵,准确性和稳定性较低,管理状态差。于是有如下结论:

图12 OEE管理状态图(二阶)

(1)一阶工作熵评估者忽视了部分失真事件,已陷入熵减错觉;

(2)一阶工作熵评估过程已受熵增事件影响,不确定性高,量化结果不可信;

(3)二阶工作熵值波动与表6 相符,信度足够,无须复测,而一阶工作熵值则因缺少成文的输入信息(如发生在过去的生产作业动作、管理行为、影响作业和行为的因素等细节)记录,无法复测。

3.3 工作熵管理方法

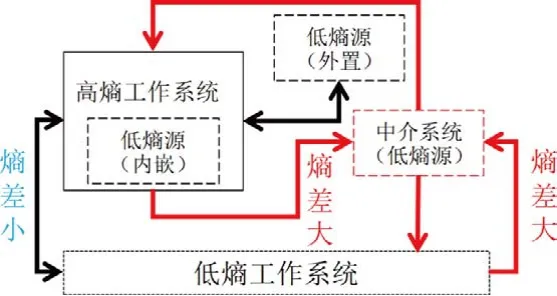

低熵是工作系统的一种能力状态,而非施加低熵影响的能力。想要引导工作系统向低熵状态演化,就必须借助工作熵管理方法,要点如下。

(1)监测熵值。监测管理系统内外部工作系统熵值,主动识别熵变事件。以熵值变化程度来衡量干预措施的有效性,敦促干预行为达成熵减结果。

(2)控制熵流。以目的性管理行为促成熵减事件或消除熵增事件,从而制造低熵源,施加低熵影响。反之,则可制造高熵源,驱动目标工作系统演变到高熵状态,验证工作熵量化工作的可靠性。

(3)适配能力。如图13 所示,提升能力方面,以内嵌低熵源为主要目标,外置低熵源为次要目标来改造工作系统。匹配能力方面,在熵差大的两个工作系统之间配备低熵中介系统作为缓冲,主动寻求改变的机会。如聘请专家导入先进管理体系、为管理人员量身定制操作指引等。

图13 适配能力

(4)自主维护。维持方面,自主监测有悖于评估结果的管理事件,持续修正工作熵评估模型。例如识别潜在的易失性信息,将其纳入监测范围。优化方面,深入研究熵增和熵减事件的成因、规律等,主动改良工作熵模型和现行管理方法。环境方面,培养和壮大低熵源,人为制造低熵管理环境,为自发性的熵减事件创造机会。

相比于忽视细微问题、缺乏恒性、疏于考证的传统思维模式,工作熵管理方法有如下优势。

(1)细节化。细微问题并非不重要,观测细微问题可量化工作系统的信息加工能力;忽视细微问题会滋生严重违规的行为;抑制细微问题则能引导工作系统向低熵方向演化。

(2)常态化。以动态更新的管理状态图作为常态化监测工具,避免了临时性评估缺乏参照物的局限。有利于在问题的萌芽期进行干预,预见性地规划工作系统的演化路径。

(3)数据化。量化信息加工能力为数值,可直观、准确地判断熵变方向。数据来源于实践事件,利于追溯和考证。

相应地,工作熵管理方法有如下缺点。

(1)高消耗。量化工作始于管理系统的底层细节,延伸范围涉及完整信息加工过程的全生命周期,工作量庞大。想要统筹企业管理系统内的全局工作熵,就必须耗费大量资源。

(2)弱控制。工作熵侧重发现问题和营造低熵管理环境,解决问题则取决于管理人员群体的智慧。如果由群体智慧决定的目的性管理行为始终不能正确引导工作系统的演化方向,那么工作熵管理系统将成为企业的累赘。

(3)易劣化。作为全局性的低熵源,工作熵管理系统有着自发性的劣化趋势。如果自主维护不及时,那么劣化结果无可避免且无法修复,在此基础上制定的管理方法将失去作用。

(4)低信度。理论方面,工作熵模型忽略了相空间内的多种可能性,仅以观测记录评定熵值,有错失潜在易失性信息的风险。实践方面,尽管工作熵系统量化了工作系统的信息加工能力,也被高阶工作熵系统量化了能力,但仍无法避免监测盲区、评估者能力不足和干预无效等管理情境。因此,必须怀疑和考证工作熵评估结果,以规避类似上述OEE案例的“状态良好”假象。

4 结束语

必要非充分的耗散关系是分辨工作系统信息加工能力强弱的主要特征。否定执行标准的严苛程度,失真事件将扩大影响,以必要非充分关系形成高熵耗散结构。重视细节,尤其是被疏忽和不在意的信号,则可塑造低熵耗散结构,增强工作系统的信息加工能力。

工作熵以输出信息不同于输入信息的程度来量化工作系统的信息加工能力。依据失真事件的动态统计数据和耗散特征,得到了契合管理实践的量化结果。使用数字和图形描述不确定性、准确性和稳定性,便于直观地解释管理状态,累积数据优势。经过缩小观测范围、合并概率集和聚焦特征事件等步骤,工作熵模型得以简化,易于掌握,利于推广。

工作熵管理是以目的性管理行为施加低熵影响的方法。通过制造低熵源来适配信息加工能力,突破了工作系统固有的能力限制。基于全局性的熵值监测数据,改良管理模型、营造低熵环境,维护了量化和提升信息加工能力的工作成果。虽然避免了传统管理思维忽视细节、缺乏恒性、疏于考证的缺陷,但是工作熵管理方法仍有高消耗、弱控制、易劣化和低信度等不足。只有经历辩证、系统和全面的考证过程,才能克服管理错觉,准确测量工作熵。从而驾驭先进生产力,推动工作系统低熵演化。