深度学习实时视频超分辨率重建实验设计

2023-12-11彭智勇黄扬鈚秦祖军梁红珍

彭智勇, 黄扬鈚, 秦祖军, 梁红珍

(1.桂林电子科技大学光电工程学院,广西桂林 541004;2.桂林生命与健康职业技术学院,广西桂林 541001)

0 引 言

影像超分辨率重建是指通过软件算法从低分辨率的图像、视频中恢复出纹理清晰的高分辨率图像或视频,最早由Harris[1]和Goodman[2]提出。超分辨率重建是后期图像识别、处理、测量的基础,是图像处理领域中的基础热点问题,特别是基于深度学习的影像超分辨率重建技术由于其高性能,近年很多学者进行了深入的研究。基于深度学习的视频超分辨率重建技术可以分为基于单帧图像的帧内超分辨率重建和基于多帧视频的帧间超分辨率重建。

基于单帧图像的帧内超分辨率重建,有很多学者基于深度学习提出了超分辨率重建模型,如:VDSR[3]、ESPCN[4]、ClassSR[5]等。基于帧内图像的超分辨率重建算法由于仅考虑帧内特征信息,忽略了视频序列的帧间相关,性能较好的超分辨率重建算法计算量和内存损耗过大;结构简单算法则特征信息不能充分利用,重建效果不好。基于多帧视频的帧间超分辨率重建,有VESPCN[6]、FRVSR[7]、RBPN[8]等,此类算法往往将已经完成超分辨率重建的帧作为后续特征提取的输入,当连续帧之间存在较大变化时,往往存在严重伪影及误差累积,并且现有深度学习超分辨率重建算法运算复杂,还不能实现实时超分辨率重建。

本文设计了基于深度学习的实时视频超分辨率重建研究型实验。针对视频特点,在利用帧内特征的同时也利用帧间特征,解决处理速度慢的问题,实现实时超分辨率重建。该实验将GhostModule 结构应用于循环递归神经网络并结合残差结构设计一个快速的视频超分辨率网络,采用具有多级跳跃连接残差映射,以解决循环卷积神经网络中存在梯度消失的风险,从而能长时间保存高频纹理信息,在取得较好重建效果的情况下实现实时视频超分辨率重建。

1 实验设计

1.1 实验算法原理

1.1.1 整体结构设计

循环卷积神经网络(RCNN)[9]可以对时域特征进行很好的建模,广泛应用于自然语言处理的研究,并可用于提炼视频帧间时域特征。Kim等[3]提出的残差结构超分辨率重建网络VDSR,该结构加深了卷积神经网络的深度,具有较好的超分辨率重建性能,VDSR 采用的全局的残差结构,尽管有效地把低层特征传递到高层,但没有充分利用中间层的特征,导致重建的图像纹理细节不够清晰。本文在传统RCNN 的基础上,受到VDSR的启发,设计了结合残差结构的RCNN,实时视频超分辨率重建网络整体结构(见图1)。

图1 实时视频超分辨率重建网络整体结构示意图

新的网络结构与VDSR 处理方法相似,网络分为两条支路。在初始阶段,上面的支路对视频当前帧LRt进行双三次方线线性插值得到初始的高分辨率图像;下面的支路进行残差学习,对输入进行循环特征提取,并把得到的高频特征信息输入到亚像素卷积层对残差图像放大。最后通过残差图像和初始的高分辨率图像相加,得到最后的当前帧超分辨率图像SRt。其中,PixelShuffler(2)是一放大2 倍的上采样模块,在图1结构中以放大4 倍为例通过2 个PixelShuffler(2)共放大到4 倍。在整体结构上,新网络与VDSR 不同的是,VDSR在当前图像输入的特征行提取模块之前就进行放大,因此后面的特征提取是在高分辨率图像上进行运算,这无疑增加了计算量。而本文实验针对低分辨率影像通过RNN网络循环进行特征提取,最后才对残差图像进行放大,能有效减少计算量并保证处理效果。算法实现的重点为循环特征提取模型的设计。

1.1.2 循环特征提取模块设计

GhostModule[10]网络基于一组原始的特征图,结合一系列线性变换,以很小的计算代价生成许多从原始特征发掘所需信息的“幻影”特征图,从而通过低的计算成本生成了更多的特征图。GhostModule 网络结构与传统结构参数量对比如下式表示:

式中:p1为传统结构的参数量;p2为GhostModule 网络的参数量;假设特征提取模块的输入和输出通道数量均为f;k为卷积核的大小(这里取3 × 3);r为GhostModule的比例参数。由式(1)2 个参数之比得

当k取值较大时,分母后半部分可忽略不计,此时c≈r,即相比于传统网络。GhostModule 具有更深的网络结构,更大的感受野,且参数量是普通卷积层的1/r,从而GhostModule网络具有强的特征提取能力及小的算法量。

图2 所示为运用GhostModule 设计循环特征提取模块示意图,其中图2(b)为本文特征提取模块内部结构,与传统的循环块[见图2(a)]相比,设计的循环块由GhostModule和隐藏信息与输出分支结构两部分组成。该循环块采用具有多级跳跃连接层之间的残差映射,解决了循环卷积神经网络中存在梯度消失的缺陷,同时确保了流畅的信息流,并能够长时间的保存高频纹理信息,从而网络更容易地处理更长的视频帧序列。

图2 循环特征提取模块示意图

由图2(b)可知,新的循环特征提取模块把当前帧It、前一帧It-1(t为影像帧编号,t=0,1,…n-1),它们之间的隐藏信息和上一个循环特征提取模块的输出作为输入,得到循环块前部分(GhostModule)的输出;同时,将GhostModule的输出分别输入到2 条支路:左边的支路作为本模块的预期目标输出Ot(RGB三通道);右边支路作为本模块的隐藏(遗留)信息Ht。把每次通过循环块得到的预期目标输出融合到n-1 个历史预期目标中,即

式中:n为循环块执行的次数;St为n次循环块预期目标输出的融合后的结果,其通道数为n×3。进一步把融合后的结果St输入到放大模块,即可得到放大后的残差图像HRES。最后把HRES与初始双三次插值放大的高分辨率HBICUBIC相加即可得到最终的超分辨率图像

1.2 实验环境及设置

1.2.1 系统环境

实验采用的硬件环境为:CPU 型号为英特尔i9-10900K,内存:32GB;系统:Win 7;GPU 为NVIDIA RTX2080TI,GPU主要用于对算法并行加速计算。实验软件环境为:ubuntu16.04、NVIDIA-3090、pytorch1.7.1、CUDA11.0 等。

1.2.2 测试数据及参数设置

本实验使用的训练数据集为Vidmeo-90K[11],该数据集大约包含90 000 个视频序列,每个视频序列包含7 帧视频剪辑与各种运动和不同的场景图像,其中随机抽取8 000 个视频序列用于训练,其余用于测试;实验的验证集为Vid4(包含4 个视频序列)和UDM10(包含10 个视频序列)。由于Vidmeo-90K 只提供高分辨率的目标图像,通过对高分辨率图像进行高斯模糊(均方差σ =1.6)下采样到1/4 像素得到64 ×64 大小的低分辨率输入块。经顺时针随机旋转0°、90°、180°、270°,左右与上下翻转得到8 倍于原始数据集的增强数据集。本文以Y 通道下重建高分辨率图像的PSNR与SSIM作为实验的评价指标,同时评估模型的参数量、计算复杂度和运算速度。

在训练循环卷积神经网络时,学习速率最初被设置为0.000 1,经过每20 个epoch学习率降低0.1 倍,共训练了60 个epoch。本文实验选用的优化器为Adam,优化器的相关参数设置:β1=0.9,β2=0.999 和权重衰减为0.000 5,以L1 作为损失函数进行监督训练,训练的批量数据大小为4。

2 实验结果与分析

2.1 峰值信噪比(PSNR)与结构相似性(SSIM)性能对比

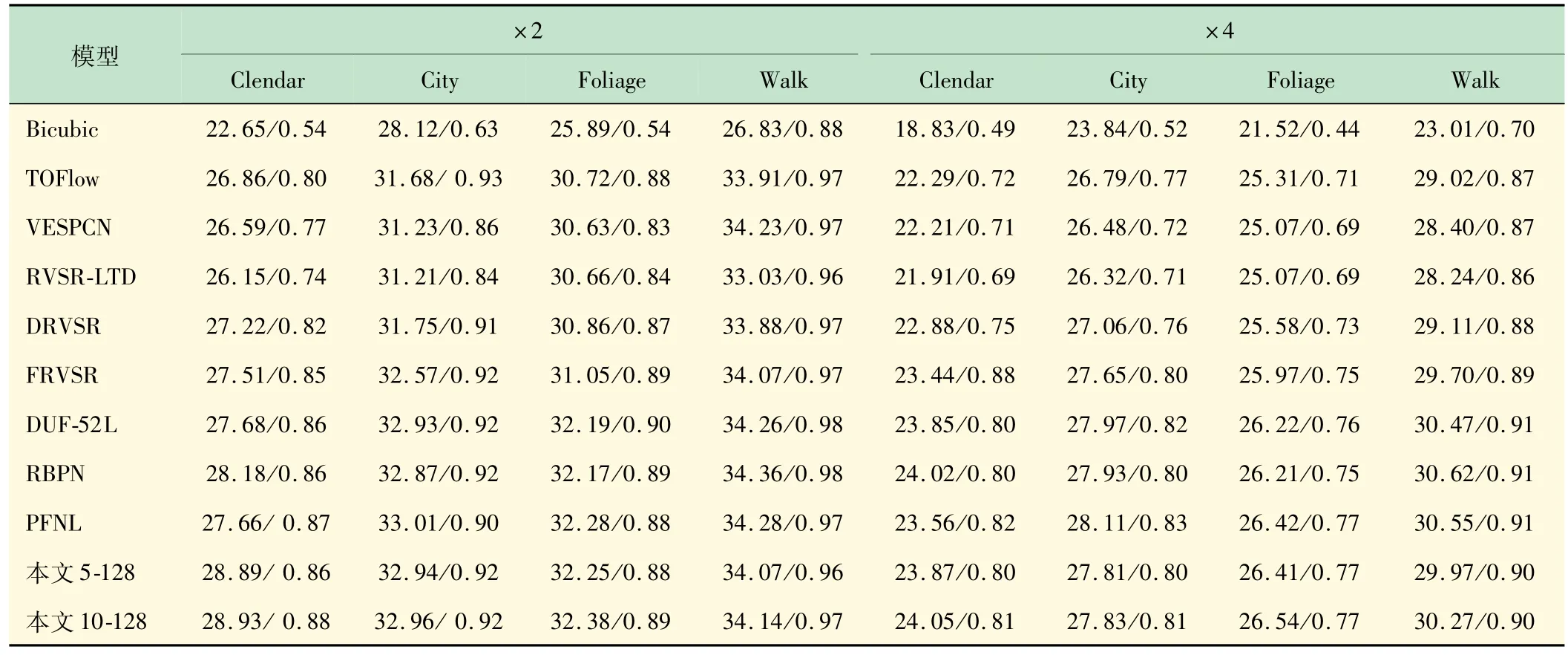

本文以通道数C=128,循环特征提取模块数量分别取B=5 和B=10 两种网络结构与目前主流视频超分辨率重建网络VESPCN,FRVSR,RBPN、RVSRLTD[12],DRVSR[13],DUF-52L[14],PFNL[15]在VID4 数据集上进行了PSNR与SSIM评价指标对比测试,结果如表1 所示。由表1 可见,本文算法在VID4 数据集4个场景的测试中,本文5-128 和10-128 比大多数传统算法有更高的评价指标。

表1 在VID4 上关于PSNR/SSIM性能的对比

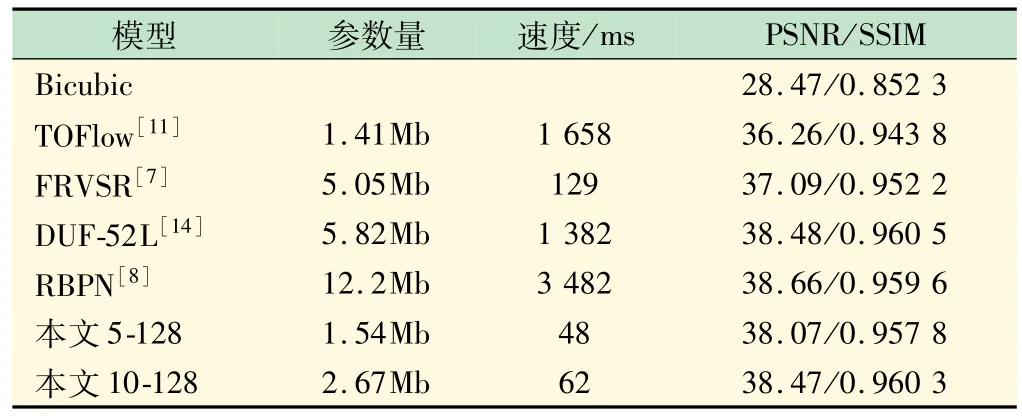

2.2 速度对比

与TOFlow,FRVSR 10-128,DUF-52L,RBPN 在UDM10 数据集上进行参数量、速度对比测试,结果如表2 所示。由表2 可见,本文5-128 的方法在参数量和计算量较小的前提下,测试指标PSNR比TOFlow高1.81 dB,比FRVSR高0.98 dB;与较大的模型相比,本文10-128 结构在PSNR 上比DUF-52L 低0.01 dB,比RBPN低0.19 dB。

表2 在UDM10 上关于速度的对比测试(×4)

以320 ×180 的低分辨率视频序列为输入进行4倍放大输入1280 ×720 的高分辨率视频序列。与传统较快速的FRVSR模型相比,FRVSR速度为129 ms/帧,本文5-128 速度为24 ms/帧,故本文的重建速度为FRVSR 的5.4 倍。本文的模型参数为FRVSR 的30.5%,在参数量上与TOFlow(1.41Mb)相近的基础下,运行速度是TOFlow(1 658 ms/帧)模型的34.5 倍,是高性能算法DUF-52L的28.8 倍。将本文算法应用于超分辨率系统,以1 920 ×1 080 作为高分辨率图像,取B=5,C=128 的网络结构,可以达到24 f/s的速度实现视频超分辨率重建。

2.3 真实效果对比

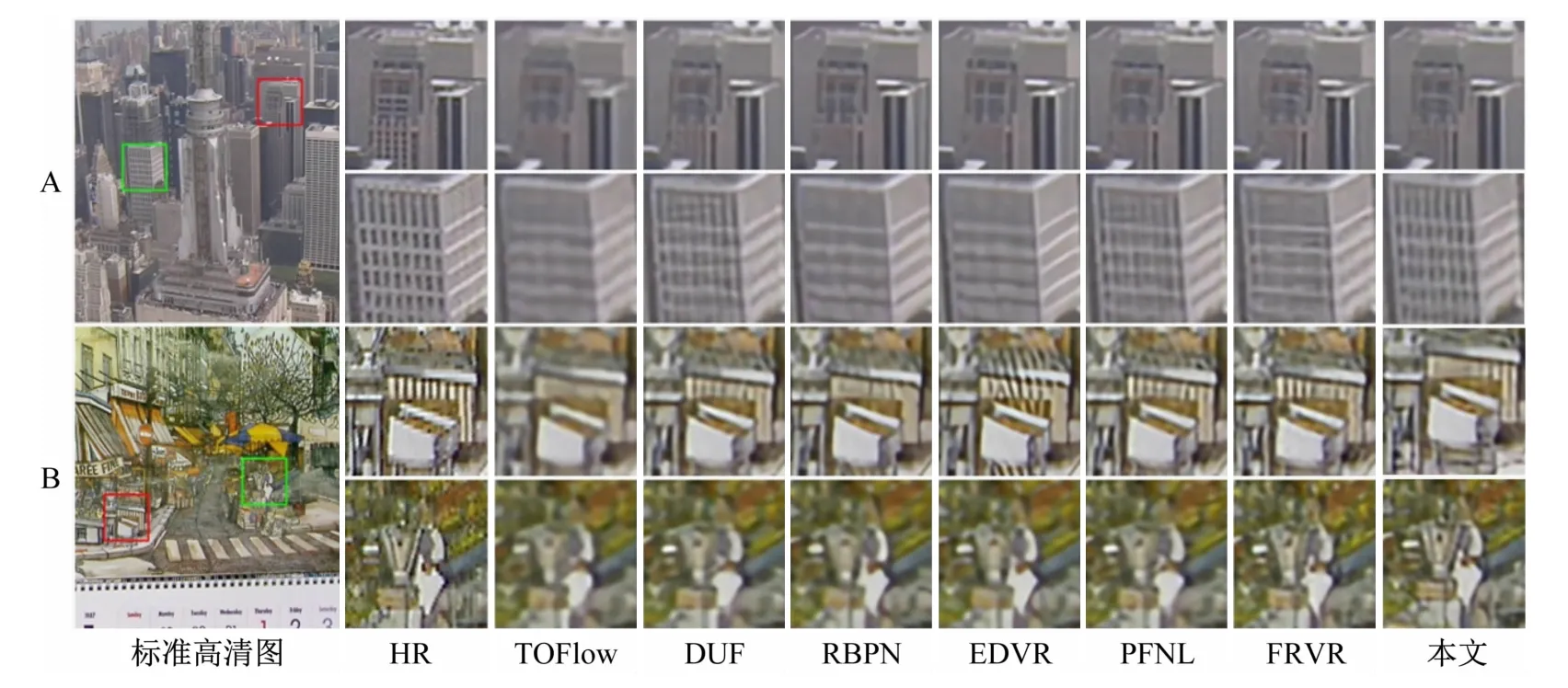

本文在效果图上进行了对比测试,在VID4 上对几种经典算法与本文算法的2 幅图(共4 个场景)实际视觉效果对比,如图3 所示。

图3 VID4数据测试效果图(A:第1幅图,B:第2幅图)

由第1、2 幅效果图的绿框场景可见,本文算法纹理明显比其他的算法更清晰;在第2 幅图的红色场景区域,所有算法相比于原始的高清图像,均存在一定的纹理丢失。

3 结 语

本文基于RCNN,引入GhostModule代替传统的卷积层,改进了传统的残差结构,并搭建一个轻量级的循环卷积神经网络进行视频的超分辨率重建,实现视频的实时超分辨率重建。实验结果表明:本新网络的重建速度为FRVSR 的5.4 倍;在参数量上与TOFlow 相近的基础下,运行速度是TOFlow模型的34.5 倍;是高性能算法DUF-52L的28.8 倍。

同时,本文基于前沿技术与工程应用角度,将科研项目与教育教学结合,积极探索和开设研究型教学实验[16-17],开展了基于深度学习的实时视频超分辨率重建研究型实验项目设计,很好地锻炼了学生的探索精神,培养学生运用理论知识和实践技能探索解决复杂问题的能力,锻炼学生积极探索精神与工程创新能力。