基于深度像素级特征的孪生网络目标跟踪方法

2023-11-29王向军郝忻王霖

王向军,郝忻,王霖

(1.天津大学精密测试技术及仪器国家重点实验室,天津 300072;2.天津大学微光机电系统技术教育部重点实验室,天津 300072)

近年来,随着科学技术的不断发展,计算机视觉已成为一个热门的领域。其中,目标跟踪作为计算机视觉的一个重要研究方向[1],也受到了越来越多的关注。目前,目标跟踪技术在监控安防、无人驾驶和增强现实等不同领域都有了广泛的应用[2-3]。目标跟踪任务包括单目标跟踪和多目标跟踪,单目标跟踪(Single Object Tracking,SOT),是指在视频的某一帧中框选出需要跟踪目标的矩形坐标框,并在后续的视频序列中,通过某种相似度计算,寻找并给出跟踪对象在后续帧序列中的信息,包括位置和尺度等信息。

目前目标跟踪算法的主要方向有两类:生成式目标跟踪算法和判别式目标跟踪算法,其中判别式目标跟踪算法又可以细分为相关滤波类目标跟踪算法和深度学习类目标跟踪算法。相关滤波类目标跟踪通过对第一帧框选的模板进行建模,利用“相关性”[4]计算得到目标的跟踪信息,设计并训练出一种能鉴别搜索区域中目标与背景的分类器。然而随着近年来机器学习的不断发展,深度学习也逐渐应用于目标跟踪领域,算法在强大的GPU 支持下完成离线训练和在线跟踪。2016 年,Bertinetto 等[5]提出了SiamFC(Fully-Convolutional Siamese Networks)算法,利用孪生网络(Siamese Network)提取模板和搜索区域图像特征,再经过互相关方法和后端网络得到输出响应,成功将孪生网络与深度学习目标跟踪相结合;2018 年Li 等[6]将检测网络中的区域推荐网络(Region Proposal Network,RPN)引入到了目标跟踪领域,提出的SiamRPN[7]算法分别对前背景分类和偏移回归进行了预测,在提高尺度估计精度和效率的同时,加快了模型的收敛速度;2019 年,Li等[8]提出了SiamRPN++算法,通过均匀分布的采样方式让目标在中心点附近进行偏移,缓解了网络因为破坏了严格平移不变性带来的影响,并利用深度可分离卷积进一步提升了网络精度;随着Transformer 结构在深度学习中的流行,2021 年,Yan等[9]利用Transformer 的编码器和解码器具有全局感受野的优势来进行目标跟踪,并输出跟踪框对角点的预测,在LaSOT 和GOT10K 等数据集上取得了当时最好的效果,为后续跟踪模型提供了使用Transformer 跟踪框架的思路。

针对跟踪算法面对变化目标以及低分辨率场景时跟踪性能下降的问题[10],本文在SiamRPN++算法的跟踪结构框架基础上进行了改进,对原有的深度可分离卷积进行替换,使用了模板与搜索区域像素级特征融合的方法,并为后续输出增加自适应的模块,以应对低分辨率下小目标特征不足的问题;同时,为特征抽取网络的输出部分增加了深度特征抽取模块;最后,设计基于时间上下文的模板更新策略,在跟踪任务中依据判据,从历史信息中筛选出合适的时空特征,利用跟踪特征的相关性,提升算法在跟踪目标不断变化时的适应能力和算法鲁棒性。

1 基于深度像素级特征的目标跟踪网络

1.1 网络结构设计

本文跟踪算法采用经典孪生网络的结构,具体网络结构如图1 所示。网络的输入有两个,分别为参考模板z(Template)和依据上一帧目标为中心进行裁剪后的搜索区域x(Search Region),输入图像经Resnet50 骨干网络提取特征后,将其中的Layer3、Layer4 和Layer5 三级特征抽取出来。经过Neck 层将多级特征整合,再分别通过预测器分支,用来预测图像中的前景背景类和回归锚框偏移量,其中每个预测器中均加入了基于残差网络和拓扑结构的特征深层提取模块,用于提取深度语义特征信息。将模板与搜索区域特征通过像素级特征融合进行互相关计算得到响应置信图,最后依据预测器得到的分类响应和回归响应结果计算目标前景背景及锚框偏移量。同时,为跟踪器加入了基于时间上下文信息的模板更新策略,提升网络鲁棒性。

图1 网络结构图

1.2 像素级特征融合方法及输出适应模块

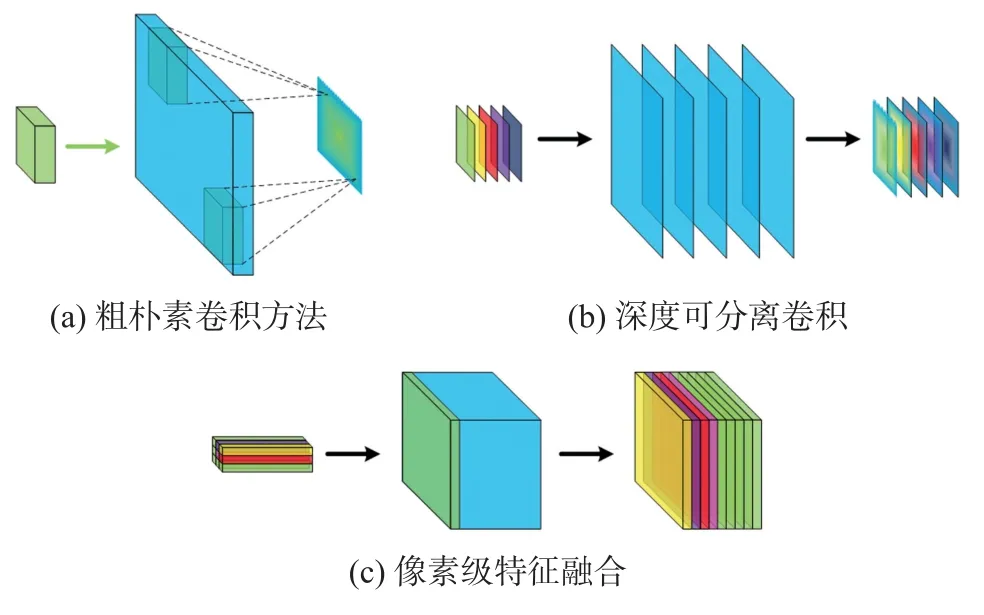

为寻找模板与搜索区域之间的关联性,进行精确定位,本文改进算法使用了像素级卷积方法[11]以替代深度可分离卷积。深度可分离卷积相较于粗朴素卷积提升了互相关操作的速度,将模板特征逐通道地与搜索区域进行卷积,降低了计算复杂度,进而提升了推理速度。但仍存在两个问题:①为了提升计算速度,深度可分离卷积将目标特征逐通道拆分,损失了部分模板特征通道间的关联性;②利用整个模板特征去滑窗与搜索区域特征进行匹配,邻近的特征窗之间会产生相似的响应,从而损失很多边缘信息,造成空间信息的模糊;像素级卷积方法以模板特征中的所有通道上同一个位置的像素值为卷积核,与单个通道上整个搜索区域的特征进行互相关运算,使输出响应可以逐通道地编码目标模板中每个像素点的信息,同时相较其他两种互相关方法,输出响应中包含了更多搜索区域的目标边缘和尺度信息。图2 是三种互相关方法的示意图。

图2 三种互相关方法示意图

像素级互相关计算可以用式(1)表示,其中,输入的模板特征为z,其尺寸为b、c、hz、wz;搜索区域特征为x,尺寸为b、c、hx、wx,经过像素级卷积f作用后,网络的输出响应则会变成b、hz×wz、hx、wx。

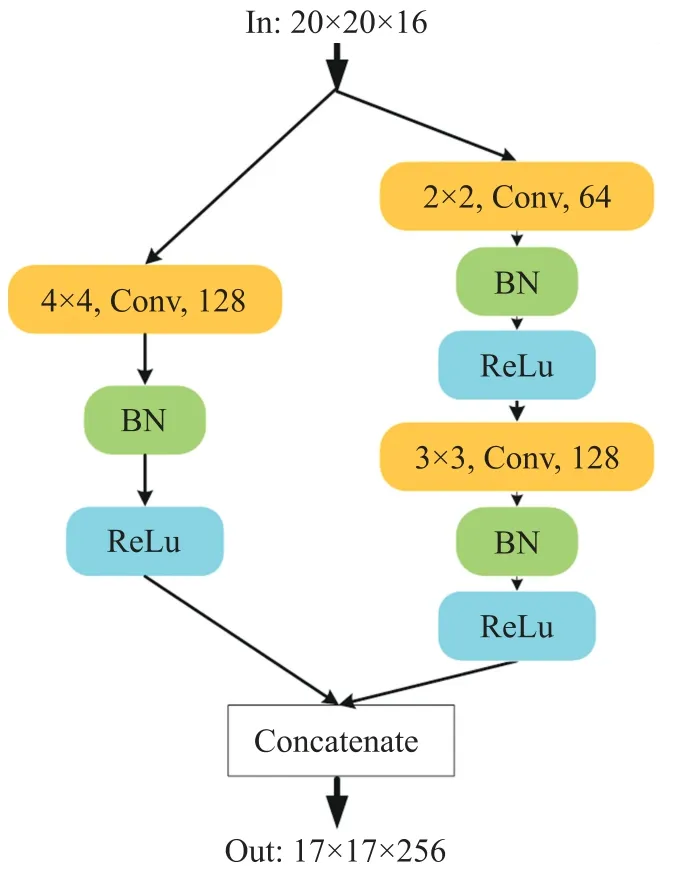

像素级特征融合方法较粗朴素卷积和深度可分离卷积来说更关注模板与搜索区域间的边缘信息等像素级细节特征,但对隐含在模板内像素空间信息关联性的挖掘有所降低。本文在使用像素级特征融合方法替代深度可分离卷积的同时,设计了输出适应模块,在补充跟踪器对目标全局信息关注的同时,提升维度,便于预测结果计算。模块参考GoogLeNet的Inception[12]结构并进行了一定的改造,设计了图3 所示的输出适应结构,网络块由两部分组成,其中一部分是经4×4 的卷积核将特征维度由16 直接提升到128,用来进行特征维度的粗提升;另一部分是先经2×2 的卷积核将特征维度提升到64,然后再经过3×3 的卷积核将特征维度提升到128,用于特征维度的精提升。最后将2 组特征响应图并联拼接起来(Concatenate),以重新聚合形成新的高维融合特征响应。这种网络块以两种方式对输入的响应图进行特征抽取,同时让信息通过更少的连接传递以达到更加稀疏的特性。

图3 像素级特征融合的输出适应模块

1.3 基于残差网络和拓扑结构的特征深层提取

为提高跟踪器特征抽取的性能,本文设计了基于残差网络和拓扑结构的模块来对骨干网络输出的三级特征进行深层挖掘。本文特征深层抽取网络块主要参考了ResNeXt[13]的设计思想,不需要人工设计复杂的Inception 结构细节,而是每个分支都采用相同的拓扑结构,另外在输出结果处引入残差部分,防止网络结构过于复杂带来过拟合问题。其中唯一的超参数为基数(Cardinality),来控制分组卷积组的个数,最后将结果并联起来,以得到更深层特征的输出。网络结构如图4 所示。

图4 基于残差网络和拓扑结构的特征深层抽取模块

网络块的主要运行逻辑为:分割-变换-合并(Split-transform-merge),提取基础算法SiamRPN++的骨干网络ResNet50 的Layer3、Layer4 和Layer5 的特征作为本网络块的输入,输入的特征维度为256维,首先输入分别进入4 组结构相同但参数不共享的拓扑结构中,每条分支均完成:将输入经过2 次1×1的卷积核以提取深层特征,同时将特征向量由256 维降维到64,再将4 种64 维度的分支特征合并,重新获得与输入结构相同的特征。最后,再将原256 维输入作为残差与合并后的特征进行相加操作。本文设计这种残差结构的目的是解决加深网络可能带来的过拟合问题,最终得到可靠的输出响应。

1.4 基于时间上下文信息的模板更新策略

在线目标跟踪任务(Online)较离线目标跟踪任务(Offline)缺少了视频图像序列的全局信息,在线跟踪器很难获得一个全局最优解,并且在线跟踪任务若有其中的任何一帧跟踪丢失,跟踪器就会产生巨大偏移,从而极大地影响跟踪结果的精度。本文为充分利用在线目标跟踪任务中包含大量目标时序信息的特点,设计使用基于时间上下文信息的模板更新策略作为更新判据,来对跟踪器进行实时更新,更新策略流程如图5 所示。

图5 基于时间上下文信息的模板更新策略流程图

基于时间上下文信息的模板更新策略执行流程是:首先,初始化网络并保存第一帧的目标模板特征;后续的视频序列图像依据上一帧跟踪器推理得到的目标坐标截取搜索区域,完成跟踪网络对于本帧图像的推理;跟踪网络经后处理会得到预测的目标空间信息及置信度得分,模板更新策略会先对当前视频序列帧数进行判断,若间隔帧数超过设定阈值,这时对当前帧推理得到的目标置信度得分进行判断:当目标此时得分大于设定阈值,说明当前目标包含了足够特征信息且还包含很多的时间信息,可以进行更新来提升跟踪器对后续图像的适应能力,以获取更好的跟踪结果;若得分太低,说明当前对跟踪器进行模板更新会影响跟踪性能,这种情况包括未达到规定更新间隔阈值,均正常进行下一帧的跟踪。完成所有视频序列的跟踪后,跟踪结束。

2 实验及结果分析

2.1 数据准备与参数设置

本文网络模型利用Pytorch 框架实现。模型的构建、训练及推理实现使用一台搭载AMD 的5800x处理器(主频3.8GHz)、32G 内存和一块NVIDIA RTX 3080 显卡的计算机。

骨干网络使用经过ImageNet 数据集训练后的ResNet50。跟踪模型的训练使用数据集为COCO、ImageNet DET、ImageNet VID 和YouTube-Bounding-Boxes。训练时图像被裁减为255×255 和127×127的尺寸,分别作为搜索区域图像和模板图像同时输入网络中,经跟踪网络前向运行得到分类和回归结果并计算损失,以反向修正网络参数。

本文网络训练时使用的优化器(Optimization)为随机梯度下降法(Stochastic Gradient Descent,SGD),批次大小(Batchsize)为16,并且使用不断变化的学习率对网络的训练进行调整,前5 个训练周期使用0.001 到0.005 逐渐递增的学习率,之后的周期学习率从0.005 指数衰减到0.000 5。

网络RPN 层输出的每个特征点给出5 个推荐锚框(Anchor Number),输出分类向量的维度为10,回归向量的维数为20;骨干网络为ResNet50 时,跟踪器抽取骨干网络的3、4、5 层特征进行后续回归和分类。

为验证本文算法的有效性,分别在2 个目标跟踪领域的标准数据集VOT2018 和OTB2015 上进行了测试,并与多种优秀算法进行了整体性能的比较,以及针对特定场景分析了本文算法较其他优秀算法的优势所在。完整模型在Ubuntu 系统下推理运行速度为65 fps(Frame Per Second)以上。

2.2 VOT2018 实验结果

VOT2018 公共数据集是目前用于评估在线单目标跟踪的主流数据集之一,由60 个视频序列组成并具有不同的挑战因素。VOT 系列主要涉及三个重要的评价指标:准确性(Accuary)、鲁棒性[14](Robustness)和EAO(Expected Average Overlap)。

准确性,是通过数据集来评价算法在跟踪目标任务中跟踪精度的指标[15]。对于单个视频序列,用Np表示整个序列的有效帧数量,A(i)表示跟踪器在该视频序列上重复跟踪N次时在第i帧的准确度,则准确性的计算如下:

式中:对于跟踪器重复跟踪N次视频序列的某单帧的准确度A(i),定义为:

式中:A(i,k)表示跟踪器在第k次跟踪第i帧图像的准确率,若用Ag(i,k)表示跟踪标注框内的图像像素区域,At(i,k)表示跟踪器预测的跟踪框内的图像像素区域,准确率表示为:

鲁棒性,是用来评价跟踪算法在完成跟踪任务时稳定性能的指标。跟踪器的鲁棒性可用跟踪器在同一个视频序列下重复跟踪N次的平均鲁棒性来表示:

式中:R(i)表示跟踪器对视频序列进行第i次重复跟踪时跟踪丢失的次数。当视频序列中某一帧的标注框与跟踪器预测框无重叠时,跟踪丢失次数加1。

EAO,即期望平均覆盖率,是对准确率和鲁棒性的综合评估,是VOT2018 用来评估在线单目标跟踪算法的主要指标。

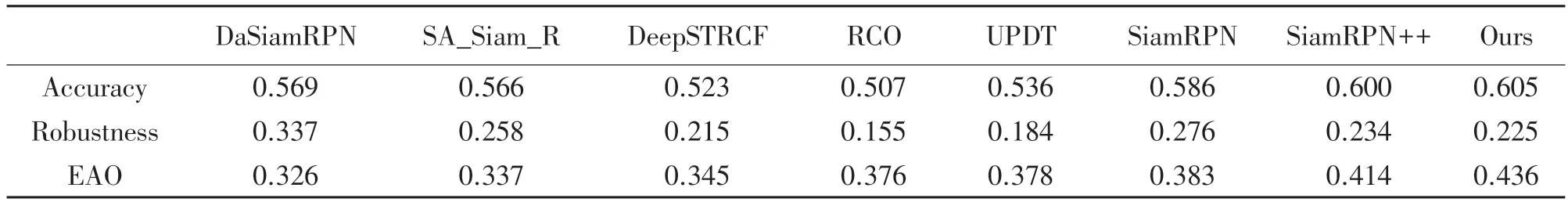

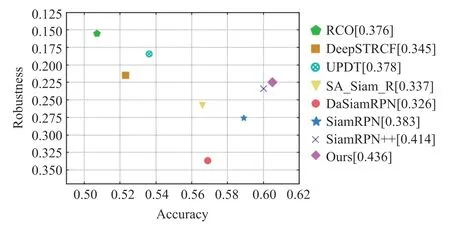

利用VOT2018 数据集对本文算法以及其他优秀算法进行评估,得到结果如表1 所示。由表1 中数据可以发现,本文改进算法较基础算法SiamRPN++来说,EAO 值由0.414 提升到了0.436,提升了5.31%;准确率由0.6 提升到了0.605,提升了0.83%;鲁棒性由0.234 降低到了0.225,降低了3.85%。相较于UPDT来说,本文算法虽然在算法鲁棒性方面不如UPDT,上升了0.041,但在算法精度方面提升明显,比其0.536的准确率高了12.87%,且EAO 值也比UPDT 的0.378高了0.058,提升了15.34%。图6 中所示准确率作为横轴,鲁棒性作为纵轴时,将各算法的性能更明确地绘制出来。可以发现,本文算法在VOT2018 评价中取得了最优的准确率和EAO 值,以及不错的鲁棒性,并且本文算法能在NVIDIA RTX 3080 显卡上运行达到65 帧/s 以上的速度。

表1 VOT2018 数据集各算法结果对比

图6 VOT2018 数据集各算法鲁棒性和准确性

2.3 OTB100 实验结果

OTB100 数据集包含有100 个富有挑战性的视频序列,这些视频序列被官方分为11 个标注属性,包括快速运动(Fast Motion,FM)、背景杂波(Background Variation,BV)、运动模糊(Motion Blur,MB)、目标形变(Deformation,DEF)、光照变 化(Illumination Variation,IV)、平面内旋转(In-Plane Rotation,IPR)、低分辨率(Low Resolution,LR)、目标遮挡(Occlusion,OCC)、平面外旋转(Out-of-Plane Rotation,OPR)、目标超出视野(Out-of-View,OV)、尺度变化(Scale Variation,SV)。

本文选择OTB100 测试数据集对算法性能进行评价,并与相关滤波算法CSK、VTD、STRUCK 和深度学习 类算法 SiamFC、SiamRPN、SiamDW、DaSiamRPN 以及基础算法SiamRPN++进行对比实验。9 种算法的精确率和成功率对比如图7 所示。每种算法在该属性下的评估性能指标标在中括号中。本文算法精确率为91.4%,成功率为71.7%,与基础算法SiamRPN++相比,精确率提升了3.28%,成功率提升了5.13%。

图7 OTB100 数据集各算法精确率和成功率

针对几种特殊情况,对算法有效性进行分析:

①尺度变化(SV):本文算法在标注为尺度变化的数据集上精确率为91.7%,成功率为72.9%,高于基础算法精确率3.26%,成功率6.73%;表2 和表3中统计了OTB100 数据集上几种算法在标注为尺度变化的典型视频序列的精确率和成功率,其中波浪线表示几种算法中的指标最优,双下划线表示指标排名第二,单下划线表示指标第三。

表2 OTB100 数据集各算法成功率对比

表3 OTB100 数据集各算法精确率对比

本文算法在目标尺度发生变化时仍能较为准确地进行跟踪,在几个视频序列中精确率和成功率都位居第一第二位。图8 中的测试序列是一位行人在过马路的过程,目标周围有汽车和人的运动,同时场景由近及远再到近处,跟踪任务包括了遮挡、相似物干扰和尺度变化等影响因素,本文改进后算法的精确率和正确率均为第一,主要原因是利用基于时间上下文信息的模板更新策略在复杂场景下目标尺度发生变化时,及时对跟踪器的跟踪模板进行调整以实现了更好跟踪。

图8 目标可视化跟踪结果(目标尺度变化)

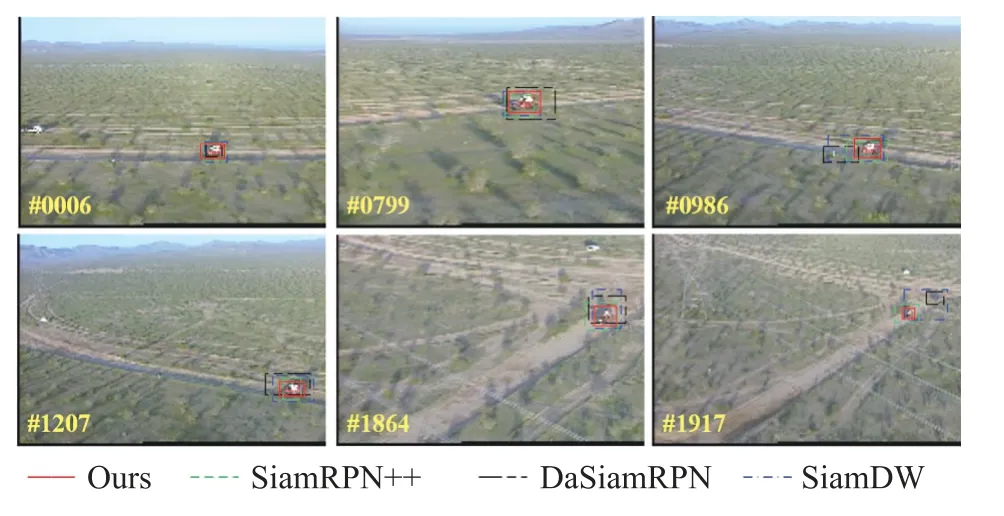

②低分辨率(LR):在OTB100 数据集标注为低分辨率的测试序列中,本文改进算法较基础算法的准确率和成功率分别提高了2.75%和0.2%。低分辨率场景是当搜索区域中目标的图像特征较少时,以考验算法的跟踪性能,本文改进算法使用了像素级互相关方法以及基于残差结构和拓扑网络的特征深层提取,对比基础算法SiamRPN++,在有限的骨干网络特征中提取到了更深层的语义信息,辅助网络的跟踪。如图9 中为RedTeam 跟踪序列,视频序列为一辆汽车在远方道路行驶,汽车不断由远到近,再由近到远,目标像素最小为13×7,本文改进算法较其他算法有更为良好的跟踪表现。

图9 目标可视化跟踪结果(低分辨率)

2.4 消融实验结果

为比较改进算法每一部分在整体跟踪模型中的作用,本文在VOT2018 数据集上进行了消融实验。

如表4 所示,当像素级特征融合及输出适应网络块单独作用于基础算法时,EAO 提升2.86%;当基于残差网络和拓扑结构的特征深层提取网络块单独作用于基础算法时,EAO 提升1.27%;而当两者结合作用时,算法EAO 提升为4.35%,高于两种方案的单独作用,说明像素级特征融合更适合作用于更深层的语义信息,并且残差结构在保留了原特征的同时,很好地避免了过拟合的问题;当基于时间上下文信息的模板更新策略加入时,跟踪器充分结合了空间与时间的信息,跟踪EAO 达到最高0.436。与未添加时间信息的跟踪器相比,EAO 提升了0.004,提升了0.93%。

表4 VOT2018 数据集上消融实验结果

为更为直观地展现改进方法的有效性,将各改进方法与基础算法的不同组合得到的输出响应图进行可视化。如图10 所示,不加入时序信息更新策略的改进算法可明显降低基础算法中噪点带来的错误目标预测估计,且加入更新策略后,目标更加突出,很好地突出了目标而降低了其他噪声的影响。

图10 输出响应图可视化结果

3 结论

本文对复杂场景中的目标跟踪算法进行了研究,并针对目标尺度变化和低分辨率的场景进行了三点主要的算法改进:本文将深度可分离卷积替换为像素级卷积,将模板和搜索区域的多层特征进行融合计算,以得到更为准确的输出响应;本文在原网络提取到的多层特征基础上,加入了基于残差网络和拓扑结构的模块以对图像特征进行深度挖掘;本文通过对跟踪器历史信息进行判别以更新目标模板,来提高改进算法的鲁棒性。在VOT2018 数据集上,本文改进算法比基础算法的EAO 值高5.31%,准确率提高到了0.605,鲁棒性为0.225;在OTB100 数据集上,本文算法精确度为91.4%,成功率为71.7%,与基础算法相比,精确度提升了3.28%,成功率提升了5.13%。