面向分类和深度损失的立体图像重定向质量评价

2023-11-10罗媛婷唐振华

罗媛婷,唐振华,2

1(广西大学 计算机与电子信息学院,南宁 530004)

2(广西多媒体通信与网络技术重点实验室,南宁 530004)

1 引 言

随着数字多媒体技术的迅猛发展,数字图像/视频已逐渐从平面走向了立体,立体图像/视频被应用于诸多的行业和领域,比如影视业、游戏业、制造业和医学生物领域等[1-3],给人们带来更舒适真实、身临其境的视觉体验[4,5].然而,立体图像/视频在不同终端设备的显示和播放仍然面临着分辨率和宽高比需要自适应调整的问题.立体图像重定向(Stereoscopic Image Retargeting,SIR)就是解决该问题的有效方法之一[6,7],SIR旨在调整原始立体图像的分辨率或宽高比以适应不同显示设备的前提下,尽可能为用户提供高质量视觉体验[8,9].在平面图像重定向方法中,影响图像重建质量的主要有几何变形、信息丢失和结构失真等3个方面的因素[10-12];但是,对于SIR方法而言,除了考虑减少几何失真、信息丢失、结构失真等常见问题外,SIR还面临着重定向过程中如何解决与立体感知相关的附加质量问题,例如保持深度感不变、减少双目竞争和降低立体视觉不适等[13,14].立体图像重定向质量评价(Stereoscopic Image Retargeting Quality Assessment,SIRQA)算法主要从以上几个方面对立体重定向图像的质量进行评价.

然而,现有的SIRQA算法存在以下的问题:

1.现有的SIRQA算法[15-22]没有考虑到不同类型的重定向图像的失真模式存在明显差异的特点,而采用统一的失真量度方法对所有的重定向图像进行衡量,评价的结果与人眼主观感知的吻合度较低.

2.现有SIRQA算法缺乏对立体重定向图像的深度感的有效衡量.与平面重定向图像不同的是,当立体图像的深度信息在重定向过程中丢失时,人眼对图像中立体空间的感知会发生显著的变化.然而,现有的客观评价方法缺少针对深度感失真的衡量指标,从而降低了SIR质量的客观评价与主观评价的吻合度.

针对上述问题,本文提出了一种基于显著度和深度特征分类的SIRQA算法,不同类型的图像采用不同的失真质量评价策略.此外,还设计了更符合人眼感知的深度感损失衡量指标.实验结果表明,本文的方法的性能优于现有的主流方法.

本文工作的贡献如下:

1.对不同特征的立体重定向图像采用不同的客观质量评价策略.现有算法中没有对重要物体的整体形变进行衡量,但在前期的研究中本文发现,这一失真在主观评价中也占据着重要因素.于是本文根据有无明显前景对象的特征,将图像分成了两类,其中有明显重要物体的一类注重对整体几何形变的衡量.同时,图像的深度复杂度不一样时,人眼对于深度感受的关注点也不同.当深度层次较为简单时,更注重重定向图像自身的深度质量;当深度层次较为复杂时,人眼更容易注意到与原图的深度感受差异.因此,对于有明显物体的一类,本文再次将图像细分为深度感受简单与深度感受复杂的两类图像,并用不同的失真指标组合进行评价.

2.提出了一种基于逆向重建的深度信息丢失衡量指标.在前期研究中本文还发现,当丢失的信息深度差异较大时,会造成物体空间感受的损失.于是本文利用SIFT-flow[23]算法,统计重定向过程中被删除像素点信息,同时结合深度边缘信息使它能够更准确地对深度信息丢失进行衡量.首先将重定向与原始图像的深度图进行逆向匹配,得到逆向重建信息图.再计算出深度信息丢失像素的占比,以此作为深度信息丢失的度量.

3.提出一种基于深度图正向距离的绝对深度相似度衡量方法.在重定向图像的评价中,本文侧重关注的是最大限度地保留原始图像的信息.在深度感受方面,本文认为立体重定向图像呈现出来的深度感受应与原图尽可能相似.与第2点不同的是,该指标直接通过计算原图与重定向图像深度图的距离来比较,更直观地体现深度图的相似度.首先将原始图像与重定向图像进行网格块划分,计算局部对应块的深度值距离,用于判断重定向图像与原始图像的深度相似度.

2 相关工作

目前有关立体图像重定向客观质量评价的研究工作较少.早期,Fu等人[24]构造了一个SIRQA数据库,并对Hand-Craft and Deep Learned Features (HCDL)[25]、Disparity Amplitude and Gradient(DAG)[26]和Bidirectional Similarity (BDS)[27]等几种SIR质量评价算法进行了性能分析后发现,SIR质量客观评价方法的准确性仍有较大的提升空间,需要综合考虑几何失真、内容损失和立体感知质量,以提高客观评价与主观评价的吻合程度.

SIR质量的客观评价算法[15-22]大都遵循以下模式来设计:首先进行视觉特征提取,人为地对图像进行分析,并提取各类图像特征,构造衡量不同类型失真的指标;再采用基于机器学习的方法来对不同类型的失真指标进行融合,得到立体重定向图像的客观评价分数.Liu等人[15]提出了一个基于学习的客观立体图像质量评价指标,对过度视差深度相似性、图片完整性、局部和全局的失真等方面提取特征进行训练.周等人[16]利用视差范围、视差强度分布、边界视差和图像质量等特征来评价三维重定向图像的质量.Muhan等人[17]提出了一种衡量图像质量、视觉舒适度、深度结构相似的客观评价指标.富等人[18]通过提取3D重定向图像的深度感特征、视觉舒适度特征和左右视点的图像质量特征,使用支持向量回归预测3D重定向图像的视觉质量.Jiang[19]等人通过将2D的高宽比相似度(ARS)指标扩展到一个被称为StereoARS的3D版本,用于对3D图像重定向质量评价的衡量.Wang[20]等人利用了SIR的3D感知和图像退化机制,并且将图像质量特征和三维感知特征集成到一个表示中,使用列表排序方法进行整体感知质量预测,优先考虑从同一原始图像生成的SIR结果图像中的排序.同年,Wang[21]等人又提出了一种新的方法,通过衡量中间视图的合成方法来描述几何变形和信息丢失的立体图像对,此外用一些深度感知特征用来表征人眼观看3D图像时的感受.Fu等人[22]从单目重定向变换和视点变换两个方面来提取图像特征,并使用随机森林的方法对图像特征及主观评分进行训练,预测立体图像重定向的评价分数.

3 面向分类和深度损失的立体图像重定向质量评价

3.1 算法框架

本文算法首先根据立体图像左视图的显著度以及深度特征,对立体图像进行自动分类,然后采用不同的评价策略对不同类型的重定向图像予以评价.本文算法的框图如图1所示,具体步骤如下:

图1 算法框架Fig.1 Algorithm framework

步骤1.提取图像特征.利用Pica-net[28]的方法分别获得原始图像和重定向图像的左图对应的显著区域图;利用GBVS[29]的方法,分别计算原始图像左图和右图的显著度图.利用SIFT-flow[23]的方法分别得到重定向图像与原始图像左图、重定向图像与原始图像右图的SIFT-flow图;利用文献[30]的方法,分别获得原始图像和重定向图像的视差图;利用文献[31]的方法,分别获得原始图像和重定向图像的深度图;利用文献[32]的方法生成原始图像深度边缘图.

步骤2.对立体图像进行分类.根据步骤一得到的原始图像左图显著区域信息图和原始图像深度边缘信息图,本文将立体图像分为3类:有显著物体且深度感受复杂类(Complex Depth Perception,CDP)、有显著物体且深度感受简单类(Simple Depth Perception,SDP)、无显著物体类(Non-salient Object,NSO).具体的介绍详见3.2节.

步骤3.计算失真指标评价分数.根据步骤一中得到的原始图像左图显著度图、SIFT-flow图、重定向图像左图显著区域图、重定向图像视差图和重定向图像深度图,计算以下5种失真指标评价分数,包括衡量几何失真的基于图像块的宽高比相似度(Aspect Ratio Similarity Based on Block,BARS)指标、基于显著区域整体宽高比相似度指标(Aspect Ratio Similarity Based on Salient Area,SARS),衡量深度信息丢失的深度感受损失(Depth Perception Loss,DPL),衡量深度感受的绝对深度距离(Absolute Depth Distance,ADD)、视点变换(Viewpoint Transformation,VPT).具体的介绍详见3.3节.

步骤4.分类评价机制.根据步骤2中的分类结果,选取步骤3中适于评价其失真的指标组合进行融合,得到立体重定向图像最终的客观评价分数.具体的介绍详见3.4.

3.2 图像分类

现有的SIRQA没有考虑特征各异的图像在重定向失真模式上存在明显差异的特点,仅采用单一且固定的失真衡量方法对不同类型的重定向图像进行质量评价,导致客观评价的结果与人眼感知的吻合度较低.经过实验证明,采用分类评价策略后评价算法的性能更佳,与主观的感知更吻合.

人眼通常对重要对象的整体几何形变比较敏感.对于有明显重要物体的图像,应重点衡量重定向图像中的几何形变.因此本文认为有必要根据有无明显重要对象对图像进行分类.于是本文引入显著度参数σ表示图像的显著信息,将其作为区分图像有无重要对象的依据.设p(i,j)为位置(i,j)的像素,简写为p,显著度参数σ的表达式如式(1)所示:

(1)

其中,S为显著信息图,由前景检测图F经过膨胀腐蚀等操作

去除噪声点,再用大津法对图像进行自适应二值化操作得到.mS和nS分别为S的宽和高.S(p)等于1时,代表该像素点为显著对象像素;S(p)等于0时,代表该像素点为背景区域像素.当显著度参数σ>0时,把该幅图像判定为有明显重要对象的图像;σ=0时,把该幅图像判定为无明显重要对象的图像,如图2所示.

图2 基于σ值的图像分类Fig.2 Image classification based on σ value

另一方面,立体图像的深度复杂程度影响人眼所关注的深度感受失真类型.当图像的深度层次较多、分布较广时,人眼更关注重定向图像全局的深度感受与原始图像的对比;当图像的层次较少、分布较集中时,人眼更关注重定向图像中重要对象成呈现出的深度感受.因此,本文还引入了深度复杂度参数d来描述图中的深度分布情况.深度图的边缘通常表示两个不同的深度层次,本文利用深度边缘信息计算深度复杂度参数d,如图3所示,具体的计算公式如式(2)所示:

图3 基于d值的图像分类Fig.3 Image classification based on d value

(2)

其中,D为深度图,E为深度边缘图,mD和nD分别为深度图D的宽和高.深度复杂度参数d值越大表示图中的深度分布越复杂.设定阈值θ,当深度复杂度d大于等于该θ时,把图像归为深度感受较为复杂的图像;当深度复杂度d小于该阈值时,把图像归为深度感受较为简单的图像.经过实验,阈值θ取0.4时,分类效果最符合人眼对于图像的分类判断.

算法1.基于显著度和深度特征的图像自适应分类算法

输入:原始图像I左图Il和右图Ir

输出:I的图像类型CT

1.F← 用Pica-Net[28]方法检测Il前景

2.S← 对F进行膨胀腐蚀处理,并进行二值化

3.D← 用文献[30]方法求Il,Ir视差图后,再利用文献[31]方法获得深度图

4.E← 用方法[32]对深度图D进行边缘检测,并进行二值化

6.ifσ=0then

7.CT= ′NSO′

8.else

10.ifd≥θthen

11.CT= ′CDP′

12.else

13.CT= ′SDP′

14.endif

15.endif

16.returnCT

分类算法根据原始图像中的显著度参数σ和深度复杂度参数d,将图像分为3类:NSO、CDP、SDP.算法的具体步骤如算法1所示.

3.3 失真评价指标

3.3.1 深度感受损失指标(DPL)

对于立体图像而言,深度变化较大区域的信息丢失,会对整幅图像的立体空间感造成影响.如果丢失了深度图像的边缘信息,会降低两个不同深度值区域的相对深度,导致深度对比感减弱,从而影响重定向图像的立体感.因此,本文设计了深度感受损失(DPL)指标,利用深度信息丢失衡量深度感.如图4所示,该指标具体实现步骤如下:

第1步.提取深度边缘特征.首先计算原始图像和重定向图像的视差图[30],再根据文献[31],将视差图转换为深度图,最后用文献[32]方法求出原始图像深度边缘图,并进行二值化处理;

第2步.生成逆向重建SIFT-flow图.用SIFT-Flow[23]方法计算出重定向图像左图的SIFT-Flow图,如图4所示,图中连续的细缝表示在立体重定向过程中被删除像素点集合.并将SIFT-flow图进行二值化,像素值为0代表重定向过程中被保留下来的像素点,像素值为1代表重定向过程比中被删除的像素点;

第3步.生成图像网格.将SIFT-Flow图均匀划分为大小m×n的图像块;

第4步.计算边缘像素点所在图像块中,被删除像素点占图像块总像素点的比值ρ,如式(3)所示;

第5步.将所有边缘像素点对应的图像块的比值ρ进行平均,计算结果为每幅图像的DPL指标,如式(4)所示:

(3)

(4)

其中,fi为二值化SIFT-flow图中的第i个图像块,m、n分别为图像块的宽和高.ρi为第i个图像块的ρ值,a为包含深度边缘像素点的图像块数.DPL的值越小,丢失的深度变化信息越多,立体图像的深度感受损失也就越大;反之,深度感受损失较少,更接近原始图像呈现出的效果.

3.3.2 绝对深度距离指标(ADD)

当重定向图像呈现出来的深度感受与原始图像越接近,其主观评价分数往往会越高.受Liu等人[15]的文章中深度相似度(Depth Similarity,DS)指标的启发,本文从深度图出发,对重定向图像与原始图像的深度值相似度进行衡量.与Liu[15]不同的是:本文去掉DS指标中的显著度图,以减少算法中复杂的操作步骤;用更直观地表达人眼对于图像的深度感受深度图代替视差图进行计算;更重要的是,改进了图像块深度距离的计算方法,本文的指标绝对深度距离(absolute depth distance,ADD)能更精确地反映深度感受的失真,具体实验结果将在4.2小节中讨论.

具体做法如下:

第1步.划分图像网格块.将原始图像深度图与重定向图像深度图划分为同样数量的均匀矩形网格;

第2步.生成平均灰度向量.用每个网格块的平均灰度值代表该网格,并把原始图像与重定向图像的网格代表值分别存放在两个向量中,如式(5)、式(6)所示;

第3步.计算绝对深度距离.根据式(7)计算ADD值.

(5)

(6)

(7)

3.3.3 基于图像块的宽高比相似度指标(BARS)

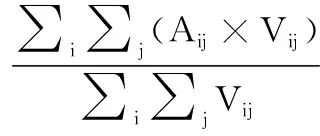

对于图中几何形变的衡量,本文采用文献[33]的中的基于图像块的宽高比相似度(BARS)指标,用于衡量全局图像块的几何失真.计算方法如式(8)所示:

(8)

其中,图像块的尺寸为16×16,i、j分别代表每行、列的图像块个数.Vij代表第i行,第j列图像块显著图的平均值.Aij代表第i行,第j列图像块的宽高比相似度计算结果,具体计算方法如式(9)所示:

(9)

3.3.4 基于显著区域的宽高比相似度指标(SARS)

为更好地衡量重要物体的整体形变,借鉴yao[34]的方法,本文采用显著区域整体宽高比相似度指标(SARS)进行计算.首先,计算出原始图像与重定向图像的显著区域图[35],接着分别求出二者显著区域的最大宽、高,计算公式如式(10)所示:

(10)

3.3.5 视点变换指标(VPT)

采用Fu[22]中视点变换(VPT)的计算方法.该方法基于视点变换,从网格变形与遮挡信息丢失两个角度对深度感受损失进行衡量.与ADD不同的是,VPT更侧重衡量重定向图像本身的深度感受失真,而前者更注重重定向图像与原图产生的深度感受是否相似.

3.4 分类质量评价

根据每类图像不同的失真类型和模式,本文选用不同的失真指标组合进行质量评价.本文都采用基于机器学习的训练方法对失真指标组进行融合,获得最终的评价分数.训练的方法如下:首先将图像库中的图像根据是否为同一原始图像分为若干组,然后在SDP、CDP、NSO类的子图像集中用一组图像作为测试集,剩余图像作为训练集,用SVM方法进行训练,将具有径向基函数核的支持向量回归(SVR)[36]用于构建回归模型,并且采用libsvm包[37]实现.训练的参数选取如下:s取3,表示用epsilon-SVR模型训练;t取2,表示用radial basic function作为核函数;c为epsilon -SVR的损失函数相关参数,取10时实验效果最佳;g为核函数中的gamma函数相关参数,取0.22时实验效果最佳.

3.4.1 SDP类

对于有显著物体且深度感受简单(SDP)类,本文用BARS、SARS、深度信息丢失(DPL)、绝对深度距离(ADD)、VPT 5个指标的组合进行评价.在2D质量上,对于几何形变而言,在基于块状的BARS的基础上,还新增加了基于整体形变的SARS衡量,从整体和局部衡量图像的几何形变,更好地代表人眼较容易捕捉到的整体几何形变.在3D质量上,DPL注重衡量深度信息的丢失,更好地代表立体感受损失;此外,本文认为重定向图像呈现出的立体感受与原图越相似,得到的主观评价会更高,因此还用基于块的ADD指标,对重定向图像和原始图像的深度图差异进行计算;同时,还用Fu[22]中的VPT衡量左右图网格差异和遮挡对立体感受的影响.SDP类的失真组合表示如式(11)所示:

FSDP=[BARSl;BARSr;SARS;DPL;ADD;VPTl;VPTr]

(11)

其中,BARSl、BARSr分别代表重定向图像左图、右图的BARS评价分数,VPTl、VPTr分别代表重定向图像左图、右图的VPT评价分数.

3.4.2 CDP类

对于有显著物体且深度感受复杂(CDP)类,本文采用BARS、SARS、DPL、ADD这4个指标进行评价.SDP类的图像,深度图边缘像素较少,而深度图的边缘通常与物体边缘一致.因此此类图像被本文认为是:整幅图像中前景物体深度值较小,背景物体深度值较大,且背景深度层次较少较为简单,即重要物体立体感较突出的一类图像.而CDP则相反,这类图像的深度分布较为复杂,深度层次分布较广,用基于局部图像块的绝对深度指标,能够很好的对这些较为分散的深度信息的相似度进行衡量.而在SDP中,只有重要对象的深度产生较大的影响,而只对深度从块与块之前的差异进行衡量,会引入其他一些人眼不太关注的区域而带来误差,因此加入VPT指标进一步精确对SDP类图像进行衡量,而在CDP类图像中去掉该指标.CDP类的失真组合表示如式(12)所示:

FCDP=[BARSl;BARSr;SARS;DPL;ADD]

(12)

3.4.3 NSO类

对于无明显重要物体(NSO)类,本文用BARS、ADD、VPT进行评价.由于此类图像没有明显的重要物体,在几何形变的衡量中,只用BARS指标进行对局部图像块的几何形变进行衡量.并且在深度感受这方面,用ADD与VPT进行衡量.NSO类的失真组合表达式如式(13)所示:

FNSO=[BARSl;BARSr;ADD;VPTl;VPTr]

(13)

4 实验结果

目前关于SIRQA的基准数据库有两个:NBU-SIRQA[22]数据库和SIRD[16]数据库.其中,NBU-SIRQA数据库中包含45组立体图像,每组图像包含Monocular Seam Carving (MSC)[38]、Monocular scale and stretch (MSNS)[39]、Content Persistent Cropping (CPC)[40]、Stereoscopic scaling (SSCL)、Geometrically Consistent Stereoscopic Seam Carving (GCSSC)[41]、Visual attention guided seam carving (VASSC)[42]、QoE-guided warping (QOE)[31]、Single-layer warping (SLWAP)[43]共8种立体重定向方法产生的结果图像.该数据库利用平均意见得分(Mean Opinion Score,MOS)方法计算720幅立体重定向图像的主观分数.SIRD数据库中包含了400幅重定向立体图像.它们由立体剪裁法、立体细缝法、立体缩放法以及立体多算子法生成.与NBU-SIRQA数据库不同,SIRD数据库用平均主观得分差(Differential Mean Opinion Score,DMOS)计算主观分数.为了衡量算法的性能,本文采用NBU-SIRQA数据库和SIRD数据库进行实验测试.

4.1 实验结果对比

4.1.1 NBU-SIRQA数据库

本文对宽度缩为75%和50%两种情况进行了测试,用皮尔森线性相关系数(Pearson Linear Correlation Coefficient,PLCC)、斯皮尔曼秩相关系数(Spearman Rank-order Correlation Coefficient,SRCC)、均方根误差(Root Mean Square Error,RMSE)3种指标衡量立体重定向图像评价方法的性能,并与11种现有评价方法的评价结果进行了对比,如表1所示.这11种方法包括:SIFT-flow[23]、BDS[27]、EMD[44]、HCDL[25]、ARS[33]5种用于2D图像重定向的评价算法,以及Liu[15]、 Zhou[16]、Fu[22]、Wang1[20]、Wang2[21]、StereoARS[19]6种为3D图像重定向设计的评价算法.

表1 NBU-SIRQA数据库实验结果Table 1 Experiment results on NBU-SIRQA database

从表1中可看出,本文算法的总体性能优于其他评价算法.除了SRCC与Wang2的算法表现相当外,PLCC、RMSE两个指标都明显优于其他现有算法.与现有性能最佳算法相比,PLCC上升了2.13%,SRCC与现存算法最佳值持平,说明本文算法评价的结果与主观评价的吻合程度更高了.从RMSE指标上看,比现有性能最佳算法的结果下降了75.45%,说明本文算法在评价的稳定性上有了显著提升.这主要得益于本文算法采用了分类评价机制,并且采用了DPL和ADD两个衡量深度感的指标.

在宽度缩放比为25%和50%的单独测试结果中,RMSE指标则明显优于现有绝大部分方法,但PLCC与SRCC指标略低于部分现有的方法.这是因为与总数据集相比,子数据集训练样本明显减少.缩放比为25%、50%时,子集图像为总集数量的一半,共360幅重定向图像,再将子集分成3类进行训练,其中在NBU-SIRQA数据库上无明显重要区域(NSO)类图像的训练样本只有48幅图像,样本数量较少对最终结果造成很大影响.对于其他方法而言,没有在子集上再将图像划分为3类,在训练率为80%的情况下,训练样本可以达到288幅图像,比本文的方法更多.当缩放比为50%,图像已经明显丢失了图中的大量信息,能够用于训练的特征信息就更少,评价的准确性会低于25%与总数据集的.所以本文更关注总数据集的结果.

4.1.2 SIRD数据库

对于SIRD数据库,本文同样也用PLCC、SRCC、RMSE 3个指标对算法的评价性能进行衡量.在表2中,与主流的13种方法对比,包含了5种用于2D图像重定向的评价方法[23,33,44,45,46],以及8种用于3D图像重定向质量评价的方法[15,16,19-22,47,48].本文算法的整体性能优于现有算法,特别是PLCC和RMSE两个指标,性能明显优于其他算法,分别比目前最优的指标Wang2[21]上升了7.59%、下降了94.37%.但SRCC指标略低于目前性能最佳的StereoARS[19],在现有算法中排名第3.经过分析发现,无明显重要区域(NSO)类的SRCC值性能较差,经过3类图像平均,使得整体性能上SRCC较低.SIRD数据库的分类评价性能如表3所示,其中无明显重要区域(NSO)类占整体图像的48%,有显著物体且深度感受复杂(CDP)类占27%,有显著物体且深度感受简单(SDP)类占25%.占据较大比例的NSO图像拉低了整体的SRCC值.而在NBU-SIRQA数据库中,NSO类约占9%,因此对整体性能的影响较小.经过分析发现,NSO类性能较差的主要的原因在于:1)一些显著区域较小的图像在分类的过程中,被划分到无明显重要物体类,导致重要物体的整体形变没有被有效衡量,影响最后的评价性能;2)对于无明显重要物体的图像,图中相对深度的相似度也会影响图中的深度感知,但目前没有相应的指标进行衡量.以上两点也是本文后续工作中要改进的地方.

表2 SIRD数据库实验结果Table 2 Experiment results on SIRD database

表3 SIRD数据库分类结果Table 3 Classification results on SIRD database

4.2 验证深度感衡量指标有效性

为验证本文提出的DPL、ADD指标对整个评价算法的贡献,本文在NBU-SIRQA数据库做了消融实验进行对比,实验结果如表4所示.可见,去掉DPL之后PLCC与SRCC分别下降了1.35%、1.76%; 同样ADD去掉之后PLCC与SRCC分别下降了0.90%、1.41%.而当同时去掉两个指标时,PLCC与SRCC分别下降了1.58%、3.29%.因此两个新指标都对算法总体性能的提升有一定提升,尤其是当两个指标同时作用时,对整体指标的性能有明显提高.

表4 消融实验Table 4 Ablation experiment

这是因为与2D图像重定向的评价不同,3D图像重定向质量评价注重对图像立体感受的评价,现有算法所设计的指标中,BARS、SARS属于在2D层面上对图像进行评价,VPT是对立体感进行评价,但这些指标的评价并不全面.就立体感受的评价而言,VPT只是对重定向图像的本身立体感受进行评价,侧重视觉舒适度方面的衡量,缺少了与原始图像质量的对比,但这恰恰是图像重定向过程中重点关注的地方.而本文提出的ADD、DPL这两个指标分别基于深度图的绝对深度差异对比、基于逆向匹配的深度信息丢失,更注重3D重定向图像在深度感受上的深度感受失真.在将BARS、SARS、VPT、ADD、DPL这5个指标进行组合之后,从图像质量、深度感受、视觉舒适度等方面进行全面衡量,提升了主观评价与客观评价的吻合度.

5 总 结

本文提出了一种基于分类和深度感损失的立体图像重定向客观评价算法,对不同类型的图像采用不同的失真质量评价策略.本文还提出了两种用于衡量深度感损失的指标,分别利用重定向过程中深度信息的丢失以及绝对深度变化来衡量深度感的损失.结果表明,该方法的总体性能优于现有的立体图像重定向客观评价算法.