基于卷积神经网络的涎腺肿瘤超声图像分类研究

2023-11-02沈筱梅张新颖王权泳

沈筱梅 张新颖 王权泳 吴 哲 陈 琴

涎腺的作用是产生唾液,唾液的功能主要是溶解消化食物、润滑口腔和抑菌等[1-2],涎腺疾病易导致其功能障碍,降低患者的生活质量。涎腺病变包括肿瘤、炎性病变及自身免疫性疾病等[2-5],临床均可表现为涎腺局部肿块,其中以肿瘤性疾病最多见,约80%发生于腮腺[6-7]。涎腺肿瘤首选手术治疗,手术方式的选择取决于其性质及组织学类型[8],当手术标本的组织学病理结果与术前诊断不一致时,易导致手术不彻底或二次手术[9],增加肿瘤复发甚至恶变的风险。此外,腮腺肿瘤手术易损伤面神经,引发面神经麻痹、Frey 综合征等并发症,因此术前准确评估肿瘤性质对制定治疗方案及预测预后均有重要作用[10]。目前涎腺肿瘤的术前辅助检查包括超声、CT、MRI、细针穿刺活检、PET-CT 等,因有肿瘤细胞种植的风险,涎腺肿瘤术前不宜进行穿刺活检[11]。超声因价廉、快捷、方便、无创和无辐射等优点,成为涎腺疾病的首选辅助检查。

涎腺肿瘤的临床表现多无特异性,肿块增长迅速、疼痛、破溃、面神经麻痹等多提示恶性,但大多恶性肿瘤的临床表现与良性肿瘤难以鉴别,尤其在病变早期阶段[12]。由于涎腺良性肿瘤的超声图像特征差异并不明显[13],仅根据单一的超声征象鉴别诊断其良恶性并不理想,且建立涎腺超声图像数据库难度较大。目前已有部分研究人员尝试应用机器学习算法对涎腺肿瘤的超声图像进行智能分析,如Vukicevic 等[14]提出了一种基于深度学习的唾液腺超声图像自动分割解决方案来实现病灶图像的分割,并考虑了4 种体系结构,包括全卷积神经网络、FCN-DenseNet、U-Net 和LinkNet,该研究纳入了1184 张经过注释的唾液腺超声图像,在交叉合并方面,表现最好的FCNDenseNet 较临床专家间的观察者间协议有较大差距[交并比(IoU)=0.85、0.76],略高于临床专家间的观察者内协议(IoU=0.84),考虑到其准确率和速度(24.5 帧/s),该研究认为FCNDenseNet 在临床实践中可获得更广泛的应用。Prezioso 等[15]提出并讨论了一种基于深度学习的涎腺肿瘤自动分割与分类框架和一种可解释的分割学习方法,通过逐时学习过程分析和注意地图机制来支持所提框架的有效性,并通过收集涎腺肿瘤的数据集对提出的框架进行评估,结果表明该方法在分割和分类方面均取得了较好成绩。Gündüz 等[16]认为放射组学和深度学习模型是医学图像计算机辅助诊断的前沿技术,该研究表明智能分析工具能够以合理的准确性对常见的腮腺肿瘤进行分类。基于此,本研究提出一种基于卷积神经网络(convolutional neural network,CNN)的涎腺肿瘤常规超声图像分类方法,并结合肿瘤超声图像特征,提高了鉴别涎腺肿瘤良恶性的准确率。

一、数据采集与工具

1.超声图像采集

本研究使用的数据集由四川省人民医院超声科通过统一的图像采集标准获得,且均经临床病理检查验证。使用仪器包括三星RS80A、S80,GE Logiq E9、S8,声科Aixplorer,百胜MyLab,迈瑞8T、R9S、DC-8 Pro,Philips iU Elite 彩色多普勒超声诊断仪,探头频率7.5~10.0 MHz。图像采集标准:①存取肿块纵切面及横切面图像各1张,显示肿块最不规则的切面,必要时需多切面斜切并存图;②聚焦点与肿块平行;③调节增益为正常涎腺与正常甲状腺相同显示为均匀细密高回声,周边肌肉呈低回声;④深度应完整显示病灶与下颌骨、周围组织的关系;⑤彩色多普勒量程为±(5~8)cm/s。本研究共回顾性收集2015年1月至2022年1月208例涎腺肿瘤患者的超声图像共984张,包括431张横切面图像和553张纵切面图像,病理归类为762张良性肿瘤图像和222 张恶性肿瘤图像,每张图均由2 名低年资(2 年以上工作经验)超声医师及1 名高年资(25 年以上工作经验)超声医师标注。

2.软、硬件工具

软件工具主体使用Python 3.9 作为开发语言,深度学习框架使用Pytorch 框架。硬件工具:使用Windows 10 版本的计算机,CPU 型号为i5-8250U,4 核8 线程处理器,主频为1.60 GHz;显卡型号为NVIDIA GeForce GTX 1650。

二、方法与结果分析

1.图像预处理

本研究应用图像处理技术对涎腺肿瘤常规超声图像进行图像分割、病灶识别、图像预处理等,并将其作为分类算法的训练和测试依据,进行进一步的特征提取和良恶性分类。研究[13]表明涎腺良恶性肿瘤超声图像特征差异不明显,仅边界和钙化灶方面比较差异有统计学意义(均P<0.05)。为评估涎腺良恶性肿瘤超声图像的边界和钙化灶的差异,本研究使用病灶边界模糊度和内部纹理特征分别作为边界和钙化灶的衡量指标。

病灶边界模糊度基于灰度值方差计算,以手动标记病灶的红圈为界,将病灶边界附近特征图分为内、外两部分。见图1。两部分的像素方差之差即为病灶边界模糊度值(EDscore),边界越清晰,EDscore越大;边界越模糊,EDscore越小。EDscore计算方法为:

图1 标记病灶边界示意图

病灶内部纹理特征基于灰度共生矩阵的特征统计量,本研究采用45°扫描灰度共生矩阵得到能量(Asm)、熵(Ent)、对比度(Con)、逆方差(H),并作为病灶内部纹理特征参数。各参数计算方法为:

其中,P(i,j)为归一化后的灰度共生矩阵,i为灰度共生矩阵的行数,j为灰度共生矩阵的列数,N为灰度共生矩阵的维度。

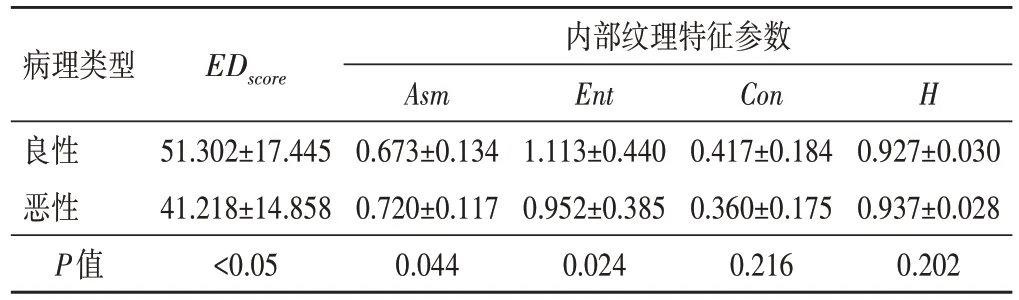

涎腺良恶性肿瘤EDscore及内部纹理特征参数比较见表1。结果显示,良恶性肿瘤EDscore、Asm、Ent比较差异均有统计学意义(均P<0.05),推测病灶内部纹理特征和边界的图像增强处理对图像分类有一定的促进作用。

表1 涎腺良恶性肿瘤EDscore及内部纹理特征参数比较()

表1 涎腺良恶性肿瘤EDscore及内部纹理特征参数比较()

EDscore:病灶边界模糊度值;Asm:能量;Ent:熵;Con:对比度;H:逆方差

病理类型EDscore内部纹理特征参数Ent 1.113±0.440 0.952±0.385 0.024 51.302±17.445 41.218±14.858<0.05 Con 0.417±0.184 0.360±0.175 0.216良性恶性P值0.927±0.030 0.937±0.028 0.202 Asm 0.673±0.134 0.720±0.117 0.044 H

因此,为增强涎腺肿瘤的钙化灶特征,同时保留原超声图像中病灶边界及内部纹理信息,本研究首先应用滤波算法去除斑点噪声,再应用图像处理方法获得病灶内部掩膜图、病灶边界轮廓图,然后将特征组合图(由病灶内部特征区域图、病灶边界轮廓图、去噪后原始图像组合而来)作为样本进行神经网络的训练。

(1)斑点噪声:由于斑点噪声的存在及医学超声图像自身成像机制的限制,医学超声图像分辨率较低且噪声干扰严重,故本研究尝试通过滤波算法减少斑点噪声对超声图像的影响。

双边滤波是一种非线性的滤波方式,其在进行低通滤波时考虑了空域信息和邻近像素相似性信息,其滤波器[17]定义为:

其中Wp是归一化因子,用来确保像素权重总和为1。

式(7)中,参数σs和σr表示对图像I的滤波程度。Gσs和Gσr则分别为空间和尺度高斯因子。相比于高斯滤波,双边滤波算法更好地保留了边缘位置的梯度,因而能够较好地保留图像边缘的高频信息。对比高斯滤波处理后的图像,经双边滤波处理后的图像边缘特征保留更加完好。但由于进行滤波算法时结合了邻近像素的灰度相似性,故对高频噪声的去除效果会因为需要保留图像边缘高频信息而衰弱。应用伽马变换可对图像的灰度进行非线性变换,其基本形式如下:

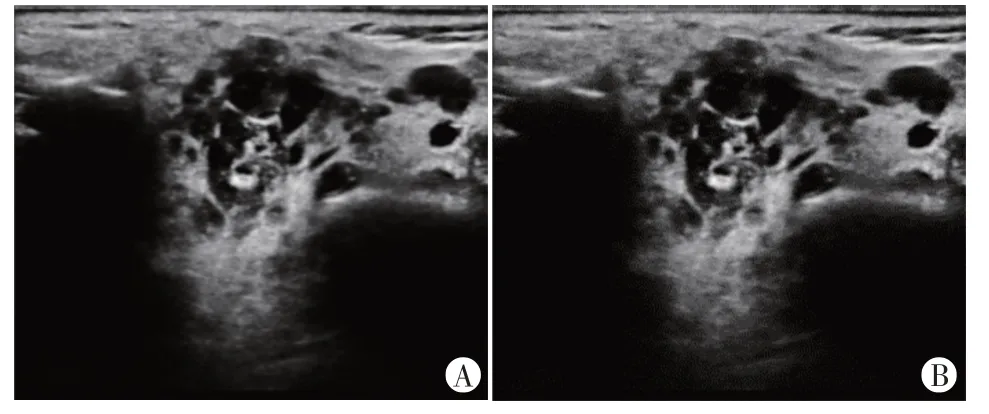

其中r为输入图像的灰度值,在经过归一化处理之后取值范围为[0,1];S为伽马变换之后的灰度输出值;c为灰度缩放系数,通常取1;γ为伽马因子,控制整个变换的缩放程度。本研究选择γ=0.5 对图像进行处理,处理后的图像较暗区域被拉伸得更亮,图像整体更亮、更清晰。见图2。本研究采用伽马变换和双边滤波算法对已有的数据图像进行处理,以更好地突出图像纹理特征,使在深度学习中CNN 能提取到更详细、准确的图像形态学特征。

图2 滤波前后超声图像

(2)特征提取与组合图像:将收集到的涎腺肿瘤超声原始图像由专业超声医师手动标记病灶区域,得到红圈标记病灶的图像,经过边界像素提取等一系列图像处理方法,得到病灶内部掩膜图和病灶边界轮廓图;将经过去噪后的原始图像与病灶内部掩膜图叠加,得到病灶内部特征区域图。见图3,4。

图3 特征提取准备图的生成

图4 特征提取准备图的生成步骤示意图

为使图像特征得到充分训练并提取,将3张准备图(病灶内部特征区域图、去噪后原始图像、病灶边界轮廓图)通过RGB三通道且合为1 张图,作为神经网络的训练样本。为强调病灶内部特征,同时不丢失病灶周围特征(后方回声等),设定不同准备图的通道和权重分别为:病灶内部特征区域图为R 通道,权重0.6;去噪后原始图像为G 通道,权重0.3;病灶边界轮廓图为B通道,权重0.1。见图5。

图5 RGB三通道特征组合图

(3)数据增强:CNN 的训练需要大量的数据支撑,而实际项目中往往难以找到充足的数据。本研究借助空间几何变换的数据增强方法,通过反转、随机裁剪、随机旋转等操作扩大训练集。本研究的增强倍数为2倍,将984张图像数据扩增到1968张,以增强模型的泛化能力,避免过拟合。

2.模型训练

CNN 具有很强的表征学习能力,可以通过卷积、池化、激活、全连接等方式提取图像的特征。相比于人工提取的涎腺肿瘤感兴趣区域的形态学特征,CNN 既可以反映图像的整体特征,也可以反映更加细节的部分特征。这些特征提取均依赖于CNN 中最重要的构成部分:卷积层。一般而言,浅层少量的卷积操作仅能获取图像的轮廓、线条等简单特征,而随着卷积次数的增加及卷积核大小的增加,可以捕获到更复杂的特征表示。

(1)VGG19 模型:VGG 网络使用3×3 的卷积核代替神经网络中较大的卷积核,可在具有相同感受野的情况下减少网络参数,从而提高训练效率。本研究首先冻结VGG19 的卷积层,并添加全局平均池化层,将原VGG19 输出的7×7×512 展平成1×1×512。对于全连接层,分别设置节点为512,128,4,2,同时在每一层全连接层后面添加批归一化层并使用ReLU 函数作为激活函数。对于全连接层输出的结果使用交叉熵损失函数计算损失。

(2)ResNet50 模型:ResNet50 模型通过建立前后层之间的短路连接,有助于训练过程中的反向传播,避免了梯度消失和梯度爆炸的问题。本研究通过迁移学习,冻结了ResNet50模型的卷积层,展平并归一化数据后,添加了线性层和池化层,对于全连接层输出的结果使用交叉熵损失函数计算损失。

(3)基于VGG19 模型改进的OwnNet 模型:本研究结果发现,VGG19模型对涎腺肿瘤良恶性分类的效果较ResNet50模型更好,因此本研究基于VGG19 模型的网络结构,自主构建了一个CNN,命名为OwnNet,其模型结构见图6。与VGG19 模型比较,OwnNet 模型的输入层由224×224×3 更改为256×256×3,增大了单张图片的数据量,从而避免特征丢失;卷积层同样采用3×3 的卷积核代替神经网络中较大的卷积核,能够在具有相同感受野的情况下减少网络参数,从而提高训练效率;卷积单元增加了批归一化函数,保证ReLU 激活函数的输入值不会过高或过低。在卷积层输出部分,与VGG19 模型比较,OwnNet 模型增加了注意力SE 模块,让模型更关注有利于良恶性分类的特征通道;同时增加了神经元个数,卷积层的输出神经元由1×1×4096 增加到1×1×16 384;还增加了全连接层的层数,设置全连接层节点分别为16 384,128,4,在全连接层后添加批归一化函数层和Sigmoid 激活函数层,最后得到分类结果,并使用交叉熵损失函数计算损失。由于本研究纳入的良恶性样本分布不均衡,在计算损失时赋予良恶性样本不同的权重(良性权重∶恶性权重=1∶3.43),使对恶性样本的错误惩罚度更大,从而降低恶性样本漏诊的风险。

图6 OwnNet模型结构示意图

3.结果分析

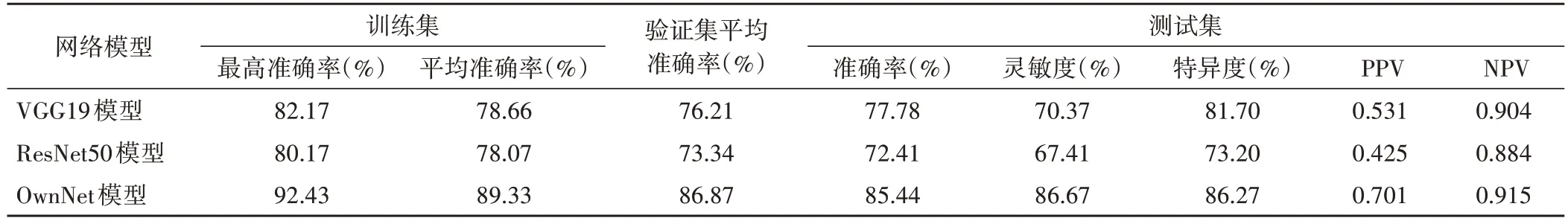

在网络训练中依据病理诊断结果对数据集添加标签。本研究共1968 张数据集样本,为保证模型在现实中的表现效果,划分训练集、验证集和测试集时要求其良恶性样本的比例一致且等于总体样本中良恶性样本的比例(1∶3.43),随机分为训练集(占比58%)、验证集(占比15%)和测试集(占比27%)3部分,其中训练集1150张,验证集296张,测试集522张。在训练过程中,综合考虑计算机性能,将Epoch 设置为500;模型采用Adam优化器,其初始学习率设定为0.001,权值衰减(weight_decay)设置为0.0001,防止出现过拟合情况;学习率衰减因子gamma 设置为0.98。将3种模型在相同数据集、相同平台上运行,通过计算在训练集的最高准确率、训练集和验证集20 个Epoches 的平均准确率,以及测试集的准确率、灵敏度、特异度、阳性预测值(PPV)、阴性预测值(NPV),总结模型的效能,结果见表2。

表2 不同网络模型的训练效能比较

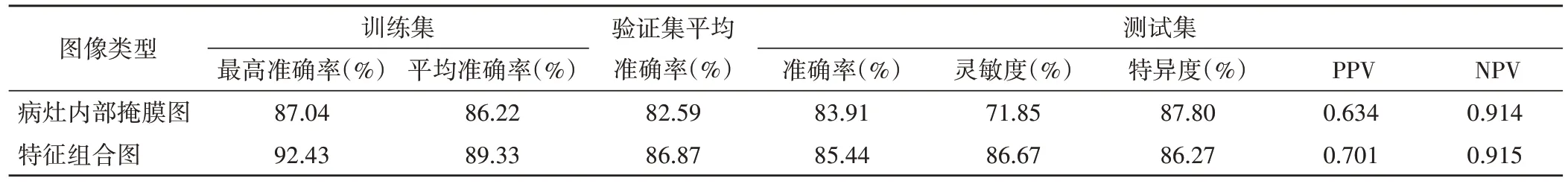

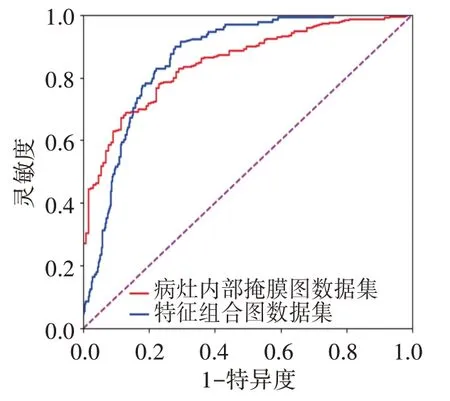

使用OwnNet 模型对病灶内部掩膜图数据集和特征组合图数据集训练,结果见表3。通过绘制受试者工作特征(receiver operating characteristic,ROC)曲线评估两种类型数据集在OwnNet 模型上的训练效能,病灶内部掩膜图和特征组合图数据集的曲线下面积(area under curve,AUC)分别为0.848 和0.863。见图7。

表3 两种类型数据集在OwnNet模型上的训练效能比较

图7 两种类型数据集在OwnNet模型上训练的ROC曲线图

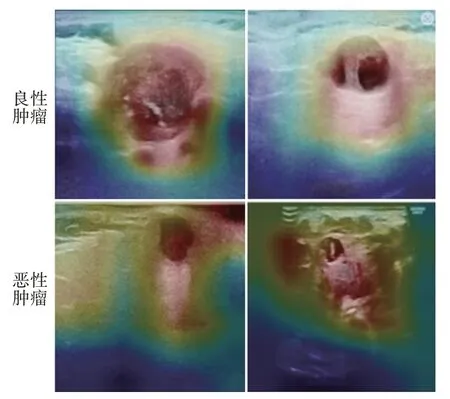

为增强模型的可解释性,获取最后一层卷积层,将其在注意力SE 模块中注意力权重最大的通道图使用双线性插值上采样到原始图像大小,生成热图以证明模型分类的可行性,见图8。将热图与原始图像合并得到在涎腺肿瘤超声图像中模型注意力的大致位置,见图9。结果发现模型对涎腺良恶性肿瘤均会关注病灶内部和部分回声结构,但对恶性病灶的关注范围相对更广,并重点注意病灶内部纹理特征。

图8 热图生成模型示意图

图9 涎腺良恶性肿瘤热图与原始图像合并得到在涎腺肿瘤超声图像中模型注意力的大致位置

三、讨论

本研究针对术前涎腺肿瘤超声图像,使用伽马变换和双边滤波算法对已有的数据图像进行处理,更好地突出图像纹理特征,然后将人工提取特征组合图作为训练样本,分别在VGG19 模型、ResNet50 模型和OwnNet 模型上进行特征提取和分类,并对网络参数进行了调整。结果显示,OwnNet 模型表现出的效果最佳,证明了CNN对涎腺肿瘤超声图像进行良恶性分类的可行性,引入注意力机制能够有效提高分类效果,从而提高人工智能诊疗效率。

在以上3 种网络模型中,ResNet50 模型在训练集的收敛速度最快,但其分类效果不够理想,平均准确率仅78.07%;在验证集的分类效果同样低于VGG19 模型和OwnNet 模型,平均准确率仅73.34%。VGG19 模型在训练集及验证集的准确率均较ResNet50 模型高,因此本研究基于VGG19 模型构建了OwnNet模型,结果提示其分类效果最好,在训练集的最高准确率达92.43%,在测试集的准确率、灵敏度、特异度、PPV、NPV 也较其他模型更高。分析OwnNet 模型分类效果更好的原因主要有:①扩大了模型输入单张图像的数据量,避免特征丢失;②采用3×3 卷积核,能够在具有相同感受野的情况下减少网络参数,提高了训练效率;③卷积单元增加了批归一化函数,保证ReLU 激活函数的输入值不会过高或过低,使参数能够有效更新,提高了模型的稳定性;④模型引入注意力SE 模块,突出对分类有用的通道特征;⑤增加了全连接层的长度和宽度,提高了模型的非线性表达能力和学习能力;⑥对良恶性样本赋予不同的损失权重,提高了模型对数量较少的恶性样本的学习能力。

本研究结果显示,与病灶内部掩膜图数据集比较,使用特征组合图数据集在OwnNet 模型上训练得到的准确率、灵敏度、PPV、NPV 均更高,而特异度较低,表明使用特征组合图数据集能够更好地学习恶性样本的特征。不同类型数据集对应的ROC 曲线分析反映了模型的泛化能力,使用特征组合图数据集得到的AUC较单纯病灶内部掩膜图数据集更高,提示前者模型性能更好。分析是由于特征组合图突出了涎腺肿瘤超声图像中病灶边界和内部特征,也保留了病灶外部特征,从而表现性能更佳。

研究[18]表明根据超声图像特征(包括肿块形状、边缘、后回声模式、钙化和局部淋巴结肿大)鉴别唾液腺肿瘤良恶性的准确率约67%~96%;多形性腺瘤是常见的良性上皮肿瘤,但恶性转化的可能性为5.0%~9.8%,由于大多恶性肿瘤早期缺乏特异性的临床症状和体征,术前难以确定肿瘤性质,穿刺活检时可能由于取材导致肿瘤转移;且该研究以组织病理学结果为因变量,临床和超声图像特征为自变量建立的逻辑回归模型鉴别涎腺肿瘤良恶性的AUC、灵敏度、特异度、准确率、PPV 及NPV 分别为0.893、84.30%、80.00%、83.10%、0.653、0.920。研究[19]使用传统的应变弹性成像和带有四模式评分系统的声辐射力脉冲成像检查了185 个涎腺肿瘤(包括163 个良性肿瘤和22 个恶性肿瘤),结果显示二者对其良恶性分类的灵敏度、特异度、准确率分别为54.50%、56.40%、56.20%和77.30%、63.80%、65.40%。以上研究均低于本研究模型在测试集的准确率、灵敏度、特异度(85.44%、86.67%、86.27%),表明该模型在涎腺肿瘤良恶性分类方面具有一定优势。

四、结论

本研究通过对3 种模型进行分类训练并测试,证实了CNN对涎腺肿瘤超声图像良恶性进行分类的可行性,结果表明VGG19模型效能优于ResNet50模型,OwnNet模型效能最佳,且由涎腺肿瘤超声图像的特征组合图训练得到的分类模型准确率更高,表明VGG深度学习网络结构更适合涎腺肿瘤超声图像的分类,可辅助临床医师诊断,使目标病灶的检出与鉴别更加直接、清晰且客观,提高诊断效率。但该模型对于整体样本的分类效果较其他方法并无明显优势。由于涎腺肿瘤超声图像数据的进一步积累较为困难,在一定程度上限制了机器学习训练的效果。推测扩大涎腺肿瘤超声图像数据集后,其分类效果还有较大进步空间;同时还需进一步优化网络结构,提高模型的训练效率和泛化能力。同时,本研究为单中心、回顾性研究,缺乏前瞻性外部验证,后期仍需进一步完善。