基于改进EDRL 的含V2G 孤岛微电网频率综合控制策略

2023-10-31范培潇温裕鑫李勇汇周桂国

范培潇,杨 军,柯 松,温裕鑫,李勇汇,周桂国

(1.交直流智能配电网湖北省工程中心,湖北省武汉市 430072;2.武汉大学电气与自动化学院,湖北省武汉市 430072;3.武汉汉测电气有限公司,湖北省武汉市 430070)

0 引言

随着社会经济的发展,能源日益紧张,“碳达峰”与“碳中和”的国家能源战略被提出[1]。以风电、光伏为主的新能源机组容量及比例逐年升高,而能够孤岛自治运行的微电网是实现分布式电源即插即用的重要手段[2-3]。然而,孤岛微电网的容量有限,其稳定性问题值得深入研究。

基于此,比例-积分-微分(PID)、模糊控制等经典控制方法[4-5]被应用到孤岛微电网频率控制中。文献[6]基于二维正弦逻辑图的混沌正余弦算法,对经典PID 控制器进行优化并将其应用于孤岛微电网。文献[7]将模糊系统用于为系统提供自适应惯性控制,实现了系统的频率稳定。然而,经典方法依赖于系数与权值的优化,以及隶属函数的建立,难以在控制模型中设置系统中的各种约束,对微电网中复杂扰动的适应性不足。此外,上述控制模型均没有考虑微型燃气轮机(micro-gas turbine,MT)机组之间的出力协调,无法节省MT 机组的出力成本。

同时,为解决电动汽车(electric vehicle,EV)接入微电网所引起的强随机性问题,文献[8-9]提出了基于电动汽车与电网互动(vehicle-to-grid,V2G)的孤岛微电网调频策略,引起了广泛的关注。文献[10]将模型预测控制和自适应下垂控制两种技术组合并应用于解决孤岛微电网的频率调节问题。文献[11]针对局部和初级控制水平(下垂控制),开发了基于李雅普诺夫理论和反推的非线性控制律,对EV 充电站控制过程进行改进并将其应用于提供辅助服务,例如频率支持和惯性支撑。文献[12]提出改进的鲁棒模型预测控制器,将EV 用户的随机行为视为动态限制,并将整个控制过程转化为线性矩阵不等式,实现了微电网系统的频率控制。实际上,V2G 过程会对用户的充电需求造成影响。而上述研究忽略了这一影响,且所采用的控制方法均不具备进化特性,无法在保证微电网调频需求的同时,尽可能降低这一负面影响。

具备在线学习与经验回放能力的深度强化学习(deep reinforcement learning,DRL)在微电网稳定控制问题中得以应用[13-14]。目前,DRL 的相关研究主要集中在控制目标单一的工程任务上,例如频率稳定性。文献[15]与文献[16]应用深度Q 学习(deep Q learning,DQN)和深度确定性策略梯度(deep deterministic policy gradient,DDPG)来设计微电网频率控制器。但是DQN 的动作空间是不连续的,会存在动作空间维数爆炸的问题。而文献[17]提出了一种基于人工情绪强化学习的控制策略,用于微电网的孤岛转换,以提高电压和频率稳定性,并有效缩短频率恢复时间。文献[18]基于改进的多智能体DDPG 提出了包含EV 的微电网频率控制策略,可以在提高微电网稳定性的同时,有效降低计算复杂度。上述研究仅考虑了频率控制这个单一控制目标,无法在保证微电网系统调频要求的同时有效减少调频成本和EV 的不必要放电。同时,上述控制策略所应用的传统DRL 算法,在面对具有欺骗奖励和稀疏奖励的多目标控制任务时,训练过程容易陷入局部最优解,收敛速度极慢,并且很难获得最优策略。现有研究在控制模型设计和算法设计上还有很大的改进空间。

为此,本文提出了基于改进进化-深度强化学习(evolutionary-deep reinforcement learning,EDRL)的含V2G 孤岛微电网频率综合控制策略。在V2G 模型设计上,在建立EV 充电站充/放电模型时考虑了V2G 过程对EV 用户充电需求的影响,能够在保证调频效果的情况下,减少V2G 过程中EV 的不必要放电。在孤岛微电网控制模型设计上,考虑了MT机组出力分配对调控成本的影响,能够实现各MT机组之间的出力协同,在保证调频效果的情况下,降低MT 机组的总成本。在算法与控制策略的设计上,将进化算法和深度强化学习算法相结合,并引入新颖搜索加以改进,能够有效协助训练过程跳出局部最优解,逼近最优策略,从而应对微电网频率综合控制这种具有欺骗性奖励、稀疏奖励的多目标工程任务。通过MATLAB/Simulink 仿真,对包含3 台发电机组和2 个EV 充电站的孤岛微电网系统进行了仿真测试,证明了所提控制策略的综合控制效果。

1 孤岛微电网频率综合控制模型

1.1 微电网调频机组概述

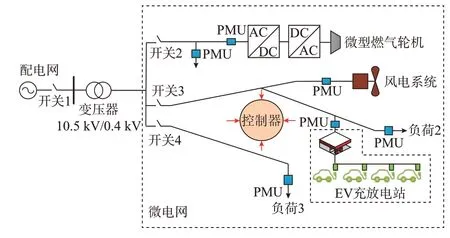

本文中,孤岛微电网以MT 作为主调频机组[19],EV 充电站作为辅助调频机组,共同实现微电网的频率控制,其具体结构如图1 所示。图中:PMU 表示同步相量测量单元。

图1 微电网结构Fig.1 Structure of microgrid

1.2 考虑EV 用户充电需求的充/放电功率模型

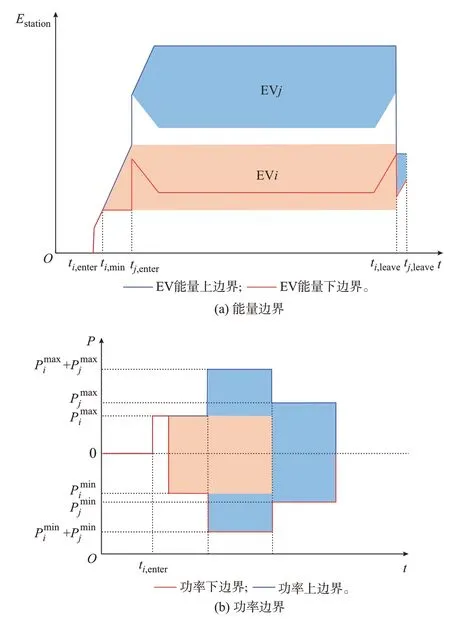

EV 作为用户的出行工具,其向微电网放电的过程在一定程度上影响了用户的充电需求[20]。充电站内某单体EV 的实时能量与充放电功率的边界与实时状态如附录A 图A1 和图A2 所示。由此,可得到单体EV 的输出功率边界,如式(A1)和式(A2)所示。并可据此得到单体EV 的能量边界,如式(A3)和式(A4)所示。进而,基于单体EV 的能量与功率边界,将充电站内EV 的实时状态与入站时间相结合,即可得到充电站的整体调控裕度,如式(A5)和式(A6)所示。

综上,以单体EVi与EVj组成的集群为例。其中,EVi进站时处于E0<Emin的状态(E0为电动汽车进入充电站时的初始能量,Emin为维护电动汽车电池寿命的能量下限),EVj进站时处于E0>Emin的状态。由此可得到参与微电网调频的EV 集群的能量和功率边界,如图2 所示。

图2 EV 参与微电网调频的能量与功率边界Fig.2 Energy and power boundaries of EVs participating in microgrid frequency regulation

图2(a)中,Estation为 电 动 汽 车 充 电 站 的 能 量,ti,enter时刻EVi进入充电 站,ti,min时 刻EVi结 束强制充电,并于ti,leave时刻离开,橙色面积块所代表的是EVi为充电站所提供的能量裕度,而EVj同理,由此可得到蓝线与红线所代表的充电站整体能量上下限。图2(b)中,分别为EVi的充、放电限度,橙色所代表的是EVi为充电站所提供的输出功率裕度,而EVj同理,由此可得到充电站整体输出功率边界。

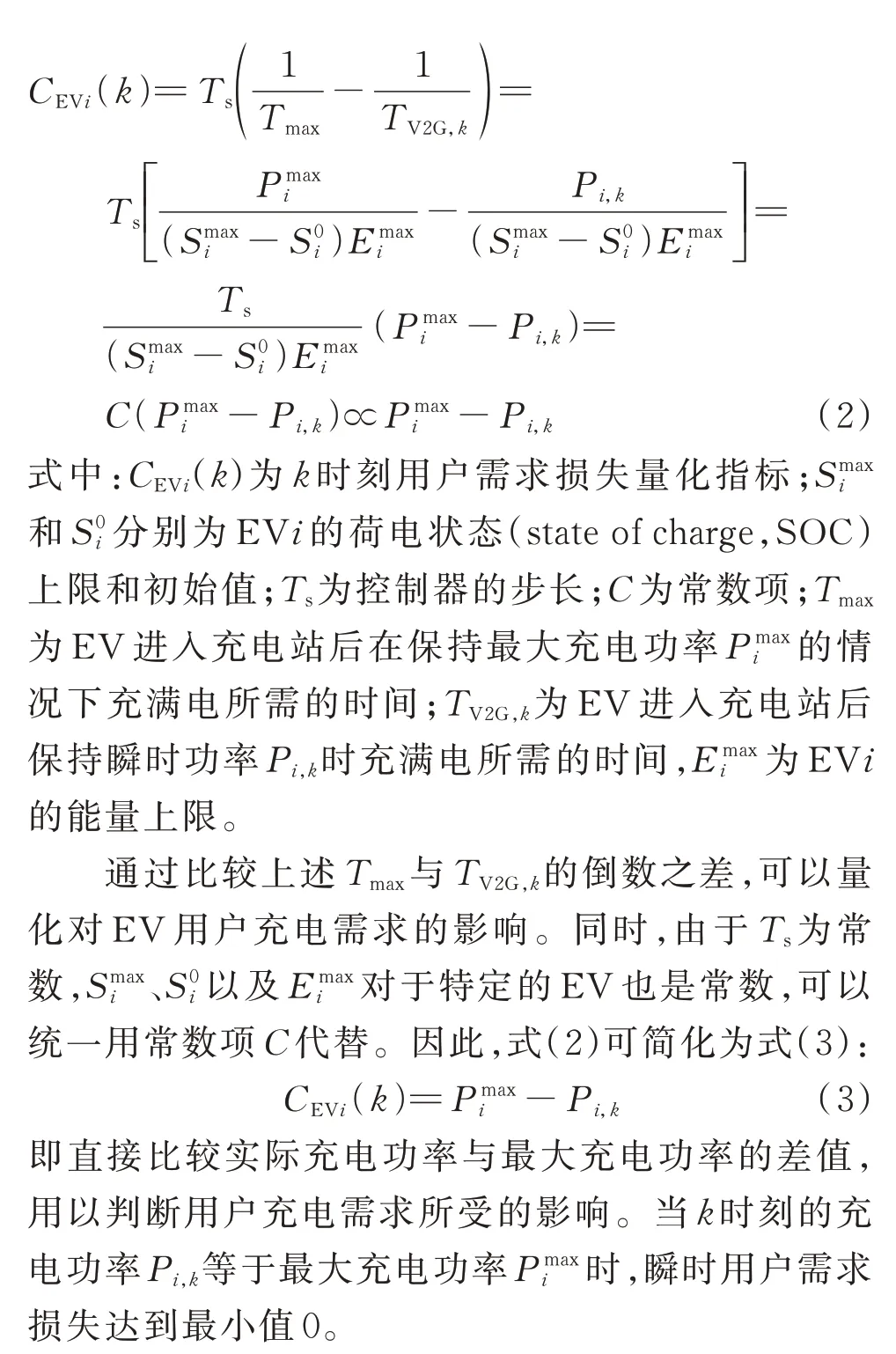

基于此,当频率发生波动后,EV 充电站内的EV 参与调频时也会发生充电功率变化,难以避免会对充电过程造成影响,如图3 所示。

图3 参与V2G 调频的EV 充电站用户需求成本Fig.3 User demand cost when EV charging stations participate in V2G frequency regulation

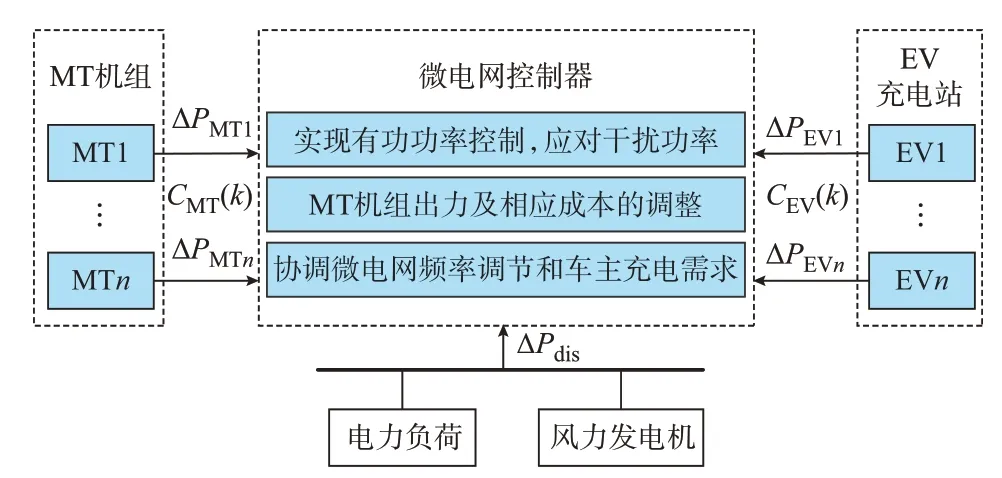

图4 微电网调频需求-调节成本-用户需求综合控制模型架构Fig.4 Architecture of comprehensive control model for microgrid frequency regulation demand, regulation cost and user demand

未参与电网调频的EV 在t0时刻进入充电站后开始充电,在tmin时刻达到所需能量Emin,然后保持充电状态直至在tmax1时刻达到能量上限Emax。而考虑V2G 过程时,EV 从t0开始进入充电站,也被强制充电到tmin,但其电池能量在t1时刻达到E1(大于Emin),并开始参与微电网调频且放电,直到tmax2时刻达到期望的上限Emax。因此,存在满足以下公式的时间差:

该时间差的长短能够在一定程度上代表EV 充电过程所受到的影响程度:

1)时间差越长,说明电池充放电状态切换过程越为复杂,对电池寿命影响越大;

2)虽然放电过程不会使能量低于Emin,但是会延缓电量达到Emax的时间,在一定程度上对车主的充电需求造成了影响。

在控制过程中,控制器的步长往往很短,式(1)中的时间差ΔTV2G显然不能单独作为量化指标,直接作为判断对用户需求影响程度的因素。因此,为了量化这种影响,本文设计了车主需求损失指标:

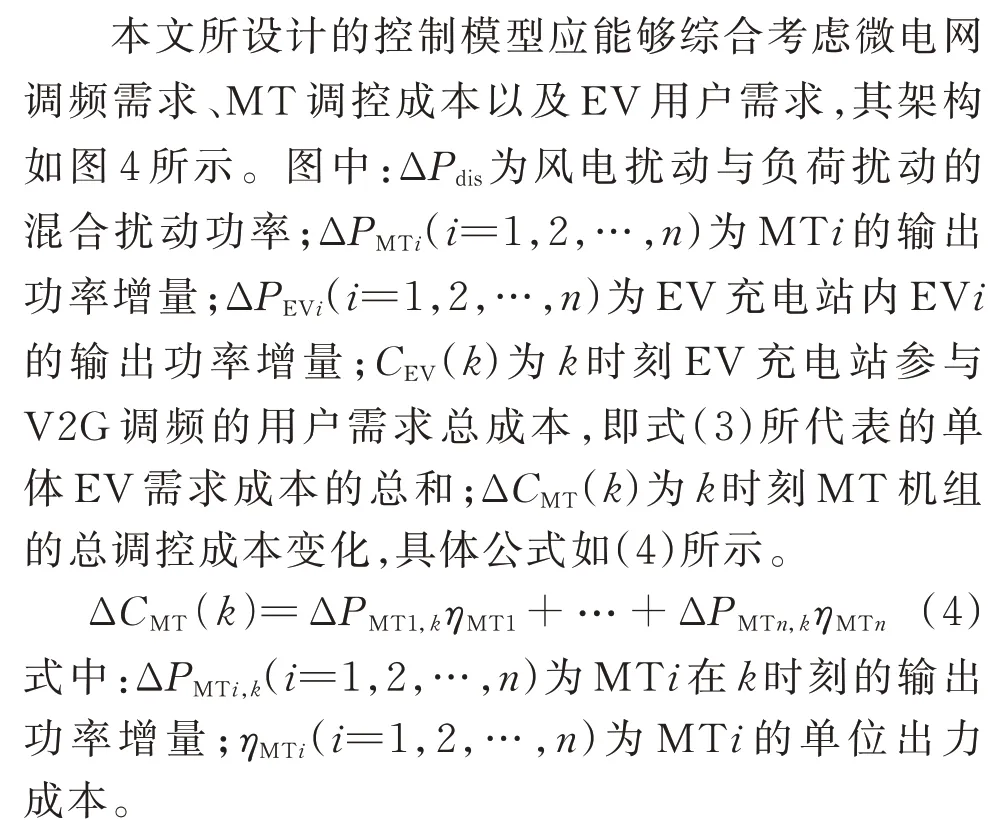

1.3 考虑微电网调频需求-调控成本-用户需求的综合控制模型

2 结合进化算法的深度强化学习

2.1 深度强化学习算法与进化算法概述

深 度 强 化 学 习 中,DDPG 算 法[21-22]是Actor-Critic 框架与DQN 算法的融合,具有经验回放能力,能够打破数据之间的关联性,降低模型的训练难度,原理如附录B 图B1 所示。而进化算法中的遗传算法是一种借鉴了进化生物学中遗传、突变、自然选择以及杂交等现象而发展出的算法[23-24]。

2.2 进化算法经验引导的深度强化学习

综合频率控制需要同时考虑频率控制效果、MT 机组出力成本以及车主充电需求。因此,由多个控制指标组成的综合控制会给传统控制带来极高的建模难度;同时,对于传统深度强化学习而言,综合控制过程具有欺骗性奖励,智能体可能会盲目提升其中1 项或2 项指标所对应的奖励值,或专注于提升某项小(欺骗性)奖励,而忽视部分指标甚至主要的控制指标,从而陷入局部最优,无法给出使整体奖励值最大的最优控制指令。

为了有效应对具有稀疏奖励与欺骗性奖励的工程任务,EDRL 在本质上就是把传统DRL 中策略网络的参数作为进化算法内所需进行优化处理的个体,并基于所对应的适应度函数进行直接的策略搜索。而EDRL 中的两种算法是通过经验池与梯度完成关联的,且DRL 向进化算法反馈的信息正是梯度值,且由于梯度的作用,DRL 与进化算法将会交替或并行运行。综上所述,进化算法经验引导的深度强化学习的基本框架如附录B 图B2 所示。算法将在智能体获取到第1 组环境状态s1时开启循环训练过程,其经验池由此不断积累,并在训练回合数达到上限或智能体达到收敛条件时结束循环。研究者可以在程序中设置智能体自动判定收敛的条件,即:当智能体在n个连续回合中获得的平均累积奖励大于某值x时,停止训练。n与x的取值取决于智能体所具体应用的场景,以本文场景为例,n为10,x为-5。

2.3 基于新颖搜索的算法改进

当控制器应用于多目标控制任务时,其运行环境与输出动作极其复杂,即对算法的探索能力有很高的要求。因此,本文基于新颖搜索[25],改进了所提出的算法,通过计算当前策略相对于先前生成的策略的新颖性,鼓励向着具有高新颖性的方向进行策略更新。因此,在整个训练过程中,需要先设置一个新颖性阈值,一旦被评估个体的新颖性大于这个值,就会被加入档案中。新颖性指数的计算方法如下:

式中:N(θ,F)为策略πθ的新颖性指数;b(πθ)为策略πθ的动作特征;F为存档集;B为存档集中策略πθ的k个邻居的集合,其定义如式(6)所示。

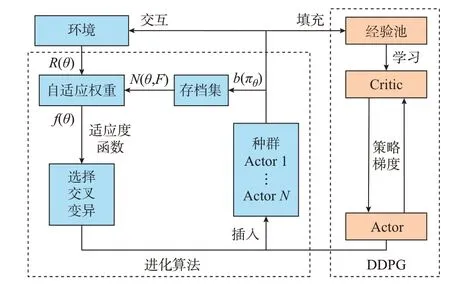

综上所述,将新颖搜索与EDRL 算法相结合,形成了改进的EDRL 算法,其算法结构如图5 所示。且新的适应度函数可以看作是奖励和新颖性指标的加权和,其数学表达式如式(7)所示:

图5 基于新颖搜索的改进EDRL 原理图Fig.5 Schematic diagram for improved EDRL based on novelty search

式中:w为权重;R(θ)为智能体在输出策略πθ时所获得的奖励值,是一个理论瞬时值。

值得注意的是,在面对具有欺骗性的奖励时,DDPG 算法本身是极难探索到“最优策略”的,这本身就是传统深度强化学习的缺陷之一,在与进化学习结合之前,仅仅通过其他增加探索的方法无法从根本上突破传统深度强化学习的收敛性能。

3 微电网频率综合控制器的结构设计

3.1 基于EDRL 的微电网综合频率控制框架

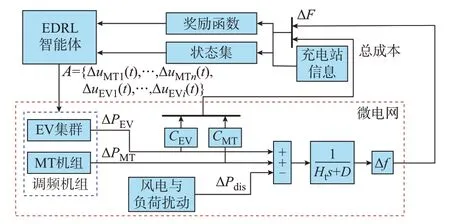

具体的训练与在线控制框架如图6 所示。图中:ΔPEV为电动汽车集群的功率增量;ΔPMT为微型燃气轮机组的功率增量;Ht与D为微电网的惯性常量;Δf为频率偏差。同时,微电网系统中的实时频率偏差集ΔF,实时机组出力所对应的MT 机组调控成本与EV 用户充电需求成本CMT、CEV,以及EV 充电站实时状态,将作为状态集在训练过程中输入智能体中。由此,EDRL 中的智能体可根据实时状态集输出动作集,以对微电网调频机组的出力进行协调控制,在完成大量试错训练后,控制奖励可达到最大化,从而实现微电网的调频需求、MT 机组的出力成本以及EV 用户的充电需求的协调控制。

图6 基于EDRL 的微电网综合频率控制框架Fig.6 Framework of EDRL-based integrated frequency control for microgrid

3.2 状态、动作空间的选取

3.3 多目标综合奖励函数的设计

综上,考虑中国较为保守的电力安全工作规程原则,即电力系统在正常运行状态下的频率应当在(50±0.2)Hz 的范围之内,并依据实际情况考虑一定的频率调节死区[26],进而加入调控过程MT 机组出力成本与EV 用户充电需求成本项。由此可设计出本文智能体的奖励函数:

4 算例分析

4.1 参数选取与架构设计

本文仿真在MATLAB/Simulink (2021a)平台上开展。微电网系统中包含3 台发电机组(MT1、MT2、MT3)和2 个EV 充电站(EV1、EV2),相应的设备参数的具体设置可见附录C 表C1;同时,本文算法的参数设置可见表C2 与表C3。

4.2 本文算法与传统控制器的频率控制性能对比

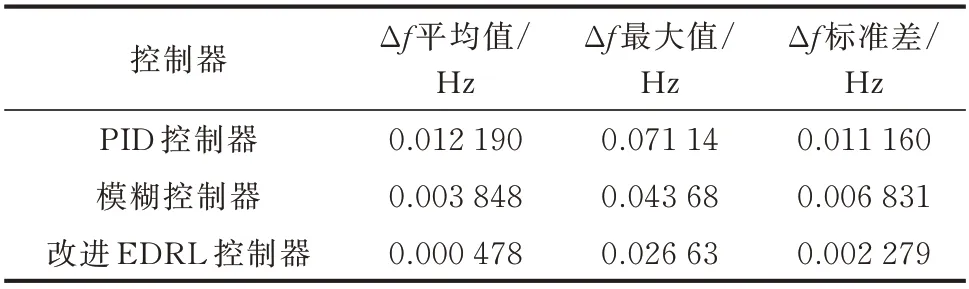

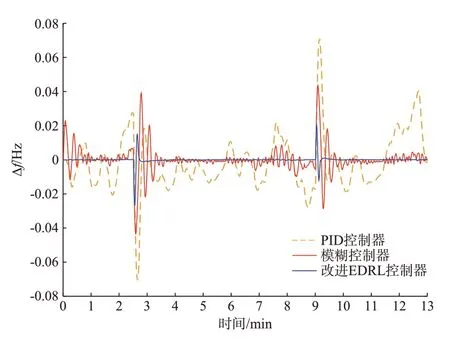

为了更好地体现所提控制器的优越性,本文引入传统算法中具有代表性的PID 控制与模糊控制作为对比,由此分析各控制器的频率控制性能,其参数见附录C 表C4。同时,由于传统控制器无法综合考虑微电网调频需求-调控成本-用户需求,在本节中改进EDRL 控制器的系统参数为a=1、b=0、c=0,即不考虑调控成本与用户充电需求。由此,可得到在附录D 图D1 扰动下的频率波动,如图7 与表1所示。

表1 场景1 下各控制器调控下的频率波动数据分析Table 1 Data analysis of frequency fluctuation under control of each controller in case 1

图7 场景1 下各控制器调控下的频率波动曲线Fig.7 Frequency fluctuation curves under control of each controller in case 1

如图7 与表1 所示,在改进EDRL 控制器管控下的微电网频率波动(图7 中蓝线)幅度较小,受到风电扰动与负载扰动时的频率偏差可以控制在±0.03 Hz 的范围内,标准差与平均值也均远优于传统控制。在传统PID、模糊控制下,频率偏差最大达到了0.071 14 Hz 与0.043 68 Hz,特别是传统PID 控制,频率波动的平均值与标准差达到了0.012 19 Hz与0.011 16 Hz。这表明所提出的改进EDRL 控制器具有最佳的频率控制性能。

1.5 统计学分析 所有数据采用SPSS 19.0统计软件进行分析,计量资料采用表示,两组比较采用t检验,相关性分析采用直线相关性分析法,P<0.05差异有统计学意义。

4.3 本文算法与传统深度强化学习控制器的对比

如附录C 表C2 参数所示,为了考虑微电网调频需求-调控成本-用户需求,将奖励函数中的参数选取为a=1、b=-0.005、c=-0.005,并基于此将改进前后的EDRL 和DDPG 算法进行比较,其训练过程的奖励收敛曲线如图8 所示。在本文智能体训练期间,训练集包含随机生成的分布式电源与负荷扰动、基于数据分布生成的EV 充电站状态等数据,而在收敛后,智能体即可获得自适应能力,并能够被投入到实际应用中。

图8 训练过程的奖励收敛曲线Fig.8 Reward convergence curves of training process

如图8 所示,在整个训练过程中,从具体的收敛性能角度分析:对于DDPG 算法而言,在训练100 回合后明显陷入局部最优解,其奖励值始终维持在较低水平,即综合考虑微电网调频需求-调控成本-用户需求时,在有限的时间内无法探索到“最优策略”,因而控制性能较低,相关分析在4.4 节中讨论;而对于未改进EDRL 而言,其在有限的时间内也难以搜索得到“最优策略”,因为在大量的研究记录中,在经过500 回合(大约18 h)以上的训练后,其奖励值基本稳定在[-20,-10]范围之间,远远优于改进后EDRL 的[-5,0]之间;实际上,改进EDRL 依靠新颖搜索具有更好的收敛特性,只需要经过100 回合,奖励值即可达到-10 以上,并基本能够在500 回合内收敛,奖励值也能稳定在-5 之内。这表明:DDPG 算法是不满足控制效果需求的,同时受限于工程硬件性能与时间需求,未改进EDRL 的收敛特性同样不满足工程需求。值得注意的是,本文设置了最大循环回合数以及智能体收敛条件,由于训练过程中存在大量随机数据,智能体难以保证能够在多个回合内始终维持在超高水平策略,其在达到最大回合数后停止训练。由此训练完成的改进EDRL控制器同样具有最好的收敛性能,能够适应复杂的多目标控制任务,具有较好的控制性能。

4.4 考虑微电网调频需求-调控成本-用户需求的综合控制效果

综合前文分析,本文所提算法能够通过调整奖励函数中的加权系数来对微电网调频需求-调控成本-用户需求进行协调。由此,本节在加权系数取a=1、b=0、c=0 和a=1、b=-0.005、c=-0.005 时进行具体的仿真分析。

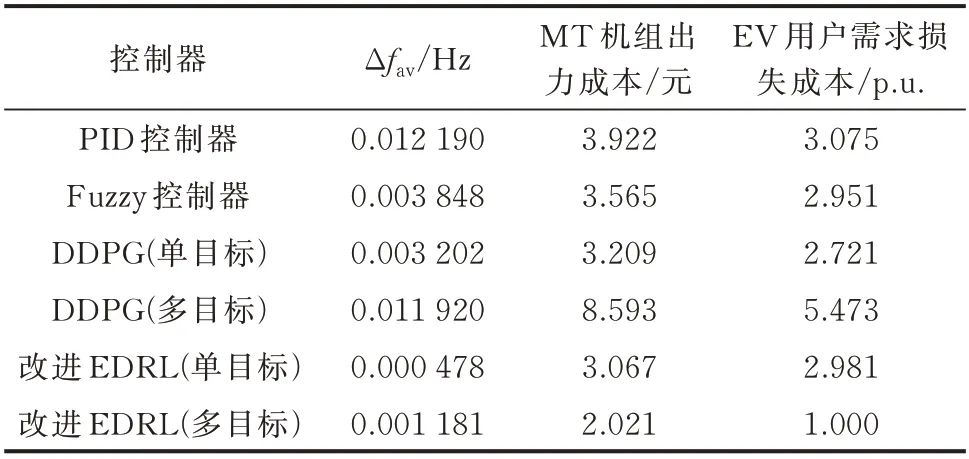

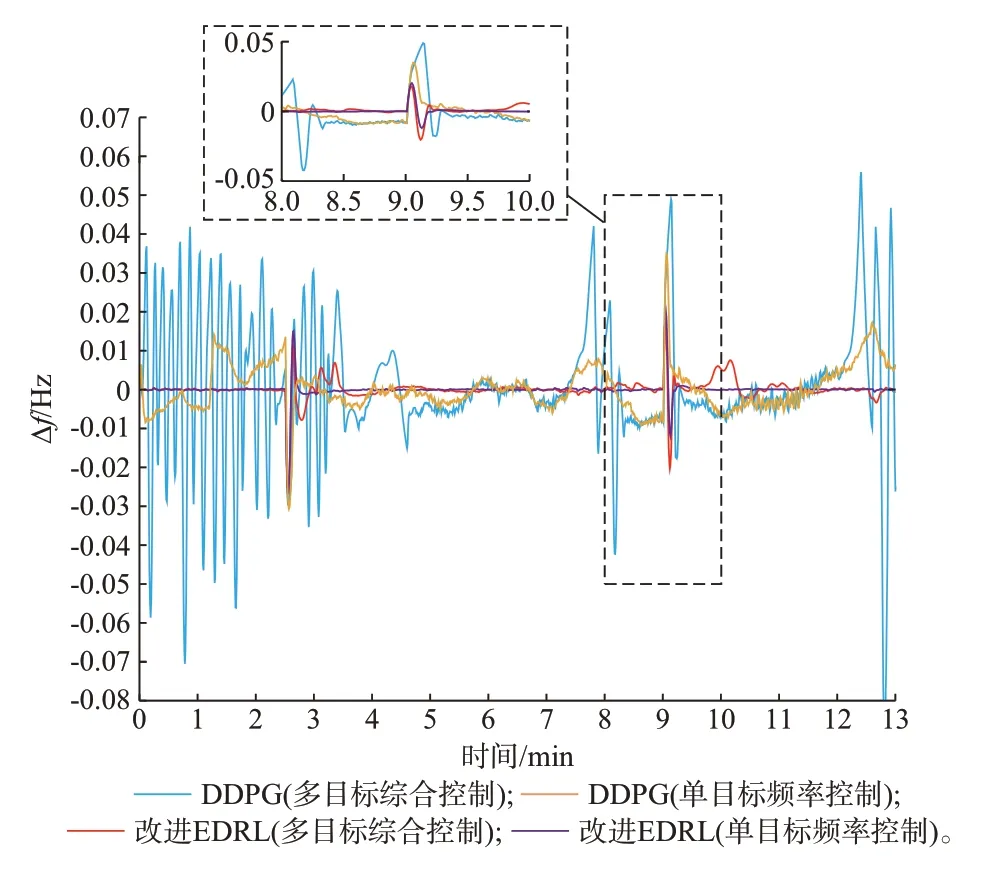

图9 比较了本文所提算法在单目标控制(a=1、b=0、c=0)和 多 目 标 控 制(a=1、b=-0.005、c=-0.005)时的频率稳定性,并将4.3 节中所提及的DDPG 控制器作为对照组。本文所提方法与其他方法在频率控制、MT 机组出力成本与EV 用户需求损失成本的对比结果如表2 所示,其中,EV 用户需求损失成本已进行标幺化处理。

表2 考虑多目标协同时的仿真结果Table 2 Simulation results considering multi-objective cooperation

图9 场景2 下各控制器调控下的频率波动Fig.9 Frequency fluctuation under control of each controller in case 2

由图9 和表2 可见,PID 控制器管控下的频率偏差平均值Δfav达到0.012 19 Hz,且其相对应的MT机组出力成本与用户需求成本均处于较高值,而Fuzzy 控制器的频率控制效果虽明显优于PID 控制器,但其在节约MT 机组出力成本与用户需求损失成本方面也并没有良好的表现,分别达到了3.565 元与2.951 p.u.。DDPG 控制器具有在线学习能力,在面对单目标控制任务时能够保证系统频率偏差在较低水平,频率偏差平均值仅为0.003 202 Hz;而多目标控制模式下的DDPG 控制器如4.3 节所示,无法正常收敛,不仅无法协调MT机组出力成本与用户需求成本,其频率控制效果也大打折扣,频率偏差平均值达到了0.011 92 Hz。本文所提出的改进EDRL 控制器能够分别在单目标控制与多目标控制模式下运行:当改进EDRL 控制器仅具有单一目标时,其频率偏差平均值可降低至0.000 478 Hz,而在综合考虑微电网调频需求-调控成本-用户需求时,改进EDRL 控制器能够在保证频率偏差平均值为0.001 181 Hz的同时,将MT 出力成本降至2.021 元,且用户需求成本维持于最低水平。即本文所提控制器无论在频率单一控制或多目标综合控制方面,均要优于对照组控制器。

值得注意的是,表2 中的MT 机组出力成本都是几元,在数值上很小,这是由于本文的研究对象是一个孤岛微电网,其容量很小,且成本计算时长为一个短暂的控制过程(仅几分钟),而在实际投入到体量更大、结构更为复杂的应用场景,并考虑长期效益(年成本)时,其节约效果将会显著提高(所节约的费用可达到万元级甚至更高)。此外,由于本文研究的核心内容为微电网的频率稳定性,表2 中的“单目标控制”特指“频率稳定性”这单一控制目标。

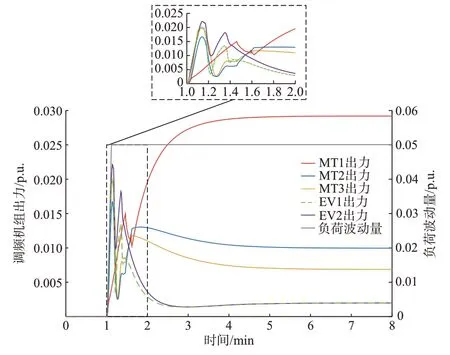

为了更直观地体现所提算法协调微电网调频需求-调控成本-用户需求的具体过程,在发生负荷阶跃的场景下,分析调频机组的输出功率变化量,如图10 所示。图中:左侧纵轴代表的是调频机组的出力,而右侧纵轴代表的是负荷波动情况。

图10 微电网各调频机组的出力情况Fig.10 Output of each frequency regulation unit in microgrid

由图10 可见,本文所提改进EDRL 控制器所管控的调频机组的出力调节过程可以被划分为几个不同的阶段:

2)随后,随着功率偏差逐渐被补偿,奖励函数式(14)中的第2 项与第3 项(MT 机组出力成本与用户需求成本)的作用开始呈现:单位出力成本较高的MT2、MT3 逐步减少功率输出,从而提高调频经济性;同时,EV 充电站降低输出功率至0 附近,从而减少对用户需求造成不必要的损失。

3)最后,单位出力成本最低的MT1 在此阶段内持续稳定提升输出功率,并稳定于较高水平,以持续补偿负荷扰动与高成本机组、EV 逐步退出主力调控所引起的功率缺额。

此外,附录D 图D2 展示了在考虑用户需求指标后,EV 充电站中单体EV 充放电过程所发生的改变。图中典型类EVa、EVb、EVc 所代表的是EV 充电站中特定的单体EV。可见,图中EVa 所代表的典型类型车辆在扰动发生后(t=1 min)处于强制充电状态,直到t=5.417 min 时EV 电量达到Emin,不考虑用户需求指标的EV 进入停滞状态,而考虑用户需求指标的EV 具有更高的充电速率;而EVb 与EVc 所代表的典型类型车辆在扰动发生时已经具有足够的电量,能够直接参与频率调节。其中,EVb在t=1 min 时由充电状态切换为放电状态,而考虑用户需求指标的放电速率明显更慢;同理,对于直接参与放电的EVc,考虑用户需求指标的EV 放电速率更慢,且更早进入稳定状态。

5 结语

本文提出了基于改进EDRL 的含EV 微电网频率综合控制策略,得到如下结论:

1)与传统控制器与控制模型相比,所提出的改进EDRL 控制器在仅考虑频率稳定性单一目标时,频率偏差平均值可降低至0.000 478 Hz,明显优于传统控制器;

2)与传统深度强化学习控制器相比,所提出的改进EDRL 控制器能够协调微电网调频需求-调控成本-用户需求,能够在保证频率偏差平均值仅为0.001 181 Hz 的情况下,将MT 机组出力成本降低48%,且用户需求成本维持于最低水平;

3)在收敛性能方面,本文将进化算法和深度强化学习算法相结合,并引入新颖搜索加以改进,能够有效协助训练过程跳出局部最优解,逼近最优策略,从而很好地应对微电网频率综合控制这种具有欺骗性奖励、稀疏奖励的多目标工程任务。

本文的研究对象是孤岛单一微电网,而对于结构更为复杂、体量更大的多微电网,则应分析信息传输的通信问题,后续可在此方向上进行深入研究。

附录见本刊网络版(http://www.aeps-info.com/aeps/ch/index.aspx),扫英文摘要后二维码可以阅读网络全文。