基于残差网络的结直肠内窥镜图像超分辨率重建方法

2023-10-07郑跃坤葛明锋常智敏董文飞

郑跃坤,葛明锋,常智敏,董文飞

(1.中国科学技术大学 生物医学工程学院(苏州)生命科学与医学部, 安徽 合肥 230026;2.中国科学院 苏州生物医学工程技术研究所, 江苏 苏州 215163)

1 引 言

结直肠癌是全球癌症发病率和死亡率排名居前的重大疾病之一,根据2020 年全球癌症统计报告,全球结直肠癌总体发病率达到9.7%左右,在各类恶性肿瘤的发病率中高居第三位[1]。大部分结直肠癌由结直肠腺瘤性息肉发展而来,因此,及早发现,并及时切除结直肠息肉特别是腺瘤性息肉,对预防和根治结直肠癌具有非常重要的临床意义。

目前,对结直肠息肉及恶性肿瘤的筛查主要借助于软性内窥镜技术。对于内窥镜图像,小病变的细节直接影响到临床专家对疾病的诊断,而软性内窥镜由于受硬件及特定环境下成像技术的限制,采集到的图像通常存在分辨率较低的问题。深度学习作为近年来兴起的一种“数据驱动”技术,在不同领域的应用越来越广泛[2-4],利用超分辨率重建技术(Super Resolution, SR),通过卷积神经网络将低分辨率(Low Resolution, LR)图像重建为高分辨率(High Resolution, HR)的图像,为提高图像分辨率提供了一种可行的替代方法。超分辨率重建在内窥镜图像处理上的应用吸引了不少科研人员进行研究。Gu[5]等人提出了一种结合了 Transformer 和 CNN (Convolutional Neural Networks)模型的内窥镜图像超分辨率重建算法,在对血管纹理的重建上取得了良好的效果。Yang[6]等人认为导致内窥镜图像质量下降的主要原因有运动模糊以及成像分辨率低两个原因,据此提出一种基于卷积神经网络的端到端的图像盲去模糊和超分辨率重建算法,在超分辨率任务上,采用基于Dense-Net、Res2Net 和分割通道的方法来提高网络性能。Turan[7]提出一种基于注意力的条件生成对抗网络,用于胶囊内镜图像的超分辨率处理。Tas[8]等人使用 SRCNN(Super Resolution Convolutional Neural Networks)[9]图像超分辨率模型作为预处理方法来提高结直肠镜图像的分辨率,其研究结果表明,与低分辨率的案例相比,在训练之前通过 SRCNN 进行超分辨率重建预处理后,再使用SSD(Single Shot MultiBox Detector)和Faster RCNN 对息肉目标进行检测都取得了更好的结果。因此,研究内窥镜图像的超分辨率重建,不仅能改善视觉效果,便于临床专家更好地观察病灶,而且作为图像的预处理步骤能够提升对病灶进行目标检测的准确率,更加精确地识别和定位病灶的精确位置,对临床医学的辅助诊断和治疗具有重要的价值。

超分辨率重建算法主要有基于重构[10]、插值[11-12]、学习[13-16]这3 种方法。基于学习的方法是目前最流行的方法,其中,基于神经网络的方法在现阶段表现出最为优越的性能。神经网络常用的方法有卷积神经网络(Convolutional Neural Network, CNN)、循环神经网络(Recurrent Neural Network, RNN)以及生成对抗网络(Generative Adversarial Network, GAN)。SRCNN 开创性地使用卷积神经网络作为SR 问题的解决方案,但由于SRCNN 具有三层结构和较小的感受野,其准确性受到限制,因此,一些研究人员建议在网络中加入更多的层数或使用深层递归结构,以提高图像超分辨率重建的效果。EDSR(Enhanced Deep Super-Resolution Network)[17]和VDSR(Very Deep Super Resolution Network)[18]等算法通过构建深层的网络结构,利用残差学习的思想学习低分辨率图像和原始高分辨率图像之间的特征关系,但未充分学习图像的特征。RCAN( Residual Channel Attention Networks)[19]使用通道注意机制对同一层中的特征通道进行不同的处理,使网络能够自适应地关注信息更为丰富的通道,从中学习并得到包含更多细节特征的高分辨率图像。SRGAN(Super Resolution Generative Adversarial Networks)[20]通过生成对抗网络来训练SRResNet,并使用VGG(Visual Geometry Group)[21]网络的高层特征映射定义了新的感知损失函数,重建图像更加自然,有更好的视觉效果,但放大后的细节通常伴随伪影,因此不太适用于医学应用。目前图像超分辨率网络在医学图像中的应用主要有以下两点需要解决:(1)重建图像必须具备真实性,严重色偏或图像结构出现失真的图像,会严重影响医生对病变的诊断;(2)重建图像的纹理细节也十分重要,特别是在小目标方面,目前大多数基于卷积神经网络的SR 方法重建后的图像纹理细节往往过于平滑,而在医用内窥镜的图像处理方面,往往要求突出更为丰富的血管或组织等小目标的特征细节。

针对上述问题,本文设计了一种基于残差注意力结构的超分辨率重建算法SMRAN,主要思路是通过不同尺度的感受野对特征进行多尺度提取和融合,并利用Sobel 卷积增强图像细节,通过残差结构传递图像特征,对图像特征进行深层特征提取,以及添加注意力机制关注高频细节的特征,从而提高图像的超分辨率重建效果。实验结果表明,使用本文算法重建后的内窥镜图像高频细节更为丰富,并且图像的整体结构和色彩也更加接近真实的高分辨率图像,因此具有一定的实际应用价值。

2 算法原理

2.1 网络结构

本文提出的残差注意力网络SMRAN 由浅层特征提取模块、深层特征提取模块和图像重建模块3 部分组成。浅层特征提取部分使用卷积网络,深层特征提取部分使用残差注意力网络,图像重建模块使用亚像素卷积层(sub-pixel convolution layer)。SMRAN 架构细节如图1 所示。

图1 SMRAN 架构Fig.1 Architecture of SMRAN

在超分辨率重建的起始阶段,浅层网络提取的特征与网络的输入相近,旨在将 LR 图像转化为一批便于后续处理的图像特征。浅层特征提取模块由一个大小为3×3 的卷积核构成,设定输入为3 通道的RGB 图像,输出通道数为64。令ILR表示输入的LR 图像,F0表示由卷积核计算后输出的特征图像,其数学表达式为:

式中,HSFE(·) 表 示卷积操作; σ(·)表示激活函数;WSFE表示权重值;BSFE表示偏置项,其目的是增加函数的灵活性,提高拟合能力。使用ReLU 函数作为激活函数,其数学表达式为:

鉴于内窥镜病理图像在形态结构和纹理特征上具有高度相似性,仅使用浅层卷积神经网络提取复杂图像特征的能力有限,难以挖掘图像的深层信息。而且,随着网络深度的不断提高,将会发生梯度消失或梯度爆炸的问题。为此,本文使用残差网络结构,构建深层特征提取模块,提高整体网络特征的稳定性。

网络的深层特征提取模块即主干部分由N个RG 模块组成,后面再连接一个3×3 的卷积核,为了加快收敛速度和方便训练,采用长跳跃连接整个主干网络的输入和输出。F0进入残差块RG 学习深度特征,有:

其中, HRG,n(·) 指第n个RG 操作,Fn表示通过第n个RG 块内部特征融合与残差学习的结果。为了使神经网络能够更好地利用浅层特征的高分辨率和深层特征的高语义信息,从不同深度的卷积层中提取高频特征细节信息,从而重建出细节更丰富的图像,本文引入了长跳跃连接。同时,长跳跃连接对残差网络的收敛也有促进作用,防止梯度爆炸或梯度消失,计算如下:

2.2 Res-Sobel 模块

边缘是图像像素值发生剧烈变化的位置的集合,具有信息集中以及图像特征突出的特点,在图像特征提取、图像分类、目标检测等图像处理相关任务都有非常重要的作用。本文采用索贝尔(Sobel)算子[22-24]增强组织边缘的细节特征。Sobel 算子是一个离散微分算子,结合了高斯平滑和微分求导。其通过对图像进行卷积操作计算灰度函数的梯度来对图像进行边缘检测和提取。Sobel 算子由两组3×3 的水平和垂直矩阵组成,通过将矩阵与图像进行卷积操作,分别获得水平和垂直亮度差分近似值。以I表示原始图像,Gx及Gy分别代表经横向及纵向边缘检测后的图像灰度值,其公式如下:

图像每个像素灰度值的大小G可通过以下公式进行运算:

为减小计算量,提升计算机的运算效率,可使用绝对值相加简化运算:

然后,通过阈值运算得到图像的边缘信息。通常,为了消除噪声的影响,往往会增加一个平滑处理的步骤作为预处理过程。

图2 为Res-Sobel 模块,在进行Sobel 滤波之前,使用1×1 卷积对输入特征作非线性变换,通过控制卷积核的数量实现降维,使网络的参数和计算量减少,并通过残差连接的方式将滤波后的图像边缘特征与原特征进行相加,从而使得通过该模块输出的图像特征得到增强。

图2 Res-Sobel 模块Fig.2 Res-Sobel Block

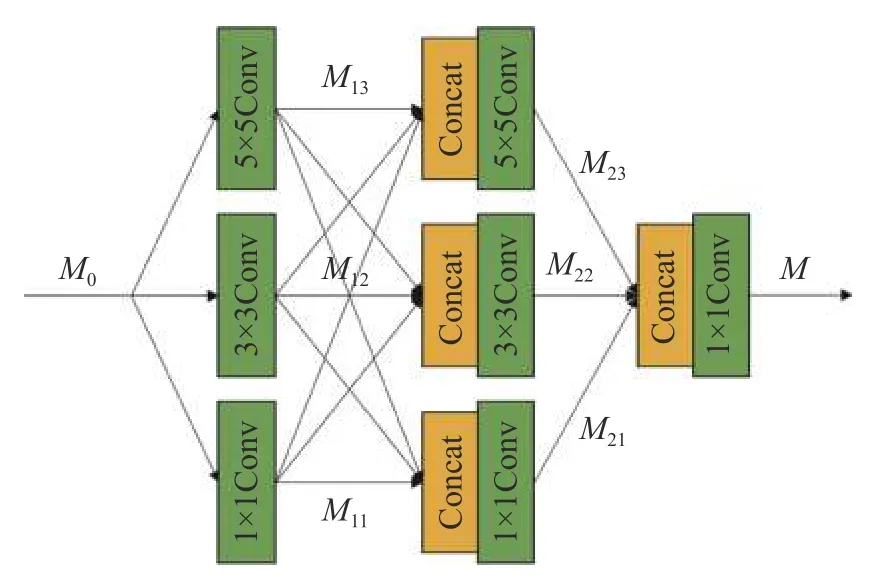

2.3 多尺度特征融合模块

内窥镜图像中有不同粗细的血管和不同大小的组织,如果对图像中不同大小的目标使用相同大小的卷积核,会使网络提取的特征单一,导致重建图像的高频细节丢失。因此,为了获取更加强大的特征表达,本研究在网络中设计了多尺度特征融合模块MEB,如图3 所示。令MEB 的输入特征为M0,输出特征为M,则该操作可以定义为:

图3 多尺度特征融合模块(MEB)Fig.3 Multi-scale feature extraction block(MEB)

其中, ω和b分别表示权重值和偏置项,其中上标表示层数,下标表示卷积核的大小, σ (·)表示ReLU激活函数。通过不同尺度的感受野提取不同大小目标的特征,然后将多个尺度特征图融合在一起,从而在图像超分辨率重建上取得优异的性能。

2.4 残差注意力结构

加深卷积神经网络的深度对提高超分辨率网络的性能非常重要。Zhang 等人在EDSR 的基础上进行改进,提出了RCAN 残差通道注意力机制网络,作者认为较深的网络具有更好的效果,但是像EDSR 那样对网络深度进行简单堆叠并不能起到很好的作用,因此,提出了RIR(Residual in Residual)结构。该结构使用了通道注意力机制。通道注意力机制可以看作是一个自适应地重新调整输入图像通道特征的过程,其根据输入的重要性动态调整加权特征来实现,以使网络更具辨别力。CBAM[25]注意力机制在通道注意力机制的基础上添加了空间注意力机制,并将通道注意力机制和空间注意力机制串联到一起,结构如图4所示。图4(a)为通道注意力部分,其计算过程如下:

图4 CBAM 注意力机制Fig.4 CBAM attention mechanism

其中: σ (·) 表示sigmoid 激活函数;W0和W1为MLP(多层感知机)的共享权重;Avgpool 和Maxpool分别表示对输入特征F进行全局平均池化操作和全局最大池化操作;Facvg表示经平均池化得到的特征;Fmcax表示经过最大池化得到的特征。图4(b)为空间注意力部分,其计算过程为:

其中 σ(·) 表示sigmoid 激活函数,f7×7表示滤波器大小为7×7 的卷积运算。

受RCAB 中残差学习思想和注意力机制的启发,本文提出了残差注意力模块SMRAB,并融合本文提出的多尺度特征融合模块MEB 和Res-Sobel 模块,将RCAB 的通道注意力机制替换为CBAM 注意力机制,并利用残差结构进行连接,防止因网络层数的加深导致网络退化,SMRAB结构如图5 所示。经过 CBAM 注意力机制之后,特征图将同时得到通道上和空间上两种维度的注意力权重,提高了各个特征在通道和空间上的联系,更有利于网络提取目标的有效特征。

图5 SMRAB 结构Fig.5 SMRAB Structure

2.5 图像重建模块

ESPCN[26]中提出基于亚像素卷积的方法来增大特征图的尺寸,并取得了很好的重建效果,亚像素卷积比反卷积具有更大的表示能力。并且重建速度具有非常明显的提升。因此,本文决定采用亚像素卷积的方法获得上采样后的特征图。对于输入维度为H×W×C的低分辨率特征图像,反卷积操作输出的特征图维度为rH×rW×C,其中r为放大的倍数;而亚像素卷积首先对图像的特征进行抽取,得到H×W×Cr2的特征图,即与输入图片的尺寸一致,但通道数扩充为原来的r2倍,然后再使用周期性洗牌(Period Shuffle,PS)操作进行重新排列,得到高分辨率图像。PS 函数定义为:

PS 的作用是将输入大小为H×W×Cr2的特征映射I重新排列,组成一个大小为rH×rW×C的数据,例如将一个维度为 4 8×48×22的特征图输入到PS 函数,则得到一个维度为96×96×1 的输出特征。

3 实验测试

3.1 实验环境和训练结果

为验证本文算法的有效性,进行编程实验。本实验所使用的图像数据集是PolypsSet[27]数据集。该数据集通过在MICCAI 2017、CVC colon DB、GLRC dataset 和KUMC dataset 数据集的视频序列中选取不同数量的帧组成。由于相机发生剧烈移动时,拍摄的图像可能会严重模糊、失焦或受到明显的照明变化,PolypsSet 数据集手动删除了一些包含误导或无用信息的帧。本实验在此基础上,选取PolypsSet 数据集中部分较清晣的图像构建为实验数据集,其中,选取3000 张图像作为训练集,200 张图像作为测试集,300 张图像作为验证集。测试集、训练集和验证集的图像均没有交集。训练和测试的过程均在Ubuntu 18.04.1系统上完成,使用单个型号为NVIDIA Geforce RTX 3090 Founders Edition 的GPU 对 网 络 进 行训练。算法基于Pytorch1.10.1 框架开发,使用Cuda11.1 对网络进行加速。

为使网络有足够的训练数据,实验从3 个方面增强数据集:(1)将图像旋转90°;(2)以一定的概率水平和垂直翻转图像;(3)随机裁剪,得到多个大小为36×36 像素的原始LR 图像块。在每个训练批次中,随机提取16 个大小为36 pixel×36 pixel 的LR 图像块输入到网络中进行训练。实验选用ADAM 优化算法作为网络的优化器,设置的参数为: β1=0.9 , β2=0.999 , ε=10-8,初始学习率设置为lr=0.0001,采用固定步长衰减的学习率衰减策略,每经过20 个训练轮次,学习率变为原来的0.5倍。超参数都是根据多次的实验结果,并对其进行反复调整而设置的。多次实验测试表明,当设置以上超参数时,使用本网络SMRAN 进行训练能产生更多的细节,从而重建出更加清晰的图像。

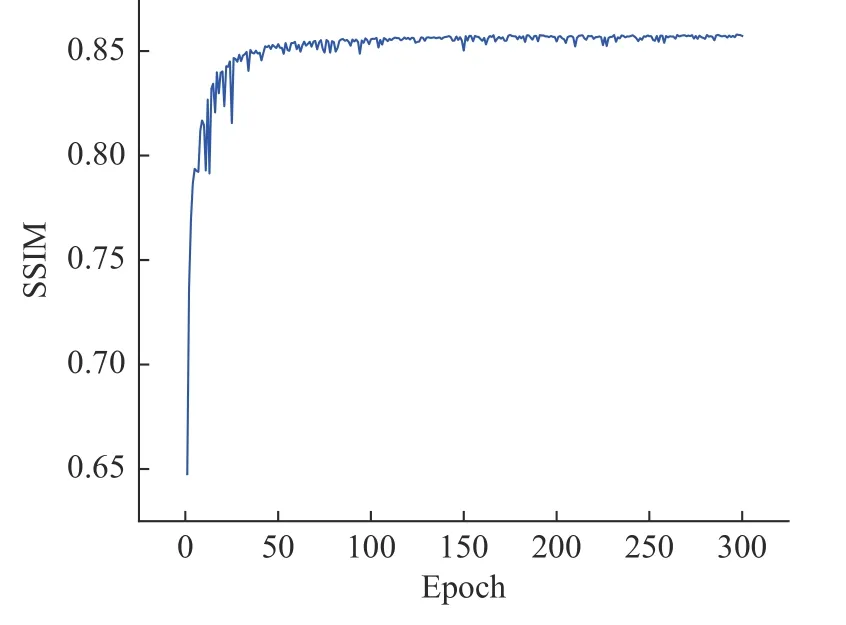

本文使用tensorboard 记录训练日志,可视化网络的训练效果。在验证集上的峰值信噪比(Peak Signal-to-Noise Ratio,PSNR)和结构相似性(Structural Similarity Index,SSIM)值随训练轮次增加而变化的曲线分别如图6、图7所示。经过大约130 次迭代,本网络开始收敛。

图6 验证集的PSNR 曲线Fig.6 PSNR curve of validation set

图7 验证集的SSIM 曲线Fig.7 SSIM curve of validation set

3.2 算法效果评价

3.2.1 客观评价

为客观地与其它主流的图像超分辨率算法进行比较,本文选用PSNR 和SSIM 两个评价指标,统一对不同算法重建后的图像质量进行评价。其中,PSNR 通过比较两幅图像的像素误差来评价重建图像的质量,对于给定尺寸均为M×N的原始HR 图像IHR和重建后的SR 图像ISR,两者之间的PSNR 定义如下:

SSIM 将图像的失真由3 个因素的组合进行运算,即亮度比较,对比度比较和结构比较,其数值越接近1,图像的质量越好。SSIM 定义为:

式中,IHR表示原始HR 图像;ISR表示重建图像;µHR, µSR分别表示两幅图像的灰度平均值; σHR,σSR分别表示两幅图像的方差; σHR,S R表示两幅图像的协方差;C1,C2是两个常数,目的是避免分母为0 带来的系统错误。

为验证本文所提出的超分辨率网络性能,将其与传统的双三次插值法(bicubic)以及几种先进的基于深度学习的图像超分辨率重建算法进行对比。在测试集上对SR 图像质量的PSNR 和SSIM量化比较结果分别如表1、表2 所示。

表1 测试集上不同算法的PSNR 值Tab.1 PSNR values of different algorithms on the testing set (Unit: dB)

表2 测试集上不同算法的SSIM 值Tab.2 SSIM values of different algorithms on the testing set

由表1、表2 可知,深度学习类算法较传统的双三次插值算法在测试集中所测得的PSNR 和SSIM 数值上均有非常明显的提升。由此可见,在图像超分辨率重建时,使用深度学习类方法更加具有优势。相较于其它卷积神经网络,RCAN 算法由于引入了残差注意力结构,因此表现更为出色。本文算法与其它所有算法相比,在×2、×3 和×4 的尺度因子上,PSNR 和SSIM 均表现最优。原因在于采用残差模块使得网络的梯度消失问题能够得到有效抑制,同时,Res-Sobel 模块和多尺度特征融合模块能充分提取图像的高频特征信息,而跳跃连接可以保留网络的浅层特征,实现不同层次的特征融合,从而得到优秀的图像重建效果。

3.2.2 主观评价

为直观可视化不同算法的重建效果,本小节从测试集中提取一张结直肠息肉图像,首先将原始HR 图像通过双三次插值算法进行四倍下采样获得退化LR 图像,然后在放大因子为4 时对图像通过不同算法进行超分辨率重建,进行视觉效果对比,结果如图8 所示。在图8(a)中,HR 表示退化前的LR 图像;图8(b)表示通过传统的双三次插值算法重建后的图像;图8(c)~图8(h)分别表示由不同深度学习方法重建的图像。经过对比可知,双三次插值算法重建图像的视觉效果最差,图像存在严重的模糊现象,图像的细节丢失严重。与图8(b)相比,图8(c)~图8(h)中深度学习类算法的图像重建效果均有明显提升。SRCNN、FSRCNN、ESPCN 和EDSR 算法的重建图像虽然相较于双三次插值算法在视觉上效果有明显改善,但均产生了斜线状的条纹。与之相比,RCAN 和本文算法SMRAN 的重建图像则未出现该现象。其中,与RCAN 相比,使用本文算法重建的图像更为清晰,并且与目标高分辨率图像的纹理细节最为相似,较有效地还原出内窥镜图像的高频信息,能够帮助医生更加清楚地观察结直肠息肉的病理特点。

图8 采用不同超分辨率算法的结直肠息肉内窥图像的重建效果对比图Fig.8 Comparison of reconstruction effects of endoscopic images of colorectal polyps using different super-resolution algorithms

3.3 损失函数对比实验

在基于卷积神经网络的超分辨率重建算法中,常用平均绝对误差损失函数L1或者均方差损失函数L2作为损失函数。虽然使用L2损失函数重建结果往往有较高PSNR 值,但更容易产生过平滑图像,丢失图像的高频细节,而使用L1损失函数能有效防止重建图像由于过度平滑而导致的失真现象,并且更易于网络收敛。然而,L1和L2损失函数均是基于逐像素去两幅图像的比较差异,忽略了重建图像的结构和边缘等高频细节信息。综合考虑,本文最终结合了L1损失函数与多尺度结构相似性损失函数LMS_SSIM为总的损失函数L,可以表示为:

其中 α为平衡参数,实验设置为0.78;G 为高斯分布参数。L1损失函数和LMS_SSIM损失函数分别定义如下:

其中,N为训练的图片数量,ISR为重建后的图像,IHR为原始的高分辨率图像,MS_SSIM 表示多尺度结构相似性运算。

为验证损失函数对本文算法效果的影响,进行对比实验,在测试集上的实验结果如表3 所示。通过表3 可以得知,使用L1与MS-SSIM 混合的损失函数时,与仅使用L1损失函数相比,SSIM提升了约0.127%,而PSNR 则下降了约0.058%,考虑到重建图像的整体视觉效果,使用混合损失函数的效果更优。

表3 不同损失函数的PSNR 和SSIM 值Tab.3 PSNR and SSIM values for different loss functions

3.4 网络结构消融实验

本小节在图像放大比例为4 倍的条件下进行了消融实验,以验证Res-Sobel 模块、MEB 模块和CBAM 模块对本网络SMRAN 的有效性。为了保证实验的科学性和可靠性,所有网络测试的超参数的设置均相同。在测试集上的实验结果如表4 所示。从表中4 可看出,各个模块对网络的性能均有一定的提升作用。

表4 各模块对性能的影响Tab.4 The impact of each module on performance

3.5 模型的泛化性能

模型的泛化能力指模型对未知的新鲜样本的预测能力,是评估超分辨率模型性能的一项重要指标,以此判断模型的实际应用价值。为验证SMRAN 的泛化能力,本小节以胃肠道息肉数据集Kvasir-SEG[28]作为测试集,使用SMRAN 等算法对其进行超分辨率重建,PSNR 和SSIM 量化比较分别如表5、表6 所示。根据此结果可知,在跨数据集的泛化性实验上,本文算法SMRAN 的综合表现最优,因此验证了SMRAN 模型具有良好的泛化能力。

表5 Kvasir-SEG 数据集上不同算法的PSNR 值Tab.5 PSNR values of different algorithms on the Kvasir-SEG dataset (Unit: dB)

表6 Kvasir-SEG 数据集上不同算法的SSIM 值Tab.6 SSIM values of different algorithms on the Kvasir-SEG dataset

为验证本文模型对通用图像光学分辨率提升的泛化性,本小节使用了OV5640 摄像头拍摄了多张USAF 标准光学分辨率标靶图像。由于本文模型仅对结直肠内窥镜图像进行训练,所以模型对分辨率标靶的超分效果难免会不太理想。因此,本文将部分拍摄的分辨率标靶图像并入结直肠内窥镜图像数据集PolypsSet,合并进行训练,得到优化训练后的模型。优化训练后的SMRAN模型在放大因子为4 时对于光学分辨率的提升效果如图9 所示。图9(a)为未退化的HR 图像,图9(b)为退化后LR 图像的局部放大图,图9(c)为EDSR 算法对图9(b)的超分辨率重建结果的局部放大图,图9(d)为进行优化训练后的SMRAN 模型对图9(b)的超分辨率重建结果的局部放大图。图9(e)为图9(b)的MTF 曲线,图9(f)为图9(d)的MTF 曲线。通过对比可以看出,经过优化训练后的SMRAN 模型对于光学分辨率的提升相当显著。

图9 SMRAN 模型对光学分辨率的提升效果Fig.9 Improvement of optical resolution by SMRAN model

4 结 论

本文提出了一种基于残差注意力结构的图像超分辨率网络SMRAN,通过多尺度特征融合模块MEB 和Res-Sobel 模块进行图像细节和边缘提取并进行增强,使用CBAM 注意力机制对给定信息进行权重分配,关注不同通道和像素区域特征对重建图像的贡献,增强网络性能,使得网络能够更好地学习不同大小的血管和组织的细节特征,从而突出结直肠内窥镜图像的细节。网络训练不是简单地计算对应像素点间的误差损失,而是将L1损失和多尺度结构相似性损失相结合进行训练,从而改善图像的整体视觉效果,为医生诊断和治疗提供具有高视觉感知质量的医学图像,重建后的高分辨率图像也可为利用大数据对结直肠息肉和肿瘤进行大规模筛查的人工智能提供技术支持。实验结果表明,就结直肠内窥镜图像的超分辨率重建的视觉效果而言,本文方法较经典网络的重建图像质量有所改善,在测试集上的PSNR 和SSIM 值分别达到34.25 dB和0.8675,并且模型具有良好的泛化性。

猜你喜欢

杂志排行

中国光学的其它文章

- Double-slot ultra-compact polarization beam splitter based on asymmetric hybrid plasmonic structure

- Decoherence of temporal quantum correlation in electrically controllable quantum-dots molecules

- The Poynting vectors, spin and orbital angular momentums of uniformly polarized cosh-Pearcey-Gauss beams in the far zone

- 单波长激光通信终端的隔离度

- 氨气高精度激光光谱检测装置的设计及实现

- 分光比可调的光功率分束器的设计