基于深度学习的丝绸文物纹样识别应用

2023-08-31孙选铭苏淼

孙选铭 苏淼

摘要: 为对数字化文物进行快速自动分类,提高藏品数字化进程,加快数字博物馆的构建,文章利用深度学习对丝绸文物的纹样进行自动识别。依据实物纹样的分类方法,建立了包含花卉纹、飞鸟纹、“卐”字纹、云纹四类纹样的样本库。利用VGGNet、ResNet、MobileNet实现对纹样的分类,结合Faster R-CNN、YOLOv5、SSD目标检测算法实现对纹样的识别与定位。实验结果表明,MobileNet对丝绸纹样分类的mAP达到83.51%;在目标检测算法中YOLOv5的识别与定位效果最好,其mAP为88.42%。与通过人工分类相比,采用深度学习算法进行分类与识别,可以在降低难度的同时提高分类的速度和准确率,为纺织品文物的鉴定与保护提供了新的思路。

关键词: 丝绸文物;深度学习;数字博物馆;目标检测;神经网络;自动分类

中图分类号: TS101.1 文献标志码: A

文章编号: 10017003(2023)080001-10

引用页码: 081101 DOI: 10.3969/j.issn.1001-7003.2023.08.001

在信息化的时代背景下,数字化媒体与计算机技术相结合给博物馆的发展带来新机遇,文物也从传统形态向数字形态转变。因此将藏品数字化,构建数字博物馆就成了一个亟待解决的问题[1-3],而在数字博物馆的搭建过程中文物的分类是一个重要的步骤。与普通的产品相比,文物分类难度高,其中纺织品文物由于材料难以保存、完整性差,使分类难度更高。因此,如何快速准确地完成纺织品文物的识别与分类成为一个需要解决的问题。纺织品文物的分类可以从色彩、纹样、材料、织造工艺等多个角度进行,其中根据纹样进行分类最为直观,也最容易被大众接受。并且,纹样也是纺织品文物在出土时判断年代的一项重要依据。目前,纺织品文物的纹样识别主要靠人工进行。在长期的演变过程中,同一种纹样的形态往往会发生巨大的变化。大多数的纹样在历史的进程中都经历了这样的演变过程,这也加大了纹样人工识别的难度,而近年来深度学习的快速发展为解决这一问题提供了新的思路。

随着人工智能技术的不断发展,其在人们日常生产生活中扮演的角色也越来越多,图像识别就是其中的一个重要分支。图像识别的逐步兴起也为各行各业的发展提供了新的思路,纺织服装领域也不例外。吴志鑫等[4]分别利用HSV颜色直方图法和灰度共生矩阵(Gray-level Co-occurrence Matrix,GLCM)算法提取图像的颜色和纹理特征,建立两种特征融合的方法实现了对服装面料图像的检索。高妍等[5]将R-FCN引入对服装图像的识别中,在降低训练时间的同时提高了识别的准确率。狄宏静等[6]利用BP神经网络的任意函数模拟功能,实现了对流行色科学、全面的预测。Bedeli等[7]以流行标志和名牌Logo为切入点,成功利用监控摄像头实现对行人服装的分类。韩曙光等[8]利用深度學习的方法对服装进行“三要素”识别,为顾客服装偏好信息的快速获取提出了新的思路。虽然国内外都在积极尝试将图像识别相关技术运用到纺织服装行业并取得了一定的结果,但纺织品文物作为其中较为独特的领域,相关研究的成果寥寥无几。本文以纺织品文物上的纹样作为研究对象,构建基于深度卷积神经网络的分类与目标检测模型,对纺织品文物,尤其是丝绸织物上的纹样进行自动识别。图像识别的主要任务有四大类:分类(classification)、定位(location)、检测(detection)、分隔(segmentation)。本文致力于解决分类与检测的问题,即实现“给定一张纹样图片,判断其中包含何种纹样的所属类别”和“给定一张文物图片,定位出其中纹样的位置并且知道定位出的是什么纹样”两项目标。

1 数据准备

1.1 数据的采集与描述

本文的研究对象为丝绸文物纹样,数据的采集难度大。首先,受材质影响,出土的纺织品文物在数量及完好程度上远不及陶瓷器青铜器等文物;其次,出土的纺织品文物的纹样通常质量较差,常常伴有严重褪色和大面积破损等问题,难以直接利用。针对以上各种问题,在数据集的采集上,本文选用文物中保存较为完好的传世品(图1),以提高数据集的质量;传世品的年代主要集中在清末民初,为解决这一问题,本文在数据集中也采用了较多纹样的复原图(图2、图3),用以增大数据集的年代跨度,提高识别的准确率和可靠性。

最终,通过中国丝绸博物馆的《中国古代丝绸设计素材图系》系列丛书提取到高质量的复原图片1 185张;借助中国丝绸博物馆的“锦秀·世界丝绸互动地图”平台,采集到清晰度较高的传世品文物及破损程度较轻的文物图片1 079张。

古代丝绸纹样的题材众多,但依据实物纹样的分类方法可以分为植物纹样、动物纹样、几何纹样、自然与器物纹样四种[9]。结合所采集到数据的实际情况,本文最终选取花卉纹、飞鸟纹、“卐”字纹、云纹四类(图4)。

1.2 数据的处理

对于分类模型,需要对数据进行裁剪处理,目的是除去较大的噪声,提高数据集的代表性,增强识别效果;此外也需要将分类的主体从图像中分离出来,为每个类别设置单独的数据集。对于检测模型,除了基本的类别之外数据集还需提供纹样的位置及尺寸等信息。本文利用Labelimg软件在图片上绘制锚框的方法制作所需数据集。由于丝绸文物上的纹样大多为循环结构,为了降低数据标注的工作量并提高检测效果,对于循环次数较多的样本图片,只取其中1~2个完整的循环。

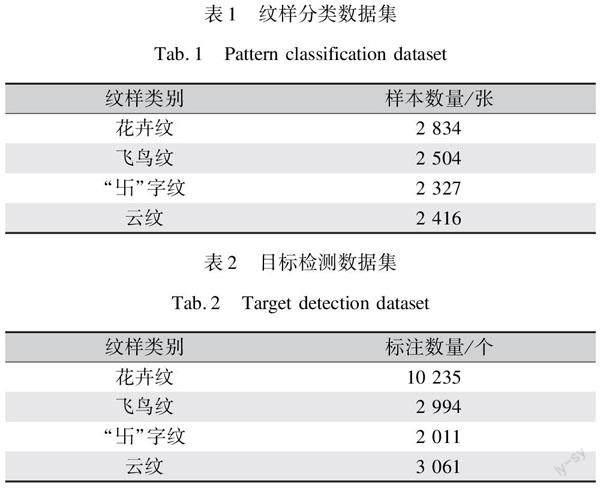

经过处理后分类样本数据集共有图片2 922张,其中花卉纹1 467张,飞鸟纹437张,“卐”字纹361张,云纹657张。由于不同类别之间差距较大,因此对数据集采取几何变换、色彩调整、尺度变换等数据增强方法,最终得到的样本数据集如表1、表2所示。

2 模型的构建

为了更好地实现对丝绸文物纹样的识别,需要分别构建分类及目标检测的两个网络模型。而且,为了提高结果的科学性和准确性,每个目标均选用多种模型以便于对比识别性能的优劣。在分类模型的选择上,本文选用经典的卷积神经网络VGG16、ResNet50[10]和MobileNet[11]。在目标检测模型上则选用Faster R CNN[12]、YOLOv5[13]及SSD[14]。

2.1 分类模型的构建

2.1.1 VGG16模型的构建

VGGNet是卷积神经网络模型,其名称来源于作者所在的牛津大学视觉几何组(visual geometry group)的缩写。VGG16的网络结构如图5所示,可以划分为6个模块层次加1个输入模块,共计13个卷积层、5个最大池化层和3个全连接层。在卷积层上,VGG16采用多个3×3的卷积核叠加取代了之前的大卷积核,卷积核的大小与感受野直接相关,卷积核过大会忽略被检测的物体,导致物体成为背景,提取不到物体特征。如“卐”字纹在织物上常作为次要装饰存在,尺度较小,故更小的理论感受野更利于类似于“卐”字纹这种较小特征的提取。

2.1.2 ResNet模型的构建

综合前文所述,丝绸文物的纹样数据较难获取且质量较差,这就要求网络的性能要够好,能够利用有限的数据集达到较好的识别效果。在其他条件不变的情况下,卷积神经网络的层数越多,网络越深,学习的效果也就更好,但网络在加深时容易收到梯度消失问题[15]的影响。换用ReLU可以一定程度上解决这个问题,但ReLU也有一个特殊的消失梯度问题,称为消亡ReLU问题[16]。针对这一问题,He等[10]提出了残差网络框架(residual learning framework),其基本原理是利用一种特殊的残差结构(图6)将靠前若干层的某一层数据输出直接跳过多层引入到后面数据层的输入部分。使得后面的特征层的内容会有一部分由其前面的某一层线性贡献,从而克服由于网络深度加深而产生的学习效率变低与准确率无法有效提升的问题。利用这种结构可以加深网絡的层数,获得更好的性能。

2.1.3 MobileNet模型的构建

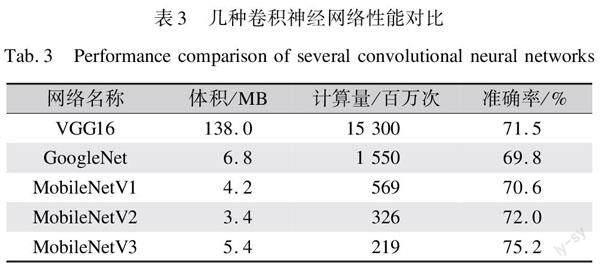

纹样作为判断文物所处历史时期的重要依据之一,在考古发掘现场对纹样识别有着较大的需求。而随着神经网络性能的不断提高,网络的结构也越发复杂,运行所需消耗的硬件资源也不断增加,这使得移动设备的硬件资源和算力难以满足。面对此类问题,深度学习领域也在努力使神经网络向小型化、轻量化发展,MobileNet就是轻量级神经网络[11]中具有代表性的一种。与其他神经网络相比,MobileNet有着体积更小、计算量更少,而精度却更高(表3)。

本文主要研究的是引入了残差结构的MobileNetV2,其提出了反相残差(inverted residuals)的概念,增强了特征表达能力的同时显著减少了所需的内存。此外,MobileNetV2网络为全卷积结构,使模型对不同尺度的图像都具有适应力。

2.1.4 分类模型评价指标

参考深度学习分类模型相关性能评价指标[17-18]并结合实际研究内容,本文采取两种评价指标:准确率(accuracy)与损失函数(loss function)。根据与实际情况的关系,预测结果可被分为四类:真阳(True Positive,TP)、假阳(False Positive,FP)、真阴(True Negative,TN)、假阴(False Negative,FN)。

准确率是被分对类别的样本数在所有样本数中的占比。通常来说,准确率越高,分类器越好。

损失函数用于评价模型的预测值与真实值的差异程度。深度学习训练模型的过程就是通过计算损失函数,不断更新模型参数,从而减小优化误差。本文所使用的损失函数为交叉熵(cross entropy)损失函数。由于本文为多标签分类,损失函数公式如下:

式中:yi为真实标签,当第i个样本属于某一目标类时值为1,否则为0;i为预测结果,其值为第i个样本属于某一目标类的预测概率;i为第几个样本。Loss是一个非负实值函数,损失函数越小,模型的鲁棒性就越好。

2.2 目标检测模型构建

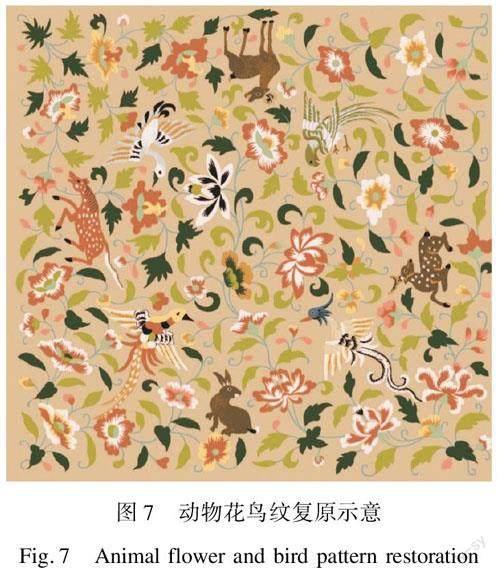

与如今流行的简约风格不同,中国古代追求富丽华贵之美,丝绸织物章彩奇丽,因此在丝绸文物上往往包含着大量的

元素(图7),这使针对单一纹样的分类失去意义。而从复杂场景中提取出多个若干特定目标的方法属于目标检测(object detection)的范畴。

目标检测和图像分类最大的区别在于目标检测需要做更细粒度的判定,不仅要判定是否包含目标物体,还要给出各个目标物体的具体位置。目前较为成熟的目标检测算法有R-CNN系列、YOLO系列及SSD模型。对于前两者,本文分别选用系列中最完善的Faster-RCNN及YOLOv5。这三种算法的异同点如表4所示。

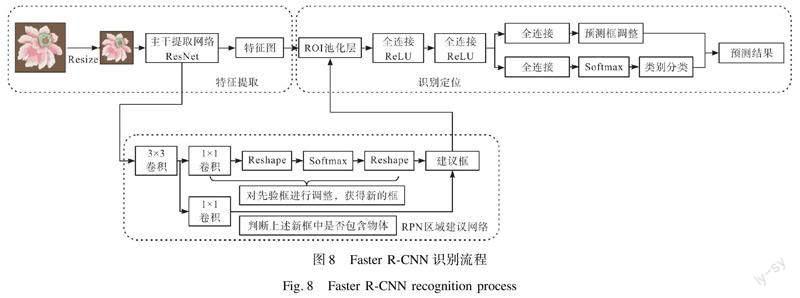

2.2.1 Faster R-CNN模型的构建

Faster-RCNN是二阶段(two-stage)目标检测模型中的典型代表。识别的过程分为两步:首先通过区域建议网络生成候选区域[12],然后再通过卷积神经网络进行分类与定位。以此为基础构建丝绸纹样识别模型,流程如图8所示。输入的丝绸纹样图片经过不失真的Resize后,输入主干提取网络提取特征,得到的纹样特征图会被RPN层和ROI Pooling层共享。特征图通过RPN层获得建议框,ROI Pooling层会根据建议框对输入进来的纹样特征图进行重新截取,截取后的纹样特征图在被Resize后送到后续网络接受进一步的卷积并最终得到预测结果。

2.2.2 YOLOv5模型的构建

YOLOv5是一种单阶段目标检测算法。与Faster-RCNN不同,没有RPN结构而是直接利用卷积神经网络进行特征提取并进行分类与定位,因此速度更快。YOLOv5可分为三个部分,分别是Backbone、FPN及Yolo Head。YOLOv5的主干网络为CSPDarknet,其中有着特殊的CSP层,作用类似残差网络中的残差结构,可以缓解在深度神经网络中增加深度带来的梯度消失问题,增强模型的学习能力,从而更好地识别复杂的丝绸纹样。基于以上原理,本文构建基于YOLOv5的丝绸纹样识别模型(图9)。丝绸纹样图像输入到模型后会对主干网络的Focus结构进行压缩获得一个特征层,并在多次卷积、标准化、激活函数和CSP层之后获得三个不同尺度的有效特征层[13]。有效特征层在进入FPN结构后会经历一次上采样特征融合和一次下采样特征融合,之后输出三个加强有效特征层。最终Yolo Head会利用这三个加强有效特征层进行分类和回归预测,得到丝绸纹样的预测结果。

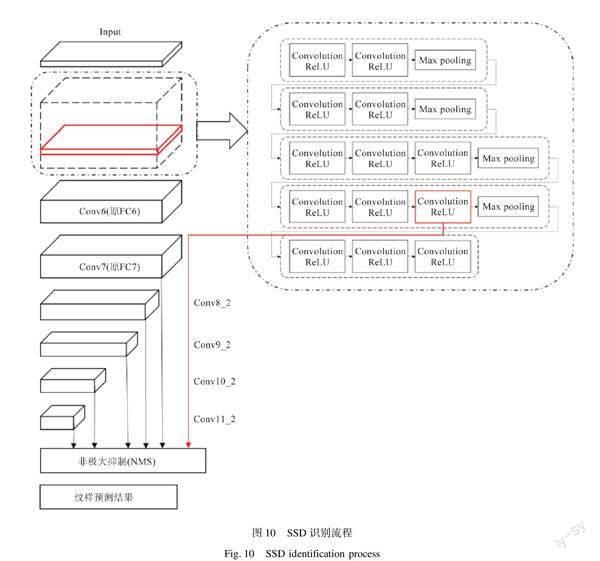

2.2.3 SSD模型的构建

SSD[14]是一种结合了Faster-RCNN和YOLO各自的优点的单阶多层的目标检测模型。SSD的主干网络是改进后的VGG:将VGG16的FC6、FC7两个全连接层转化为卷积层;去掉最后一个全连接层和所有的Dropout层;并在原FC7层之后新增了四个卷积层。根据SSD算法构建的丝绸纹样识别模型如图10所示。通过此识别流程,SSD可以获得6个不同尺度的有效特征层,根据不同尺度的特征层映射生成不同尺度的预测结果,并通过纵横比明确分开预测。其中越早提取的特征层,抽象程度越小,细节信息保留得也更多,适合预测的目标也更小。反之越后面的特征层适合预测的目标也越大。这种设计使其在低分辨率输入图像上也能实现简单的端到端训练和高精度,可以更好地识别图片质量普遍较差的丝绸文物纹样图片。

2.2.4 目标检测评价指标

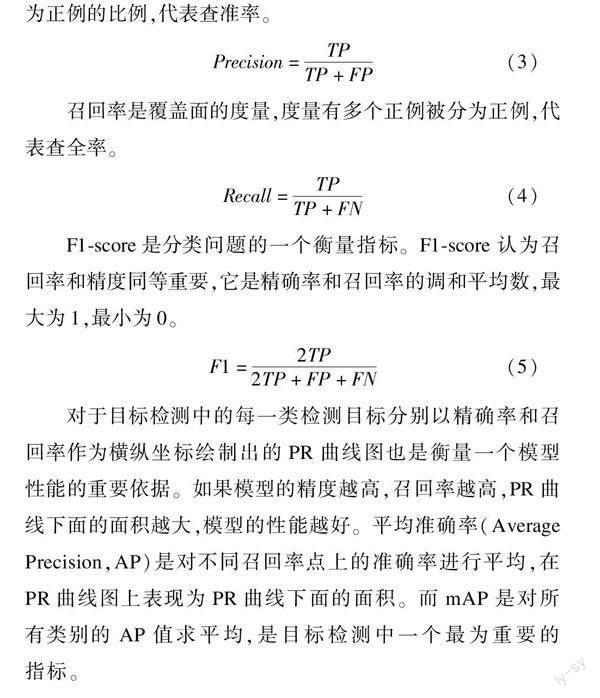

参考目标检测算法的常用评价指标并结合本文研究实际,目标检测任务采用的评价指标为精确率(precision)、召回率(recall)、F1分数(F1-score)、平均精度均值(mAP)。

精确率是精确性的度量,表示被分为正例的示例中实际为正例的比例,代表查准率。

召回率是覆盖面的度量,度量有多个正例被分为正例,代表查全率。

F1-score是分类问题的一个衡量指标。F1-score认为召回率和精度同等重要,它是精确率和召回率的调和平均数,最大为1,最小为0。

对于目标检测中的每一类检测目标分别以精确率和召回率作为横纵坐标绘制出的PR曲线图也是衡量一个模型性能的重要依据。如果模型的精度越高,召回率越高,PR曲线下面的面积越大,模型的性能越好。平均准确率(Average Precision,AP)是对不同召回率点上的准确率进行平均,在PR曲线图上表现为PR曲线下面的面积。而mAP是对所有类别的AP值求平均,是目标检测中一个最为重要的指标。

3 实验与结果分析

3.1 实验环境

本文的分类任务的实验环境为CPU:Intel(R) Core(TM) i5-10200H CPU@2.40 GHz,GPU:NVIDIA GeForce GTX 1650 Ti,软件环境为Windows 10版本。目标检测任务的实验环境为CPU:Intel(R) Xeon(R) Platinum 8255C,GPU:GeForce RTX 3090。本文所采用的深度学习框架均为PyTorch,编译语言为Python。

3.2 分类模型实验与结果

本次实验所使用的数据集为前文自制丝绸文物纹样图片数据集,包含花、鸟、云、“卐”四种纹样共11 081张。在实验数据集中将随机选取80%作为训练集,20%作为测试集用于模型的性能评估。为提高实验的科学性和可靠性,在各个模型的参数方面进行统一。Epoch设为200,最大学习率设为001,batch size设为32。

因神经网络主干特征提取部分所提取到的特征通用性较高,且本文所选用的三种网络性能均十分良好,所以本文采取了冻结训练的方法以提高训练效率。冻结阶段的Epoch设置

为50,在冻结阶段主干特征提取网络的权重被冻结,只对网络进行微调。而在50个Epoch后网络解冻,开始对主干网络的权重进行调整,因此导致损失率的突变。在损失率方面,三个网络均表现良好,由图11可知,在解冻后,损失率快速下降并最终趋于平稳,表明结果已经趋于稳定。最终值均小于0.16但不为零,表明模型并未过拟合。表5为丝绸纹样分类结果。

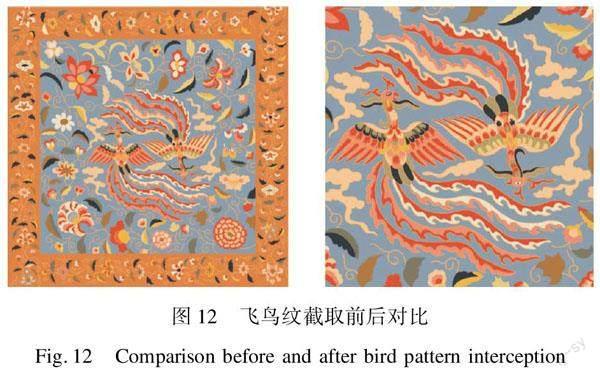

由表5可见,在本文的数据集中MobileNet表现出较优的性能,其平均准确率达到了83.51%。在所选择的四种纹样中,对花卉纹和云纹的分类效果较好,准确率均在90%以上。与云纹及花卉纹不同,飞鸟纹样大多作为主要纹样,在更为精细的同时尺度也更大,在进行截取时容易造成背景的复杂(图12)。而神经网络层数越多提取的特征就越丰富,对于VGG16和ResNet这种较深的网络来说,在场景细节特征上挖掘得较深反而造成了准确率的下降。与飞鸟纹相反,“卐”字纹在纹样中更多充当次要装饰,尺度一般很小。在分辨率较

低的图片上采样时,样本的像素数较少,极易受到噪声干扰,严重影响了分类效果。

3.3 目标检测模型实验与结果

用于目标检测实验的数据集为上述四种纹样的4 284张图片,其中多数图片包含相应类别的一个或多个图案或不同类别的一个或多个图案,实际标注数量共10 081个。实验为上述三种模型的对比实验,参数设置为相同的参数。Epoch设置为200,包含50个Epoch的冻结阶段。冻结阶段batch size为16,解冻阶段batch size为8。最大学习率0.01,Score threshold设置为0.5。在实验数据集中随机抽取90%作为训练集,10%作为测试集用于模型的性能评估。实验结果如表6所示。

对比三个模型的实验结果,在识别与定位纹样上YOLOv5的性能更加优越,其平均精度均值达到了88.42%。分别比Faster R-CNN和SSD高出4.83%和8.64%。其中飞鸟纹的识别效果最好,平均准确率达到95.97%。如前文所述,飞鸟纹的尺度一般较大。在多尺度的物体中,大尺度的物体由于面积大、特征丰富,通常来讲较为容易检测。其次是花卉纹和云纹,平均准确率均高于85%。这两种纹样在尺寸和风格上变化较大:植物纹样在染织艺术史上出现较晚,大约南北朝时期才进入中国染织艺术领域,最初大部分为装饰性的花卉,如以宝花为主的大团花,随后写生花卉才逐渐兴起。但直到写生花卉成为主流时,同时期的团花纹样依然占据相当的比例[9]。而团花和写生花卉的区别很大,这就使得计算机在学习这类图案特征时较为困难,从而影响检测的效果;而云纹的形式更加多样,识别的难度更大,检测效果受到的影响也更大。“卐”字纹的平均准确率最低,仅有82.23%。在本文选择的纹样中,“卐”字纹的尺寸最小,小物体由于其尺寸较小,可利用的特征有限,这使得其检测较为困难。并且目前的检测算法普遍对于小物体的检测效果较差。小物体因尺寸小,若小于检测算法的下采样率,甚至会导致在特征图上占据的面积达不到一个像素点。感受野的大小也是影响小物體检测的一个因素,过大的感受野会导致在特征图上的一个点中,小物体占据的特征更少,并且包含大量周围区域的特征,从而影响其检测结果。此外,SSD算法虽使用了多层特征图,但浅层的特征图语义信息不足,没有进行特征的融合,使得其在“卐”字纹的检测上效果较差,AP仅有58.44%

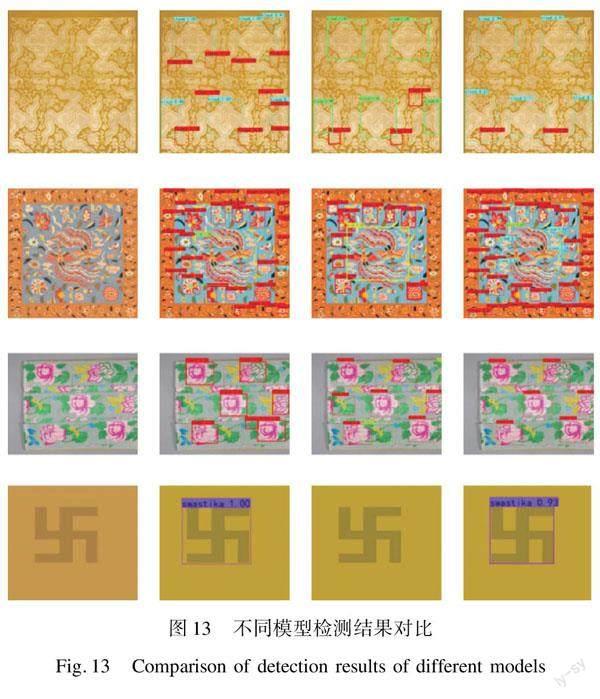

3.4 實验例证与分析

为了更加直观地体现不同检测模型对四种纹样的识别效果,选取了包含四种纹样的纺织品文物实物图进行测试,结果如图13所示。图13中,从左到右分别为文物原图、Faster R-CNN、SSD、YOLOv5的检测结果,可以得出不同算法对四种纹样进行识别时出现的错检、漏检情况,由此得出YOLOv5模型的检测效果明显优于其他两种。

4 结 论

丝绸在中国的历史十分悠久,文物的数量也众多,如何更快更好地发掘、保护、管理丝绸文物就成了一个重要的问题。针对丝绸纹样数字化分类工作量大、识别困难的问题,本文利用深度学习进行了识别丝绸文物纹样的有益尝试。按照实物纹样的分类方法,本文从中各自选取较有代表性的一种纹样为例,通过收集专业的纹样复原图和网络上各大博物馆的数字化藏品图片,建立了包含上述四种纹样14 365图片的数据集,然后利用深度学习的方法对其进行分类与识别。结果表明,MobileNet在对纹样进行分类时表现出较优的性能,其在占用计算机硬件资源最少的情况下,在测试集上的平均准确率最高,达到了83.51%,略优于VGG16和ResNet。Faster-RCNN、SSD及YOLOv5三种目标检测模型在对四种纹样的识别中,YOLOv5表现出了明显的优势。在Score threshold设置为0.5的情况下,其对纹样识别的平均精度均值达到了8842%。在四种纹样中,飞鸟纹的识别效果最好,AP为9597%。花卉纹、“卐”字纹、云纹的AP分别为89.52%、8223%、85.95%。基于本文实验中YOLOv5表现出的优越性能及YOLO在视频检测上的优势与摄像设备相结合,在文物数字化的过程中直接为数据打上置信度较高的分类标识,可以大大提高分类的精度与速度,加快数字博物馆的建立,拉近文物与每个人的距离,更利于保护和弘扬中国优秀的传统文化。

参考文献:

[1]赵丰. 丝绸之路数字博物馆: 开放共享的博物馆数字融合[J]. 中国博物馆, 2022(3): 109-115.

ZHAO Feng. Silk Road digital museum: Open and shared museum digital fusion[J]. Chinese Museum, 2022(3): 109-115.

[2]秦一. 关于博物馆文物数字化的技术探索[J]. 文化月刊, 2022(2): 104-105.

QIN Yi. Technical exploration on the digitization of museum cultural relics[J]. Cultural Monthly, 2022(2): 104-105.

[3]陈刚. 数字博物馆概念、特征及其发展模式探析[J]. 中国博物馆, 2007(3): 88-93.

CHEN Gang. The concept, characteristics and development model of digital museum[J]. Chinese Museum, 2007(3): 88-93.

[4]吴志鑫, 李立轻, 汪军, 等. 一种基于特征值融合的服装面料图像检索方法[J]. 服装学报, 2021, 6(1): 42-47.

WU Zhixin, LI Liqing, WANG Jun, et al. An image retrieval method of clothing fabric based on feature fusion[J]. Journal of Clothing Research, 2021, 6(1): 42-47.

[5]高妍, 王宝珠, 郭志涛, 等. 改进HSR-FCN的服装图像识别分类算法研究[J]. 计算机工程与应用, 2019, 55(16): 144-149.

GAO Yan, WANG Baozhu, GUO Zhitao, et al. Clothing image recognition and classification based on HSR-FCN[J]. Computer Engineering and Applications, 2019, 55 (16): 144-149.

[6]狄宏静, 刘冬云, 吴志明. 基于BP神经网络的春夏女装流行色预测[J]. 纺织学报, 2011, 32(7): 111-116.

DI Hongjing, LIU Dongyun, WU Zhiming. Forecast of women’s spring/summer fashion color basedon BP neural networks[J]. Journal of Textile Research, 2011, 32(7): 111-116.

[7]BEDELI M, GERADTS Z, VAN E E. Clothing identification via deep learning: Forensic applications[J]. Forensic Sciences Research, 2018, 3(3): 219-229.

[8]韩曙光, 姜凯文, 赵丽妍. 基于深度学习的服装三要素识别[J]. 服装学报, 2022, 7(5): 399-407.

HAN Shuguang, JIANG Kaiwen, ZHAO Liyan. Recognition of clothing “three elements” based on deep learning[J]. Journal of Clothing Research, 2022, 7(5): 399-407.

[9]赵丰, 袁宣萍. 中国古代丝绸设计素材图系: 图像卷[M]. 杭州: 浙江大学出版社, 2016: 1-24.

ZHAO Feng, YUAN Xuanping. The Ancient Chinese Silk Material Design Department: Image Volume[M]. Hangzhou: Zhejiang University Press, 2016: 1-24.

[10]HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. Las Vegas: IEEE, 2016: 770-778.

[11]高继强. 基于轻量级神经网络的服装图像检索[J]. 科學技术创新, 2020(31): 94-95.

GAO Jiqiang. Clothing image retrieval based on lightweight neural network[J]. Scientific and Technological Innovation, 2020(31): 94-95.

[12]张飚雪, 刘成霞. 基于Faster R CNN的浅口高跟鞋款式识别[J]. 丝绸, 2021, 58(1): 79-84.

ZHANG Biaoxue, LIU Chengxia. Style recognition of shallow opening high-heeled shoes based on Faster R CNN[J]. Journal of Silk, 2021, 58(1): 79-84.

[13]郭波, 吕文涛, 余序宜, 等. 基于改进YOLOv5模型的织物疵点检测算法[J]. 浙江理工大学学报(自然科学版), 2022, 47(5): 755-763.

GUO Bo, L Wentao, YU Xuyi, et al. Fabric defect detection algorithm based on improved YOLOv5 model[J]. Journal of Zhejiang Sci-Tech University (Natural Sciences), 2022, 47(5): 755-763.

[14]LIU W, ANGUELOV D, ERHAN D, et al. SSD: Single shot multibox detector[C]//Computer Vision-ECCV 2016: 14th European Conference. Amsterdam: Springer International Publishing, 2016: 21-37.

[15]BENGIO Y, SIMARD P, FRASCONI P. Learning long-term dependencies with gradient descent is difficult[J]. IEEE Trans Neural Netw, 1994, 5(2): 157-166.

[16]HU Z, ZHANG J J, GE Y. Handling vanishing gradient problem using artificial derivative[J]. IEEE Access, 2021, 9: 22371-22377.

[17]RUSSAKOVSKY O, DENG J, SU H, et al. ImageNet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252.

[18]李青, 冀艳波, 郭濠奇, 等. 基于深度学习的女衬衫图案样式识别分类[J]. 现代纺织技术, 2022, 30(4): 207-213.

LI Qing, JI Yanbo, GUO Haoqi, et al. Pattern recognition and classification of women’s shirts based on deep learning[J]. Advanced Textile Technology, 2022, 30(4): 207-213.

Application of silk cultural relic pattern recognition based on deep learning

ZHANG Chi, WANG Xiangrong

SUN Xuanming, SU Miao

(a.College of Textile Science and Engineering (International Institute of Silk); b.World Silk and Silk Road International Research Center,Zhejiang Sci-Tech University, Hangzhou 310018, China)

Abstract: Silk, as one of the greatest inventions in ancient China, has a history of over 5 000 years and represents one of China’s most significant traditional cultures. The value of ancient silk is a historical witness, and the important information it carries is also important. As the most representative cultural symbol of a nation, decorative patterns are a crucial part of the information carried by ancient silk. Therefore, extracting information from ancient silk is of great significance for the protection and promotion of China’s excellent traditional culture. Although museum visits are the most effective way for non-cultural relic protection workers to access ancient silk, this approach is not only inconvenient but also insecure, particularly in the context of the recent worldwide outbreak of the new coronavirus. To break the spatial limitations of collections and museums, bring people closer to cultural relics, realize resource exchange and sharing, and serve the promotion of the Silk Road spirit, China National Silk Museum has issued an initiative to jointly build the Silk Road Online Museum (SROM). The classification of cultural relics is an important step in the construction of digital museums. Compared with ordinary products, the classification of cultural relics is difficult. Specifically, textile cultural relics are more difficult to classify because of the difficulty in preserving materials and poor integrity. Therefore, how to quickly and accurately complete the identification and classification of textile cultural relics has become a problem to be solved.

In view of the above problems, we adopted deep learning to automatically identify the patterns of silk cultural relics. According to the classification method of physical patterns, a sample library including flower patterns, bird patterns, swastika patterns and cloud patterns was established. VGGNet, ResNet and MobileNet were used to classify patterns, and Faster R-CNN, YOLOv5 and SSD target detection algorithms were used to identify and locate patterns. The results show that MobileNet shows better performance in classifying patterns. It has the highest average accuracy amounting to 83.51% on the test set with the least computer hardware resources, which is slightly better than that of VGG16 and ResNet. Among the three target detection models of Faster-RCNN, SSD and YOLOv5, YOLOv5 shows obvious advantages in the recognition of four patterns. When the Score threshold is set at 0.5, the average accuracy of pattern recognition is 8842%. Among the four patterns, the bird pattern has the best recognition effect, with an AP of 95.97%. The AP of the flower pattern, swastika pattern and cloud pattern is 89.52%, 82.23% and 85.95%, respectively.

Based on the superior performance of YOLOv5 demonstrated in this study and the advantages of YOLO in video detection combined with camera equipment, directly marking data with a high degree of confidence can greatly improve the accuracy and speed of classification during the digitization of cultural relics. This can accelerate the establishment of digital museums, effectively reduce the classification threshold of ancient silk patterns, and have a positive impact on the protection and promotion of excellent traditional culture. Future research will aim to achieve recognition closer to the reality of cultural relics and verify the recognition effect of damaged and severely faded patterns. Additionally, building on the experimental results of this study, we can also explore the use of lightweight networks such as MobileNet as the backbone feature extraction network of the target detection model. This will reduce the network’s volume and consumption of hardware resources, allowing for the transplantation of the model to mobile terminals with camera equipment and making target detection possible on archaeological sites. These efforts contribute to the protection of cultural relics in China, particularly the preservation of textile cultural relics.

Key words: silk cultural relics; deep learning; digital museum; target detection; neural network; automatic classification

收稿日期: 20220930;

修回日期: 20230613

基金項目: 国家重点研发计划课题项目(2019YFC1521301);浙江省文物保护专项项目(2021016);浙江理工大学科研启动基金项目(20202214-Y)

作者简介: 孙选铭(1997),男,硕士研究生,研究方向为丝绸历史及其数字化应用。通信作者:苏淼,教授,sumiao2008@qq.com。