细粒度实体分类的研究进展

2023-07-17刘波

刘波

摘 要:细粒度实体分类是自然语言处理中一项重要的基础任务,实体的类别信息为实体链接、关系抽取、事件抽取等下游任务提供帮助。近年来,基于深度学习的细粒度实体分类研究成为热点,该文从处理数据噪声、对类别层级建模、少样本学习和其他一些方法进行了综述性介绍,此外介绍了常见的数据集和评测方法,并对未来的研究方向进行了展望。

关键词:自然语言处理 细粒度實体分类 深度学习 信息抽取

中图分类号:TP391.1 文献标识码:A

Research Progress of Fine-Grained Entity Classification

LIU Bo

(School of Mathematics and Statistics, Hanshan Normal University, Chaozhou, Guangdong Province, 521041 China)

Abstract: Fine-grained entity classification is an important basic task in natural language processing, and the category information of entities provides help for downstream tasks such as entity linking, relation extraction and event extraction. In recent years, the research on fine-grained entity classification based on deep learning has become a hot topic. This paper gives an overview of dealing with data noise, category-level modeling, few-sample learning and some other methods, introduces common datasets and evaluation methods, and prospects future research directions.

Key Words: Natural language processing; Fine-grained entity classification; Deep learning; Information extraction

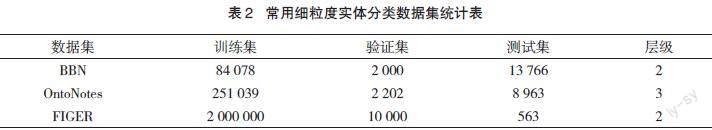

细粒度实体分类任务是给定一个实体和包含这个实体的上下文预测这个实体可能的类别集合。如表1所示,文本为“ Bennett said the city-owned arena lacked the amenities to support an NBA franchise and moved the team to Oklahoma City after failing to secure a new arena here”,任务是识别出给定的实体“NBA”的类别为“organization” 和 “organization/sports_league”。它是很多自然语言处理领域重要的基础工作。细粒度实体分类任务的一个特点就是实体的类别更加细致,如类别有“actor”“sports_team”“car”“power_station”等[1]。常用的细粒度实体分类数据集的类别数量在50-100个左右[2,3]。而且大部分的数据集的类别有层级关系,如粗粒度类别和细粒度类别,如表 1(a)的实体只有粗粒度类别,“/person”, 表 1(b)的实体类别有粗粒度类别“/organization”和细粒度类别“organization/sports_league”。

细粒度实体分类为信息抽取下游任务提供帮助,如在关系抽取中实体的类别信息能够提升关系抽取任务的效果[4]。实体的类别对实体之间的关系有很强的指示性,比如说如果知道头尾实体类别分别是公司和人物,那么实体对之间的关系很可能是建立者这样的关系。另外,实体类别信息也有助于实体消歧。在实体消歧任务中,已经获得了所有的候选实体集。如果知道其指代的知识库中实体应当具有的类别,那么就能从候选实体集中确定应该链接的实体是哪一个。

1基于深度学习的方法

在早期的工作中SHIMAOKA S等人[5]提出了基于注意力机制的模型,通过编码器得到实体的表示和上下文的表示,然后通过一个全连接网络进行预测。XIN J等人[6]提出了KNET模型,使用了语义注意力、实体注意力、知识注意力。实体使用知识图谱中的实体表示。近年来随着预训练语言模型的发展, LIN Y等人[7]使用了预训练语言模型ELMO和BERT进行实体和上下文的表示,而不是在之前的工作中使用的固定的词嵌入。模型不是独立预测每一种类别,而是预测一个低维向量,该向量由潜在类别特征编码,并以这种潜在表示重建类别向量。以上模型使用了注意力机制、预训练语言模型等方法。

2 处理数据噪声

针对远程监督产生的数据噪声问题。XU B等人[8]提出了类似投票的方法,将数据集分成两部分,用其中一部分数据训练多个分类器,并用这些分类器对另一部分数据打标签,若这些分类器都预测某个类别是错误的,则将其从数据中删除,此方法比较简单但效果有限。XU P等人[9]提出的模型将训练数据集划分成纯净集合和噪声集合,对于纯净集合和降噪集合分别建模设置不同的目标函数提高效果。XIN J等人[10]提出使用语言模型来降噪的方法。思想是把文本中的实体替换成类别,正确的类别要比错误的类别得到更加通顺的句子。通过语言模型的作用,可以让模型自动去关注那些符合上下文语境的类别。

3 针对类别层级的方法

针对类别的层级关系, CHEN B等人[11]提出了层次损失标准化的方法,根据类别在分类树中的相关性具有不同程度的惩罚,修正预测的概率。XU B等人[8]将一个实体的所有的上下文和类别汇集起来,然后在类别融合的过程中使用整数规划的方法,将层级关系显式地写成整数规划中的约束,实现类别融合过程中关于层级结构的检查。ONOE Y等人[12]使用盒嵌入来捕获潜在类别的层次结构,即模型不需要已知数据集的类别结构。模型将类别和实体嵌入同一个盒子空间,可以通过盒子的关系确定他们之间的层级关系,用盒子的体积表示概率,可以用来衡量计算一个实体是否属于某个类别的概率。

4 最新的研究

最近人们试图通过使用更丰富、超细粒度的类别集来扩展细粒度实体类别。DAI H等人[13]提出使用掩码语言模型来获取超细实体分类的训练数据。模型将上下文中的实体输入到掩码语言模型中,以便预测实体的上下文相关的超词,它可以用作实体类别标签。借助这些自动生成的标签,超细粒度实体分类模型的性能可以显著提高。DING N等人[14]研究了提示学习在有监督、少样本和零次学习中细粒度实体分类的应用。模型通过构建实体的语言表达器和模板,并进行掩码语言建模,提出了一个简单而有效的提示学习方法。

5 数据集和评估指标

5.1 数据集

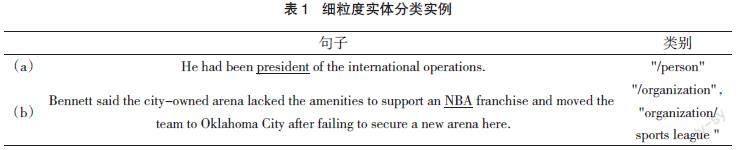

5.1.1 FIGER

数据集从维基百科的文章和新闻报道中取样,在这些文本中的实体被映像到来自Freebase的113个类别中。数据集有47个粗粒度类别,66个细粒度类别[1]。

5.1.2 BBN

数据集的类别层级有两级,标记了《华尔街日报》的Penn Treebank语料库(LDC95T7)中的一部分作为BBN实体分类语料库。数据集有17个粗粒度类别,39个细粒度类别[3]。

5.1.3 OntoNotes

数据集从OntoNotes语料库中抽取句子,并使用类别层级结构中的89种类别对实体进行标注。此数据集的类别有3个层级:一级类别4个、二级类别44个和三级类别41个[15]。

5.2 评估指标

细粒度实体分类任务采用严格的准确率(Strict Accuracy,Acc)、宏平均F1值(Macro-F1 score,MaF1)和微平均F1值(Micro-F1 score,MiF1)进行评估。对于输入![]() ,设预测的类别集合为

,设预测的类别集合为![]() ,设数据集的标注类别集为

,设数据集的标注类别集为![]() 。严格的准确率是满足

。严格的准确率是满足![]() 的實例的比率。宏平均F1值是计算所有样本的召回率和精度的平均值,然后再计算F1值。而微平均F1值是计算所有样本的真阳性、假阴性和假阳性总数,然后计算F1值。3个指标的具体计算公式如下。

的實例的比率。宏平均F1值是计算所有样本的召回率和精度的平均值,然后再计算F1值。而微平均F1值是计算所有样本的真阳性、假阴性和假阳性总数,然后计算F1值。3个指标的具体计算公式如下。

6 结语

综上所述,在细粒度实体分类任务中,研究者主要从处理数据噪声和类别的层级关系建模,以及掩码语言模型、提示学习或更好的嵌入方法等。随着实体分类任务研究的进一步深入,未来有待进一步研究的方向有少样本和零样本学习问题,如何处理新的类别,以及如何结合具体的任务如关系抽取、实体链接等进行细粒度实体分类。

參考文献

[1] LING X, WELD D S.Fine-grained entity recognition[C]//Twenty-Sixth AAAI Conference on Artificial Intelligence.2012:94-100.[2] Ren X,He W,Qu M,et al.Afet: Automatic fine-grained entity typing by hierarchical partial-label embedding[C]//Proceedings of the 2016 conference on empirical methods in natural language processing.2016:1369-1378.

[3] WEISCHEDEL R,BRUNSTEIN A.BBN Pronoun Coreference and Entity Type Corpus[EB/OL].[2005-09-20].https://doi.org/10.35111/9fx9-gz10.

[4] VASHISHTH S,JOSHI R,PRAYAGA S S,et al.RESIDE: Improving Distantly-Supervised Neural Relation Extraction using Side Information[C]//Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing.2018:1257-1266.

[5] SHIMAOKA S, STENETORP P, INUI K, et al. Neural Architectures for Fine-grained Entity Type Classification[C]//Association for Computational Linguistics.In Proceedings of the 15th Conference of the European Chapter of the Association for Computational Linguistics. 2017:1271–1280.

[6] XIN J,ZHU H,HAN X,et al.Put It Back:Entity Typing with Language Model Enhancement[C]//Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing.2018:993-998.

[7] LIN Y, JI H.An Attentive Fine-Grained Entity Typing Model with Latent Type Representation[C]//Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing.2019:6197-6202.

[8] XU B, LUO Z,HUANG L,et al.METIC: Multi-Instance Entity Typing from Corpus[C]//Proceedings of the 27th ACM International Conference on Information and Knowledge Management.2018: 903-912.

[9] XU P, BARBOSA D. Neural Fine-Grained Entity Type Classification with Hierarchy-Aware Loss[C]//Association for Computational Linguistics. In Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1.2018:16–25.

[10] XIN J,LIN Y,LIU Z,et al.Improving neural fine-grained entity typing with knowledge attention[C]//Thirty-second AAAI conference on artificial intelligence.2018.

[11] CHEN B,GU X,HU Y,et al.Improving Distantly-supervised Entity Typing with Compact Latent Space Clustering[C]//Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics.2019:2862-2872.

[12] ONOE Y,BORATKO M,MCCALLUM A,et al.Modeling Fine-Grained Entity Types with Box Embeddings[C]//Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing.2021:2051-2064.

[13] DAI H,SONG Y,WANG H.Ultra-Fine Entity Typing with Weak Supervision from a Masked Language Model[C]//Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing.2021:1790-1799.

[14] DING N,CHEN Y,HAN X,et al.Prompt-Learning for Fine-Grained Entity Typing[J].Association for Computational Linguistics.In Findings of the Association for Computational Linguistics:EMNLP 2022:6888–6901.

[15] GILLICK D,LAZIC N,GANCHEV K,et al.Context-Dependent Fine-Grained Entity Type Tagging[EB/OL]. https://dblp: Context-Dependent Fine-Grained Entity Type Tagging.