基于异构集成学习的多元文本情感分析研究

2023-06-25仲兆满熊玉龙黄贤波

仲兆满 ,熊玉龙 ,黄贤波

(1.江苏海洋大学计算机工程学院,连云港,222005;2.江苏省海洋资源开发研究院,连云港,222005)

文本情感分析主要是对文本的情感极性(积极、消极和中性)进行自动分类、对带有感情色彩的主观性文字进行研判的过程.分析这些蕴含情感的评论可以很好地应用在舆情监控、意见挖掘、搜索排名等领域[1-2],高效精准地提取文本表达的情感已成为当前产业界和学术界的迫切需求,也是目前自然语言处理(Natural Language Pro‐cessing,NLP)领域的一个研究热点.

早期的文本情感分析主要是基于规则与机器学习的方法[3].基于规则的方法依靠人工搭建情感词典,对文本的情感词进行规则匹配,但该方法受限于情感词典的质量,需根据领域需求构建高质量的词典,扩展性差[4].基于传统机器学习的方法需要使用语料库训练分类模型,优点是具有强大的多特征建模能力,但需要人工构建特征,模型泛化能力不强[5].近年来,深度学习在NLP 领域成为重要的研究工具,卷积神经网络(Convolu‐tional Neural Network,CNN)和长短期记忆网络(Long Short‐Term Memory Networks,LSTM)是NLP 领域应用较广泛的两种神经网络模型[6-7].CNN 通过不同大小的卷积核能有效获取文本的局部特征,Kim and Kim[8]第一次将CNN 应用到文本分类任务中,在众多数据集中取得了高效的结果.CNN 虽然可以有效地捕获局部信息,但无法获得句子的长序列依赖关系,使用LSTM 可以弥补这一缺陷.Zhu et al[9]使用LSTM 解决了评论语句情感长距离依赖问题.预测任务可能需要由前面若干输入和后面若干输入共同决定,这样会更准确,Bidirectional‐LSTM(BiLSTM)可以更好地完成上述任务.Pavan and Jayagopal[10]提出基于上下文敏感词典的BiLSTM,在不平衡文本情感分类上取得了很好的效果.虽然上述神经网络在情感分类中取得了较好的效果,但均未在网络中添加注意力机制(Attention Mechanism),因而不能使分类器在识别时集中于部分重要特征.注意力机制源于对人类视觉的研究,可以使神经网络在进行识别时更关注高特征词汇,使识别更准确.Graves and Schmidhuber[11]提出基于注意力机制的BiLSTM 来解决NLP 中的复杂语义问题.Huddar et al[12]提出一种新的基于注意力机制的多模态语境融合策略,使用BiLSTM 结合注意力机制从文本中提取重要的语境信息.值得注意的是,以上情感分类器不仅有各自的优点,也有各自难以克服的弊端,如何应用这些优秀的分类器是一个新问题[13].集成学习是一种新的机器学习范式,它联合多个基分类器来解决同一个问题,能显著地提高分类系统的泛化能力[14].使用集成学习来联合多种分类器进行分类任务可以避免单一分类器的弊端,使集成模型达到扬长避短的效果[15-16],显著提高分类性能.

本文提出一种基于异构分类器的集成学习模型,以提升情感分类性能为目标,从获取高区分度的子词列表和联合多分类器的分类结果两个方面开展理论和实验研究工作.本文的主要创新:

(1)提出基于文本信息熵的朴素贝叶斯(Naive Bayesian)模型作为集成学习模型的基分类器之一,定义文本信息熵,从文本类别间和文本类别内两个角度综合度量文本包含的词汇对文本类别区分的贡献度.根据贡献度的大小实现对n‐gram 低区分度子词的过滤,产生高贡献度子词列表,使朴素贝叶斯的模型达到较高的分类性能.

(2)提出SelfAttention‐BiLSTM,CNN 以及基于文本信息熵的朴素贝叶斯三种模型相结合的异构集成学习模型,创新性地使用模糊积分的方法确定各分类器在各待分类样本上的分类权重,最大化地利用各个分类器的分类结果,最终得到待分类文本的具体类别.

1 相关工作

1.1 集成学习方法简述集成学习是机器学习的重要组成部分,通过组合多个性能相似的模型,使整体模型具有更高的识别准确率和稳定性[17].常见的集成学习方法包括Bagging,AdaBoost 和Stacking.1989 年Dasarathy and Sheela[18]的工作是集成模型的最早案例之一,提出了结合多个分类器的复合分类器系统的概念.Zhang et al[19]利用多个神经网络的集合来提高分类性能.集成学习方法通常根据基分类器的多样性分为同构和异构.通过结合分类器与相似算法来建立同构集成模型,Bagging 和AdaBoost 是最著名的同构集成学习方法.异构集成模型结合不同的分类器[20],如Stacking 就是一种异构集成学习方法,在基层结合不同的分类器,在下一层使用元分类器方法[21].Bagging 和Stacking 由于其集成机制,适用于基模型较多的场景.Bagging 方法也常用于构建在线评论情感分类集成模型[22],但只适用于基分类器较多的情况,否则投票方式会导致模型整体不稳定.本文使用的集成模型是基于Stacking思想建立的异构集成分类模型.

1.2 集成学习在文本情感分析方面的应用情感分析作为NLP 领域的重要任务,旨在判断文本的情感极性.对于如何提高情感分类算法的准确性这一问题,Wan and Gao[23]基于朴素贝叶斯、支持向量机(Support Vector Machine,SVM)[24]、贝叶斯网络[25]和C4.5 决策树[26]等多种分类方法的多数投票原则,提出一种集成的情感分类策略,在推特数据集取得了较好的分类效果.Wang et al[27]用五种基分类器证明集成学习能够作为一种可行的方法用于情感分类.因为强分类器已经在情感分类任务中取得了较好的效果,所以目前的集成技术大都针对弱分类器设计,如何将强分类器应用到集成学习并发挥其优势成为当前的研究热点.Zhang et al[28]针对强分类器提出一种序贯三支决策(Sequential Three‐ way Decision,S3WC)的成本敏感的集成模型,通过将目标分为正区、负区和边界区来减少错误分类代价,使总成本低于其他的集成组合技术,如多数表决、加权平均等,但该方法没有使用同构基分类器和异构基分类器进行扩充实验.Liang and Yi[29]借助三支决策(Three‐way Decision,3WD)方法集成CNN 模型和传统机器学习的方法对文本进行两次分类,对类别模糊文本的分类效果较好.

随着微博服务的兴起,微博情绪分类在舆论监测、商品评估和市场预测等领域得到了大量的研究和应用,集成学习方法以其优异的性能在微博情感分类方面得到了一定的关注.Ye et al[30]采用局部融合和全局融合的集成学习方法进行微博情感分类,在局部融合阶段利用原始特征拼接构造基分类器组合,并将这些分类器组合在全局阶段进行整合,但未能在集成模型中加入深度学习的方法,导致模型构造单一.微博文本较短,很难使用上下文模型将其联系在一起,针对这一问题,Zhu et al[31]在微博情感分析中加入历史用户信息来缓解上下文稀疏问题,并通过大量的实验证实其可行性.尹鹏博等[32]提出一种基于异构深度学习的集成模型,通过二次训练的方式将不同的深度学习分类器组合起来,对微博谣言的检测效果很好,但未能将机器学习的强大表征能力加入模型.Hama and Dimililer[33]将多个基分类器(弱学习者)组合成一个集成分类器,并结合特征集的方式有效改善了社交媒体的情感分类问题.

综上,现有的基于集成学习的多元情感分类模型存在基分类器相似度高、未能充分利用各分类器的优点以及在短文本分类上表现不佳等弊端.本文认为判断集成学习算法是否具有良好的性能,可以从五个方面入手:(1)模型是否具有结合上下文的能力,能学习到多大范围的上下文;(2)模型是否包括注意力机制,能否聚焦高特征词汇;(3)模型是否具有记忆力,能否记忆词汇顺序信息;(4)各个基分类器权重的划分能否联系各个分类器的相互关系;(5)能否解决多元情感数据集类别不平衡问题.本文基于这五个方面开展模型建立工作.

2 模型介绍

2.1 模型概述本文提出一种基于异构分类器的集成学习模型,首先确定基分类器在分类问题中的核心地位,其性能对文本分类的效果起决定性作用.将已经训练好的多个分类器同时用于分类可以取长补短,获得更好的分类效果.选择的第一种情感分类器为SelfAttention‐BiLSTM 模型,由于重要的信息可能出现在句子的任何位置,可以利用BiLSTM 模型获得文本的特征与长距离依赖,通过自注意力机制计算特征的重要性来获得句子中的语义信息.第二种文本情感分类器为CNN,利用不同大小的卷积核来获取文本的不同特征,使用CNN 学习文本的构造特征和语义特征.第三种文本情感分类器为基于文本信息熵的朴素贝叶斯方法,创新性地提出文本类别内和文本类别间熵值来筛选最大特征子词,结合朴素贝叶斯对待分类文本进行分类,通过模糊积分的方式确定各分类器在每个待分类文本上的权重系数,最大程度地利用各分类器的分类结果.针对多元数据集类别不平衡问题,使用随机欠采样和随机过采样方法处理数据集,最大程度地提高模型的分类效果.整体模型如图1 所示.

图1 本文模型的总体框架Fig.1 The general framework of our model

2.2 SelfAttention⁃BiLSTM 模型情感分析任务中的输入序列具有时间特征,BiLSTM 可以联系文本的上下文和捕捉双向语义依赖来实现对信息的过滤.BiLSTM 构造了两个LSTM 神经网络,从两个相反的方向获取信息,更有利于从整体上记忆句子的长依赖关系以及文本的深层次语义表达.对于微博短文本数据,采用BiLSTM 模型比LSTM 模型分类更加准确和有效,BiLSTM 的前后两个LSTM 网络的结构是一致的.LSTM 由三种门构成,即输入门、遗忘门和输出门,通过这三种门来控制信息传递,单一的LSTM 的记忆单元在t时刻的前向计算过程如下所示.

其中,{W*,b*}是神经网络训练的参数集合it,ot分别表示t时刻记忆单元的输出单元、遗忘门、输入门和输出门的输出值,ht-1和xt分别表示t时刻上第一个记忆单元以及当前记忆单元的输入,Ct表示t时刻记忆单元的内部状态,ht表示t时刻记忆单元的输出.

BiLSTM 模型可以增加文本逆向语义的学习,通过连接正反两个方向的LSTM模型输出向量作为t时刻的BiLSTM的输出,即上下文的语义关系Bt,如式(5)所示:

BiLSTM 考虑文本的时序信息并结合上下文来进行特征分类,但很难捕获不同词汇的重要性和获取细粒度的情感特征.对于微博文本这种复杂且带有多种特殊词语的长句,单独使用Bi‐LSTM 模型不一定能准确地获取特征信息.针对这个问题,考虑到自注意力机制可以在文本关键信息上分配足够的关注度,聚焦重要信息,故选用SelfAttention‐BiLSTM 算法作为基分类器之一.自注意力机制函数attention(Q,K,V)的本质可以被描述为一个查询(query)一系列键值对(key‐value)的映射,如式(6)所示:

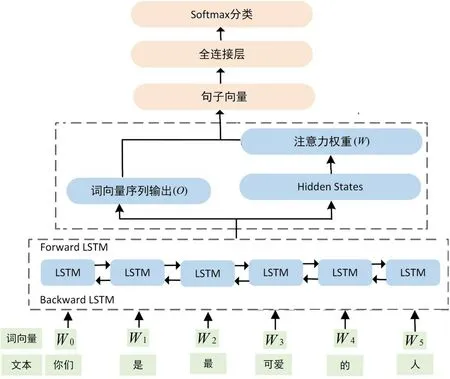

其中,Q,K,V均为向量形式,且表示Q,K的维度.起调节的作用,控制Q和K的内积不太大.自注意力机制就是在序列内部寻找文本的联系,在词语层面添加自注意力机制可以得到一段文本内不同词语的重要性.模型如图2 所示,首先将文本词汇向量输入BiLSTM,BiLSTM 输出每个时间步的词向量序列输出(O)与最后时刻的Hidden States(H).注意力权重向量设置为Wattention,使用注意力机制计算句子向量(V),计算步骤如式(7)和式(8)所示:

图2 BiLSTM⁃Attention 模型框架Fig.2 The framework of BiLSTM⁃Attention model

得到句子向量V后,通过全连接层和Softmax函数输出待分类文本所属各个类别的概率.

2.3 基于文本信息熵的朴素贝叶斯模型朴素贝叶斯分类器(Naive Bayes Classifier)建立在“全概率公式”的基础上,是一种基于统计的概率模型算法.文本分类中,该算法认为文本中词语之间的关系是统计独立的,即每个文本的特征向量中的每个维度都是相互独立的.其定义为:设x={a1,a2,…,am}为一个待分类文本,每个ai为x的一个特征属性,类别集合C={y1,y2,…,yn},计算计算条件概率就是找到一个已知分类的待分类项集合,即训练集,计算训练集数据得到各个类别下各个特征属性的条件概率估计.设各个特征属性条件独立,根据贝叶斯定理,计算如式(9)所示:

由式(9)可推出极大后验概率,得到待分类文本的最大可能性类别,如式(10)所示:

本文提出基于文本信息熵的朴素贝叶斯算法.首先,使用文本信息熵将找出的文本的高特征且具有区分能力的情感词汇,提取出来后再与朴素贝叶斯模型结合,提升文本分类效果.

文本信息熵从文本类别间和文本类别内两个角度得到一个词语对文本类别的区分能力,再得到针对该突发事件语料库的高区分能力词汇列表.通过设置文本信息熵阈值获取领域情感词汇集合,对高区分能力词汇进一步判断极性和分配权重即可得到突发事件领域情感词典.文本信息熵的原理基于信息熵(Information Entropy).信息熵是一个系统内信息含量不确定性程度的量化指标,假设任意概率事件x发生时产生n种相互独立结果的概率分别为p(xi)(i=1,2,…,n),那么事件x的信息熵H(x)可按式(11)计算:

由式(11)可知,信息熵是一个概率事件所含信息量多少的数学期望.若该事件产生某种结果的不确定性程度越高,表明该事件所含的信息量越小,信息熵H(x)随之减小,反之则增大.根据信息熵的原理,定义文本信息熵在类别间与类别内的计算原理如下.

假设某语料库有K个类别(c1,c2,…,ck)的文本,每个类别包含N个文本(t1,t2,…,tN),词语w在各个类别中出现的次数为(g1,g2,…,gK),在ck类别内N个样本中出现的次数为(s1,s2,…,sN).

定义1 词语类别间信息熵H1(w)主要用于在不同的类别之间衡量词语w对类别的区分能力.词语w在各类别中的概率分布较均匀,表明该词语对类别区分的能力较小,否则表示区分能力较大.由信息熵的定义可知,词语类别间信息熵的大小应与式(11)中信息熵的值成反比,其计算如下:

定义2 词语类别内信息熵H2(w)主要用于从相同的类别内来衡量词语w对类别区分能力的大小.与词语类别间信息熵相反的是,词语w在类别内的概率分布较均匀,表明该词语有较大的类别区分能力,否则区分能力较小.词语类别内信息熵的大小与式(11)中信息熵的值成正比,其计算如下:

定义3 文本信息熵HE(w)结合式(12)与式(13),得到词语w的文本信息熵的定义HE(w),根据文本信息熵值的大小,可以得到具有高类别区分能力的词汇集合.

由以上分析可知,文本信息熵的定义以及计算设计适用于度量n‐gram 子词对于文本类别区分的贡献度.实现对低类别区分贡献度子词的过滤,可以得到具有高类别区分能力的情感词汇集合,再联合使用朴素贝叶斯得到待分类文本所属各类别的概率,从而得出待分类文本类别.整体模型框架如图3 所示.

图3 基于文本信息熵的朴素贝叶斯模型Fig.3 Naive Bayesian model based on text information

2.4 卷积神经网络CNN 最初用于处理图像问题,但在自然语言处理中,使用CNN 进行文本情感分类也得到了很好的应用.文本中的每个词都可以用一个行向量来表示,一句话可以用一个矩阵来表示,然后使用CNN 中的卷积层提取文本数据的局部特征,CNN 的卷积层通过大小不同的卷积核来提取不同的局部特征.假设句子包含m个词(a1,a2,…,am),ai∈Rk是句子中第i个词,k代表每个词由k维向量表示,卷积核w∈Rn×k与ai:i+n-(1n个词)进行卷积操作,再使用激活函数得到对应的特征si,如式(15)所示:

其中,f为激活函数,b为偏置.在训练神经网络时输入神经元线性组合,通过激活函数完成非线性映射.采用Relu 函数作为激活函数来加快模型的收敛速度,Relu 函数的表达如式(16)所示:

通过卷积核w对输入数据进行卷积,可以得到特征图S,如式(17)所示:

CNN 池化层在特征图S的基础上提取具有明显特征的情感表达词汇,然后使用全连接层进行最终的概率分类.

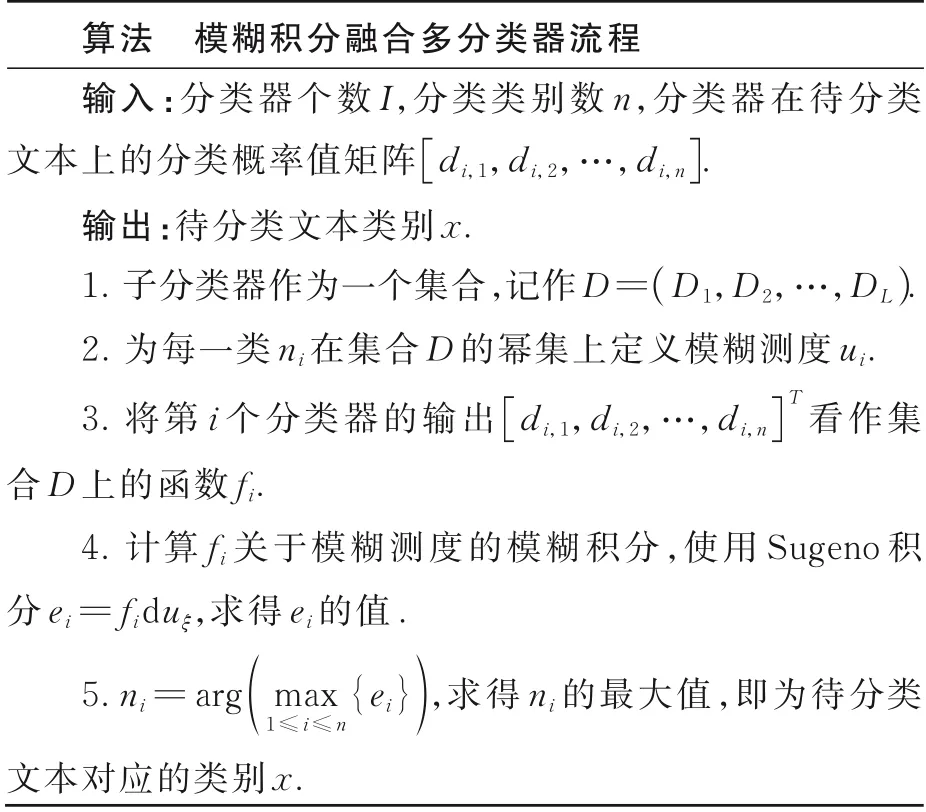

2.5 模糊积分在进行分类器组合时,加权平均是一种常用的方法,但在许多实际应用中,若干个分类器之间不是相互独立的,而是存在交互影响.模糊积分是分类信息融合过程中常用的一个融合算子.将分类器之间的交互影响考虑进来,能提高融合系统的分类精度,增强系统的容错性.Sugeno[34]提出的模糊积分原理是建立在模糊测度[35]上的概念,模糊测度可以表达分类器间的交互作用,这里的交互作用目前不能确定为统计学中的相关性,但可以理解为分类器融合过程中分类器间的相互影响和任意组合表达的重要性.模糊测度是一个非负非可加集函数,其非可加性恰恰可以用来描述分类器之间的交互作用.基于模糊积分的多分类器融合方法是一种扩展的加权平均法,根据分类器输出和对应的模糊测度来动态地输出整体集成的结果,使集成分类器获得比最优的单个分类器更好的性能.在基于模糊积分的多分类融合系统中,需要分类器输出的是非负实数向量,范围为[ 0,1 ],对于一个n分类问题,分类器的输出是非负实数值的n维向量,第i个分类器的输出形式为[di,1,di,2,…,di,n],表示第i个分类器判定待识别样例属于某个类ni的概率,其中di,j∈[ 0,1 ](j=1,2,…,n).把所有子分类器作为一个集合,记作D=(D1,D2,…,DL),为每一类ni在集合D的幂集上定义模糊测度ui.接下来使用模糊积分来综合分析各个分类器对未识别样本x的输出,得出未识别样本最终可能属于某个类别的程度值ei,ei也可被理解为是某种类别的概率.计算样例属于类别ni的可能性时,把第i个分类器的输出[di,1,di,2,…,di,n]T看作集合D上的函数fi.使用Sugeno 积分[36]计算fi关于模糊测度的模糊积分,即求积分器ei的值,如式(18)所示:

系统把最大可能性对应的类作为待分类文本的分类结果,如式(19)所示:

模糊积分算法的流程如下所示.

2.6 不平衡数据分类策略多元情感分类往往是少数几类情感占主要部分,为了获取更优的分类性能,分类器会倾向多数类而忽视少数类,导致分类效果降低.本文利用过采样和欠采样对原本分布不平衡的数据进行调和,使分布趋于平衡,具体操作如下.

(1)过采样:过采样通常对少数类样本进行处理,通过重复采样或合成新的少数类样本来增加少数类样本数量,提高分类器对少数类的识别度,提升算法的分类性能.本文使用的过采样方法是随机过采样,即随机重复复制少数类样本.

(2)欠采样:欠采样通常对多数类样本进行处理,在多数类样本中选择与少数类样本数量大概一致的样本,再与所有少数类样本结合组成平衡数据集.本文使用的是随机欠采样.

2.7 投票法投票法是一种遵循少数服从多数原则的集成学习模型,通过多个模型的集成来降低方差,提高分类模型的鲁棒性,理想情况下投票法的预测效果优于任何一个基模型的预测效果.投票法可分为回归投票法与分类投票法,分类投票法又可以被划分为硬投票(Hard Voting)与软投票(Soft Voting).硬投票法的预测结果是所有投票结果中出现最多的类,软投票法的预测结果是所有投票结果中概率加和最大的类.由于软投票法考虑了预测概率这一额外的信息,可以获得比硬投票法更准确的预测结果.软投票法可以认为是加权投票法的一个特例,即各分类器的权重W均为1.软投票法可以先为每个弱学习器分配权重,将学习器预测的概率乘以学习器的权重再取平均,然后导出平均概率最高的类标签,作为该测试数据的标签.

软投票法的具体计算过程如表1 所示.假设有三个训练好的分类器,并且要被分类的问题是一个三分类问题,给每个分类器分配的权重W都为1.观察表1 可见,每一列每个分类器的预测概率和为1,如分类器1 对三种类别预测的概率为0.2,0.5,0.3,它们的和为1.在此基础上各分类器乘以事先分配好的权重,最后计算每个类别的加权平均.如类别1 的结果由(W1×0.2+W2×0.3+W3×0.4)/3 计算得出,加权平均后的计算结果最大的是0.5,所以该测试数据的标签为2.

表1 软投票的计算过程Table 1 The calculation process of soft voting

3 实验过程、结果与分析

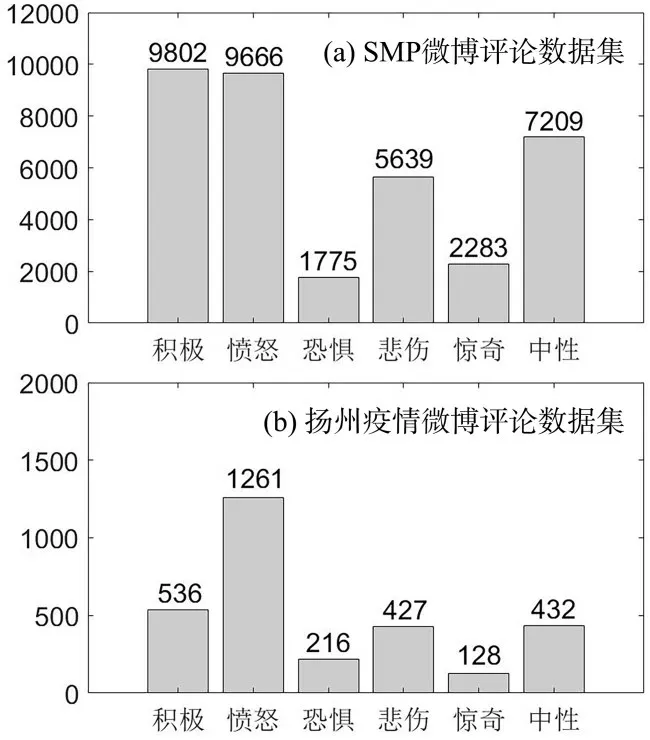

3.1 数据集及数据预处理实验使用了两个数据集,第一个是由中文信息学会社会媒体处理专委会主办、哈尔滨工业大学承办的SMP2020 微博情绪分类技术测评比赛提供的微博评论数据.本文使用其提供的通用数据集,每个主题被标记了积极、愤怒、恐惧、悲伤、惊奇和中性六类情感,其中积极、愤怒、中性占数据的主要部分.第二个是从新浪微博爬取的2021 年部分扬州疫情评论数据集,时间区间为2021 年7 月30 日至2021 年8 月30日,共计两万条微博评论文本.筛选其中部分语料资源并用人工标注微博评论文本的情感极性,得到3000 条情感分类文本,包括积极、愤怒、恐惧、悲伤、惊奇和中性六类情感.两个数据集的总体分布如图4 所示.

图4 两个数据集的情感类别分布Fig.4 Distribution of sentiment categories of the two datasets

两个数据集均含有大量噪声,需要对语料进行预处理以便后续的应用操作,具体操作包括去除用户名,去停用词、特殊符号等.使用jieba 分词对文本进行分词,使用Bert 预训练模型训练词向量模型,词向量维度为300,训练批次大小(batch‐size)为64,Dropout 设置为0.2.训练集与测试集的比重为0.2∶0.8,优化器为Adam,学习率为1e-5.对于CNN 模型,卷积核设置为5.对基于文本信息熵的贝叶斯模型,使用2‐gram 进行文本的分词与输入.数据集的部分实例如表2 所示.

表2 数据集的实例Table 2 Examples of datasets

3.2 评价指标采用Macro_F1 和准确率(Accu⁃racy)作为评价指标.与二分类相同,准确率为预测正确的样本占总样本的比例.

3.3 实验分析与讨论设置三组对比模型实验,每种模型均运行30次,取平均值.第一组为完全训练组,不对数据集进行过采样和欠采样处理,设计对比实验如下:

(1)基于文本信息熵的朴素贝叶斯的情感分类,使用2‐gram,命名为NBC‐IE.

(2)普通的朴素贝叶斯模型,使用2‐gram,命名为NBC.

(3)基于卷积神经网络进行情感分类.

(4)基于自注意力机制结合双向长短期记忆网络进行情感分类,命名为SelfAttention‐Bi‐LSTM.

(5)基于SentiXGboost 模型[33]的情感分类,使用2‐gram,基分类器包括朴素贝叶斯、K近邻算法、逻辑回归、随机森林、决策树.其他参数使用文献[33]中的默认参数.

(6)基于3WD‐AdaCNN‐SVM 模型[29]的情感分类,词向量采用Word2vec,采样数T设置为5,其他参数使用文献[29]中的默认参数.

(7)基于SelfAttention‐BiLSTM,CNN,NBC‐IE 三种模型的情感分类,使用硬投票法进行模型融合,命名为ANC‐H.

(8)基于SelfAttention‐BiLSTM,CNN,NBC‐IE 三种模型的情感分类,使用软投票法进行模型融合,命名为ANC‐S.

(9)本文提出的基于SelfAttention‐BiLSTM,CNN,NBC‐IE 三种模型的情感分类,使用模糊积分进行分类器的权重分配,命名为ANC‐F.

第二组为欠采样实验组,在完全训练组的基础上对数据集进行随机欠采样,使多数类的数目趋近少数类别,再使用上述九种模型进行训练.

第三组为过采样实验组,在完全训练组的基础上对数据集进行随机过采样,使少数类的数目趋近多数类别,再使用上述九种模型进行训练.

完全训练组的模型在测试集上的实验结果如表3 所示,由表可见,本文方法在SMP 与扬州疫情微博评论数据集上均取了得较好的结果.前三种基分类算法SelfAttention‐BiLSTM,CNN,NBC‐IE中,SelfAttention‐BiLSTM 的效果最好,这主要得益于注意力机制对语句关键性词语的聚焦以及BiLSTM 对双向语义依赖的捕捉.NBC‐IE 的准确率在两个数据集上均取得了超过70%的优秀效果,主要是因为通过文本信息熵得到了对文本分类具有高贡献度的词汇集,加强了贝叶斯模型的分类效果.与SentiXGboost,3WD‐AdaCNN‐SVM,ANC‐H,ANC‐S 和本文ANC‐F五种模型对比,本文方法仅在SMP 微博评论数据集上的表现略逊于3WD‐AdaCNN‐SVM,在扬州疫情微博评论数据集上的表现均优于其他方法,因为基于模糊积分的多分类器融合方法是一种扩展的加权平均法,它根据分类器输出和对应的模糊测度来动态地输出整体集成的结果,使集成分类器获得了比最优的单个分类器更好的性能.3WD‐AdaCNN‐SVM 也取得了不错的效果,该方法借助三支决策并通过SVM 对分类结果不确定的文本进行二次分类,可以很大程度地提高分类准确率.软投票法(ANC‐S)的效果也要好于硬投票法(ANC‐H),因为硬投票法根据少数服从多数来确定最终的结果,而软投票法将模型预测样本为某一类别的概率的平均值作为标准,概率最高的对应类为最终的预测结果.软投票法考虑了预测概率这一额外的信息,因而可以得出比硬投票法更准确的预测结果.

表3 完全训练组的模型在两个数据集上的实验结果Table 3 Experimental results of the model under com⁃plete training group on two datasets

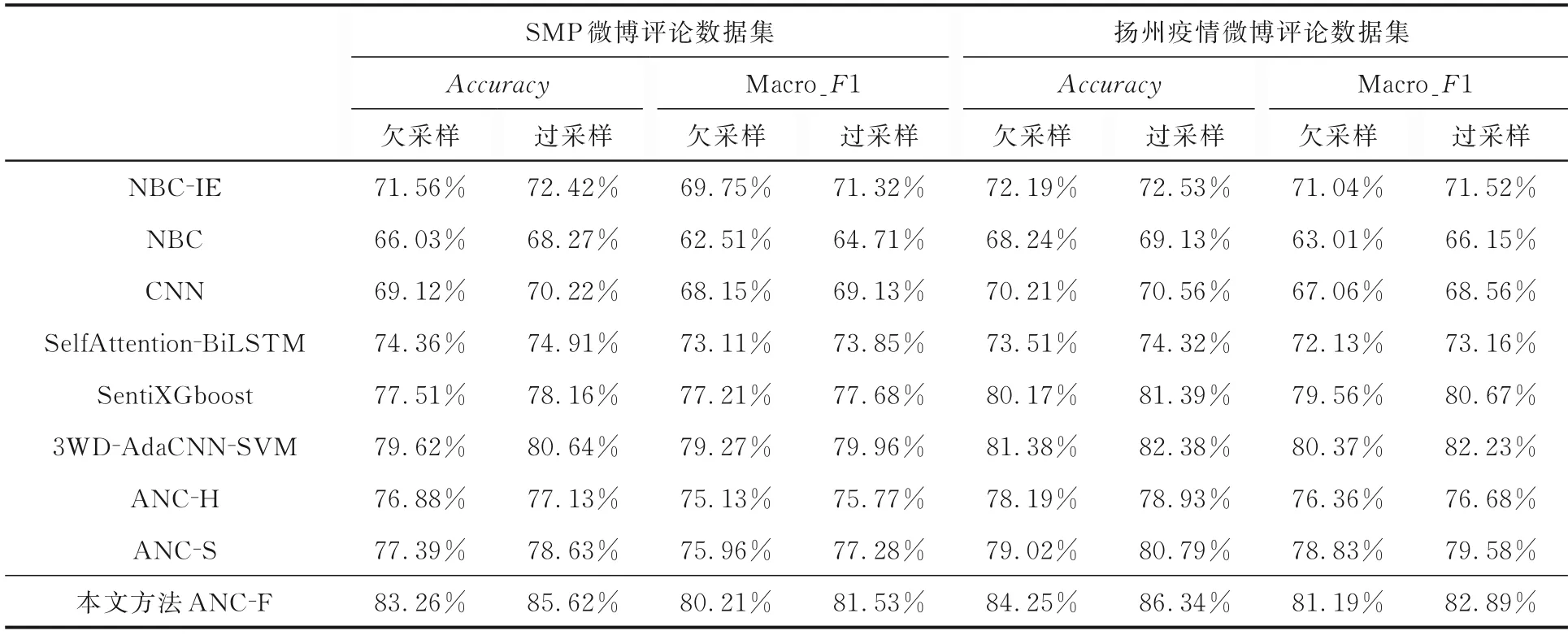

表4 给出了欠采样与过采样实验组的实验结果,由于数据集是不平衡的,其中的少数类别的错分代价更高,分类模型倾向多数类,忽略了少数类,造成少数类的分类准确率低.由表可见,对不平衡数据集进行采样处理能明显提升模型的分类效果,其中SentiXGboost,3WD‐AdaCNN‐SVM以及本文方法取得了较好的效果,本文方法在两个数据集上的指标都是最好的.证明对数据集进行采样处理能提升集成模型的分类效果,而过采样使本文方法的效果有明显提升,在各项指标的对比中均取得了最高的值.

表4 各模型在两个数据集上欠采样与过采样的指标对比Table 4 Indicator values of the under⁃sampled and oversampled models on the two datasets

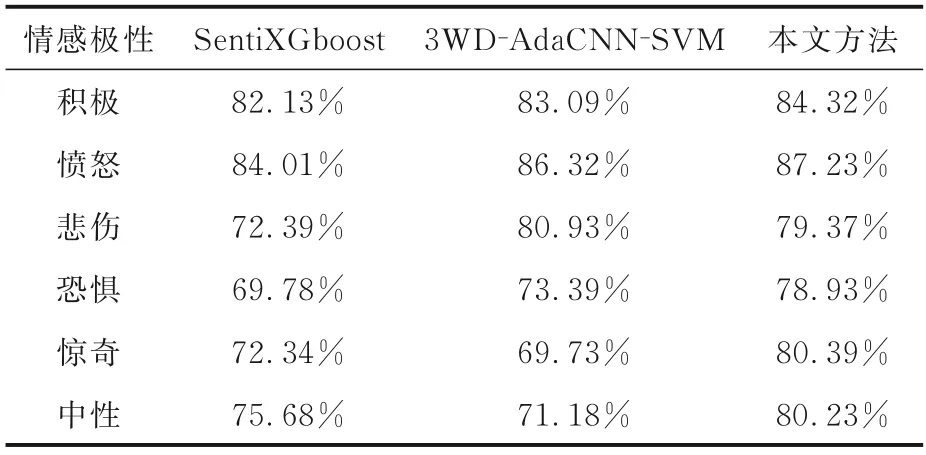

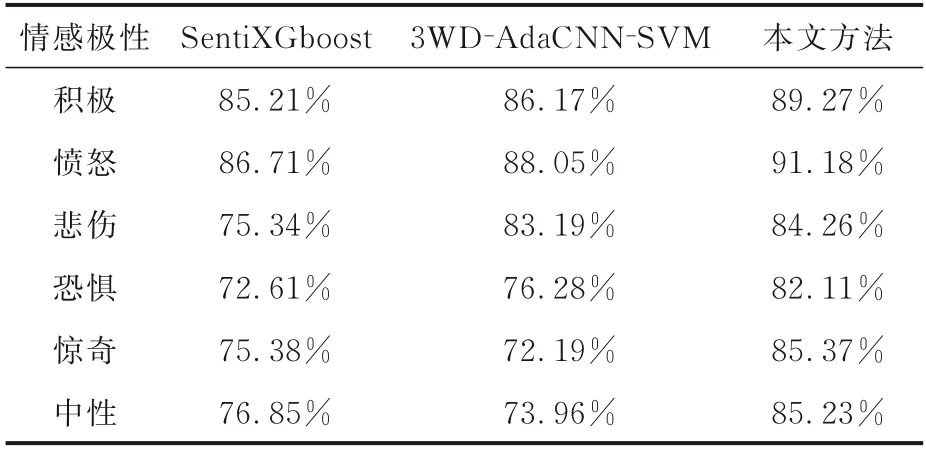

表5 和表6 给出了本文模型与两种主要的对比模型在两个数据集上进行过采样处理后,在各个情感类别上进行单独分类的Macro_F1.由表可知,在SMP 与扬州疫情微博评论数据集上,恐惧、惊奇和悲伤这三种情感的极性较少,通过过采样处理与集成模型的分类后也能得到较高的Macro_F1.本文提出的方法对单个情感极性的分类,其效果好于两种对比算法,这是由于本文方法ANC‐F 表达了分类器间的交互作用,针对每一个待分类文本分配给各基分类器一个自适应权重,动态地输出整体集成的结果.这使模型在少数类别上得到了较高的Macro_F1,整体准确率更均衡,所以没有出现不同类别间分类效果差距过大的情况,证明本文提出的模型不仅提升了分类指标,在不平衡数据集上也可以取得很好的分类效果.

表5 本文算法和两种对比方法在SMP 通用微博评论数据集上经过采样处理后的Macro_F1Table 5 Macro_F1 of our algorithm and other two al⁃gorithms with oversampling on the SMP generic microb⁃logging dataset

表6 本文算法和两种对比方法在扬州疫情微博评论数据集上经过采样处理后的Macro_F1Table 6 Macro_F1 of our algorithm and other two al⁃gorithms with oversampling on the Yangzhou epidemic microblogging dataset

4 结论

针对多元文本情感分类面临类别间界限模糊、提取特征不充分等问题以及现有的基于集成学习的情感分类模型存在基分类器相似度高、未能充分利用各分类器优点等弊端,本文从结合上下文的能力、是否包含注意力机制、是否记忆词汇顺序信息、能否解决多元情感数据集类别不平衡问题以及各个基分类器的权重划分能否联系各个分类器的相互关系这五个方面建立情感分析集成模型.三种基分类模型分别为SelfAttention‐Bi‐LSTM,CNN 和NBC‐IE.SelfAttention‐BiLSTM可以很好地提取句子中的关键词语,并考虑到文本的时序信息和关键信息,是三种基分类器中效果最好的.NBC‐IE 是本文提出的创新性的方法,从文本类别间和文本类别内两个角度生成具有较高区分力的训练样本集,提高了贝叶斯的分类效果.CNN 通过设置大小不同的卷积核提取文本的局部特征.最后,通过模糊积分的方式确定各分类器在各待分类样本上的分类权重,最大程度地利用各分类器的分类结果来提升分类的准确性.并且,对数据集使用过采样与欠采样操作,使模型在不平衡数据集上进一步提升了分类效果.

未来将进一步确定各个分类器之间分类结果的相互作用的影响以及优化模糊积分在集成学习中的应用场景,以期高效、精确地确定最优阈值,进一步提升模型的文本分类性能.