国际学生技术与工程素养评估项目的比较研究

2023-05-30顾乃景

顾乃景

[ 摘 要 ] 为促进我国技术与工程教育的发展,提升学生科学与技术素养水平,实现“以评促教”“以评促学”,从框架目标和项目特点两方面出发,比较分析ICILS 2018与NAEP TEL 2018两种典型模式的异同,得出两者在维度划分、重视情境、采用量规等方面存在相似点,在评估重点、试题分布、编制依据等方面存在不同点的结论。结合我国实际,提出了科学与技术素养评估今后的发展思路:统一课程标准,完善评估体系;明确评估目标,构建三维架构;营造真实情境,提升解决能力;凸显整体平衡,科学编制试题;重视人机交互,增强现实体验;强化过程评价,实现“质”“量”结合;重视环境影响,改进后续教学。

[ 关键词 ] ICILS 2018;TEL 2018;技术与工程素养;比较研究

[ 中图分类号 ] G632.0 [ 文献标识码 ] A [ 文章编号 ] 1005-4634(2023)02-0009-09

当今,作为促进经济增长和提升国家竞争力的重要战略,STEAM教育日益成为全球教育变革的核心议题。21世纪以来,技术与工程的重要性不断增加,而作为STEAM教育重要组成部分,除艺术(Art,A)外,技术(Technology,T)与工程(Engineering,E)相较于科学(Science,S)及数学(Mathematics,M)长期以来“评估核心学科”的地位而言[1],重视程度及相关评估力度严重不足。

技术与工程素养评估作为评价学生科学素养的有效方式,对技术与工程教育的发展、学生技术与工程素养水平的提高起着重要的导向作用。由国际教育成就评价协会(International Association for the Evaluation of Educational Achievement,IEA)主持的国际计算机与信息素养研究项目(International Computer and Information Literacy Study,ICILS)和美国国家教育评测中心(National Center for Education Statistics,NCES)推行的美国NAEP技术与工程素养评估(NAEP Technological and Engineering Literacy Assessment,NAEP TEL)作为当前国际上大规模评估学生技术与工程素养的典型模式,其成熟的运作体系对我国的科学素养评估有着重要的借鉴意义[2]。本研究从“测什么”(即架构目标)和“怎么测”(即项目特点)两方面来比较ICILS 2018和NAEP TEL 2018(以下简称TEL 2018)评估体系的异同,归纳有益经验,从而为我国的技术与工程素养评估及相关问题研究解决提供参考建议。

1 架构目标的比较

1.1 总体框架

在框架设计目的方面,ICILS 2018的主要目的是“系统评估学生为实现一系列不同目的,从而利用信通技术能力的有效度”,次要目的是“调查学生、教师使用计算机与其他数字设备的情况,以及对使用计算机技术的态度”[3]。而TEL 2018突出“作为数字信息时代NAEP评估的重要补充”特点,主要包括三个目的:一是评估学生对技术与工程知识的掌握程度;二是了解技术和工程知识在日常生活中的使用程度;三是了解工程师设计和开发技术的程度。

在具体框架内容(或维度)方面,ICILS 2018包含两个维度:“领域”(Areas)、“情境”(Contexts/Contextual Factors);TEL 2018包含三个维度:“领域”(Areas)、“实践”(Practices)及“情境”(Contexts)。

1.2 内容领域

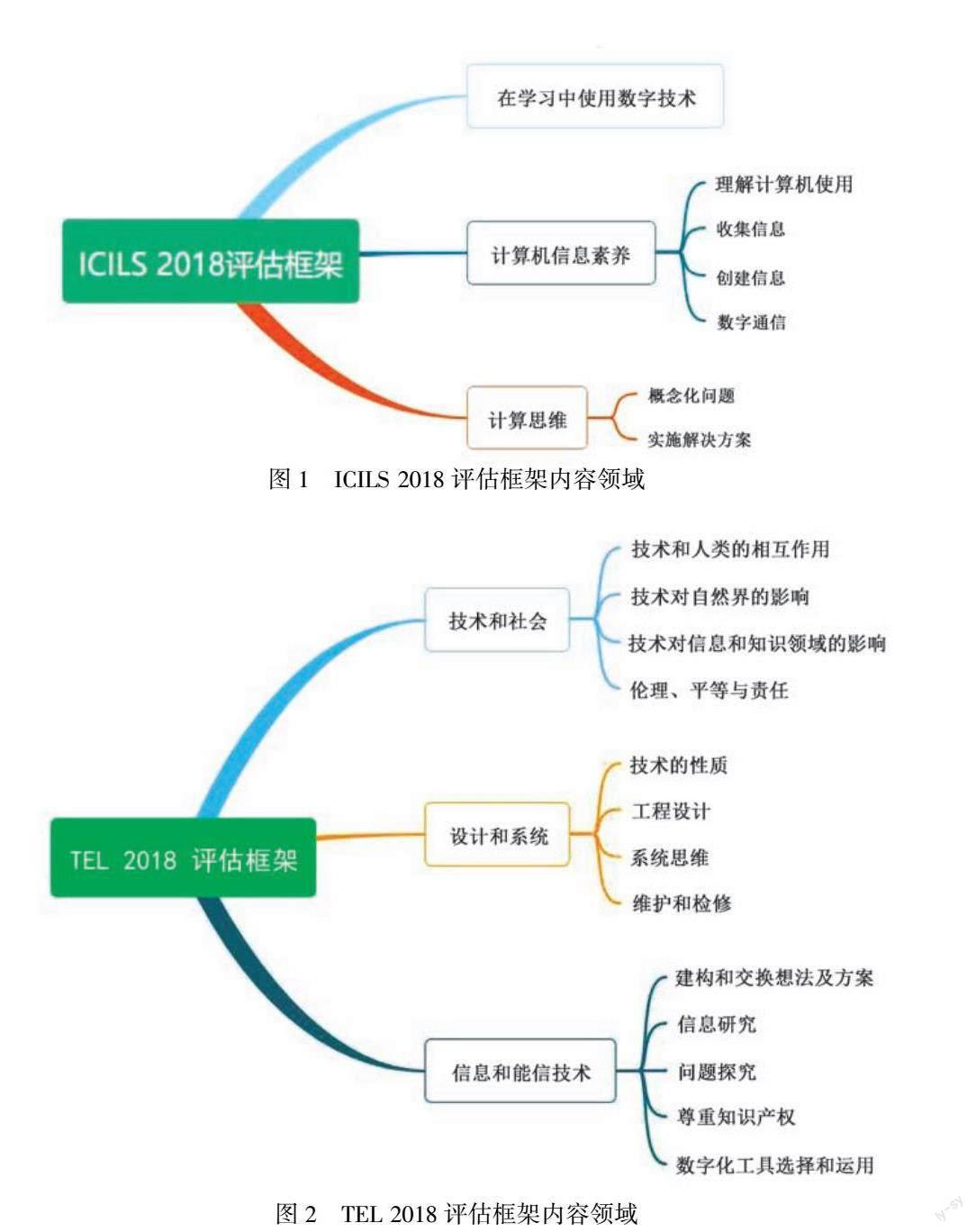

ICILS 2018主要涉及三个核心领域:计算机与信息素养(Computer Information Literacy,CIL)、计算思维(Computational Thinking,CT)、学习中使用数字技术(Use of Digital Technologies in Learning)。TEL 2018也包含三个领域:技术与社会(Technology and Society,TS)、设计与系统(Design and Systems,DS)、信息和通信技术(Information and Communication Technology,ICT)。ICILS 2018和TEL 2018各自三大领域都有具体的子领域,且子领域又包含具体的评估方面(见图1、图2)[4]。

就核心领域看,ICILS 2018基于其“系统评估学生利用信通技术能力的有效度”的主要目标,将计算机与信息素养(CIL)定义为“个人使用计算机进行调查、创造和交流的能力,以便在家庭、学校、工作场所和社会生活中得到有效参与”;计算思维(CT)定义为“个人识别现实世界问题的各方面的能力,采用计算公式,评估和开发解决问题的相关方案,并实施以相关计算机操作”。值得一提的是,ICILS 2018首次创造性地对学生的计算思维进行了大规模国际测评,这为各国深入理解计算思维、把握學生计算思维发展状况、明确相关影响因素等提供了科学有效的途径与工具。在TEL 2018方面,将技术与社会(TS)定义为“涉及技术对社会和自然的影响,以及由此产生的伦理问题”;设计与系统(DS)定义为“涵盖技术的性质、开发设计及日常处理的基本原则,包括相关维护及故障排除”;信息和通信技术(ICT)定义为“包括计算机和软件学习工具、网络系统协议、数字化设备及获取、新建和推进创造性表达的其他技术”[5]。由此可见,TEL 2018对“技术与工程”的关注比ICILS 2018对“计算机信息素养及计算思维”的关注更广泛。

1.3 情境方面

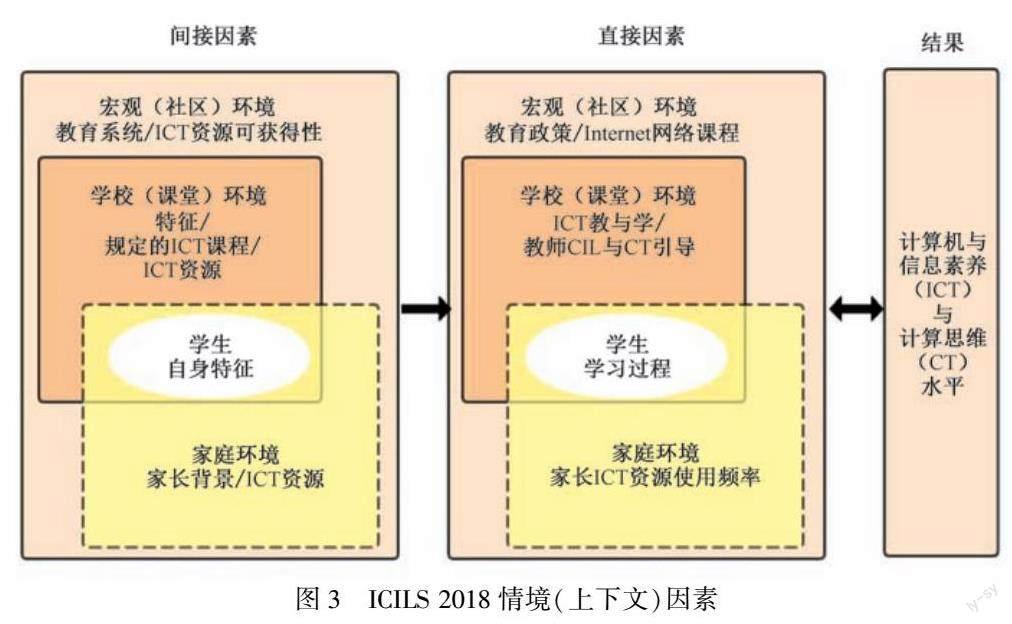

情境,即上下文因素,是ICILS 2018及TEL 2018评估的重要方面。ICILS 2018强调将测评设置在校内外不同影响因素之下,让学生通过自身不同知识经验来解决系列问题(见图3)[3]。ICILS 2018认为影响学生计算机与信息素养(CIL)及计算思维(CT)水平的背景因素复杂,如不同的学习场所、不同的家庭环境以及学生自身经历,等等。ICILS 2018将其细化为四个方面,一是宏观(社区)环境:学生计算机与信息素养、计算思维学习的广泛背景,如整个教育系统、教育政策等;二是学校(课堂)环境:学校及课堂条件,包括学校的ICT课程、教师引导能力等;三是个人因素:学生自身特征,如年龄、性别、学习动机等;四是家庭环境:学生的家庭背景特征,如家长的社会经济地位、学生ICT资源使用频率等。图3 ICILS 2018情境(上下文)因素

由图3可见,宏观环境对个人、家庭及学校环境均产生作用,其中学生成长受到学校和家庭环境的双重影响。按照关联程度,ICILS 2018将影响学生信息素养的情境分为间接因素和直接因素。间接因素,也称前置因素,即限制学生信息素养的外在条件,如家长的社会经济地位;直接因素,也称过程因素,即影响学生信息素养的直接条件,其受间接因素及更高层次因素的影响,如课堂中教师CIL与CT的引导能力[6]。上述提到的个人、家庭、社区、学校四个层次都涉及到间接因素和直接因素。其中,间接因素直接作用于直接因素,如教育系统的相关特征决定着Internet网络课程的设置[7];直接因素与结果相互影响、相互制约,如学生在家庭中ICT资源使用频率越高,其计算机与信息素养越高,反过来又在一定程度上增进了学生ICT资源使用的频率,从而形成了一个良性循环。

TEL 2018围绕“社会议题(Issues)”“设计问题(Problems)”“学校和社区目标(Goals)”三方面,突出“将相关任务及问题设置于相关情境下”的理念,重在获取真实的学生测试及反应数据[1]。由于三个领域内问题类型、测试目标侧重点不同,评估项目的背景情况也会有所不同[8]。四年级、八年级和十二年级学生的评估难度由“相对简单”到“相对复杂”递进。以八年级学生为例,其信息与技术素养评估的三个领域情境各不相同(见表1[4]),在每个领域对应的子领域(及情境下)下,又包含着相应的核心原则和具体的情境描述(见表2[4])。

1.4 实践方面

实践是技术与工程素养的重要内容。在ICILS 2018方面,虽未明确提出“实践”这一概念,但其着重强调“在学习中使用数字技术”,并提出“使用计算机进行调查、创造和交流的能力,以便在家庭、学校、工作场所和社会生活中有效参与”,突出数字技术运用的重要性,足见其对“实践”的重视程度。而在TEL 2018层面,将“实践”定义为“对学生技术与工程思维及推理的期望”,即期望学生在实际生活中展现出其对技术知识和技能的理解和运用。TEL强调学生所进行的实践活动是带有“普遍性”和“跨领域”特点的推理过程,并将其分为“理解技术原则”“设计方案与实现目标”以及“交流与合作”[1]。由此可见,ICILS 2018与TEL 2018均重视“实践”的作用,即要培养一个精通技术与工程知识,且思维活跃、推理和行动能力强的人。

此外,评估的内容领域、实践和情境三者构成了TEL 2018评估的三维架构。由图3[4]可知,整个架构由内到外分别为三个内容领域、三个实践目标和三种情境。其中,内容领域构成了一个三面金字塔,显示了其基础作用。而最外侧为情境,充分展现了“内容领域与实践都依赖于情境的实现”这一理念[9]。

2 项目特点的比较

2.1 试题类型分布

ICILS 2018针对计算机与信息素养(CIL)和计算思维(CT)两大内容领域,采用“模块”概念,将整个测评分为CIL和CT两个测试模块,并将相关模块划分为六种任务类型,其中:CIL测试模块包含基础信息响应任务(Information-Based Response Tasks)、技能任务(Skills Tasks)、编辑任务(Authoring Tasks);CT测试模块包含非线性系统传输任务(Nonlinear Systems Transfer Tasks)、仿真模拟任务(Simulation Tasks)、可视化编码任务(Visual Coding Tasks)。ICILS 2018題型主要为情境任务题,按照难易程度和耗时长短,可分为简短任务、持续性任务等类型。一般来讲,学生有120分钟的时间完成整个测评的四个模块。

TEL 2018主要包含两种题型:一是基于场景的任务题(Scenario-Based Item Sets,SBT);二是传统的独立题(Discrete Item Sets)。其具体的时间及反应类型见表3[4]。

在TEL 2018评估中,基于场景的任务题(SBT)通过构建真实世界的场景,使学生处在宏观的背景之下,着重强调学生“必须使用ICT工具来分析技术对人类社会的影响”,最为典型的就是计算机交互任务,即计算机构建相关虚拟情境,学生在相关提示下通过操作计算机来逐步完成相关任务。可见,SBT任务可以“复制”生活中可能遇到的真实情况,从而为学生提供“其他类型评估任务中无法展现的真实性”,大大提升了评估的有效性。但在SBT任务中,由于相关问题多与同一场景相关,导致许多度量相互依赖,为抵消这种相互依赖性并确保可靠性,TEL 2018还采用了传统的独立题(Discrete Item Sets),包含10~15个独立项目,并通过建构或选择的响应类型,让学生在60分钟内完成。

在评分方面,ICILS 2018与TEL 2018均采用评分量规(Scoring Rubric)对学生的答案进行测评,根据学生答案中所包含答题要点的多少,由高到低分为三个层次,分别给予满分、部分分和零分。

2.2 试题编制方式

评价试题的编制是评估体系的核心。ICILS 2018试题是根据其测评目标进行编制,测评内容在其评估框架中有详细规定。而TEL 2018遵循NAEP的试题编制的依据,主要根据《美国国家科学教育标准》和《科学素养基准》两个基本文件,基于学生的“表现期望”(Performance Expectation),编制相关测评试题。由试题引发出学生相关反应,以此作为测评学生科学素养的依据(见图5)[2]。此外,TEL 2018特别强调测评时间分布的整体平衡,如在内容领域,四年级强调信息与通信技术,八年级强调设计与系统,而十二年级则注重信息与通信技术、设计与系统间的平衡。具体的时间占比见表4[4]。

2.3 相关比较

基于探究ICILS 2018与TEL 2018两个评估框架之间异同的目的,美国国家教育统计中心(NCES)于2018年对两个评估相关项目(主要涉及八年级学生)进行编码,具体为:ICILS 2018包含113个基于场景的测试题(SBT);TEL 2018包含184个项目,其中:基于场景的测试题(SBT)107题,独立题77题(见表5、表6)[10]。

接下来,按照主题、实践、情境、评分级别、评分方法对两个评测项目进行比较。

2.3.1 相关主题(科目)

“相关主题(科目)”是指测评内容(或题目)所涉及到的相关科目,如数学、科学、艺术等。通过相关科目的讲授、学习,可以更好地评估学生所需的内容及能力。由表7[10]可知:在ICILS 2018方面,有近一半(49%)的项目进入计算机科学。在TEL 2018方面,SBT任务中,有41%的项目进入科学,34%进入社会研究;独立题中,均有43%的项目进入科学和社会研究。可见,ICILS 2018侧重于计算机科学,而TEL 2018则侧重于科学和社会研究领域方面,这与其各自的评估框架目标是一致的。

2.3.2 实践

TEL 2018明确提出“实践”是其评测框架的主要组成部分,而ICILS 2018未明确提出“实践”这一词。为了更好地进行比较,美国国家教育统计中心(NCES)把ICILS相关项目也进行了编码(见表8)[10]。由表8可知,两个评估框架均强调方案制定和目标实现的重要性。

2.3.3 情境(上下文)因素

情境(上下文)因素是影响测评的重要因素,两个评估项目所涉及到的情境因素编码情况见表9[10]。ICILS 2018中,有一半的项目是在娱乐及课外活动的情境下提出的。而TEL 2018项目则涵盖了更多的上下文因素,如政府、工业、工程和商业等。

2.3.4 评分级别

ICILS 2018与TEL 2018均采用评分量规(Scoring Rubric)对学生的答案进行测评,即根据学生答案中所包含的答题要点由高到低分为三个层次(多个级别),分别给予满分、部分分和零分。由表10[10]可见,在ICILS 2018中,分别有42%的项目有两个或三个评分级别,有约10%的项目有八个或更多的评分级别。在TEL 2018 SBT任务中,大约一半(47%)的项目有三个评分级别,只有4%的项目有五个或六个评分级别。对于TEL 2018独立题,只有两个和三个评分级别,其中60%的项目只有两个评分级别,这意味着学生要么得到全部学分,要么得到零分。

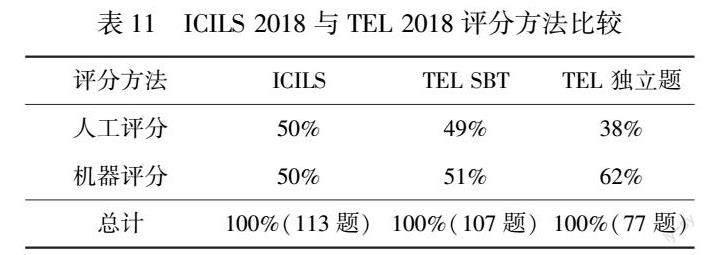

2.3.5 评分方法

关于评分方法,ICILS 2018与TEL 2018 SBT任务是较为相似的:大约一半为机器评分,一半为人工评分。而在TEL 2018独立题中,机器评分的比例(62%)远高于人工评分(38%)(见表11[10])。

总之,两项评估具有很多相似的特点,如均包含“领域”“情境”两大维度,并采用“分层”概念,确立核心领域并划分具体的子领域;均高度重视“情境”(上下文)因素的作用,采用“基于场景的测试题(SBT)”这一题型,并使用评分量表加以评判等。然而,两项评估又存在许多不同,如评估重点上,TEL 2018更注重技术和工程整体素养,而ICILS 2018更侧重计算机和信息素养;试题设置上,TEL 2018除SBT任务外,还配置了相当数量的独立题等。

3 相关启示

就我国技术与工程素养评估而言,当前存在“评测目标笼统”“重知识轻实践”“评价模式传統”“试题类型单一”“轻视过程性评价”“忽视非正式环境作用”等问题。为解决上述问题,实现“以评促教”“以评促学”的评测目的,通过ICILS 2018与TEL 2018评估框架的比较,可以得出以下启示。

3.1 统一课程标准,重视评估体系构建

2017年,教育部颁布《小学科学课程标准》,将技术与工程作为一个独立领域纳入课程体系,标志着我国科学教育特别是技术工程教育进入了一个新的发展阶段。但学前、中学阶段尚未有相应的政策规定,造成学前、小学、中学三个阶段技术与工程教育的“脱节”。对我国而言,为达到“从幼儿阶段便开始以螺旋式上升的方式提升学生的技术与工程素养”的目标,制定学前、小学、中学统一连贯的技术与工程课程标准是十分必要的[11]。而课程标准的实施成效需要一定的评测予以展现,如TEL 2018重点评估四年级、八年级和十二年级学生,形成了小学及中学一以贯之的评价体系,有力保障了学生技术与工程素养培养的连续性。同时,针对我国学生的技术与工程素养评估“数量庞大”“复杂度高”的特征,我国需要借鉴ICILS及TEL“由专门的机构实施推进”的经验,建立自上而下的评估领导、组织、执行体系,构建科学有效的评估体系,强化政府、学校、家庭的交流合作,保证学生技术与工程素养评估的持续有效推进。

3.2 明确评估目标,构建评估三维结构

为实现教育部《小学科学课程标准》(2017版)明确提出的具体的技术与工程领域的学段目标,取得“了解技术是人类能力的延伸,技术是改变世界的力量,技术推动人类社会的发展和文明的进程”[12]的效果,我国技术与工程素养评估体系的构建应当秉持“以人为本”理念,实施差异化的评测定位和发展目标,进一步细化评测目标的层次,如借鉴ICILS 2018和TEL 2018设立“维度”的概念,通过构建“内容”“情境”及“实践”三维结构,凸显“评测学生技术与工程知识掌握及运用水平高低,全面提升学生的技术与工程素养”的目标。建立协调一致的评估框架是评估得以实施的重要基础,如在内容方面,可以借鉴两个评估体系“分层”的方式,确立核心领域并划分具体的子领域,并参照TEL 2018技术与社会(TS)、设计与系统(DS)及信息和通信技术(ICT)的领域划分,使得学生充分理解现实问题,提出相应解决方案,并通过利用信息技术等手段进行实际操作,解决实际问题。

3.3 营造真实情境,评测解决问题能力

《中国STEAM教育发展报告》认为,STEAM以解决真实世界的问题为导向,以工程和技术为核心。但长期以来,我国学科教学过程中,呈现出“忽视情境”“缺少实践”及“高分低能”的倾向,即重视知识传授,忽视动手实践。而实践是技术与工程素养的重要内容,又与相关情境紧密相连。ICILS 2018及TEL 2018明确提出:“上下文情境是其评估的重要方面”,“内容与实践都依赖于情境的实现。”ICILS 2018和TEL 2018均采用“基于情境的任务”,将需要评估的内容,如知识、能力等融入模拟的现实问题中,通过解决问题的系列活动,从而评估出学生的“技术原则的理解度”“方案设计的有效度”和“交流合作的协同度”。为此,在评估中需要构建真实的情境,积极评测学生的实践能力。评估前,通过问卷等形式,了解学生所处的学校环境、家庭环境以及学生个人因素,从学生的实际出发,制定科学可行的评估内容及学习任务。评估中,让学生在特定环境下进行评估,更好地激发学生对科学知识的求知欲,重点评测学生合理运用相关知识,采用多种方法收集、解释数据,提升自身解决实际问题的能力。评估后,要对学生的评测信息进行及时的分析挖掘,总结经验,弥补不足。

3.4 科学编制试题,凸显评测整体平衡

试题编制是评估体系的核心。在我国,科学素养试题的编制以课程标准为基础,这与TEL 2018“根据《美国国家科学教育标准》和《科学素养基准》两个基本文件进行试题编制”不谋而合,均强调试题编制要体现出“对国家课程标准所规定要求的具体量化”。但不同的是,TEL 2018更加注重以“任务驱动”和“问题解决”作为学习和研究活动的主线,基于学生的“表现期望”(Performance Expectation)编制相关评测试题,并通过试题引发出学生相关反应,以此作为评测学生素养水平的依据,取得了良好的效果。为此,在我国技术与工程素养评估试题编制过程中,要积极贯彻“将评测能力外显为具体化、可测量的行为”的理念。首先,要重视评测的“整体平衡性”。根据学生的实际与相关表现期望,规划并建构相关的评估内容、实践、题型及反应类型,将相关评估难度按年级顺序依次递增,从易到难。同时,合理分配相关主题(科目)的比例,体现跨学科知识及方法的融合,平衡自然科学与社会科学等主题及“基于场景的测试题(SBT)”题型的使用比例等。其次,试题类型应当多样化。通过情境任务题(SBT)构建真实世界的场景,将学生置于特定背景之下,促使其制定相应实施方案,更具有现实性与社会性。此外,在充分发挥情境任务题(SBT)优势的基础上,结合传统试题,通过不同题型的组合更全面地评估学生的技术与工程素养状况,从而实现新颖性、独立性和可靠性的融合。

3.5 注重人机交互,增强学生“现实体验”

当前,我国科学素养评价方式仍然较为单一,主要集中于标准化测验(如纸笔测试)、量表设计及问卷调查等传统方式[13]。伴随信息技术的发展,具备良好的ICT能力日益成为学生的基本素养之一,学生的知识与能力已不能简单地通过一张试卷或一份问卷进行衡量。以计算机为依托的评测项目,凭借其人机交互与虚拟现实的特点,已成为ICILS 2018、TEL 2018等国际主流评测框架的发展方向。为此,在我国技术与工程素养评估体系构建中,要以计算机交互任务为主要评测方式,积极创设现实问题情境,通过虚拟任务,增强学生的“现实体验”,考查学生信息技术的实操作能力,衡量学生利用信息技术工具解决真实问题的能力,促进技术与工程素养内化为学生知识经验的内在组成部分,从而打破传统纸笔测试的局限性,取得“评测过程也是不断学习新知识的过程”的效果[14]。此外,要充分发挥计算机ICT技术数字智能、实时存储及省时省力的优势,推广大规模评测,存储海量信息,以供后续深入挖掘。

3.6 强化过程评价,实现评定“质”“量”结合

长期以来,我国关于科学素养的评价评分标准主要体现出“量化评定”的特点,即学生通过完成相关纸笔测试或问卷调查,得出具体分数并以此作为素养高低的衡量依据。这种量化评定方式在操作程序上简单易行,便于大规模评测的开展与实施,但由于各个评测试题编制的理念、方式不同,导致评估结果效度不高,可解释性较差。而ICILS 2018与TEL 2018采用人工评分与机器评分相结合的方式,并使用专门的评分指南即评分量规(Scoring Rubric)对学生的答案进行评测,实现了技术与工程素养评价量与质的结合。为此,我国在评价标准的制定上,要在运用量化方式进行评价的基础上,更加注重开展形成性评价质性评价标准的构建,如利用计算机的情境任务,并结合档案袋等形式对学生的信息素养进行过程性评价。同时,应当积极借鉴ICILS 2018与TEL 2018“评分方式、级别与题型相对应”的特点,针对不同的题型,平衡人工评分、机器评分的比例,并合理安排评分级别,从而实现科学高效的评测。

3.7 重视非正式环境,改进后续教学

ICILS 2018及TEL 2018均重视上下情境及非正式环境因素[15]。特别是ICILS 2018强调校内外不同影响因素,让学生通过自身不同知识经验来解决系列问题,主要涉及到宏观环境、学校环境、家庭环境以及学生个人因素。国家层面,需要为技术与工程教育提供良好的教育资源支持,建议加大信息基础设施建设力度,并出台全国性文件,指导各级部门、学校研发或开展更多的技术与工程课程项目。学校层面,合理安排课程设置,增加技术与工程课程开设节次,如将选修改为必修,破除“轻视技术和工程”现象;强化教师专业培训,如学习大数据、学习分析等技术,增强“以人为本”的培育理念,精准提取学生学习需求,为后续开展科学有效的教学设计做好准备。家庭层面,由于学生原生家庭的背景,如收入等具有一定的稳定性和差异性,在短时间内难以得到改变。为此,可以采取家校合作机制,如在收集学生家庭相關信息的基础上,围绕技术与工程特别是学生计算思维发展等问题,为受教育程度相对不高(主要指学士以下)的家长提供切实可行的咨询和建议,提升其对技术与工程教育的重视程度。

参考文献

[1] 杨玉琴.美国NAEP技术与工程素养评估述评[J].外国教育研究,2017(8):22-35.

[2] 夏小俊,顾乃景,柏毅.TIMSS 2015与NAEP 2015科学评估框架的比较研究[J].考试研究,2016(1):96-101.

[3] IEA.ICILS 2018 International Computer and Information Literacy Study 2018 [EB/OL].[2022-02-14].https://www.iea.nl/studies/iea/icils/2018.

[4] NAEP.technological and engineering literacy framework for the 2018 national assessment of educational progress[EB/OL].[2021-02-14].https://www.nagb.gov/content/nagb/assets/documents/publications/frameworks/technology/2018-technology-framework.pdf.

[5] 张娣.美国NAEP技术与工程素养评估及其进展[J].世界教育信息,2020(3):66-71.

[6] FRAILLON J,SCHULZ W,AINLEY J.International computer and information literacy study:assessment framework[R].Amsterdam:International Association for the Evaluation of Educational Achievement,2013.

[7] 唐晓玲.国际学生信息素养测评框架、方法与评价[J].图书情报工作,2015(15):12-19.

[8] 冯达.NAEP2014技术与工程素养评估试题编制框架研究[J].考试周刊,2018(74):1-2.

[9] 柏毅,黄雪莹,周安然.NAEP信息与通信技术素养测评框架、评估设计及启示[J].教育测量与评价,2019(9):38-44.

[10] NAEP.A comparison study of NAEP TEL and ICILS[EB/OL].(2020-08-12)[2022-02-14].https://nces.ed.gov/nationsreportcard/subject/tel/pdf/tel_icils_study.pdf.

[11] 苏洵,丁邦平.美国 PreK-12年级技术与工程素养标准解读与启示[J].比较教学学报,2021(2):150-166.

[12] 中华人民共和国教育部.义务教育小学科学课程标准[M].北京:北京师范大学出版社,2003.

[13] 李新.国际大规模中小学生信息素养测评工具的研究[D].武汉:华中师范大学,2020.

[14] 陈慧珍.小学科学六年级技术与工程素养评测研究[D].南京:东南大学,2018.

[15] 林静.美国STEM教育质量评价新动向——NAEP技术与工程素养评价要点与启示[J].华东师范大学学报(教育科学版),2017(1):78-86.

Abstract In order to promote the development of China′s technology and engineering education,improve the level of students′ scientific and technological literacy,and achieve "promoting teaching by evaluation" and "promoting learning by evaluation".We should proceed from the frame goal and the characteristics of the project,by comparing and analyzing the similarities and differences between ICILS 2018 and NAEP TEL 2018.It is concluded that there are some similarities between the two models in dimension division,emphasis on context,and the use of gauges,and there are different conclusions in the aspects of assessment emphasis,distribution of test questions and compilation basis. Combining with the reality of our country,this paper puts forward the development ideas of science and technology literacy evaluation in the future:unify curriculum standards to build an assessment system;clarify assessment goals and build a three-dimensional structure;create a real situation and improve solving capabilities;highlight the overall balance and scientifically prepare test questions;pay attention to humans and machines Interaction,augmented reality experience;strengthen process evaluation to achieve the combination of "quality" and "quantity";attach importance to environmental impact and improve follow-up teaching.

Keywords ICILS 2018;TEL 2018;technological and engineering literacy;comparative study

[責任编辑 马晓宁]