低空空域小型无人机目标检测算法

2023-04-12王传云司可意

摘要: 在利用视觉检测算法进行检测与定位的过程中,当空域中目标无人机相对较小时,现有的检测算法容易受到空中其他飞行物、复杂背景和光照强度变化影响导致检测精度较低。为了解决这一问题,提出了一种基于YOLOv3改进的目标检测算法。当空域中目标无人机体积相对较小、视觉特征较弱、存在其他干扰时,通过增加主干特征提取网络对图像特征提取的层级数,提取多个不同尺度特征层进行跨层连接融合,使多个不同层级的特征层之间的语义信息联系得更加紧密,让网络模型可以学习到不同尺度目标的特征信息,以此增强检测算法对小目标无人机检测的精度。最后,利用Drone vs Birds数据集进行实验测试,所提出的算法可以有效地提高小型无人机目标的检测精度,检测速度基本满足实际要求。

关键词: 低空空域;小型无人机;目标检测;深度学习;特征融合

中图分类号: TP39" " " " 文献标志码: A

doi:10.3969/j.issn.2095-1248.2023.02.007

Detection algorithm of small UAV target in low altitude airspace

WANG Chuan-yuna, SI Ke-yib

(a.College of Artificial Intelligence,b.College of Computer Science, Shenyang Aerospace University,

Shenyang 110136,China)

Abstract: When the target UAV(Unmanned Aerial Vehicle) in the air domain is relatively small, the existing detection algorithm is prone to be affected by other flying objects in the air, complex background and light intensity changes, resulting in low detection accuracy in the process of using visual detection algorithm for detection and positioning. To solve this problem, an improved target detection algorithm based on YOLOv3 was proposed. When the target UAV in the space domain was relatively small in size, with weak visual features and other disturbances, the main feature extraction network was added to the image feature extraction level, and multiple feature layers of different scales were extracted for cross-layer connection and fusion, so that the semantic information between multiple feature layers of different levels was more closely related. The network model could learn the characteristic information of targets of different scales, so as to enhance the accuracy of detection algorithm for small target UAV detection. Finally, Drone vs Birds dataset was used for experimental testing. The algorithm can effectively improve the detection accuracy of small UAV target , and the detection speed basically meets the actual requirements.

Key words: lowattitude airspace;small UAV;target detection;deep learning;feature fusion

由于无人机技术的快速发展,无人机的操作难度逐渐降低,灵活性显著提高,所以无人机在多个领域都得到了广泛的普及和应用[1-3]。但利用无人机进行恐怖袭击、侵犯公共安全等事件也随之不断发生,这不仅对公民隐私和生命财产安全造成了危害,也对公共安全和国家安全带来了巨大威胁[4-6]。因此,反无人机技术的研究得到了各界的高度重视[7]。在反无人机技术中,通过基于视觉的检测方法对无人机进行识别发现是最普遍最常用的[8]。基于视觉的检测方法需要采集视频图像信息对目标进行有效地识别及发现,其中基于深度学习的检测算法在图像处理方面有着优秀的性能和较高的分类准确度[9-11]。虽然深度学习拥有强大的图像处理和特征提取能力,但是在目标尺度较小、视觉特征不明显、存在复杂的背景干扰等情况时,通用的检测算法并不能准确地检测出无人机。为了解决上述问题,研究人员提出了许多针对无人机目标的检测算法[12]。

Hu等[13]将YOLOv3中输出的3个尺度特征图修改为4个尺度特征图,从而获取更多的纹理和轮廓信息。同时,为了减少计算量,根据输入数据计算出4个尺度特征图中无人机的尺寸,并对锚点的数量进行调整。结果表明,在保持检测速度下算法具有更高的检测精度。Ma等[14]采用了双通道检测器作为数据源,将红外图像和可见光图像同时输入网络进行特征提取并将提取出的深度特征串联起来,利用多尺度预测网络对目标位置进行回归,在mAP和检测速度上有所提升。Fan等[15]提出一种无人机威胁感知的并行检测跟踪框架,在SSD和DSSD的基础上提出了一种改进的网络,在保证检测速度的前提下提高无人机目标的检测精度。为了提高噪声和运动模糊条件下对低空无人机有效识别的能力,Luo等[16]对YOLO模型中原始的残差单元进行了改进,将图像的噪点和运动模糊部分等同为图像的一部分,采用不同大小的卷积核研究噪声和运动模糊的特征,加速模型训练,能够满足实时性要求。Que等[17]针对在噪声环境下无人机的“低慢小”问题,构造不同强度的噪声加强对象的标准训练数据集,同时构建了一个能够适应环境噪声的“低慢小”目标检测系统,在噪声测试集上经过实验验证,提高了系统检测的精度。上述算法,虽然解决了检测无人机目标过程中的部分问题,但是在无人机尺度变化较大、存在其他干扰物和飞行背景复杂等情况下检测精度较低,容易产生漏检、误检的情况。

小目标无人机的检测过程中存在无人机尺度变化比较大的问题,导致算法无法准确捕获无人机位置。本文通过延伸主干特征网络,扩大感受野,可以使算法模型学习到更多的无人机形态,从而提高检测无人机目标的精度。在检测过程中,当发生光照变化、存在复杂的背景和其他的飞行物(例如鸟类)的干扰时,会影响检测的精度。本文通过改进算法模型的特征融合方式,加强算法模型对无人机目标特征的学习,提高算法的检测精度。最后,本文介绍了算法生成无人机目标边界框的方式和算法模型的损失函数。利用Drone vs Birds数据集[18]进行训练验证,通过实验证明,相比于一般算法,本文所提算法在多种复杂场景下对小型无人机目标的检测具有更高的精度。

1 无人机目标检测算法

1.1 无人机目标特征提取

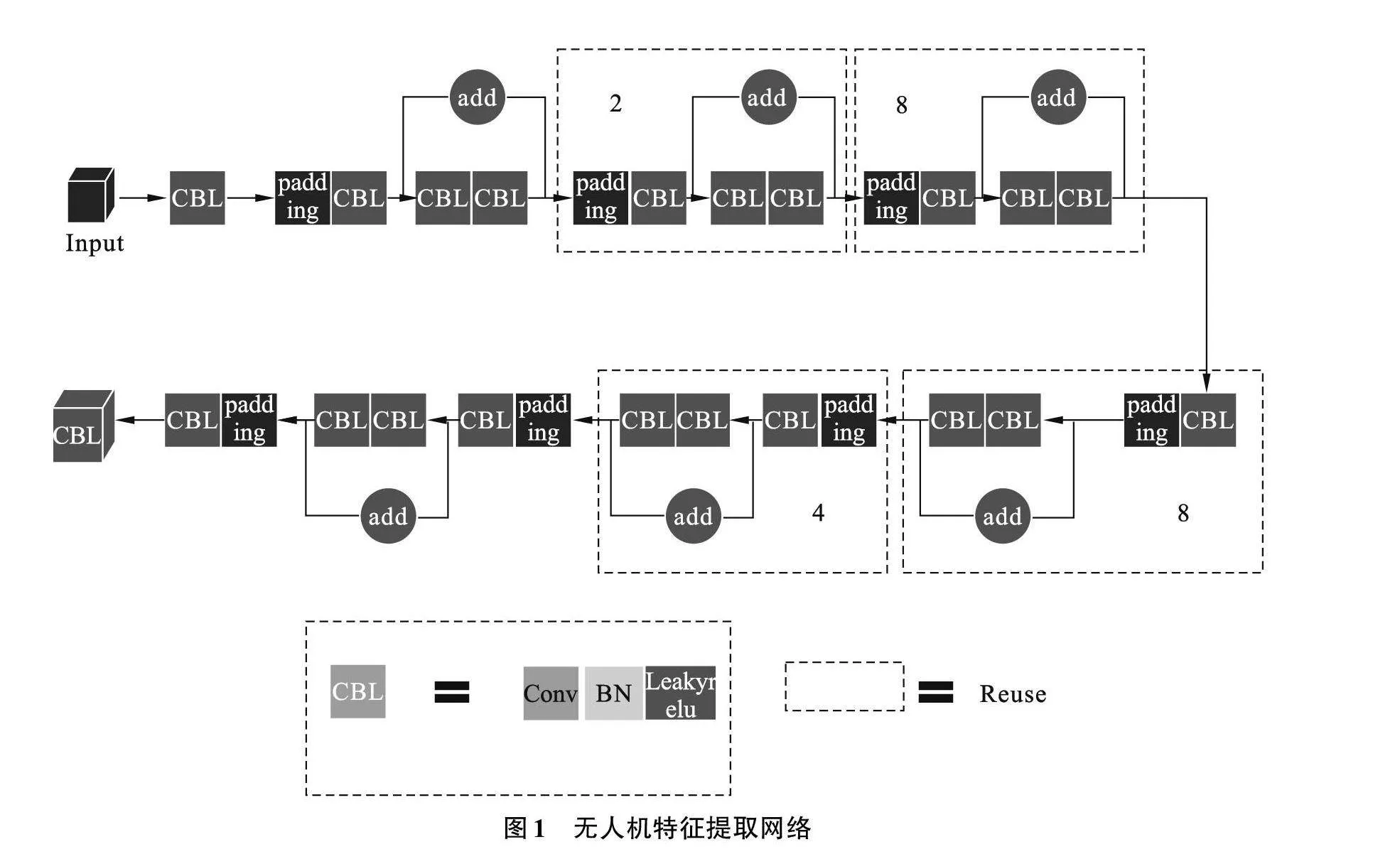

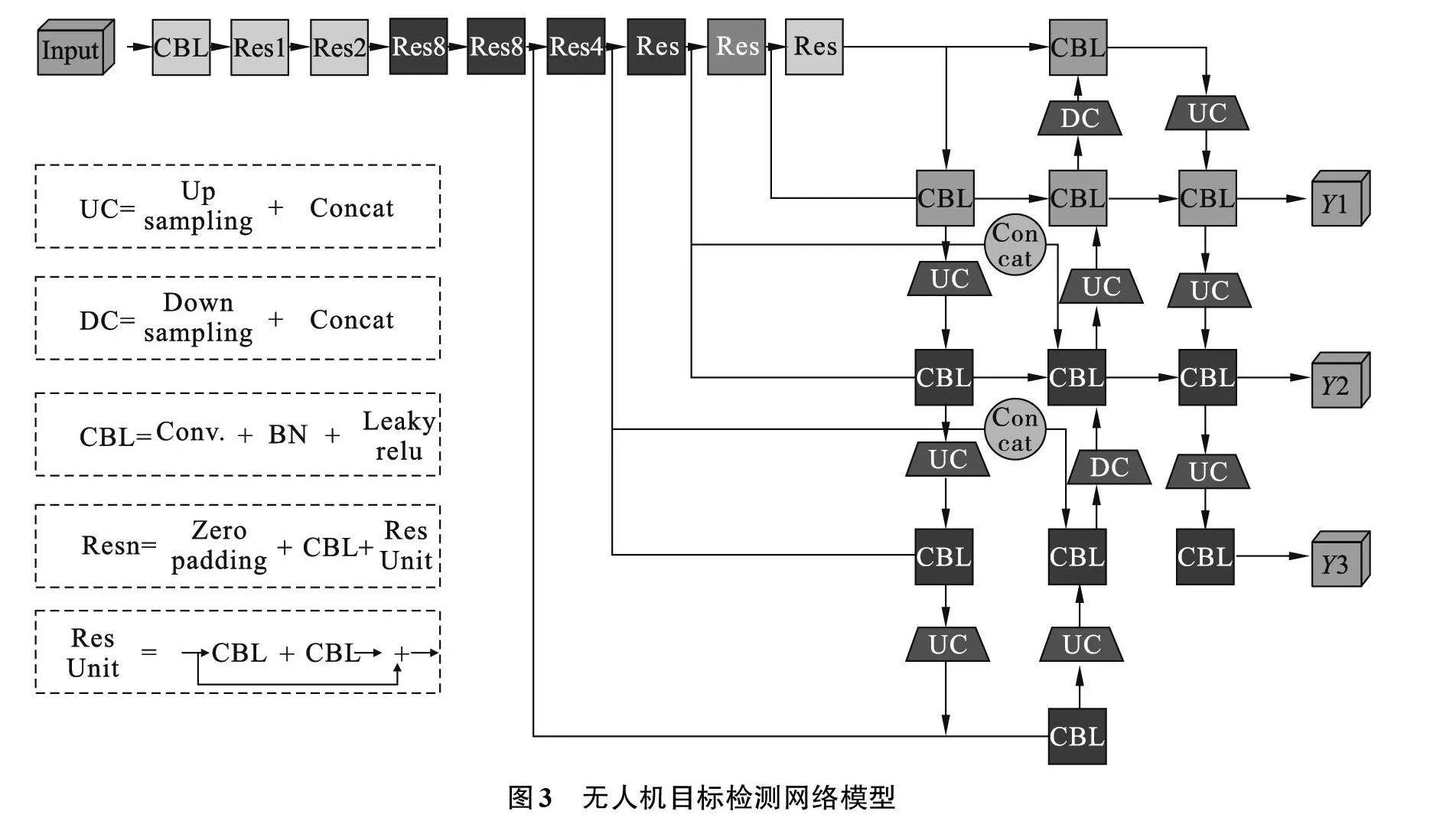

因为无人机目标在飞行过程中的位姿多样、尺度变化较大,在算法检测的过程中,容易出现漏检、误检等情况,所以本文将对YOLOv3[19]中的主干特征提取网络Darknet53进行改进,将网络深度向后进行延伸,不仅可以提取出原始图像中更深层次的语义信息,而且可以扩大感受野,提高网络模型对更多尺度无人机特征信息的学习。同时为了防止加深网络带来的退化效应,利用残差模块[20]中恒等映射的思想,改进后的主干特征提取网络如图1所示。其中,CBL表示的是卷积操作、批量归一化和激活函数的一次组合操作;padding表示对特征层的填充操作;黑色虚线框中数字代表的是该模块循环的次数。

同时在网络中加入了批量归一化的操作,通过规范化和线性变换的方式将每一层网络输入数据的均值和方差控制在一定的范围内,使得后一层的网络不必去适应底层网络中输入的变化,从而实现网络中层与层之间的解耦,允许每一层进行独立学习,有利于整个网络模型学习速度的提升,使得网络对参数大小的适应能力更强,可以缓解梯度消失的问题,同时还具有一定的正则化效果。

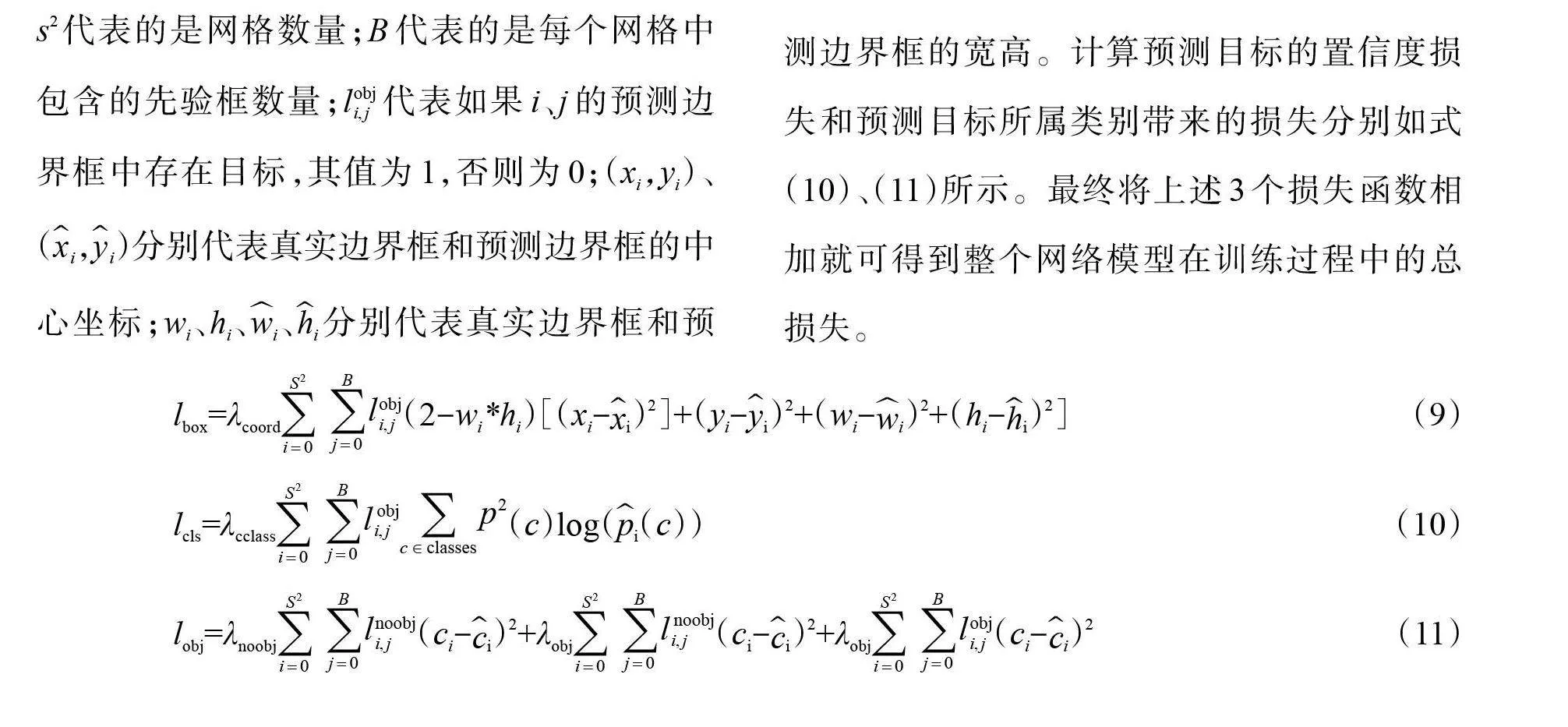

在训练的过程中,使用ReLU激活函数会使得对某些节点权重调整幅度太大,导致这一节点永久失效,所以本文使用LeakyReLU激活函数,如公式(1)所示

f(x)={(x,x≥0@x/a,xlt;0)┤ (1)

式中:a是(1,+∞)区间内的固定参数,通常情况下a值为0.01。LeakyReLU函数通过把x的较小线性分量赋予负输入来调整负值的零梯度问题,有效解决了ReLU中的节点失效问题。

1.2 无人机目标特征融合

对无人机目标进行检测的过程中,由于主干特征提取网络层次较深,所以在最后的特征层中只包含了原始图像中深层次的语义信息,如果只在最后的特征层上进行预测输出的话,并不能达到较好的检测效果。为了提高网络模型的整体检测精度,将特征提取网络中不同层级的特征进行提取融合,让算法可以学习到原始图像中更多的纹理信息和语义信息,从而提高检测精度。

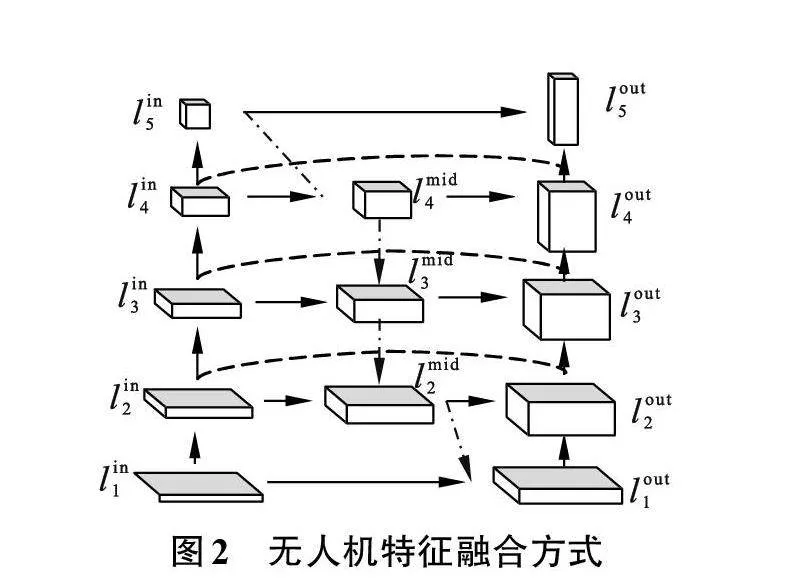

一般的特征融合方式只是将不同层级的特征层由深到浅地通过线性方式进行拼接,但是在面对目标较小、背景复杂和存在干扰的情况下,不仅检测精度较低,而且容易发生漏检、误检等情况[21]。本文结合算法模型的量级并充分利用不同特征层中语义信息,使用EfficientDet[22-23]中的融合方式,同时为了保证算法输出的简单有效,将EfficientDet中分别用于位置回归和分类预测的网络删除,改进最后的输出结构,降低对计算资源的要求。无人机特征融合方式如图2所示。

将主干特征提取网络中最后的5个特征层提取出来,作为特征融合模块的输入,以图2中的融合方式进行特征融合。其中,图2中点划线表示的是对特征层进行的上采样操作,点虚线表示的是对特征层进行的下采样操作,虚线表示的是特征层之间的跨层连接。首先将提取到的原始特征层由深到浅地进行上采样,将通过上采样后得到的特征层与同一尺度大小的特征层进行拼接,将拼接后的特征层再次进行上采样,重复上述步骤直至将特征层尺度扩大到与尺度最大的特征层大小相同为止;其次为了防止在多次卷积过程中原始特征层中语义信息的丢失,通过跨层连接将拼接后的特征层与原始特征层结合;最后将得到的特征层按照自底向上的顺序通过下采样进行逐层级的特征提取。以图2中的l_5^in和l_4^in两个特征层融合为例进行说明,如式(2)、(3)所示。

l_4^mid=Conv(l_4^in+Resize(l_5^in)) (2)

l_4^out=Conv(l_4^in+l_4^mid+Resize(l_3^out)) (3)

式中:l_5^in和l_4^in为主干特征提取网络中的两个输入特征层;l_4^mid是l_5^in通过上采样与l_4^in进行拼接和卷积后得到的特征层;l_4^out是l_4^in、l_4^mid和l_3^out经过下采样进行拼接卷积后得到的特征层。经过特征融合后的网络对无人机目标的特征学习更加充分,可以有效地避免在检测过程中出现类似的飞行干扰物和在复杂场景下飞行出现的漏检、误检的情况。

考虑到反无人机系统部署场景的问题,为了降低网络模型对计算资源的要求,在最后的输出过程,将融合模块中最后的5个特征层利用自深到浅的线性融合方式变换为3个输出特征层,分别对应检测大、中、小型无人机目标。网络整体架构如图3所示。其中:CBL表示卷积操作、批量归一化和激活函数的一次组合操作;DC操作为一次上采样操作和拼接操作;UC操作为一次下采样操作和拼接操作;Res操作表示的是残差连接;n表示残差单元的重复次数。

1.3 无人机目标检测损失

损失函数是用来评价算法模型对目标的预测值与真实值之间的误差的,从而指导算法模型下一步的训练向正确方向进行。本文提出的网络模型的损失函数由3部分组成。

(1)预测的边界框与真实边界框之间中心坐标和宽高带来的损失。

(2)预测目标计算的置信度带来的损失;

(3)计算预测目标所属类别带来的损失。

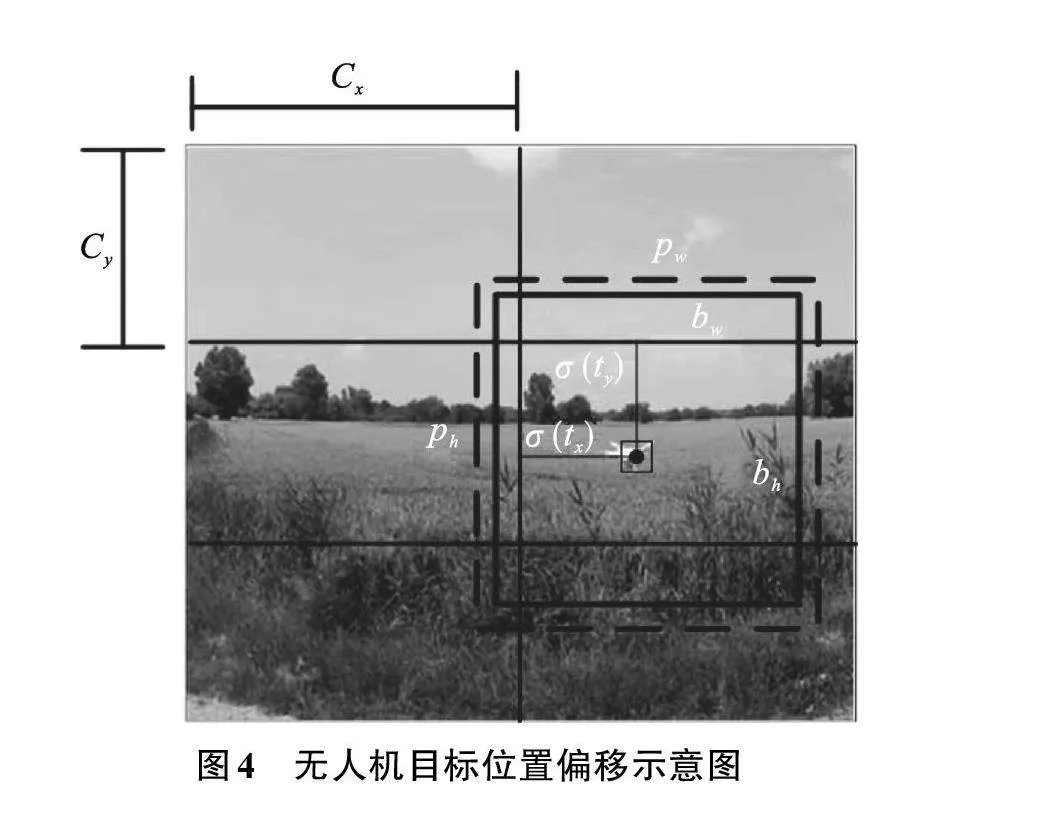

预测边界框是将网络在训练过程中对选择出来的先验框中心坐标和宽高进行调整,以适应检测目标的尺寸,先验框的尺寸调整控制在当前网格中,如图4所示。对先验框的中心坐标和宽高调整方式,如式(4)~(8)所示

bx=σ(tx)+cx (4)

by=σ(ty)+cy (5)

bw=pwe^(t_w ) (6)

bh=phe^(t_h ) (7)

Pr(object)*IOU(b,object)=σ(to) (8)

式中:bx、by、bw、bh分别是对先验框进行调整后的中心位置坐标和宽高;Pr*IOU是预测边框的置信度;cx、cy是当前网格的左上角相对于输入图像的左上角的距离,将网格大小归一化,即令一个网格的宽和高都为1;pw、ph是先验框的宽高;σ是Sigmoid函数;tx、ty、tw、th、to是网络通过训练学习的参数,分别用于预测边框的中心位置坐标、宽高以及置信度。

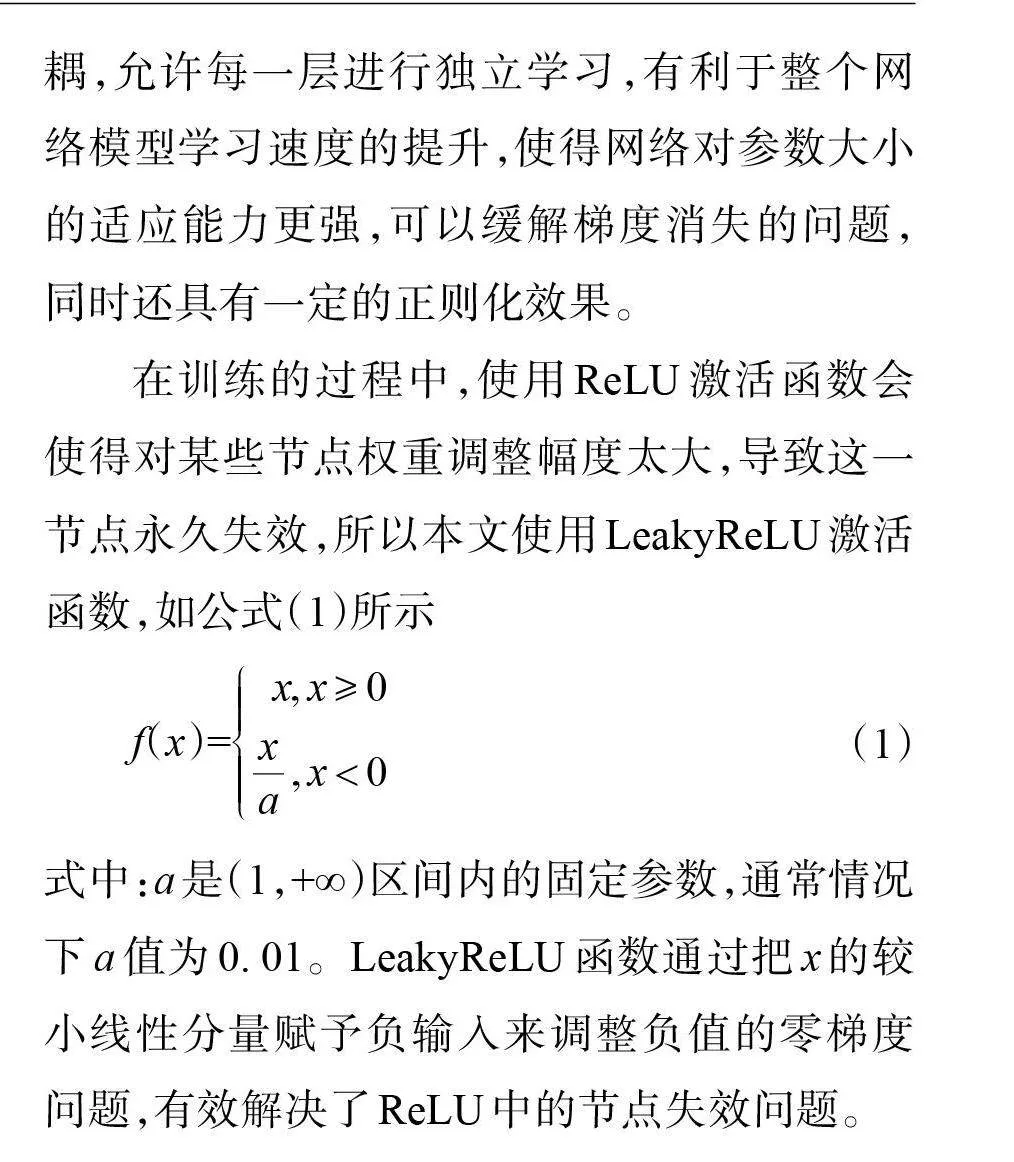

预测的边界框与真实边界框之间的损失如式(9)所示。式中:λcoord代表的是惩罚因子;s2代表的是网格数量;B代表的是每个网格中包含的先验框数量;l_(i,j)^obj代表如果i、j的预测边界框中存在目标,其值为1,否则为0;(xi,yi)、(x ̂_i,y ̂_i)分别代表真实边界框和预测边界框的中心坐标;wi、hi、w ̂i、h ̂i分别代表真实边界框和预测边界框的宽高。计算预测目标的置信度损失和预测目标所属类别带来的损失分别如式(10)、(11)所示。最终将上述3个损失函数相加就可得到整个网络模型在训练过程中的总损失。

lbox=λcoord∑_(i=0)^(S^2)∑_(j=0)^B▒l_(i,j)^obj(2-wi*hi)[(xi-x ̂i)2]+(yi-y ̂i)2+(wi-w ̂i)2+(hi-h ̂i)2] (9)

lcls=λcclass∑_(i=0)^(S^2)∑_(j=0)^B▒l_(i,j)^obj ∑_(c∈classes)▒p^2 (c)log(p ̂i(c)) (10)

lobj=λnoobj∑_(i=0)^(S^2)∑_(j=0)^B▒l_(i,j)^noobj(ci-c ̂i)2+λobj∑_(i=0)^(S^2)∑_(j=0)^B▒l_(i,j)^noobj (ci-c ̂i)2+λobj∑_(i=0)^(S^2)∑_(j=0)^B▒l_(i,j)^obj(ci-c ̂i)2 (11)

2 实验结果与分析

2.1 实验条件

为了验证本文所提出的目标检测算法模型的检测效果,将利用Drone vs Birds数据集进行实验,并通过计算检测算法的精准率和召回率进行实验性能的评估。

本文实验算法是在 Python3.7 中使用 PyTorch=1.4.0 框架实现的,实验测试电脑使用Ubuntu 18.04操作系统、CPU InterCore i7-9700k、主频3.60 GHz、16 G内存、GPU NVIDIA GeForce RTX 2080Ti,网络学习率设置为0.003。

2.2 实验分析

本文所使用的数据集包含77个无人机在不同场景下飞行测试的视频序列。通过对YOLOv3、SSD[24]和本文检测算法在Drone vs Birds数据集上训练网络模型,并在多个场景下进行实验测试,测试结果如图5所示。

图5中,第一列为测试的原始图像,第二列为SSD算法的检测结果,第三列为YOLOv3算法的检测结果,第四列为本文所提算法的检测结果。在第一、二行图像中,当场景中出现和无人机飞行特征相似的滑翔鸟类时,可以检测算法是否能精确捕捉到无人机目标。在第一行图像的场景中,SSD算法不仅将尺度较大的鸟类误检为无人机,而且未能准确检测出小型无人机的飞行位置。YOLOv3虽然可以将小型的无人机目标检测出来,但是同时也将鸟类误检为无人机目标,相对其他两种算法,本文所提的检测算法可以准确标定出小型无人机的位置,不受鸟类的干扰。在第二行图像的场景中,SSD算法并没有检测出体积较小的无人机目标和鸟类,YOLOv3依然出现了误检的情况,本文所提算法在不受鸟类干扰的情况下,依然准确地标记出了无人机目标的位置。在第三、四行图像中,对不同复杂背景下无人机目标飞行的检测精度进行测试。其中,SSD并不能检测出无人机目标的位置,出现了漏检的情况,虽然YOLOv3可以在无人机目标与复杂背景存在较大差异的第二种原始图像中检测出无人机,但是在无人机目标与背景特征相似的情况下,依然出现了漏检的情况。在第五行图像中,当场景中的光照强度较弱时,可以测试算法对无人机目标检测的稳定性。其中,SSD和YOLOv3算法都出现了漏检的情况,但本文所提算法准确标定出了无人机目标的位置。在第五行图像中,当场景中同时出现多个尺度大小不同的无人机目标时,可以测试算法对不同大小、不同位姿的无人机目标特征的检测精度。其中,SSD依然出现了漏检的情况,但是YOLOv3和本文所提算法都可以准确标定出无人机目标的位置。

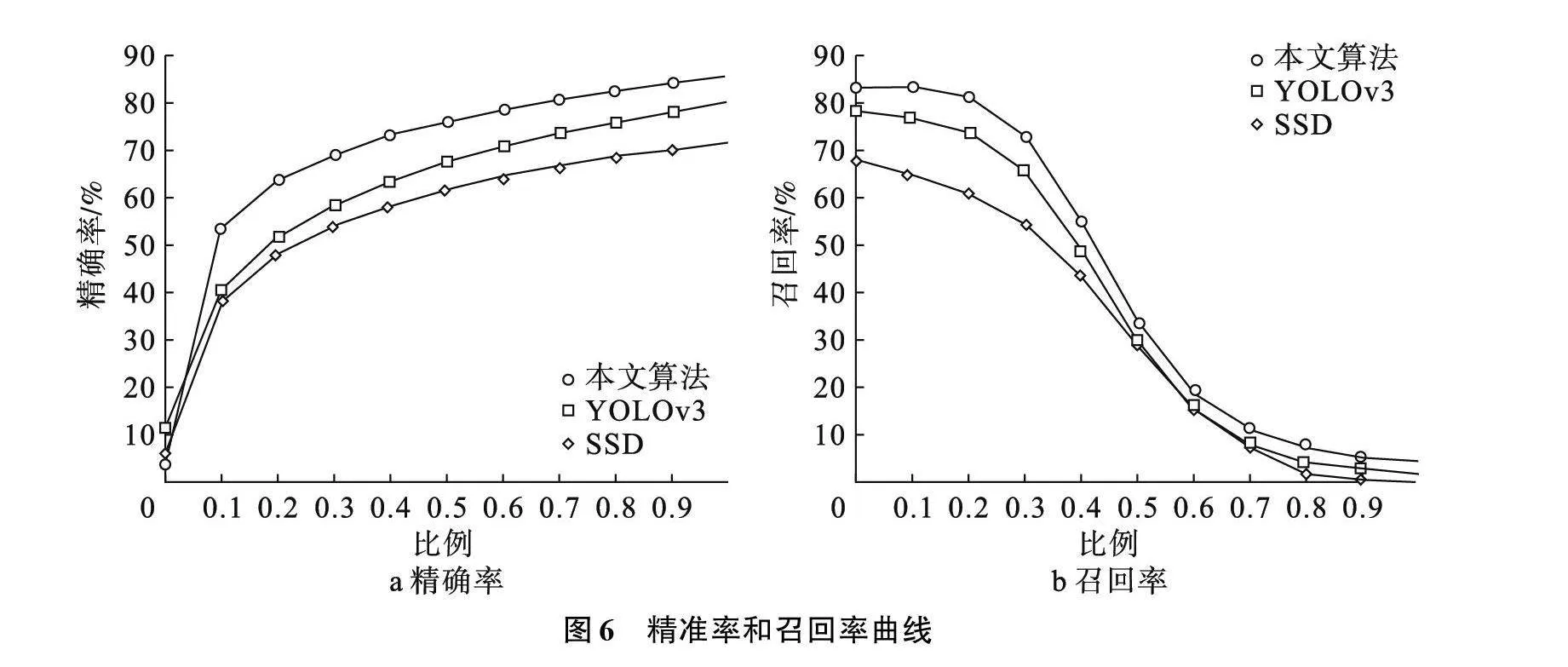

为了客观研究本文所提算法的优点,在测试数据集上进行实验并通过精准率和召回率进行性能评估。3种算法在测试数据集上的精准率和召回率曲线如图6所示。其中,本文所提算法的精准率为85.60%,召回率为83.17%,相比于YOLOv3算法分别提高6.91%和6.42%,相比于SSD算法分别提高了19.10%和22.49%。由此可见,本文所提算法可以有效提高复杂场景下无人机目标检测的性能。

3 结论

本文针对空域中无人机目标较小、背景复杂和特征不明显时检测精度较低的问题,提出了一种基于深度学习的目标检测算法模型,通过主干特征提取网络的深层特征提取方法和融合模块中多路径的融合方式提高了算法模型的检测精度。经实验测试证明,该方法可以有效检测出空域中小目标无人机。在未来的研究中,可以利用不同传感器获取到的图像,通过融合技术将不同传感器的图像融合为信息更为丰富的融合图像,以此进行检测,提高检测精度。

参考文献(References):

[1] 于冲,司帅宗,赵海,等.基于二跳共同邻居的无人机群体网络演化算法[J].软件学报,2020,31(11):3559-3570.

[2] Anwar M Z,Kaleem Z,Jamalipour A.Machine learning inspired sound-based amateur drone detection for public safety applications[J].IEEE Transactions on Vehicular Technology,2019,68(3):2526-2534.

[3] Seidaliyeva U,Akhmetov D,Ilipbayeva L,et al.Real-time and accurate drone detection in a video with a static background[J].Sensors,2020,20(14):3856.

[4] Kang H G,Joung J,Kim J,et al.Protect your sky:a survey of counter unmanned aerial vehicle systems[J].IEEE Access,2020,8: 671-710.

[5] Yang S B,Luo Y,Miao W,et al.RF signal-based UAV detection and mode classification:a joint feature engineering generator and multi-channel deep neural network approach[J].Entropy,2021,23(12):1678.

[6] Svanström F,Alonso-Fernandez F,Englund C.A dataset for multi-sensor drone detection[J].Data in Brief,2021,39:107521.

[7] Taha B,Shoufan A.Machine learning-based drone detection and classification:state-of-the-art in research[J].IEEE Access,2019,7: 669-682.

[8] Masita K L,Hasan A,Shongwe T.Deep learning in object detection:a review[C]//2020 International Conference on Artificial Intelligence,Big Data,Computing and Data Communication Systems (icABCD).Durban,South Africa:IEEE,2020:1-11.

[9] 陈科圻,朱志亮,邓小明,等.多尺度目标检测的深度学习研究综述[J].软件学报,2021,32(4):1201-1227.

[10] 罗会兰,陈鸿坤.基于深度学习的目标检测研究综述[J].电子学报,2020,48(6):1230-1239.

[11] 林景栋,吴欣怡,柴毅,等.卷积神经网络结构优化综述[J].自动化学报,2020,46(1):24-37.

[12] Liu S,Li G T,Zhan Y F,et al.MUSAK:a multi-scale space kinematic method for drone detection[J].Remote Sensing,2022,14(6):1434.

[13] Hu Y Y,Wu X J,Zheng G D,et al.Object detection of UAV for anti-UAV based on improved YOLO v3[C]//2019 Chinese Control Conference (CCC).Guangzhou,China:IEEE,2019:8386-8390.

[14] Ma Q,Zhu B,Cheng Z D,et al.Fast detection and recognition method of UAV in sky background[C]//Proc SPIE 11209,Eleventh International Conference on Information Optics and Photonics (CIOP 2019),Xi'an,China:Chinese laser Press,2019:36-41.

[15] Fan J X,Li D W,Wang H L,et al.UAV low altitude flight threat perception based on improved SSD and KCF[C]//2019 IEEE 15th International Conference on Control and Automation (ICCA).Edinburgh,UK:IEEE,2019:356-361.

[16] Luo K,Zhu G B,Li Y,et al.Low altitude and low speed uav identification based on hybrid model[C]//Proceedings of the 3rd International Conference on Computer Engineering,Information Science amp; Application Technology (ICCIA 2019). Paris,France:Atlantis Press,2019:76-87.

[17] Que J F,Peng H F,Xiong J Y.Low altitude,slow speed and small size object detection improvement in noise conditions based on mixed training[J].Journal of Physics:Conference Series,2019,1169:012029.

[18] Coluccia A,Fascista A,Schumann A,et al.Drone-vs-bird detection challenge at IEEE AVSS2021[C]//2021 17th IEEE International Conference on Advanced Video and Signal Based Surveillance (AVSS).Washington,DC,USA:IEEE,2022:1-8.

[19] Redmon J,Farhadi A.YOLOv3:an incremental improvement[EB/OL].( 2018-04-08)[2021-04-08]. https://arxiv.org/abs/1804.02767.

[20] He K M,Zhang X Y,Ren S Q,et al.Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Las Vegas,NV,USA:IEEE,2016:770-778.

[21] Lin T Y,Dollár P,Girshick R,et al.Feature pyramid networks for object detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu, USA:IEEE,2017:936-944.

[22] Tan M, Le Q. Efficientnet: rethinking model scaling for convolutional neural networks[EB/OL].(2019-05-28)[2021-04-15].https://arxiv.org/abs/1905.11946.

[23] Tan M X,Pang R M,Le Q V.EfficientDet:scalable and efficient object detection[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Seattle, USA:IEEE,2020:10778-10787.

[24] Liu W,Anguelov D,Erhan D,et al.SSD:single shot MultiBox detector[C]//European Conference on Computer Vision Cham,Amsterdam,Netherlands:Springer,2016:21-37.

(责任编辑:刘划" 英文审校:杜文友)