通道注意力引导的空洞卷积神经网络图像去噪

2023-03-11孙光灵彭欣仪

孙光灵,彭欣仪

(1.安徽建筑大学 电子与信息工程学院,安徽 合肥 230601;2.合肥工业大学 智能互联系统安徽省实验室,安徽 合肥 230009)

图像去噪是视觉应用和图像处理领域中的典型问题,也是研究热点之一。许多图像都存在部分细节丢失,图像质量下降的问题。高效的图像去噪算法在去除噪声的同时,保证被处理图像的结构信息不被改变,从而有助于图像分类、图像分割等其他图像处理任务,进一步运用于遥感、医疗成像、监控等领域。典型的图像去噪算法所应用的模型y,是由不加噪声的图像x和噪声水平n相加组合而成,去噪的最终目的是从y中推算出潜在的干净图像x。从贝叶斯的角度,给定似然的图像先验是克服不良去噪问题的关键。受这一事实的启发,ZHA等[1]充分利用稀疏表示的固有去噪特征这一特性,提高去噪性能并降低计算成本。用图像的稀疏性质对其结构信息进行表示[2],经典的相关算法有K-SVD算法[3]、BM3D算法[4]、OMP算法[5]。由于图像去噪的实际应用场景不断增加,去噪任务面临的现实需求更加复杂多变,但是上述算法功能有限,不能满足当前图像去噪的需求。

随着各类计算机性能和算力的增强,研究人员把深度学习的方法逐渐引入图像去噪领域。ZHANG等[6]首先提出了一种用于去噪的卷积神经网络(DnCNN),包括残差学习(RL)[7]和批处理(BN)[8]以恢复破裂的图像。深层递归残留网络(DRRN)[9]利用全局和局部RL技术来增强受过训练的模型在图像恢复中的表示能力。ZHANG等[10]提出了一个用于图像去噪的FFDNET方法,其将噪声水平与噪声图像作为联合输入,并训练一种模型以在不同噪声水平下处理噪声图像。在经典的深度学习算法中,利用卷积神经网络的图像去噪模型在性能上获得了一定提升,但是目前去噪网络的整体去噪性能仍有很大的提升空间。卷积神经网络(CNN)的表现力一般情况下会随着网络深度的增加而增加,然而简单叠加的多层卷积层会使训练变得更加困难,导致过拟合或性能饱和[7,11]。为了解决这个问题并获得更高的去噪质量,HU等[12]首次提出通道注意来提高图像分类精度,在CNN情况下不同的特征信道对应不同的频率分量,利用通道注意可以选择性地使用信息信道来更有效识别噪声。尽管上述方法对图像去噪都有一定的效果,但其中有些方法存在计算成本高、内存消耗大、未能充分利用深层网络对浅层网络的影响,以及容易忽视一些复杂背景后的关键信息特征等缺点。

针对上述问题,本文在DnCNN基础上探究了一种通道注意引导的空洞卷积神经网络(CDNet)以用于图像去噪。该方法主要优势如:(1)引用了稀疏块的理念,减少网络深度。(2)引入通道注意力机制来调节网络同一层中特征通道间的重要程度,使网络更加关注与噪音密切相关的信息通道。所采用的网络主动适应图像内容,获取更多信息特征,从而清晰高质量地恢复图像。(3)二者结合构成本文的去噪网络,噪声最终被处理为残差图,在输出时残差被丢弃,从而实现去噪功能。

1 DnCNN网络

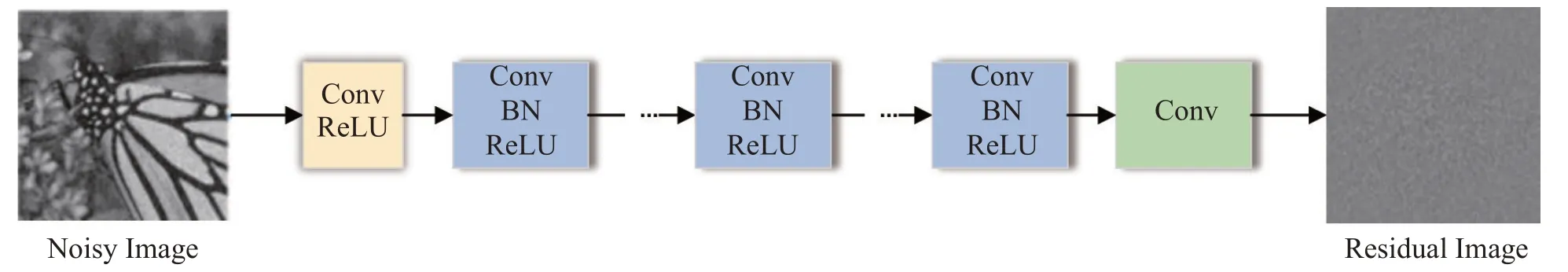

DnCNN[6]在VGG基础上进行改进,是用于图像去噪的前馈去噪卷积神经网络,其网络结构是卷积、批量归一化(BN)以及ReLU函数的级联结构。该网络共有17层,分为三个部分,第一部分为Conv+Re-LU(一层),第二部分为Conv+BN+ReLU(若干层),第三部分为Conv(一层),对于每个卷积层,卷积核的大小为3×3,步长设置为1。网络结构如图1所示。

图1 DnCNN结构

DnCNN 通过残差学习策略进行训练,损失函数数学表达式,其中,θ表示网络参数,N表示训练样本数,R(yi;θ)表示残差输出,yi为噪声图,xi为无噪声图像。

2 去噪网络CDNet

虽然DnCNN去噪效果较好,但其网络结构单一,且同一层中特征通道间的重要程度平等,不利于特征的提取,且随着网络深度的增加,浅层网络对深层的影响也随之减弱。本文在DnCNN网络基础上结合通道注意力机制及稀疏性质构成了通道注意力引导的空洞卷积神经网络CDNet 以用于图像去噪。CDNet利用稀疏性质可以减少网络深度,对输入图像进行充分特征提取,再经过通道注意力机制,根据不同权重以得到更重要的特征信息,从而有助于恢复清晰的图像并提高去噪性能,其网络结构如图2所示。

图2 CDNet结构

2.1 空洞卷积与稀疏性质

上下文信息对于重建图像去噪过程中损坏的像素点很重要[12],扩大卷积神经网络的感受野,是获取更多上下文信息的经典方法。堆叠后的普通卷积感受野大小rn=rn-1+,其中,rn为本层的感受野大小,kn为本层的核尺寸(实际覆盖尺寸,空洞卷积需要考虑dilation rate,池化层同理),si为第i层的步长。

空洞卷积不仅可以增加感受野,还能降低数据维度来减少计算量。YU[13]等用多个空洞卷积层来构建了一个网络,其中每层空洞率都按指数级增长,有效的感受野大小随层数的增加是指数级增长,而参数量以线性增长。为了提高模型的训练速度和性能,WANG[14]等结合了空洞卷积和批处理技术,降低了图像去噪的计算成本。ZHANG 等[15]利用多尺度损失和扩张的卷积来消除伪像对JPEG 压缩任务的影响。这些方法都验证了空洞卷积在图像应用中的有效性。其次,TIAN等[16]提出稀疏性对于图像应用也是有效的,可以减少去噪网络的深度,有利于降低计算成本和内存消耗。TIAN等[17]验证了网络前12层中Dilated Conv+BN+ReLU和Conv+BN+ReLU错综交替可以被视为是稀疏的,其中,BN为批量归一化处理,ReLU是激活函数,空洞卷积的空洞率为2。这不仅可以提高训练的降解性能和效率,还能降低模型复杂度,基于此,本文将其作为此网络的特征提取模块。在稀疏块中,Conv+BN+ReLU分别在第1、3、4、6、7、8、10以及11层,Dilated Conv+BN+ReLU分布在第2、5、9和12层。空洞卷积既能尽可能避免信息损失,保持图像输出特征的尺寸大小,又能获得更多的上下文信息。具体而言,1~12层的卷积滤波器大小为3×3。第1层输入为噪声图像的通道数即1或3,第2~12层的输入和输出都为64。特征提取模块的输出O1可表示为O1=Function1(IN),。其中IN表示输入的噪声图像,Function1表示特征提取模块的功能函数。

2.2 通道注意

WOO等[18]提出了一种卷积注意模块,其将通道注意和空间注意结合起来,用于高级视觉任务。在真实图像去噪方面,肖娟等[19]通过对加性高斯白噪声与真实噪声的灰度直方图进行分析,用于去除图像的真实噪声。注意力机制能使网络模型自适应地获取隐藏在复杂图像背景后的隐藏信息,从而提升模型的表达性能与去噪能力。典型的注意力网络为Squeeze-Excitation 网络(SE-Net),其原理如图3所示。

图3 Squeeze-Excitation模块

Squeeze压缩操作是将输入的空间特征维度进行压缩,类似于进行池化操作且被压缩后特征的通道数不改变,C表示特征的通道数目。该过程的数学表达式为,c=1,2,3,…,C,其中uc代表第c个特征通道。Excitation操作获取通道之间的依赖关系,通过参数W给每一个特征通道生成权重,再将该权重用于原来的所有通道并学习不同通道的重要程度,因此使用两个全连接层FC来学习通道之间的依赖关系,最后再通过sigmoid函数对权重进行归一化(将各通道的权重值限制在0-1,权重和限定为1),其公式为s=Fex(z,W)=σ(W2δ(W1z)),其中,δ和σ分别为ReLU 和Sigmoid 函数,W1表示对特征维度进行降维,W2表示对特征维度进行升维。最终将学习到的各通道激活值乘以原始特征,公式为=Fscale(uc,sc)=sc·uc。

中间残差块负责在特征空间中执行去噪任务,一个残差块由三个Conv+BN+ReLU、一个Conv、一个通道注意力模块,以及后面的执行跳跃连接,残差块中每个Conv有64个大小为3×3×64的滤波器。该功能计算公式为O2=Function2(O1),其中,O2为残差块的输出,O1为上一层输出并作为本层输入,Function2表示该块的功能函数。最后一个块为3×3×1大小的单个Conv层,以构建最终的干净图像,此功能计算公式为O3=IN-Function3(IN),其中,O3为重构块的输出即最终的潜在图像,IN为输入的噪声图像,Function3表示整个模型所预测出的残差图像。

为了训练CDNet,文中使用L2损失函数。给定一个训练数据集D={…,(I(i),J(i),…)},其中I(i)和J(i)代表第i张噪声图像以及其对应的ground truth 无噪声图像。所采用的损失函数表达式为

3 实验结果与分析

3.1 实验设置

实验硬件平台为NVIDIA RTX 3060,深度学习框架为Pytorch1.8、Cuda11.1 和CuDNN 8.0。训练数据集来自于BSD数据集的训练集。通过设置0.9、0.8和0.7的比例因子以对每幅图像进行下采样。然后将每个图像随机裁剪成180×180大小,并从每幅被裁剪后的图像中提取40×40的patch,且stride设置为10。在整个实验过程中,通过零均值随机初始化以及0.000 5的标准差来初始化所有普通卷积层的权重,并使用Adam优化器来优化模型。

实验将训练三个噪声水平:σ=15、σ=25以及σ=30的模型。最终每个epoch生成了45 563个patch,同时采用峰值信噪比(PSNR/dB)和结构相似性(SSIM)[20]作为最终的数据评价指标来衡量并比较各个模型的去噪性能。PSNR和SSIM越大则去噪性能越好。为了验证该网络的去噪性能,与DnCNN[6]、FFDNet[10]、IRCNN[21]几种常见的网络模型进行对比,测试数据集则使用公开数据集Set12中常用的7张图片以及Set68中的10个测试集。

3.2 去噪性能对比

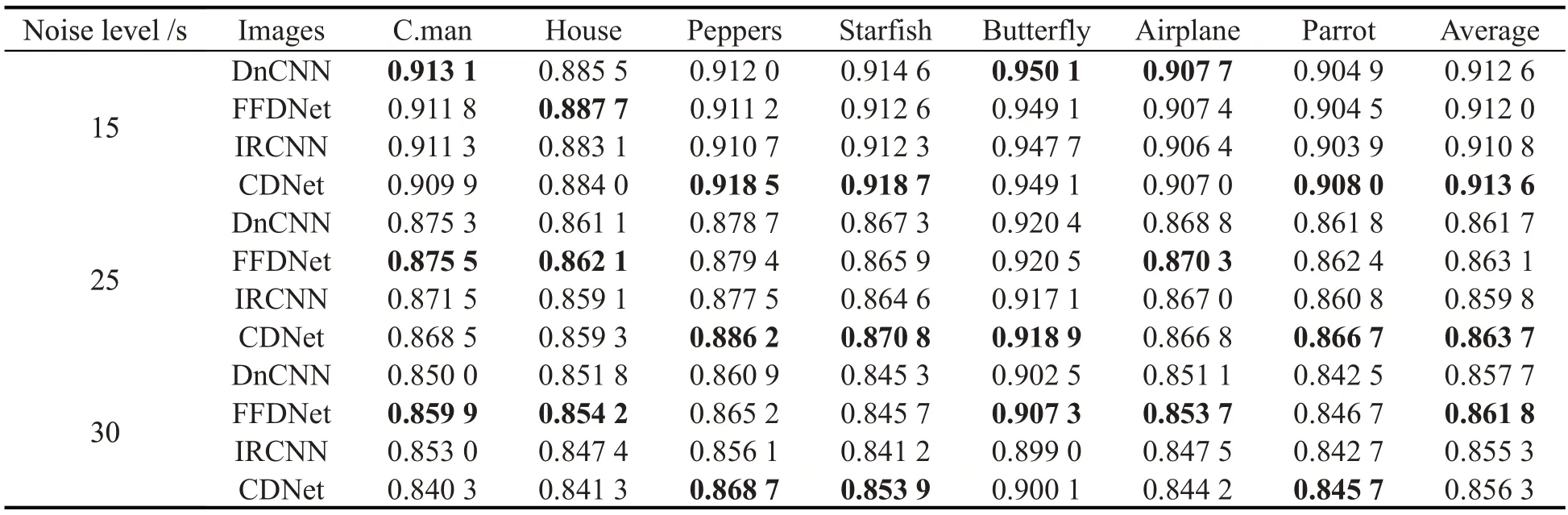

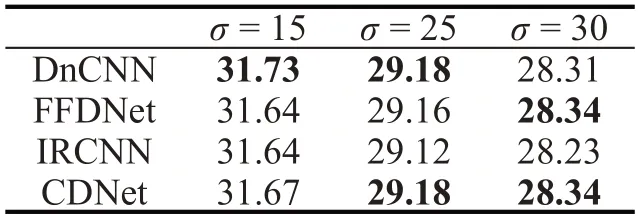

表1~2 给出了各算法在Set12 和Set68 上的PSNR 值和SSIM 值,其中,表1 为各算法在不同水平高斯白噪声强度下(σ=15、σ=25、σ=30)的PSNR 值。表2 则为各算法在不同水平高斯白噪声强度下(σ=15、σ=25、σ=30)的SSIM值。由于不同图像之间的结构存在差异性,因此不同的去噪算法在不同验证集上的去噪性能也会产生不同程度的差异性。

表1 Set12上不同算法的PSNR值

表2 Set12上不同算法的SSIM值

从表1和2可以看出,该网络在高斯噪声水平为σ=25和σ=30情况下,除了σ=30的平均SSIM值稍逊于FFDNet[10],其PSNR值均取得了最好的平均指标,表明此网络在该水平高斯噪声情况下的去噪效率整体处于优势。图4给出了“Barbara”(σ=25)去噪图像的视觉效果。可以看出CDNet可以较好地保持一些边缘特征,在纹理和边缘结构上具有一定的长处。

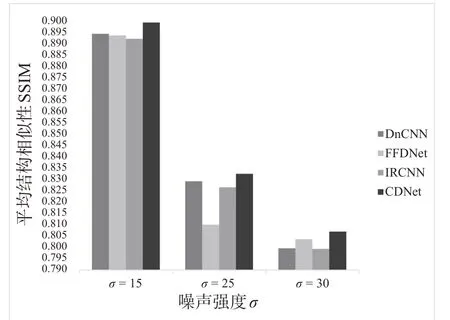

从表3和图5也可以看出,在数据集Set68上,各种不同噪声强度情况下CDNet 的SSIM 值均高于其他模型,且都有较强的优势。同时在中高噪声的水平下,该网络的PSNR值也都不逊色于其他对比网络。

表3 Set68上不同算法的平均PSNR值

图5 Set68上不同算法的平均SSIM值

4 结束语

该文在DnCNN 的基础上组合了通道注意力机制和稀疏机制,构建了一种通道注意力引导的去噪卷积神经网络。注意力模块使网络模型自适应地获取隐藏在复杂图像背景后的信息,由空洞卷积和普通卷积构成的具有稀疏性的网络部分可以增加感受野,并减少网络深度,从而降低数据维度以减少计算量,提高了网络模型的性能与效率。对比结果表明,该去噪网络在各类公开数据集上都可以取得很好的效果。接下来,作者将继续研究注意力机制对卷积神经网络的自适应性,进一步提高模型对不同类型图像特征的表征能力,从而更广泛有效地处理各种去噪问题。