融合子空间共享特征的多尺度跨模态行人重识别方法

2023-02-18王凤随刘芙蓉钱亚萍

王凤随 闫 涛 刘芙蓉 钱亚萍 许 月

(安徽工程大学电气工程学院 芜湖 241000)

(检测技术与节能装置安徽省重点实验室 芜湖 241000)

(高端装备先进感知与智能控制教育部重点实验室 芜湖 241000)

1 引言

随着计算机视觉技术的进步,创建无处不在的智能监控系统成为可能,安装可视摄像机和红外摄像机能够监控不断变化的环境,加强对犯罪的检测,为公共安全提供保障。该技术关键在于跨越不同的摄像机来匹配相同身份的行人图像。然而,大多数现有行人重识别(Re-IDentification, Re-ID)技术只关注在白天或者在光线充足的场景中用可见光谱摄像机来搜集可见光RGB(Red Green Blue)图像,专注于RGB图像的匹配,例如文献[1-3],这就具有很大的局限性。夜晚进行犯罪活动等违法行为时,很难用可见光谱的摄像机来进行识别。但是现在大多数监控摄像头可以在夜间捕捉红外(Infrared, IR)图像,这就可以为跨模态的相关任务提供可用的信息。在这种情况下,传统的Re-ID技术不能解决这种问题,因为RGB图像和IR图像具有巨大的差异性。具体来说,红外图像缺少颜色信息,而RGB图像具有丰富的颜色信息。

为解决这一问题,Chen等人[4]提出了一种新颖的摄像机协同关系感知特定视角下的特征增强框架,解决复杂场景下行人重识别问题。随后,更多关注跨模态可共享全局特征的工作来理模态差异。Y e 等人[5]提出了一种双流网络架构T O N E(TwO-stream CNN NEtwork),该方法同样是关注全局特征来扩大特征的类间差异。同时,Dai等人[6]采用生成对抗网络的方法来生成不同模态下的图像,提出了一种交叉模式生成对抗网络(cross-modality Generative Adversarial Network, cmGAN),该网络可以学习模态不变的特征表示。这些方法都是通过全局特征进行学习,但是全局特征往往对背景杂波敏感,不能很好地处理模态的差异。因此,基于这种缺陷,Ye等人[7]提出了一种非局部注意力成分来恢复图像的部分信息。Zhu等人[8]提出了一种双流局部特征网络(Two-Stream Local Feature Network, TSLFN),该方法通过在特征提取模块中不采用下采样操作来扩大局部特征的感受野,但仅仅也只是关注到了局部的细粒度信息,从而忽略了全局的粗粒度信息,没有尝试全局与局部特征的多粒度特征融合。

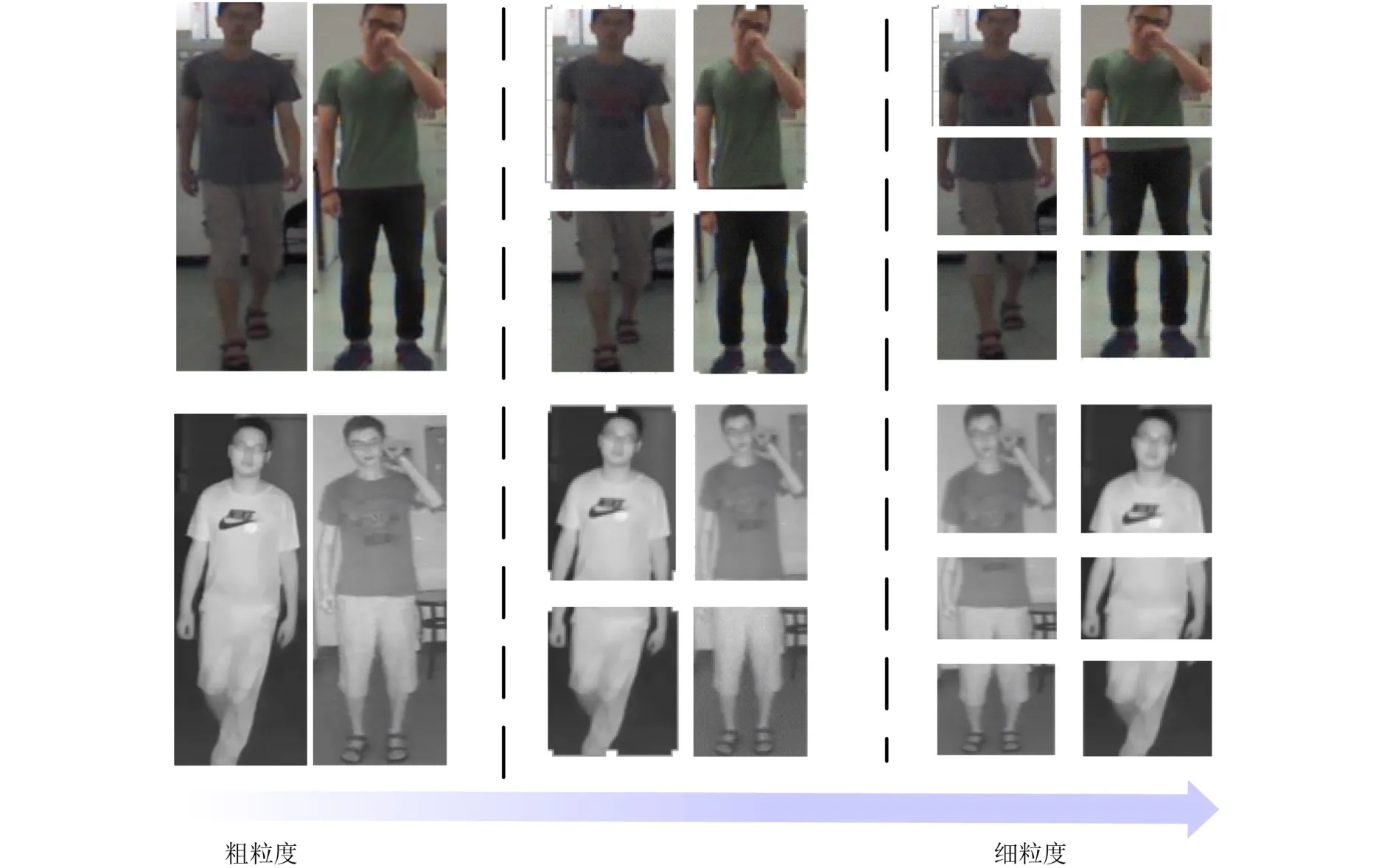

针对上述问题,受Wang等人[9]在单模态下提出的多粒度网络的启发,本文提出了一种针对跨模态端到端的特征学习策略,该策略集成了不同粒度的判别信息。设计了一种新的多粒度共享特征融合(Multiple-granularity Shared Feature Fusion,MSFF)网络,所提MSFF框架旨在学习两种模态共享的全局和局部特征表示,是一种多分支网络体系结构。在框架中,采用一个全局特征表示的分支和两个用于局部特征表示的分支组成。本文将只有一个完整的全局信息看作最粗糙的信息,随着分块的增加,局部的部分特征可以更多地集中在每个分块中更精细的判别信息上,如图1所示,行人身份从粗粒度信息到细粒度信息划分的越来越详细,更多有用信息被捕捉到。

图1 行人从粗粒度到细粒度开始详细划分

此外,本文在骨干网络中设计了子空间共享特征模块,将来自不同模态的特征信息对齐投影到同一子空间中,共享更多权值,使网络提取更有效的共享特征,同时有利于损失函数进行约束,来扩大特征类间差异和提高类内跨模态相似性。在公共数据集上进行了一系列的实验,实验结果表明本文所提MSFF网络框架有着优越的性能。本文主要贡献如下:

(1)本文提出了一种新的MSFF网络结构框架,该框架结合了全局和局部特征来学习两种模态的不同粒度表示,共同学习图像的多尺度信息,最后形成更强的特征描述符。

(2)提出了一种子空间共享特征模块,在该模块中将两种模态各自的特征提前映射到同一子空间中,使骨干网络共享更多的权重参数,提取更有效的共享特征,同时有利于损失函数更好地监督约束网络,实现扩大类间的差异和提高类内相似性。

(3)在两个公共的数据集上进行实验表明,该网络框架具有很好的性能和可靠性。

2 本文算法

2.1 网络总体框架

单模态行人重识别中,一种经典的方法是文献[10]中将局部特征进行切片与LSTM(Long Short Term Memory)网络合并,并与从分类度量学习中学习的全局特征相结合。在文献[9]中特征被连接表示身体的局部结构和全身结构,行人身体的结构是行人固有的属性,该结构的表示不随着模态的变化而改变,所以行人身体结构信息是跨模态中共享的。基于这一特性本文提出了适用于跨模态的MSFF网络,其网络结构如图2所示,包含多尺度特征提取模块和特征嵌入模块。

图2 本文算法整体网络结构

2.2 多尺度特征提取

网络由两条路径(可见光路径和红外路径)组成,分别从两种模态中提取信息,在每条路径中采用ResNet-50作为本文的骨干网络[11],不同之处在于,在骨干网络的第3层之后又分为3个独立的分支,提取图像的全局和局部特征。

表1列出了这些分支的结构设置,第1个分支中,骨干网络的第3层之后采用下采样,在相应的输出特征图中我们采用全局最大池化操作[12],该分支中没有任何分区信息的情况下学习全局特征表示,该分支命名为全局分支(Part-global)。然后,采用全连接层(Fully Connected, FC)来进行特征向量的降维。对于FC层,采用一个Leaky ReLU(Rectified Linear Units)激活层和一个批处理归一化层[13],使特征维度由2048减少到512。第2个分支中,采用与全局分支相似的网络结构,与全局分支不同在于,骨干网络的第3层之后没有采用下采样操作,为局部特征扩大感受野,丰富特征粒度,该部分作为第2个分支的全局特征。同时分支输出特征映射在水平方向上被均匀地分割成两个部分,两部分别表示行人的上半身和下半身,作为第2个分支的局部特征。在该分支中得到这些特征向量之后,执行与全局分支相同以上操作来学习全局和局部特征,该分支命名为Part-1。第3个分支中,与第2个分支具有相同的网络架构,不同的是将输出的特征映射在水平上均匀地分为3部分,表示行人的头部,上半身和下半身。得到这些特征条带之后执行和Part-global, Part-1相同的操作,该分支命名为Part-2。

表1 网络3个分支的结构设置

2.3 子空间共享特征模块

子空间共享特征模块旨在骨干网络中提前共享两种模态更多特征,首先可见光图像xiRGB和红外图像xiIR分批次的输送到双流网络中提取各模态特定的特征,然后经过子空间共享特征模块将两种模态特征对齐并映射到同一子空间中,使网络产生更丰富的共享权值,本文采用在骨干网络的第4层加入了子空间共享特征模块,表述为

其中,yiRGB⊆RC×H×W和yiIR⊆RC×H×W分别为经过双流网络得到模态特定特征的可见光图像和红外图像的特征图,其中C表示通道数目,H和W表示图片的长和宽。feat表示提取两种模态特定特征支路。cat用于连接两种模态的对齐特征,将连接起来的对齐特征投影到同一子空间中。Conv表示将子空间的对齐特征进行卷积。Yi表示经过骨干网络得到的两种模态共享特征。

在测试阶段,根据模态将图像输入到相应的分支中。然后,将特征向量进行L2归一化。最后,所有的特征向量连接起来形成最后的特征描述符,训练好的模型测试过程中,给定一个探针图像,提取所有异质图库图像的特征描述符,接下来根据探针和所有图库图像的欧氏距离对图库图像进行排序,异类的类内图像最高的相似性。

2.4 特征嵌入模块

特征嵌入模块是用损失函数来约束网络学习的特征表示,从而扩大类间的差异和提高类内跨模态的相似性,所以采用交叉熵损失和异质中心损失(Hetero Center Loss, HC Loss)联合对网络进行监督。对于交叉熵损失,将全局和局部特征向量输入到分类器中,该分类器由全连接(FC)层和softmax激活层组成。本文有8个特征向量输入到8个独立参数的分类器中,分类器预测每一个特征向量的身份。在每一个分支中,根据分类器的预测值和图像的身份标签来计算交叉熵损失。对于异质中心损失,在进行计算时要先经过L2归一化。最后,各个分支的损失在训练阶段用来更新相应的参数。

2.5 损失函数设计

在跨模态行人图像中,行人的身体结构是行人固有的属性,属于模态共享信息,不随着模态的变化而变化,而对于行人的衣服颜色等属于模态的特定信息,这种特定模态的信息会降低相同身份的两个异质样本的相似性。这就需要相应的损失函数来监督网络学习到特定的信息。以往跨模态行人重识别方法中,采用交叉熵损失(Cross Entropy Loss,CE Loss)和3元组损失(Triplet Loss),对于交叉熵损失是用来刻画实际输出与期望输出的距离,主要用来行人身份的分类。对于3元组损失用于扩大类间差异和提高类内相似性。但是3元组损失不能很好地监督网络提取模态共享信息。所以,本文采用CE Loss和HC Loss联合监督的方法来监督网络,对于CE Loss计算公式为

其中,K表示批次的大小,xi表示第yi类中第i个样本提取的特征,Wj表示权重的第j列权重,b表示偏差项。从交叉熵损失公式可知,交叉熵损失的目的是提取特定的身份进行分类,所以在对行人特定信息(如行人衣服颜色)预测真实标签时能够监督网络提取,来形成描述符。本文采用CE Loss作为ID损失,而对于模态共享的信息交叉熵损失不能起到约束网络的作用。

因此对于模态共享的信息采用HC Loss来监督,HC Loss具有很强的聚类能力,能够约束两个模态特征分布之间的中心距离,提高类内跨模态的相似性。HC Loss计算如式(5)所示

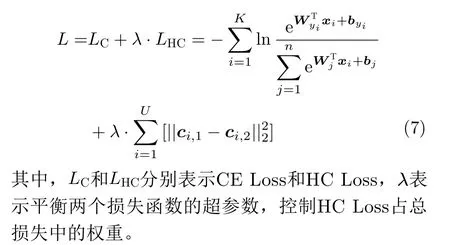

由于HC Loss仅约束图库图像各类的中心损失来提高类内的相似性,所以不能单独用来监督网络来扩大类间的相似性。本文采用文献[8]的损失函数监督策略来监督本文设计的网络,用CE Loss和HC Loss联合监督的方法来实现跨模态行人再识别的任务。在整个优化阶段实现端到端的训练,在每个小批次中,总的损失函数表述如式(7)所示

3 实验结果与分析

3.1 数据集描述

本文在两个公开的跨模态数据集SYSU-MM01[14]和RegDB[15]上进行了一系列实验来评估所提方法的有效性。SYSU-MM01是由中山大学采集的第1个跨模态行人重识别领域的大型数据集,如图3所示,这些图像在不同的摄像机之间和不同的模态、光照、环境、人的体态之间呈现出很大差异。它包括了287628张RGB图像,15792张IR图像,其中对应491个不同身份的行人,这些图像是由6台摄像机拍摄收集的,其中包括4台可见光摄像头和2台红外摄像头,摄像机位于室内和室外环境中。Camera 1, Camera 2,Camera 4, Camera 5为可见光摄像头,Camera 3, Camera 6为红外摄像头。该数据集包含的491个身份的行人中,每个身份至少由1个可见摄像机和1个红外摄像机捕捉。

图3 SYSU-MM01数据集中示例图像

评估方案实验,采用文献[16,17]将数据集随机分为两部分,一部分用于训练,一部分用于测试。训练集包含395个身份的22258幅可见光图像和11909幅红外图像。测试集包含了可见光图像和对应于95个身份的红外图像。在测试阶段,红外图像用作为探针图像,来搜索出测试集中的RGB图像。测试模式分为两种,第1种是全搜索模式,包括使用所有的摄像头;第2种模式是室内搜索模式,使用室内的摄像机采集图库图像。全搜索模式由于场景复杂多样性比室内搜索模式更加困难,而室内搜索模式更接近于理想状态,能更好地评估跨模态网络的检索性能。对于两种搜索模式下还设置了单镜头(Singlehot)和多镜头(Multi-hot),这两种模式的区别在于构成图库集时每个身份的图像量。在单镜头设置中,随机为每个身份选择一个图像来构建图库,而在多镜头设置中,每个身份包含图库集中10个图像。

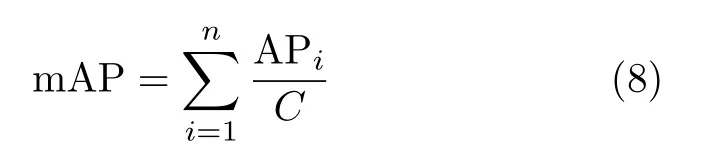

评估指标采用文献[17]中CMC、平均精度mAP作为评估标准;CMC表示第n次命中概率,即R-n (Rank n)表示搜索结果最靠前的n张图片的准确率,当n=1,10,20时即计算测试集中前1,10,20张与查询集中图片相似度排序后为同一标签的准确率。mAP如式(8)所示,APi表示类别的平均精度,C表示类别的个数。每个实验用随机测试集重复10次,以获得平均性能。

3.2 实验设置

本文实验环境配置为显卡GeForce RTX 2080ti, CPU为I9-10900k, 64 bit Ubuntu 16.04系统,CUDA10.0, Pytorch1.2。行人图像预处理成384×128大小;数据增广策略采用对图像进行随机旋转和剪裁;batch size大小设置为16;1个批次中行人身份数量设置为4,所以在每个批次中,每个身份包含4个RGB图像和4个红外图像。网络输出3个分支的特征图中每个条带的输出维度为2048,本文采用FC层将特征维度降为512。因此,测试阶段特征描述符的维数为8×512=4096。对于损失函数中λ参数设置,将λ的值设置为0.1来平衡HC损失函数。在训练阶段epoch大小设置为60;初始学习率设为0.01,前30个epoch的学习率为0.01,后30个epoch的学习率为0.001;优化器采用动量为0.9的SGD进行优化。

3.3 与其他方法进行比较

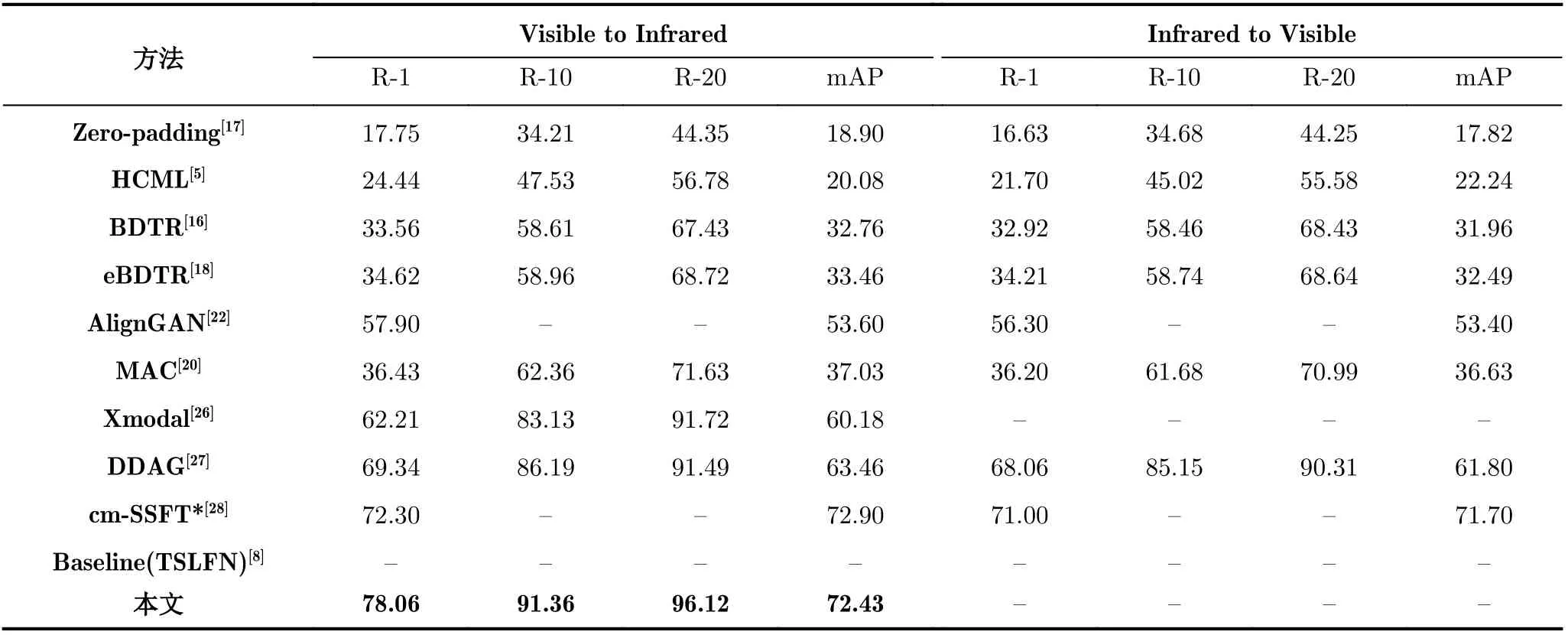

为了验证本文算法的先进性,将所提方法与以往跨模态的先进方法进行了比较。如表2与图4所示,比较的方法有Zero-padding[17], D2RL[19](Duallevel Discrepancy Reduction Learning), DPMBN[21](Dual-Path Multi-Branch Network), LZM[23](Local Zernike Moments), DDAG[27](Dynamic Dual-attentive AGgregation), TSLFN[8]等。其中DDAG[27]是利用注意力模块局部分块特征来细化样本的表示。Xmodal[26](X Modality)是利用中间辅助模态X,将两种模态的问题转化为三模态问题。

图4 在SYSU-MM01的All-search single模式下和其它方法对比

表2 在SYSU-MM01的All-search模式下和其他方法对比实验结果(%)

cm-SSFT[28](cross-modality Shared Specific Feature Transfer)实现了目前跨模态行人重识别的最高性能,该方法融合了模态共享特征和模态特定特征,可以基于最近邻传播来自不同模态的信息,但是该方法有复杂的网络结构,且需要辅助数据集,在现实应用中没有辅助数据集无法实现端到端的学习。对于基线TSLFN[8]网络采用局部条带的分支策略,用HC损失作为目标函数将正样本进行拉近,更加关注局部信息。

从表2和表3可以很清晰地看出在SYSU-MM01和RegDB两个数据集上所提出方法性能的优越性,在所有的搜索模式下都优于基线网络。表中最后一行展示了本文方法的CMC和mAP,即使在最困难的模式下,即全搜索单镜头模式下,本文方法在R-1, R-10, R-20分别超过了基线网络TSLFN方法2.97%, 2.18%, 0.85%,mAP的性能上提高了5.67%。其中“-”表示原论文中没有报告的结果。

表3 在RegDB数据集和其它方法对比实验结果(%)

3.4 消融实验

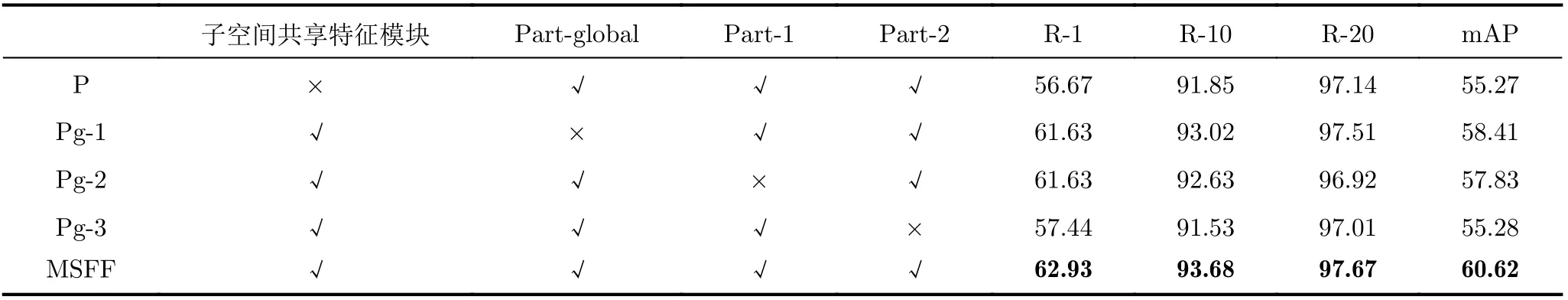

本文在SYSU-MM01数据集单镜头全搜索模式下进行了一系列消融实验,来证明MSFF网络各个分支的有效性。在每个对比实验中,参数设置为相同,因为本文网络有3个分支,在消融实验过程中采用依次删除子空间共享特征模块、Part-global,Part-1, Part-2分支分别训练,验证该模块和分支是否在网络中缺一不可。

如表4所示,其中P表示删除子空间共享特征模块,在本文设计的MSFF网络的基础上进行训练,实验结果发现采用本文设计的网络结构框架在性能上依然相比基线(TSLFN)网络要高。Pg-1表示删除网络的第1个分支(Part-global),保留子空间共享特征模块、Part-1和Part-2分支,在删除网络中第1个全局分支之后发现性能下降,R-1和mAP分别下降1.3%、2.21%,可见该全局分支表示的粗粒度信息能够被网络学习到。Pg-2表示删除第2个分支(Part-1),保留其余的模块和分支。删除的分支中包含一个全局特征分支和一个特征图分成两部分的局部特征分支,实验结果表明在删除的第2个分支后R-1和mAP分别下降1.3%、2.79%,相比于Pg-1下降得更明显,这说明特征图分为两部分的局部特征分支在网络的训练过程中能够学习到细粒度的有用信息,例如,行人衣服上图案的形状等细节特征。Pg-3表示删除第3分支(Part-2),保留其余的模块和分支。该部分删除的分支中包含全局特征分支和一个特征图分成3部分的局部特征分支,在删除该分支后性能明显下降,R-1和mAP分别下降5.49%, 5.34%。充分体现出第3分支的重要性,既能学习到行人粗糙的全身信息又能学习到行人各个部位的细粒度信息。MSFF表示保留网络中各个模块和分支的完整结构。

表4 网络各个模块在SYSU-MM01数据集All-search single模式下实验结果(%)

通过上述消融实验结果能够看出网络中的这些局部特征在性能上有很大的提升,有了更细粒度的信息之后能够得到更好的结果,通过将特征图分割成若干块,该模型能更加集中行人样本中的细节信息,获得更高的精度。局部特征的方法验证了行人局部特征能提供丰富的匹配线索信息。另外,也证实了局部特征和全局特征结合的有效性,在MSFF网络框架形成的最终描述符中结合了局部特征和全局特征,显著提升性能。局部特征提供细粒度的信息,而全局特征补充整体行人特征表示。

3.5 参数和子空间共享特征模块位置分析

本节进行了一系列实验来研究总损失函数中参数λ的影响。参数λ影响总损失函数中HC Loss所占权重,λ的值以0.1为区间,从0.1到0.5进行实验。图5(a)所示在全搜索单镜头模式下,不同λ的值在SYSU-MM01数据集上的性能。观察到λ的最佳值是0.1,随着λ的增加,mAP的性能逐渐下降,网络收敛速度降低,当λ取0.3, 0.4, 0.5时网络甚至不收敛。分析得出可能是因为两种模态的共享信息不够,使得网络无法将两种模态的中心距离拉的更近,不能在正确的方向上优化HC Loss,导致过拟合。

为验证子空间共享特征模块在骨干网络中位置的影响,分别将该模块依次加入到骨干网络中,如图5(b)所示在SYSU-MM01数据集全搜索单镜头模式下,该模块在MSFF网络中不同位置的性能实验结果。其中横坐标表示依次加入到骨干网络第2层、第3层和第4层,FC表示不在骨干网络中加入子空间共享特征层,而是在网络最终层之后全连接层共享特征,使两种模态有更多的单独层提取各自特定的特征。实验发现,在骨干网络第4层及之后加入性能最好,网络的最终层之前更多的单独层可以生成更多的异构特征,在损失函数的约束下扩大不同模态的类间差异。但是过多的单独层使得两种模态的共享特征信息不够,不利于提高不同模态的类内相似性。同时,过多的共享特征层会使得异构特征信息不够,导致损失函数优化过程的低效性。

图5 不同λ和子空间共享特征模块在MSFF网络中不同位置的性能实验结果

4 结束语

本文针对跨模态行人重识别提出了一种新的多粒度共享特征融合网络(MSFF),该网络是一种新的多分支深度网络,从跨模态图像中学习局部和全局特征的区别性表示,不引入局部注意力或姿势估计等区域定位的方法,实现完全的端到端。此外,本文还提出了子空间共享特征模块,用于网络提取更有效的模态共享特征,在CE损失和HC损失联合监督约束下,实现跨模态行人重识别重要的目标,扩大类间的差距和提高类内相似性。在两个公共数据集上,进行了消融实验以及与现有的先进方法进行比对实验,充分验证了所提方法的先进性,具有更好的鲁棒性和识别精度,为该领域提供了简单有效的思路。