一种时空特征融合的鲁棒视觉跟踪算法

2023-01-07杨志龙侯志强余旺盛张成煜马素刚

杨志龙, 侯志强, 余旺盛 , 蒲 磊, 张成煜, 马素刚

(1.西安邮电大学计算机学院,西安, 710121 ;2.空军工程大学信息与导航学院,西安, 710077;3.火箭军工程大学作战保障学院,西安, 710025)

视觉目标跟踪是计算机视觉领域研究的热点之一,在视频理解、人机交互、无人机、自动驾驶等方面具有广泛的应用[1]。近年来,视觉跟踪领域涌现出诸多优异的成果,但仍然面临着不小的挑战[2],在跟踪过程中,当目标发生形变、遮挡、旋转、运动模糊以及处于复杂场景等情况下,往往会造成目标丢失。

近几年,相关滤波跟踪算法[3]以其良好的跟踪性能吸引了众多研究人员的关注。相关滤波类跟踪算法通常采用手工特征[4-6]对目标外观进行表征,基于深度学习的CNN特征[7]也被广泛应用,并取得了良好的跟踪效果。文献[8]在分析了深度特征和手工特征各自的优势后,提出不同特征应区别对待,调整不同特征的权重系数进行融合,发挥不同特征的优势,进一步提升了跟踪器的性能。在基于相关滤波的跟踪算法中,ECO算法[9]表现突出,该算法使用了CN特征、HOG特征和CNN特征的组合,获得了很好的跟踪性能。

但上述这些特征都属于表征目标表观特征的静态信息,在运动目标的跟踪中,如果引入表征目标运动特征的动态信息或者时序信息,应该能够进一步提升算法的跟踪性能。文献[10]提出递归全对场变换深度网络(recurrent all-pairs field transforms,RAFT),通过递归单元迭代更新的方式提取光流获取运动特征,该网络具有良好的泛化能力,并在推理时间和计算速度等方面具有较高的效率。运动特征被广泛应用于动作识别[11]和人体行为识别[12]中, 文献[13]在视觉跟踪算法中运用了深度运动特征,并取得了较好效果,但现有的跟踪算法大多数没有利用目标的运动特征,如何通过对目标的运动特征和空间表观特征的融合来提高算法的跟踪性能,是一个值得研究的工作。

此外,在跟踪过程中,对跟踪结果质量的判定可以有效减少模型累积错误导致的跟踪失败。常用的质量判别指标是根据目标响应图的变化来判断跟踪结果是否可靠,文献[14]提出了峰值旁瓣比(peak-to-sidelobe ratio, PSR),该方法通过响应图峰值尖锐程度来判定跟踪结果是否可靠。文献[15]在LMCF算法中提出平均相关峰能量(average peak to correlation energy,APCE)通过对响应图振荡的幅度来判断跟踪结果是否可靠。因此,可以依据相关的判别准则对跟踪结果的质量进行判定,以保证获得较好的跟踪结果。

综上所述,本文将在相关滤波跟踪框架的基础上,通过引入RAFT深度网络来估计光流,获取表征目标运动特征的时序信息,提取目标的CN特征和HOG特征,获取表征目标表观特征的空间信息,然后融合这两种信息以增强对目标时空特征的表征能力;其次,建立一种基于相似度的跟踪结果质量判别机制,根据跟踪结果实时调整时序信息在融合过程中的权重,以期在跟踪过程中更好地发挥不同特征的优势。在OTB100[16]和VOT2019[17]数据集上对所提出的算法进行了测试,实验结果表明,基于目标时序信息和空间信息自适应融合的跟踪算法有效提升了视觉跟踪算法的精度与成功率。

1 相关工作

为提升视觉跟踪算法的跟踪性能,本文选择了性能优异的ECO算法作为基准算法,将目标的运动特征引入到ECO算法中。ECO算法分析了影响跟踪算法的3个重要因素:模型冗余、时间复杂度和模型更新策略。针对模型冗余提出了因式分解卷积,针对时间复杂度提出了样本生成空间模型,在模型更新中主要减少了模型更新次数。接下来介绍ECO算法中的因式分解卷积过程和样本生成空间模型。

1.1 因式分解的卷积操作

SPf(x)=PfJ(x)=∑c,dpd,cfcJd{xd}=fPTJ{x}

(1)

式中:PT为线性降维算子。傅里叶域中滤波器求解目标函数表示为:

(2)

1.2 样本生成空间模型

该模型通过样本分类来简化训练集。通过概率生成模型减小冗余样本集进而使样本更紧凑。将样本进行编组,类似的样本划为一组,每一个组都代表一种特定的场景。即组与组之间差异性大,而组内比较相似程度高,该方法极大丰富了训练样本集的多样性。

根据样本特征x和对应的期望输出分数y的联合概率分布p(x,y),可将式(2)进一步完善为:

(3)

式中:E为联合概率分布p(x,y)的期望。样本x的关联输出y的形状是预先定义好的,在这里为一个高斯函数。假设为目标位于图像区域中心点,因此所有y都一致。将样本分布简化为P(x,y)=p(x)δy0(y)只需计算p(x)即可:

(4)

式中:L表示样本组的个数,i∈[1,L];样本组由N(x;μ;I)表示。将原训练样本替换为高斯模型均值μ1,使用高斯主成分先验权值π1代替原更新系数。引入上述模型后滤波器求解目标函数最终可表示为:

E(f)=

(5)

2 本文算法

本文首先引入递归全对场变换深度网络(RAFT)估计光流,以提取时序信息,然后,利用目标的运动特征和表观特征的互补性,融合目标时序信息和空间信息,以增强目标时空特征的表征能力,同时,建立了一种基于相似度的跟踪结果质量判别机制,根据跟踪结果实时调整时序信息在融合过程中的权重,在特征融合过程中发挥不同特征的优势,以获得更好的跟踪性能。

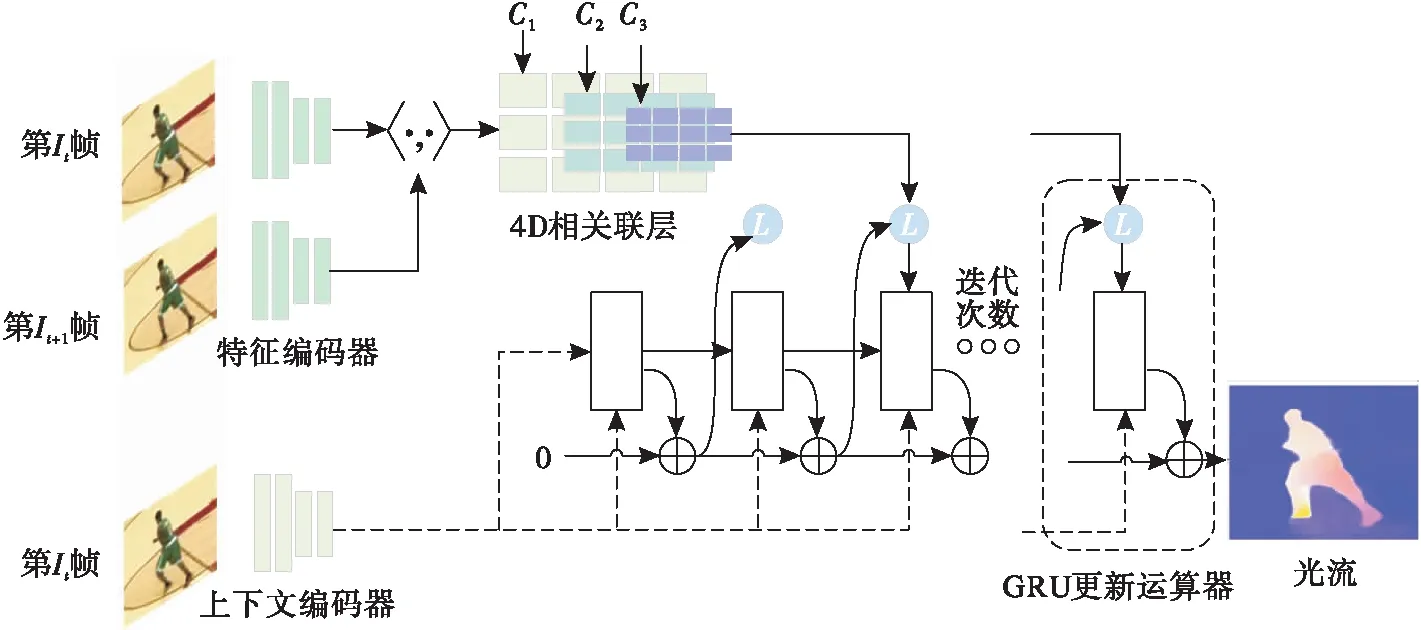

2.1 RAFT网络时序信息提取

RAFT是一种性能优异的光流深层网络结构,如图1所示。 RAFT主要由三部分构成:特征编码器、4D相关联层和基于门控循环单元[17](gate recurrent unit,GRU)的更新运算器。

图1 RAFT网络结构

定义视频的总序列为t={1,2,…,i},其中i为视频总帧数,第t时刻图像为It,选取t、t+1时刻连续2帧RGB图像输入网络。首先通过特征编码器提取It、It+1的特征,对It+1的特征图进行平均池化,池化核大小分别为{1,2,4,8};其次将池化后的特征向量分别与It的特征向量进行内积运算,得到一个4D的多尺度相关联层ck(k=1,2,3),图1中Ck的维度大小为H×W×H/2k-2;最后将相关联层特征向量和上下文编码器特征向量输入GRU更新运算器,GRU更新运算器的输出为最终光流。 RAFT网络估计了一个密集位移场(f1,f2),该场将It+1中的每个像素(u,v)映射到对应的坐标(u′,v′)=(u+f1(u),v+f2(v)),以描述每个像素在下一帧中的运动光流。其中光流场可以通过GRU更新运算器的迭代来更新。

在测试中,当直接利用RAFT网络计算的原始光流进行特征融合跟踪时,目标非常容易丢失,通过分析得知,ECO算法分别对CN特征和HOG特征进行了归一化处理,而原始光流没有进行归一化处理,使得3种特征融合时得到了错误的融合结果,造成跟踪失败。为此,我们对原始光流采用式(6)进行了归一化处理。

(6)

式中::xij为矩阵中对应的像素值;f′为归一化处理后的光流特征向量,通过对原始光流的归一化处理,使特征融合结果能够很好地用于目标跟踪,显著提升了算法的跟踪性能。

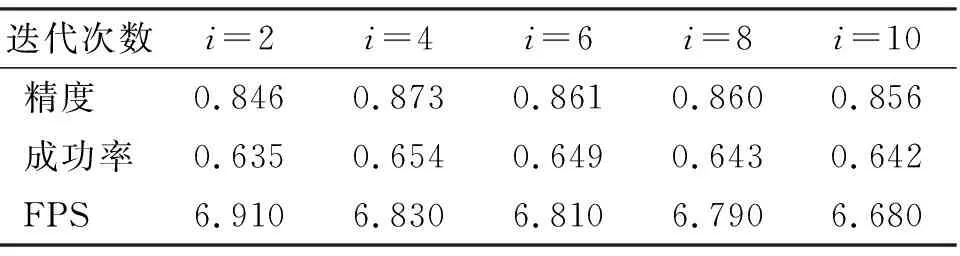

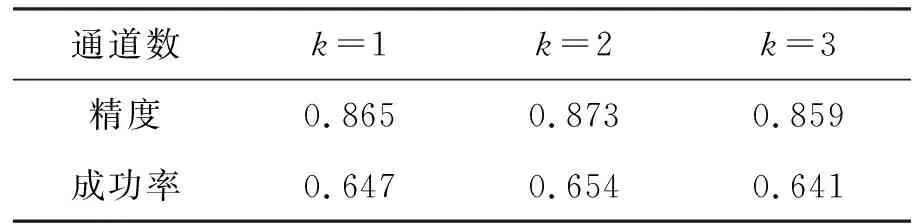

RAFT网络中,光流提取速度约为10 FPS,不同的迭代次数对跟踪速度和成功率有重要的影响,在OTB100数据集实验结果如表1所示。从表中可以看出,迭代次数为4时跟踪效果最好,而当迭代次数超过4时,不仅影响跟踪器的实时性,同时会降低跟踪器的性能。因此,为平衡跟踪器性能,本文将RAFT网络迭代次数设置为4,并在后续实验中采用该值。

表1 迭代次数对精度、成功率和速度的影响

2.2 跟踪结果质量判定

目标跟踪过程中,目标外观和背景随时间的推移不断发生变化,在目标遮挡或者外观出现剧烈变化时容易造成模型污染,从而导致跟踪失败,因此对跟踪结果的质量判定非常重要。这不仅会影响模型更新的策略,也会影响不同类别特征在融合过程中所占的比重。

APCE是根据响应图震荡程度来反映跟踪结果的指标,该指标定义如式(7)所示,当响应图峰值起伏越小则该值越大,说明跟踪结果可靠,反之当出现跟踪失败时该值会急剧下降。

(7)

当APCE突然减小时,可能发生目标被遮挡,或者目标丢失的情况,但当目标在快速运动、运动模糊或周围有干扰物等情况下,该值也会突然减小,而大多这种情况下跟踪结果却是可靠的,所以这时该值会对跟踪结果的质量造成误判。

对此,我们采用目标模板和候选模板之间的相似度来判断跟踪结果的可靠程度,该指标定义如下:

(8)

式中:Aobj为目标模板,选取图像的初始模板为目标模板;Bcdt为候选模板,每一帧的跟踪结果为候选模板;·为计算矩阵二范式范围为[0,1]。最后根据调整运动特征在融合过程中的权重。

2.3 特征融合

当目标处于复杂动态环境下,仅用空间特征表征目标的特征,其表征能力十分有限。针对不同特征之间的互补性,本文采用时序特征和空间特征的自适应融合方式对目标建模。采用的3种不同特征分别为:HOG、CN和光流。首先从训练样本X中提取不同类型的特征fj,提取目标的CN特征和HOG特征表征目标空间信息,将It、It+1时刻的相邻帧输入RAFT网络中提取光流,利用目标的运动特征和表观特征的互补性,融合目标时序信息和空间信息,增强目标时空信息的表征能力。

光流可以提取目标的运动信息,在复杂动态背景下相对于空间特征更有利于定位,但光流对周边相似运动干扰物十分敏感,这种情况下,如果光流设置权值过大会造成模型漂移。针对不同场景下光流在特征融合过程中体现的重要程度不同,本文采用式(8)对跟踪结果质量的判定,来调整光流在跟踪过程中所占的比重,对光流fflow乘以系数w。定义w为光流的权值,取值为:

(9)

式中:δ为目标模板和候选模板之间的相似度,α取值为0.3,β取值为0.7,当δ<0.3时,跟踪过程中可能发生遮挡、形变等情况,此时增加光流权值,可以更好地提取目标的运动信息,更有利于对目标进行定位;δ≥0.7时,为缓解目标周边相似运动干扰物造成的模型漂移,则减小光流的权值。在0.3~0.7时,光流权重为1。

相关滤波器分别与3种特征的特征图进行相关计算得到响应图,为保证响应图的质量,根据响应值大小对响应图通道进行筛选,取3个特征图响应值最高的前k个通道进行add融合,最后根据融合后的响应图Z估计新的一帧中的目标。特征响应值最高的前k个通道的计算过程如式(10)所示:

(10)

式中:P为响应值;fcn、fhog、fflow分别为CN 特征、HOG 特征和光流特征对应的响应图。

本文在OTB100数据集测试了k(k=1,2,3)对成功率和精度的影响,结果如表2所示,实验表明本文算法在k=2时,在融合过程中更好地发挥了不同特征优势,得到较好的成功率和精度。

表2 参数对成功率和精度的影响

2.4 算法流程

图2为本文算法流程图。首先提取目标的CN特征和HOG特征,利用RAFT网络提取连续两帧图像的光流,然后分别训练HOG 特征、CN 特征和光流的相关滤波器,通过相关滤波计算得到各自的响应图;根据跟踪结果的可靠程度来计算光流的权重,将光流乘以权重对光流特征进行调整,图2中绿色的线条模块为光流权重调整模块;最后,对3种特征响应图筛选后进行特征融合,根据融合后的响应图计算目标最终的位置。

图2 算法流程图

3 实验

为验证本文算法的有效性,在Ubuntu操作系统下,使用Python语言编程实现本文算法, 在Intel i5-8400 CPU@2.80 GHz处理器上进行测试,并利用GPU(NVIDIA GTX 1080Ti)进行加速。实验部分参数设置为: 目标尺度搜索个数K=5,学习率为P=0.009,尺度缩放参数初始化为R=4。为验证算法的实际效果,本文选择OTB100[18]、VOT2019[19]这2个经典数据平台进行评估。选择ECO-HC[9]等经典算法[20-26]作为参照算法。

3.1 OTB100实验

3.1.1 消融实验

表3为本文在增加不同模块下在OTB100数据上的实验结果的比较。实验性能评估指标采用OTB100数据集的评价指标,分别为精度和成功率,其中精度衡量算法对目标中心点位置的估计能力。成功率衡量算法对目标尺度大小的估计能力。从表中可以看出,在单独CN特征和HOG特征下的跟踪精度分别为0.796和0.804,成功率分别为0.618和0.610。在对3种特征融合后精度达到0.873和0.642,证明了跟踪过程中运动特征和空间特征互补融合的重要性。与基准算法相比,融合光流特征后精度提升1.2%,成功率提升0.8%;在对光流权重根据式(9)进行更新后,算法精度提升2.4%,成功率提升1.6%。

表3 本文算法在OTB100上的消融实验结果

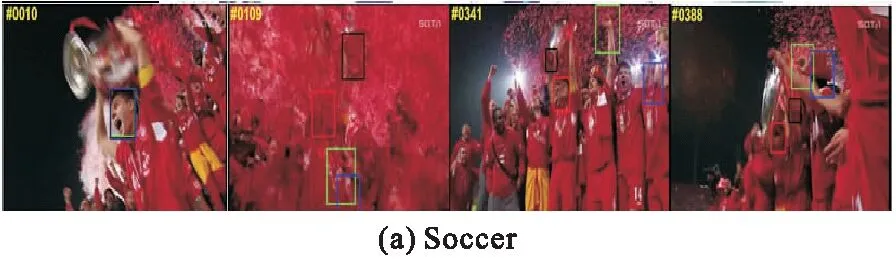

3.1.2 定性分析

图3(a)为Soccer视频序列,该视频序列背景复杂,目标在运动过程中的多次出现被大量相似干扰物遮挡的情况,目标在第109帧中目标几乎不可见,Staple和ECO-HC等算法无法准确跟踪,本文算法可以较好的跟踪且当目标刚从被遮挡区域恢复出来时仍能跟上目标。图3(b)为Dragon baby视频序列,该视频中的目标和小恐龙对打,目标姿态变化丰富。目标快速运动过程中极易发生跟踪漂移,其他3种算法在跟踪过程中均产生了不同程度的误差,本文算法有效缓解了因目标运动过快而造成的跟踪失败问题。图3(c)为Skating视频序列跟踪过程中背景光照发生变化,本文算法在低分辨率下能够很好跟踪目标。图3(d)为Biker序列,在跟踪过程中目标发生旋转,要求算法具有一定旋转不变性。部分算法出现跟踪漂移,本文算法和ECO-HC算法能够较好地跟踪目标。

3.1.3 定量分析

1)整体性能

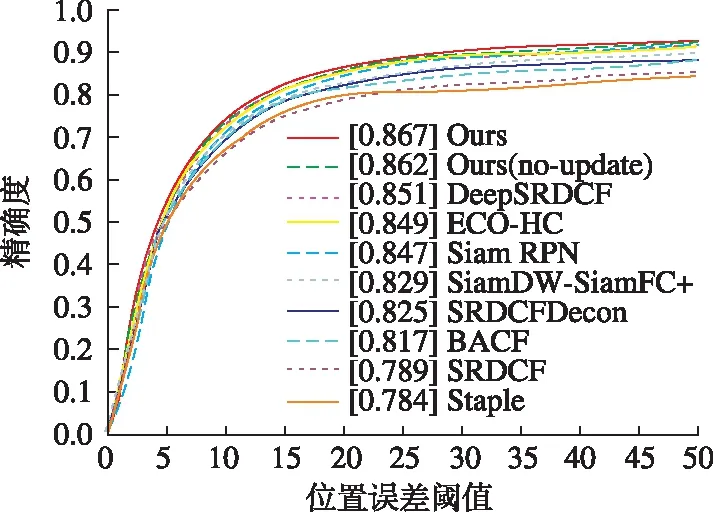

图4为本文算法与其他8种经典参照算法在OTB100数据集上评估结果。从图中可以看出,本文算法通过时序信息和空间信息的自适应融合,充分发挥了不同特征间判别力,相对ECO-HC算法,本文算法精度提升了2.4%,成功率提升了1.6%。

(a)精确度曲线

(b) 成功率曲线图4 不同算法精度曲线和成功率曲线

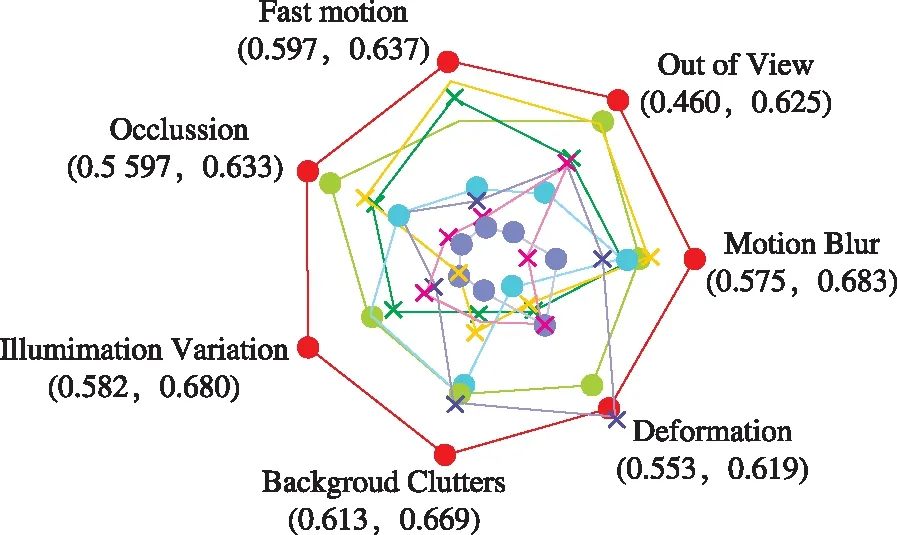

2)属性分析

在OTB100数据集测试了不同属性下的成功率曲线下面积(area under curve, AUC)并绘制了雷达图,如图5所示,运动类视频往往会出现图像低分辨,目标重影等情况。在该类视频中能够提取单帧图像的空间特征十分有限,本文算法充分利用了视频序列中帧与帧之间的时序信息。相对ECO-HC算法,在运动模糊视频中AUC提升3.6%;快速运动视频中AUC提升1.4%。在运动类视频序列中有明显优势。表明在应对复杂场景时本文算法具有很好的鲁棒性。

图5 视觉跟踪实验结果

3.2 VOT2019实验

为进一步评估本文算法在视觉跟踪中的有效性,本文在VOT2019数据集进行测试,并与其他7种经典的相关滤波类算法[27-29]进行比较,比较了EAO(expected average overlap, EAO)、精度和鲁棒性3个指标,结果如表4所示。其中最优结果加黑表示,次优结果加下划线表示,第3优结果加虚下划线表示。相对ECO-HC算法,本文算法在VOT2019数据集中EAO提升了1.7%,该结果进一步说明了基于时空信息和空间信息自适应融合算法在视觉跟踪中的有效性。

4 结语

本文提出一种时序信息和空间信息自适应融合的视觉跟踪算法。利用目标的运动特征和表观特征的互补性,融合目标时序信息和空间信息,增强了目标时空特征的表征能力;其次,建立一种基于相似度的跟踪结果质量判别机制,根据跟踪结果实时调整运动特征在融合过程中的权重,以适应复杂动态场景下目标的变化。结果表明,本文算法有效提升了跟踪性能,在一些具有挑战性的视频中跟踪效果良好。但是,光流在提取过程中计算量较大,在提升跟踪性能的前提下,如何减少光流在跟踪过程中的计算量将是本文未来的工作。