一种结合全局一致性与局部连续性的壁画修复方法

2022-11-14王欢李利李庆邓筠钰商惠敏

王欢 李利 李庆 邓筠钰 商惠敏

摘要:提出了一种全局一致性和局部连续性结合的壁画修复算法.主要利用线性系统和图像修复间所蕴含的关系,构建具有全局过完备特性的相似块集合字典,同时构造弹性网正则化下的稀疏修复模型,并用同伦-最小角回归法求解出过完备字典下的稀疏系数;通过字典与系数的线性组合,得到待修复区域的全局特征;之后提出一种基于领域相似特性的局部特征估计方法,得到待修复区域的局部特征;最后对上述得到的全局和局部特征信息做线性加权,完成整个待修复区域的填充.实验结果表明,本算法能很好地解决相关修复算法在修复时所出现的纹理错误填充、结构不连续以及“块效应”等现象,并且得到较好的修复结果.

关键詞:线性系统;敦煌壁画;稀疏表示;图像修复

中图分类号:TN911.73文献标志码:A

A Global Uniform and Local Continuity Repair Method for Murals Inpainting

WANG Huan1,LI Li1,LI Qing2,Deng Junyu3,SHANG Huiming1

(1. Industrial Technology Research Center,Guangdong Institute of Scientific & Technical Information,Guangzhou 510033,China;2. College of Civil and Transportation Engineering,Shenzhen University,Shenzhen 518061,China;3. School of Automation Science and Engineering,South China University of Technology,Guangzhou 510641,China)

Abstract:This paper proposes a global uniform and local continuity repair method for mural image inpainting. It uses the relationship between linear system and image repair to construct the similarity-preserving overcomplete dictionary with global weighted feature. Meanwhile,a novel sparse repair model with elastic net regularization based on similarity-preserving overcomplete dictionary is formulated to enhance the global feature consistency,and then an estimated method of neighborhood similarity is presented to guarantee local feature consistency,finally,a global feature patch and local feature patch weighted method are applied to obtain the target patch. Experimental results on damaged murals demonstrate the proposed method outperforms state-of-the-art inpainting methods.

Key words:linear systems;dunhuang murals;sparse representation;image inpainting

古代壁画有着极其珍贵的艺术和历史研究价值,是集建筑、彩塑于一体的综合艺术,其中以甘肃敦煌莫高窟的壁画最为出名.但由于饱受环境因素、重大自然灾害以及人为破坏等威胁,这个人类艺术宝库已变得异常脆弱.传统壁画修复工作主要是由有经验的专家或画家以手工临摹的方式进行.这种方式不仅和修复人员的经验直接相关而且效率低下,更重要的是这种修复方式有较大概率出现由于主观上对内容的错误理解而形成的错误复原,会给壁画文物带来不可磨灭的损失.而数字化壁画修复工作既可以将壁画文物永久保存,又可以通过计算机对壁画进行数字化修复,从而将壁画的真实面貌通过虚拟展示技术呈现在人们面前.

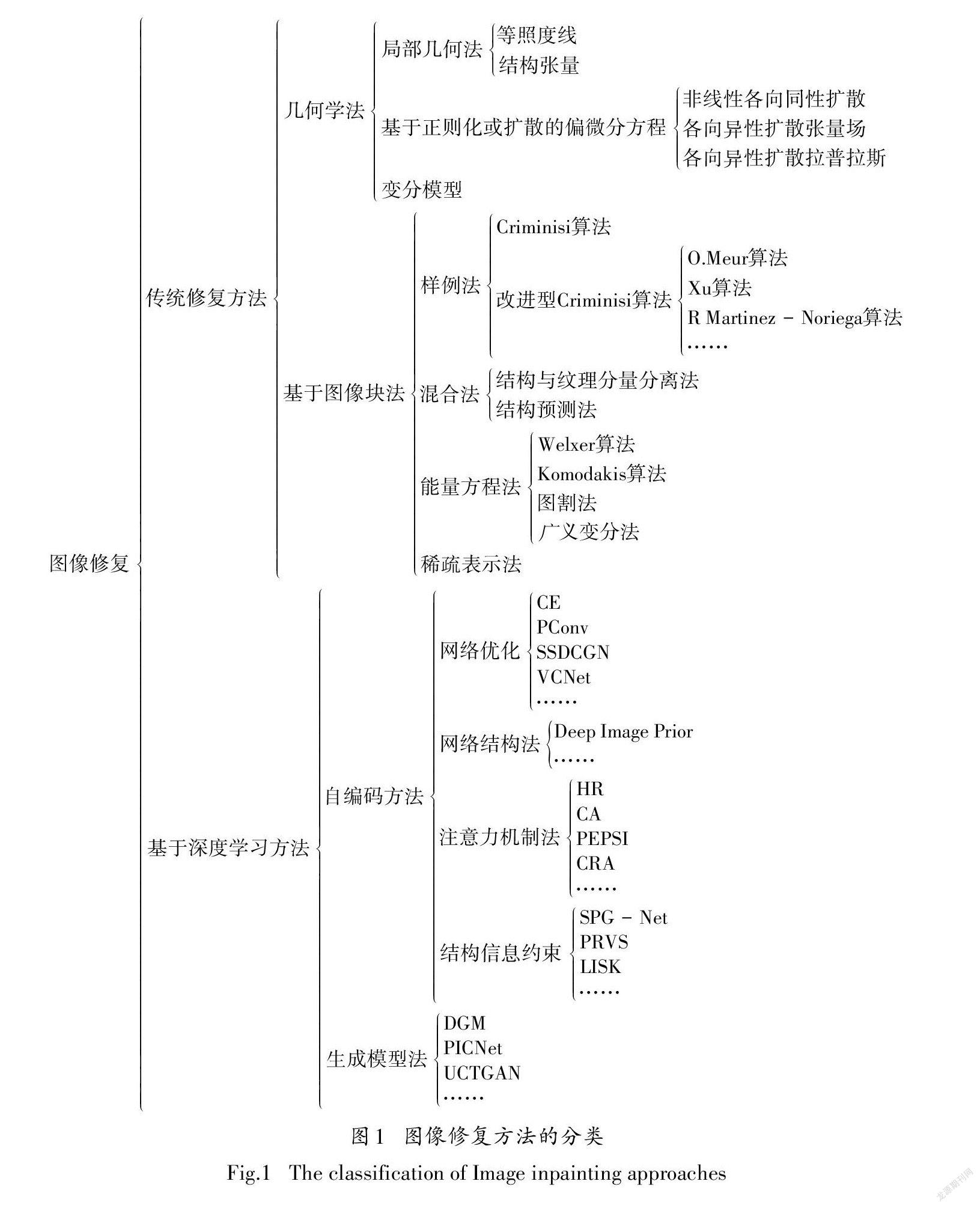

图像修复概念最早由Bertalmio[1]在2004年提出,目前已成为图像处理中的热门主题之一.近年来,图像修复发展迅速,目前主要分为传统修复方法和基于深度学习方法两大类.其中,传统修复方法分为几何学法和基于图像块法,基于深度学习方法则包括自编码方法和生成模型法.具体分类方法详见图1.

传统修复方法的几何学法[2-4]包括:偏微分方程或变分[2]的各向异性扩散,曲率[3]、相干性传播[4]的全变分[5]最小化,以及图像统计学方程的最小化⑹等.这些方法通过在参数模型或偏微分方程中引入的图像光滑先验信息,扩散已知部分到缺失部分的图像局部结构信息.该类方法优点在于适合完成直线、曲线和小区域的修复,但在重建大面积纹理和平坦区域时,会出现边缘模糊.

图像块法源于1999年Efros[7]和Zontak[8]的开创性工作,提出图像中已知部分可通过采样、复制将图像块粘贴在缺失部分里.该类方法可分为:样例法、混合法、能量方程法和稀疏表示法.样例法最早由Bornard[9]、Drori[10]和Criminisi[11]三位学者在2000年左右提出,这三种独立算法奠定了样例法的理论基础.之后,更多改进样例算法被提出[12-17],主要针对置信因子项[12-14],数据项[15],优先权函数[16]以及搜索空间[17]等方面的优化.

混合法[18-20]将几何法和样例法相结合,将有界变差-G范(Bounded Variational-G norm,BV-G)模型[18]运用到图像修复[19];Chen[20]提出结构指导下的多尺度全局优化修复算法.首先将缺失部位的显著性结构检测出来,之后通过羊角曲线和置信传播将缺失的结构曲线补全.但该类方法存在若缺失部位中包含有少量或大量纹理信息时,很难从图像中较好的分离出纹理和结构信息的问题.

能量方程法[21-33]则通过求解全局能量方程来修复图像,Wexler[21]提出了一种基于像素合成的图像块加权平均算法,通过最大期望法优化所提出的模型,将缺失部分修复完整.Komodakis[22]将图像补全作为基于置信传播的离散全局最优化问题,而Darabi[23]提出了文献的改进型算法.

稀疏表示法[24-28]率先由Elad[24]提出,指出稀疏表示模型能自适应的选择最优基,从而估计出目标图像.Xu[25]提出一种基于稀疏表示框架下的图像块扩散修复算法.Wang[26]提出一种线描图指导下基于稀疏表示的敦煌壁画修复模型,修复结果较好. Zhuang[27]提出了一种快速超光谱的低秩稀疏去噪和修复模型.

图像块法在面对大片纹理和边缘缺失的图像具有较好的修复效果.但该类方法存在如果缺失区域所需的信息不能在图像已知区域中找到,则通常无法得到令人满意的修复结果的问题.

近年来,随着深度学习技术的不断发展,越来越多的基于深度学习的图像修复方法被研究学者提出.目前,主要可以分为自编码方法和生成模型法[28].其中,自编码方法以网络结构为基本架构,该类方法也是基于深度学习主流的修复方法.根据优化角度不同,自编码方法包括网络优化、网络结构、注意力机制法以及结构信息约束等.

网络优化法[29-32]起初由Pathak[29]提出,作者构建了一种Context Encoder网络,通过引入重构损失函数和对抗损失函数来预测图像中缺失区域,但存在边界模糊的问题.Liu等[30]针对不规则缺损区域,通过设定的掩膜更新机制,提出了一种基于部分卷积的修复模型.针对不规律的缺损区域形状,Wang等[32]提出了一种两阶段视觉一致网络(visual consistency network,VCN),该方法解决了后处理中出现的模糊问题,提高了模型的泛化能力.

网络结构法由Ulyanov[33]提出,作者构建了一种全新的修复框架,对单张破损图像的未破损内容进行训练,将网络结构本身作为唯一的先验信息,不断迭代并反推出图像缺失区域的内容.该方法适合无法得到大量训练集,但单张图像的修复次数会增加数千次的情形.

注意力机制法[34-37]结合了传统修复中的块匹配思想.Yang等[34]利用Context Encoder作为全局预测网络,通过预训练好的网络提取圖像特征,最后完成纹理细节的填充.该方法对纹理具有较好的修复结果.Yi等[37]针对超高分辨率图像,提出了一种上下文残差聚合机制,该方法取得了较好效果,但该类方法存在输入、输出均是低分辨率图像的问题.综上,注意力机制法大多基于两阶段修复架构(低分辨率—高分辨率),且低分辨率结果对最终的修复效果的影响较大.

结构信息约束[38-40]类似混合法中的结构预测法.最初,Song等[38]将分割后得到的语义标签作为结构信息来指导缺失区域中的结构修复.但对具有相似语义标签但纹理不同的区域进行修复时,会出现修复错误.Yang等[40]引入了一个结构嵌入层,该模型可以同时修复图像内容和结构,还引入了注意力机制,有效提升了图像纹理细节的合成效果.

生成模型法[42-44]是指通过训练好的强大的生成模型,并利用已知先验分布修复破损区域.目前,比较有代表性的模型包括DGM[42]、PICNet[43]、UCTGAN[44]等.其中,Zheng等[42]提出了一种包含重构网络和生成网络并行的图像修复模型.其中,重构网络挖掘出图像数据的先验分布;生成网络预测缺失区域的潜在先验分布,同时结合重构网络生成较好的修复结果.但该类方法只适合处理低分辨率图像.

1提出的方法

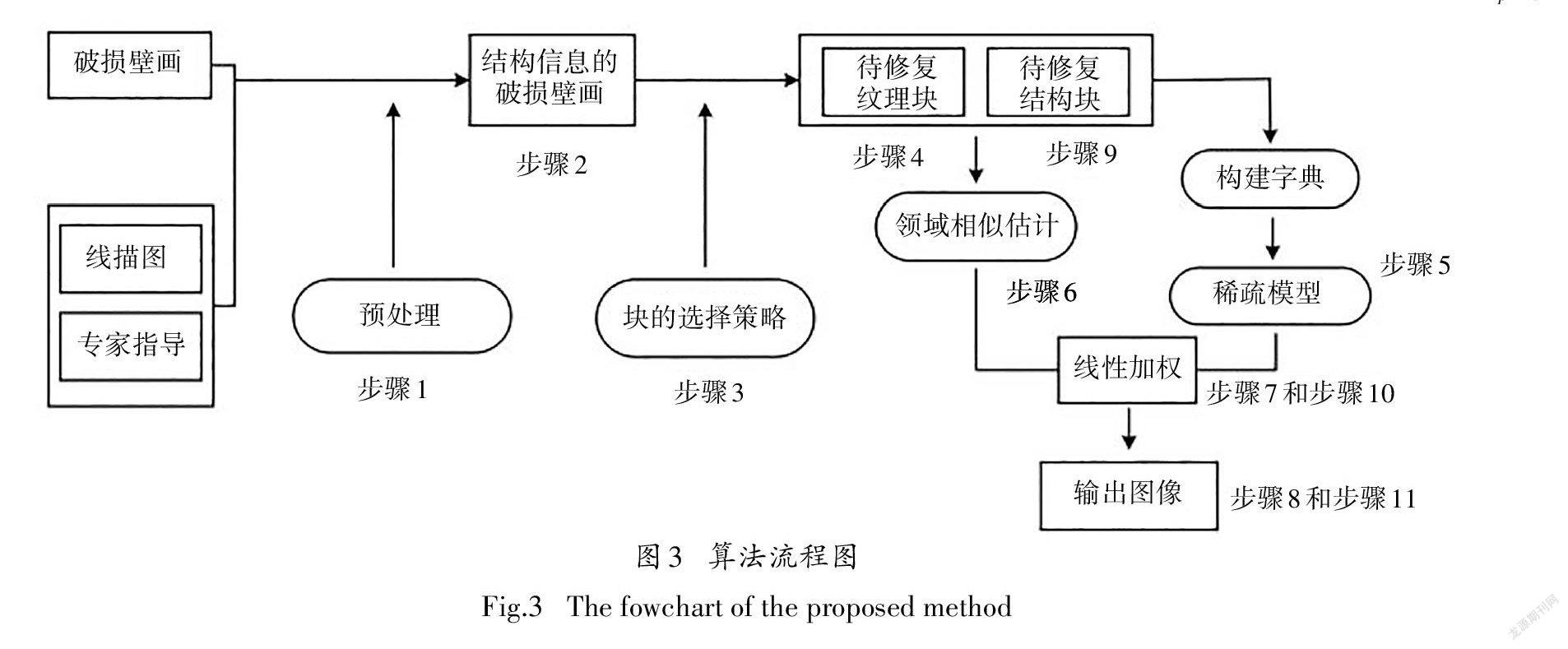

为更好解决上述问题,本文提出了一种全局一致性与局部连续性相结合的壁画修复方法.首先针对破损的敦煌壁画,根据对应的线描图[图2(a)]及专家指导[图2(b)],利用人机交互的方式将破损图像中破损区域缺失的结构信息补全;之后通过线性系统和图像修复之间所存在的内在关系,建立弹性网正则化下的稀疏修复模型;为了使填充区域满足局部连续性,提出了一种领域相似估计方法,最后,将上述得到的待修复区域的全局信息和局部信息做线性加权,实现待修复区域的填充.

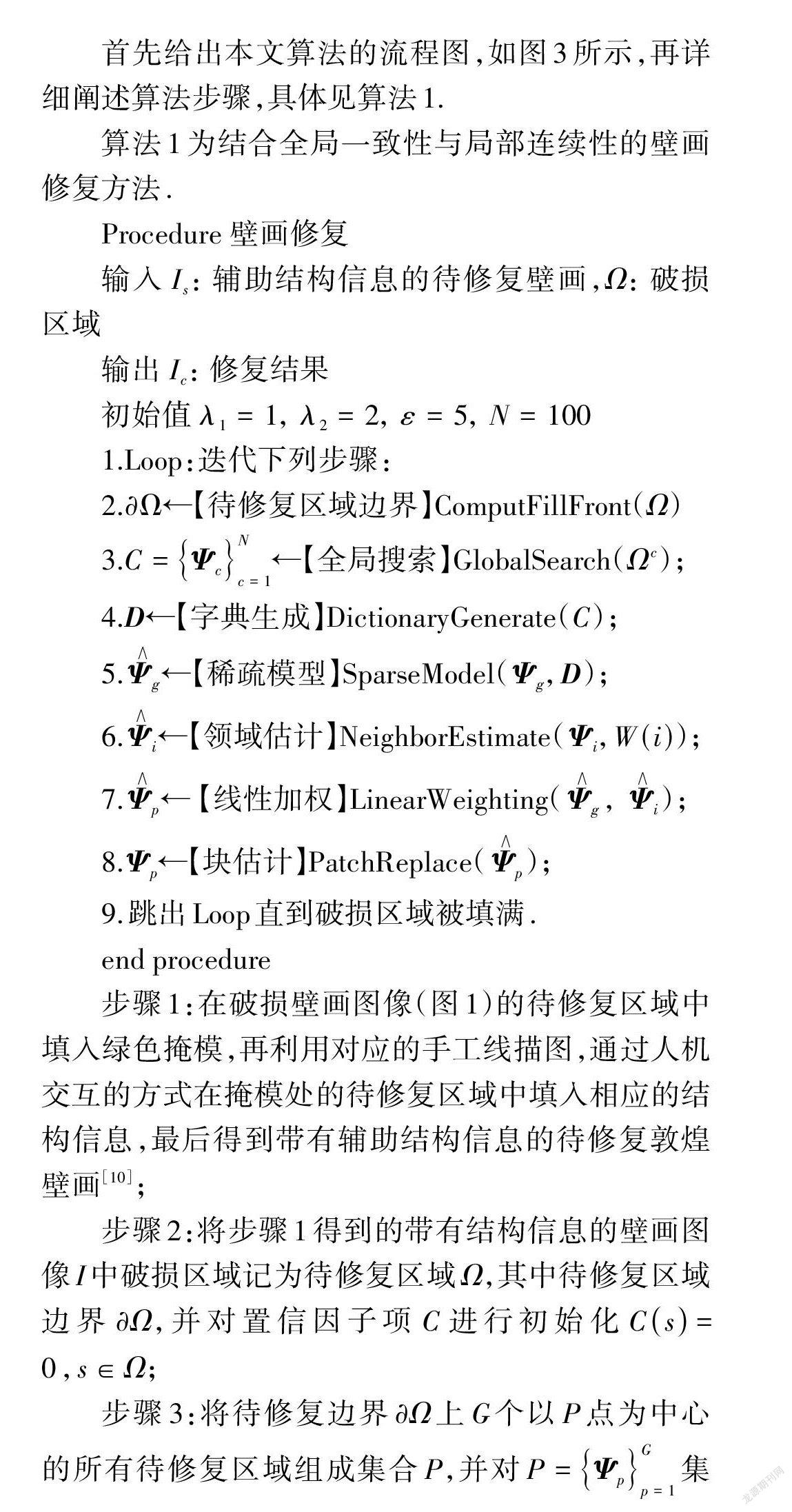

首先给出本文算法的流程图,如图3所示,再详细阐述算法步骤,具体见算法1.

算法1为结合全局一致性与局部连续性的壁画修复方法.

Procedure壁画修复

输入I:辅助结构信息的待修复壁画,Ω:破损区域

输出I:修复结果

初始值λ=1,λ=2,ε=5,N=100

end procedure

步骤1:在破损壁画图像(图1)的待修复区域中填入绿色掩模,再利用对应的手工线描图,通过人机交互的方式在掩模处的待修复区域中填入相应的结构信息,最后得到带有辅助结构信息的待修复敦煌壁画[10];

步骤2:将步骤1得到的带有结构信息的壁画图像I中破损区域记为待修复区域Ω,其中待修复区域边界∂Ω并对置信因子项C进行初始化C(s)=0,s∈Ω;

合分成结构块集合S和纹理块集合T;

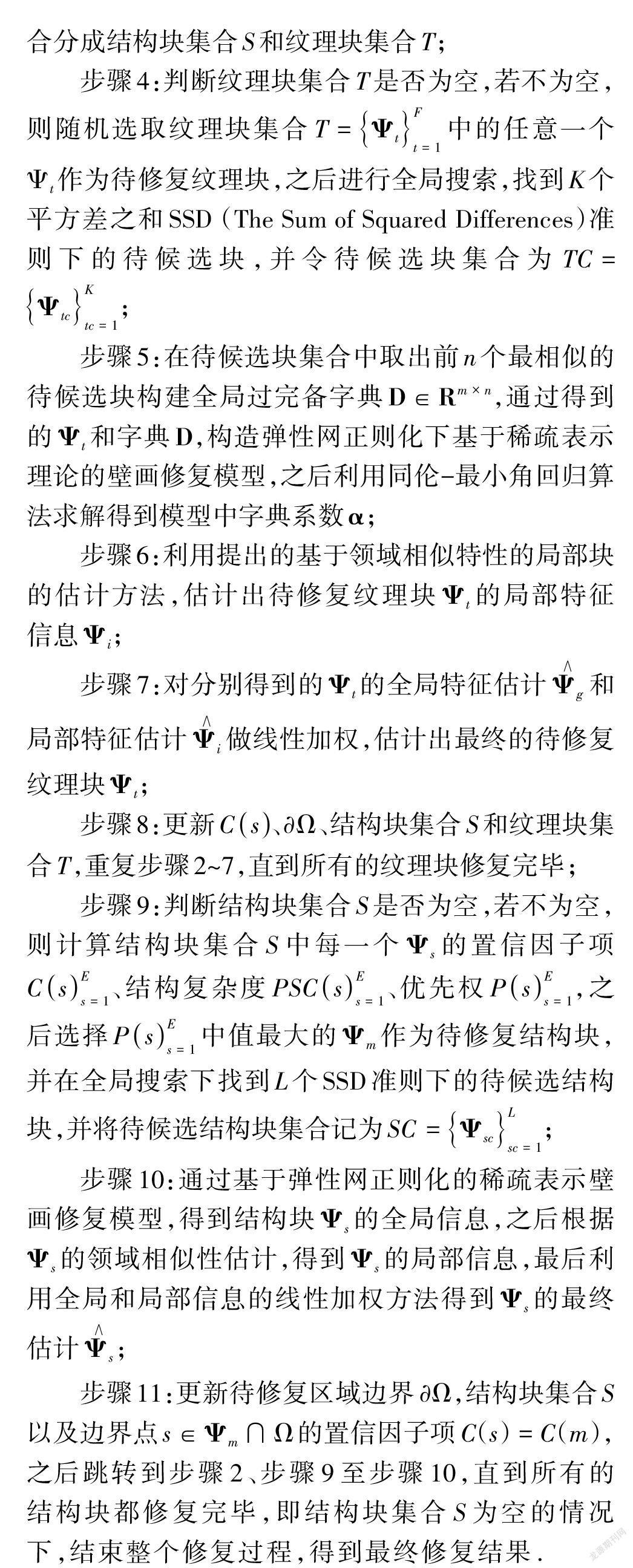

步骤5:在待候选块集合中取出前n个最相似的待候选块构建全局过完备字典D∈R,通过得到的Ψ和字典D,构造弹性网正则化下基于稀疏表示理论的壁画修复模型,之后利用同伦-最小角回归算法求解得到模型中字典系数α;

步骤6:利用提出的基于领域相似特性的局部块的估计方法,估计出待修复纹理块Ψ的局部特征信息Ψ;

步骤8:更新C(s)、∂Q、结构块集合S和纹理块集合T,重复步骤2~7,直到所有的纹理块修复完毕;

步骤11:更新待修复区域边界∂Q,结构块集合S以及边界点s∈Ψ∩Ω的置信因子项C(s)=C(m),之后跳转到步骤2、步骤9至步骤10,直到所有的结构块都修复完毕,即结构块集合S为空的情况下,结束整个修复过程,得到最终修复结果.

1.1全局特征信息

被填充区域需满足全局一致性与局部连续性,其中全局一致性是指被填充区域需和整幅图像中的颜色和纹理特征保持一致,否则会使修复结果变得不自然;而局部连续性则表示已修复区域需和邻域部分在颜色和纹理上满足一定连续性,否则会出现“块效应”.

由此可知,被修复区域的信息需由全局特征和局部特征组成,即待修复块Ψ∈R分别由具有全局特征信息的Ψ∈R和具有局部特征信息的Ψ∈R所组成.

1.1.1稀疏修复模型原理

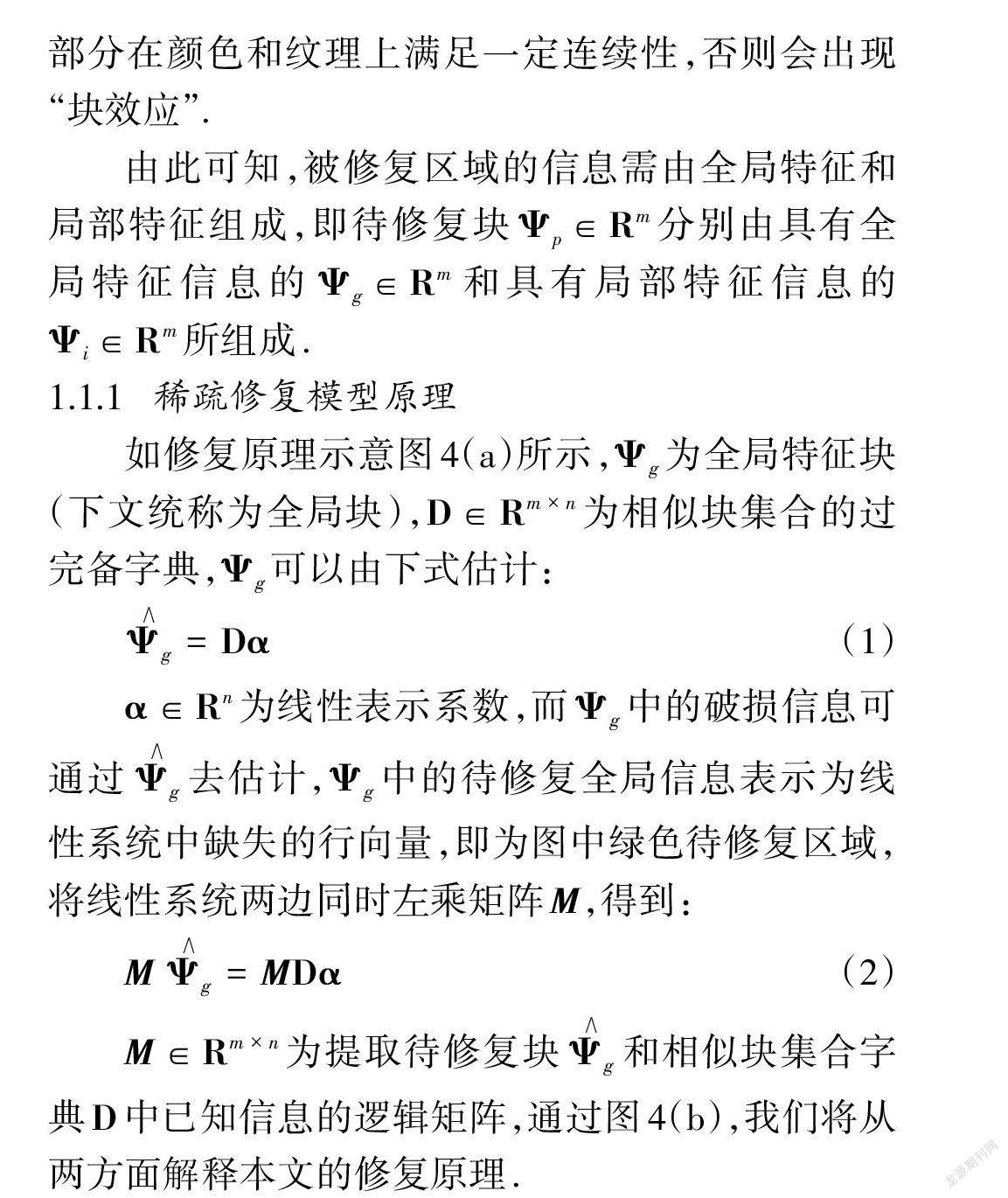

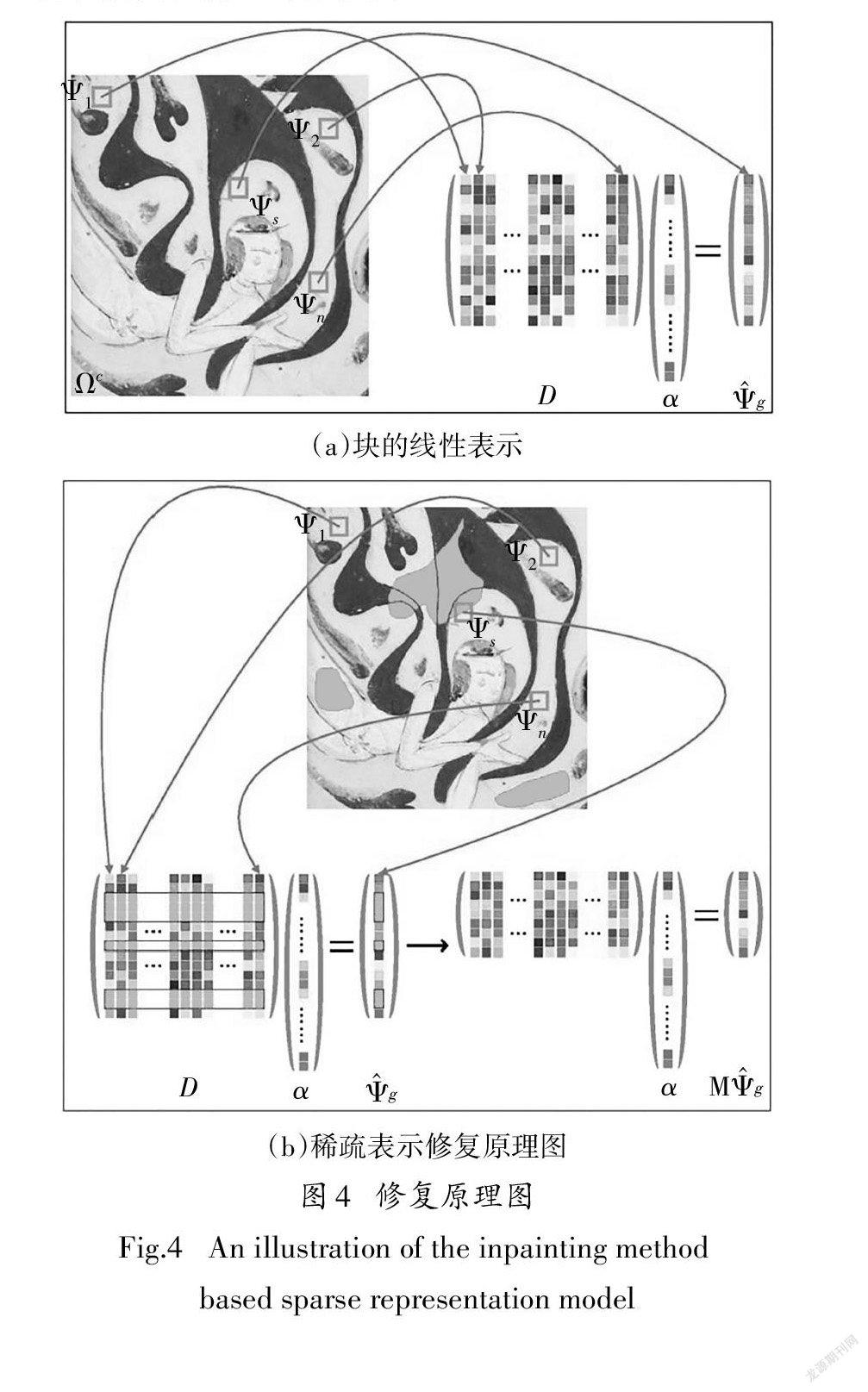

如修复原理示意图4(a)所示,Ψ为全局特征块(下文统称为全局块),D∈R为相似块集合的过完备字典,Ψ可以由下式估计:

1.1.2不同范数约束下的修复模型

通过上式所阐述的原理,我们基于稀疏表示建立一个弹性网正则化[44]下的修复模型:

2)“Ridge修复模型”:令λ=0,λ>0,

这里,λ>0和λ>0分别为模型参数.弹性网正则化的优点在于既有l范数正则化项(Lasso)又有l范数正则化项(Ridge).

根据公式(3)所建立的基于弹性网正则化的稀疏表示修复模型可知,随着λ和λ取值的不同可变为三种不同约束下的稀疏模型.当λ=0时,公式(3)退化成只有l范数正则化项的“Lasso模型”;而当λ=0时,则退化成带有l范数正则化项的Ridge模型;只有当λ、λ≠0时,公式(3)才是弹性网模型. 下面将通过理论分析三种不同修复模型的优缺点.

1)“Lasso修复模型”:令λ>0,λ=0,

M由于l正則化可以较容易地获得稀疏解,因此本文采用了弹性网正则化下的稀疏表示修复模型,实验部分将会重点讨论并分析不同范数约束条件下的修复效果.

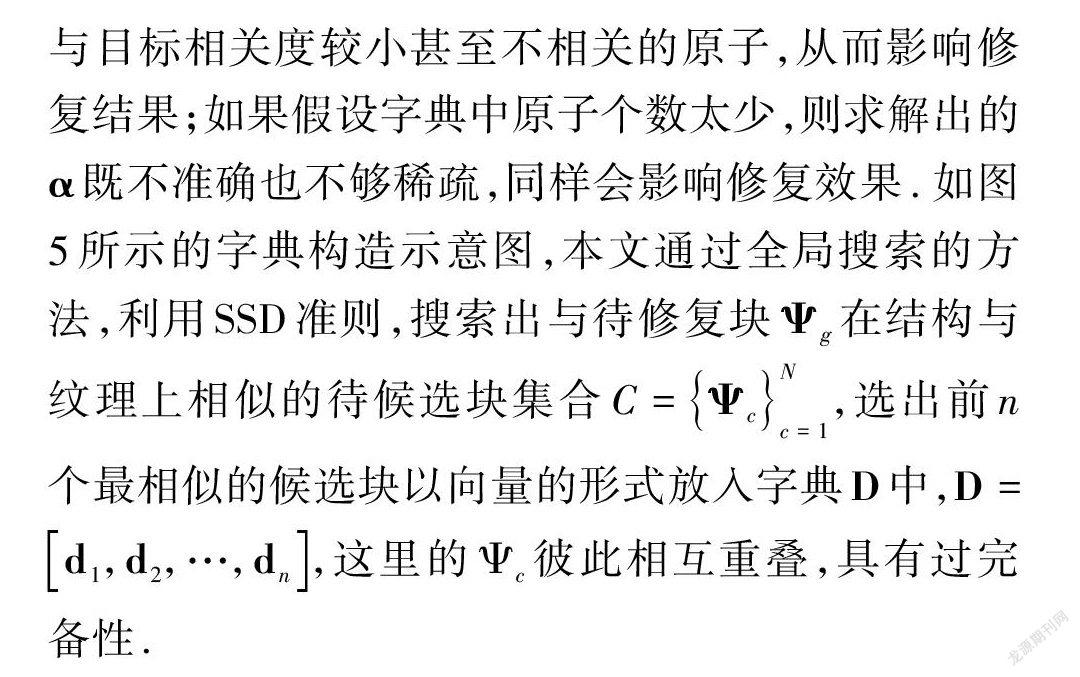

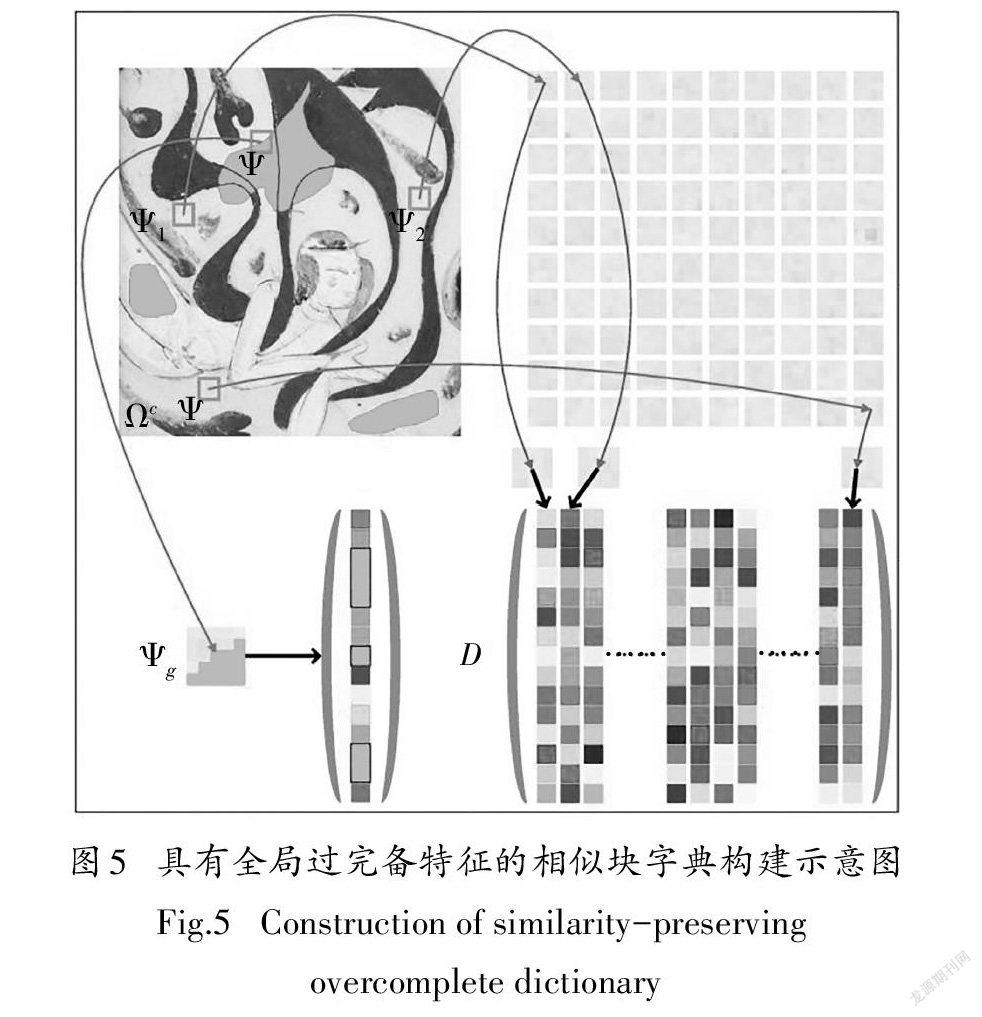

1.1.3全局过完备相似块集合字典

为了获得稀疏解,首先需要构建一个过完备字典.在稀疏表示模型中,如果假设字典中原子个数太多,则不但会降低计算效率,还会在字典中引入一些

1.1.4全局特征块的估计

1.2局部特征信息

设局部特征块为Ψ∈,W(i)为以i点为中心,尺寸大小比Ψ大很多的一个滑动区域窗口,i属于集合Q(i):

这里,d(·,·)为SSD标准下的准则,ε=5,N(i)

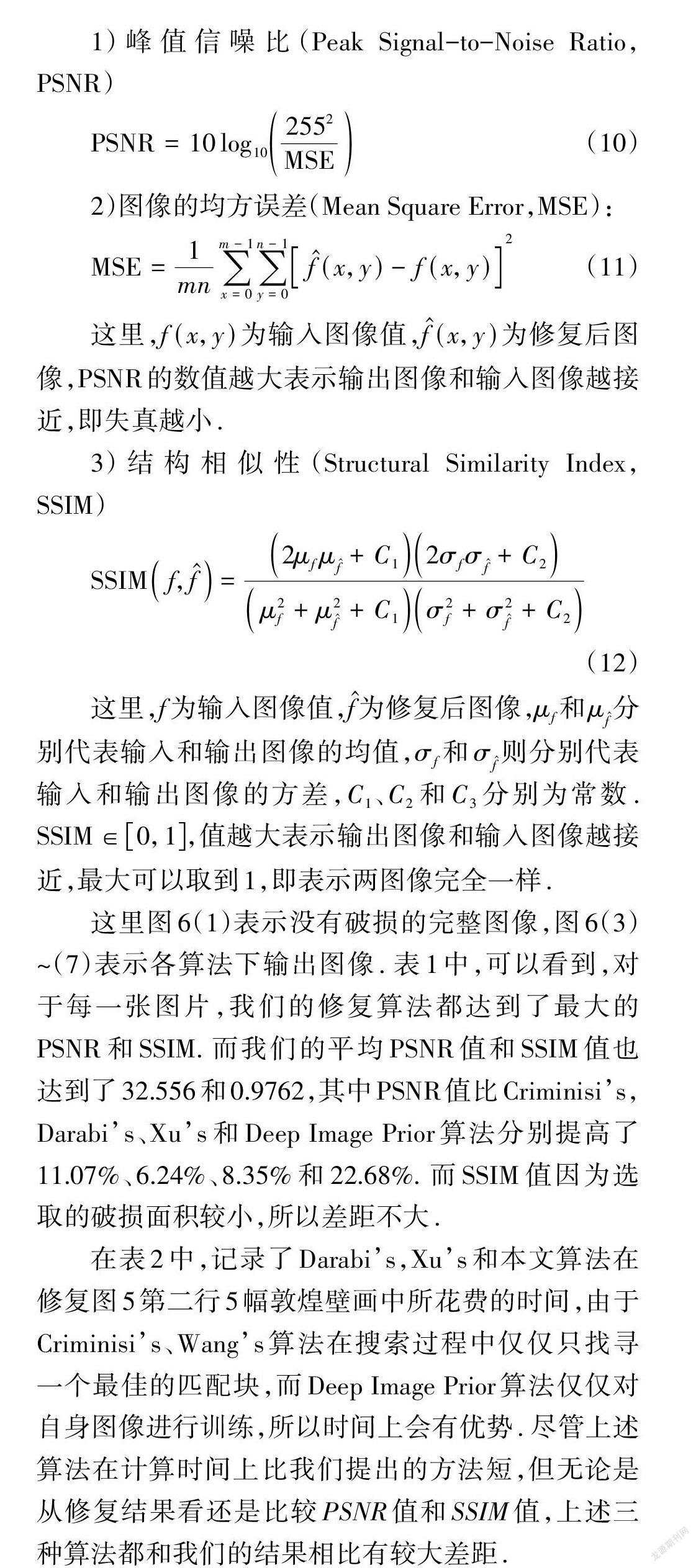

1.3全局特征和局部特征的线性加权

这里,μ∈[0,1],v∈[0,1].需要注意的是,在修复结构块时,要求Ψ在领域的结构处保持连续,所以设μ=0.8,v=0.2;而在修复纹理块时,我们不仅要求待修复块Ψ在区域保持纹理连续,还要求在全局上保持纹理一致性,设μ=v=0.5.

2实验结果与分析

为了验证本文算法的修复效果,我们将和Criminis[11]算法、Darabi[23]算法、Xu[25]算法及Deep Image Prior[33]算法进行比较和分析.本算法中所使用的重要参数,如待修复块大小、字典中原子个数、局部特征信息中的窗口大小及平衡参数λ、λ分别取5×5、100、27×27及1和2.

2.1模拟破损修复结果

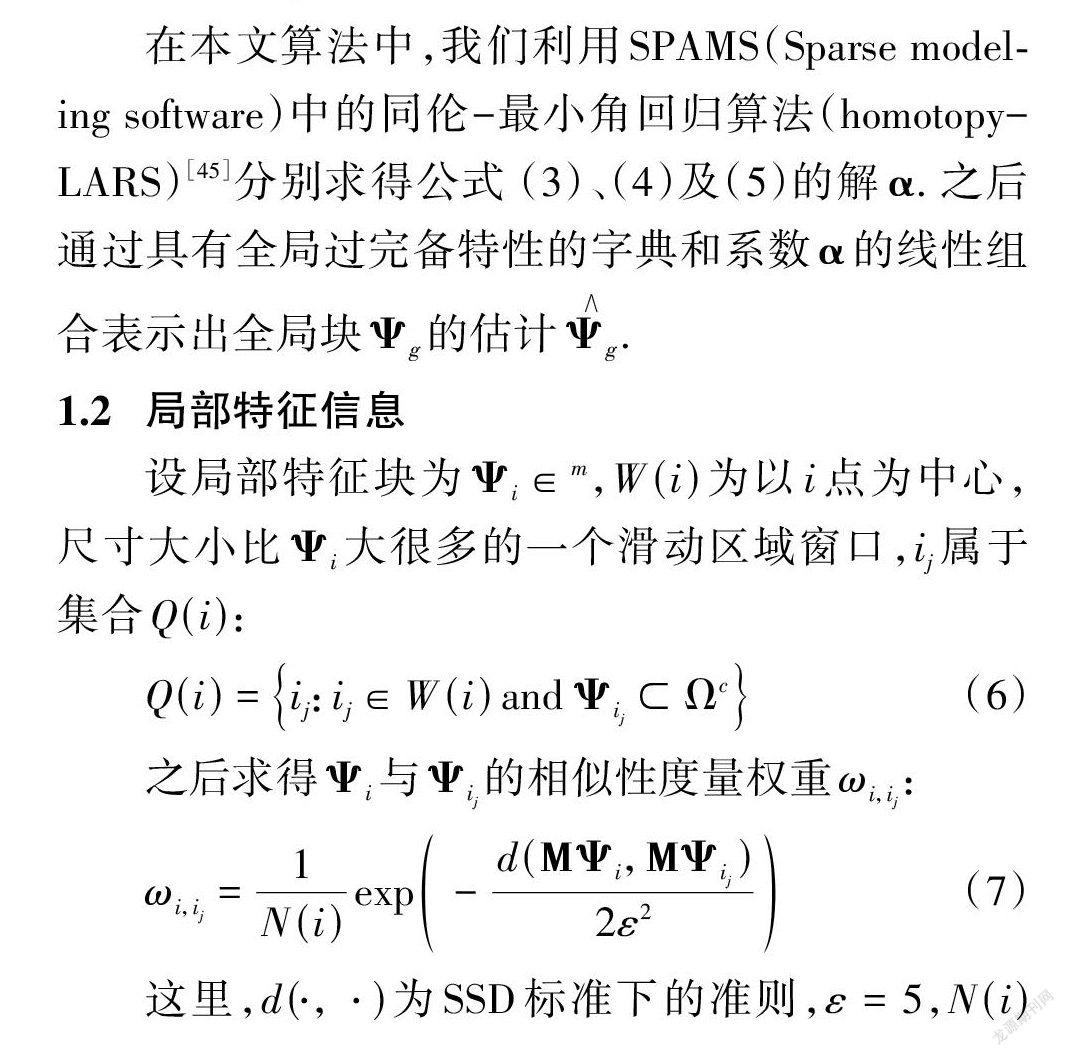

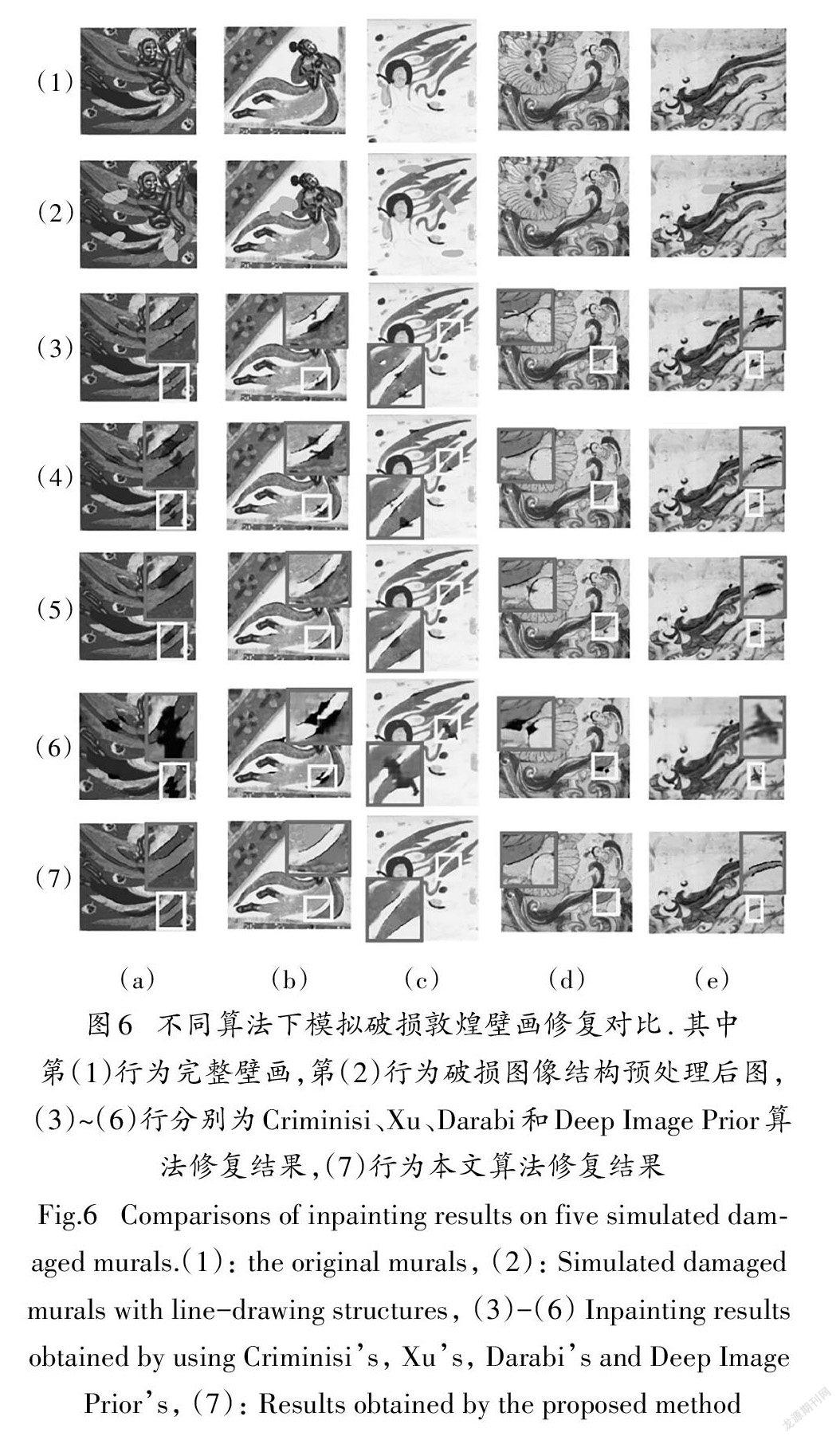

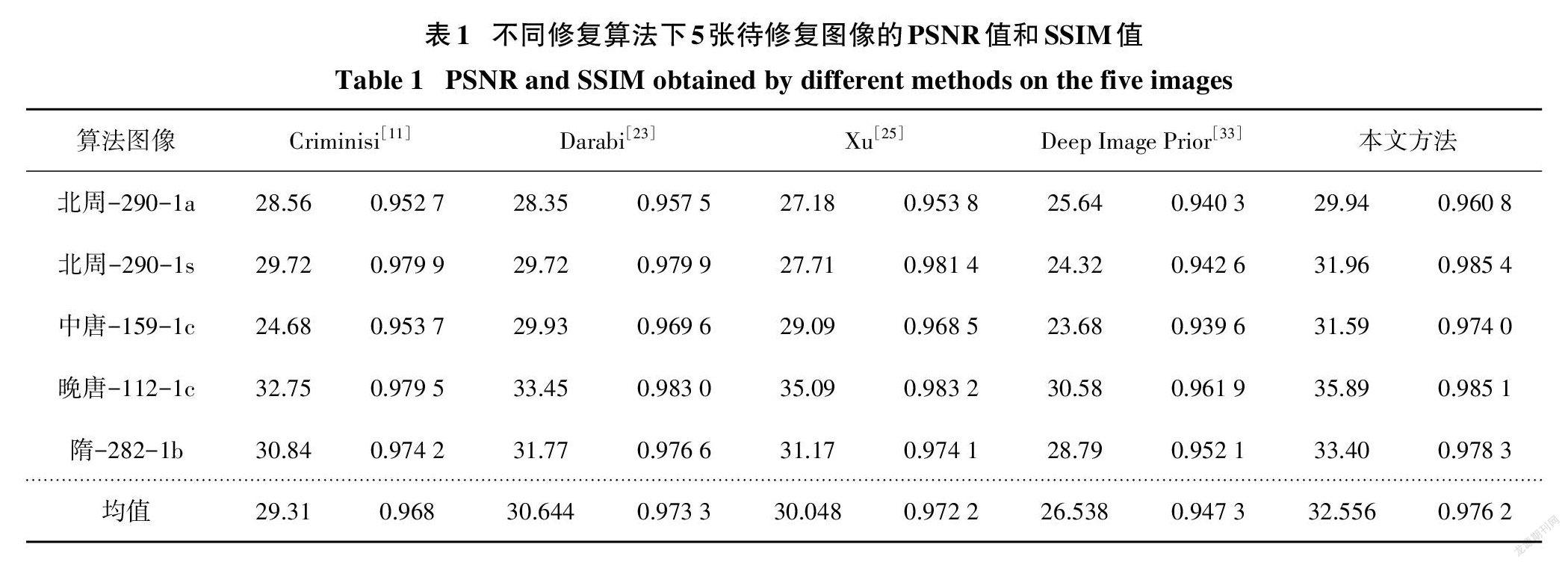

图6为不同算法下模拟破损敦煌壁画修复图的对比结果,其中(a)和(b)的第(1)行中分为五张带有辅助结构信息的待修复壁画,而在(2)~(7)行中,分别为Criminisi、Darabi、Xu、Deep Image Prior和本文算法的修复结果.而表1和表2中给出了上述算法中的PSNR值、SSIM值和对应的计算时间.

从图6中的Criminisi算法修复结果来看,几乎所有结果都出现了结构不连续以及纹理区域的错误填充现象.Darabi算法结果稍好,但几乎所有的修复结果都存在不想要的纹理,这是因为该算法用最邻近搜索方式寻找相似块,缺乏全局一致性.Xu算法从修复结果上看要好于上述两种算法,并没有出现结构不连续性的现象,但纹理不连续性还是会出现在所有结果中.主要是因为Xu算法中所定义的块结构稀疏度(Structure Sparsity)并不能较好的衡量待修复纹理块的置信度,所以在确定修复块的填充顺序时,出现了错误和偏差.而最新的Deep Image Prior算法虽然在测试集上的修复结果较好,但由于该算法的核心思想是利用图像未知区域进行训练,而敦煌壁画本身在颜色和结构上就具有特殊性,所以修复结果并不理想.而本文算法则能很好地解决上述四种算法在修复时所出现的问题,并得到更好的修复结果.

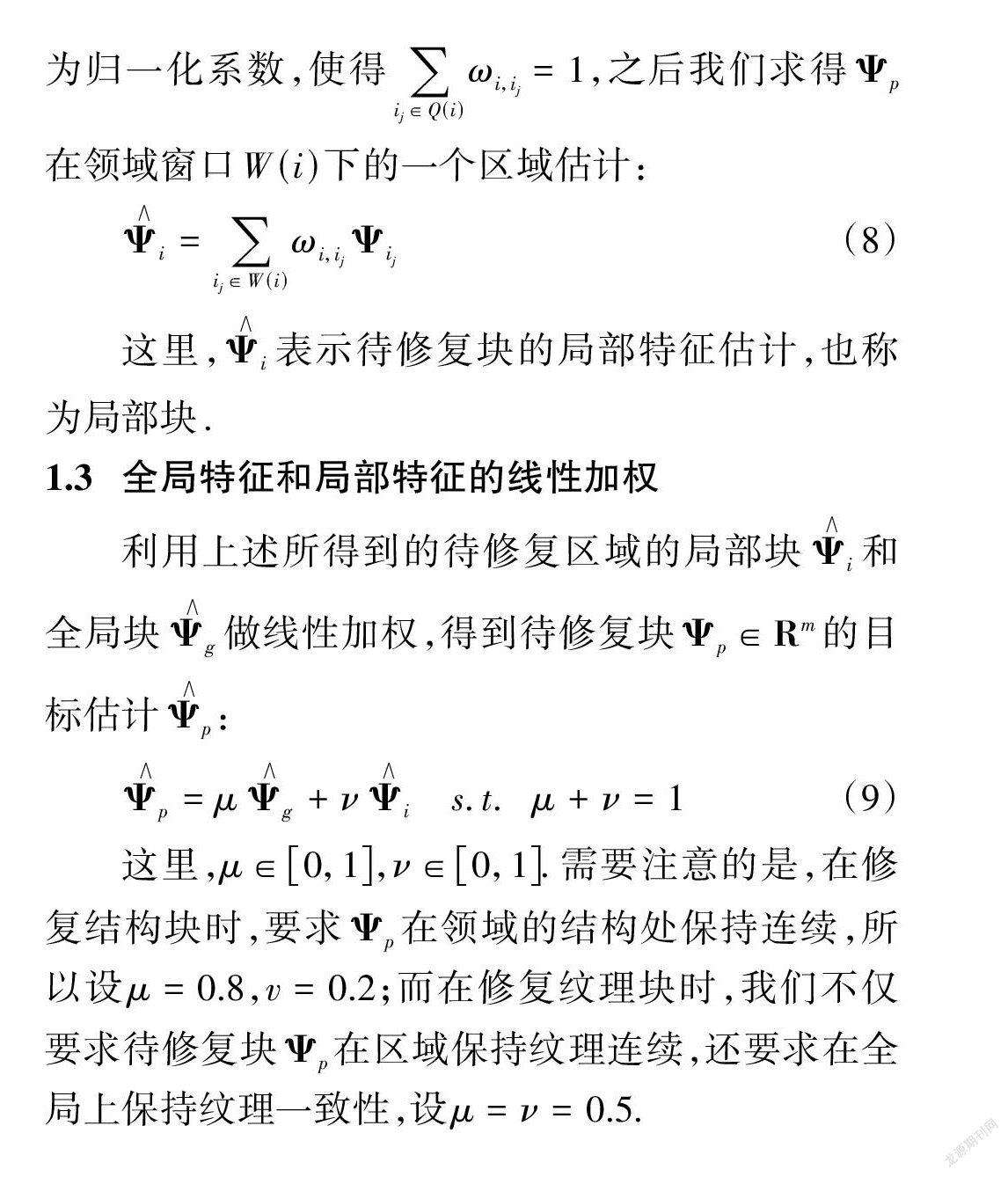

2.2修复评价指标

目前,图像修复的评价标准依然停留在主观评价上,即修复后的图像结构信息是否连续,纹理区域有无错误填充,是否有明显的修复痕迹,如“块效应”等.这里,我们介绍几种图像修复中的主流量化指标.

1)峰值信噪比(Peak Signal-to-Noise Ratio,PSNR)

2)图像的均方误差(Mean Square Error,MSE):

3)结构相似性(Structural Similarity Index,SSIM)

这里图6(1)表示没有破损的完整图像,图6(3)~(7)表示各算法下输出图像.表1中,可以看到,对于每一张图片,我们的修复算法都达到了最大的PSNR和SSIM.而我们的平均PSNR值和SSIM值也达到了32.556和0.9762,其中PSNR值比Criminisi's,Darabi's、Xu’s和Deep Image Prior算法分别提高了11.07%、6.24%、8.35%和22.68%.而SSIM值因为选取的破损面积较小,所以差距不大.

在表2中,记录了Darabi's,Xu's和本文算法在修复图5第二行5幅敦煌壁画中所花费的时间,由于Criminisi's、Wang's算法在搜索过程中仅仅只找寻一个最佳的匹配块,而Deep Image Prior算法仅仅对自身图像进行训练,所以时间上会有优势.尽管上述算法在计算时间上比我们提出的方法短,但无论是从修复结果看还是比较PSNR值和SSIM值,上述三种算法都和我们的结果相比有较大差距.

2.3真实破损修复结果

在本节中,我们将分别对基于线描图指导和基于专家指导的敦煌壁画进行修复,并分析实验结果.这里的基于线描图指导指的是,可通过线描图和专家的双重指导下进行人機交互式配准;而基于专家指导指的是对于那些绝大多数没有相对应线描图的破损壁画来说,只能通过专家的指导做预处理.

图7中Darabi算法的效果还是较为优秀的,只是在处理专家指导下的破损壁画时,仍然无法解决重要结构信息处的纹理信息,导致错误填充.而本文算法的结果可以看出,在修复大面积纹理区域时,几乎没有出现错误填充现象,对于缺失的重要结构信息,也都能准确的复原,整体修复效果从视觉上看明显优于其他算法.

3结论

本文提出了一种基于全局一致性和局部连续性相结合的壁画修复算法,创新研究了稀疏表示修复原理;并认为待修复区域是由全局特征信息和局部特征信息所构成;为了保证待修复区域具有全局一致性,搭建了具有全局过完备特征字典下基于弹性网正则化的稀疏修复模型;并提出了一种基于领域相似特性的局部特征估计方法,使得待修复区域满足局部连续性,最后利用全局块与局部块的线性加权,较好的估计出最终的待修复块,从而实现整个破损壁画的修复.实验结果表明,本方法相较于其他方法所提算法对敦煌壁画破损图像修复具有较好效果.

参考文献

[1] BERTALMIO M,SAPIROG,CASELLES V,et al. Image inpainting [C]//Proceedings of the 27th annual conference on Computer graphics and interactive techniques —SIGGRAPH '00. Not Known. NewYork:ACM Press,2000:417—424.

[2] BALLESTER C,BERTALMIO M,CASELLES V,et al. Filling—in by joint interpolation of vector fields and gray levels [J]. IEEE Transactions on Image Processing,2001,10(8):1200—1211.

[3] CHAN T F,SHEN J H. Nontexture inpainting by curvature—driven diffusions [J]. Journal of Visual Communication and Image Representation,2001,12(4):436—449.

[4] BORNEMANN F,MARZ T. Fast image inpainting based on coherence transport[J].Journal of Mathematical Imaging and Vision,2007,28(3):259—278.

[5] SHEN J H,CHAN T F. Mathematical models for local nontexture inpaintings[J].SIAM Journal on Applied Mathematics,2002,62 (3):1019—1043.

[6] LEVIN A,ZOMET A,WEISS Y. Learning how to inpaint from global image statistics[C]//Proceedings Ninth IEEE International Conference on Computer Vision.October 13—16,2003,Nice,France.IEEE,2003:305—312.

[7] EFROS A A,LEUNG T K. Texture synthesis by non-parametric sampling[C]//Proceedings of the Seventh IEEE International Conference on Computer Vision.September 20—27,1999,Kerkyra,Greece. IEEE,1999:1033—1038.

[8] ZONTAK M,IRANI M. Internal statistics of a single natural image[C]//CVPR 2011.June 20—25,2011,Colorado Springs,CO,USA.IEEE,2011:977—984.

[9] BORNARD R,LECAN E,LABORELLI L,et al. Missing data correction in still images and image sequences[C]//Proceedings of the tenth ACM international conference on Multimedia —MULTIMEDIA '02.December 1—6,2002.Juan—les—Pins,France.New York:ACM Press,2002:355—361.

[10] DRORI I,COHEN—OR D,YESHURUN H.Fragment—based image completion[J].ACM Transactions on Graphics,2003,22 (3):303—312.

[11] CRIMINISI A,PEREZ P,TOYAMA K. Region filling and object removal by exemplar—based image inpainting[J].IEEE Transactions on Image Processing,2004,13(9):1200—1212.

[12] LE MEUR O,GAUTIER J,GUILLEMOT C.Examplar—based inpainting based on local geometry[C]//2011 18th IEEE International Conference on Image Processing.September 11—14,2011,Brussels,Belgium.IEEE,2011:3401—3404.

[13] WANG J,LU K,PAN D,et al. Robust object removal with anexemplar—based image inpainting approach[J]. Neurocomputing,2014,123:150—155.

[14] MARTINEZ—NORIEGA R,ROUMY A,BLANCHARD G. Exemplar—based image inpainting:fast priority and coherent nearest neighbor search[C]//2012 IEEE International Workshop on Machine Learning for Signal Processing.September 23—26,2012,Santander,Spain.IEEE,2012:1—6.

[15] SIADATI S Z,YAGHMAEE F,MAHDAVI P.A new exemplar—based image inpainting algorithm using image structure tensors [C]//2016 24th Iranian Conference on Electrical Engineering (ICEE). May 10—12,2016,Shiraz,Iran. IEEE,2016:995—1001.

[16] STROBEL M,DIEBOLD J,CREMERS D. Flow and color inpainting for video completion[J]. Pattern Recognition,2014,8753:293—304.

[17] NEWSON A,ALMANSA A,FRADET M,et al.Towards fast,ge- neric video inpainting[C]//Proceedings of the 10th European Conference on Visual Media Production —CVMP '13.November 6—7,2013.London,KingdomUnited.New York:ACM Press,2013:

[18] MEYER Y.Oscillating Patterns in Image Processing and Nonlinear Evolution Equations[M].Providence,Rhode Island:Ameri- can Mathematical Society,2001.

[19] BERTALMIO M,VESE L,SAPIRO G,et al.Simultaneous structure and texture image inpainting[J].IEEE Transactions on Image Processing,2003,12(8):882—889.

[20] CHEN X W,ZHOU B,GUO Y,et al. Structure guided texture inpainting through multi—scale patches and global optimization for image completion[J].Science China Information Sciences,2014,57(1):1—16.

[21] WEXLER Y,SHECHTMAN E,IRANI M.Space—time completion of video[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2007,29(3):463—476.

[22] KOMODAKIS N,TZIRITAS G.Image completion using efficient belief propagation vi a priori ty scheduling and dynamic pruning [J].IEEE Transactions on Image Processing:a Publication of the IEEE Signal Processing Society,2007,16(11):2649—2661.

[23] DARABI S,SHECHTMAN E,BARNES C,et al.Image melding [J].ACM Transactions on Graphics,2012,31(4):1—10.

[24] STARCK J L,ELAD M,DONOHO D L.Image decomposition via the combination of sparse representations and a variational ap- proach[J].IEEE Transactions on Image Processing,2005,14 (10):1570—1582.

[25] XU Z B,SUN J.Image inpainting by patch propagation using patch sparsity[J].IEEE Transactions on Image Processing,2010,19(5):1153—1165.

[26] WANG H,LI Q Q,ZOU Q. Inpainting of Dunhuang murals by sparsely modeling the texture similarity and structure continuity [J]. Journal on Computing and Cultural Heritage,2019,12(3):17.

[27] ZHUANG L N,BIOUCAS—DIAS J M.Fast hyperspectral imagedenoising and inpainting based on low-rank and sparse representations [J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing,2018,11(3):730-742.

[28]趙露露,沈玲,洪日昌.图像修复研究进展综述[J].计算机科学,2021,48(3):14-26.

ZHAO L L,SHEN L,HONG R C. Survey on image inpainting research progress[J]. Computer Science,2021,48(3):14-26. (In Chinese)

[29] PATHAK D,KRAHENBUHL P,DONAHUE J,et al. Context encoders:feature learning by inpainting [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. June 27-30,2016,Las Vegas,NV,USA. IEEE,2016:2536-2544.

[30] LIU G L,REDA F A,SHIH K J,et al. Image inpainting for irregular holes using partial convolutions [C]//Computer Vision-ECCV2018,2018:85-100.

[31] SHEN L,HONG R C,ZHANG H R,et al.Single-shot semantic image inpainting with densely connected generative networks [C]//MM '19:Proceedings of the 27th ACM International Conference on Multimedia. 2019:1861-1869.

[32] WANG Y,CHEN Y C,TAO X,et al. VCNet:a robust approach to blind image inpainting [C]//Computer Vision - ECCV 2020,2020:752-768.

[33] LEMPITSKY V,VEDALDI A,ULYANOV D.Deep image prior [C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.June 18-23,2018,Salt Lake City,UT,USA.IEEE,2018:9446-9454.

[34] YANG C,LU X,LIN Z,et al.High-resolution image inpainting using multi-scale neural patch synthesis[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition.July 21-26,2017,Honolulu,HI,USA.IEEE,2017:4076-4084.

[35] YU J H,LIN Z,YANG J M,et al.Generative image inpainting with contextual attention [C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.June 18-23,2018,Salt Lake City,UT,USA.IEEE,2018:5505-5514.

[36] SAGONG M C,SHIN Y G,KIM S W,et al.PEPSI:fast image inpainting with parallel decoding network[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 15-20,2019,Long Beach,CA,USA.IEEE,2019:11352- 11360.

[37] YI Z L,TANG Q,AZIZI S,et al. Contextual residual aggregation for ultra high-resolution image inpainting[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 13-19,2020,Seattle,WA,USA.IEEE,2020:7505-7514.

[38] SONG Y H,YANG C,SHEN Y J,et al.SPG-net:segmentation prediction and guidance network for image inpainting[EB/OL].2018:arXiv:1805.03356 [cs. CV]. https://arxiv.org/abs/1805.03356.

[39] LI J Y,HE F X,ZHANG L F,et al.Progressive reconstruction of visual structure for image inpainting[C]//2019 IEEE/CVF International Conference on Computer Vision(ICCV).October 27 - November 2,2019,Seoul,Korea(South).IEEE,2019:5961-5970.

[40] YANG J,QI Z Q,SHI Y. Learning to incorporate structure knowledge for image inpainting[J].Proceedings of the AAAI Conference on Artificial Intelligence,2020,34(7):12605-12612.

[41] YEH R A,CHEN C,LIM T Y,et al.Semantic image inpainting with deep generative models[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition.July 21-26,2017,Honolulu,HI,USA.IEEE,2017:6882-6890.

[42] ZHENG C X,CHAM T J,CAI J F.Pluralistic image completion [C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).June 15-20,2019,Long Beach,CA,USA. IEEE,2019:1438-1447.

[43] ZHAO L,MO Q H,LIN S H,et al.UCTGAN:diverse image inpainting based on unsupervised cross-space translation[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 13-19,2020,Seattle,WA,USA. IEEE,2020:5740-5749.

[44] ZOU H,HASTIE T. Regularization and variable selection via the elastic net[J].Journal of the Royal Statistical Society:Series B (Statistical Methodology),2005,67(2):301-320.

[45] J MAIRAL,F BACH,J PONCE,et al. SPAMS:Sparse modeling software[EB/OL]. http://spams-devel.gforge.inria.fr/index. html,2011.