基于改进Mask Scoring R-CNN的铲齿磨损检测研究

2022-07-05卢进南王连捷杨润坤丁振志

卢进南,刘 扬,王连捷,杨润坤,丁振志

(辽宁工程技术大学机械工程学院,辽宁 阜新 123000)

电铲又称为绳铲、钢缆铲,是矿山生产中的主要采掘设备。在电铲作业过程中,其铲齿部分直接冲击矿石,易造成磨损,严重影响采掘效率[1]。目前,铲齿的磨损状况主要依靠人工记录铲齿的连续工作情况来确定,尚没有成熟的自动检测系统。因此,有必要对铲齿磨损检测系统展开进一步研究。

近年来,国内外学者一直试图在已有的视频监控系统中利用图像分割算法来实现铲齿磨损状态的智能化检测。例如:宋浒等[2]对图像进行二值化处理,根据目标灰度值和环境灰度值相差较大的特点,采用小波多尺度边缘检测法提取边缘信息,以进行图像分割,从而实现目标的智能化检测。Li等[3]提出了Grab Cut算法,将最小割问题应用于图像分割,可实现图像中目标和背景部分的分割。除此之外,常用的图像分割算法还包括Canny算法[4]、LoG(Laplacian of Gassian,拉普拉斯高斯)算法[5]和Sobel算法[6]等,这些算法均是通过检测目标物体边界处的像素点并将其连接起来以形成边缘轮廓,从而将图像划分成不同的区域。随着深度学习技术的不断发展,计算机视觉领域取得了突破性进展,卷积神经网络(convolutional neural networks,CNN)等成为图像分割的重要方法。例如:Chen等[7]提出的深度卷积神经网络(deep CNN,DCNN)可在不额外增加算力和参数的前提下融合更多的特征,有效地扩大了卷积核的感受视野和控制了响应分辨率。Zou等[8]提出了全卷积网络(fully convolutional networks,FCN)。该方法在编码器中使用池化层来逐渐缩减输入图像的维度,在解码器中利用反卷积网络来复原特征图的尺寸,并在深度不同的特征层之间引入跳级连接结构,以融合不同尺寸的特征,从而实现像素级分类。

综上所述,基于传统图像分割算法的铲齿磨损检测方法主要存在以下几个挑战:1)在检测精度及速度方面达不到要求;2)无法实现全年全天候检测;3)传统图像分割算法在复杂多变的环境下不具备较强的鲁棒性。因此,构建一种检测精度高、检测速度快以及鲁棒性强的铲齿磨损检测方法十分有必要。

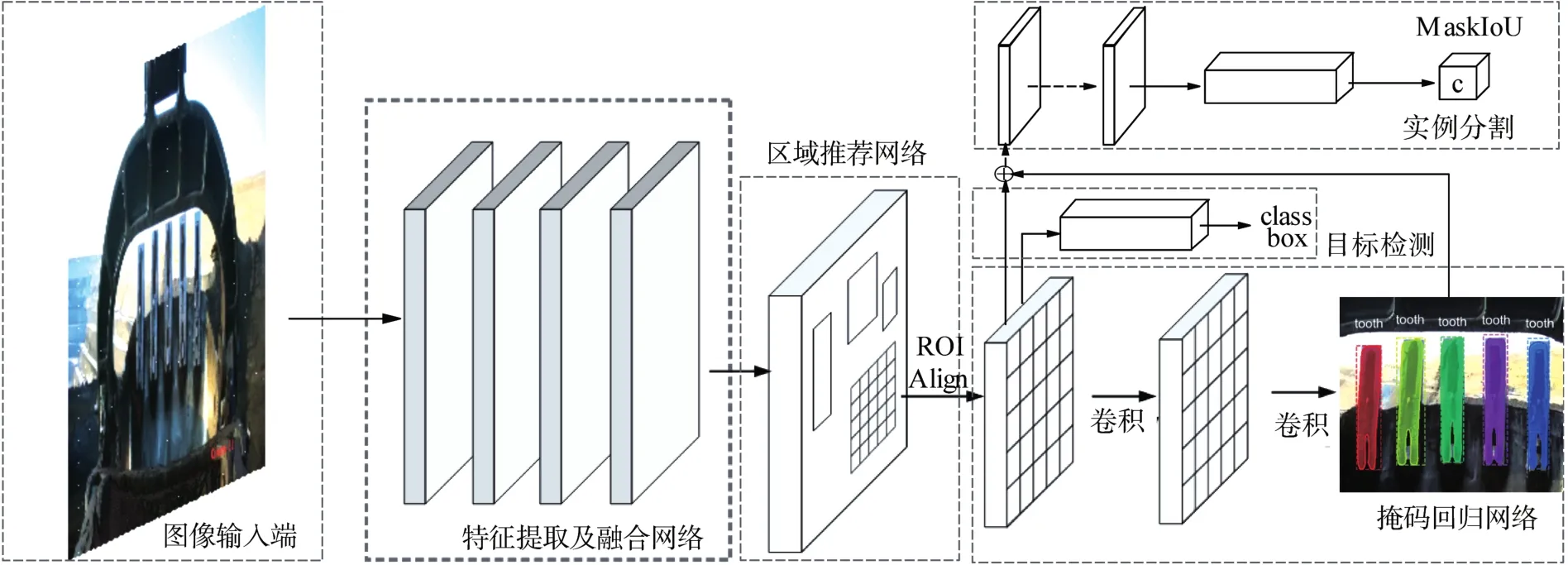

基于此,笔者提出采用基于改进Mask Scoring R-CNN(regional CNN,区域卷积神经网络)的实例分割模型对铲齿图像进行分割,以提升分割精度,从而改善检测效果,实现铲齿磨损情况的准确判断。具体步骤为:将铲齿原始图像输入主干网络后,提取高、低特征层的语义信息和细节特征并融合,获得铲齿特征图;然后利用区域推荐网络提取铲齿特征图中的感兴趣区域,并输入ROIAlign层进行裁剪和归一化处理,完成目标检测和实例分割,以获得每颗铲齿的分割掩码;最后提取铲齿的掩码轮廓,并对轮廓内的像素面积进行计算,通过与预设初始值对比,输出铲齿的磨损情况。

1 基于改进Mask Scoring R-CNN的铲齿实例分割模型构建

1.1 总体框架

在进行铲齿磨损检测时,须对每一颗铲齿进行分割与判断,而语义分割算法仅能实现一类物体的判别。故在铲齿磨损检测中引入基于改进Mask Scoring R-CNN的实例分割模型[9],其主要由特征提取及融合网络、区域推荐网络、目标检测及实例分割网络和掩码回归网络等组成,总体框架如图1所示。

图1 基于改进Mask Scoring R-CNN的铲齿实例分割模型总体框架Fig.1 Overall framework of instance segmentation model of shovel tooth based on improved Mask Scoring R-CNN

1.2 特征提取网络

特征提取网络选择ResNet-101(residual network,残差网络)[10]。ResNet-101的内部使用了残差模块,可有效缓解CNN中梯度消失的问题,且在网络优化方面也具有较好的表现。ResNet-101中的残差模块结构如图2所示。

图2 ResNet-101中残差模块的结构示意Fig.2 Structure diagram of residual module in ResNet-101

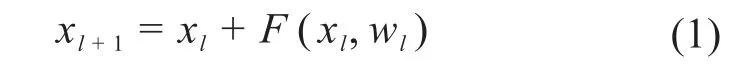

由图2可知,第l层残差模块的输出可表示为:

式中:xl为第l层残差模块的输入;F()为ReLU激活函数;wl为第l层特征的权重。

ResNet-101自下向上逐层对输入的铲齿原始图像进行特征提取,共提取得到4个特征层,对每个特征层进行可视化处理,结果如图3所示。由图3可知,浅层网络提取的是铲齿的纹理、细节等特征,深层网络提取的是铲齿的轮廓、形状等特征。

图3 基于ResNet-101提取的铲齿特征图Fig.3 Shovel tooth feature map extracted based on ResNet-101

1.3 特征融合网络

在对铲齿特征层进行融合的过程中发现,铲齿部分在整个图像中所占的比例较大,导致顶层特征信息对铲齿检测有重要作用。而特征融合中常用的传统 FPN(feature pyramid networks,特征金字塔网络)[11]中顶层特征信息未与其他层融合,虽语义信息较强,但细节损失较多,导致检测效果差。针对这一问题,对传统FPN进行改进,改进后的FPN结构如图4所示。

图4 改进后的FPN结构Fig.4 Structure of improved FPN

首先,以铲齿新增特征层的底层N2为特征金字塔中的P2层,不进行多余操作。然后,针对N3、N4、N5层,分别对上层特征进行步长为2的上采样,并与横向连接的P层进行叠加,每次卷积后都采用ReLU激活函数来减少过拟合。最后,去除叠加后特征图中的多余重复特征,获得新的N层。改进后的FPN为底层特征传输提供了新的传递方式,减少了主干网络对细节特征的丢失,缩短了顶层特征与底层特征之间的信息传递距离,从而改善了对铲齿检测的准确性。

1.4 目标检测及实例分割网络

含有位置候选框的铲齿图像经ROI Align层[12]裁剪和归一化处理后,输入具有3个分支的目标检测及实例分割网络,分别进行铲齿分类、预测框回归和掩码分割。本文采用R-CNN对铲齿进行分类与预测框回归,用实例分割网络进行掩码分割。实例分割网络通过将归一化处理后的区域推荐特征图输入FCN来进行像素分类[13],以提取目标特征的语义信息,其结构如图5所示。

图5 铲齿实例分割网络结构Fig.5 Instance segmentation network structure for shovel tooth

首先,对特征融合后的铲齿特征图进行5次卷积和最大池化操作,将其分别缩放至原来的1/2,1/4,1/8,1/16和1/32,在降低分辨率的同时将特征变得集中和抽象,并保留池化3和池化4操作后对应层的特征图,再经过第6,7次卷积获得高维特征图;然后,将高维特征图进行32倍上采样以得到FCN-32s,并将经2倍上采样的高维特征图与池化4操作后的特征图融合后再进行16倍上采样以得到FCN-16s,同时将FCN-16s在进行16倍上采样前融合的特征图进行2倍上采样后与池化3操作后的特征图结合,并再次进行8倍上采样获得FCN-8s。重复上采样的分割效果远优于仅一步上采样的结果,可使浅层铲齿分割结果的细节更饱满,深层铲齿分割结果的鲁棒性更强。将上述3个层级的特征层进行堆叠,可大幅度提高对铲齿的分割精度。

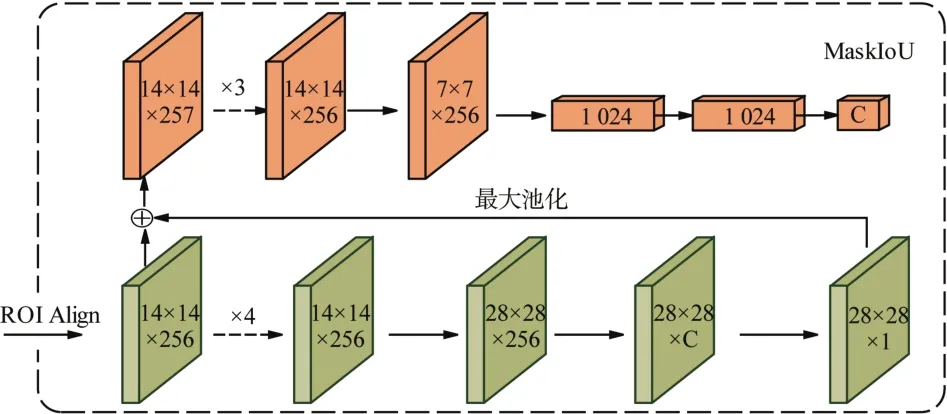

1.5 掩码回归网络

在进行实例分割时,多数分割网络采用目标分类置信度作为分割质量得分,而分割后的掩码与真实标注掩码的关系并未在得分中体现,导致评分结果与真实分割结果的相关性较差,不利于提升对目标的分割质量。针对这一问题,引入分割掩码评分机制[14]。掩码回归网络的结构如图6所示,将目标掩码进行最大池化后与ROI Align层的特征图合并,并输入掩码回归网络,经过4个卷积层和3个全连接层后,末尾全连接层输出每一类目标的掩码交并比(mask intersection over union,MaskIoU)。

图6 掩码回归网络结构Fig.6 Mask regression network structure

在铲齿的实例分割过程中,将目标检测及实例分割网络中得分最高的前n个框输入掩码回归网络,以获得铲齿掩码。将铲齿掩码和分割前的特征图结合,利用掩码回归网络计算得到掩码像素级交并比,再与铲齿分类置信度相乘得到最终的掩码分割得分,其计算式如下:

式中:Lmask为铲齿的掩码分割得分;Ncls为铲齿分类置信度;Imaskiou为掩码像素级交并比。

2 铲齿实例分割模型训练与测试

2.1 铲齿数据集建立

2.1.1 图像采集

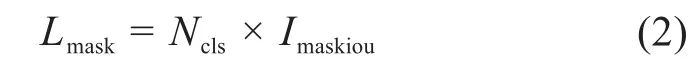

利用工业相机采集铲齿图像,其进光量比普通监控摄像头多,在露天微光环境下也可采集清晰的图像。此外,还配备了角度可调节的摄像头支架和混合补光灯,便于调整拍摄角度和夜间补光,保证在恶劣工况环境下也能获得最优的铲齿图像。本次训练共采集铲齿关键帧图像1 200张,其中夜间500张,白天700张,覆盖缺齿、遮挡等工况;铲齿图像大小为(1 280×960)像素,使用传统数据增强方法对铲齿原始图像进行旋转、镜像、亮度变换(变暗、变亮)和色彩抖动[15-17]等操作(效果如图7所示),将数据集扩充至2 000张。

图7 铲齿图像增强效果Fig.7 Enhanced rendering of shovel tooth image

2.1.2 图像标注

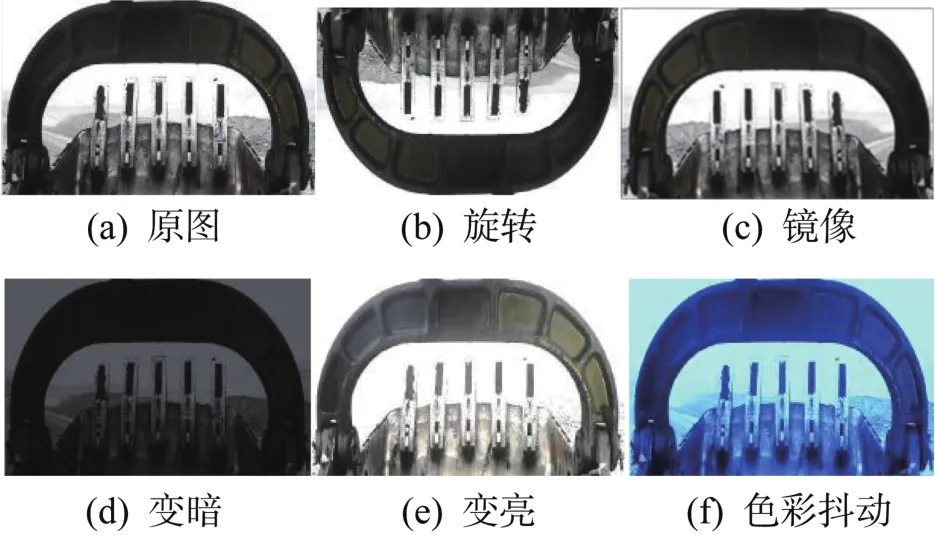

使用图像标注工具labelme对采集到的铲齿图像进行手动标注,沿铲齿边缘绘制轮廓线并定义标签,共获得5 030个铲齿样本。标注完成后,将铲齿边缘轮廓坐标和标签等图像信息保存为json文件,再通过py脚本将标签格式文件转化为实例分割模型训练所需的标注图像和掩码图像,如图8所示。

图8 铲齿图像实例分割标注结果Fig.8 Instance segmentation and annotation results of shovel tooth image

2.2 铲齿实例分割模型训练

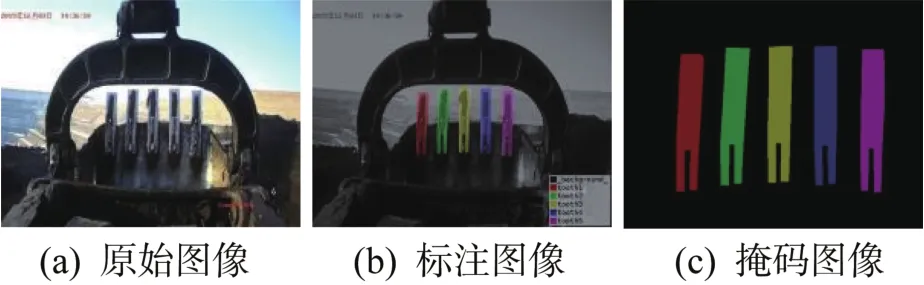

在Windows10系统中,选择Tensorflow和Keras组合的深度学习框架,构建基于改进Mask Scoring R-CNN的铲齿实例分割模型。设定初始学习率为1×10-3,动量因子为0.9,权重衰减率为0.001,迭代次数为35 000次,分别在迭代25 000次和28 000次时将学习率改为1×10-4和1×10-5。为验证ResNet-100的优越性,分别对基于ResNet-50和ResNet-101的铲齿实例分割模型进行训练,其损失值变化曲线如图9所示。

图9 基于不同ResNet的铲齿实例分割模型的损失值变化曲线Fig.9 Change curve of loss value of shovel tooth instance segmentation model based on different ResNet

由图9可知,当特征提取网络为ResNet-50时,迭代前期铲齿实例分割模型的损失值较大,下降速度较快;在迭代数为5 000~15 000次时损失值下降的速度变慢;当迭代数为15 000次后损失值的变化趋势较平缓并逐步收敛,在迭代数为32 000次时损失值稳定在0.1左右,此时终止训练。当特征提取网络为ResNet-101时,损失值的下降速率比采用ResNet-50时平缓,在迭代数为5 000~15 000次时损失值逐步收敛,之后下降幅度较缓和,最终在迭代数为28 000次时收敛于0.1左右。由此表明,ResNet-101比ResNet-50拥有更深层的网络结构,其特征提取效果更好。

2.3 铲齿分割评估指标

选定一些评估指标对不同条件下的铲齿分割结果进行定量分析,以直观反映所构建实例分割模型的检测效果。实例分割模型常用的评估指标包含像素精度(pixel accuracy,PA)、平均像素精度(mean pixel accuracy,mPA)和平均交并比(mean intersection over union,mIoU)等。

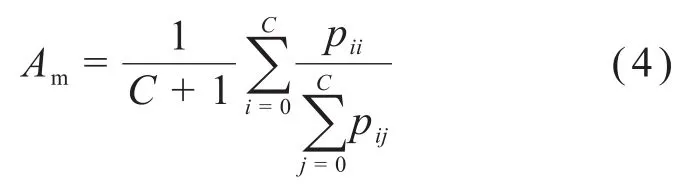

像素精度和平均像素精度是实例分割中最基本的评估指标。其中,像素精度A表示分割后标记正确的像素与总像素之比,其计算式为:

式中:C为铲齿分割类别;pii为i类被正确分割标记为i类的铲齿像素;pij为i类被错误分割标记为j类的铲齿像素。

平均像素精度Am在像素精度的基础上进一步提升,即先计算每一类中正确分割像素的比例,再对所有类(包括背景)求像素精度均值,其计算式为:

平均交并比Im通过先计算被正确分割的每一类铲齿的像素与此类铲齿真实像素和预测像素并集之比,再求所有类均值后得到,其计算式为:

式中:pji为j类被错误分割标记为i类的铲齿像素。

2.4 测试结果分析

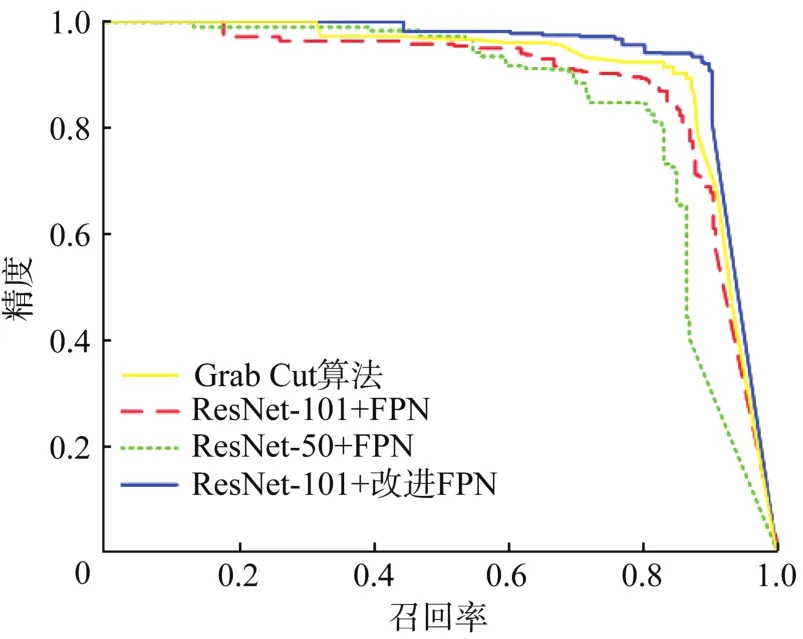

铲齿实例分割模型训练完成后,分别将铲齿关键帧图像输入到基于不同主干网络的各实例分割模型中进行精度测试,以分析不同模型的分割效果,其精度—召回率曲线如图10所示。

图10 基于不同主干网络的铲齿实例分割模型的精度—召回率曲线Fig.10 Precision-recall curve of shovel tooth instance segmentation model based on different backbone networks

由图10可知,以ResNet-101和改进FPN为主干网络的实例分割模型的精度最高,说明其检测和分割铲齿的性能优于以其他算法为主干网络的模型。提取不同实例分割模型的平均像素精度Am、平均交并比Im和单帧检测时间t,结果如表1所示。由表1可直观看出:以ResNet-101和改进FPN为主干网络时实例分割模型的平均像素精度可达到90.76% ,平均交并比为83.62% ,比以ResNet-101和传统FPN为主干网络的模型分别提高了1.18% 和1.21% ;同时,在检测精度和速度方面均优于以Grab Cut算法为主干网络的模型。综上,以ResNet-101和改进FPN为主干网络的Mask Scoring R-CNN对铲齿磨损检测的效果最好。

表1 基于不同主干网络的铲齿实例分割模型的性能对比Table1 Performance comparison of shovel tooth instance segmentation models based on different backbone networks

采用基于改进Mask Scoring R-CNN的实例分割模型对铲齿关键帧图像进行分割,效果如图11所示。默认分割结果显示铲齿目标边框、类别标签及掩码信息。其中,图11(a)所示为目标掩码标签,图11(b)所示为实例分割模型的分割效果。

图11 基于改进Mask Scoring R-CNN的铲齿实例分割效果Fig.11 Instance segmentation effect of shovel tooth based on improved Mask Scoring R-CNN

从图11所示的铲齿分割效果可直观看出,基于改进Mask Scoring R-CNN的铲齿实例分割模型具有良好的检测和分割效果,基本满足铲齿磨损检测的需求,并对环境具有较强的鲁棒性。

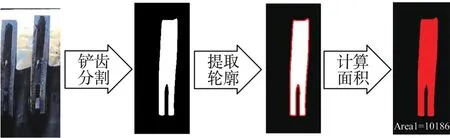

2.5 铲齿磨损程度计算

利用所构建的实例分割模型对铲齿关键帧图像进行目标检测和实例分割后,提取每颗铲齿在图像中的相对位置和二值化掩码图形信息。利用铲齿分割掩码对铲齿像素面积进行定量计算,并与其原始像素面积进行对比,从而输出铲齿的真实磨损情况。铲齿像素面积计算过程如图12所示。

图12 铲齿像素面积计算过程Fig.12 Calculation process of shovel tooth pixel area

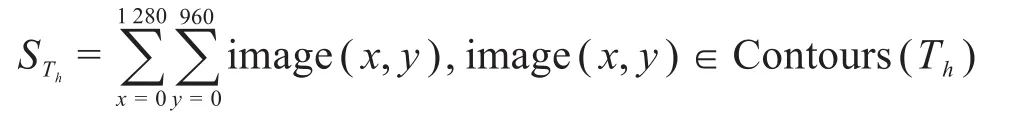

首先,依次输入单颗铲齿的二值化掩码图像,通过OpenCV软件中的轮廓跟踪算法Suzuki85[18]对铲齿二值化掩码图像进行拓扑分析,确定铲齿的外边界和层次关系,提取图像的轮廓信息并绘制轮廓线后,遍历铲齿掩码像素。当像素点image(x,y)属于铲齿时,对像素点进行叠加,则可得铲齿轮廓内的像素面积为:

将计算得到的铲齿像素面积与未磨损铲齿的像素面积进行对比,得到铲齿的磨损情况。用Wh表示铲齿的磨损程度,当Wh>40% 时,表明铲齿磨损严重。Wh的计算式如下:

3 铲齿磨损状态实验分析

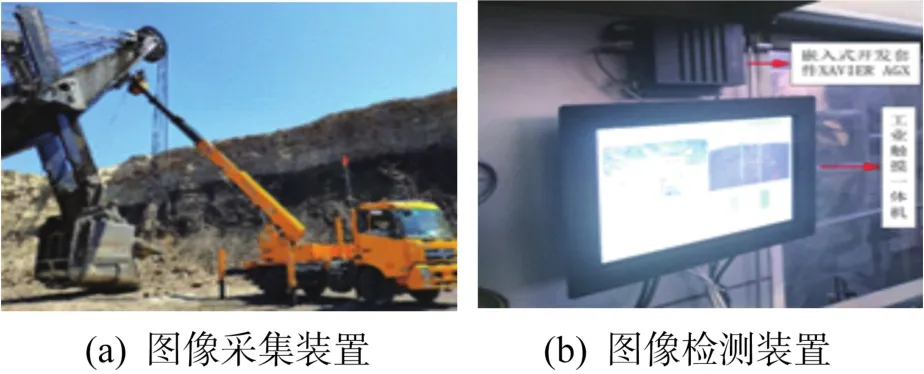

3.1 设备安装

为了验证所构建模型对铲齿磨损检测的可行性,在内蒙古某大型露天矿上进行现场实验。经过对现场考察,综合权衡生产安全性、硬件可靠性、系统稳定性和布局合理性等,搭建铲齿磨损状态检测系统硬件平台,其安装情况如图13所示。其中,摄像机安装在电铲大臂上,负责采集铲齿图像;图像检测装置安装在驾驶舱内,负责检测铲齿的磨损状态。

图13 铲齿磨损状态检测系统硬件平台Fig.13 Hardware platform of shovel tooth wear state detection system

3.2 磨损检测实验

在磨损检测实验中,将电铲的3号铲齿更换为未磨损的新铲齿,其实际长度为914 mm,初始面积为126 804.622 4mm2,初始像素面积为11 796像素。在1 h内共进行8次磨损检测实验,分别对5颗铲齿的磨损程度进行检测和评估。其中,第1次磨损检测实验中提取的各铲齿的轮廓如图14所示。基于图14,计算各铲齿的像素面积并得到其磨损程度,结果如表2所示。

图14 第1次磨损检测实验中提取的各铲齿轮廓Fig.14 Profile of each shovel tooth extracted in the first wear detection experiment

表2 第1次铲齿磨损检测实验的结果Table 2 Results of first shovel tooth wear detection experiment

由表2实验结果可知,由于5颗铲齿的工作状态和工作时长不同,检测得到的各铲齿磨损程度也不同。其中3号铲齿为新更换的铲齿,其磨损程度最轻,仅为0.99% ;1号铲齿的磨损程度最严重,为13.64% ;5颗铲齿的磨损程度均低于报警值(40% ),说明电铲可正常工作。

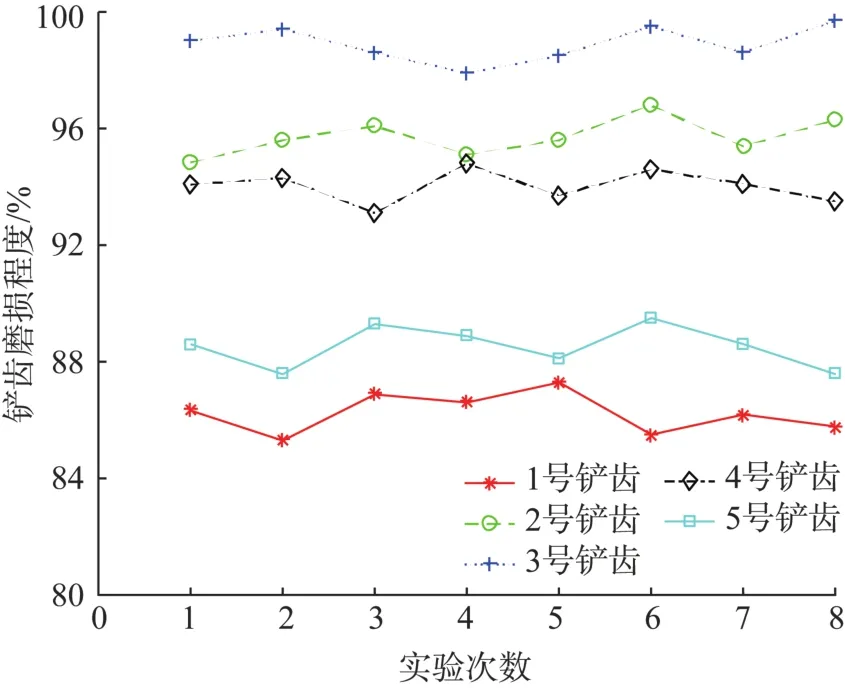

8次铲齿磨损检测实验的结果如图15所示。由图15可知,检测到的每颗铲齿的磨损程度均在一定范围内波动,其中4号铲齿的波动幅度最小,为1.70% ;1号铲齿的波动幅度最大,为1.97% ;所有铲齿磨损程度的波动幅度均小于2% ,均方差均在0.7左右,说明所搭建检测系统的误差较小,满足磨损检测的稳定性要求。

图15 铲齿磨损检测实验结果Fig.15 Experiment results of shovel tooth wear detection

4 结论

本文将实例分割应用于铲齿的磨损检测,结合ResNet-101和改进FPN,构建了基于改进Mask Scoring R-CNN的铲齿实例分割模型,充分利用了铲齿的细节特征,提升了检测效果。测试结果表明:以ResNet-101和改进FPN为主干网络时实例分割模型对铲齿的分割效果最佳,平均像素精度为90.76% ,平均交并比为83.62% ,相比于仅以ResNet-101和传统FPN为主干网络的模型分别提升了1.18% 和1.21% ,有利于铲齿轮廓提取以及面积计算。现场磨损检测实验表明:检测到的每颗铲齿的磨损程度波动幅度均小于2% ,均方差在0.7左右,满足磨损检测的稳定性要求。研究结果为铲齿磨损状态的智能化检测提供了新思路,具有工程指导价值。