人工智能伦理及其课程教学

2022-05-30古天龙

摘 要:人工智能技术的颠覆性、复杂性以及社会关联性,特别是强人工智能的可能性,引发了诸多方面的伦理挑战和风险。人工智能伦理对于人工智能技术进步、人工智能科技向善有着重要的调和作用。对人工智能的研发和从业人员来说,了解人工智能中的伦理风险、遵守人工智能的职业道德规范、培养人工智能的伦理思维和意识,无论对人工智能技术进步、人类社会发展,还是个人职场发展,都有着重要的意义。本文对人工智能伦理的历史渊源进行了梳理,对人工智能伦理的主要问题及治理进行了简要介绍,并结合教学实践对“人工智能伦理”课程教学进行了讨论。

关键词:人工智能伦理;风险;职业道德规范;课程建设;人才培养;素质教育

人工智能(Artificial Intelligence,AI)作为引领未来的战略性技术,日益成为驱动经济社会各领域从数字化、网络化向智能化加速跃升的重要引擎。2017年7月,我国《新一代人工智能发展规划》提出了面向2030年我国新一代人工智能发展的指导思想、战略目标、重点任务等。人工智能在带来巨大机遇的同时,也蕴含着风险和挑战。2018年10月中共中央政治局就人工智能发展现状和趋势举行第九次集体学习,习近平总书记指出,要加强人工智能发展的潜在风险研判和防范,维护人民利益和国家安全,确保人工智能安全、可靠、可控。2019年6月,国家新一代人工智能治理专业委员会发布《新一代人工智能治理原则——发展负责任的人工智能》,提出AI治理的框架和行动指南,强调了公平公正、尊重隐私、安全可控、同担责任、开放协作、敏捷治理等八条原则。2021年9月,国家新一代人工智能治理专业委员会发布《新一代人工智能伦理规范》,明确提出“将伦理道德融入人工智能全生命周期,促进公平、公正、和谐、安全,避免偏见、歧视、隐私和信息泄露等问题”。

在国外,2017年12月国际电气电子工程师协会发布《符合伦理设计:人工智能和自主系统促进人类福祉的远景》。2019年4月欧盟委员会下属的欧洲人工智能高级别专家组撰写并发布了人工智能道德准则《可信赖AI的伦理指导原则》。2019年6月美国发布的《国家人工智能研究和发展战略规划》中七项战略之一是“理解人工智能的伦理、法律和社会影响,开发用于设计与伦理、法律和社会目标一致的人工智能研发方法;建立伦理人工智能,设计符合伦理道德的人工智能体系”。2021年11月,联合国教科文组织(UNESCO)通过了首个全球性的AI伦理协议《人工智能伦理建议书》。

人工智能技术及其产业的可持续健康发展离不开人工智能伦理治理。人工智能伦理治理需要积极开展人工智能伦理教育。高等院校在开展人工智能教学时[1-3],要及时开展人工智能伦理课程教学,培养大学生的伦理道德素养,无论对人工智能技术进步、人类社会发展,还是大学生个人职场发展,都有着重要的意义。

一、人工智能伦理渊源

人工智能伦理学(Ethics of Artificial Intelli-gence)是针对人工智能系統的应用伦理学的一个分支。人工智能伦理是人类设计、制造、使用和对待人工智能系统的道德、机器伦理中的机器行为以及超级人工智能的奇点问题[4]。

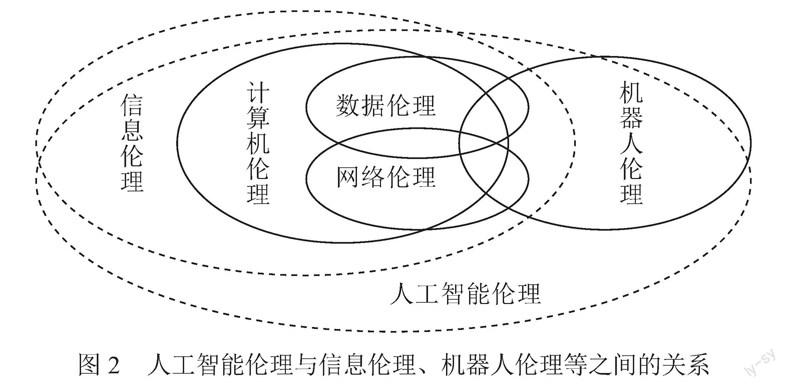

首先,机器人通常被认为是人工智能系统的载体,机器人是人工智能的承载者。但是,不是所有的机器人都通过人工智能系统发挥作用,也不是所有的人工智能系统都是机器人。因此,人工智能伦理与机器人伦理相互交叉。其次,机器学习是人工智能的核心技术,机器学习被誉为“算法+算力+数据”。由此,人工智能伦理与数据伦理、网络伦理、计算机伦理、信息伦理具有密切的联系[4]。

计算机伦理(学)(Computer Ethics)是计算机设计、开发和应用以及计算机信息的生产、存储、交换和传播中所涉及的伦理道德问题。计算机伦理最早可追溯到20世纪40年代。1948年,维纳(Norbert Wiener)在《控制论》(Cybernetics)一书中指出:“像众所周知的原子弹一样……超高速计算机器给人类带来的是美好还是罪恶?”1950年,他的另一本书《人有人的用处》(The Human Use of Human Beings)的观点为计算机伦理学研究奠定了基础。1958年发生了世界上第一起计算机犯罪:一位程序员使用计算机代码来防止他的银行账户被标记为透支。当时没有法律能够阻止,因此他没有受到指控。人们意识到,为了避免通过计算机进行类似金融犯罪的发生,有必要设立计算机的相关道德准则。1976年,曼娜(Walter Maner)正式提出“计算机伦理学”这一概念,并率先将自己的理论用于教学实践。计算机伦理的主要问题包括:个人隐私、计算机犯罪、知识产权、职业道德等[4]。

信息伦理(学)(Information Ethics)是从伦理学角度研究和探讨信息以及信息传递过程中的道德伦理问题,以揭示信息传递中的道德伦理规律。1985年,卡普罗(Rafael Capurro)发表论文《信息科学中的道德问题》(“Moral issues in information science”),研究了电子形式下专门信息的生产、存储、传播和使用问题,包括信息研究、信息科学教育、信息工作领域中的伦理问题,是最早的以信息科学作为伦理学研究对象的论文。1986年,梅森(Richard O. Mason)提出了著名的“PAPA”理论,即,信息隐私(Privacy)、信息正确(Accuracy)、信息产权(Property)、信息存取(Accessibility)。1999年卡普罗的论文《数字图书馆的伦理问题》(“Ethical Aspects of Digital Libraries”)对信息时代下图书馆方面产生的伦理问题进行了分析和论述。2000年,卡普罗的论文《21世纪信息社会的伦理挑战》(“Ethical challenges of the information society in the 21st century”)将信息伦理从计算机伦理中区分出来,强调了信息伦理学。信息伦理的主要问题包括:知识产权、个人隐私、信息污染、信息安全、信息鸿沟和文化侵害等[4]。

信息伦理学有广义和狭义之分:狭义的信息伦理学是研究信息和知识管理(与管理伦理学有关)以及图书馆、档案领域的伦理问题的应用伦理学科。广义的信息伦理学是探讨与信息相关的所有方面的伦理问题,而不局限于信息情报技术的范围。随着信息伦理学研究范围和深度的不断拓展,人们逐渐认识到,信息伦理学与计算机伦理学虽具有密切的关系,但信息伦理学不完全等同于计算机伦理学,信息伦理学有着更广阔的研究范围,涵盖了前者的研究范围。计算机伦理学融入信息伦理学、被信息伦理学取而代之代表了诸多学者的一种观点[4]。

网络伦理(学)(Network Ethics,Internet Ethics,Cyber Ethics),又称为计算机网络伦理学,是在计算机信息网络领域调节人与人、人与社会之间特殊利益关系的道德价值观念和行为规范,是研究计算机网络中的伦理问题以及计算机网络引起的社会伦理问题的一门应用性学科。20世纪90年代,计算机信息技术与互联网通信技术融合,推动人类进入信息化程度更高的网络时代。相较于计算机信息技术,网络技术对人们生产、生活、学习和工作方式的影响要更加深刻。网络技术在使用过程中不仅出现了传统计算机伦理问题,还出现了新的伦理问题,计算机伦理学的外延得到进一步拓展。1996年,罗格森(Simon Rogerson)和贝奈姆(Terrell Ward Bynum)共同发文《信息伦理:第二代》(“Information Ethics: the Second Generation”)指出,第一代计算机伦理学存在研究范围有限、深度不够和应用领域狭窄等问题。高尼亚科(Krystyna Gorniak)倡导建立有力的信息伦理理论来为网络社会提供指南和决策。为了更加全面、深入地研究和解决信息网络技术和信息网络系统相关的伦理问题,学术界在传统计算机伦理学的基础上将计算机伦理学的研究范围向外拓展到互联网,进入计算机伦理学的第二个阶段,为了凸显网络信息这一专门领域的特点,一些学者将该阶段称为网络伦理阶段,这一阶段的计算机伦理学称为网络伦理学[4]。

大数据伦理(学)(Big Data Ethics),简称为数据伦理(学),是大型数据的采集、开发、利用和保护的道德规范,关注的是由大型数据集的收集和分析引起的伦理问题。数据伦理作为大数据时代的新概念,它来源于信息伦理、网络伦理和计算机伦理,但又需要新的范式来适应大数据时代的需求。2012年9月,戴维斯(Kord Davis)和帕特森(Doug Patterson)出版的《大数据伦理:平衡风险与创新》(Ethics of Big Data: Balancing Risk and Innovation)开启了数据伦理的先河。2013年,舍恩伯格(Viktor Mayer-Sch?nberger)和库克耶(Kenneth Cukier)的《大数据》(Big Data)一书将大数据伦理界定为新的隐私问题、数据安全问题、虚假数据问题。数据伦理的主要问题包括:数字身份、数据隐私、数据权利、数据独裁、数字鸿沟等[4]。

现代信息技术是信息伦理学產生与演进的逻辑依据,即随着信息技术的发展,信息伦理学不断形成新的研究领域。20世纪70年代,因研究计算机技术引发的伦理问题,产生了计算机伦理学。到了20世纪90年代,信息技术拓展到互联网领域,与信息相关的伦理研究发展为网络伦理学。进入21世纪,大数据作为信息化发展的高级阶段,产生了新的伦理现象,引发新的伦理问题,逐步形成了新的道德价值和道德规范,即数据伦理学。信息伦理学是一个动态的概念,其内涵随着信息社会的变化而变化。信息技术的推进和信息化程度的加深,促使信息伦理学的研究范围不断向外拓展,已经深入与信息领域有关的所有伦理问题,超出了传统计算机伦理学与网络伦理学的边界。总体上,信息伦理学的内涵经历了计算机伦理、网络伦理到大数据时代信息伦理(数据伦理)的历史演变,逐步形成了一种抽象层次的、具有整体视野和普遍意义的信息伦理学[4]。

机器人伦理(学)(Robot Ethics)是人类设计、建造、使用和对待机器人的道德,是关涉机器人的建造和使用的伦理学。机器伦理(学)(Machine Ethics)是如何确保使用人工智能的人工机器或人工智能体(Artificial Moral Agents)具有道德的行为,是人工道德智能体、机器人或人工智能计算机行为的道德(或伦理)设计。机器伦理学与机器人伦理学的内涵略有差异。机器人伦理学属于“以人为中心”的伦理学,责任主体是人,主要研究设计者在机器人设计、使用中的伦理规范以及把人类道德规范嵌入机器人系统等问题;机器伦理学是机器人具有了人类智能后应该遵循的伦理规范,机器伦理学是“以机器为中心”的伦理学,责任主体是机器。

机器人伦理学的根源滥觞于科幻文学作品之中。1936年,恰佩克(Karel Capek)在喜剧《罗素姆的万能机器人》(Rossums Universal Robots)中首次使用了“Robota”一词,后来演化为“Robot”,该词指的是经过生物零件组装、为人类服务的奴隶。恰佩克创制该词的原意是指“劳动”或“奴役”,为伦理道德的引入提供了对象载体。巴特勒(Samuel Butler)在1863年就已开始考虑机器成为人类继任者的可能性。他在该问题上做了深刻的哲学反思,不仅表现在对智能机器的一般性探讨,而且也转向了机器伦理方面(利用伦理原则对机器行为进行规约和引导)的讨论。1942年,阿西莫夫(Isaac Asimov)的短篇小说《环舞》(Run Around)阐述了著名的“机器人三定律”。1987年,沃尔德罗普(Mitchell Waldrop)的论文《责任问题》(“A Question of Responsi-bility”)正式提出机器伦理这一术语。2002年在意大利召开的国际机器人伦理学研讨会上,首次使用了“机器人伦理学”(Roboethics),并提出把“机器人伦理学”细化为“机器伦理学”和“机器人伦理学”两个应用分支学科。2017年,机器人索菲亚(Sophia)被授予沙特阿拉伯国籍(第一个拥有国籍的机器人),引发了若干争议,如,索菲亚是否可以投票选举或结婚?故意关闭系统是否视为谋杀等。机器人伦理的主要问题包括:机器人的权利、人与机器人的关系、机器人法律、专门领域机器人道德等[4]。

以2016年阿尔法狗(AlphaGo)赢得人机围棋大战为标志,人工智能伦理成为世界各国政府、组织机构以及大型科技企业的人工智能政策的核心内容之一。学者们也对人工智能伦理及相关问题开展了积极广泛的研究和探讨。2017年,伯德丁顿(Paula Boddington)出版了首部AI伦理著作《走向人工智能的道德准则》(Towards a Code of Ethics for Artificial Intelligence),阐述了如何借鉴其他领域的经验教训制定人工智能伦理规范或其他法规,并介绍了人工智能职业道德的特点,认为人工智能伦理的主要问题包括:隐私泄露、偏见歧视、责权归属、技术滥用等[4]。

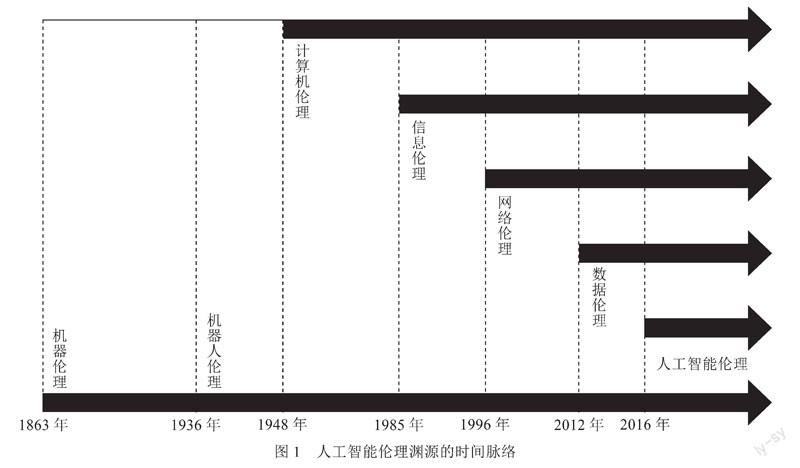

综上可知,人工智能伦理源于计算机伦理、信息伦理、网络伦理、数据伦理和机器人伦理(见图1)。从计算機伦理、信息伦理、网络伦理、数据伦理、机器人伦理到人工智能伦理,有其发展的继承性,有很多相似之处,但也有不同(见图2)。

二、人工智能伦理课程的开设情况

人工智能伦理教育逐步引起了国内外高等学校的关注。美国斯坦福大学于2014年首先开设了人工智能伦理相关课程“人工智能中的哲学、伦理及其影响”(Artificial Intelligence-Philosophy, Ethics, and Impact),涉及内容包括:人工智能历史,哲学问题,伦理问题,法律、社会及经济影响,未来挑战等。2017年至2019年间,美国哈佛大学、麻省理工学院、卡内基梅隆大学等,英国的爱丁堡大学、卡迪夫大学等,加拿大的麦吉尔大学、滑铁卢大学等,荷兰的代尔夫特大学等一大批欧美高校陆续开设了人工智能伦理相关课程。尽管这些课程的授课内容存在差异,但是大部分课程都对经典伦理理论、人工智能伦理问题、典型伦理案例、未来政策及挑战等主题进行了介绍和讨论。

在国内,南京大学于2019年出版了《南京大学人工智能本科专业教育培养体系2019》,将“人工智能伦理”课程(2学分)列入人才培养方案[5],课程教学内容包括:人工智能与伦理简介、伦理规范、人工智能伦理的案例及分析、应对技术变革的措施、人工智能伦理的发展之路等。西安交通大学于2019年出版了《人工智能本科专业知识体系与课程设置》,其中设置了由“人工智能的哲学基础与伦理”(1学分)和“人工智能的社会风险与法律”(1学分)共两门课程组成的人工智能与社会课程群[6]。“人工智能的哲学基础与伦理”课程的教学内容有:人工智能的一般哲学问题、强人工智能的哲学问题、人工智能的伦理规范问题、人工智能系统的道德困境等。“人工智能的社会风险与法律”课程的教学内容包括:人工智能的产业发展与政策规制、人工智能的社会风险、人工智能的法律挑战以及人工智能与未来社会等。西安电子科技大学于2019年出版了《人工智能学院本硕博培养体系》,将“人工智能中的道德法律”课程(1学分)列为选修课[7]。

同时,北京大学于2019年开设了“人工智能与机器人伦理”课程,教学内容包括:AI的基本问题、发展历史,人的心智与智能,AI伦理与社会影响,AI中的法律与治理等。复旦大学于2019年开设了“人工智能:语言与伦理”课程,其授课内容由人工智能史、超级人工智能、人工智能与自然语言处理、机器翻译问题、具有道德意识的机器人设计、如何建造儒家机器人等内容组成。暨南大学于2021年开设了“人工智能伦理导论”通识课。但迄今为止,国内高校人工智能伦理相关课程的开设还非常欠缺。

三、人工智能伦理课程的教学设计

人工智能伦理课程的教学目标应该着力培养学生建立AI技术应用、AI技术研发、AI系统设计、AI系统运维中的伦理意识,要求学生了解在AI技术应用、AI技术研发、AI系统设计、AI系统运维中的伦理规范(和职业道德),要求学生基本具备在AI技术应用、AI技术研发、AI系统设计、AI系统运维中的伦理思维和伦理决策能力。

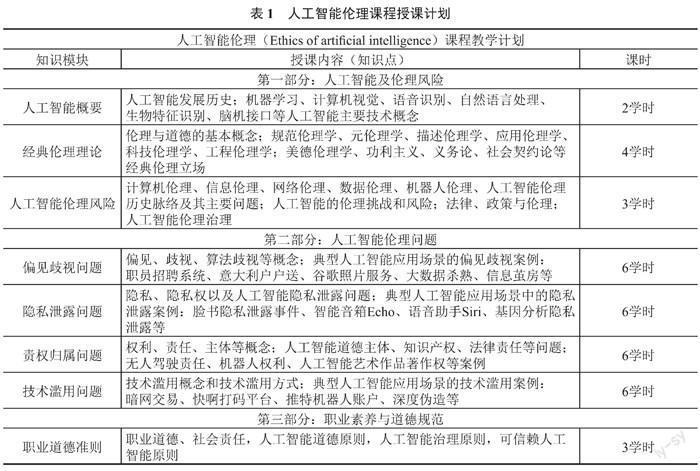

表1给出了结合教学实践设计的人工智能伦理课程教学计划(2学分)。课程授课内容大致包括三大部分:人工智能及伦理风险、人工智能伦理问题、职业素养与道德规范。人工智能及伦理风险部分讲授人工智能的发展历史、经典伦理理论基础、人工智能的伦理风险、人工智能伦理的历史渊源、人工智能治理的基本路径。人工智能伦理问题部分结合计算机视觉、自然语言处理、语音识别、生物特征识别、推荐系统、无人驾驶、人工智能创作等人工智能应用的典型案例,分析讲授人工智能应用中隐私泄露、偏见歧视、责权归属、技术滥用等主要伦理问题。职业道德准则部分讲授人工智能应用、研发、设计人员应该遵守的职业道德,以及可信赖人工智能的基本治理原则。

总而言之,目前国内高校主要设置了“人工智能”和“智能科学与技术”两个人工智能类的主要本科专业[8],现有人工智能和智能科学与技术本科专业点数共计643个。积极开展人工智能伦理课程教学研究,建立适合我国国情的人工智能伦理课程教学内容、教学方式和课程教材,显得十分迫切和必要。

参考文献:

[1] 吴飞,吴超,朱强. 科教融合和产教协同促进人工智能创新人才培养[J]. 中国大学教学,2022(1/2):15-19.

[2] 刘江,章晓庆. 面向非计算机专业的人工智能导论课程建设与探索[J]. 中国大学教学,2022(1/2):46-51.

[3] 胡清华,王国兰,王鑫. 校企深度融合的人工智能复合型人才培养探索[J]. 中国大学教学,2022(3):43-50,57.

[4] 古天龙. 人工智能伦理导论[M]. 北京:高等教育出版社,2022.

[5] 南京大学人工智能学院. 南京大学人工智能本科专业教育培养体系 2019[M]. 北京:机械工业出版社,2019.

[6] 郑南宁. 人工智能本科专业知识体系与课程设置[M]. 北京:清华大学出版社,2019.

[7] 焦李成,李阳阳,侯彪,等. 人工智能学院本硕博培养体系[M]. 北京:清华大学出版社,2019.

[8] 古天龙. 适应办学层次/类型的人工智能专业建设[J]. 中国大学教学,2020(10):25-29.

古天龙,暨南大学教授,教育部高等学校计算机类专业教学指导委员会副主任委员。