基于深度学习的食管癌肿瘤靶区自动勾画临床价值研究*

2022-04-26张军黄勇黄晓雨汪琦吴齐兵徐凯梁栋

张军,黄勇,黄晓雨,汪琦,吴齐兵,徐凯,梁栋

230039 合肥,安徽大学 互联网学院(张军、徐凯、梁栋);230012 合肥,合肥市第二人民医院 肿瘤内科(黄勇); 230032 合肥,安徽医科大学 第一临床医学院(黄晓雨、汪琦、吴齐兵)

食管癌是世界范围内常见肿瘤之一,发病率占恶性肿瘤排行第9位,死亡率占第6位[1]。手术治疗是食管癌首选的治疗方式,但食管癌侵袭性很强,病程前期即可发生淋巴及血行转移等并发症,且疾病早期症状不明显,多数人因进食哽咽、声音嘶哑等症状就诊时肿瘤已处于进展期,往往已失去手术切除机会[2]。对于不可手术治疗的食管癌患者,单独使用化疗、靶向等治疗手段疗效不佳,5年生存率不高[3-4]。相对而言,放射治疗能够使一部分进展期食管癌患者获得长期生存机会,在不可手术切除的食管癌综合治疗中占据主要地位[5]。放疗的过程包括定位、扫描、靶区勾画、物理医师制定放疗计划、复位、放疗。而肿瘤局部复发和远处转移是食管癌放疗失败的主要原因,且由于人体正常组织可耐受的放射剂量有限,食管癌患者放疗失败后接受二程放疗的风险极大,容易造成食管气管瘘、食管纵膈瘘等严重并发症。因此,在食管癌放疗开始前,食管癌肿瘤靶区的精确勾画是十分重要的环节[6],该任务通常是由放疗科专科医生通过治疗计划系统人工手动进行,过程耗时且靶区的准确性高度依赖于医生的知识、经验和偏好[7]。

近年来,多位研究者尝试将深度学习自动勾画方法应用于临床靶区勾画[8-9],马辰莺等[10]采用改进的VB-Net深度学习网络应用于宫颈癌术前临床盆腔淋巴引流区和宫旁区域以及术后盆腔淋巴引流区的分割,在测试数据集上平均自动勾画与参考勾画的吻合度分别达80.0%、70.0%及86.0%。王学涛等[11]在经典U-Net网络中引入残差单元和注意力机制单元对乳腺癌临床靶区及危及器官进行勾画,在测试数据集上平均自动勾画与手动勾画结果的吻合度分别达到80.5%及92.0%。以上研究初步证明了基于深度学习自动勾画肿瘤靶区的可行性,但有关食管癌靶区勾画的研究较少,目前仅Cao等[12]在U-Net基础上提出一种DDUnet深度学习网络,应用于食管癌术后临床靶区勾画,在测试集中验证精度达86.7%。考虑到食管癌CT影像中病灶区与背景区的面积差异较大,常规U-Net等网络模型未能较好学习到靶区目标特征。基于此,本研究提出一种嵌入空间金字塔池化层的U型对称自动勾画网络,并探究其用于食管癌肿瘤靶区自动勾画的几何精度,探讨其临床应用的可能性。

1 材料与方法

1.1 数据来源

数据选取自2013年1月至2021年10月在合肥市第二人民医院已接受调强适形放疗的100例食管癌患者CT影像,其中术前患者71例,术后患者29例,共选取切片数5 094张。患者均采取仰卧位真空垫固定,使用GE LightSpeed 16排CT模拟定位机进行定位扫描,影像分辨率512×512,重建层厚5 mm。主管医师在瓦里安Eclipse计划系统上完成危及器官以及肿瘤靶区的勾画。

1.2 数据划分

由于本文所收集的术后患者数据均为术后复发数据,其CT影像含有食管癌肿瘤病灶,因此将术前和术后数据同时入组进行实验,并采用两种不同的数据划分方式,来对模型进行评估:1)采用患者切片影像为单位的方式对数据集进行划分,将患者的所有切片影像放在一起,从中选取10%作为测试集,来评估模型训练完成后的性能。其余90%作为训练验证集,训练时随机选取80%作为训练集用于训练模型,20%作为验证集,用于单个批次训练完成时验证模型的损失值和精确度以评估模型的稳定性;2)采用以患者整体为单位对数据集进行划分,从100例患者数据中随机选取术前患者7例和术后患者3例作为测试集,其余90例中的20%作为验证集,并在单个批次训练完成时测试模型的损失值和精确度以评估模型的稳定性。90例中的80%作为训练集用于训练模型。

1.3 数据处理

首先将原始dcm格式影像的灰度值线性映射至0~255范围,存储为png格式,大小为512×512的影像切片。并将切片影像对应的主管医师手动勾画肿瘤靶区,经专家审核后作为参考勾画。此外,为提升网络泛化能力,在训练数据输入网络前进行增广,以得到更多训练数据。数据增广形式主要为对切片影像进行仿射变换和弹性变换处理[13]。仿射变换处理主要将切片影像和靶区进行旋转、翻转、剪切等处理,其中经仿射变换矩阵映射,任意原影像点和变换影像点两点横纵坐标差控制在15%左右。弹性变换处理对原影像中像素点各个维度产生随机标准偏差生成变换影像。

1.4 网络结构

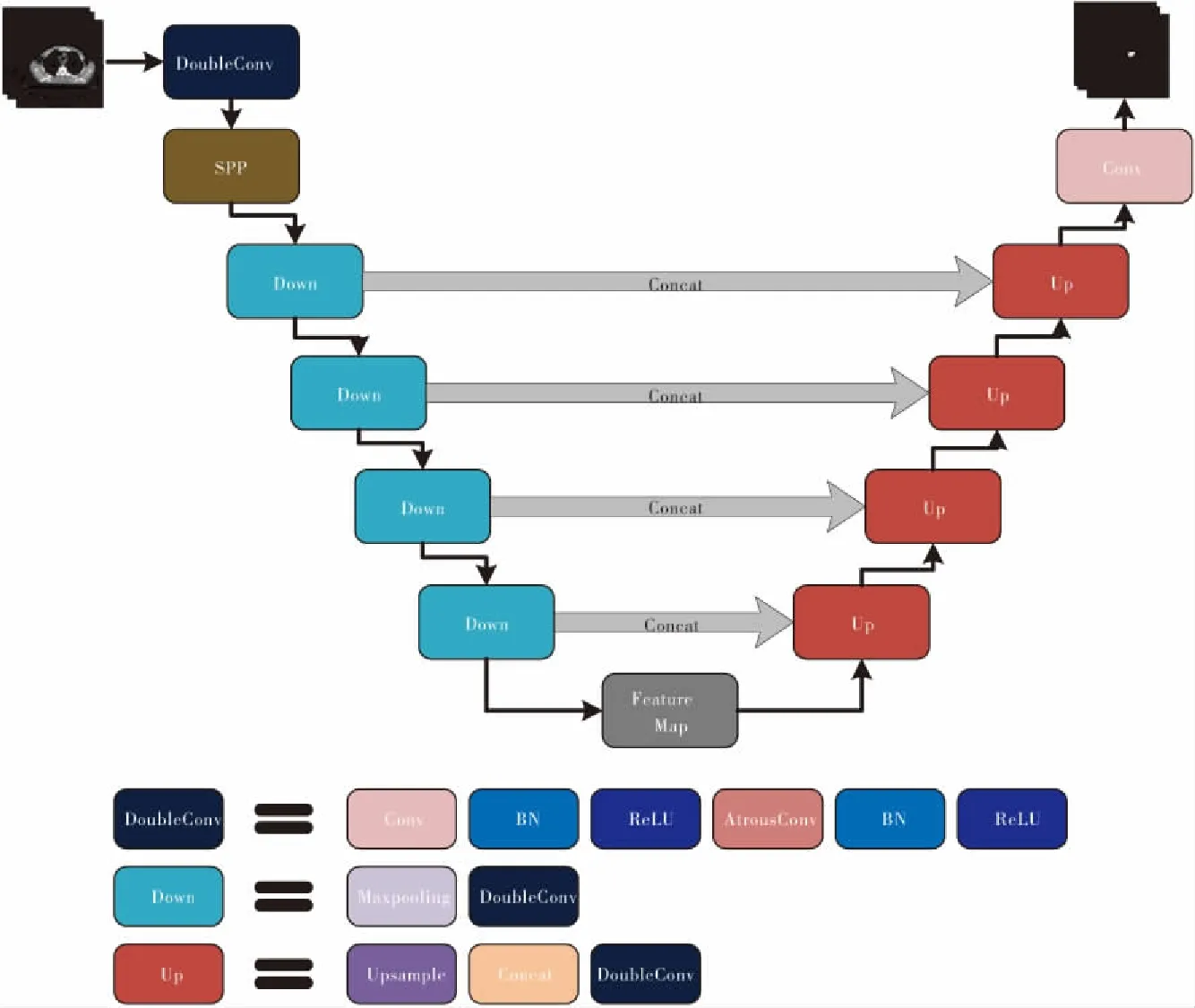

经典U-Net[14]网络在分割精度和速度上都达到了较高水平,但对于食管肿瘤影像这种肿瘤边界模糊、个体差异大,无法实现肿瘤靶区不同尺度的特征融合,以及传统卷积层的感受野较小等问题。为解决上述问题,本文结合食管癌解剖结构特点,构建如图1所示网络结构:1)嵌入改进的空间金字塔池化层模块,实现不同尺度的特征融合,对食管癌肿瘤靶区边界更加敏感;2)采用空洞卷积替代传统卷积层,扩大感受野;3)通过影像增强、归一化处理等方法缓解梯度消失、过拟合等问题;随着网络层次加深,训练时间增长,容易造成信息丢失产生错误。为解决这一问题,训练分割网络时引入He等[15]于2014年提出的空间金字塔池化层网络原理,构造空间金字塔池化层模块(spatial pyramid pooling,SPP),如图2所示。分别对输入的特征图进行3次不同池化核大小的全局最大池化操作,在和输入的特征图拼接,之后进行卷积操作生成融合后的特征图,以实现肿瘤靶区不同尺度的特征融合,从而提升网络整体对肿瘤边界的特征提取能力。

图1 网络结构图

图2 空间金字塔池化层模块

整个实验在显存为24 GB的NVIDIA 3090 GPU上运行,使用Python编程语言在PyTorch框架内实现。影像输入大小设置为512×512,Batch Size为8以及Adam梯度下降算法。初始学习率为1×10-4,Epoch设置为50。

1.5 损失函数

经典U-Net网络是利用SoftMax的输出结果计算二元交叉熵损失(binary cross entropy,BCE),作为网络整体的优化函数,见公式(1):

(1)

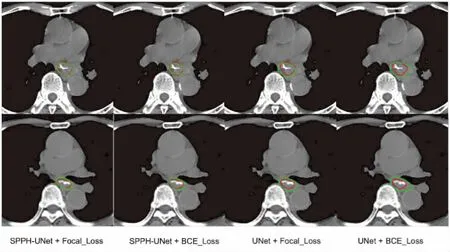

其中:N表示输入影像像素总数;gi∈{0,1}表示第i个像素的真实标签,其中0为背景,1为病灶;pi∈[0,1]表示对应像素预测为前景的概率。当前景像素远远小于背景像素的数量,计算得到的背景损失值则较大,致使优化函数在优化网络时更偏向于对背景的优化。如图3所示为食管癌患者CT影像,其中肿瘤靶区相对背景区域较小,因此数据集存在严重的前景与背景像素不平衡问题,使用二元交叉熵损失函数会使得网络的最终勾画效果不佳。

图3 食管癌患者CT影像

The target area was colored by blue.

因此针对类别不均衡问题,本文采用一种在标准交叉熵损失基础上改进的损失函数Focal_Loss[16],见公式(2):

(2)

其中y′表示经过sigmoid的预测结果,y表示标签的真实值,α和γ为平衡因子。在原有交叉熵损失函数的基础上添加γ>0平衡因子是为了降低易分类样本对loss的贡献,使得网络更加关注于难分类样本本身,解决类别不平衡问题。此外添加α平衡因子是用来平衡正负样本本身的数量不均问题。

1.6 评价指标

本文采用戴斯相似性系数(Dice similarity coefficient,DSC)以及豪斯多夫距离(Hausdorff distance,HD)来评价自动勾画与手动勾画结果的相似性。

戴斯相似性系数对区域内部填充比较敏感,其计算方法如公式(3)所示:

(3)

式中,A为自动勾画部分,B为手动勾画部分,分子为手动勾画与自动勾画交集的两倍,分母为手动勾画与自动勾画区域的并集。DSC数值介于0和1之间,其值越大,表明重合度越高。

HD(A,B)对分割的边界区域比较敏感,其计算方法如公式(4)、公式(5)所示:

HD(A,B)=max(h(A,B),h(B,A))

(4)

h(A,B)=max(min‖a-b‖),∈A,b∈B

(5)

其中,h(A,B)表示A集合中每一个点到B集合最小距离中的最大值。h(A,B)数值越小,表示A、B重合度越高,分割的效果越好。

1.7 统计学处理

使用基于Python 3.1软件自编的程序分别对食管癌肿瘤靶区自动勾画网络进行评估参数提取,并利用SPSS 24.0软件对结果进行统计分析和配对T检验。P<0.05为差异有统计学意义。

2 结 果

2.1 网络性能对比

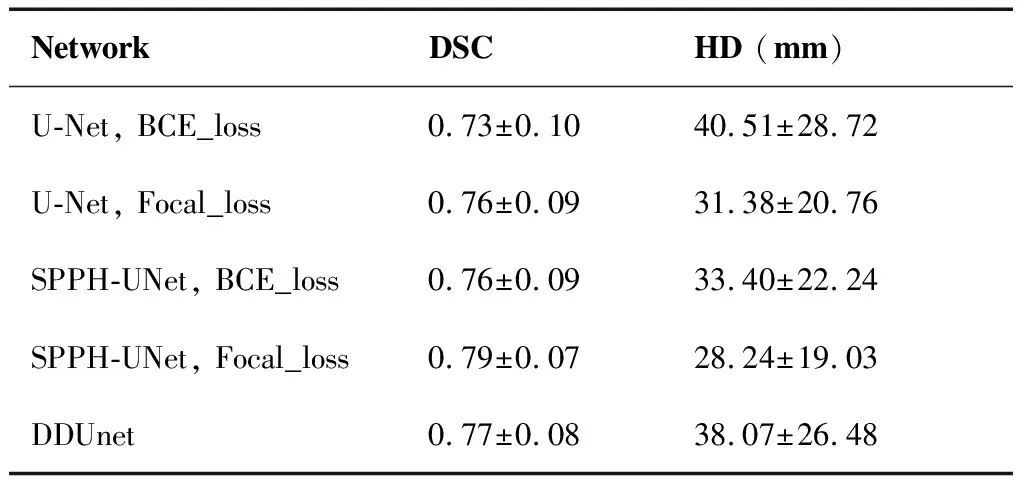

将SPP模块放置在改进U-Net网络的初始位置(记为SPPH-UNet),分别采用BCE_Loss及Focal_Loss应用于SPPH-UNet网络与经典U-Net网络上,并与在U型对称网络中引入空洞卷积并添加批量归一化的DDUnet网络进行对比验证,数据划分方式采用以患者整体为单位对数据集进行划分。所有实验采用相同的训练初始参数进行网络训练,选取在验证集上趋于平稳时的最优模型应用于测试集上得到食管癌肿瘤靶区自动勾画结果如表1所示,并对结果进行比较分析。

表1 网络性能对比

可以看出SPPH-UNet相比经典U-Net网络不管是BCE_Loss还是Focal_Loss上均有所提升。DSC均值达到0.79±0.07,HD均值达到(28.24±19.03) mm,且单张切片在AMD Ryzen 7 5800H CPU上预测平均耗时约4.7 s左右。图4展示了2位食管癌患者在不同网络上对肿瘤靶区进行勾画的结果。红色标注为Ground Truth,即专业放疗科医生进行手工标注的靶区“金标准”,绿色标注为本次试验的预测结果。可以看出数据经网络得到自动勾画与医师手动勾画结果对比具有较好的一致性,符合临床应用的要求。

图4 2位食管癌患者在不同网络上肿瘤靶区勾画可视化图

2.2 手动勾画耗时与自动勾画后经医生审核手动调整耗时对比

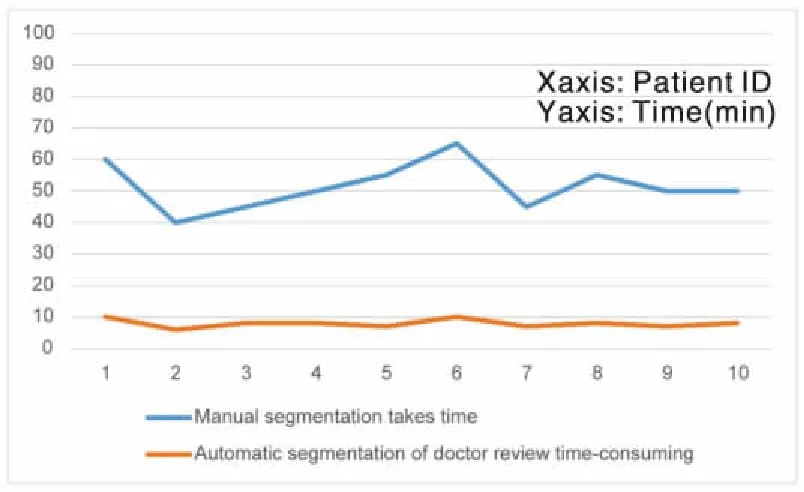

对比测试集十名患者手动勾画与深度学习网络自动勾画后经医生审核并加以手动调整所需时间,结果如图5所示,并对结果进行比较分析。

图5 手动勾画耗时与自动勾画后经医生审核手动调整耗时对比

可以看出手动勾画平均每个患者耗时51.5 min,而经深度学习网络自动生成的结果经医生审核手动调整平均每个患者耗时7.9 min,速度提升6.52倍。

2.3 不同数据集划分方式的结果比较

为了探究不同数据划分方式对最终结果的影响,本文进行了如下实验研究,数据划分方式采用以患者切片为单位对数据集进行划分。所有实验采用相同的训练初始参数进行网络训练,选取在验证集上趋于平稳时的最优模型应用于测试集得到食管癌肿瘤靶区自动勾画结果如表2所示,并对结果进行比较分析。

表2 不同数据划分方式对最终结果的影响

可以看出虽然采用不同的网络以及不同的损失函数,但最终结果差距不大且对比表1可以看出网络离线的评估指标结果“虚高”。

2.4 统计学结果对比

将不同网络以及不同损失函数对比经典U-Net在DSC和HD指标上的统计分析,其配对t检验的P值结果如表3所示。所有配对t检验结果P值均小于0.05,差异有统计学意义。

表3 对比经典U-Net网络在DSC和HD指标上的配对T检验结果

3 讨 论

食管癌肿瘤靶区勾画的主要技术难点在于确定肿瘤边界、肿瘤亚临床病灶和微转移灶、靶区内肿瘤细胞的放疗敏感性等,使得食管癌肿瘤靶区勾画较其他肿瘤的靶区勾画更具挑战性[17]。靶区的精确勾画是影响食管癌放疗疗效的主要因素,而目前手动勾画过于依赖医生的经验和能力,勾画的准确性和一致性难以保证。此外,患者体型差异、摆位差异、呼吸运动所致食管位置改变,食管与纵膈CT值接近,术前术后影像形变差异大等原因[18],使得样本一致性较差给数据搜集、清洗、训练造成困难。

本研究结合食管癌患者肿瘤靶区特征,提出了一种嵌入空间金字塔池化层的U型对称自动勾画网络SPPH-UNet,将空间金字塔池化层模块嵌入U型网络架构中,实现肿瘤靶区不同尺度的特征融合,解决由于几何形状、空间位置、呼吸运动等原因所致食管位置改变,以及肿瘤解剖结构复杂等问题,提升网络对肿瘤边界的特征提取能力,从而提高肿瘤靶区的自动勾画精度。从本研究结果表明,加入了空间金字塔池化层模块的网络相较经典的U-Net网络有一定程度的提升,说明引入空间金字塔池化层模块对提高网络性能有实质性的作用。此外通过对比不同损失函数得出Focal_Loss能够获得最大分割精度,本文方法在DSC和HD指标上都不同程度优于经典的U-Net网络,相对肿瘤靶区目标边界模糊、个体差异大等问题,本网络能够较为准确地分割出目标靶区的整体形状及位置,网络预测结果一致性较好。

此外,训练集和测试集的划分方式导致算法结果存在差异,不合理的数据集划分则可能会导致评估指标表现“虚高”[19]。如表2所示,以患者切片为单位的方式对数据集进行划分,则会将测试集中的标签信息泄露到训练集中,从而测试结果较表1表现更优,对比DSC和HD指标上分别提升了18.1%和38.6%。因此为避免数据泄露问题,在对数据集划分时,同一患者的切片影像及靶区数据不可既一部分划分为训练集,另一部分又划分为测试集,需对同一患者的切片数据进行整体划分为训练集或测试集。

综上所述,本研究采用改进的U-Net网络对食管癌肿瘤靶区进行自动勾画,自动分割勾画结果与医师勾画具有较好的一致性,相较手动勾画耗时显著缩短。应用于临床中,可以大大提高医生的工作效率和勾画一致性。但本研究采用二维切片数据对卷积神经网络进行训练,丢失了三维信息。今后将收集更多不同机构的患者数据以及采用三维数据对网络进行训练实现食管癌肿瘤靶区自动勾画将是研究重点。

作者声明:本文全部作者对于研究和撰写的论文出现的不端行为承担相应责任;并承诺论文中涉及的原始图片、数据资料等已按照有关规定保存,可接受核查。

学术不端:本文在初审、返修及出版前均通过中国知网(CNKI)科技期刊学术不端文献检测系统的学术不端检测。

同行评议:经同行专家双盲外审,达到刊发要求。

利益冲突:所有作者均声明不存在利益冲突。

文章版权:本文出版前已与全体作者签署了论文授权书等协议。