不同情绪载体的神经活动及其异同——脑成像研究的ALE元分析*

2022-03-15刘俊材冉光明

刘俊材 冉光明 张 琪

·元分析(Meta-Analysis)·

不同情绪载体的神经活动及其异同——脑成像研究的ALE元分析*

刘俊材1冉光明1张 琪2

(1西华师范大学教育学院心理系;2西华师范大学学前与初等教育学院, 四川 南充 637002)

情绪识别一直是学界关注的热点。虽然已有研究探讨了动态面孔表情、动态身体表情和声音情绪的脑机制, 但对每种情绪载体的整体认识相对不完善, 同时对不同情绪载体之间神经机制的共性和区别知之甚少。因此, 本研究首先通过三项独立的激活似然估计元分析来识别每种情绪模式的大脑激活区域, 然后进行对比分析以评估三种情绪载体之间共同的和独特的神经活动。结果显示, 动态面孔表情的大脑活动包括广泛的额叶、枕叶、颞叶和部分顶叶皮层以及海马、小脑、丘脑、杏仁核等皮层下区域; 动态身体表情的激活集中于颞/枕叶相关脑区以及小脑和海马; 声音情绪则引起了颞叶、额叶、杏仁核、尾状核和脑岛的激活。联合分析表明, 三种情绪载体跨模态激活了左侧颞中回和右侧颞上回。对比分析的结果证明了视觉刺激比听觉刺激更占优势, 动态面孔表情尤为突出, 同时动态身体表情也发挥着重要作用, 但声音情绪有其独特性。总之, 这些发现验证和拓展了三种情绪载体的现有神经模型, 揭示了情绪处理中心的、普遍性的区域, 但每种情绪载体又有自己可靠的特异性神经回路。

情绪载体; 动态面孔表情; 动态身体表情; 声音情绪; ALE元分析

1 引言

作为一个高度社会化的物种, 人类无时无刻不与他人进行频繁的社会互动。准确感知他人的情绪是社会互动中最重要的社交技能之一。心理学界长期以来一直关注与情绪相关的面孔表情、身体动作和声音情绪, 这是因为它们都是社会关系建立和维持过程中不可或缺的交际信号。例如, 恐惧可以通过面孔眼部区域的视觉信息、身体部位的动作和姿势以及声音的声学变化来识别(de Gelder et al., 2006; Heberlein & Atkinson, 2009)。尽管这些信号有着本质不同, 但都可以导致对情绪状态的相同识别(即, 人是害怕的), 并激活观察者相似的情绪特异性反应(Magnée et al., 2007)。

1.1 不同情绪载体及其神经基础

1.1.1 动态面孔表情及其神经基础

面孔是社会生活中最常见的刺激形式, 100多块解剖上和功能上截然不同的肌肉构成了这一巨大的姿势空间(Kilts et al., 2003; Waters & Terzopoulos, 1990)。肌肉的细微变化提供了丰富而有力的社会信息, 我们可以通过面孔的特征快速而准确地推断他人的特质(Ritchie et al., 2017), 并自动化地形成对他人的印象(Klapper et al., 2016), 以便于进一步的社会交流(Haxby et al., 2000; 张琪等, 2015)。但在日常生活中, 我们面对的面孔是动态变化而非静态的, 准确识别他人的动态情绪面孔对于个体的生存以及人际交往更为重要。研究表明, 在动态面孔表情处理的神经网络中存在一个核心的神经网络, 即颞−枕联合区(Foley et al., 2012; Haxby et al., 2000), 包括梭状回(fusiform gyrus, FG)、颞上回(superior temporal gyrus, STG)、颞中回(middle temporal gyrus, MTG)、颞下回(inferior temporal gyrus, ITG)、枕中回(middle occipital gyrus, MOG)和枕下回(inferior occipital gyrus, IOG)等。由核心神经网络向外延伸的被称为扩展的神经网络, 包括核心脑区之外的广大皮层和皮层下的相关脑区, 前者涉及顶下小叶(inferior parietal lobule, IPL) (Sarkheil et al., 2013)和额下回(inferior frontal gyrus, IFG) (Sato et al. et al., 2012)等, 而后者主要与杏仁核(amygdala)有关(Sato et al., 2010)。核心脑区主要负责早期的视觉分析和刺激的运动加工, 而扩展的神经网络则与个体的情感处理、面孔模仿、刺激的动态表征等有关(Haxby et al., 2000; 张琪等, 2015)。Zinchenko等人(2018)的元分析发现动态面孔表情激活了上述脑区以及小脑(cerebellum), 验证和支持了动态面孔表情处理的神经网络。

1.1.2 动态身体表情及其神经基础

除了面孔表情外, 身体表情也是情感交流的重要载体。长期以来, 面孔表情被认为是比身体表情更普遍、更一致的情感信息载体(de Gelder, et al.,2014)。然而, 研究表明, 成年人通过身体姿势和动作来识别情绪的准确性可以与面孔相媲美(Atkinson et al., 2007; Zieber et al., 2014), 甚至在某些情况下, 人的身体比面孔更能传达情绪状态(de Gelder & Partan, 2009; Sinke, et al., 2012)。与面孔相比, 身体有着独特的优势, 可以促进信息的情感交流, 例如, 其相对较大的尺寸使得他们在更远的距离就能被看到, 即使是处在信号发出者的背后也能观察到身体所传达的情感信号(de Gelder, 2009)。但以往关于动态身体表情的加工机制存在不同的看法, 一部分研究者赞同Giese和Poggio (2003)提出的躯体形态与动作加工的分层神经模型, 他们认为身体形态信息(如外形特征)的加工通路始于视觉皮层, 经次级颞叶皮层到达梭状回和颞上沟(superior temporal sulcus, STS); 动作与情绪信息的加工通路从视觉皮层出发, 经枕叶和颞叶, 而后到达负责整合人类复杂动作信息的颞上沟(de Gelder et al., 2014; Moro et al., 2008)。但大多数研究者更认同de Gelder等人(2006, 2015)提出的身体表情加工的双通道理论。该理论认为身体表情的加工有两条独立且相互协作的神经通路:一条是身体表情的自动化加工通路, 维持着反射性行为, 主要涉及上丘(superior colliculus, SC)、丘脑(thalamus)、纹状体(striatum)和杏仁核等; 另一条是皮层控制回路, 主要负责情感、认知和决策过程, 包括额−顶运动系统、前额叶与杏仁核相连接的部分。

1.1.3 声音情绪及其神经基础

声音同样带有关于动作发出者的多种信息(Krauss et al., 2002; Pisanski et al., 2016), 和面孔及身体一样容易识别(Scherer, 1995), 但与视觉刺激更高的空间灵敏度不同, 声音的主要作用是使我们能够区分更细微的时间差异(Calvert et al., 1998)。与面孔和身体相比, 声音更具层次化(多样性), 如强度、速度、0等都可以传达信息(Scherer et al., 2003)。研究者认为声音主要传递着言语、情绪和身份信息, 有三条部分分离的神经通路分别进行加工(Belin et al., 2004)。言语信息加工的脑机制可以用双通路模型(Hickok & Poeppel, 2007)很好的理解。在该模型中, 双侧颞上沟的中部和后部(middle and superior temporal sulcus, M/PSTS)负责声音刺激的语音加工和表征, 随后分出腹侧通路和背侧通路, 分别对言语信息进行意义理解和将颞上沟编码的语音表征转换成运动区域(额下回)编码的发声运动表征。情绪信息的加工则可以用3阶段工作模型很好的解释(Schirmer & Kotz, 2006):在刺激出现后的100 ms左右, 初级和次级听觉皮层对声学信息进行提取和分析; 在200 ms左右, 前颞上回/沟(anterior superior temporal gyrus/ sulcus, ASTG/S)和杏仁核对情绪线索进行整合; 在400 ms左右, 右侧额下回和眶额皮质(orbitofrontal cortex, OFC)进行更高级的认知评价, 左侧额下皮层负责语义情绪信息加工。而身份信息的加工能够从整合模型中得到全面了解(Maguinness et al., 2018)。根据该模型, 在感知层面的加工是对身份特征进行分析, 主要涉及颞上回/沟后部、颞横回(heschl’s gyrus, HG)和颞平面(planum temporale, PT); 在识别层面, 被提取的身份特征在颞上回/沟中部与已储存的声音原型进行比较, 选择出偏离原型的特征; 而后, 颞上回/沟前部和中部将偏离的特征与储存的参照图式进行比较, 即人声−身份识别。元分析研究验证了上述理论, 同时拓展了小脑和脑岛(insula)等的作用(Frühholz & Grandjean, 2013; Frühholz et al., 2016)。

1.2 不同情绪载体神经机制的异同

尽管大量的研究探讨了三种情绪载体的神经机制, 但通常都只关注单一模式的加工。随着认识的深入, 部分研究者开始关注面孔表情和身体表情之间脑机制的相似性与差异性。一方面, 研究发现, 面孔表情与身体表情加工的神经机制存在重合。不论是静态还是动态身体表情都能够显著激活梭状回、颞上沟和杏仁核等面孔知觉敏感区域(Kret et al., 2011; Giese & Poggio, 2003)。此外, 不同情绪类型的面孔和身体刺激可以共同激活眶额皮质(de Gelder, 2006)、脑岛(Tamietto et al., 2015)和楔叶(cuneus) (Kret et al., 2011)等负责情绪加工的脑区。另一方面, 有证据支持面孔与身体表情加工的神经机制存在分离。Downing等人(2001)的研究直接将不同刺激进行对比, 结果发现外纹状皮层躯体区(extrastriate body area, EBA)仅对身体刺激敏感, 对面孔和其他刺激不敏感。此外, 尽管面孔和身体表情在脑区的激活峰值存在重合, 但具体的激活位置存在分离(Schwarzlose et al., 2005; van de Riet et al., 2009)。

除了探讨面孔表情和身体表情之间神经机制的相似性与差异性, 研究者还发现了面孔表情和声音情绪之间神经机制的异同。例如, Dricu和Frühholz (2016)的元分析研究表明, 面孔和声音都引起了双侧额下皮层(inferior frontal cortex, IFC)、腹内侧额叶(dorsal medial frontal cortex, DMFC)、右侧颞上沟和左侧脑岛的激活; 面孔比声音在双侧杏仁核、梭状回中部(middle fusiform gyrus, MFG)和视觉联合区更为活跃; 而声音比面孔在右侧颞上沟中部、左侧额下皮层、左内侧额叶和额叶岛盖(frontal operculum, FOP)上激活更大。Schirmer (2018)的元分析则对纳入的面孔和声音研究进行了匹配:为每个声音研究选择一个任务和情绪匹配的面孔研究; 没有模式匹配的声音研究被排除在分析之外; 如果一个声音研究有多个匹配的面孔研究, 则进一步在被试数量、性别比例和发表时间上进行匹配, 选择差异最小的研究。结果发现, 面孔比声音在双侧海马旁回(parahippocampal gyrus, PHG)、左侧胼胝下回(subcallosal gyrus, SG)和右侧壳核(putamen)更为活跃; 声音比面孔在双侧颞上沟上激活更大。

尽管以往对不同情绪载体神经机制异同的考察大多数集中于两种情绪载体之间, 但仍有极少数研究者关注到了多模态刺激之间神经机制的相似性与差异性。Peelen等人(2010)要求被试评估从面部运动、身体动作和声音语调中感知到的情绪强度, 结果发现内侧前额叶皮层(medial prefrontal cortex, MPFC)和左侧颞上沟后部可以忽略情绪刺激载体来表征基本情绪。曹林敬(2018)的研究则有所不同:实验1要求被试判别视觉刺激的情绪类型而不考虑刺激的类别(面孔、身体和全身情绪), 分析表明只有左侧中央后回(postcentral gyrus, POCG)可以跨模态的显著区分3种情绪; 实验2要求被试对刺激的价态(负性、中性和正性)进行判断, 但刺激类别有4种(面孔、身体、声音和音乐), 涉及视听觉两种模态, 结果发现左侧中央后回和颞中回既可以不受不同模态的限制(视觉和听觉)表征价态信息, 又可以不受视觉(面孔和身体)和听觉(声音和音乐)模态内各自不同刺激类别的限制表征价态信息。

1.3 以往研究的不足

一方面, 实证研究存在其自身不可避免的缺陷。首先, 单个脑成像研究使用的被试数量相对较少, 由此可能导致统计检验力和效应量较低(Yarkoni, 2009); 其次, 神经影像学数据对任务和控制条件等的选择特别敏感, 由此可能导致结果的不一致(周临舒等, 2017)。因此, 有必要采用基于大规模数据合成方法的元分析技术来克服单个脑成像研究的局限(Eickhoff et al., 2009; Yarkoni et al., 2011)。这不仅有助于弥补对每种情绪载体整体认识的不足[例如, 除上文所提及的脑区外, 大量的研究还发现动态面孔表情和声音情绪激活了其他脑区(Brattico et al., 2011; Sato et al., 2012; Trautmann et al., 2009)。此外, 关于身体表情的加工模型仍然存在争论, 尚无较为统一的结论], 还可以探究3种情绪载体之间神经活动的一般性与差异性, 更能为今后的感兴趣区(region of interest, ROI)分析提供具有代表的参考坐标点。另一方面, 现有的元分析存在一定不足。首先, 在动态面孔表情的元分析中, 大部分数据来自于女性被试, 且纳入分析的文献既有面孔刚性运动(指头部转动, 相对于身体而运动, 如点头、摇头)的研究, 又有非刚性运动(指脸部各个器官的运动, 如眨眼、撇嘴等)的研究, 其结果可能存在一定偏差。其次, 目前还没有任何研究对动态身体表情进行元分析以确定其大脑活动区域。再次, 声音情绪的元分析纳入了非人类环境的声音、部分研究只关注了情绪韵律的处理而忽视了音乐情绪和语调等。此外, 尽管有元分析将面孔和声音进行对比, 但研究未区分静态和动态面孔, 其结果的可靠性和可推广性受到制约。最后, 目前还没有元分析研究将面孔和身体、身体和声音进行对比, 对三种情绪载体神经机制的相似性与差异性的认识还相对不清晰。

1.4 本元分析的目的

综上所述, 目前对每种情绪载体的整体认识相对不完善, 同时对不同情绪载体之间脑机制的共性和区别知之甚少。因此, 在本研究中, 首先采用激活似然估计(activation likelihood estimation, ALE)元分析来识别每种情绪模式的大脑激活区域。然后, 对这些元分析激活图进行对比分析以评估三种情绪载体之间共同的和独特的神经机制。

2 方法

2.1 文献检索

在PubMed、PsycINFO、CNKI和Google Scholar中对发表的关于情绪脑机制的研究进行检索(截止日期为2020年10月10日)。检索使用的关键词分为4组:第一组与神经成像相关:神经成像、功能性磁共振成像(functional magnetic resonance imaging, fMRI)、正电子发射断层扫描(positive emission tomography, PET)、Neuroimaging、fMRI、PET; 第二组与刺激载体相关:面孔、身体、声音、韵律、语调、音乐、facial、body、voice、vocal、prosody、intonation、music; 第三组与运动状态相关:动态、移动、运动、dynamic、move、motion。面孔和身体表情需将三组关键词一一配对进行检索, 而声音情绪仅需将前两组相关词进行配对。此外, 对所有确定的研究进行正向和反向引文检索, 以确保纳入所有相关的研究。依据上述方法, 共检索到8494篇文献。

2.2 文献选取标准

文献的纳入与排除标准如下:(1)研究类型:文献为实证研究, 排除综述、元分析及个案研究; (2)研究对象:研究中的被试为正常人(平均年龄为9~55岁), 排除脑损伤病人和心理障碍患者等特殊群体以及年龄小于9岁的儿童和大于55的老年人; (3)刺激材料:研究使用的刺激材料为人类的动态面孔(非刚性运动)、动态身体、声音且呈现的情绪为6种基本情绪中的一种或中性, 排除使用静态刺激、刚性运动面孔、点光运动身体、动物声音以及非基本情绪或中性的研究; (4)研究手段:研究采用fMRI或PET的方法, 排除采用认知行为、脑电图(electroencephalograph, EEG)和脑磁图(magnetoencephalography, MEG)等其他方法的文献以及旨在分析白质和灰质情况的弥散张量成像(diffusion tensor imaging, DTI)和磁共振成像(magnetic resonance imaging, MRI)研究; (5)数据分析:研究采用全脑分析, 排除只进行感兴趣区域分析的研究; (6)结果报告:研究使用标准化后的Talairach或MNI空间报告大脑的激活结果, 排除未报告激活区域坐标的研究。具体的筛选过程与结果请见图1。

2.3 文献编码

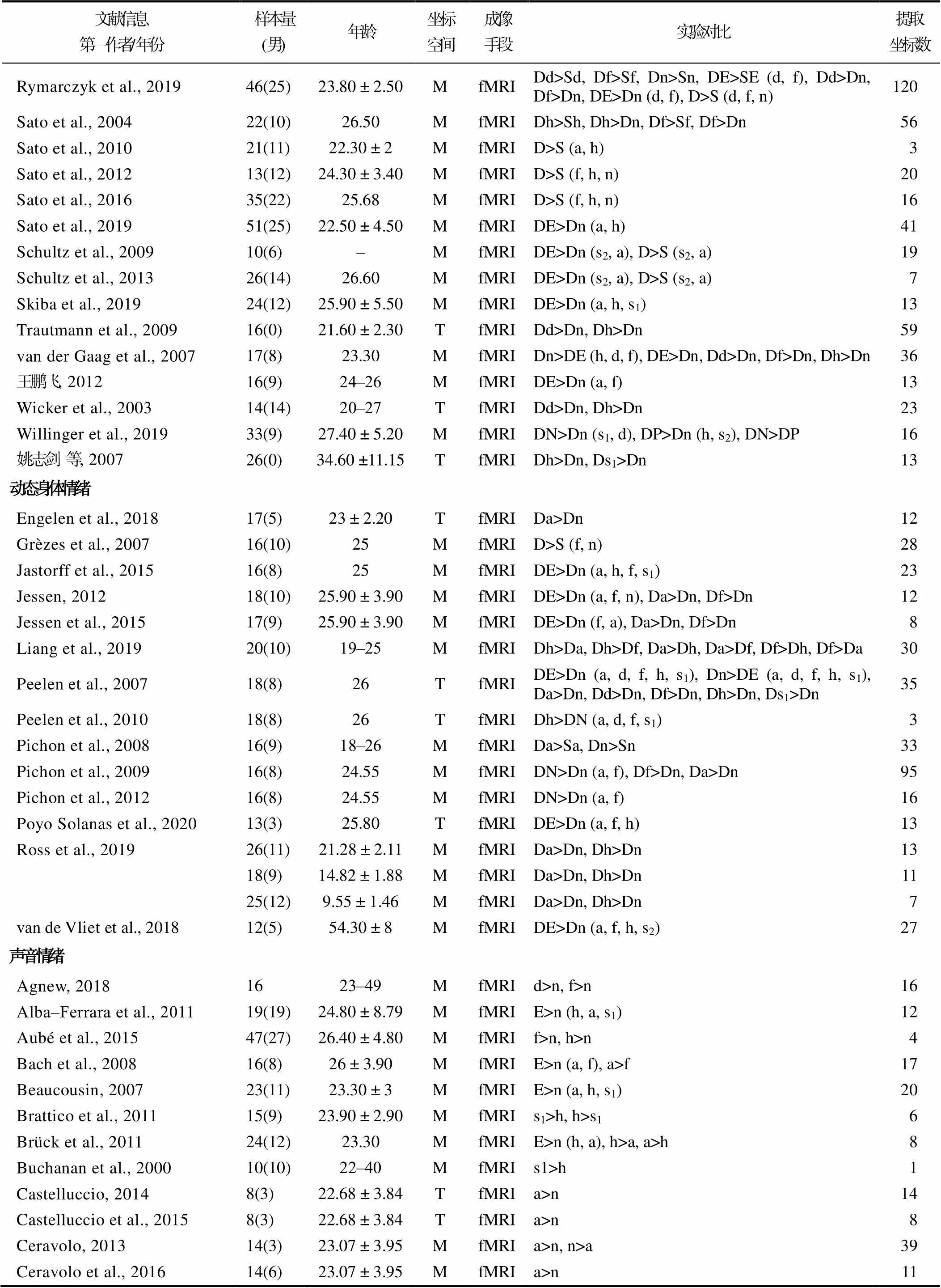

对纳入元分析的文献进行如下编码:文献信息(第一作者姓名和发表时间)、样本量大小(总样本量及男性样本量)、年龄(平均年龄或年龄范围)、坐标空间(Talairach 或MNI 空间)、成像手段(fMRI或PET)、实验具体对比和坐标值。先由第一作者在两个时间段依据文献纳入与排除标准进行编码, 再由通讯作者对两次编码结果进行校对。结果显示, 两次编码仅存在个别数据偏差, 一致性较高。纳入文献的基本信息请见表1。

2.4 激活似然估计法

研究使用神经成像领域最常用的元分析方法——激活似然估计法。它是利用高斯概率密度分布模拟激活焦点局部化的不确定性, 这些分布的体素联合产生ALE值, 即数据集中至少一个焦点位于给定体素的可能性估计(Turkeltaub et al., 2012; Morrison, 2016)。数据处理通过GingerALE软件(3.0.2版本) (Eickhoff et al., 2009; Turkeltaub et al., 2012)进行。在数据分析之前, 使用软件中的转换工具将MNI空间中报告的坐标转换为Talairach空间中的坐标。然后, 分别对3种情绪载体进行单一元分析, 在统计图阈值为< 0.05的水平上使用家族错误校正(Cluster‒level FWE), 对聚类阈值为< 0.001进行多重比较(5000个排列)校正(Eickhoff et al., 2017)。最后, 3种情绪载体两两间进行对比分析, 与前人研究一致(Arsalidou et al., 2020; Yalpe & Arsalidou, 2018), 对比分析阈值为< 0.01且最小团块大于200 mm3(10000个排列)。

图1 文献筛选流程图

表1 元分析文献基本信息

续表1

续表1

注:T = Talairach, M = MNI, D = 动态, S = 静态, E = 情绪, N = 负性情绪, P = 正性情绪, a = 愤怒, d = 厌恶, f = 恐惧, s1= 悲伤, s2= 惊讶, h = 高兴, n = 中性

3 结果

3.1 单一元分析的结果

分析显示, 相较于静态载体, 动态面孔在双侧颞上回、颞中回、梭状回, 左侧颞下回、海马旁回、杏仁核, 右侧额下回、中央前回(precentral gyrus, PG)、豆状核(lentiform nucleus, LN)激活更大; 动态身体在双侧颞上回和右侧小脑更活跃。相比于中性刺激, 动态情绪面孔引起了双侧颞上回、颞中回、梭状回、小脑和杏仁核, 左侧颞下回和枕中回, 右侧额下回、额中回(medial frontal gyrus, MFG)、中央前回、脑岛和顶下小叶的激活; 动态情绪身体在双侧颞上回, 左侧枕中回、枕下回、楔叶、小脑, 右侧颞下回、梭状回、海马旁回更活跃; 情绪声音在双侧颞上回, 左侧颞中回、颞横回(transverse temporal gyrus, TTG)、中央前回和杏仁核, 右侧额下回、额中回和脑岛激活更大。与中性和负性载体相比, 动态正性面孔在右侧颞中回、枕下回和小脑更活跃; 动态正性身体在左侧小脑和右侧颞上回、枕中回、舌回(lingual gyrus, LING)激活更大; 正性声音情绪则引起了双侧颞上回, 左侧杏仁核, 右侧颞横回和尾状核(CN)的激活。负性情绪效应显示, 动态负性面孔在双侧颞中回和杏仁核, 左侧额下回, 右侧颞上回、额上回(superior frontal gyrus, SFG)、枕中回、梭状回、中央前回和海马旁回激活更大; 动态负性身体在左侧颞上回、枕中回、枕下回、和楔叶以及右侧颞中回和梭状回更活跃; 负性声音引起了双侧颞上回和额下回, 左侧颞横回、中央前回和右侧脑岛的激活。

3.2 联合分析的结果

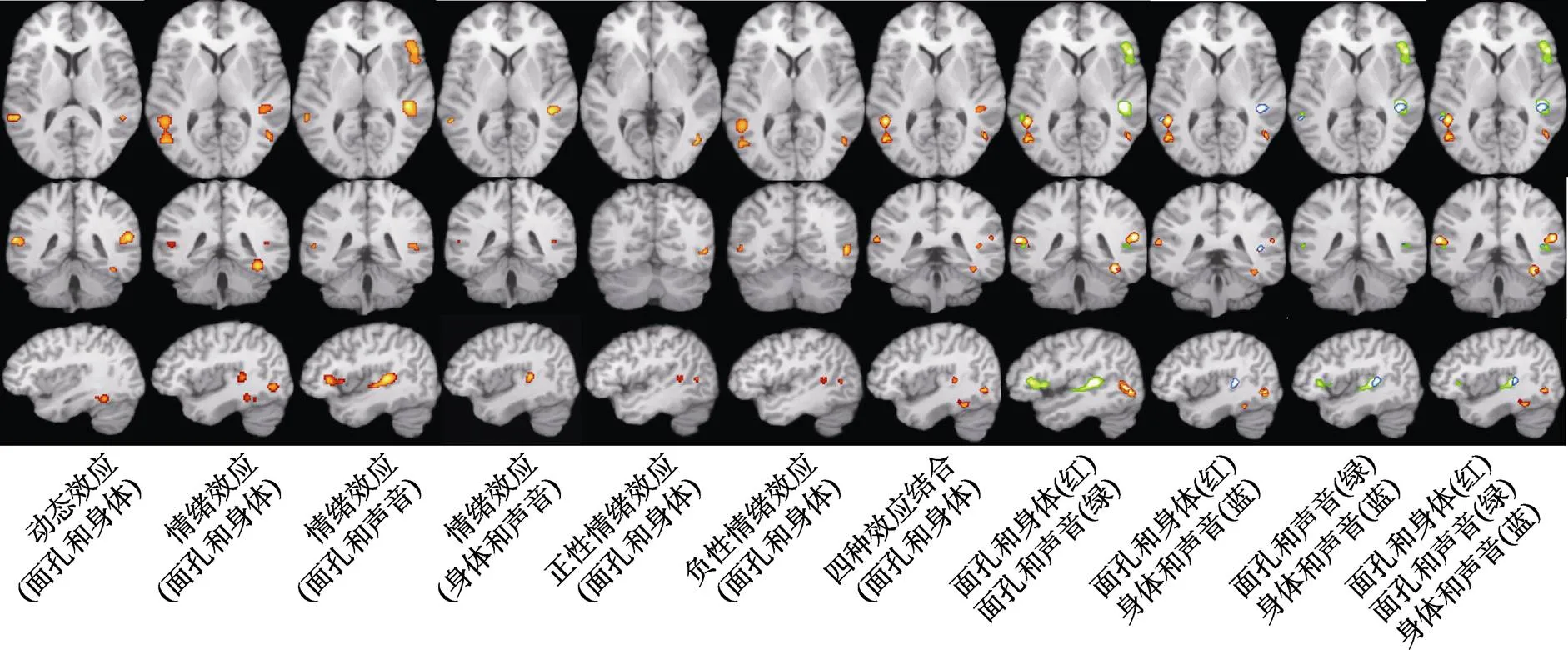

联合分析的结果见表2和图2。其中, 图2第1~6列激活图表示三种情绪载体两两之间共同激活的脑区。在动态效应下, 动态面孔和身体共同激活的脑区有:双侧颞上回、左侧梭状回和右侧小脑。在情绪效应下, 动态面孔和身体共同激活了双侧颞上回, 左侧颞中回、枕下回以及右侧颞下回、梭状回、海马旁回、豆状核; 动态面孔和声音共同激活了左侧颞中回、杏仁核和右侧颞上回、额下回、脑岛; 动态身体和声音共同激活了左侧颞中回和右侧颞上回。在正性情绪效应下, 动态面孔和身体被发现在右侧颞下回和颞中回共同激活。在负性情绪效应下, 动态面孔和身体被发现共同激活了双侧颞下回、左侧颞中回和右侧枕下回。动态面孔和声音、动态身体和声音在正性和负性情绪效应下不存在共同的激活脑区。第7列则展示了动态面孔和身体在动态效应、情绪效应、正性和负性情绪效应下共同激活的所有脑区。第8~11列激活图表示三种情绪载体两两之间共同激活脑区的进一步叠加, 重叠的部分即共同激活的脑区。由此不难看出三种情绪载体共同激活的区域位于左侧颞中回和右侧颞上回。

表2 联合分析激活簇结果

图2 联合分析的结果

3.3 对比分析的结果

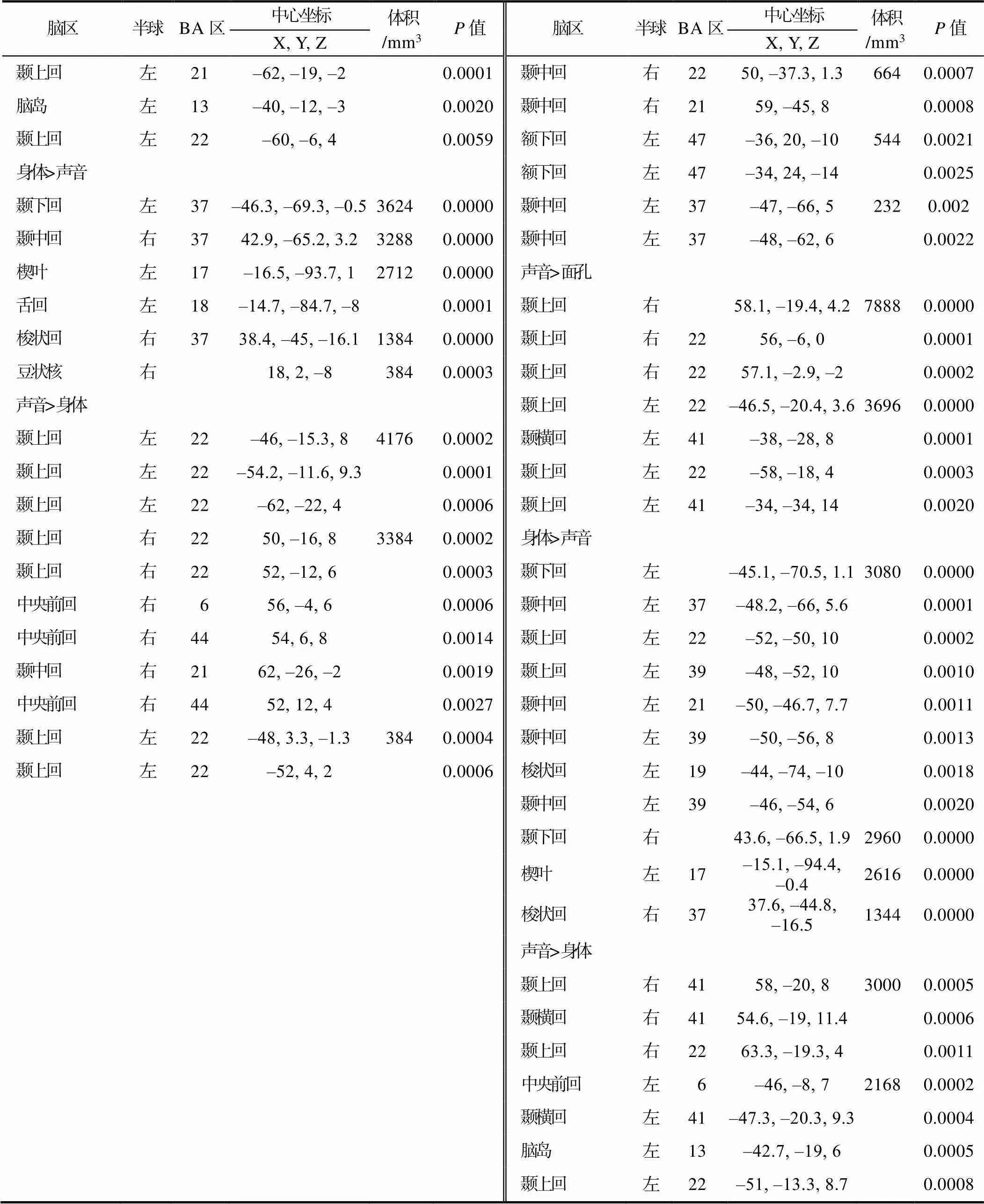

对比分析显示, 在动态效应下, 与面孔相比, 身体引起了左侧颞上回的激活。在情绪效应下, 面孔相比于身体在右侧梭状回、中央前回、海马旁回和小脑激活更大, 反过来, 身体引起了左侧枕下回、舌回、楔叶和右侧枕中回的活跃; 与声音相比, 面孔在双侧海马旁回, 左侧小脑和杏仁核以及右侧颞上回、额上回、梭状回、中央前回和顶下小叶激活更大, 而声音引起了双侧颞上回和左侧脑岛的活跃; 相较于声音, 身体在左侧颞下回、舌回、楔叶和右侧颞中回、梭状回、豆状核激活更大, 反之, 声音引起了双侧颞上回和右侧颞中回、中央前回的活跃。在正性情绪效应下, 与声音相比, 身体在右侧枕中回更活跃, 而面孔比声音在右侧颞下回、枕中回、枕下回、梭状回、小脑激活更大; 与面孔相比, 声音在双侧脑岛和左侧颞上回更活跃, 而身体引起了右侧枕中回的激活。在负性情绪效应下, 相对于面孔, 身体引起了左侧楔叶以及右侧枕中回和小脑的活跃; 与声音相比, 面孔在双侧颞中回, 左侧额下回和杏仁核以及右侧梭状回和中央前回上激活更大; 相对于面孔, 声音引起了双侧颞上回和左侧颞横回的活跃; 身体相比于声音, 在双侧颞下回和梭状回以及左侧颞上回、颞中回和楔叶上显著激活; 相对于身体, 声音引起了双侧颞上回、颞横回和左侧中央前回、脑岛的活跃(见表3和图3)。在动态效应、正性情绪效应和负性情绪效应下未发现动态面孔比动态身体激活更大的脑区, 同时, 未在负性情绪效应下发现声音情绪比动态身体更活跃的区域。

4 讨论

本研究使用ALE元分析确定了动态面孔表情、动态身体表情和声音情绪各自的大脑激活区域, 探明了三种情绪载体之间共同的和不同的大脑活动机制。在接下来的章节中, 我们将讨论当前发现对于理解情绪识别的潜在意义, 重点关注不同情绪载体之间的异同。

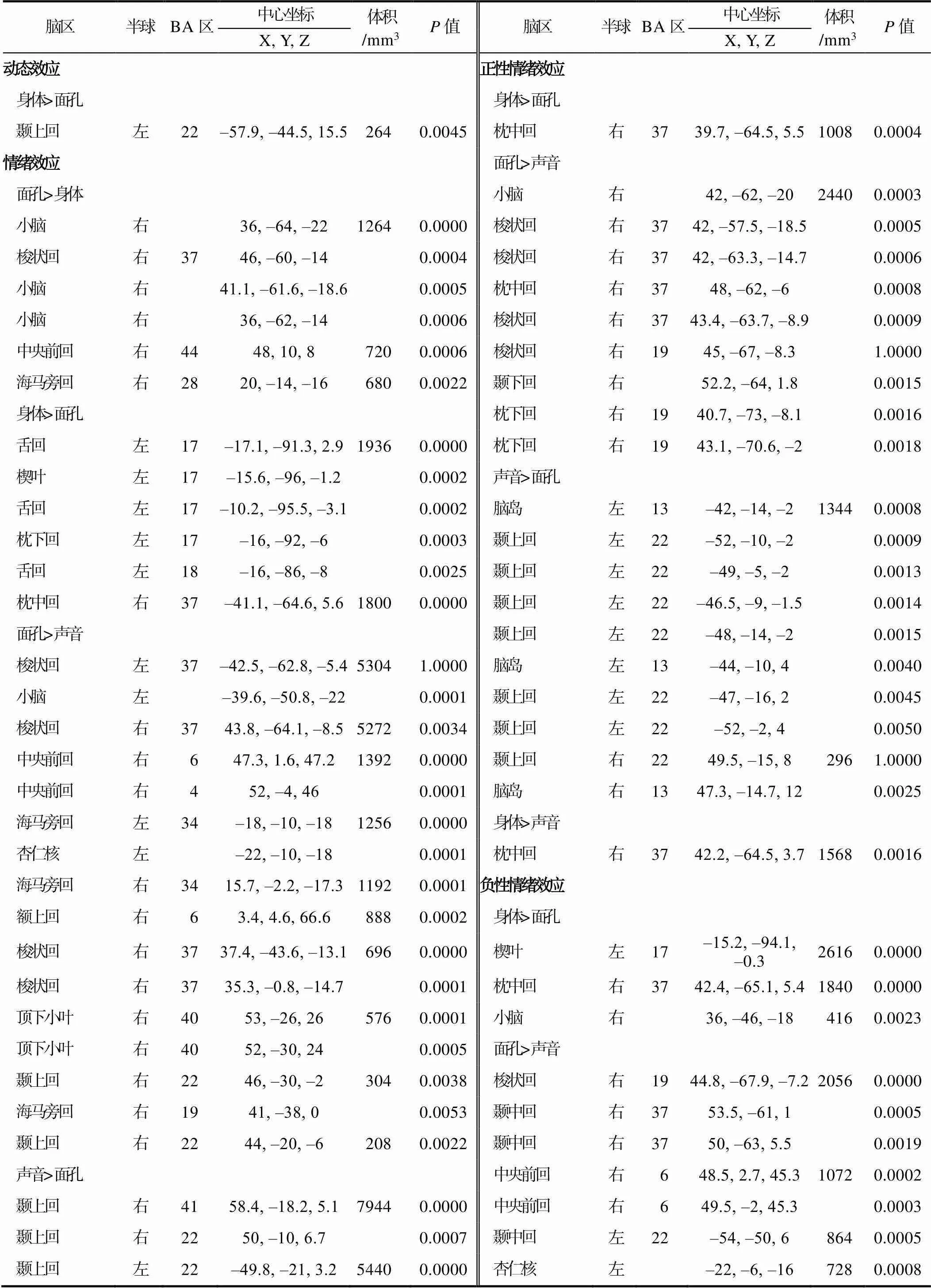

表3 对比分析激活簇结果

续表3

4.1 单一元分析:不同情绪载体的神经机制

4.1.1 动态面孔表情

与以往的动态面孔表情元分析一致(Zinchenko et al., 2018), 本研究发现了双侧梭状回和颞中回, 左侧枕中回、小脑、杏仁核和额下回, 右侧颞上回和枕下回的激活。此外, 结果显示, 双侧海马旁回, 左侧颞上回和颞下回以及右侧枕中回、额上回、额中回、额下回、中央前回、顶下小叶、小脑、杏仁核、豆状核和脑岛也处于活跃状态。其中双侧颞上回、颞中回、梭状回, 左侧颞下回、海马旁回、杏仁核以及右侧额下回、中央前回、豆状核对动态信息敏感; 双侧颞上回、颞中回、梭状回、小脑和杏仁核, 左侧颞下回和枕中回, 右侧额下回、额中回、中央前回、脑岛和顶下小叶对情绪信息更活跃; 而右侧颞中回、枕下回和小脑对正性情绪信息更敏感; 双侧颞中回和杏仁核, 左侧额下回, 右侧颞上回、额上回、枕中回、梭状回、中央前回和海马旁回则对负性情绪信息更活跃。两项研究结果共同验证和拓展了动态面孔表情处理的核心−扩展神经网络(张琪等, 2015), 结果表明:核心的神经网络(颞−枕联合区)主要包括梭状回、颞上回、颞中回、颞下回、枕中回和枕下回等脑区; 扩展的神经网络包括两个部分, 一是核心脑区之外的广大皮层脑区, 包括额上回、额中回、额下回、中央前回和顶下小叶等, 二是皮层下的相关脑区, 涉及海马旁回、小脑、杏仁核、豆状核以及脑岛等区域。核心的神经网络主要负责早期的知觉编码和刺激的运动加工, 而扩展网络与个体的空间注意力、面孔模仿、情绪处理、刺激的动态表征等有关。这些结果极大的完善了动态面孔表情处理的神经网络, 为动态面孔表情的识别提供了一个基础模型。

图3 对比分析的结果

4.1.2 动态身体表情

如前文所述, 大多数的研究验证和支持了de Gelder等人(2006, 2015)提出的双通道模型, 但我们的结果(动态身体信息激活了双侧颞上回和右侧小脑; 情绪信息引起了双侧颞上回, 左侧枕中回、枕下回、楔叶、小脑以及右侧颞下回、梭状回和海马旁回的活跃; 正性情绪信息更多地激活了左侧小脑和右侧颞上回、枕中回、舌回; 而左侧颞上回、枕中回、枕下回、和楔叶以及右侧颞中回和梭状回对负性情绪信息更敏感)似乎更支持躯体形态与动作加工的分层神经模型(Giese & Poggio, 2003)。这并不矛盾, 因为Giese和Poggio (2003)的理论强调从身体的外形和动作中推断情绪信息, 其本质是一种自下而上的加工机制, 没有涉及以往经验和记忆对情绪的分类、调节等高级认知加工; 而de Gelder (2006, 2015)等人的理论在强调自动化加工的同时充分地考虑了认知因素对情绪及行为的调节作用, 将自下而上的加工与自上而下的加工相结合。当前元分析纳入的文献中并未探究高级认知加工的影响, 因此未发现相关脑区的激活。本研究在Giese和Poggio (2003)的分层神经模型基础上为研究者们呈现了一个更为完善的动态身体表情加工模型:躯体形态信息的加工通路始于视觉皮层, 经次级颞叶皮层到达梭状回和颞上沟; 动作与情绪信息的加工通路也从视觉皮层出发, 经广大枕−颞叶皮层, 最后到达负责整合人类复杂动作信息的颞上沟; 同时, 小脑、楔叶、舌回和海马旁回等皮层下区域也不同程度的参与了视觉、动作和情绪信息的加工。

4.1.3 声音情绪

本研究发现情绪性声音激活了双侧颞上回, 右侧额下回、额中回和脑岛, 左侧颞中回、颞横回、中央前回和杏仁核; 正性声音情绪引起了双侧颞上回, 左侧杏仁核, 右侧颞横回和尾状核的活跃; 负性声音情绪引起了双侧颞上回和额下回, 右侧脑岛、左侧颞横回和中央前回的激活。与前人关于声音情绪的元分析研究基本一致(Frühholz & Grandjean, 2013; Frühholz et al., 2016)。支持了现有关于声音情绪神经基础的理解:(1)人类听觉皮层中存在对声音情绪进行特异性加工的区域, 即沿双侧颞上回/沟分布的颞叶声音区(temporal voice areas, TVA)。(2)大脑分三条通路加工声音情绪的言语、情绪和身份信息:在颞上沟、后外侧颞叶、前颞叶和额下回等区域加工言语信息; 在初级和次级听觉皮层、颞上回/沟、杏仁核、眶额皮质以及额下皮层处理情绪信息; 在颞上回/沟、颞横回、颞平面以及颞中回对身份信息进行表征。同时, 扩展了在声音情绪加工中对额中回、脑岛和尾状核作用的理解, 研究表明, 这三个脑区都参与了声音刺激中对情绪信息的处理(Bestelmeyer et al., 2014; Mitterschiffthaler et al., 2007; Numminen- Kontti, 2014)。此外, 我们还发现了以往元分析未曾报告的中央前回的激活。既往研究发现中央前回作为额叶情绪处理区域的一部分, 和正负性情绪处理都相关(Brattico et al., 2011; Fecteau et al., 2007; Numminen‒Kontti, 2014)。

4.2 联合分析:不同情绪载体共性的神经机制

联合分析表明, 动态面孔和身体共同激活了双侧颞上回、颞中回、颞下回、枕下回和梭状回, 以及右侧海马旁回、豆状核和小脑; 动态面孔和声音情绪共同引起了左侧颞中回、杏仁核和右侧颞上回、额下回、脑岛的活跃; 动态身体和声音情绪在左侧颞中回和右侧颞上回上共同激活; 其中, 左侧颞中回和右侧颞上回为3种情绪载体所共同激活。

4.2.1 左侧颞中回

颞中回是人类非常重要的一个脑区, 其功能复杂而多样。Xu等人(2019)用静息状态功能连通性和共激活模式描述了颞中回分离的功能, 发现左侧颞中回在社会认知、音韵加工、动作观察、情绪感应、心理理论、语音识别、面孔监控/识别等多方面发挥作用。元分析表明, 左侧颞中回在动态面孔表情处理中发挥着重要作用(Arsalidou et al., 2011; Zinchenko et al., 2018), 主要负责动态面孔的特征运动。在动态身体表情的研究中也发现了左侧颞中回的激活, 主要涉及动作知觉和身体形状的选择性激活以及情绪识别(Grèzes et al., 2007; Jastorff et al., 2015; Poyo Solanas et al., 2020)。而声音情绪的研究发现左侧颞中回不仅被声音选择性激活(Ceravolo, 2013); 而且对语音信息敏感(Binder et al., 1997); 同时还是情绪加工的重要脑区, 既包括情绪与中性的比较(Leitman et al., 2010; Regenbogen et al., 2012), 也包括情绪间的对比(Numminen‒Kontti, 2014), 还包括复杂情绪的理解(Alba‒Ferrara et al., 2011)。曹林敬(2018)利用动态面孔、动态身体、声音和音乐刺激发现, 左侧颞中回不仅可以跨模态(视觉和听觉)表征情绪信息, 并且不受视觉(动态面孔和动态身体)和听觉(声音和音乐)模态内不同刺激的影响。综上所述, 左侧颞中回在表情识别中扮演着普遍的角色, 不论是在单模态刺激中还是在多模态刺激的比较中均发现了左侧颞中回的激活, 但在不同载体中发挥的作用有所不同。

4.2.2 右侧颞上回

近20年来, 研究者对颞上回及其周围区域进行了广泛的研究, 大量的发现反而使得颞上回区域在人类大脑中的作用愈加神秘。Bukowski和Lamm (2018)系统总结了颞上回区域证据相对充分的功能, 包括言语感知(Hickok & Poeppel, 2007)、声音识别(Kriegstein & Giraud, 2004)、音乐感知(Mitterschiffthaler et al., 2007)、面孔处理(张琪等, 2015)、生物运动(Pelphrey et al., 2005)、视听整合(Stevenson & James, 2009)、自传体记忆和静息状态活动(Spreng & Grady, 2010)、自我−他人归因(Sperduti et al., 2011)、心理理论和同情心以及个性(Olson et al., 2007)等。研究发现, 右侧颞上回不仅在单一刺激中被激活, 也被动态面孔和身体(Goldberg et al., 2015; Kret et al., 2011)、动态面孔和声音情绪共同激活(Dricu & Frühholz, 2016; Watson et al., 2014), 并且在颞上回右后部有一个有限的部分, 与物体相比, 它对人的信息具有综合偏好(Watson et al., 2014)。同时, 来自精神分裂症、自闭症和注意缺陷多动障碍等的疾病研究也表明右后侧颞上回与患者的情绪识别缺陷有关(Alaerts et al., 2013; Mier et al., 2016; Zuberer et al., 2020)。当前研究再次证明了右侧颞上回在表情识别中的重要作用[对刺激进行感官处理之后理解和识别情绪(Dricu & Frühholz, 2016; Yang et al., 2015)], 同时表明右侧颞上回可以跨动态面孔、动态身体和声音情绪三种模态表征情绪。

4.3 对比分析:不同情绪载体分化的神经机制

尽管面孔、身体和声音都是社会关系建立和维持过程中不可或缺的交际信号, 都可以导致对情绪状态的相同识别, 但每种情绪载体都有自己可靠的特异性激活区域。整体来看, 动态面孔非常突出, 比动态身体和声音情绪更能引发大脑活动, 涉及双侧颞中回、梭状回、海马旁回、小脑, 左侧额下回、杏仁核, 右侧颞上回、颞下回、额上回、中央前回和顶下小叶。与其它两种载体相比, 动态身体调动了双侧颞中回、颞下回和梭状回, 左侧颞上回、枕下回、舌回和楔叶以及右侧枕中回、豆状核和小脑的活跃。尽管视觉刺激更有优势, 但声音情绪有其独特性, 引起了双侧颞上回、颞横回、中央前回、脑岛和右侧颞中回的激活。

4.3.1 突出的动态面孔

与动态身体相比, 动态面孔主要激活了右侧小脑、梭状回、海马旁回和中央前回。van de Riet等人(2009)要求被试对静态面孔和身体表情进行分类, 结果发现面孔比身体显著激活了小脑, 当前研究将这一结论扩展到了动态面孔和身体。众所周知, 梭状回是面孔识别的核心区域, 对面孔进行特异性加工, Atkinson等人(2012)的研究对动态点光显示的面孔和身体进行对比, 发现动态面孔相比于动态身体显著激活了双侧梭状回面孔区域。另一项研究(Kret et al., 2011)将现实的威胁性动态面孔和身体进行比较, 结果表明, 与动态身体相比, 动态面孔显著引起了海马的激活。中央前回则与动作观察和模仿有关, 被认为是人类镜像神经元系统的一部分(Iacoboni et al., 1999)。该系统通过模仿和学习提供了一种动作识别机制, 将动作的感觉表征转化为相应的运动程序(Rizzolatti & Craighero, 2004)。在大量的动态面孔表情研究中均发现中央前回对动态面孔表情具有强烈反应, 既在动态面孔与静态面孔的对比中被激活(Foley et al., 2012; Sato et al., 2012), 也在动态情绪面孔和动态中性面孔的比较中被激活(Trautmann et al., 2009; Wicker et al., 2003)。但在动态身体表情的研究中鲜有类似发现。

与声音情绪相比, 动态面孔在双侧海马旁回、颞中回和小脑, 左侧额下回和杏仁核以及右侧颞上回、颞下回、枕中回、枕下回、额上回、梭状回、中央前回和顶下小叶更活跃。张帆(2018)的研究表明, 低级视觉皮层和面孔选择区(梭状回和颞上回)对面孔图片的激活大于声音情绪。其它研究利用动态刺激发现面孔比声音在双侧颞中回、左侧颞下回激活更强(Hasan et al., 2016)。而Aubé等人(2015)在非言语发声的基础上加入了音乐情绪, 结果发现动态面孔引起了枕叶、运动皮层、辅助运动区(supplementary motor area, SMA)和背外侧前额叶皮层(dorsolateral prefrontal cortex, DLPFC)的活跃。元分析则表明面孔比声音情绪在双侧海马旁回、杏仁核、梭状回、视觉联合区, 左侧胼胝下回以及右侧壳核更活跃(Dricu & Frühholz, 2016; Schirmer, 2018)。最新的一项研究(Lin et al., 2020)结果更为丰富:在双侧额中回, 左侧梭状回、枕下回、扣带回和尾状核, 右侧颞下回、中央后回、中央前回、缘上回(supramarginal gyrus, SG)、枕中回、楔叶和扣带前回均发现了动态面孔比声音情绪更活跃。综上所述, 当前研究验证了以往的结果, 同时还发现了双侧小脑和左侧额下回被激活。小脑的作用主要是协助大脑维持身体的平衡与协调, 在感觉分辨中发挥重要作用(彭聃龄, 2019), 因此, 面孔作为身体的一部分比声音刺激在小脑更为活跃就不足为奇。与声音相比, 动态面孔可能会产生更多需要协调的信息, 因此需要自上而下的认知控制, 所以, 与认知过程相关的额下回区域也被激活(Arsalidou et al., 2011; Christoff & Gabrieli, 2000)。

4.3.2 重要的动态身体

对比分析结果表明, 动态身体在动态效应、情绪效应、正性情绪效应和负性情绪效应下均比动态面孔更活跃, 涉及左侧颞上回、枕下回、舌回、楔叶以及右侧枕中回和小脑。以往的研究(Atkinson et al., 2012; Kret et al., 2011)已经发现了动态身体相比动态面孔更占优势的脑区, 例如颞上回、楔叶、舌回和EBA, 但没有发现小脑的活动。早在2001年的研究中, Downing等人就发现了EBA对身体刺激敏感, 但对面孔和其他刺激不敏感。颞上回的功能是负责整合人类复杂的动作信息(de Gelder et al., 2014; Moro et al., 2008)。楔叶和舌回主要参与情绪加工(Jastorff et al., 2015; Kret et al., 2011)。而小脑主要负责身体运动的视觉感知和动作理解(Sokolov et al., 2010)。对于小脑在动态面孔>动态身体和动态身体>动态面孔的对比中均被激活的原因有待进一步的研究。我们的初步推测是:小脑与动态面孔表情和动态身体表情的神经网络都有联系, 在二者的情绪及动作加工中均发挥了作用, 但小脑的不同部位各自负责面孔和身体。毕竟小脑是如此之大[最近发表在PNAS上的一项研究发现, 人类的小脑几乎拥有新大脑皮层表面积的80% (Sereno et al., 2020)]、如此之复杂[划分为13个小叶(Stoodley & Schmahmann, 2010)以及小脑脚、齿状核(dentate nucleus, DN)等诸多结构], 目前还没有研究很好地对小脑进行最全面的解剖学区域划分并对子区域的具体功能进行探讨。

相较于声音情绪, 动态身体在双侧颞中回、颞下回、梭状回, 左侧颞上回、楔叶、舌回, 右侧枕中回和豆状核显著激活。这说明EBA不仅在区分身体表情和其他视觉刺激时起作用, 也在区分声音情绪时活跃。此外, 梭状回躯体区(fusiform body area, FBA)的功能似乎也被扩展了, 不仅仅是负责身体和情绪信息加工(Goldberg et al., 2015; Hodzic et al., 2009), 可能也参与视听觉信息的分辨。结果显示, 楔叶和舌回仅在动态身体中被发现激活更大, 而没有在动态面孔和声音情绪中被发现, 这提示我们, 楔叶和舌回既是情绪加工的区域, 也可能是身体表情加工新的特异性脑区。既往关于身体表情的研究虽然没有发现豆状核的激活, 但报道了其组成部分之一的壳核被激活(de Gelder et al., 2004; van de Riet et al., 2009), 主要负责感知运动与行为信息。这些结果为之后的研究奠定了基础, 但还需要相关研究的进一步佐证。据我们所知, 目前还没有实证研究直接对比动态身体和声音情绪来探究二者之间神经机制的异同。

4.3.3 独特的声音情绪

与动态面孔相比, 声音情绪在双侧颞上回和脑岛以及左侧颞横回激活更大。如前文所述, 双侧颞上回分布着对声音情绪进行特异性加工的区域:TVA, 这与其他研究者的结果一致 (Aubé et al., 2015; Schirmer, 2018)。脑岛的作用主要是声音情绪的认知表征和情绪探测, 不仅在以往的元分析研究中被发现激活(Frühholz et al., 2016; Witteman et al., 2012), 也在最近的一项声音情绪与动态面孔的实证比较中被发现激活(Lin et al., 2020)。颞横回主要负责身份信息的感知加工, 是整合模型的重要组成部分(Maguinness et al., 2018)。与动态身体相比, 声音情绪激活了双侧颞上回、颞横回、中央前回, 左侧脑岛和右侧颞中回。以上发现共同证明了TVA是听觉信息加工的重要特异性脑结构, 能够很好的区分声音情绪与动态面孔和身体。此外, 颞横回和脑岛除了本身所具有的功能之外也可能是声音情绪加工的又一特异性脑区。颞中回则在情绪处理和身份信息表征中扮演着重要角色(Friederici & Alter, 2004; Roswandowitz et al., 2017)。中央前回作为额叶情绪处理区域的一部分, 在情绪处理中发挥着重要作用(Brattico et al., 2011; Fecteau et al., 2007; Numminen-Kontti, 2014)。

同时, 本研究存在着一些局限。其一, 未对纳入被试的年龄范围加以严格限制。尽管以往的ALE元分析研究也纳入了少量的儿童/青少年或老年被试(Arsalidou et al., 2020; Ran & Zhang, 2018), 但年龄是一个重要的影响因素, 不同的年龄阶段可能会带来结果的不一致。因此, 将来的研究应该对被试的年龄加以严格限制, 针对特定的年龄阶段进行元分析, 并可比较不同年龄段之间的异同。其二, 由于相关研究的数量较少, 难以达到ALE元分析对实验对比的基本要求(Eickhoff et al., 2017; Eickhoff et al., 2009), 因而未针对具体的情绪类型(如愤怒、恐惧、厌恶等)进行分析。今后的元分析应该在有足够数据的情况下对每种情绪类型的神经机制进行探究, 并分析同一种情绪类型在不同情绪载体之间神经活动的异同。

5 结论

综上所述, 我们的研究结果验证和拓展了三种情绪载体的现有神经模型, 探明了三者之间神经机制的异同。三项单一元分析显示, 动态面孔表情的大脑活动包括广泛的额叶、枕叶、颞叶和部分顶叶皮层以及海马、小脑、丘脑、杏仁核等皮层下区域; 动态身体的激活集中于颞/枕叶相关脑区以及小脑和海马; 声音情绪则引起了颞叶、额叶、杏仁核和脑岛的激活。联合分析表明三种情绪载体跨模态激活了左侧颞中回和右侧颞上回。对比分析结果证明了视觉刺激比听觉刺激更占优势, 尤其以动态面孔表情最为突出, 同时动态身体表情也发挥着重要作用, 但声音情绪有其独特性。未来的研究应进一步验证和延伸这些发现; 探究不同年龄阶段情绪加工的神经机制及其异同; 对具体情绪类型的脑机制及同一种情绪在不同载体之间神经活动的相似性与差异性进行研究; 并探讨不同脑区之间的连接以及同一脑区的不同功能; 同时要注意重点关注动态身体表情的神经基础。

注: *表示该文献被用于元分析, 剩余的元分析文献详见网络版附录。

曹林敬. (2018).(硕士学位论文). 天津大学.

彭聃龄. (主编). (2019).. 北京师范大学出版社.

张帆. (2018).(硕士学位论文). 西南大学, 重庆.

张琪, 尹天子, 冉光明. (2015). 动态面孔表情优势效应的心理机制及神经基础.(9), 1514–1522.

周临舒, 赵怀阳, 蒋存梅. (2017). 音乐表演训练对神经可塑性的影响:元分析研究.(11), 1877–1887.

Alaerts, K., Woolley, D. G., Steyaert, J., Di Martino, A., Swinnen, S. P., & Wenderoth, N. (2013). Underconnectivity of the superior temporal sulcus predicts emotion recognition deficits in autism.(10), 1589–1600.

*Alba-Ferrara, L., Hausmann, M., Mitchell, R. L., & Weis, S. (2011). The neural correlates of emotional prosody comprehension: Disentangling simple from complex emotion.(12), e28701. https://doi.org/10.1371/journal.pone.0028701

*Arsalidou, M., Morris, D., & Taylor, M. J. (2011). Converging evidence for the advantage of dynamic facial expressions.(2), 149–163.

Arsalidou, M., Vijayarajah, S., & Sharaev, M. (2020). Basal ganglia lateralization in different types of reward.(6), 2618–2646.

Atkinson, A. P., Tunstall, M. L. & Dittrich, W. H. (2007). Evidence for distinct contributions of form and motion information to the recognition of emotions from body gestures.(1), 59–72.

Atkinson, A. P., Vuong, Q. C., & Smithson, H. E. (2012). Modulation of the face- and body-selective visual regions by the motion and emotion of point-light face and body stimuli.(2), 1700–1712.

*Aubé, W., Angulo-Perkins, A., Peretz, I., Concha, L., & Armony, J. L. (2015). Fear across the senses: Brain responses to music, vocalizations and facial expressions.(3), 399–407.

Belin, P., Fecteau, S., & Bédard, C. (2004). Thinking the voice: Neural correlates of voice perception.(3), 129–135.

Bestelmeyer, P. E. G., Maurage, P., Rouger, J., Latinus, M., & Belin, P. (2014). Adaptation to vocal expressions reveals multistep perception of auditory emotion.(24), 8098–8105.

Binder, J. R., Frost, J. A., Hammeke, T. A., Cox, R. W., Rao, S. M., & Prieto, T. (1997). Human brain language areas identified by functional magnetic resonance imaging.(1), 353–362.

*Brattico, E., Alluri, V., Bogert, B., Jacobsen, T., Vartiainen, N., Nieminen, S., & Tervaniemi, M. (2011). A functional MRI study of happy and sad emotions in music with and without lyrics., 308. https:// doi.org/10.3389/fpsyg.2011.00308

Bukowski, H., & Lamm, C. (2018). Superior temporal sulcus. In V. Zeigler-Hill & T. K. Shackelford (Eds.),(pp. 1–5). Springer International Publishing.

Calvert, G. A., Brammer, M. J., & Iversen, S. D. (1998). Crossmodal identification.(7), 247–253.

*Ceravolo, L. (2013).(Unpublished doctorial dissertation). Université de Genève.

Christoff, K., & Gabrieli, J. D. E. (2000). The frontopolar cortex and human cognition: Evidence for a rostrocaudal hierarchical organization within the human prefrontal cortex.(2), 168–186.

de Gelder, B. (2006). Towards the neurobiology of emotional body language., 242–249.

de Gelder, B. (2009). Why bodies? Twelve reasons for including bodily expressions in affective neuroscience.(1535), 3475‒3484.

de Gelder, B. (2015).. Oxford University Press.

de Gelder, B., de Borst, A. W., & Watson, R. (2014). The perception of emotion in body expressions.(2), 149–158.

de Gelder, B., Meeren, H. K., Righart, R., van den Stock, J., van de Riet, W. A., & Tamietto, M. (2006). Beyond the face: Exploring rapid influences of context on face processing., 37–48.

de Gelder, B., & Partan, S. (2009). The neural basis of perceiving emotional bodily expressions in monkeys.(7), 642–646.

Downing, P. E., Jiang, Y., Shuman, M., & Kanwisher, N. (2001). A cortical area selective for visual processing of the human body.(5539), 2470–2473.

Dricu, M., & Frühholz, S. (2016). Perceiving emotional expressions in others: Activation likelihood estimation meta-analyses of explicit evaluation, passive perception and incidental perception of emotions., 810–828.

Eickhoff, S. B., Laird, A. R., Fox, P. M., Lancaster, J. L., & Fox, P. T. (2017). Implementation errors in the GingerALE software: Description and recommendations.(1), 7–11.

Eickhoff, S. B., Laird, A. R., Grefkes, C., Wang, L. E., Zilles, K., & Fox, P. T. (2009). Coordinate-based activation likelihood estimation metaanalysis of neuroimaging data: A random- effects approach based on empirical estimates of spatial uncertainty.(9), 2907–2926.

*Fecteau, S., Belin, P., Joanette, Y., & Armony, J. L. (2007). Amygdala responses to nonlinguistic emotional vocalizations.(2), 480–487.

*Foley, E., Rippon, G., Thai, N. J., Longe, O., & Senior, C. (2012). Dynamic facial expressions evoke distinct activation in the face perception network: A connectivity analysis study.(2), 507–520.

Friederici, A. D., & Alter, K. (2004). Lateralization of auditory language functions: A dynamic dual pathway model.(2), 267–276.

Frühholz, S., & Grandjean, D. (2013). Multiple subregions in superior temporal cortex are differentially sensitive to vocal expressions: A quantitative meta-analysis.(1), 24–35.

Frühholz, S., Trost, W., & Kotz, S. A. (2016). The sound of emotions-towards a unifying neural network perspective of affective sound processing., 96–110.

Giese, M. A., & Poggio, T. (2003). Neural mechanisms for the recognition of biological movements.(3), 179–192.

Goldberg, H., Christensen, A., Flash, T., Giese, M. A. & Malach, R. (2015). Brain activity correlates with emotional perception induced by dynamic avatars., 306–317.

*Grèzes, J., Pichon, S., & de Gelder, B. (2007). Perceiving fear in dynamic body expressions.(2), 959–967.

Hasan, B. A. S., Valdes-Sosa, M., Gross, J., & Belin, P. (2016). “Hearing faces and seeing voices”: Amodal coding of person identity in the human brain.(1), 1–8.

Haxby, J. V., Hoffman, E. A., & Gobbini, M. I. (2000). The distributed human neural system for face perception.(6), 223–233.

Heberlein, A. S., & Atkinson, A. P. (2009). Neuroscientific evidence for simulation and shared substrates in emotion recognition: Beyond faces.(2), 162–177.

Hickok, G., & Poeppel, D. (2007). The cortical organization of speech processing.(5), 393–402.

Hodzic, A., Kaas, A., Muckli, L., Stirn, A., & Singer, W. (2009). Distinct cortical networks for the detection and identification of human body.(4), 1264–1271.

Iacoboni, M., Woods, R. P., Brass, M., Bekkering, H., Mazziotta, J. C., & Rizzolatti, G. (1999). Cortical mechanisms of human imitation.(5449), 2526–2528.

*Jastorff, J., Huang, Y. A., Giese, M. A., & Vandenbulcke, M. (2015). Common neural correlates of emotion perception in humans.(10), 4184–4201.

*Kilts, C. D., Egan, G., Gideon, D. A., Ely, T. D., & Hoffman, J. M. (2003). Dissociable neural pathways are involved in the recognition of emotion in static and dynamic facial expressions.(1), 156–168.

Klapper, A., Dotsch, R., van Rooij, I., & Wigboldus, D. H. J. (2016). Do we spontaneously form stable trustworthiness impressions from facial appearance?(5), 655–664.

Krauss, R. M., Freyberg, R., & Morsella, E. (2002). Inferring speakers’ physical attributes from their voices.(6), 618–625.

Kret, M. E., Pichon, S., Grèzes, J., & de Gelder, B. (2011). Similarities and differences in perceiving threat from dynamic faces and bodies. An fMRI study.(2), 1755–1762.

Kriegstein, K. V., & Giraud, A. L. (2004). Distinct functional substrates along the right superior temporal sulcus for the processing of voices.(2), 948–955.

*Leitman, D. I., Wolf, D. H., Ragland, J. D., Laukka, P., Loughead, J., Valdez, J. N., … Gur, R. C. (2010). “It’s not what you say, but how you say it”: A reciprocal temporo-frontal network for affective prosody., 19. https://doi.org/10.3389/ fnhum.2010.00019

Lin, H., Müller-Bardorff, M., Gathmann, B., Brieke, J., Mothes-Lasch, M., Bruchmann, M., … Straube, T. (2020). Stimulus arousal drives amygdalar responses to emotional expressions across sensory modalities.(1), 1898.

Magnée, M. J., Stekelenburg, J. J., Kemner, C., & de Gelder, B. (2007). Similar facial electromyographic responses to faces, voices, and body expressions.(4), 369–372.

Maguinness, C., Roswandowitz, C., & von Kriegstein, K. (2018). Understanding the mechanisms of familiar voiceidentity recognition in the human brain., 179–193.

Mier, D., Eisenacher, S., Rausch, F., Englisch, S., Gerchen, M. F., Zamoscik, V., … Kirsch, P. (2016). Aberrant activity and connectivity of the posterior superior temporal sulcus during social cognition in schizophrenia.(7), 597–610.

*Mitterschiffthaler, M. T., Fu, C. H. Y., Dalton, J. A., Andrew, C. M., & Williams, S. C. R. (2007). A functional MRI study of happy and sad affective states induced by classical music.(11), 1150–1162.

Moro, V., Urgesi, C., Pernigo, S., Lanteri, P., Pazzaglia, M., & Aglioti, S. M. (2008). The neural basis of body form and body action agnosia.(2), 235–246.

Morrison, I. (2016). ALE meta-analysis reveals dissociable networks for affective and discriminative aspects of touch.(4), 1308–1320.

*Numminen-Kontti, T. (2014).-(Unpublished master’s thesis). University of Helsinki.

Olson, I. R., Plotzker, A., & Ezzyat, Y. (2007). The enigmatictemporal pole: A review of findings on social and emotional processing.(7), 1718–1731.

*Peelen, M. V., Atkinson, A. P., & Vuilleumier, P. (2010). Supramodal representations of perceived emotions in the human brain.(30), 10127–10134.

Pelphrey, K. A., Morris, J. P., Michelich, C. R., Allison, T., & McCarthy, G. (2005). Functional anatomy of biological motion perception in posterior temporal cortex: An fMRI study of eye, mouth and hand movements.(12), 1866–1876.

Pisanski, K., Cartei, V., Mcgettigan, C., Raine, J., & Reby, D. (2016). Voice modulation: A window into the origins of human vocal control?, 304–318.

*Poyo Solanas, M., Vaessen, M., & de Gelder, B. (2020). Computation-based feature representation of body expressions in the human brain.(12), 6376–6390.

Ran, G., & Zhang, Q. (2018). The neural correlates of attachment style during emotional processing: An activation likelihood estimation meta-analysis.(6), 626–633.

*Regenbogen, C., Schneider, D. A., Gur, R. E., Schneider, F., Habel, U., & Kellermann, T. (2012). Multimodal human communication-targeting facial expressions, speech content and prosody.(4), 2346–2356.

Ritchie, K. L., Palermo, R., & Rhodes, G. (2017). Forming impressions of facial attractiveness is mandatory.(1), 1–8.

Rizzolatti, G., & Craighero, L. (2004). The mirror-neuron system.(1), 169–192.

Roswandowitz, C., Schelinski, S., & von Kriegstein, K. (2017). Developmental phonagnosia: Linking neural mechanisms with the behavioural phenotype., 97–112.

Sarkheil, P., Goebel, R., Schneider, F., & Mathiak, K. (2013). Emotion unfolded by motion: A role for parietal lobe in decoding dynamic facial expressions.(8), 950–957.

*Sato, W., Kochiyama, T., & Yoshikawa, S. (2010). Amygdala activity in response to forward versus backward dynamic facial expressions., 92–99.

*Sato, W., Toichi, M., Uono, S., & Kochiyama, T. (2012). Impaired social brain network for processing dynamic facial expressions in autism spectrum disorders.(1), 1–17.

Scherer, K. R. (1995). Expression of emotion in voice and music.(3), 235–248.

Scherer, K. R., Johnstone, T., & Klasmeyer, G. (2003). Vocal expression of emotion. In R. J. Davidson, H. H. Goldsmith & K. Scherer (Eds.),(pp. 433–456). Oxford University Press.

Schirmer, A. (2018). Is the voice an auditory face? An ALE meta-analysis comparing vocal and facial emotion processing.(1), 1–13.

Schirmer, A., & Kotz, S. A. (2006). Beyond the right hemisphere: Brain mechanisms mediating vocal emotional processing.(1), 24–30.

Schwarzlose, R. F., Baker, C. I., & Kanwisher, N. (2005). Separate face and body selectivity on the fusiform gyrus.(47), 11055–11059.

Sereno, M. I., Diedrichsen, J., Tachrount, M., Testa-Silva, G., d'Arceuil, H., & Zeeuw, C. D. (2020). The human cerebellum has almost 80% of the surface area of the neocortex.(32), 19538–19543.

Sinke, C. B., Kret, M. E., & de Gelder, B. (2012). Body language: Embodied perception of emotion. In: Berglund, B., Rossi, G. B., Townsend, J. T., & Pendrill, L. R. (Eds.),(pp. 335–352). Psychology Press/Taylor & Francis.

Sokolov, A. A., Gharabaghi, A., Tatagiba, M. S., & Pavlova, M. (2010). Cerebellar engagement in an action observation network.(2), 486–491.

Sperduti, M., Delaveau, P., Fossati, P., & Nadel, J. (2011). Different brain structures related to self- and external- agency attribution: A brief review and meta-analysis.(2), 151–157.

Spreng, R. N., & Grady, C. L. (2010). Patterns of brain activity supporting autobiographical memory, prospection, and theory of mind, and their relationship to the default mode network.(6), 1112–1123.

Stevenson, R. A., & James, T. W. (2009). Audiovisual integration in human superior temporal sulcus: Inverse effectiveness and the neural processing of speech and object recognition.(3), 1210–1223.

Stoodley, C. J., & Schmahmann, J. D. (2010). Evidence for topographic organization in the cerebellum of motor control versus cognitive and affective processing.(7), 831–844.

Tamietto, M., Cauda, F., Celeghin, A., Diano, M., Costa, T., Cossa, F. M., … de Gelder, B. (2015). Once you feel it, you see it: Insula and sensory-motor contribution to visual awareness for fearful bodies in parietal neglect., 56–72.

*Trautmann, S. A., Fehr, T., & Herrmann, M. (2009). Emotions in motion: Dynamic compared to static facial expressions of disgust and happiness reveal more widespread emotion- specific activations., 100‒115.

Turkeltaub, P. E., Eickhoff, S. B., Laird, A. R., Fox, M., Wiener, M., & Fox, P. (2012). Minimizing within-experiment and within-group effects in activation likelihood estimation meta-analyses.(1), 1–13.

van de Riet, W. A. C., Grezes, J., & de Gelder, B. (2009). Specific and common brain regions involved in the perception of faces and bodies and the representation of their emotional expressions.(2), 101–120.

Waters, K., & Terzopoulos, D. (1990, January). A physical model of facial tissue and muscle articulation. In(pp. 77–78). IEEE Computer Society.

Watson, R., Latinus, M., Charest, I., Crabbe, F., & Belin, P. (2014). People-selectivity, audiovisual integration and heteromodality in the superior temporal sulcus., 125–136.

*Wicker, B., Keysers, C., Plailly, J., Royet, J.-P., Gallese, V., & Rizzolatti, G. (2003). Both of us disgusted in my insula: The common neural basis of seeing and feeling disgust.(3), 655–664.

Witteman, J., van Heuven, V. J. P., & Schiller, N. O. (2012). Hearing feelings: A quantitative meta-analysis on the neuroimaging literature of emotional prosody perception.(12), 2752–2763.

Xu, J., Lyu, H., Li, T., Xu, Z., Fu, X., Jia, F., … Hu, Q. (2019). Delineating functional segregations of the human middle temporal gyrus with resting-state functional connectivity and coactivation patterns.(18), 1–13.

Yalpe, Z., & Arsalidou, M. (2018). N-back working memory task: Meta-analysis of normative fMRI studies with children.(6), 2010–2022.

Yang, D. Y.-J., Rosenblau, G., Keifer, C., & Pelphrey, K. A. (2015). An integrative neural model of social perception, action observation, and theory of mind., 263–275.

Yarkoni, T. (2009). Big correlations in little studies: Inflated fMRI correlations reflect low statistical power – Commentary on Vul et al., (2009).(3), 294–298.

Yarkoni, T., Poldrack, R. A., Nichols, T. E., van Essen, D. C., & Wager, T. D. (2011). Large-scale automated synthesis of human functional neuroimaging data.(8), 665–670.

Zieber, N., Kangas. A., Hock, A., & Bhatt, R. S. (2014). Infants’s perception of emotion from body movements.(2), 675–684.

Zinchenko, O., Yaple, Z. A., & Arsalidou, M. (2018). Brain responses to dynamic facial expressions: A normative meta-analysis., 227. https://doi.org/10.3389/fnhum.2018.00227

Zuberer, A., Schwarz, L., Kreifelts, B., Wildgruber, D., Erb, M., Fallgatter, A., … Ethofer, T. (2020). Neural basis of impaired emotion recognition in adult attention deficit hyperactivity disorder.. https://doi.org/10.1016/ j.bpsc.2020.11.013

杜经纶. (2007).(硕士学位论文). 南京医科大学.

杜经纶, 姚志剑, 谢世平, 史家波, 滕皋军. (2007). 动态表情情绪识别相关脑区的fMRI研究.(08), 558‒562.

王鹏飞. (2012).(硕士学位论文). 南京师范大学.

姚志剑, 杜经纶, 谢世平, 滕皋军, 刘文, 曹燕翔, … 王丽. (2007). 动态面部表情情绪不明确识别的fMRI研究.(8), 685‒687.

Bach, D. R., Grandjean, D., Sander, D., Herdener, M., Strik, W. K., & Seifritz, E. (2008). The effect of appraisal level on processing of emotional prosody in meaningless speech.(2), 919–927.

Beaucousin, V., Lacheret, A., Turbelin, M. R., Morel, M., Mazoyer, B., & Tzourio‒Mazoyer, N. (2007). FMRI study of emotional speech comprehension.(2), 339–352.

Brück, C., Kreifelts, B., Kaza, E., Lotze, M., & Wildgruber, D. (2011). Impact of personality on the cerebral processing of emotional prosody.(1), 259–268.

Buchanan, T. W., Lutz, K., Mirzazade, S., Specht, K., Shah, N. J., Zilles, K., & Jäncke, L. (2000). Recognition of emotional prosody and verbal components of spoken language: An fMRI study.(3), 227–238.

Castelluccio, B. C. (2014).(Unpublished master’s thesis). University of Connecticut, Mansfield.

Castelluccio, B. C., Myers, E. B., Schuh, J. M., & Eigsti, I. M. (2015). Neural substrates of processing anger in language: Contributions of prosody and semantics.(6), 1359–1367.

Ceravolo, L., Frühholz, S., & Grandjean, D. (2016). Proximal vocal threat recruits the right voice–sensitive auditory cortex.(5), 793–802.

Dietrich, S., Hertrich, I., Alter, K., Ischebeck, A., & Ackermann, H. (2008). Understanding the emotional expression of verbal interjections: A functional MRI study.(18), 1751–1755.

Eigsti, I.–M., Schuh, J., Mencl, E., Schultz, R. T., & Paul, R. (2012). The neural underpinnings of prosody in autism.(6), 600–617.

Engelen, T., Zhan, M., Sack, A. T., & de Gelder, B. (2018). Dynamic interactions between emotion perception and action preparation for reacting to social threat: A combined cTBS–fMRI study.(3). https://doi.org/10.1523/ ENEURO.0408–17.2018

Ethofer, T., Bretscher, J., Gschwind, M., Kreifelts, B., Wildgruber, D., & Vuilleumier, P. (2011). Emotional voice areas: Anatomic location, functional properties, and structural connections revealed by combined fMRI/DTI.(1), 191–200.

Ethofer, T., Kreifelts, B., Wiethoff, S., Wolf, J., Grodd, W., Vuilleumier, P., & Wildgruber, D. (2009). Differential influences of emotion, task, and novelty on brain regions underlying the processing of speech melody.(7), 1255–1268.

Ethofer, T., Wiethoff, S., Anders, S., Kreifelts, B., Grodd, W., & Wildgruber, D. (2007). The voices of seduction: Cross–gender effects in processing of erotic prosody.(4), 334–337.

Fecteau, S., Armony, J. L., Joanette, Y., & Belin, P. (2005). Sensitivity to voice in human prefrontal cortex.(3), 2251–2254.

Frühholz, S., Ceravolo, L., & Grandjean, D. (2011). Specific brain networks during explicit and implicit decoding of emotional prosody.(5), 1107–1117.

Frühholz, S., Klaas, H. S., Patel, S., & Grandjean, D. (2014). Talking in fury: The cortico–subcortical network underlying angry vocalizations.(9), 2752–2762.

Gandour, J., Wong, D., Dzemidzic, M., Lowe, M., Tong, Y., & Li, X. (2003). A cross–linguistic fMRI study of perception of intonation and emotion in Chinese.(3), 149–157.

Goerlich–Dobre, K. S., Witteman, J., Schiller, N. O., van Heuven, V. J. P., Aleman, A., & Martens, S. (2014). Blunted feelings: Alexithymia is associated with a diminished neural response to speech prosody.(8), 1108–1117.

Grandjean, D., Sander, D., Pourtois, G., Schwartz, S., Seghier, M. L., Scherer, K. R., & Vuilleumier, P. (2005). The voices of wrath: Brain responses to angry prosody in meaningless speech.(2), 145–146.

Hennenlotter, A., Schroeder, U., Erhard, P., Castrop, F., Haslinger, B., Stoecker, D., … Ceballos–Baumann, A. O. (2005). A common neural basis for receptive and expressive communication of pleasant facial affect.(2), 581–591.

Hurlemann, R., Rehme, A. K., Diessel, M., Kukolja, J., Maier, W., Walter, H., & Cohen, M. X. (2008). Segregating intra–amygdalar responses to dynamic facial emotion with cytoarchitectonic maximum probability maps.(1), 13–20.

Jessen, S. (2012).(Unpublished doctorial dissertation). Max Planck Institute for Human Cognitive and Brain Sciences, Leipzig.

Jessen, S., & Kotz, S. A. (2015). Affect differentially modulates brain activation in uni– and multisensory body–voice perception., 134–143.

Johnston, P., Mayes, A., Hughes, M., & Young, A. W. (2013). Brain networks subserving the evaluation of static and dynamic facial expressions.(9), 2462–2472.

Johnstone, T., van Reekum, C. M., Oakes, T. R., & Davidson, R. J. (2006). The voice of emotion: An fMRI study of neural responses to angry and happy vocal expressions.(3), 242–249.

Kang, J. I., Kim, J. J., Seok, J. H., Chun, J. W., Lee, S. K., & Park, H. J. (2009). Abnormal brain response during the auditory emotional processing in schizophrenic patients with chronic auditory hallucinations.(1), 83–91.

Kanske, P., & Kotz, S. A. (2010). Emotion speeds up conflict resolution: A new role for the ventral anterior cingulate cortex?(4), 911–919.

Kessler, H., Doyen–Waldecker, C., Hofer, C., Hoffmann, H., & Abler, B. (2011). Neural correlates of the perception of dynamic versus static facial expressions of emotion..https://doi.org/10.3205/psm000072

Koelsch, S., Skouras, S., Fritz, T., Herrera, P., Bonhage, C., Küssner, M. B., & Jacobs, A. M. (2013). The roles of superficial amygdala and auditory cortex in music–evoked fear and joy., 49–60.

Korb, S., Frühholz, S., & Grandjean, D. (2015). Reappraising the voices of wrath., 1644–1660.

Kotz, S. A., Dengler, R., & Wittfoth, M. (2015). Valence–specific conflict moderation in the dorso–medial PFC and the caudate head in emotional speech.(2), 165–171.

Kotz, S. A., Meyer, M., Alter, K., Besson, M., von Cramon, D. Y., & Friederici, A. D. (2003). On the lateralization of emotional prosody: An event–related functional MR investigation.(3), 366–376.

Krautheim, J. T., Dannlowski, U., Steines, M., Neziroglu, G., Acosta, H., Sommer, J., … Kircher, T. (2019). Intergroup empathy: Enhanced neural resonance for ingroup facial emotion in a shared neural production–perception network., 182–190.

Krautheim, J. T., Straube, M., Dannlowski, U., Neziroglu, G., Acosta, H., Sommer, J., … Kircher, T. (2020). Emotion specific neural activation for the production and perception of facial expressions., 17–28.

Krautheim, J. T., Straube, B., Dannlowski, U., Pyka, M., Schneider–Hassloff, H., Drexler, R., … Kircher, T. (2018). Outgroup emotion processing in the vACC is modulated by childhood trauma and CACNA1C risk variant., 341–348.

Labar, K. S., Crupain, M. J., Voyvodic, J. T., & Gregory, M. C. (2003). Dynamic perception of facial affect and identity in the human brain.(10), 1023–1033.

Liang, Y., Liu, B., Ji, J., & Li, X. (2019). Network representations of facial and bodily expressions: Evidence from multivariate connectivity pattern classification., 1111. https://doi.org/10.3389/ fnins.2019.01111

Liu, P. P. (2018).(Unpublished doctorial dissertation). University of Glasgow.

Mitchell, R. L. C., Elliott, R., Barry, M., Cruttenden, A., & Woodruff, P. W. R. (2003). The neural response to emotional prosody, as revealed by functional magnetic resonance imaging.(10), 1410–1421.

Morris, J., Scott, S., & Dolan, R. (1999). Saying it with feeling: Neural responses to emotional vocalizations.(10), 1155–1163.

Park, M., Gutyrchik, E., Welker, L., Carl, P., Poppel, E., Zaytseva, Y., … Bao, Y. (2015). Sadness is unique: Neural processing of emotions in speech prosody in musicians and non–musicians.. https://doi.org/10.3389/fnhum.2014.01049

Peelen, M. V., Atkinson, A. P., Andersson, F., & Vuilleumier, P. (2007). Emotional modulation of body–selective visual areas.(4), 274–283.

Pelphrey, K. A., Morris, J. P., McCarthy, G., & LaBar, K. S. (2007). Perception of dynamic changes in facial affect and identity in autism.(2), 140–149.

Péron, J., Frühholz, S., Ceravolo, L., & Grandjean, D. (2015). Structural and functional connectivity of the subthalamic nucleus during vocal emotion decoding.(2), 349–356.

Pentón, L. G., Fernández, A. P., León, M. A., Ymas, Y. A., García, L. G., Iturria–Medina, Y., … Valdés–Sosa, M. (2010). Neural activation while perceiving biological motion in dynamic facial expressions and point–light body action animations.(14), 1076–1083.

Phillips, M. L., Young, A. W., Scott, S. K., Calder, A. J., Andrew, C., Giampietro, V., … Gray, J. A. (1998). Neural responses to facial and vocal expressions of fear and disgust.(1408), 1809–1817.

Pichon, S., de Gelder, B., & Grezes, J. (2008). Emotional modulation of visual and motor areas by dynamic body expressions of anger.(3–4), 199–212.

Pichon, S., de Gelder, B., & Grèzes, J. (2009). Two different faces of threat. Comparing the neural systems for recognizing fear and anger in dynamic body expressions.(4), 1873–1883.

Pichon, S., de Gelder, B., & Grezes, J. (2012). Threat prompts defensive brain responses independently of attentional control.(2), 274–285.

Prochnow, D., Höing, B., Kleiser, R., Lindenberg, R., Wittsack, H. J., Schäfer, R., … Seitz,R. J. (2013). The neural correlates of affect reading: An fMRI study on faces and gestures., 270–277.

Rahko, J., Paakki, J. J., Starck, T., Nikkinen, J., Remes, J., Hurtig, T., … Kiviniemi, V. (2010). Functional mapping of dynamic happy and fearful facial expression processing in adolescents.(2), 164–176.

Rosenblau, G., Kliemann, D., Dziobek, I., & Heekeren, H. R. (2016). Emotional prosody processing in autism spectrum disorder.(2), 224–239.

Ross, P., de Gelder, B., Crabbe, F., & Grosbras, M. H. (2019). Emotion modulation of the body–selective areas in the developing brain., 100660. https://doi.org/10.1016/j.dcn.2019.100660

Rymarczyk, K., Żurawski, Ł., Jankowiak–Siuda, K., & Szatkowska, I. (2018). Neural correlates of facial mimicry: Simultaneous measurements of EMG and BOLD responses during perception of dynamic compared to static facial expressions., 52. https://doi.org/ 10.3389/fpsyg.2018.00052

Rymarczyk, K., Żurawski, Ł., Jankowiak–Siuda, K., & Szatkowska, I. (2019). Empathy in facial mimicry of fear and disgust: Simultaneous EMG–fMRI recordings during observation of static and dynamic facial expressions., 701. https://doi.org/10.3389/ fpsyg.2019.00701

Salimpoor, V. N., Benovoy, M., Larcher, K., Dagher, A., & Zatorre, R. J. (2011). Anatomically distinct dopamine release during anticipation and experience of peak emotion to music.(2), 257–262.

Sander, D., Grandjean, D., Pourtois, G., Schwartz, S., Seghier, M. L., Scherer, K. R., & Vuilleumier, P. (2005). Emotion and attention interactions in social cognition: Brain regions involved in processing anger prosody.(4), 848–858.

Sato, W., Kochiyama, T., Uono, S., Sawada, R., & Toichi, M. (2019). Widespread and lateralized social brain activity for processing dynamic facial expressions.(13), 3753–3768.

Sato, W., Kochiyama, T., Uono, S., Yoshikawa, S., & Toichi, M. (2016). Direction of amygdala–neocortex interaction during dynamic facial expression processing.(3), 1878–1890.

Sato, W., Kochiyama, T., Yoshikawa, S., Naito, E., & Matsumura, M. (2004). Enhanced neural activity in response to dynamic facial expressions of emotion: An fMRI study.(1), 81–91.

Schultz, J., Brockhaus, M., Bülthoff Heinrich H., & Pilz, K. S. (2013). What the human brain likes about facial motion.(5), 1167–1178.

Schultz, J., & Pilz, K. S. (2009). Natural facial motion enhances cortical responses to faces.(3), 465–475.

Seydell–Greenwald, A., Chambers, C. E., Ferrara, K., & Newport, E. L. (2020). What you say versus how you say it: Comparing sentence comprehension and emotional prosody processing using fMRI., 116509. https://doi.org/10.1016/j.neuroimage.2019.116509

Skiba, R. M., & Patrik, V. (2019). Brain networks processing temporal information in dynamic facial expressions.(11), 6021–6038.

Smith, K. W., Laura–Lee, B., Oshin, V., & Vinod, G. (2015). Syllogisms delivered in an angry voice lead to improved performance and engagement of a different neural system compared to neutral voice., 273. https://doi.org/10.3389/fnhum.2015.00273

van der Gaag, C., Minderaa, R. B., & Keysers, C. (2007). Facial expressions: What the mirror neuron system can and cannot tell us.(3–4), 179–222.

van de Vliet, L., Jastorff, J., Huang, Y. A., van Paesschen, W., Vandenbulcke, M., & van den Stock, J. (2018). Anterior temporal lobectomy impairs neural classification of body emotions in right superior temporal sulcus and reduces emotional enhancement in distributed brain areas without affecting behavioral classification.(43), 9263–9274.

Wildgruber, D., Pihan, H., Ackermann, H., Erb, M., & Grodd, W. (2002). Dynamic brain activation during processing of emotional intonation: Influence of acoustic parameters, emotional valence, and sex.(4), 856–869.

Wildgruber, D., Riecker, A., Hertrich, I., Erb, M., Grodd, W., Ethofer, T., & Ackermann, H. (2005). Identification of emotional intonation evaluated by fMRI.(4), 1233–1241.

Willinger, D., Karipidis, I. I., Beltrani, S., Pietro, S. V. D., & Brem, S. (2019). Valence–dependent coupling of prefrontal– amygdala effective connectivity during facial affect processing.(4). https://doi.org/10.1523/ENEURO. 0079–19.2019

Witteman, J. (2014).Lden University.

Wittfoth, M., Schroder, C., Schardt, D. M., Dengler, R., Heinze, H. J., & Kotz, S. A. (2009). On emotional conflict: Interference resolution of happy and angry prosody reveals valence–specific effects.(2), 383–392.

The neural activities of different emotion carriers and their similarities and differences: A meta-analysis of functional neuroimaging studies

LIU Juncai1, RAN Guangming1, ZHANG Qi2

(1Department of Psychology, School of Education, China West Normal University, Nanchong 637002, China)(2College of Preschool and Primary Education, China West Normal University, Nanchong637002, China)

Emotion recognition has always been a hot topic in psychology. Although some studies have explored the brain mechanisms of dynamic facial expressions, dynamic bodily expressions and emotional voices, the overall understanding of each emotion carrier is relatively incomplete, and the commonalities and differences of neural mechanisms among different emotion carriers were still poorly known. First, this study used three separated meta‒analyses to identify the brain regions activated by each emotion pattern, and then, conjunction and contrast analysis of these activation maps were used to assess common and unique neural activity between the three emotion carriers. The results showed that the brain activity of dynamic facial expressions including extensive frontal, occipital, temporal and partial parietal cortices, as well as subcortical regions, such as hippocampus, cerebellum, thalamus and amygdala. The activation of dynamic bodily expressions was concentrated in temporal/occipital regions, cerebellum and hippocampus. Emotional voices activated the temporal, frontal, amygdala and insula. Conjunction analysis suggested that the left middle temporal gyrus (MTG) and the right superior temporal gyrus (STG) were activated by three emotion carrier across the modalities. The results of the contrast analysis proved that the visual stimuli was more advantaged than the auditory stimuli, especially the dynamic facial expressions, of course the dynamic bodily expressions also played an important role. However, the emotional voices had their own uniqueness. In sum, these findings validate, support, and extend the existing neural models of the three emotion carriers, revealing the central, universal region of the emotional processing, but with each emotion carrier relying on its own reliable specific neural circuits.

emotion carriers, dynamic facial expressions, dynamic bodily expressions, emotional voices, ALE meta-analysis

冉光明, E-mail: haiqi198649@163.com

2021-10-06

* 国家自然科学基金青年项目(31900760)和省级大学生创新创业训练计划项目(S201910638117)资助。