基于特征融合的深度学习点云补全算法

2022-03-09赵毅强周意遥艾西丁

赵毅强,周意遥,胡 彬,艾西丁,陈 瑞

基于特征融合的深度学习点云补全算法

赵毅强,周意遥,胡 彬,艾西丁,陈 瑞

(天津大学微电子学院,天津 300072)

由于激光雷达等三维扫描设备分辨率限制、目标间的相互遮挡以及目标表面材质透明等问题,采集到的三维点云数据往往是不完整的.近年来,以数据驱动为主的深度学习方法逐渐被用于解决点云补全问题,然而,现有的点云补全算法致力于补全出原始目标点云的整体拓扑结构而忽略了对于目标点云局部细节位置的恢复.针对这一问题,提出了一种基于特征融合的深度学习点云补全算法,利用关系感知编码器提取得到的点云邻域分布特性和点云空间特征进行融合并把点云映射为128维的潜在特征向量,接着通过树状解码器将全局特征向量与局部特征向量进行特征融合并分形输出补全的点云预测.在开源数据集ShapeNet和KITTI上的仿真结果显示,提出的点云补全算法在补全精度和可视化效果上相比于现有主流的点云补全算法均有了提升.在相互倒角距离指标上,本文算法在飞机、汽车、椅子和桌子点云模型上分别减少了2.4%、2.5%、8.3%和6.2%;在单向豪斯多夫距离指标上,本文算法在飞机、汽车、椅子和桌子点云模型上分别减少了2.1%、0.4%、0.8%和0.3%.最后,利用镭神智能16线激光雷达实测点云数据进行点云补全实验验证了所提出的点云补全算法的有效性,说明了在ShapeNet数据集中训练的点云补全网络能够很好地适用于激光雷达测量得到的稀疏点云数据.

三维点云;深度学习;补全算法;拓扑结构;特征融合

随着三维扫描设备的不断发展,具有空间坐标信息的点云数据越来越容易获取,并广泛应用到三维建模、自动驾驶及机器人路径规划等领域[1].然而在点云数据采集过程中,由于设备分辨率的限制、物体间的相互遮挡以及物体表面透明材质等问题的影响,采集到的点云数据往往是不完整的,这需要利用设备的移动进行多视角采集并进行点云拼接来还原目标的点云数据,这增加了点云采集的工作量.因此如何利用数量有限的残缺点云数据进行点云补全恢复出原始的点云形貌成为了当前点云处理算法的研究热点,并对点云三维重建以及目标的识别具有重要的研究价值[2].

近年来,以数据驱动为主的深度学习点云补全算法广泛用于点云补全问题.但是与传统的二维图像像素具有规则的排列方式不同,点云数据是一系列稀疏的三维空间点,并且具有排序不变性[3],而传统的卷积神经网络(convolutional neural network,CNN)要求规则的空间排布[4].VoxelNet方法[5]尝试将点云划分为空间体素网格来模拟图像的规则排列形式以将卷积神经网络应用于点云目标探测,然而体素网格的方法会损失点云的细节特征,并且随着体素网格分辨率的提高会显著增加设备的内存消耗.2017年,Qi等[6]提出了一种名为PointNet的网络框架并利用共享全连接层直接对原始的点云数据进行神经网络操作,能够有效提取点云模型的空间关键点并最大化空间特征.Groueix等[7]在2018年提出了AtlasNet网络,以共享全连接层的形式来提取点云的特征并重建出原始的点云模型.同年,Yang等[8]提出了一种共享全连接层与网格变形相结合的FoldingNet网络来用于点云特征的提取.Yuan等[9]也在2018年提出了一种多尺度融合的点云补全网络PCN来补全点云模型并能够有效用于自动驾驶的实测点云数据.2019年斯坦福大学的Lyne等[10]提出了一种基于树状形式的点云补全网络TopNet来恢复出缺失的点云部分,但是随着树层次的增加,网络参数会显著提高.在生成对抗式网络(generate adversarial networks,GAN)[11]被提出以后,其被广泛用于深度学习网络来增强网络的泛化性能.2017年Panos等[12]用实验证明了利用GAN网络生成点云的特征向量会比直接生成点云数据效果更好.基于Panos等的成果,Chen等[13]在2019年利用自编码器与GAN相结合的网络架构进行点云补全,具有较好的泛化性能.

综上所述,现有深度学习均以共享全连接层的方式独立地处理每个采样点,再由最大池化层进行特征提取,这忽视了点云的邻域空间分布特性.同时,仅以全连接层将整个特征向量映射回点云空间的方式忽略了潜在特征空间的某些维度可能学习点云模型的某种特定空间拓扑结构.为了提高深度学习点云补全算法的性能,本文提出了一种基于特征融合的深度学习点云补全算法,此算法分为关系感知编码器和树状解码器两个部分.关系感知编码器将邻域点的空间分布特征与原始的点云空间坐标进行融合,并利用多层特征拼接来将点云映射为潜在特征向量,树状解码器通过潜在特征向量的局部特征与全局特征进行融合来分形输出补全的点云预测.在开源数据集和实测点云数据的补全实验结果表明,本文提出的点云补全算法相比于现有主流的点云补全算法在补全精度和可视化效果上均有了较大提升.

1 基于特征融合的深度学习点云补全算法架构

1.1 算法整体架构

本文提出的基于特征融合的深度学习点云补全算法框架如图1所示.

整个网络架构分为关系感知编码器与树状解码器两个部分,关系感知编码器将输入点云的特征信息映射为潜在特征向量,树状解码器将潜在特征向量进行特征解码并由4个叶子节点分形输出补全点云.图中每个方框上的数字代表张量的维度数,为点云的数量(如×3代表此张量共有两个维度,第1个维度数为,第2个维度数为3).整个网络结构共包含3种神经网络单元,分别为全连接层、共享全连接层和最大池化层.

1.2 关系感知编码器

现有的深度学习点云补全算法研究中,常用编码器独立地提取原始点云中每个采样点的特征信息而忽略了点云邻域的局部空间分布关系,然而这些由点云邻域点构成的局部空间拓扑结构对于点云局部细节的表达至关重要.

图1 基于特征融合的深度学习点云补全框架

1.3 树状解码器

现有的点云补全网络的解码器直接使用全连接层来把整个潜在特征向量进行特征解码以输出补全点云,这忽略了特征向量的不同维度可能会对应不同的局部点云拓扑结构,这对于恢复点云的结构细节至关重要.

为了解决这一问题,本文提出了一种新的树状解码器并采用分形输出的策略来有效融合潜在特征空间的全局特征和局部特征.如图1紫框中的树状解码器所示,树状解码器共含有3层节点,包含1个根节点和4个叶子节点.树状解码器将1×128维的潜在特征向量划分为4个1×32维的张量,接着使用5个1层全连接层来分别处理这4个局部特征向量和全局特征向量,每一个全连接层均使用BN和ReLU操作.再将从全局特征向量提取到的1×256维的张量复制4次并分别与从局部特征向量提取到的特征张量进行特征拼接.接着用4个2层全连接层(256个神经元与1536个神经元)分别处理这4个拼接好的特征张量并使用Tanh激活函数进行非线性激活得到叶子节点的输出.最后将各个叶子节点的输出维度进行调整并将点云片段拼接得到最终维度为×3的补全点云预测.

本文将传统的基于全连接层直接输出整个补全点云的基准方法与树状解码器输出的点云进行了对比.如图2所示,基准方法为使用全连接层将潜在特征向量直接映射回整个补全点云,总维度为2048×3.把2048个采样点分为了4段并使用不同的颜色进行了标记,其中第1~512个采样点为绿色,第513~1024个采样点为蓝色,第1025~1536个采样点为红色,第1537~2048个采样点为黄色.由于基准方法是将全局潜在特征向量进行直接点云映射,可以看到输出的分段补全点云在空间中分布散乱并且覆盖整个点云空间,没有将特定的局部拓扑结构映射到潜在特征向量的特定维度上.而本文算法采用树状解码器将32维度的局部潜在特征与128维度的全局潜在特征进行融合并分形输出补全点云片段,4个叶子节点分别输出512个采样点,对应的颜色分别为绿色、蓝色、红色和黄色.从图2中可以看到,不同颜色的采样点倾向于聚集在特定的局部空间结构,比如椅子的扶手、飞机的机翼和桌子的腿部位置,这说明了树状解码器能够通过无监督学习的方式将局部拓扑结构映射到潜在特征向量的特定维度,更好地表达点云的局部细节特征.

图2 输出点云空间分布

2 开源数据集点云补全结果

2.1 实验设置

本文提出的点云补全算法将与PointNet[6]、FoldingNet[8]、PCN[9]、TopNet[10]和UPCC[13]这5种主流的深度学习补全算法进行对比.其中PointNet[6]为第一个使用共享全连接层处理点云数据的深度学习框架,利用多层全连接层直接将潜在特征向量进行整体点云输出.FoldingNet[8]在共享全连接层提取点云特征的基础上加入了网格变形模块,利用二维网格的折叠组合来输出补全点云.PCN[9]使用多尺度的操作来提升点云补全的性能,首先输出512个采样点进行补全精度计算,再通过网格变形操作输出2048个采样点得到最终的输出补全点云.TopNet[10]采用多个全连接层相结合的方式来聚合多层全局特征并输出补全点云.UPCC[13]采用共享全连接层与GAN网络相结合的方式进行补全点云的输出,通过两阶段训练以提升补全网络的泛化性能.实验设置主要分为数据集、实施细节、损失函数和评价指标4个方面.

2.1.1 数据集

本文利用大型开源数据集ShapeNet[15]和KITTI[16]进行点云补全算法仿真实验.ShapeNet数据集是一个规模较大的三维形状数据集,用于计算机图形学、机器人学和计算机视觉等领域,由斯坦福大学和芝加哥丰田学院于2015年联合发布,共包含55个常见类别的物品种类.KITTI数据集是由德国卡尔斯鲁厄理工学院和美国丰田技术研究院于2013年联合发布,是目前世界上最大的自动驾驶场景下的算法评测数据集,用于立体图像、光流、3D物体检测等领域,每张图像包含最多达15辆车和30个行人,并带有各种程度的目标遮挡和阻断.

2.1.2 实施细节

在仿真实验中,将ShapeNet数据集用于深度学习网络的训练和测试,KITTI数据集由于没有完整的目标点云进行补全精度计算,因此仅用于补全算法的性能测试并进行可视化分析.本文选用飞机、汽车、椅子和桌子4种模型用于仿真实验,其中桌子模型包含8443种形状、汽车模型包含7497种形状、椅子模型包含6778种形状、飞机模型包含4045种形状.所有的点云模型均归一化到-0.5~0.5的范围内,对每一种类别单独训练补全网络,并且将80%的模型用于训练、10%的模型用于验证、10%的模型用于测试.

本文算法使用Pytorch框架进行网络的训练,利用Adam优化器在NVIDIA Geforce 2080 Ti GPU上对每个类别的点云进行300轮的训练,训练批次为32,学习率设置为0.0001,邻域的数量为10,保存在验证集上效果最好的模型参数用于测试.

2.1.3 损失函数

在网络训练过程中,使用相互倒角距离(chamfer distance,CD)[17]作为损失函数,相互倒角距离度量了两个点云模型1和2中相互之间最为接近采样点的平均距离,和分别为点云模型中采样点的三维坐标,倒角距离越小说明网络补全性能越好.倒角距离的计算公式为

2.1.4 评价指标

本文使用相互倒角距离和单向豪斯多夫距离(unidirectional Hausdorff distance,UHD)[13]作为补全精度的评价指标.单向豪斯多夫距离度量了补全点云与原始残缺点云之间的保真度,其计算了残缺点云中各点与补全点云中各点最小距离的最大值,计算公式为

为了更好地说明网络的泛化性能,所有补全网络的输出点云的倒角距离计算仅在测试集上进行.同时,本文对补全的点云预测进行可视化,以观察补全后的点云形状,进行定性分析.

2.2 ShapeNet数据集评估

在ShapeNet数据集上的相互倒角距离和单向豪斯多夫距离统计如表1和表2所示.从表中可以看出,本文提出的补全算法在4个点云模型中均取得了最高的补全精度,在相互倒角距离指标上,本文算法在飞机、汽车、椅子和桌子点云模型上相比于其他主流算法中精度最高的PCN[9]分别减少了2.4%、2.5%、8.3%和6.2%;在单向豪斯多夫距离指标上,本文算法在飞机、汽车、椅子和桌子点云模型上相比于其他主流算法中精度最高的PointNet[6]分别减少了2.1%、0.4%、0.8%和0.3%.可以看出,在具有更多细节结构的桌子和椅子点云模型上本文算法补全性能提升更为明显.

表1 点云补全相互倒角距离

Tab.1 Mutual CD of point cloud completion

表2 点云补全单向豪斯多夫距离

Tab.2 UHD of point cloud completion

4种点云模型补全的可视化结果如图3所示,从补全精度和可视化结果可以看出,PointNet[6]和PCN[9]具有较高的点云补全精度,并且在一定程度上恢复出点云的局部细节.但是由于这两种方法都是利用全连接层对全局潜在特征向量进行整个点云模型的直接输出,所以在局部细节的地方存在着一定的分布不均匀和不平整的情况.FoldingNet[8]通过网格变形操作来形成点云的空间结构,从图3中可以看出,其输出的点云模型存在一定的网格扭曲痕迹,并且对于尖锐的结构难以有效补全,往往以面阵形式形成补全点云的结构,这使得FoldingNet[8]的补全精度不高.TopNet[10]由于采用多个全连接层来分层聚合全局特征,使得网络的参数量大,并且收敛速度慢,会存在一定的补全点云分布散乱的情况.UPCC[13]采用生成对抗式网络的形式进行点云补全,在训练过程中使用鉴别器来判断输入点云是生成器生成的点云还是真实的输入点云,这使得网络能够更广泛地应用于更多不同形状的残缺点云补全处理,但是对于点云的局部细节补全效果有限,补全精度有待提高.与其他点云补全算法相比,本文提出的点云补全算法能够恢复出更多的细节特征(比如桌子和椅子的腿部位置以及机翼位置),点云补全效果相比于其他算法更加合理并且与输入点云更加一致,这说明了本文算法能够提升点云补全网络的性能.

图3 ShapeNet数据集点云补全可视化

2.3 KITTI数据集评估

由于KITTI数据集没有完整的汽车点云数据来计算点云补全的精度,因此对于KITTI数据集中的激光雷达汽车点云数据,仅展示补全可视化结果.本文利用VoxelNet网络[5]对自动驾驶场景点云数据进行了汽车目标提取,将在ShapeNet数据集的汽车点云模型上训练好的补全网络用于预测激光雷达采集得到的汽车点云补全.KITTI数据集上的点云数据更加稀疏并且空间分布呈现各向异性,这与ShapeNet数据集的三维点云模型数据分布存在一定的差异,因此能够很好地验证补全网络的泛化性能.

本文对两种不同汽车朝向的场景点云进行目标提取和点云补全,所有对比算法的补全结果如图4和图5所示,利用VoxelNet目标识别网络提取的车辆点云在绿色三维包围框内,每个场景分别选取2辆汽车进行点云补全.从图中可以看出,FoldingNet[8]、TopNet[10]和UPCC[13]的补全输出结果具有一定的外形缺陷,而本文提出的补全算法与PointNet[6]和PCN[9]相比能够更好地恢复出汽车点云的整体形貌并且补全的点云分布更为均匀,同时补全出的汽车点云与可见光图像中实际的汽车外形最为接近.对KITTI数据集中的自动驾驶扫描车辆点云的补全结果说明了本文算法与现有主流点云补全算法相比提升了点云补全的性能,并且补全结果具有更高的保真度,能够适用于不同朝向的汽车点云补全.

图4 KITTI数据集点云补全可视化(场景1)

图5 KITTI数据集点云补全可视化(场景2)

2.4 消融实验

为了证明本文提出的网络模块能够提升点云补全的精度,在汽车点云模型上对不同网络模块的有无进行了消融实验探究.在关系感知解码器中,有邻域向量模块和多层连接模块;在树状解码器中,有通道连接模块和树状分形输出模块.对于前3种模快,分别将其去除来训练网络以计算补全精度(相互倒角距离);对于树状解码器输出模块,将其替换为基准的全连接层输出模块.消融实验的补全精度如表3所示,从表3中可以看出,去掉补全网络的每一种模块均会使得补全精度降低,当所有模块均存在时,补全网络取得了最高的补全精度,这证明了本文所提出的网络模块在点云补全任务中均有所贡献.

表3 消融实验补全精度

Tab.3 Completion precision of ablation study

3 实测点云补全结果

3.1 实验扫描平台

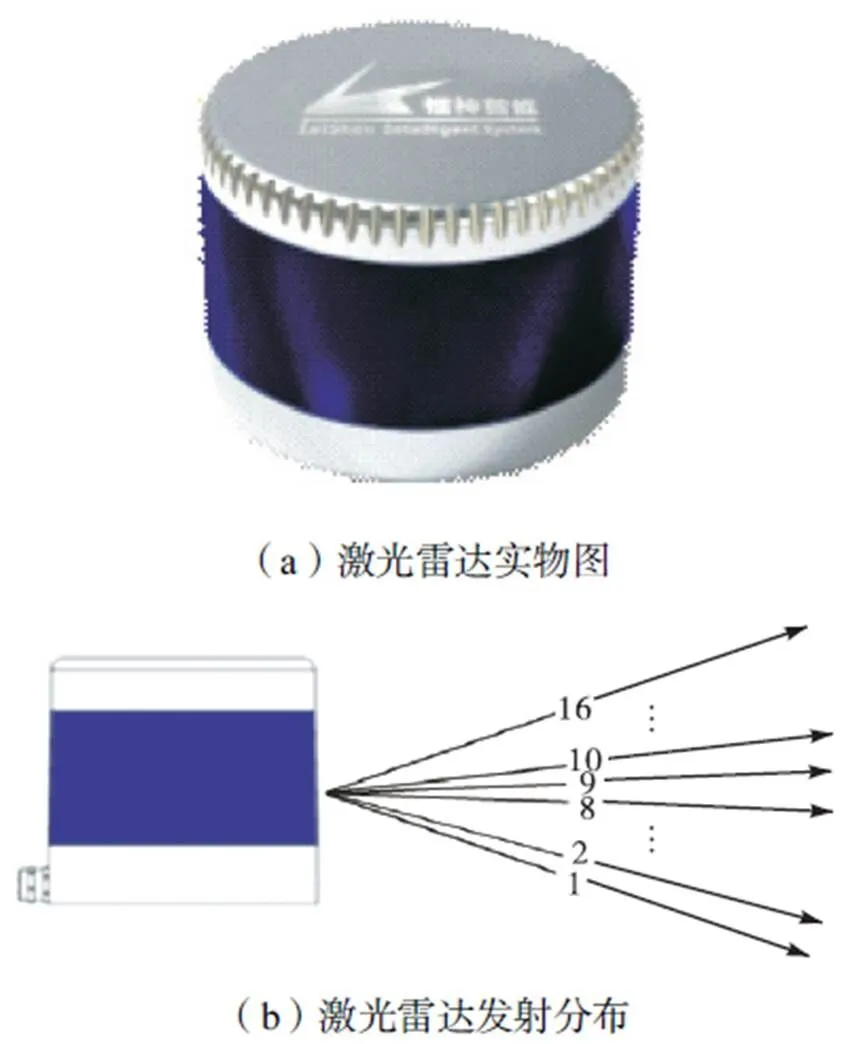

本文采用镭神智能C16系列机械式激光雷达采集实测场景点云数据.图6为所使用的激光雷达,选用的波段为905nm,测距方式为脉冲式测距,雷达外壳内共安装16对固定在轴承上的激光发射与接收装置,通过内部的旋转电机以一定的转速进行360°旋转扫描以得到场景点云数据.雷达的旋转频率为10Hz,垂直方向以2°的分辨率覆盖30°的视场大小,水平方向以0.18°的分辨率覆盖360°的视场大小.

图6 C16系列激光雷达

3.2 实测点云补全结果

图7为室内扫描场景以及对应的点云补全可视化图,可以看到扫描到的目标点云空间分布非常稀疏并且单个目标含有的点云数量少且残缺程度大.本文选取了实测点云中的椅子点云和桌子点云分别进行补全实验,补全可视化结果如图7(c)所示,从图7中可以看出,虽然实测点云分布非常稀疏并且残缺程度大,但是本文算法依旧能够获得最好的补全性能,并且补全结果与实际形状最为接近.通过激光雷达实测点云数据的补全实验验证了本文提出的基于特征融合的点云补全算法能够有效提升点云补全性能,并且可以很好地用于由激光雷达扫描获得的稀疏点云数据.

图7 激光雷达实测点云补全可视化

4 结 论

本文主要对三维点云数据获取过程中由于采集设备分辨率受限和目标间的相互遮挡等情况存在而导致的点云残缺问题进行了研究,针对现有深度学习点云补全网络无法恢复出细节特征的问题提出了一种基于特征融合的深度学习点云补全算法.本文算法可以有效地将残缺点云输入进行高保真的形状补全,这可以减少在实际点云采集过程中需要进行多视角的点云采集和拼接来还原目标的三维形貌而带来的额外工作量.本文算法还可以与实际应用的自动驾驶目标检测算法相结合,利用目标检测算法检测出车辆目标的三维包围框后提取车辆的残缺点云数据并进行形状补全来还原完整的车辆信息.大型开源数据集ShapeNet和KITTI的补全实验以及实测激光雷达点云数据的补全实验结果表明:

(1) 本文提出的基于特征融合的深度学习点云补全算法能够适用于密集扫描点云和稀疏扫描点云等不同空间分布特点的点云情形,并且补全的结果具有较高的保真度;

(2) 在ShapeNet和KITTI数据集上的补全实验结果说明本文算法能够在补全点云轮廓的同时有效恢复出目标点云的细节特征,与现有主流的补全算法相比能够大大提升点云补全的精度和可视化效果,并且能够适用于不同残缺分布的点云目标;

(3) 对激光雷达实测点云数据补全实验结果说明,本文算法能够有效地补全出真实采集的残缺目标点云数据,相比现有主流的补全算法具有更好的补全性能.

[1] Zou Yu,Wang Xueqian,Zhang Tao,et al. Broph:An efficient and compact binary descriptor for 3D point clouds[J]. Pattern Recognition,2008,76:522-536.

[2] Wu Rundi,Chen Xuelin,Zhuang Yixin,et al. Multi-modal shape completion via conditional generative adver-sarial networks[C]// European Conference on Computer Vision. Glasgow,UK,2020:281-296.

[3] Chen Honghua,Wei Mingqiang,Sun Yangxing,et al. Multi-patch collaborative point cloud denoising via low-rank recovery with graph constraint[J]. IEEE Transactions on Visualization and Computer Graphics,2020,26(11):3255-3270.

[4] 梁 煜,张金铭,张 为. 一种改进的卷积神经网络的室内深度估计方法[J]. 天津大学学报(自然科学与工程技术版),2020,53(8):74-80.

Liang Yu,Zhang Jinming,Zhang Wei. An improved indoor depth estimation method using convolutional neural networks[J]. Journal of Tianjin University(Science and Technology),2020,53(8):74-80(in Chinese).

[5] Yin Z,Oncel T. VoxelNet:End-to-end learning for point cloud based 3D object detection[C]// IEEE Computer Vision and Pattern Recognition. Salt Lake City,USA,2018:4490-4499.

[6] Qi C R,Su H,Mo K,et al. PointNet:Deep learning on point sets for 3D classification and segmentation[C]// IEEE Conference on Computer Vision and Pattern Recognition. Hawaii,USA,2017:77-85.

[7] Groueix T,Fisher M,Kim V G,et al. A papier-mache approach to learning 3D surface generation[C]// IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City,USA,2018:216-244.

[8] Yang Yaoqing,Feng Chen,Shen Yiru,et al. FoldingNet:Point cloud auto-encoder via deep grid deformation[C]// IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City,USA,2018:206-215.

[9] Yuan W T,Tejas K,David H,et al. PCN:Point completion network[C]//International Conference on 3D Vision. Verona,Italy,2018:728-737.

[10] Lyne P,Tchapmi,Vineet K,et al. TopNet:Structural point cloud decoder[C]// IEEE Conference on Computer Vision and Pattern Recognition. Long Beach,USA,2019:383-392.

[11] Ian J G,Jean P A,Mehdi M,et al. Generative adversarial nets[C]// Conference and Workshop on Neural Information Processing Systems. Montreal,Canada,2014:2672-2680.

[12] Panos A,Olga D,Ioanni M,et al. Learning representations and generative models for 3D point clouds[C]// International Conference on Machine Learning. Sydney,Australia,2017:40-49.

[13] Chen Xuelin,Chen Baoquan,Niloy J M,et al. Unpaired point cloud completion on real scans using adversarial training[C]// International Conference on Learning Representations. Louisiana,USA,2019:1-17.

[14] Wang Yue,Sun Yongbin,Liu Ziwei,et al. Dynamic graph CNN for learning on point clouds[J]. ACM Trans-actions on Graphics,2019,38(5):1-12.

[15] Angel X C,Thomas F,Leonidas G,et al. ShapeNet:An information-rich 3D model repository[EB/OL]. https://arxiv. org/abs/1512.03012,2015-12-09.

[16] Geiger A,Lenz P,Stiller C,et al. Vision meets robotics:The kitti datasets[J]. International Journal of Robotics Research,2013,32(11):1231-1237.

[17] Fan Haoqiang,Su Hao,Leonidas G,et al. A point set generation network for 3D object reconstruction from a single image[C]// IEEE Conference on Computer Vision and Pattern Recognition. Honolulu,USA,2017:2463-2471.

Deep Learning Point Cloud Completion Algorithm via Feature Fusion

Zhao Yiqiang,Zhou Yiyao,Hu Bin,Ai Xiding,Chen Rui

(School of Microelectronics,Tianjin University,Tianjin 300072,China)

Owing to the limitation of 3D scanning devices such as lidar,mutual occlusion among targets,and the transparency of surface materials,the acquired 3D point cloud is often incomplete. Recently,data-driven deep learning methods have been gradually applied to complete point clouds. However,existing point cloud completion methods only focus on completing the global topological structure of the original point cloud and ignore the local detail recovery of the target point cloud. To address this limitation,this study proposes a novel deep learning point cloud completion algorithm via feature fusion. This algorithm uses a relation-aware encoder,which performs the mapping from the point cloud to the 128-dimensional latent feature vector to fuse the neighbor distribution characteristics and spatial features of the point cloud. Subsequently,a tree-structured decoder is applied to fuse the features of the global and local feature vectors to output the complete point cloud predictions. The simulation results of the ShapeNet and KITTI datasets show that the proposed point cloud completion algorithm exhibits better performance than state-of-the-art methods on completion precision and visualization. The proposed method reduces the chamfer distance on the airplane,car,chair,and table point cloud models by 2.4%,2.5%,8.3%,and 6.2%,respectively. In contrast,the proposed method reduces the unidirectional Hausdorff distance on the airplane,car,chair,and table point cloud models by 2.1%,0.4%,0.8%,and 0.3%,respectively. Finally,the point cloud completion experiment on the actual scanning of point clouds measured using the LeiShen intelligent system lidar verifies the effectiveness of the proposed point cloud completion algorithm,which indicates that the point cloud completion networks trained on the ShapeNet dataset are suitable for sparse point clouds measured using lidar.

3D point cloud;deep learning;completion algorithm;topological structure;feature fusion

10.11784/tdxbz202103073

TN958.98;TN911.73

A

0493-2137(2022)05-0535-08

2021-03-30;

2021-06-04.

赵毅强(1964— ),男,博士,教授,yq_zhao@tju.edu.cn.

陈 瑞,ruichen@tju.edu.cn.

国家自然科学基金资助项目(61871284);广西驱动发展项目(2018AA13005).

Supported by the National Natural Science Foundation of China(No.61871284),Guangxi Innovative Driven Development Project (No.2018AA13005).

(责任编辑:王晓燕)