基于WEMD和生成对抗网络重建的红外与可见光图像融合

2022-03-07杨艳春高晓宇党建武王阳萍

杨艳春,高晓宇,党建武,王阳萍

基于WEMD和生成对抗网络重建的红外与可见光图像融合

杨艳春*,高晓宇,党建武,王阳萍

(兰州交通大学 电子与信息工程学院,甘肃 兰州 730070)

针对红外与可见光图像融合中边缘模糊、对比度较低的问题,提出一种二维窗口经验模式分解(WEMD)和生成对抗网络重建的红外与可见光图像融合算法。将红外和可见光图像进行WEMD分解得到内蕴模式函数分量和残余分量,将内蕴模式函数分量通过主成分分析进行融合,残余分量用加权平均进行融合,重构得到初步融合图像,再将初步融合图像输入生成对抗网络中与可见光图像进行对抗博弈,补全背景信息,得到最终的融合图像。客观评价指标采用平均梯度、边缘强度、熵值、结构相似性和互信息,与其他5种方法相比,本文算法的各项指标分别平均提高了46.13%,39.40%,19.91%,3.72%,33.10%。实验结果表明,该算法较好地保留了源图像的边缘及纹理细节信息,同时突出了红外图像的目标,具有较好的可视性,而且在客观评价指标方面也有明显的优势。

图像融合;红外与可见光图像;窗口经验模式分解;生成对抗网络

1 引 言

图像融合是从不同传感器捕获的图像中提取最有意义的信息,并将多个源图像的互补信息生成一幅信息更完备、对后续应用更有利的图像[1]。具体来说,可见光图像容易受天气、光照等因素的影响,无法有效突出目标。红外成像通过捕捉热辐射信息差异形成红外图像,与可见光图像相比,红外图像对成像环境的鲁棒性更强,所捕获的红外图像具有显著的对比度,能有效地将热目标与背景区分开。然而在对比度、分辨率和细节刻画等方面,红外图像又远不如可见光图像。通过红外与可见光图像融合实现两种图像的优势互补,生成的图像既能突出目标区域又有丰富的纹理细节。目前,这种技术广泛应用于军事[2]、安全监控[3]、医疗科学技术[4]、遥感[5]和机器视觉[6]等领域。

随着图像融合领域的不断发展,新的融合方法不断提出,融合效率也明显提高。基于多尺度变换的方法是图像融合中的有力工具,比如小波[7]、金字塔[8]、曲波[9]以及它们的改进方法。这些方法取得了一定的融合效果,但得到的融合结果耗时长、效率低。经验模态分解(Emperical Mode Decomposition,EMD)[10]是Huang在1998年提出的,它可以分解为一维非线性和非平稳信号。诸多学者将一维信号分解扩展到二维图像信号分解,并且已经逐步地发展成熟。文献[11]提出了一种基于二维经验模态分解(BEMD)的图像融合方法,利用BEMD进行分解,各自分量对应一个融合规则,最后各自分量相加得到融合结果。文献[12]提出了一种分级多尺度融合的水下偏振图像处理方法,基于BEMD分别将偏振参量融合图像与偏振强度图像进行多尺度变换,对得到的高低频子图像分别进行加权平均融合,融合权重是采用穷举搜索法计算得到的,最后,将高低频融合结果反变换得到最终的融合图像。深度学习可以自动从数据中提取独有的特征,无需人工干预,在图像融合中得到了广泛的应用。文献[13]利用深度学习框架生成源图像特征的单幅图像,较好地保留了源图像的重要特征,取得了较好的融合效果。文献[14]用生成对抗网络(Generative Adversarial Networks,GAN)来融合红外与可见光这两种类型的信息,其中生成器的目标是生成具有主要红外强度和附加可见梯度的融合图像,鉴别器的目标是迫使融合图像具有可见光图像中存在的更多细节,这使得最终的融合图像同时保持红外图像中的热辐射和可见光图像中的纹理信息。

目前,红外与可见光图像融合存在以下问题:(1)部分方法利用BEMD的优良分解特性,在使用BEMD算法分解图像时存在信号隐藏问题,无法完全分离信号,对图像边缘和纹理提取不充分;(2)生成对抗网络训练过程中会产生梯度消失的现象,无法达到纳什均衡。为解决以上问题,本文提出一种基于窗口经验模态分解(Window Empirical Mode Decomposition,WEMD)和GAN重建的红外与可见光图像融合算法。利用WEMD算法的高频细节信息强获取能力,可以更好地提取可见光中的背景信息,分解成残余分量和内蕴模式函数分量(Intrinsic Mode Function,IMF)。残余分量则相当于低频信息,融合规则采用加权平均的方法,重构得到初步的融合图像。代表高频信息的IMF分量采用主成分分析(Principle Component Analysis,PCA)的融合规则进行融合,生成初步融合图。将得到的初步融合图像输入GAN中,针对训练不稳定的问题,将GAN的目标函数由交叉熵损失替换为最小二乘损失,增强图像细节特征的提取能力。为了验证算法的有效性,与其他5种方法进行对比,本文方法在解决信号隐藏问题的基础上,保留了图像的边缘及纹理等细节信息,具有较好的可视性。

2 理论分析

2.1 窗口经验模式分解

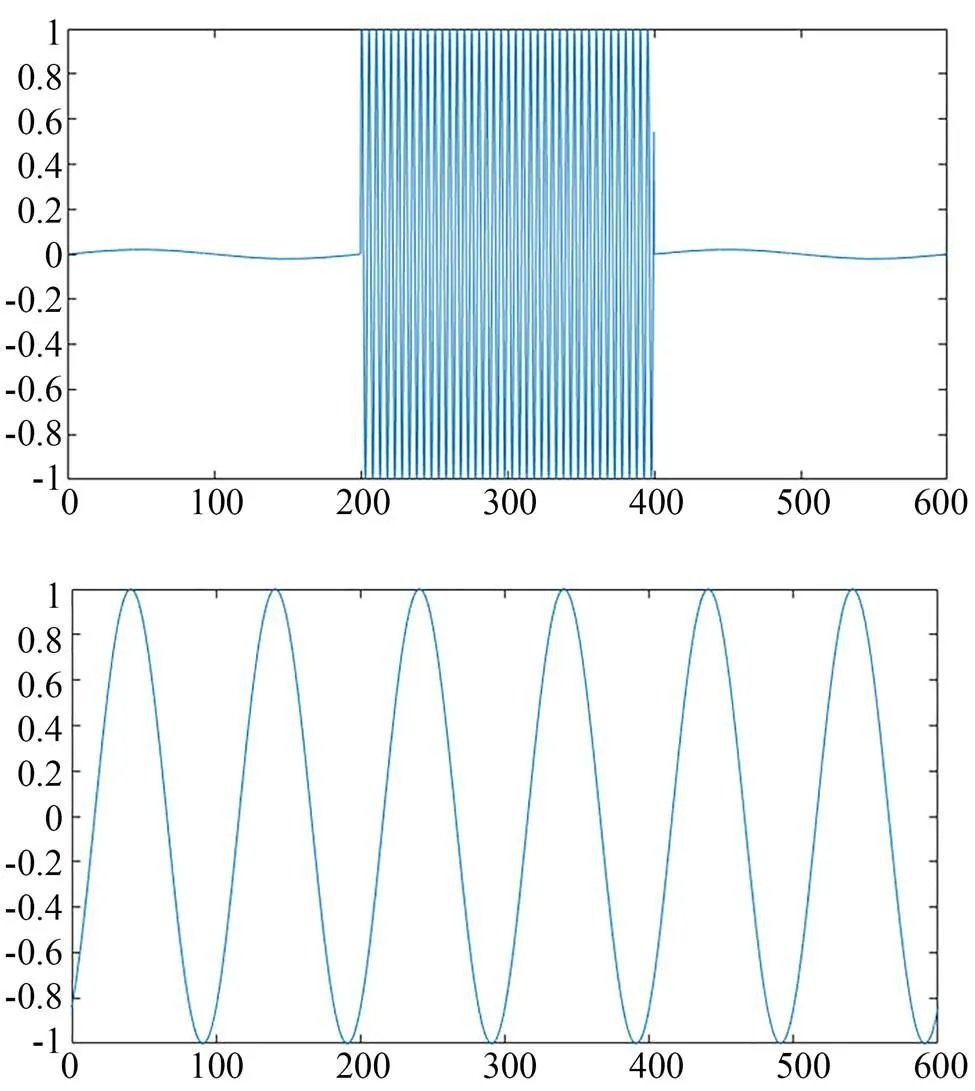

传统BEMD存在着信号隐藏和收敛速度慢的问题,因为BEMD在计算平均包络时运用了插值算法,插值算法在端点处和频率变化较大的区域会出现较大的摆动,随着分解层数的增加,得到的分解数据会出现严重的失真。BEMD的分解停止条件是通过计算标准差来决定的,而这种筛选过程不具备快速收敛性,影响运算速度。本文提出了一种二维WEMD算法,在BEMD的基础上,增加了一个自适应窗口,替代了BEMD中通过插值算法计算出上下包络的方法,很好地克服了信号隐藏问题[15],舍弃了根据标准差的停止筛选条件,有效提高了算法的运算速度。WEMD可以很好地解决信号隐藏问题,如图1所示。

图1 窗口经验模式分解

它的基本算法流程如下:

(2)对当前第层,进行加窗处理:

③=+2,如果<,转到步骤②;否则求;

④计算下一像素,转到步骤②,直到计算完所有像素点;

2.2 生成对抗网络框架

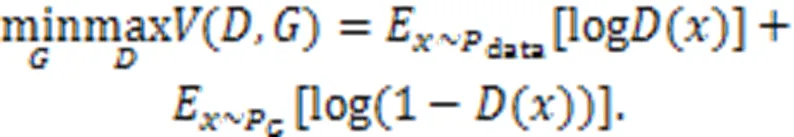

GAN将生成模型设计成一个学习概率参数的模型,为了使真实分布数据和生成模型之间的散度最小化,通过一个最大、最小博弈对抗过程同时训练两个模型来估计生成模型:生成模型G和鉴别模型D[16]。生成器G将生成的一个样本去欺骗鉴别器D,鉴别器D则是区分真假图像。在训练过程中进行对抗学习来提高两个模型的性能,产生更高质量的图像。它的目标函数为:

当训练G时,鉴别器D中的参数是不变的。G和D的对抗过程构成了最小最大博弈,其中G试图愚弄D,而D被训练来鉴别生成的数据。因此,鉴别器很难区分生成的样本和真实数据。现有的基于GAN的融合方法仅仅应用GAN来迫使融合图像在可见光图像中获得更多细节,而红外图像中的热辐射仅通过内容损失获得。随着对抗博弈的进行,融合后的图像与可见光图像更加相似,热目标的突出度逐渐降低。利用双鉴别器可以很好地解决以上的问题。

3 方 法

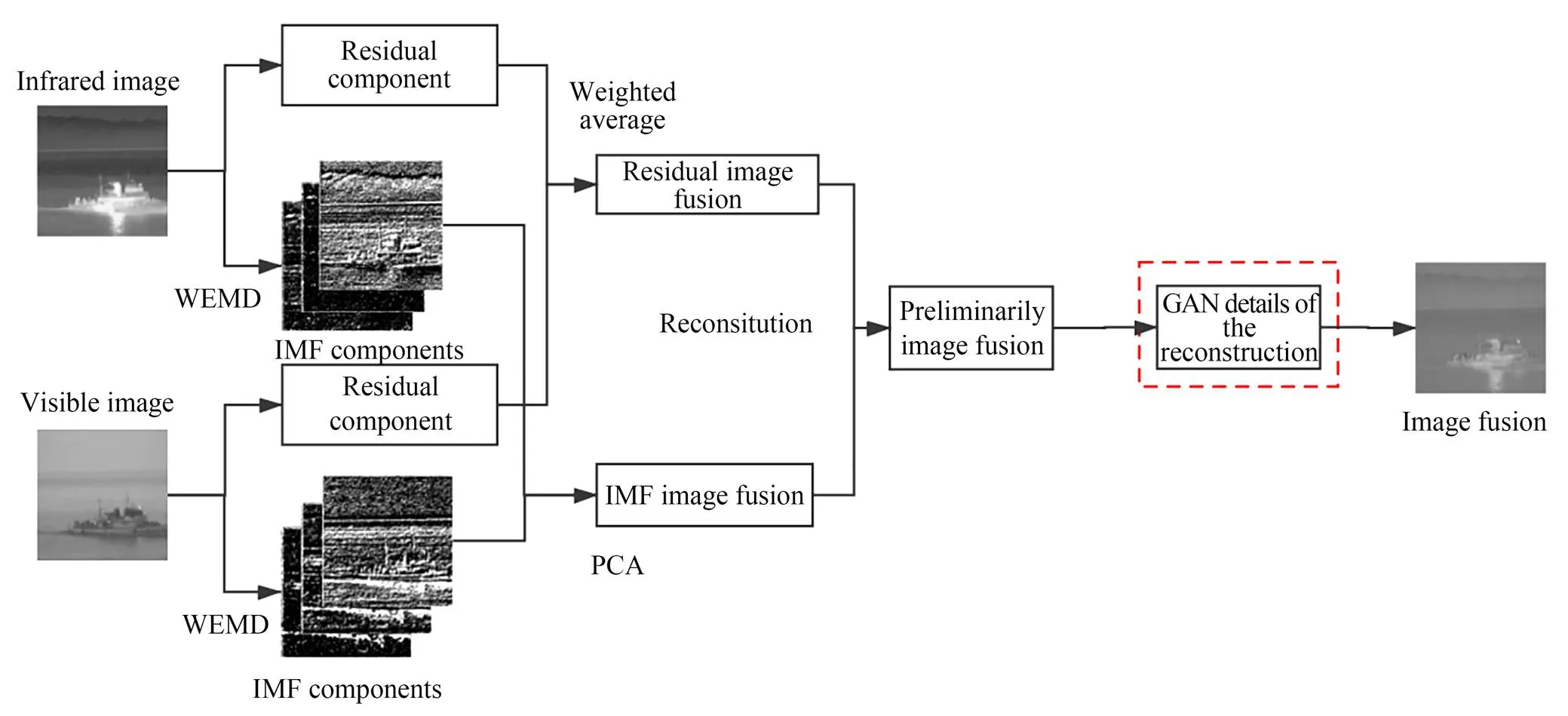

将源图像通过WEMD分解得到残余分量和IMF分量,通过加权平均对残余分量进行融合。IMF分量则采用PCA主成分分析法进行融合,PCA方法的降维处理方式应用在图像处理上往往容易获得大尺度下的纹理和细节信息,将PCA应用于IMF分量的融合,可以很好地对IMF分量中的细节、线条和边缘进行捕捉和刻画,从而保留图像主要的细节信息。最后,将得到的各分量的融合图像累加得到初步的融合图像,将初步融合图像输入GAN中进行细节重建,得到最终的融合图像。基于WEMD的算法流程如图2所示,具体步骤如下:

(2)选用加权平均来融合残余分量,利用PCA融合IMF分量,得到各个分量的融合图,重构得到初步的融合图像;

(3)再将得到的初步融合图像输入GAN中进行细节重建得到最终的融合图像。

图2 基于窗口经验模式分解算法流程

3.1 融合部分

(8)将得到的两部分融合图重构得到初步的融合图像。

3.2 细节重建部分

细节重建部分是将得到的初步融合图像输入GAN,通过生成器来生成虚假样本,利用双鉴别器与生成器对抗的过程中补全红外图像和可见光图像的信息。

321生成器的网络架构

生成器的网络结构如图3所示。由图可知,它是一个简单的五层卷积神经网络,其中第一层和第二层使用5×5滤波器,第三层和第四层使用3×3滤波器,最后一层使用1×1滤波器。每层的步幅设置为1。对于红外和可见光图像融合,每个下采样过程都会丢失源图像中的一些细节信息,这对融合很重要。因此,只引入卷积层。这也可以保持输入和输出的大小相同,因此,转置卷积层在我们的网络中是不必要的。此外,为了避免梯度消失的问题,遵循深度卷积GAN的规则进行批量归一化和激活函数。为了克服对数据初始化的敏感性,在前四层采用了批量归一化,批量归一化层可以使模型更加稳定,也可以帮助梯度有效地反向传播到每一层。为了避免随着网络加深出现的误差,引入残差网络。在前四层使用ReLU激活函数,最后一层使用tanh激活函数。

图3 生成器的网络架构

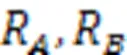

322鉴别器的网络架构

鉴别器的网络结构每一层都只有卷积操作,如图4所示。从第一层到第四层,卷积层中使用3×3的滤波器,在没有填充的情况下将步幅设置为2。鉴别器是一个分类器,它先从输入图像中提取特征图,然后对它们进行分类。因此,将步幅设置为2,它的工作方式与汇集层相同。为了不引入噪声,只在第一层对输入图像执行填充操作,在其余三个卷积层不执行填充。从第二层到第四层,使用批处理规范化层。随着层数的增加,为了避免误差,引入残差网络。每一层的激活函数都是Leaky ReLU函数,最后是线性层。

图4 鉴别器的网络架构

323网络训练

为了解决GAN在网络训练中不稳定的问题,在训练中引入内容丢失。因此,生成器不仅被训练成欺骗鉴别者,而且约束生成的图像和内容中的源图像之间的相似性的任务。因此,生成器的损失函数由两部分构成,损失函数定义为:

4 实验结果与分析

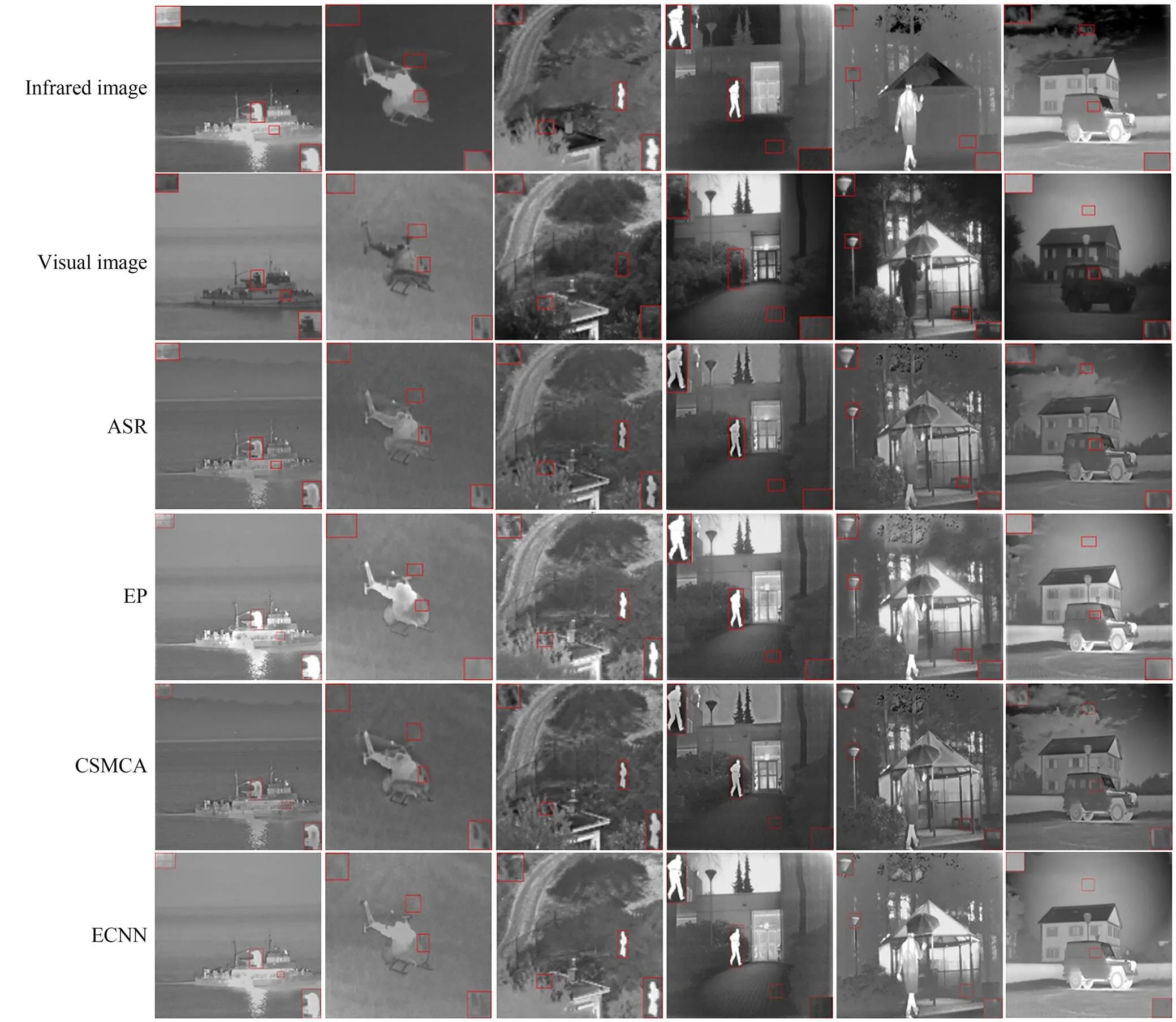

为验证本文算法的可行性与有效性,实验中选取6组经过配准的红外与可见光图像进行融合,其大小分别为632×496,640×480,620×450,360×270,595×328和768×576 pixel。网络模型运用tensorflow框架。实验的仿真平台采用配置为Intel酷睿i5-4210H CPU,运行内存8 GB,操作系统为Win 10,编程环境为Python 3.6。如图5所示,将本文方法与自适应稀疏表示(ASR)[17]、通过红外特征提取和视觉信息保存实现红外与可见光图像融合(EP)[18]、基于卷积稀疏性的形态学成分分析方法(CSMCA)[19]、集成卷积神经网络方法(ECNN)[20]和GAN[14]进行对比。

图5中,第一组EP方法很好地突出了高亮区域,但遗漏了很多可见光图像中的信息,而其他方法没有很好突出红外信息,本文方法在保持细节信息的同时,得到了足够的红外信息。第二组对比方法的融合结果丢失了一些红外信息,本文方法中很好地体现出了飞机螺旋桨的红外信息,对比度更高。本文方法很好地体现了红外目标信息,并保有一定的背景细节信息。第三组很好地保留了房子周围树木的纹理细节,EP方法有明显的遮挡,GAN方法保留了目标建筑物的显著性,但周边树木的纹理结构却不够丰富,而本文方法则很好地突出了红外目标的信息。第四组图像在标出的路面上损失了很多背景信息,CSMCA方法和ECNN方法融合得到的图像虽然突出了前景目标信息,但两个方法丢失了部分细节、纹理信息。相比而言,本文算法对路面的纹理保留得最好,且有效地突出了高亮区域。第五组EP和ECNN具有明显的融合处理痕迹,比如树林的背景被虚化、人体线条失真,且源图像区域间成像特性差异越大、特征变化越急剧,这种效应越明显,对比之下,ASR和本文方法则较为自然。从第六组图片可以看出,房子周围的树木模糊,天空中的云出现失真的现象,本文算法可以清晰地看到树木和云朵的纹理信息,相比其他方法具有明显优势。

为了更好地评价图像质量,本文采用了5种客观评价指标,如表1所示,对多组图像进行评价。这5种评价指标分别是平均梯度[23](Average Gradient,AG),边缘强度[24](Edge Intensity,EI),熵值[25](Entropy,EN),结构相似性[26](Structural Similarity,SSIM)和互信息[27](Mutual Information,MI)。

图6 指标折线图

表1图像融合对比实验的客观评价指标

Tab.1 Objective evaluation index of image fusion contrast experiment

如表1所示,本文效果优于对比融合方法。本文算法较好地保留了图像的边缘及纹理细节信息,同时突出了红外图像的目标,具有较好的对比度和清晰度。

运行效率也是评估算法性能的重要标准之一。统计了不同方法在TNO数据集上的运行时间,结果如表2所示。因为EP方法运用了传统方法,所以运行时间较短,其他方法需要通过字典或网络来生成融合图像,本文所提方法在TNO数据集上的运行效率比多数方法都快。

表2各方法在TNO数据集上的运行时间

Tab.2 Running time of each method on TNO dataset (s)

5 结 论

本文提出了一种基于WEMD和GAN重建的红外与可见光图像融合方法,不仅能够有效地解决图像分解中信号隐藏的问题,而且保持了边缘和纹理等细节信息,提高了图像的对比度。WEMD算法对图像各层的细节信息进行提取,将图像分解为残余分量和IMF分量,IMF分量可以通过阈值将细节和背景分离开来,更好地提取高频信息。最后重构得到初步的融合图像,初步融合图像再通过GAN的细节重建,补全丢失的细节纹理信息。与其他方法相比,本文提出的方法能获得纹理和细节更加丰富的图像,提高了图像的对比度和清晰度,是一种有效的融合方法。与ASR,EP,CSMCA,ECNN和GAN 5种方法相比,平均梯度(AG),边缘强度(EI),熵值(EN),结构相似性(SSIM)和互信息(MI)分别平均提高了46.13%,39.40%,19.91%,3.72%,33.10%。不过,基于WEMD和GAN的方法在图像融合中会受到噪声的影响,提出更具鲁棒性的融合规则是今后努力的方向。

[1] 刘先红,陈志斌,秦梦泽. 结合引导滤波和卷积稀疏表示的红外与可见光图像融合[J]. 光学精密工程, 2018, 26(5): 1242-1253.

LIU X H, CHEN ZH B, QIN M Z. Infrared and visible image fusion using guided filter and convolutional sparse representation[J]., 2018, 26(5): 1242-1253. (in Chinese)

[2] SINGH R, VATSA M, NOORE A. Integrated multilevel image fusion and match score fusion of visible and infrared face images for robust face recognition[J]., 2008, 41(3): 880-893.

[3] HAN J, BHANU B. Fusion of color and infrared video for moving human detection[J]., 2007, 40(6): 1771-1784.

[4] REINHARD E, ADHIKHMIN M, GOOCH B,. Color transfer between images[J]., 2001, 21(5): 34-41.

[5] 冯维,吴贵铭,赵大兴,等. 多图像融合Retinex用于弱光图像增强[J]. 光学精密工程, 2020, 28(3): 736-744.

FENG W, WU G M, ZHAO D X,. Multi images fusion Retinex for low light image enhancement[J]., 2020, 28(3): 736-744. (in Chinese)

[6] 殷明,段普宏,褚标,等. 基于非下采样双树复轮廓波变换和稀疏表示的红外和可见光图像融合[J]. 光学精密工程, 2016, 24(7): 1763-1771.

YIN M, DUAN P H, CHU B,. Fusion of infrared and visible images combined with NSDTCT and sparse representation[J]., 2016, 24(7): 1763-1771. (in Chinese)

[7] ALI S S, RIAZ M M, GHAFOOR A. Fuzzy logic and additive wavelet-based panchromatic sharpening[J]., 2014, 11(1): 357-360.

[8] CHEN G, LI L, JIN W Q,. Weighted sparse representation and gradient domain guided filter pyramid image fusion based on low-light-level dual-channel camera[J]., 2019, 11(5): 1-15.

[9] CHOI M, KIM R Y, NAM M R,. Fusion of multispectral and panchromatic Satellite images using the curvelet transform[J]., 2005, 2(2): 136-140.

[10] HUANG N E, SHEN Z, LONG S R,. The empirical mode decomposition and the Hilbert spectrum for nonlinear and non-stationary time series analysis[J].:,, 1998, 454(1971): 903-995.

[11] YANG J K, GUO L, YU S W,. A new multi-focus image fusion algorithm based on BEMD and improved local energy[J]., 2014, 9(9): 2329-2334.

[12] 王慧斌,廖艳,沈洁,等. 分级多尺度变换的水下偏振图像融合法[J]. 光子学报, 2014, 43(5): 192-198.

WANG H B, LIAO Y, SHEN J,. Method of underwater polarization image fusion based on hierarchical and multi-scale transform[J]., 2014, 43(5): 192-198. (in Chinese)

[13] LI H, WU X J, KITTLER J. Infrared and visible image fusion using a deep learning framework[C].201824()2024,2018,,, 2018: 2705-2710.

[14] MA J Y, YU W, LIANG P W,. FusionGAN: a generative adversarial network for infrared and visible image fusion[J]., 2019, 48: 11-26.

[15] 朱攀,黄战华. 基于二维经验模态分解和高斯模糊逻辑的红外与可见光图像融合[J]. 光电子·激光, 2017, 28(10): 1156-1162.

ZHU P, HUANG ZH H. Fusion of infrared and visible images based on BEMD and GFL[J]., 2017, 28(10): 1156-1162. (in Chinese)

[16] RADFORD A, METZ L, CHINTALA S.Unsupervised representation learning with deep convolutional generative adversarial networks[J]., 2015(1): arXiv:1511.06434.

[17] LIU Y, WANG Z F. Simultaneous image fusion and denoising with adaptive sparse representation[J]., 2015, 9(5): 347-357.

[18] ZHANG Y, ZHANG L J, BAI X Z,. Infrared and visual image fusion through infrared feature extraction and visual information preservation[J]., 2017, 83: 227-237.

[19] LIU Y, CHEN X, WARD R K,. Medical image fusion via convolutional sparsity based morphological component analysis[J].,2019, 26(3): 485-489.

[20] AMIN-NAJI M, AGHAGOLZADEH A, EZOJI M. Ensemble of CNN for multi-focus image fusion[J]., 2019, 51: 201-214.

[21] SHEN Y, WU Z D, WANG X P,. Tetrolet transform images fusion algorithm based on fuzzy operator[J]., 2015, 9(9): 1132-1138.

[22] XYDEAS C S, PETROVIĆ V. Objective image fusion performance measure[J]., 2000, 36(4): 308.

[23] 闫莉萍,刘宝生,周东华. 一种新的图像融合及性能评价方法[J]. 系统工程与电子技术, 2007, 29(4): 509-513.

YAN L P, LIU B SH, ZHOU D H. Novel image fusion algorithm with novel performance evaluation method[J]., 2007, 29(4): 509-513. (in Chinese)

[24] MA J Y, MA Y, LI C. Infrared and visible image fusion methods and applications: a survey[J]., 2019, 45: 153-178.

[25] QU G H, ZHANG D L, YAN P F. Information measure for performance of image fusion[J]., 2002, 38(7): 313-315.

Infrared and visible image fusion based on WEMD and generative adversarial network reconstruction

YANG Yanchun*,GAO Xiaoyu,DANG Jianwu,WANG Yangping

(,,730070,),:102

To overcome the problem of blurred edges and low contrast in the fusion of infrared and visible images, a two-dimensional window empirical mode decomposition (WEMD) and infrared and visible light image fusion algorithm for GAN reconstruction was proposed. The infrared and visible light images were decomposed using WEMD to obtain the intrinsic mode function components (IMF) and residual components. The IMF components were fused through principal component analysis, and the residual components were fused by the weighted average. The preliminary fused image was reconstructed and input into the GAN to play against the visible light image, and some background information was supplemented to obtain the final fusion image. The average gradient (AG), edge strength (EI), entropy (EN), structural similarity (SSIM), and mutual information (MI) are used for objective evaluation, and they increased by 46.13%, 39.40%, 19.91%, 3.72%, and 33.10%, respectively, compared with the other five methods. The experimental results show that the proposed algorithm achieves better retention of the edge and texture details of the sources image while simultaneously highlighting the target of the infrared image, has better visibility, and has obvious advantages in terms of objective evaluation indicators.

image fusion; infrared and visible image; window empirical mode decomposition; generative adversarial network

TP391

A

10.37188/OPE.20223003.0320

1004-924X(2022)03-0320-11

2021-05-27;

2021-07-01.

长江学者和创新团队发展计划资助项目(No.IRT_16R36);国家自然科学基金资助项目(No.62067006);甘肃省科技计划资助项目(No.18JR3RA104);甘肃省高等学校产业支撑计划资助项目(No.2020C-19);兰州市科技计划资助项目(No.2019-4-49);兰州交通大学天佑创新团队资助项目(No.TY202003);兰州交通大学-天津大学联合创新基金资助项目(No.2021052)

杨艳春(1979),女,新疆五家渠人,副教授,博士,硕士生导师,2002年、2007年、2014年于兰州交通大学分别获得学士、硕士和博士学位,主要从事图像融合和图像处理的研究。E-mail:yangyanchun102@sina.com

高晓宇(1997),男,内蒙古乌兰察布人,硕士研究生,2019年于兰州交通大学大学获得学士学位,主要从事图像融合和图像处理的研究。E-mail:xiaoyu19971101@163.com