数据中心算力—电力灵活性协同研究

2022-02-02周滢垭童流川王爱喜高清爽赖宇阳

■周滢垭 童流川 王爱喜 高清爽 赖宇阳 等

适应新能源发电比例不断提高,以及用户侧电力需求响应逐步常态化的趋势,本文针对通过数据中心算力—电力协同进行需求响应做了初步可行性研究,提出通过判断计算任务在服务器上的算力—电力特征,在不影响业务运行的情况下,降低电力部件的实时冗余性、调整业务负载的并行规模和时间分布。

本项研究对业务—算力—电力三者协同提供电力灵活性的多种策略进行了实际测试,在服务器集群运行不同IT任务类型时,通过切换空载服务器功耗状态、利用服务器子部件资源消耗不均衡性、平移和伸缩实时性不敏感任务,改变负荷大小和时间分布,可达到节能降耗、对电网负荷削峰填谷等目的,可适用于各种规模、形式的数据中心、机房、集群和服务器。

研究表明,三种策略均可根据外部指令实现秒级对服务器功率的快速控制,为数据中心参与需求侧分钟级、秒级响应,或参与电力现货市场和电力辅助服务市场,提供了可行性依据和技术支持,显示数据中心的电力灵活性响应具备巨大的潜力以及广阔的应用前景。未来,推动其由研究走向数据中心算力—电力需求响应的成熟应用,既需要对更多部件、更复杂的部署情况进行深入实验,又需要形成自动化系统,联动业务—算力—电力三者的对应信息,同时更需要产业伙伴广泛协同,采用一套标准的测试方法标定业务负载在机型上的电力特性数据,开源共享,从而充分挖掘和发挥出数据中心算力侧的电力灵活性,助力构建新型电力系统。

图1 探索数据中心服务器负荷灵活性的主要策略

系统化构建数据中心算力—电力灵活性方案

通过系统化分析发现,数据中心通过算力调节进行需求响应,来提供电力辅助服务的实现策略有四种,分别是利用空载服务器功耗切换、利用服务器硬件资源消耗不均衡性、平移和伸缩实时性不敏感任务以及跨数据中心转移任务。

灵活性策略设计

1.利用空载服务器在不同功耗状态之间切换。

从时间分布上看,数据中心中会有一部分服务器处于并未执行任何工作而空载备用的状态。因此,通过业务规模的精细预测,对服务器执行不同方式的功率降低和休眠策略,可实现不同级别的响应速度和响应深度。该策略可以长期运用,作为数据中心节能的重要途径,只是存在精细管理的成本与节能收益之间的平衡问题;也可作为响应策略,以电力辅助服务的优势价格,刺激数据中心精细预测和切换空载服务器功耗状态。

2.利用计算任务在服务器硬件资源消耗上的不均衡性。

任何一个业务负载在服务器上的运行,会存在要么服务器能力有冗余,要么其CPU、网络、内存、硬盘等某子部件的某一性能使用密集,成为“短板”,而导致其余部件的能力产生冗余,即“长板”。降低冗余的子部件性能,可以在不影响业务负载运行效率的情况下,降低电力负荷。该策略需要研究一系列的特性数据,包括业务负载对于各子部件的压力特性数据、总体业务性能与子部件性能的关联以及子部件性能变化时的能耗特性数据,同时在执行响应时,还需要实时监测业务负载对于各子部件的实时压力数据,以便根据之前的特性数据集,及时做出电力负荷调整的位置和幅度策略。

3.利用平移和伸缩实时性不敏感的计算任务。

近年来,随着智慧城市、智能制造、自动驾驶、元宇宙等应用的不断增长,高性能计算(HPC)的需求也随之不断提升。影视渲染、效果图渲染等批量计算任务,基因测序、风机工况模拟等科学计算任务以及AI训练等可并行的计算任务,往往需要消耗大量的服务器资源和运算较长时间,已经成为IT行业节能减排研究的重要课题。这类任务往往具有计算成本敏感、实时性不敏感、计算规模可变动的特性。对此,一方面可以通过实时传递价格信号,激励用户选择电力价格较低的时间段进行整体运算;另一方面,也可以通过断点续算、可续渲染技术,在计算任务执行的过程中暂停乃至对并行规模进行改变,来平移和升降电力负荷。

4.利用网络跨数据中心转移任务。

通过将业务冷迁移或者热迁移到不同地理位置的数据中心,而改变多个数据中心的电力负荷在空间上的分布,该策略需要较庞大的业务群及分布式计算存储业务架构予以支撑。

前三个策略的实现需要业务—算力—电力三者的精准关联关系和协同,但能够适用于各种规模、形式的数据中心、机房、集群和服务器,也是本研究的重点。

灵活性策略结果

利用空载服务器在不同功耗状态之间切换的策略测试。

空载消耗:

对于单台实验服务器,在未运行任何计算任务的空载状态下,消耗电力功率215瓦,其中CPU消耗53%,内存消耗21%。

图2 实验中单台服务器空载时的功耗及分布

测试流程:

对空载状态服务器进行功耗状态切换。

在单机环境,测试了三类切换空载服务器功耗状态的方式:

将Linux 功耗状态设置为Freeze,并通过HMI 唤醒;

通过Intel®DCM 的PowerCap将CPU功率上限调节至最低,并通过解除设定来恢复功率;

输入系统命令Shutdown,进行软关机,再通过电源按键启动。

图3 测试策略流程图

测试结论:

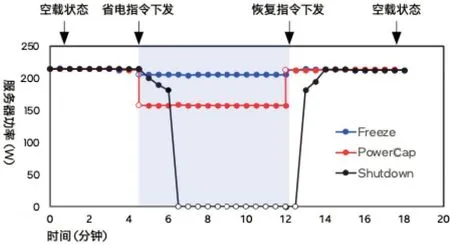

测试数据显示,通过切换服务器空载状态,三种模式皆可获得功率降低。其中,Freeze、PowerCap 皆可秒级响应,功率降比分别为4%、27%;关机带来的功率降低最大,达100%,但切换开关机需要2.5 分钟,额外消耗电量0.0083千瓦时。

图4 Freeze、PowerCap 和关机三种方式下的功耗和响应特征曲线

表1 测试结果表

此外,本研究还进行了利用计算任务在服务器子部件消耗不均衡性的策略测试和利用平移和伸缩实时性不敏感的计算任务策略测试。

对下一步研究的启示

本项目提供了一个在数据中心利用算力—电力协同进行需求响应,从而提供电力辅助服务的初步可行性研究,在测试的设计上不尽周全,在分析的过程中也仍有许多未知和值得深入探讨的问题,欢迎各领域的学者、专家、产业伙伴给予指教与建议。在形成一个数据中心算力—电力需求响应的成熟方案之前,无疑需要在更多的机型上对更加多元化的计算任务进行特性数据测试。除此之外,下一步的实验也需要将以下几方面纳入研究:

从CPU 功率调控到内存功率调控:本项目中所使用的服务器内存配置较小,也未涉及运行非内存密集型的任务时限制内存功率的测试。而对于一些大内存机型,其功率可占到总服务器功率的40%以上,对于内存功率调控的研究就显得极其必要;

从服务器到数据中心整体:本项目中的测试和监测对象只有服务器,尚未纳入交换机和制冷设备的关联影响,其中包括:

响应特性:当大量的服务器进行电力响应并持续一段时间后,很可能带来相关联的交换机和制冷设备的功率变化,从而形成系统型响应特征曲线。

策略组合:对于整个数据中心,可根据各个服务器的状态和执行的任务特性,采用不同策略的组合,从而获得整个机架、机柜、数据中心层级的负荷调节。

从物理机到虚拟化:本项目中的业务负载直接运行在物理机上,从而能够获得更直观的算力—电力的关联关系,而在实际业务环境中有相当多的数据中心和服务器进行了虚拟化和混部,这使得业务负载—算力—电力之间又多添加了虚拟化层和混部运行,增加了精细管理的复杂度,但同时虚拟化及其资源调度也为算力分布调整能力带来了更大空间。

性能指标的定义:本项目中的业务负载性能特性比较单一,而在实际运行业务中,有可能除了计算速度(消耗时间)之外,还包含稳定性、网络延迟等其他性能,需要与每一个业务负载的开发者和运营者进行具体探讨。

未来展望

由实验研究到应用解决方案:本项目对数据中心算力—电力协同进行电力灵活性响应的策略应用进行了初步可行性研究,已经展现出其巨大的潜力及广阔的应用前景。但是上述研究对每一种策略应用只选取了一两个工作负载且只在一种机型上进行了可行性验证,测试了特性数据。而要针对实际运行的数据中心进行电力现货交易,打造需求响应能力,并提供精准的电力辅助服务,无疑需要有一套自动化系统,集合业务—算力—电力三者的对应信息,具备监控、预测、响应策略规划组合和调节控制的四项能力,方能对服务器集群和其各子部件进行敏锐监测和灵活调控,进而实现协同响应。

开放式协作与特性数据库:要对一个数据中心进行电力灵活性的预测和策略,需要不同负载在不同服务器以及其子部件(包括CPU、硬盘、内存等)的电力响应特性数据作为基础。然而逐个对其进行测试带来的巨大工作量,对于任何一方都难以承担。这就需要业务(程序)开发方、硬件生产商、业务运行方甚至硬件调度方(例如云或超算中心的运营商)开放式协作,制定和采用一套标准的测试方法、数据格式和数据共享网络来共同推进,进而加速实现智能管控计算负载,充分挖掘和发挥出数据中心的电力灵活性潜力,助力构建新型电力系统。■

备注:本项目有赖于横跨计算机硬件、计算机软件、数据中心运营、电力等各个方向的同仁共同合作。特此感谢以下单位和人员(排名不分先后)。腾讯科技有限公司:许浩、苏鑫、梁家启、马国勇、邵明、赵传寓、朱健保、淮赛男。英特尔(中国)有限公司:崔煜、朱晟伟、解强、史毅磊、华雯、古今、高阳。树优科技有限公司:叶芳、方立桥、孙军勇、魏凯锋

资料图