基于数字媒体技术的交互式三维脸部表情动画合成方法研究

2022-01-25张帅

张 帅

(滁州学院,安徽 滁州 239000)

随着三维动画产业的发展,对三维动画的视觉优化设计和合成技术提出了更高的要求,需要构建高效的交互式三维脸部表情动画合成模型,结合交互式图像处理技术,采用纹理渲染和三维融合的方法实现交互式三维脸部表情动画合成,提高三维动画的影视效果。相关的交互式三维脸部表情动画合成技术设计研究受到人们的极大关注[1]。

对交互式三维脸部表情动画合成设计是建立在特征分析和信息融合的基础上完成的,构建数字媒体交互式三维脸部表情动画图像采样模型,在三维信息特征提取的基础上建立信息融合模型。

当前,针对三维脸部表情动画合成的方法主要有基于模糊度辨识的合成方法、基于RGB融合的合成方法以及基于参数模糊度特征分析的合成方法等[2-4]。但传统方法的自适应性不好,渲染能力不够。

对此,本文提出基于数字媒体技术的交互式三维脸部表情动画合成方法。在构建数字媒体交互式三维脸部表情动画图像采集模型的基础上,采用多层次纹理映射方法构建特征提取模型,对提取的三维脸部表情特征点进行合成预处理。然后采用RGB分解技术进行动画图像的颜色分量融合,再根据视觉重建结构实现动画合成。最后进行仿真测试分析,展示了本文方法在提高交互式三维脸部表情动画合成能力方面的优越性能。

1 三维脸部表情动画图像信息采集和预处理

1.1 交互式三维脸部表情动画图像采集

首先构建数字媒体交互式三维脸部表情动画图像采集模型,结合滤波检测技术[5]实现动画合成和色彩搭配。在这一过程中,采用参数模板匹配的方法,得到数字媒体交互式三维脸部表情动画图像合成的匹配适应度函数为:

(1)

(2)

u(t)=rect(t)·T2π+[log2|t|-Wuu(a,b)]

(3)

式中,|t|≤1/2,rect(t)表示动画样本函数,t表示信息视觉参数。利用数字媒体技术对交互式三维脸部表情动画的三维中心点进行粗糙集图像匹配[7],得到动画图像的频率因子为:

(4)

式中,K=Tfmaxfmin/B表示三维脸部表情动画的粗糙度比对值,t0=f0T/B表示图像合成因子频率系数,f0表示动画交互处理的适应度系数,fmin,fmax分别表示动画采集的最低和最高采样频率,B表示采集样本数据范围。

在此基础上,对图像进行多尺度分解,得到交互式三维脸部表情动画合成图像区块信息采集函数为:

(5)

其中,⊗表示交互式三维脸部表情动画采集的模糊卷积算子。

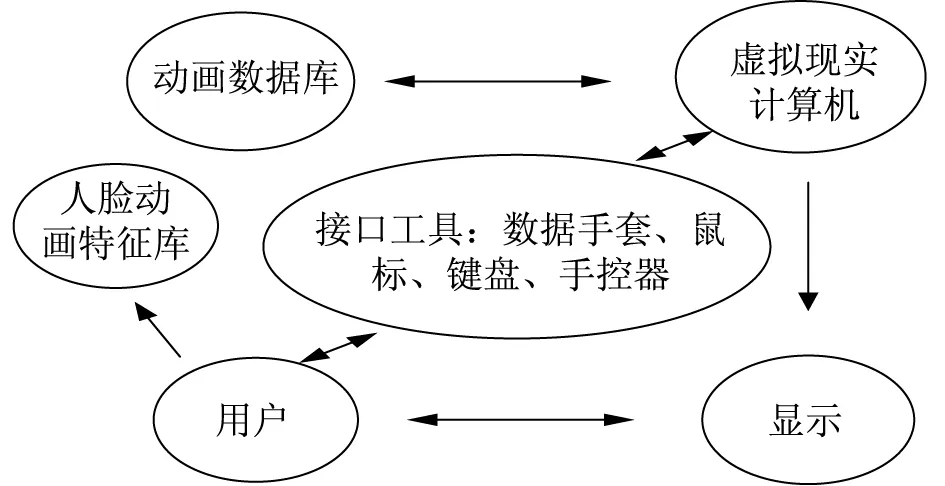

根据上述分析,构建了数字媒体交互式三维脸部表情动画图像采集模型,如图1所示。

图1 交互式三维脸部表情动画图像采集模型

通过对交互式三维脸部表情动画进行图像采集,得到图像信息,然后采用多层次纹理映射方法构建数字媒体交互式三维人脸特征提取模型,对提取的三维人脸特征点进行合成预处理。

1.2 三维脸部表情动画特征合成预处理

分析数字媒体交互式三维脸部表情动画图像的三维信息特征,采用多层次纹理映射方法建立特征信息提取模型,然后采用匹配滤波检测方法完成图像尺度分解[9],得到数字媒体交互式三维脸部表情动画图像的特征分解序列I(k)(i,j)表示如下:

(6)

式中,I(i,j)表示三维脸部表情动画多元线性特征函数,Ik表示动画图像分解向量,g表示图像的灰度边缘特征集。

结合上述得到的特征分解序列构建三维动画图像的张量模型,对交互式三维脸部表情动画图像进行参数优化,得到参数特征分解结果为:

(7)

式中,u为交互式三维脸部表情动画的二维色彩空间分块匹配集在p(i,j)的信息强度,(i,j)表示三维脸部表情动画的多尺度分布像素序列,m表示三维色彩空间分块匹配集的信息强度。采用多元线性特征结合方法,得到交互式三维脸部表情动画图像的视觉传达分析模型为:

(8)

其中,f(x,y)、ε(x,y)分别表示交互式三维脸部表情动画的自适应引导滤波函数,采用RGB分解技术进行交互式三维脸部表情动画的邻域检测,得到特征信息分量为:

(9)

式中,i表示交互式三维脸部表情动画图像的模糊度合成系数,R表示动画图像的规范量化集,sj表示灰度信息,gi表示动画图像的色彩空间。

在多分辨视觉成像环境下[10],得到交互式三维脸部表情动画的分块区域特征处理函数为:

(10)

式中,xc,xd分别表示交互式三维脸部表情动画图像样本分块区域。

采用分块区域检测,计算匹配窗口相关系数,实现交互式三维脸部表情动画的分块特征匹配,得到分块匹配的区域为M×N,在2×2的子块区域,采用颜色模板空间引导滤波检测的方法,进行交互式三维脸部表情动画图像的优化特征辨识处理[11]。

2 交互式三维脸部表情动画合成优化

2.1 三维脸部表情动画信息融合

将交互式三维脸部表情动画图像特征点输入到特征映射关系模型中,结合模糊信息融合的方法[12],得到交互式三维脸部表情动画图像的聚焦融合输出式为:

(11)

式中,Ts表示交互式三维脸部表情动画图像采样时间间隔,Dj表示三维脸部表情动画图像色彩认知的局部分解值。基于此,采用虚拟视景重构技术进行图像匹配[13],并建立数字媒体交互式三维脸部表情动画图像合成三维重建模型,得到融合像素为:

(12)

式中,P表示交互式三维人脸图像元素初始值,Q表示融合分布序列,x1,x2表示动画场景像素的参数坐标。然后通过空间区域融合方法,进行数字媒体交互式三维脸部表情动画图像合成的灰色分解,得到动画图像的融合关联度为μ。然后结合信息融合的方法,实现对数字媒体交互式三维人脸信息跟踪识别和视觉重建,得到交互式三维脸部表情动画图像的边缘尺度为:

(13)

式中,R表示交互式三维脸部表情动画图像的跟踪距离。如果pixel_A (14) 其中,θ表示交互式三维脸部表情动画合成的信息合成量,λ1,λ2分别为长、短边缘尺度,交互式三维脸部表情动画模糊信息融合函数为: (15) 采用RGB分解技术进行交互式三维脸部表情动画图像的颜色分量融合,实现交互式三维脸部表情动画合成和图像融合。 结合模糊信息融合的方法,实现对交互式三维人脸信息跟踪识别和视觉重建[14],根据视觉重建结构,得到交互式三维脸部表情动画图像的滤波合成函数为: (16) 其中,K表示交互式三维脸部表情动画图像的边缘聚焦函数,m表示图像分解尺度,uj(k)表示像素强度,j表示交互式三维脸部表情动画合成的能量系数。通过邻域插值补偿的方法,得到交互式三维脸部表情动画的像素点合成函数为[15]: (17) 式中,wmt表示交互式三维脸部表情动画合成分块输出的检测系数。 综上,利用数字媒体技术进行交互式三维脸部表情动画合成,合成后的动画人脸边缘轮廓向量用p*=(Xcs2,θ*,ρ*)描述,采用视觉边缘处理技术,得到交互式三维脸部表情动画分布的区域像素分布集合式为: (18) 设置h为交互式三维脸部表情动画图像的边缘像素集,采用正则化向量分解的方法,得到三维脸部表情动画状态输出匹配量为: (19) 根据上述分析,采用多维空间数据组合检测的方法,实现对交互式三维脸部表情动画合成,提高脸部表情动画的视觉图像表达能力。 为验证本文方法在三维脸部表情动画合成中应用性能进行仿真测试分析。 三维脸部表情动画采集的像素点大小为300300300,特征辨识度水平为0.83,三维重构的迭代次数为1200,动画合成渲染的模糊系数为0.36,三维人脸合成的窗口大小为1246,根据上述参数设定,进行数字媒体交互式三维脸部表情动画合成,对本文方法和传统方法进行融合度对比,对比结果如图2所示。 图2 三维脸部表情动画场景色彩搭配信息融合度 分析图2可知,用本文方法进行三维脸部表情动画合成的融合度远高于其他传统方法,证明本文方法能够有效提高色彩搭配图形的三维分布融合能力。 进行三维脸部表情动画合成场景色彩搭配系统图像的优化输出,得到不同方法下的对比结果如图3所示。 图3 三维脸部表情动画场景色彩搭配输出 分析图3得知,本文方法进行数字媒体交互式三维脸部表情动画合成的输出质量较高,测试输出信噪比,得到对比结果见表1。 表1 输出信噪比测试 分析表1得知,本文方法进行数字媒体交互式三维脸部表情动画合成的输出信噪比较高,说明动画合成输出精度较高。 本文提出基于数字媒体技术的交互式三维脸部表情动画合成方法,采用多层次纹理映射方法构建三维人脸特征提取模型,然后对动画图像的三维信息进行特征提取,并建立模糊信息融合模型。采用正则化向量特征分解法实现对交互式三维脸部表情动画的合成,提高脸部表情动画的视觉图像表达能力。经实验研究得知,本文方法对交互式三维脸部表情动画合成的效果较好,输出结果质量较高。2.2 交互式三维脸部表情动画合成输出

3 仿真实验与结果分析

结语