面向机器人自主分割的肉品识别分类系统实现

2022-01-22冀晶晶刘佳豪刘雨婷

马 欢,冀晶晶,刘佳豪,刘雨婷

面向机器人自主分割的肉品识别分类系统实现

马 欢,冀晶晶,刘佳豪,刘雨婷

(华中科技大学数字制造装备与技术国家重点实验室,湖北 武汉 430074)

针对传统禽类肉品分割环节存在的人工成本突出、卫生安全风险高等世界性难题,集成精准感知、快速切块、自主剔骨等关键技术,设计了面向机器人自主分割的全自动化生产线工艺流程。基于自主分块环节形成的鸡胸肉、翅尖、翅中、翅根后续高效自动化分类包装需求,提出了一种结合图像像素个数和卷积神经网络(CNN)分类的识别方法,建立软硬件协同框架,以满足生产线上图片获取、处理和实时检测等功能要求。首先,利用提取肉品区域大小区分鸡胸肉和翅尖;然后,基于CNN技术识别翅中和翅根并进行分类;最后,通过对识别算法的参数量和计算量进行分析,估算软硬件协同处理的识别速度。搭建肉品识别系统平台,分析传送带全速运行下的运动模糊情况,采用数据增强的方式扩展数据集,为了减少计算量,仅采用R通道图像数据作为神经网络的输入。结果表明,鸡胸肉、翅尖的识别准确率达100%,翅中、翅根的识别准确率达98.7%,识别速度可达0.047 s,可满足禽类肉品10 000只/小时的高效分拣的研发需求。

机器人;分拣系统;自动化生产线;卷积神经网络;机器视觉

禽类肉品是人们餐桌上不可或缺的必需品,其消耗量巨大,禽肉尤其是鸡肉已成为世界第二大消费肉品。2020年我国禽肉产量2 361万吨,同比上年增加5.5%[1],预计到2030年需求将增加50%以上。禽类肉品的安全、高效生产加工是关乎民生的大事。

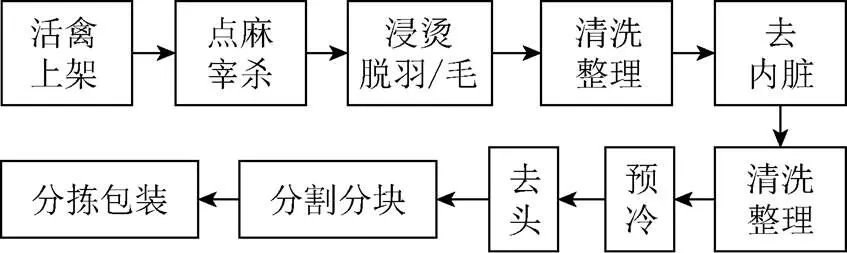

图1为禽类肉品加工生产线流程图。禽类屠宰流程包括活禽上架、电麻宰杀、浸烫脱羽、去头去爪、切肛掏膛、清洗整理、排酸预冷。当前屠宰环节除第一步需要人工将禽类双爪倒挂上架外,均已实现机械自动化。但紧接着的“分割分块”和“分拣包装”环节目前在全世界范围内仍属于人工密集型工种。分割行业突出的难题表现为:①禽类肉品分割劳动强度大,分割效率低;②禽胴体结构复杂,肉品损耗多,残次品数量大;③肉品分割工艺时间长,容易造成肉品二次污染。针对禽类肉品分割环节存在的卫生安全风险高、人工成本突出、产品不一致等世界性难题,结合机器人技术和计算机视觉技术,集成精准感知、快速切块、自主剔骨等关键技术,有望能够形成禽类肉品高效精准机器人自主分割生产线,实现禽类肉品生产加工的全产线无人化作业。

图1 禽类肉品加工生产线流程图

当前,国内外很多机构都对禽类肉品分割自动化展开了广泛地研究。如生产厂商方面,最具代表性的是荷兰的梅恩(MEYN),已经在屠宰分割环节全面铺设机械自动化装备,但在剔骨和精细分割环节,面临禽类胴体形体各异、生物软体组织刚度不均、分割骨肉界面材料特性复杂的难点,导致产品损耗率高,其对应设备的研发举步维艰。而机器人具有灵活性高、成本低、简单等特点,使得机器人和机器视觉的结合可以代替肉品加工中的手工操作[2],引起了国内外学者的广泛关注。位于美国佐治亚州的家禽最大产地佐治亚理工研究所率先尝试将机器人技术引入禽类肉品屠宰、分割、分拣等环节,进行相应的工艺探索和设备研发,其研发的自动剔骨机器人集成机器视觉、机器人技术、力反馈控制[3],先利用视觉系统识别鸡的3处特征点,然后基于鸡胴体几何和骨架的映射关系进行缩放,明确骨架位姿,确定入刀点和剔骨路径,最后结合机器人操作和力控技术进行剔骨路径修正,完成自动化剔骨流程,如图2所示[4]。JOFFE等[5]通过深度学习评估鸡胴体在箱子中姿态,并结合机器人和吸盘抓取器将鸡胴体抓取并放置在合适姿态。MISIMI等[6]设计了一种新颖的3D视觉引导的机器人GRIBBOT,用于鸡肉片的抓取。ADAMCZAK等[7]提出了一种基于三维扫描的鸡胸肉质量估算方法,便于机器人个性化处理鸡胴体,有利于提高产品价值。CHEN等[8]结合机器视觉和机器人技术实现禽类内脏的自动切除。

图2 禽类肉品机器人自主加工示意图[4]

上述研究结合机器人和机器视觉技术,有望实现对肉品分割中单一环节的无人化操作。然而,肉品分割是一个多环节流程,通过对肉品分割全流程的分析,有利于将机器人技术、机器视觉技术同已有的全自动屠宰工艺进行有机的结合,实现全自动化肉品分割流程。基于此,本文设计了一种禽类肉品机器人自主分割生产线工艺流程,并针对自主分块环节所产生的多类肉品混合的状态下满足10 000只/小时产线速度进行分类包装的需求,受深度学习在工业生产领域应用的启发[9-10],提出了一种结合图像处理预分类和卷积神经网络(convolutional neural network,CNN)技术识别分类方法,通过对识别准确率、识别速度的分析,说明了其实际应用的可行性。

1 肉品识别分类算法及软硬件协同

结合中国市场对于禽类肉品的实际需求,设计面向机器人自主分割无人化作业生产线的工艺流程(图3)。流程承接已有的屠宰自动化产线,始于去头去爪去内脏的鸡胴体,最终形成市场导向的翅尖、翅中、翅根、鸡胸肉、完成剔骨的鸡腿肉及鸡架。该工艺流程由机器人抓取配合、拉扯、分块、剔骨及分类分拣包装5部分组成。

本文主要基于光学测量手段和图像处理方法,进行分拣包装前的肉品分类识别(图3中的红色框图)。分块专用机器人对翅胸一体(butterfly)的翅尖、翅中、翅根、鸡胸肉依次进行分割后,肉品随即落至传送带被输送至下一工位,可避免肉品重叠干扰,也有利于后续对肉品进行质量检测。并将条分块产线汇集到同一条分拣产线,以协同产线运行节拍,节约产线搭建成本;但产线速度快(一般为10 000只/小时),软硬件集成要求高,使得分类算法必须尽可能简单,且实时性应用对硬件提出算法加速要求。

图3 禽类肉品机器人自主分割生产线工艺流程图

1.1 基于像素个数和特征提取的肉品识别分类算法

本文基于图像处理技术,提出了基于像素个数的肉品分类方法,通过阈值对待测物区域的像素点数进行判断,实现翅尖和鸡胸的区分,然而,该方法难以识别像素大小相近的翅中和翅根。CNN方式通过低层级网络提取边角特征,深层级网络识别高级特征形状,有利于区分不同形状的肉品,然而为了提升准确率,往往需要很大的数据集。本文通过结合基于像素个数和基于CNN特征提取的分类方法,在减少数据量的同时,保证了比较高的准确率,同时满足了生产线应用的实时性要求,算法流程如图4所示。

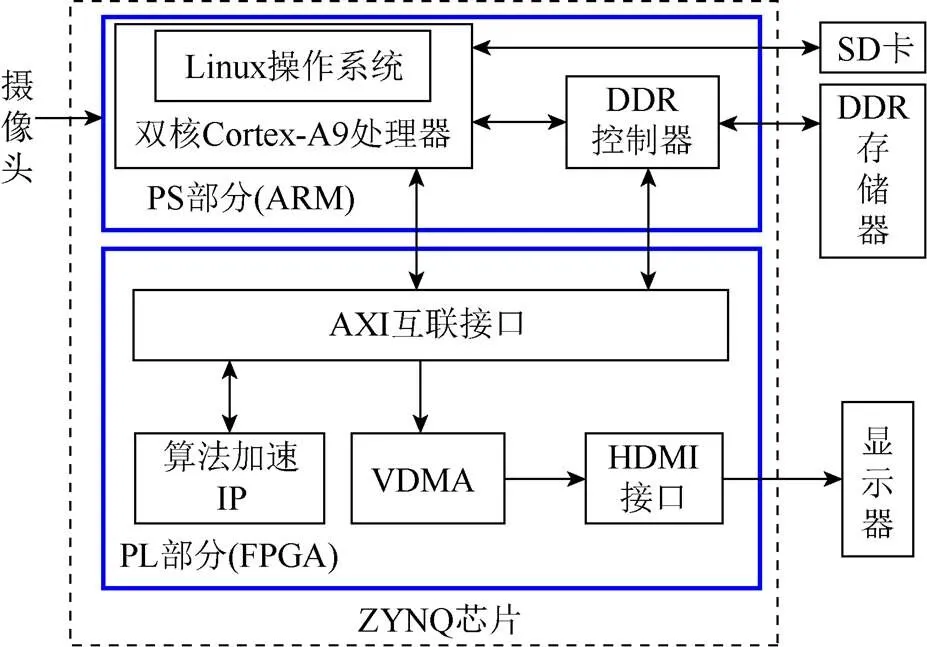

1.2 软硬件协同

为了实现产线上图片的获取、处理和检测等功能,需要进行软硬件协同。考虑到功耗、设备体积、实时性等因素,本文选取ZNYQ平台进行软硬件系统的设计,实现对算法的硬件加速。ZNYQ芯片包括处理系统(PS)端和可编程逻辑(PL)端,其兼具这2部分各自优点,既容易实现串行化控制,又容易实现算法的加速处理。为了能够结合这2部分各自的特点,本文采用图5的软硬件协同架构,初始输入数据为摄像头捕获的原始图像数据,通过SD读取识别算法的相关参数,利用处理系统(PS)部分进行图像处理。经AXI互联接口传入到可编程逻辑(PL)部分,进行CNN硬件加速运算,然后将处理结果先缓存到VDMA,最后经HDMI接口在显示屏上显示。同时,分拣执行器根据识别的肉品类别进行相应的分类包装。

图4 基于像素个数和CNN特征的分类算法

图5 基于ZYNQ芯片的图像分类识别平台

2 实验搭建及数据集获取

图像处理手段由于简单、高效,是生产线目标对象识别分类的首选方法,但禽类肉品个体差异很大、摆放位姿形态各异,使得单纯基于像素灰度图像处理的方式存在一定的局限性,在此基础上本文结合CNN训练方法,搭建软硬件平台,进行翅尖、翅中、翅根、鸡胸肉识别分类。

2.1 肉品识别系统的硬件组成

肉品识别系统的硬件结构主要由传送、图像采集、照明模块和图像处理4模块组成。搭建的实验装置如图6所示。

图6 肉品识别系统的硬件组成

传送模块由可变速传送带组成,速度可调区间为0~8 m/min,用于研究分析不同传送速度下不同的去模糊算法效果、肉片识别分类准确率。图像采集模块由漫反射光电触发器、CMOS相机(频率为120 Hz)组成,肉品从传送带左侧向右移动,待肉品达到漫反射光电触发器检测区域处,触发器由ZYNQ-7020芯片将触发信号传递给CMOS相机,从而获得清晰肉品图片。照明模块由漫反射LED圆顶光源、遮光罩和电源组成,遮光罩有助于抑制外界环境光照的影响,提高图片品质,其设定的合适光照强度可用于分类识别。

2.2 训练数据集获取

为了建立一个用于测试肉品识别分类系统的图像数据库,购买了白羽鸡翅尖1 kg、翅中3 kg、翅根4 kg、鸡胸肉2 kg,对应数量分别为84个、60个、60个、8个。每次将肉品放置在CMOS相机观测的图像区域正中央(也是漫反射器感知区域),调节光照强度尽可能使图像清晰,为了获得更多的图像数据,分别对肉品在正面、翻转2种情况进行拍摄。

3 图像识别算法流程

首先观察实验平台全速运行和静态情况下相机捕捉的图像差异,优化相机的曝光值,以采集清晰的图像,然后根据获取的翅尖、翅中、翅根、鸡胸肉的图像数据特点,可采用基于像素大小的预分类和基于CNN识别分类相结合的方式,来提高肉品识别的准确率。

3.1 产线图像的获取

由于流水线上的物体是运动的,如果相机参数设置的不合理,将影响图像质量及后续图像处理和分析。过低的曝光值易引起图像亮度低、噪声大,而过高的曝光值易引起运动模糊。对现有平台全速运行(8 m/min),通过将白平衡设定为自动,曝光绝对值设定为44,获得的翅中静态和动态对比效果如图7所示。可以发现,现有平台下运动模糊的影响较小。

图7 翅中静态图像和动态图像对比((a)静态图像; (b)动态图像)

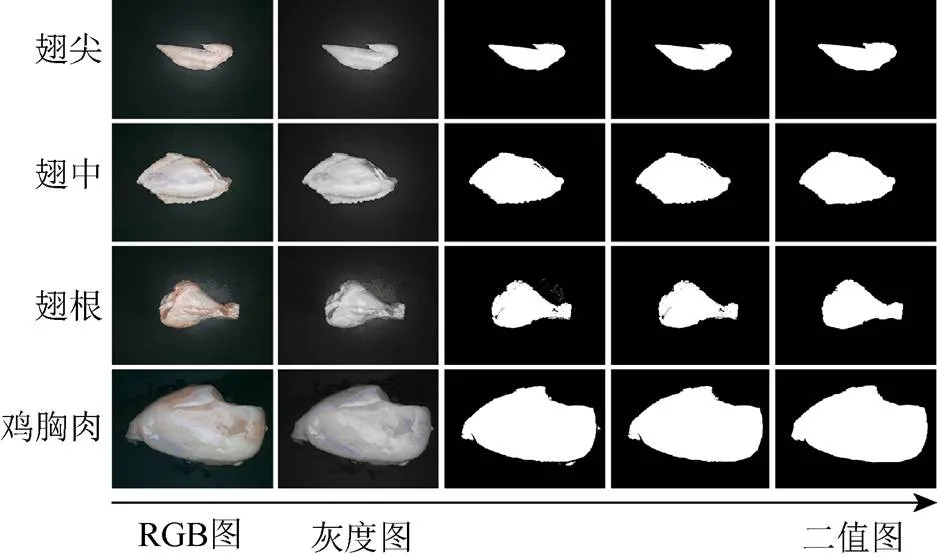

3.2 基于像素个数的预分类

预分类流程如图8所示。首先,将拍摄的RGB图像转换灰度图,然后设定合适的灰度阈值,以保证二值化处理能获得清晰的肉品区域信息(图8第3列),进一步去除代表噪声信息的小连通域(图8第4列),采用膨胀算法获得单一简单连通区域(图8第5列)。对连通域亮点进行计数,从而获得肉品所占的图像区域大小。

图8 预分类处理过程

3.3 CNN分类手段

本文用于提取肉品特征的CNN网络模型的结构如图9所示。为了减少计算量,仅采用单通道的图像数据作为神经网络的输入,模型的输入层像素大小为64×48的R通道数据,输出层对应翅中、翅根2种分类结果。卷积层和第一层全连接层采用非线性激活函数ReLU,输出层采用常用于分类的激活函数SoftMax。网络共包括2个卷积层、2个池化层、1个全连接层。卷积核的大小f1和f2均为3,卷积核数n1和n2均为4,扫描步长s1和s2均为1,padding形式采用‘same’,大小分别为p1和p2。池化层的大小f1和f2均为2,扫描步长s1和s2均为1,padding的形式采用‘valid’,大小分别为p1和p2。将池化层2得到的结果展开为一维数组,全连接层单位数1为15个,输出层类别数2为2个。

图9 CNN模型示意图

4 实验结果及分析

4.1 基于像素个数的预分类结果

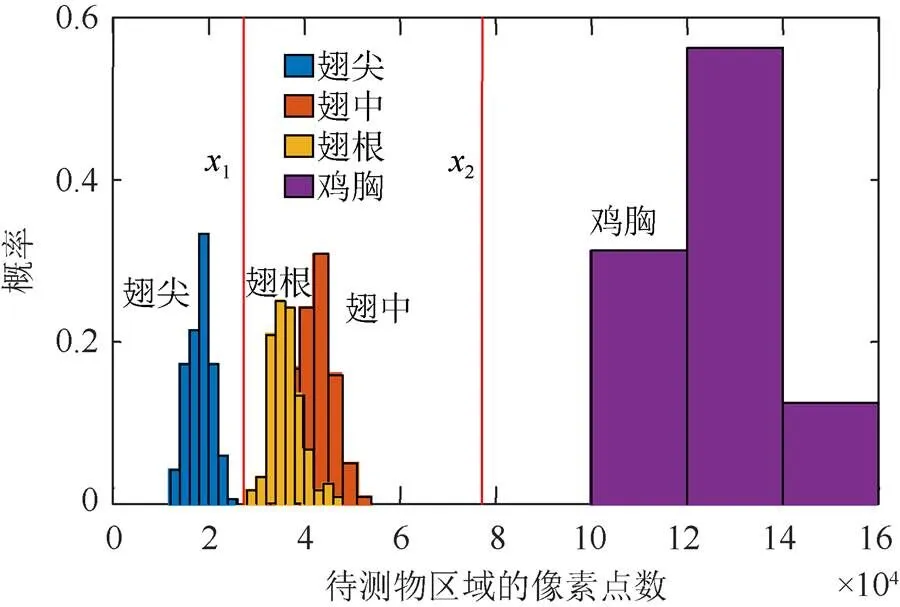

图10为翅尖、翅中、翅根、鸡胸肉在基于肉品区域像素个数下的概率直方统计图。横坐标为利用图像处理获得的肉品区域像素个数,纵坐标为各肉品在对应像素下分布的概率。可以发现:

(1) 鸡胸肉面积最大,翅尖面积最小,通过设定阈值1和2可区分翅尖和鸡胸肉;

(2) 4类肉品像素个数范围均跨度较大是由于鸡胴体的个体差异性所导致;

(3) 翅中和翅根的重合区域较大难以区分(图10橙红色和黄色色块相交部分),因此对于翅中、翅根,仅利用设定像素个数阈值难以区分。对这2种肉品需要进一步采用CNN网络模型区分。

图10 基于像素个数的预分类处理结果

4.2 基于CNN的分类结果

本文采用Tensorflow1.9.0开源深度学习框架进行CNN模型的搭建和训练,软件环境采用Python3.6。每层网络权重参数以高斯分布初始化,均值为0,标准差为0.1,偏差初始值为0.1,Adam学习率参数设置为0.000 1;操作系统为Windows 10,处理器为Intel(R) Core(TM) i5-10400 CPU @ 2.90 GHz,内存为16 G。为了减少数据采集的时间,将拍摄的图像采用数据增强的手段(图像转、旋转)来获得大量的数据集,选取翅中、翅根图片各120张,首先提取R通道的数据,然后将图像缩放到64×48像素大小,再采用Matlab软件中的flip函数进行左右翻转,imrotate函数随机旋转12次,因此最终获得翅尖、翅中、翅根各5 760张图像。为了使旋转后的图像更接近实际,对图片边缘的黑色区域用背景色取代。将数据集随机混合,并按照70%﹕30%比例分为训练集和交叉验证集,利用训练集每次迭代获得的网络参数分类交叉验证集。

对混有翅中、翅根的数据集进行训练,minibatch的大小为128个,遍历数epoch为968次,因此网络参数的迭代次数共124 000次,训练过程如图11所示,可以发现:随着迭代次数增多,训练集和验证集的准确率都可超过95%。

图11 卷积神经网络的训练((a)损失函数值的变化;(b)准确率的变化)

对训练次数区间(123000,124000]内的CNN正确率进行统计计算,有如下发现:

(1) 通过鸡胸肉和翅尖通过区域像素个数阈值判断可完成分类,其识别准确率可达100%;

(2) 对于翅中和翅尖,采用CNN分类的方式,在一般网络架构下,可达到98.7%的准确率,接近人工识别效果。

4.3 各种方法计算复杂度及硬件处理时间分析

设计CNN网络时,需考虑计算量、参数量及对应的准确率。计算量决定硬件处理时间,参数量决定设备所需的计算内存。本文计算量以计算乘法次数为单元,参数量内存占用以权重参数量为单位进行估算,特征图内存占用以网络中每层的输出图像素之和为单位。以图9中的CNN网络为例:

(1) 乘法次数计算为

(2) 参数量占用内存计算为

(3) 特征图内存占用计算为

根据采用ZYNQ-7020芯片进行颗粒状农作物分类软硬件协作的实验研究[11]的实验结果,以其CNN网络架构中的乘法运算量、参数量内存占用、特征图内存占用为基准(1,1,1),对应2.24×106,6.36×104和3.50×104,则本文中R通道图的对应比例为(0.10,0.18,0.57)。在该CNN网络结构下,计算量和内存占用差异较小。由基准网络架构下软硬件协同测试时间为0.469 s,可估算本文采用的CNN网络分类识别速度可达0.047 s,通过增加分拣产线以将肉品分流或改进CNN网络架构以提升识别速度的方式,可满足10 000只/小时的工业生产需求。

5 结 论

针对禽类肉品分割环节存在的人工成本突出、卫生安全风险高等难题,提出了机器人自主分割的生产线工艺流程,其集成精准感知、快速切块、自主剔骨等关键技术,由机器人抓取配合、拉扯操作、分块、剔骨、分类分拣包装流程组成,实现禽类肉品全自动化加工。提出了一种结合图像处理与CNN网络的分类手段快速精准识别翅尖、翅中、翅根及鸡胸肉,有利于实现机器人快速分拣。搭建简易的工业禽类肉品分类平台,采用数据增强的方式增大数据集。基于像素个数的预分类方式能100%识别鸡胸肉和翅尖;考虑到禽类肉品生产线的快速生产和低能耗需求,仅选用R通道的图像进行训练基于CNN网络的分类方式能很好地识别翅中、翅根,识别准确率分别可达98.7%,后续可采用模型剪枝、量化、轻量级模型设计等模型压缩方式,减少模型参数量和计算量,进一步提高模型准确率和计算速度。在实际生产过程中,可能存在传送带上残留物的干扰、肉品间间距较小等情况。下一步对残留物干扰情况下的肉品识别效果进行研究分析,结合图像分割和识别算法对包含多肉品的图像进行分析,并将图像识别算法植入ZNYQ芯片中进行实际应用。

[1] 李锁强. 粮食生产再获丰收生猪生产较快恢复[EB/OL]. (2021-01-19) [2021-02-28]. http://www.stats.gov.cn/tjsj/sjjd/ 202101/t20210119_1812637.html.

LI S Q. Grain production regained good harvest and pig production recovered quickly[EB/OL]. (2021-01-19) [2021-02-28]. http://www.stats.gov.cn/tjsj/sjjd/202101/t20210119_1812637.html (in Chinese).

[2] BARBUT S. Meat industry 4.0: a distant future?[J]. Animal Frontiers, 2020, 10(4): 38-47.

[3] HU A P, BAILEY J, MATTHEWS M, et al. Intelligent automation of bird deboning[C]//2012 IEEE/ASME International Conference on Advanced Intelligent Mechatronics (AIM). New York: IEEE Press, 2012: 286-291.

[4] DYER N. How it works: the robotic chicken butcher[EB/OL]. (2013-04-05) [2021-02-28]. https://www. popsci.com/technology/article/2013-03/robotic-chicken-butcher/?src=SOC&dom=pin.

[5] JOFFE B, WALKER T, GOURDON R, et al. Pose estimation and bin picking for deformable products[J]. IFAC-PapersOnLine, 2019, 52(30): 361-366.

[6] MISIMI E, ØYE E R, EILERTSEN A, et al. GRIBBOT – Robotic 3D vision-guided harvesting of chicken fillets[J]. Computers and Electronics in Agriculture, 2016, 121: 84-100.

[7] ADAMCZAK L, CHMIEL M, FLOROWSKI T, et al. The use of 3D scanning to determine the weight of the chicken breast[J]. Computers and Electronics in Agriculture, 2018, 155: 394-399.

[8] CHEN Y, WANG S, BI J, et al. Study on visual positioning and evaluation of automatic evisceration system of chicken[J]. Food and Bioproducts Processing, 2020, 124: 222-232.

[9] 石志良, 张鹏飞, 李晓垚. 基于SIFT-SVM的发动机主轴承盖识别与分类[J]. 图学学报, 2020, 41(3): 382-389.

SHI Z L, ZHANG P F, LI X Y. Classification of engine main bearing cap parts using SIFT-SVM method[J]. Journal of Graphics, 2020, 41(3): 382-389 (in Chinese).

[10] QIU L T, WU X J, YU Z Y. A high-efficiency fully convolutional networks for pixel-wise surface defect detection[J]. IEEE Access, 2019, 7: 15884-15893.

[11] 朱江波. 基于嵌入式平台的颗粒状农作物图像分类算法研究[D]. 哈尔滨: 哈尔滨工业大学, 2019.

ZHU J B. Research on image classification algorithm of granular crops based on embedded platform[D]. Harbin: Harbin Institute of Technology, 2019 (in Chinese).

Implementation of meat classification system for autonomous robotic cutting

MA Huan, JI Jing-jing, LIU Jia-hao, LIU Yu-ting

(State Key Laboratory of Digital Manufacturing Equipment and Technology, Huazhong University of Science and Technology, Wuhan Hubei 430074, China)

To solve the worldwide problems in the traditional poultry meat cutting process, including high labor costs, high safety risks, and other global problems, a robot autonomous cutting production line system was designed by integrating the key technologies such as accurate perception, rapid cutting, and autonomous deboning. To meet the requirements of efficient automatic classification and packaging for chicken breasts and wings (including wing tip, middle joint, and root) produced in the autonomous cutting process, a new recognition method combining image processing, convolutional neural network (CNN) classification, and the hardware/software collaborative framework was proposed, aiming to achieve the function integration and real-time requirements of image acquisition, processing, and detection. Firstly, the meat area was extracted to distinguish chicken breast and wing tip; secondly, the wing middle and root were classified based on CNN technology; finally, the recognition speed via software/hardware cooperation was estimated by parameter and computational efficiency analysis in the recognition algorithm. With the meat identification system platform built, the motion blur of the conveyor belt at full speed was analyzed, and the data set was expanded by data enhancement. In order to reduce the amount of computation, only the image data of R channel was used as the input of neural network. The results show that the recognition accuracy of chicken breast and wing tip can reach 100%, and that of wing middle and root can reach 98.7%, with recognition speed of 0.047 seconds, which could meet the research and development needs of efficient sorting of 10,000 poultries per hour for future work.

robot; sorting system; automated production line; convolution neural network; machine vision

TP 391.4

10.11996/JG.j.2095-302X.2021060924

A

2095-302X(2021)06-0924-07

2021-03-01;

2021-06-07

国家重点研发计划项目(2019YFB1311005);国家自然科学基金项目(52175510)

马 欢(1996-),男,湖北仙桃人,博士研究生。主要研究方向为数字图像处理、深度学习和触觉传感器。E-mail:huanm@hust.edu.cn

冀晶晶(1987–),女,山西平遥人,副教授,博士。主要研究方向为机器人与自动化过程中的感知与物理场重构。E-mail:jijingjing@hust.edu.cn

1 March,2021;

7 June,2021

National Key Research and Development Program of China (2019YFB1311005); National Natural Science Foundation of China (52175510)

MA Huan (1996-), male, PhD candidate. His main research interests cover digital image processing, deep learning, and tactile sensor. E-mail:huanm@hust.edu.cn

JI Jing-jing (1987-), female, associate professor, Ph.D. Her main research interests cover perception and physical field reconstruction in robotics and automation. E-mail:jijingjing@hust.edu.cn