多空间协同进化的自然计算方法

2022-01-21孙小晴季伟东徐浩天

孙小晴,季伟东,林 平,徐浩天

1(哈尔滨师范大学 计算机科学与信息工程学院,哈尔滨 150025)2(哈尔滨医科大学,哈尔滨 150086)

1 引 言

自然计算(Natural Computation)是智能算法中的一个术语,它包含3种方法:

1)从自然种群进化中汲取灵感,从而发现新的问题解决方法;

2)基于利用计算机分析自然现象的方法;

3)利用自然材料(例如分子)进行计算的方法.

构成这3个分支的主要研究领域是人工神经网络、进化算法、群体智能、人工免疫系统、分形几何、人造生命、DNA计算和量子计算等[1].

基于种群的自然计算方法是模拟自然界生物进化机理的群智能优化算法.随着群智能算法种类的增长,其改进算法也呈指数增长,因此,寻找一种不针对具体算法且具有普适意义的改进策略是目前自然计算领域研究的热点.在改进策略中,种群管理对算法的搜索性能有较大的影响.2019年杜永兆等人[2]提出了一种多种群协方差学习的差分进化算法,该算法将每一子种群赋予不同的变异策略,从而提高种群的多样性,子种群之间通过协方差学习,建立一个沟通的桥梁.刘彬等人[3]针对遗传算法的种群多样性和局部搜索能力差的问题,提出了多种群遗传算法,多种群遗传算法具有运行时间短,搜索能力强的优点.申雨轩等人[4]提出了变搜索区域的多种群遗传算法,采用种群搜索区域自适应变化策略逐渐缩小搜索范围,降低空间搜索消耗,提高搜索效率和最优解精度.刘小龙[5]提出了改进多元宇宙算法求解大规模实值优化问题,解决了代间宇宙信息沟通问题.孙辉等人[6]提出了一种混合均值中心反向学习粒子群优化算法,该算法对混合均值中心进行反向学习,从而使得粒子探索更多搜索区域.在多种群方面,邓先礼等人[7]提出了一种基于多种群的自适应迁移PSO算法,每个子种群采用不同的加速因子,并通过历史评估来指导个体迁移,从而实现种群间的协作.针对大规模优化问题,梁静等人[8]提出了协同进化动态粒子群优化算法,将此策略加入到动态多种群粒子群优化算法中,实验效果显著提升.夏学文等人[9]提出了多尺度选择性学习和探测-收缩机制的PSO算法,粒子不仅能够根据自身状态在多个尺度自适应选择,而且利用历史信息指导种群逃离局部最优.Yuhua Li等人[10]提出了一种信息共享机制,使得粒子之间的相互作用就得到了充分的增强,大大提高了它们的搜索整个群体的信息能力.2014年M.R.Tanweer等人[11]提出了一种自调节粒子群优化算法(Self Regulating Particle Swarm Optimization,简称SRPSO),该算法能够根据当前粒子的现状和对其他粒子最佳经验的感知,从而调整搜索方向,充分利用群体信息,以最佳效果寻找最优解.李朝华等人[12]则是将适应度值好的粒子组成精英粒子群,普通种群与精英种群协同进化,实现种群功能分配,以更好的收敛精度和收敛速度进行全局搜索.Xin Jin等人[13]提出了基于距离的维数选择算法,该算法这对大规模群体具有显著优势.胡成玉等人[14]提出了多种群协同的动态多目标粒子群算法,该算法同时利用多种群的竞争协作关系,从而更好的求解多目标问题.蔡良伟等人[15]提出了多种群遗传算法,多个种群直接通过相互竞争和优良个体共享,从而提高资源利用率,克服个体早熟,提高收敛性能.文献[16]提出了自适应动态控制种群分组的自然计算方法,该方法采用高斯函数,拟合粒子运动曲线,从而达到自适应分组的目的.

在这些方法中,收敛速度和全局最优的问题依然是一直在探索的关键问题.种群规模大,全局搜索能力较强,但收敛速度就会降低,同时还会增加运行负荷;种群规模小会减少运行时间,收敛速度较快,但全局搜索能力又会下降,对于多峰问题极易陷入局部最优,导致算法早熟[17].因此,找到一个恰当的处理种群规模的问题对自然计算方法就显得格外重要.

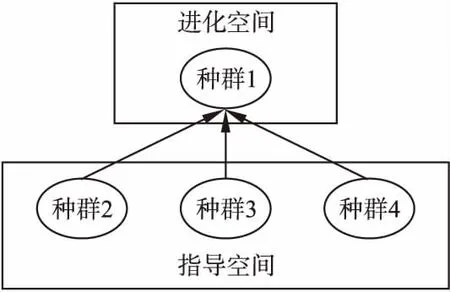

为了解决这一问题,本文提出了一种具有普适意义的多空间协同进化(Multispace Coevolution,MSC)的自然计算方法,该方法与具体的进化算法无关,因而适用于各种基于种群优化的自然计算方法.MSC自然计算方法的子种群分为指导空间和进化空间,进化空间根据指导空间传递信息而进化.将该策略应用到3种不同的自然计算方法中,使用不同的测试函数来验证该策略的普适应和有效性.

2 协同进化

在MSC自然计算方法中,不是所有的粒子都同时进化,而是有先后顺序,指导空间对进化空间进行有意义指导,两个 空间协同进化.如图1所示.大种群随机划分为多个小种群.

图1 子种群分组Fig.1 Sub population grouping

指导空间有多个不同的等规模的小种群,不同的小种群之间互不干扰,各自进化,并且按照原始的自然计算方法或者改进的方法进化,对于不同的自然计算方法会得到不同的信息传递方式,即指导空间如何将关于进化方向的信息传递给进化空间.本文以粒子群和遗传算法为例,粒子群算法的空间信息传递方式是速度和适应度值,遗传算法的空间信息传递方式是最优个体适应度值,对进化空间进行有意义搜索,更快的找到全局最优解.

2.1 指导空间

指导空间(Guiding space)是由个体的行为特征组成的信息单元,是群体的全局信息知识库.指导空间中的信息是每个子种群的行为经验概括所得.然而,概括绝不是一代或者几代所积累形成的,而是成百上千代的集合,每一代的经验值都对进化空间的对应进化代产生影响,从而指导其进化的方向.指导空间的进化方式依然按照原算法进化.

指导空间中的小种群数目可以有多个,本文以分为3个子种群为例,每个子种群作为一个信息单元为进化空间传送信息.因此,在指导空间和进化空间之间需要通信方式,该通信方式指定了一些操作,不同的群体智能算法因需要指定不同的操作,本文以粒子群和遗传算法为例,粒子群算法采用的是每个子种群中最优个体的适应度值和速度作为空间信息传递方式,遗传算法采用的是指导空间每个子种群的最优个体替代进化空间适应度最劣的3个个体.

2.2 进化空间

进化空间(Evolutionary space)由另外剩余的小种群构成.进化空间中小种群的数量一般为1个,小种群的粒子数目可以和指导空间小种群数目相等也可以不相等.进化空间通过空间信息传递方式得到指导空间的信息,利用这些信息指导进化朝着最优解的方向进化.

进化空间与指导空间的不同之处在于:其一,指导空间利用原算法的进化方式进化,而进化空间则是在原算法中加入指导空间所传递的信息从而达到进化的目的;其二,大种群分为若干个个数相等的子种群,其中1个子种群作为进化空间单元,剩余作为指导空间单元;其三,指导空间要为进化空间提供有关进化方向的信息,即通信方式,这些通信方式或者是速度或者是位移或者是最优值等等,根据具体的算法选择合适的通信方式.

2.3 算法流程

多空间协同进化的自然计算方法首先初始化种群的个体数目Size和选取算法的参数;然后,划分子种群,并且给子种群分组,一组是指导空间,另一组是进化空间;接着,指导空间的小种群按照原算法进化规则进化,并保留经验概括所得的通信方式;最后,进化空间根据信息传递方式,在原算法基础上进化.算法1是本文所提策略的伪码表示.

算法1.MSC策略.

Step 1.初始化种群的数目Size,以及相应算法的参数;

Step 2.划分子种群Sizei(i=1,2,…,m).Sizej(j=1,2,…,m-1)作为指导空间小种群,Sizem作为进化空间小种群;

Step 3.FNs=1;

Step 4.指导空间小种群进化,并计算适应度值;

Step 5.根据适应度值获得通信信息Infj(j=1,2,…,m-1);

Step 6.进化空间小种群根据Infj(j=1,2,…,m-1)进化,并计算适应度值;

Step 7.FNs = FNs + 1;

Step 8.判断是否满足终止条件,若不满足,转Step 4,若满足,转Step 9;

Step 9.结束.

3 试验及仿真测试

实验仿真平台为Window7,Matlab2019b.本实验把MSC策略分别应用到标准遗传算法(GA)[18]、标准粒子群算法(PSO)[19]和改进的粒子群算法EXPPSO(Exponential Decay Weight PSO)[20]中,得到MSCGA算法、MSCPSO算法和MSCEXPPSO算法,并与标准遗传算法、标准粒子群算法和7个关于种群规模算法[2,3,4,7,10,11,13]做对比实验.

近年来,优化高维函数已经成为优化算法领域的研究热点.本实验采用国际通用的12个标准高维测试函数:F1~F12(如表1所示).F1~F4、F11、F12是高维单峰函数,仅有一个全局最优点;F5~F7、F9、F10是高维多峰函数,这些测试函数具有许多局部最优点,是优化界中较难优化的函数.这些测试函数的全局最优值为0,F8的维数不能少于4维,且全局最小值和维数有关.由于部分测试函数有多个最优点,因此,在寻优过程中极易陷入局部最优.

表1 标准测试函数

Table 1 Benchmark functions

测试函数维数可行解空间F1=∑Di=1xi21000[-100,100]nF2=∑D-1i=1[100(xi+1-x2i)2+(xi-1)2]1000[-5,10]nF3=(x1-1)2+∑Di=1i*(2xi2-xi-1)21000[-10,10]nF4=∑Di=1|xi|i+11000[-1,1]nF5=-a*exp-b1D∑Di=1xi2 -exp1D∑Di=1cos(cxi) +a+exp(1)a=20,b=0.2,c=2π1000[-32.768,32.768]nF6=∑Di=1(xi2-10*cos(2*π*xi)+10)1000[-5.12,5.12]nF7=∑Di=1xi24000-∏Di=1cosxii +11000[-600,600]nF8=∑D/4i=1[(x4i-3+10x4i-2)2+5(x4i-1-x4i)2+(x4i-2-2x4i-1)4+10(x4i-3-x4i)4]1000[-4,5]nF9=sin2(πω1)+∑D-1i=1(ωi-1)2[1+10sin2(πωi+1)]+(ωD-1)2[1+sin2(2πωD)]ωi=1+ωi-141000[-10,10]nF10=418.9829D-∑Di=1xisin(|xi|)1000[-500,500]nF11=∑Di=1ix2i1000[-10,10]nF12=∑Di=1x2i+(∑Di=10.5ixi)2+(∑Di=10.5ixi)41000[-5,10]n

3.1 粒子群相关实验对比

3.1.1 MSC策略与相关粒子群算法的实验结果分析

实验中,PSO、MSCPSO、EXPPSO和MSCEXPPSO的参数设置为:维数D=1000,种群规模均为Size=50,应用MSC策略的指导空间每个子种群规模Sizei=10(i=1,2,3),进化空间子种群规模size=20,学习因子c1=c2=2,惯性权重ωmax=0.9,ωmin=0.4,指数衰减参数e=2.71828.每个算法独立运行20次,进化迭代1000次.在进化过程中,本文提出新的速度更新公式.MSCPSO的进化空间速度使用公式(1),MSCEXPPSO的进化空间速度使用公式(2),其他参数在迭代过程中不会发生改变.PSO和MSCPSO的指导空间使用速度及位移公式(3),EXPPSO和MSCEXPPSO的指导空间使用速度及位移公式(4).

vt+1=w*(1/f1*v1+1/f2*v2+1/f3*v3)+c1*r1(pbest-x)+c2*r2(gbest-x)

(1)

vt+1=e-1*(1/f1*v1+1/f2*v2+1/f3*v3)+c1*r1(pbest-x)+c2*r2(gbest-x)

(2)

(3)

(4)

其中,f1,f2,f3分别是指导空间3个小种群的最佳适应度值;v1、v2、v3分别是指导空间3个小种群中最佳粒子对应的速度;pbest和gbest代表进化空间的个体最优和群体最优.

各算法对12个测试函数分别执行20次,其平均结果及标准方差如表2所示.在优化这12个测试函数时,MSCPSO算法和MSCEXPPSO算法较PSO算法和EXPPSO算法相比,在大部分测试函数中都能够接近全局最优,尤其是在测试函数F4、F5、F7上,MSCPSO算法和MSCEXPPSO算法在误差允许的范围内已找到全局最优解.与PSO和EXPPSO相比,MSCPSO算法和MSCEXPPSO算法的标准方差远低于其他算法.

表2 各PSO算法对12个标准测试函数优化结果

Table 2 Optimization results of each PSO algorithm for 12 benchmark functions

PSOMSCPSOEXPPSOMSCEXPPSOF14.7408e+05±6.0567e+04956.7405±537.71295.2279e+05±5.9804e+04934.7853±568.2368F26.8907e+06±1.0109e+062.0748e+05±2.2986e+048.4306e+06±1.5060e+062.1517e+05±2.1297e+04F31.1270e+08±2.1186e+076.3175e+03±4.5550e+031.3970e+08±3.0455e+076.6451e+03±5.5013e+03F42.4810e-07±6.6946e-070.0125± 0.03491.4728e-05±1.8879e-050.0588±0.0569F517.2093±0.48123.2987±0.763117.1461±0.36233.1378±0.5346F69.7236e+03±467.2895636.1493±406.70261.0717e+04±201.7529509.1434±255.0011F74.3360e+03±384.38178.0635±3.97364.5950e+03±505.400011.1476±5.2572F89.3610e+04±1.6402e+04529.9684±132.32701.1438e+05±1.5873e+04489.4651±172.9301F91.7026e+04±1.5059e+0398.1293±12.67282.0139e+04±1.6469e+03101.6254±12.6604F103.4472e+05±7.7329e+033.9481e+05±2.3389e+033.8024e+05±3.8340e+033.9321e+05±3.6025e+03F112.2562e+06±1.5279e+054.4887e+03±2.6061e+032.5115e+06±2.8375e+055.1138e+03±2.0446e+03F121.2171e+04±3.0807e+031.0767e+06±3.5088e+066.9048e+03±2.0376e+031.9944e+05±4.2817e+05

图2 各PSO算法对12个标准测试函数优化的收敛曲线Fig.2 Convergence curves of PSO algorithms for 12 benchmark functions

图2是各PSO算法在12个测试函数F1~F12的收敛比较图.横轴代表进化次数,纵轴代表平均适应度值.从图中可以清楚的看到,使用多空间协同进化策略的算法比未使用该策略的算法具有更好的寻优能力.

根据收敛曲线走势可以清晰的观察到,MSCPSO和MSCEXPPSO在测试函数F1,F2,F3,F5,F6,F7,F8,F9,F11中平均大概进化200次左右,函数曲线保持水平,不再有下降趋势,说明算法陷入局部最优,这是PSO算法本身的性质所决定的;而PSO和EXPPSO在上述测试函数中大概进化至50代左右,算法陷入局部最优,说明应用MSC策略之后,算法具有了更好的全局搜索能力.但在测试函数F4和F10中,MSCPSO和MSCEXPPS的寻优效果远不及PSO和EXPPSO,这是由于F4是一个连续但不可微的函数,因此分种群后指导空间的种群不能为进化空间提供较优的指导方向;F10是一个功能复杂且有许多局部最小值,因此,极易使算法陷入局部最优.

3.1.2 MSCPSO与其他4个算法的实验分析结果

维度选择的距离粒子群优化算法(PSO with distance based dimension selection,简称PSODDS)[13]、具有信息共享机制的竞争与合作粒子群算法(the competitive and cooperative PSO with information sharing mechanism,简称CCPSO-ISM)[10]、自调节粒子群算法(Self Regulating Particle Swarm Optimization,简称SRPSO)[11]和多种群的自适应迁移 PSO 算法(Multi-population based self-adaptive migration PSO,简称MSMPSO)[7],这4个算法都是对种群规模以及粒子维度进行优化的最新且具有代表性的算法.为了与这4个算法参数设置一致,MSCPSO的种群规模是30个粒子,每个粒子30维,迭代进化10000次,实验重复30次取平均值.“-”表示算 法在指定测试函数中参考文献没有数据,结果如表3所示.

表3 MSCPSO与其他种群优化算法在30维时的实验结果对比

Table 3 Comparison of experimental results between MSCPSO and other population optimization algorithms in 30 dimensions

PSODDSCCPSO-ISMSRPSOMSMPSOMSCPSOF18.45e+01±1.46e+023.78e-11±6.58e-111.31e+02±2.01e+024.5441±2.52343.7256±3.2303F26.05e+01±2.95e+006.37e+01±2.32e+016.95e+01±1.90e+0156.6348±39.07651.641±1.0634F3---5.4099±3.01401.6646±0.5473F4---6.51e-10±7.95e-100.0141±0.0094F52.09e+01±4.61e-022.09e+01±4.06e-022.10e+01±2.91e-023.9791±0.67313.0145±0.4534F61.62e+02±3.56e+013.91e+01±1.34e+015.60e+01±1.46e+0135.6772±8.79812.9239± 1.5589F77.63e+01±4.89e+011.17e-01±4.60e-029.07e+01±6.78e+011.0018±0.11011.3903±0.1790F8---1.1871±0.68001.1393±0.9634F9---1.1053±0.56042.6253±0.2563F102.00e+03±4.55e+021.40e+03±3.17e+021.37e+03±2.20e+024.7109e+03±949.34517.6800e+03±594.6053F11---2.0574±1.65790.8960±0.5266F12---1.6954±0.797016.4850±8.4478

MSCPSO在F2、F3、F5、F6、F8和F11这6个测试函数中取得的结果要优于其他4个算法.MSCPSO将种群分为指导空间和进化空间,进化空间在指导空间的指引下进行搜索,因此,其在多峰函数中的效果更佳.而PSODDS,CCPSO-ISM,SRPSO并未赋予每个粒子以不同的功能,导致粒子在搜索过程中易陷入局部最优;采用多种群的MSMPSO在4个算法中的适应度值较优,这与本文所提出的算法有异曲同工之妙,因此,从侧面证明了多空间协同进化策略的有效性和实用性.

3.2 遗传算法相关实验对比

3.2.1 MSC策略与相关遗传算法实验结果分析

GA和MSCGA的参数设置为:交叉概率Pc=0.8,变异概率Pm=0.02,维数D=1000,种群规模Size=50.MSCGA的指导空间每个子种群规模Sizei=10(i=1,2,3),进化空间子种群规模size=20.每个算法独立运行20次,进化迭代10000次.指导空间与进化空间之间的通信方式采用指导空间最优个体取代进化空间适应度值最劣的3个个体.

在12个标准测试函数中的测试结果如表4所示.GA算法与MSCGA算法相比,在F1、F2、F3、F5、F7、F8、F10、F11、F12这9个测试函数中,MSCGA表现出明显的优势,在其他3个测试函数中MSCGA表现较优,这也证明,在遗传算法中选择的通信策略有待提高.总之,MSCGA算法有较低的标准方差,证明应用MSC策略的算法具有更好的稳定性.

图3是12个测试函数F1~F12的收敛比较图.横轴代表进化次数,纵轴代表平均适应度值.从图中可以清楚的看到MSC策略优势.MSCGA几乎在每个测试函数中进化迭代10000次 之后均有继续下降的趋势,尤其在F2、F5、F6、F10最为明显,在其他测试函数中也有缓慢的下降趋势,说明算法没有被局部最优值束缚.而GA在绝大部分函数中进化100次左右陷入局部最优.这更加验证了改进后的算法具有更强的全局搜索能力.

表4 GA算法对12个标准测试函数优化结果

Table 4 Optimization results of 12 benchmark functions

GAMSCGAF17.0450e+04±2.6740e+035.5516e+04±3.0685e+03F21.4381e+06±1.6934e+059.2895e+05±1.0614e+05F36.7909e+06±4.8759e+052.7244e+06±14.0154e+05F41.7129e-15±3.0166e-092.0026e-14±5.2458e-10F59.4205±0.16659.1100±0.2004F67.5555e+03±255.94247.9795e+03±98.3462F7616.7508±28.0638491.9251±37.2226F89.3112e+03± 601.99037.2109e+03±631.5110F93.5240e+03±344.08363.1303e+03±414.9190F103.1636e+05±2.6643e+033.1301e+05±1.7698e+03F113.2396e+05±1.4102e+042.3836e+05±1.7070e+04F129.7129e+03±635.32424.1983e+03±908.9310

3.2.2 MSCGA与其他3个算法的实验对比分析

多种群协方差学习差分进化(MCDE)算法[2]、多种群遗传算法(MGA)[3]、变区域多种群遗传算法(VRMGA)[4]这3个算法均是关于多种群算法,且具有一定的代表性.为了保证实验对比的可信度,将MSCGA的实验参数分别参考文献[2- 4]进行设置,对比结果如表5所示.采用MSC策略的遗传算法在8个测试函数中取得了最佳效果,在剩余3个测试函数中虽然没有取得最佳,但是与最优值在误差允许的范围内基本一致.进化空间在指导空间的作用下完成有目的的搜索,大大提高了实验结果的收敛精度和速度,使个体在多空间协同作用下向最优解进化.

图3 各GA算法对12个标准测试函数优化的收敛曲线Fig.3 Convergence curves of GA algorithms for 12 benchmark functions

表5 与其他遗传算法的实验结果对比

Table 5 Comparison of experimental results with other GA

算法函数最优值F10F23.19E-10±7.12E-10MCDEF52.09E+01±4.21E-02(D=30)F62.28E+01±4.27E+00F71.52E-03±4.11E-03F102.12E+03±1.34E+03MGABranin0.39791(D=2,3)Hartmanl-3.86266VRMGA(D=2)Schaffer6(最优值为最大值)1Shubert-186.7302Schaffer10F10F22.20E+01±1.43E+00F56.50E-03±1.40E-03F61.80E-03±4.48E-04F72.20E-03±4.90E-03MSCGAF109.73E+02±4.12E+02Branin0.3979Hartmanl-3.8627Schaffer6(最优值为最大值)1Shubert-186.6944Schaffer10.0072

3.3 显著性检验

为了验证MSC策略的有效性,对MSCPSO、MSCEXPPSO、MSCGA和其他算法在D=1000时得到的结果逐一进行显著性检验.由于不能够确定各算法多次优化同一函数的结果服从分布的类型,因此采用非参数检验的方法,这里选用Mann Whitney检验方法,显著水平α=0.05.表6详细列出了4种算法的检验数据,这里以PSO列为例说明表中各数据的意义:PSO列与F1行交叉的数据为“0.000↑”,“0.000”为Mann Whitney检验的p值,“↑”表示PSO在F1上的运行数据的秩均值大于MSCPSO的运行数据的秩均值;若为“↓”,则表示PSO在此函数上的运行数据的秩均值小于MSCPSO的运行数据的秩均值;若为“→”,则表示两种算法的运行数据的秩均值相等;GA列是与MSCGA的Mann Whitney检验数据;EXPPSO列是与MSCEXPPSO的Mann Whitney检验数据.表中的better行、same行和worse行分别表示在显著水平为0.05下,12个测试函数中MSCPSO优于PSO、与PSO无差和劣于PSO的函数的个数.从表6中,可以清晰的看到,在12个测试函数上,MSCPSO、MSCGA、MSCEXPPSO和其他算法的综合性能的比较结果,应用本文所提MSC策略的算法明显占优.

4 结 论

传统的自然计算方法中,种群按照循规蹈矩的方式进化.对某些特定群体智能算法的改进,研究较多的有关于参数的修改,有关于拓扑结构的修改等等.但将种群分组思想应用到自然计算方法中,利用指导空间对进化空间的指导来寻找最优解还有上升的余地.因此,本文提出了子种群分组策略,实现了种群在进化过程中的信息指导与干预.该方法与具体的群体智能算法无关,适用于所有的自然计算方法,具有普适性和通用性.因此,可以方便的将本策略应用至各种群体智能算法中,来提高原方法的收敛精度和收敛效率.在PSO和GA的实验结果表明,基于MSC的PSO算法,在收敛精度和收敛速度方面都有大幅度的提高;基于MSC的GA算法,虽然没有PSO算法改进效果明显,但也有一定程度的提升,这与本文所选的通信方式和原算法的性能有关.而与关于种群改进的其他4个算法相比,也表现出较好的优势.后期将尝试完善通信方式,以求得更理想的结果.

表6D=1000,Mann Whitney检验数据

Table 6D=1000,Mann Whitney test data

PSOMSMPSOGAEXPPSOF10.000↑0.000↑0.010↑0.000↑F20.000↑0.000↓0.025↑0.000↑F30.000↑0.000↑0.000↑0.000↑F40.000↑0.000↓0.036↑0.000↓F50.000↑0.000↑0.957↓0.000↑F60.000↑0.000↑0.000↓0.000↑F70.000↑0.000↑0.152↑0.000↑F80.000↑0.000↑0.020↑0.000↑F90.000↑0.000↑0.000↓0.000↑F100.000↑0.000↓0.000↑0.000↓F110.000↑0.000↑0.011↑0.000↑F120.000↑0.000↓0.552↓0.000↓Bet-ter12879Worse0423Same0030