基于特征融合的小型透明注塑件缺陷检测技术研究*

2022-01-14刁思勉黄天仑毛霆王楠钟震宇张云周华民

刁思勉 黄天仑 毛霆 王楠 钟震宇 张云 周华民

特约论文

基于特征融合的小型透明注塑件缺陷检测技术研究*

刁思勉1黄天仑2,3毛霆3王楠2钟震宇2张云3周华民3

(1.深圳市烨嘉为技术有限公司,广东 深圳 518000 2.广东省科学院智能制造研究所/广东省现代控制技术重点实验室,广东 广州 510070 3.华中科技大学材料科学与工程学院/材料成形与模具技术国家重点实验室,湖北 武汉 430074)

针对小型透明注塑件在成像过程中受成像质量与产品尺寸的影响,导致透明注塑件产品的缺陷检测准确率与召回率低的问题,提出一种基于特征融合的小型透明注塑件缺陷检测技术。首先,采用高清工业相机并搭配M5028-MPW2镜头对小型透明注塑件局部区域进行成像,以弥补尺寸的影响从而保证成像质量;然后,采用特征融合网络将低层次的高分辨率特征图下采样、高层次的强语义信息特征图上采样变换到相同尺寸,并通过局部响应归一化技术进行融合,从而提高缺陷区域的定位与识别精度;最后,利用特征共享的区域生成网络与分类网络实现缺陷位置的自动定位与检测。经实验验证:该技术能准确实现小型透明注塑件的缺陷检测,在300个推荐区域与交并比为0.5的情形下,缺陷区域召回率为100%;缺陷类别识别平均准确率为98.49%,具有较高的实用价值。

小型透明注塑件;缺陷定位与检测;特征融合;特征共享

0 引言

注塑成形产品具有成形周期短、精度高、适应性强等特点,广泛应用于汽车、航空航天、电子电气等领域。注塑件缺陷检测是实现注塑成形工业产业升级的重要技术环节。传统依靠人工检测的效率、精度与稳定性都得不到保障,严重制约了注塑成形工业的自动化与智能化水平。

目前,基于机器视觉的检测技术已逐渐应用于注塑件的缺陷检测。如,针对具有较强纹理特征的注塑件,LIU等采用截断奇异值分解和小波分解技术,实现注塑件的纹理特征提取,并建立外观缺陷的检测模型[1];GAHLEITNER等利用数字图像处理技术和条状光源成像技术实现产品指定位置的纹理检测[2]。针对具有缩痕缺陷的注塑件,GRUBER等建立产品缩痕强度与产品外观图像的二阶微分之间的定量关系与模型,实现注塑件缩痕缺陷的自动检测[3]。针对透明注塑件的外观检测,SATORRES等结合定制的照明硬件系统与可配置组合的软件模块,实现前照灯透镜的自动检测[4]。相关学者结合改进的霍夫变换、轮廓拟合与亚像素处理等技术实现小型齿轮类注塑件的披锋、缺齿与翘曲等缺陷的自动检测[5-6];也有学者结合模板匹配与图像分割技术,实现平板类注塑件的外观缺陷检测[7-8]。在注塑成形工业的模具保护方面,通过模板匹配、特征匹配与轮廓检测等技术实现模内异物或产品残留的自动检测[9]。综上所述,基于传统机器视觉的检测技术大多针对特性类型产品、特定外观缺陷的检测,模型可迁移性不强。随着深度学习技术的发展,基于深度学习的检测技术已逐渐取代传统的机器视觉检测技术,并广泛应用于图像分类[10]、检测[11]与分割[12]等领域。

近年来,专家学者针对如何利用深度学习技术准确识别注塑件缺陷进行了大量研究,但针对小型透明注塑件缺陷检测的文献鲜有报道。为此,本文提出一种基于特征融合的小型透明注塑件缺陷检测技术。首先,对小型透明注塑件进行局部成像从而提高局部区域的图像分辨率;其次,利用特征融合网络将不同层次特征图变换到同一尺寸,从而提高缺陷的定位精度与识别准确率;最后,利用缺陷生成和分类网络检测头对缺陷的位置和类型进行自动识别,提高了小型透明注塑件缺陷检测的召回率与准确率。

1 图像获取与数据集准备

待检测的小型透明注塑件来自实际生产中的案例,尺寸为8 mm×6 mm×2 mm。由于材料、工艺与设备状态等参数的波动,导致产品在注塑成形过程中容易出现毛丝(Hair)和黑点(Spot)2种常见的缺陷,如图1所示。本文主要检测这2种外观缺陷。由于待检测小型透明注塑件对成像质量要求较高,本文采用高清工业相机acA3800-10gc并搭配M5028-MPW2镜头(分辨率为2 454×2 056)对小型透明注塑件局部区域进行成像。为平衡检测效率和检测精度,将成像后的图像统一缩放至800×640像素。

图1 典型小型透明注塑件外观图像与缺陷

分别收集正常图像100幅、含有毛丝和黑点缺陷的图像各80幅,合计260幅。其中,毛丝和黑点缺陷出现次数分别为417次和384次,采用人工标记的方式记录每个缺陷的位置和类型;同时通过将图像旋转至不同角度(如30°、90°、180°等)和平移等方式对数据进行增强,从而获得10倍于原始数据量的数据集,选取60%的数据作为训练集,剩余的40%作为测试集。

2 多维度特征融合

本文采用预训练的VGG16网络作为特征提取主干网络(移除网络架构最后3个全连接层),包含13个卷积层和4个池化层。传统目标检测采用特征提取主干网络最后的卷积层输出特征作为区域生成网络和检测器的输入,该特征图的缩放因子为1/32,存在目标定位精度不足的问题;而低层次的特征图没有经历卷积等非线性变换操作,其语义信息较弱,缺陷识别能力不高。因此,为利用高层次特征图的强语义特性,对第五卷积组输出的特征图进行上采样,以增强其位置信息;为利用低层次特征图的高分辨率特性,将第一卷积组输出的特征图进行最大池化操作以增强其语义信息;将上述特征图变换到与第三卷积组输出的特征图相同尺寸,并通过1个5×5的卷积操作增强特征的非线性表达能力,通过局部响应归一化技术将3组特征图进行融合,从而提高缺陷区域的定位精度。多维度特征融合网络如图2所示。

图2 多维度特征融合网络

3 缺陷区域自动生成与检测

首先,将小型透明注塑件外观图像输入特征提取网络并经历多维特征融合后,输出1个××的特征图;然后,利用具有个通道的3×3卷积模板对该特征图进行非线性变换,并将三维特征图的形状变换为(×) ×的二维特征图;最后,在该二维特征图后接入2个全连接层,用于缺陷区域的生成和粗定位。此外,为提高缺陷定位的精度,引入锚点(anchor)机制,以锚点为中心,通过生成个不同尺度和比例的矩形框来指定不同大小和长宽比例的缺陷区域。因此,对于×大小的特征图,最终将生成××个候选区域,缺陷区域生成网络架构如图3所示。

图3 缺陷区域生成网络结构示意图

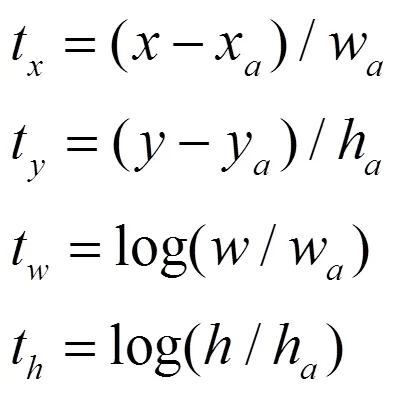

缺陷区域生成网络的损失函数为

式中,(,,,)分别为预测候选区域锚点中心坐标(,)、矩形区域的宽度()与高度();(x, y, w, h)分别为真实候选区域锚点中心坐标(x, y)、矩形区域的宽度(w)与高度(h)。

在训练阶段,采用带动量的小批量随机梯度下降法训练区域生成网络模型,该模型每幅图像输出128个候选区域,送入后续区域检测网络进行进一步的分类与定位训练。其中,正负样本比例保持为1∶1,若正样本数量不足,则由负样本补齐。正负样本的设置规则如下:

1)如果候选区域与真实缺陷区域的交并比大于0.5,将该区域标记为正样本区域的样本,否则标记为负样本;

2)如果多个候选区域与同一个真实缺陷区域的交并比大于0.5,则将交并比最大的那个候选区域设置为正样本,其他设置为负样本;

3)如果同一个候选区域与多个真实缺陷区域的交并比大于0.5,则取交并比最大的那个真实缺陷区域作为正样本。

在测试阶段,由于区域生成网络模型输出的候选区域没有真实标签,因此直接输出300个候选区域并送入区域检测网络进行预测。

利用感兴趣区域(ROI)池化操作将缺陷区域生成网络生成的候选区域池化为7×7的特征图,并送入后续检测器进行最终缺陷区域的精确定位和识别。检测器网络结构与缺陷区域生成网络结构类似,包含2个全连接层检测头,分别用于位置回归和缺陷分类,缺陷检测网络总体结构如图4所示。

图4 缺陷检测网络总体结构示意图

采用带动量的小批量随机梯度下降法训练检测器,检测器的位置回归误差计算方式与式(1)相同;缺陷类型识别采用SoftMax函数:

本文采用四步法训练缺陷检测网络:1)单独训练缺陷区域生成网络;2)单独训练检测器;3)冻结第2)步中的特征提取主干网络的模型参数,对缺陷区域生成网络的模型参数进行微调;4)冻结第3)步中的特征提取主干网络的模型参数,对检测器的模型参数进行微调。

4 实验及结果分析

为验证本文所提方法对小型透明注塑件缺陷检测的有效性,网络训练的实验平台硬件配置如下:10核Intel Xeon CPU E5-2630 v4 @ 2.20 GHz;64 GB内存;2张Nvidia GeForce GTX 1080Ti显卡。区域召回率与推荐数量、交并比之间的关系如图5所示。图5同时给出了传统边缘框(EB)、选择性搜索(SS)、VGG、特征融合网络(Hyper)的结果。

图5 区域召回率与推荐数量、交并比之间的关系

由图5(a)可知,当推荐数量为50个且交并比为0.5时,传统的EB方法或SS方法的召回率不足60%,而VGG与Hyper网络的召回率均在80%以上,其中Hyper网络的召回率更高;由图5(b)可知,当推荐数量为300个且交并比为0.5时,传统的EB方法或SS方法的召回率不足80%,而VGG与特征融合网络的召回率基本可达100%。此外,还发现特征融合网络的召回率始终高于VGG网络和传统的EB方法、SS方法,证实了本文提出的特征融合网络结构的有效性。

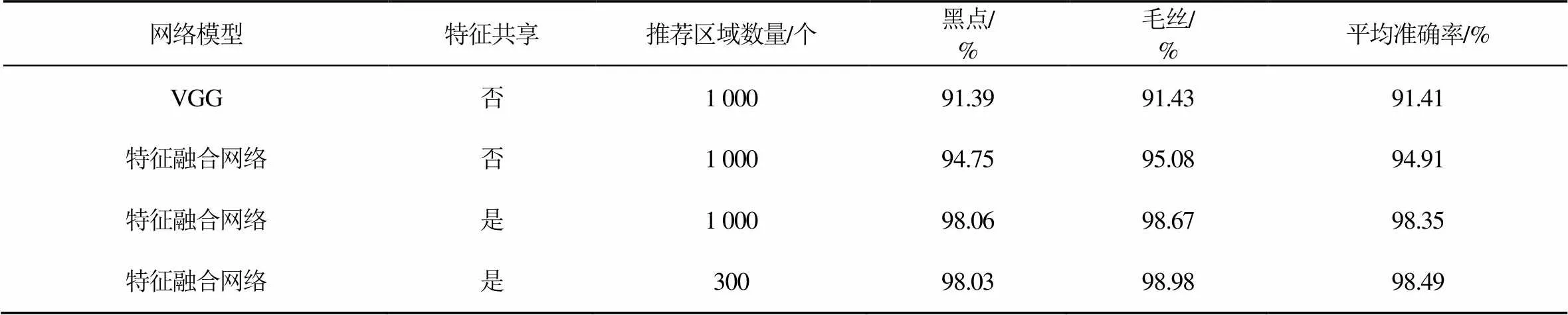

在实时性方面,当推荐区域数量为1 000个时,传统EB方法、SS方法处理单幅图像平均耗时约为 4 s,而VGG和特征融合网络平均耗时分别为165 ms和190 ms。特征融合网络处理单幅图像处理速度是传统EB方法、SS方法的4倍以上,这是因为特征融合网络模型结构参数略有增加,导致单幅图像速度略慢于VGG网络,但仍能满足实时性检测需求(≥5 s/幅)。VGG网络、特征融合网络的检测准确率如表1所示。

表1 VGG、特征融合网络的检测准确率

由表1可知:当推荐区域数量为1 000个、区域生成网络与检测器不共享特征提取主干网络的模型参数时,相比VGG网络,特征融合网络对黑点、毛丝的识别准确率和平均准确率分别提高了3.34%、3.65%、3.50%;当采用共享特征网络参数时,特征融合网络对黑点、毛丝的识别准确率和平均准确率分别提高了3.31%、3.59%、3.44%;当推荐区域由1 000个降为300个时,平均准确率可以达到98.49%,能够满足实际检测需求。由以上结果可以看出,本文采用的特征融合方法能提高缺陷的识别准确率与平均准确率。

图6给出了缺陷检测结果,其中1表示黑点缺陷、2表示毛丝缺陷,1∶0.983表示出现黑点缺陷的概率为0.983;2∶0.837表示出现毛丝缺陷的概率为0.837。由图6可知,本文所提方法能够较好地检测出黑点、毛丝等缺陷。

图6 小型透明注塑件缺陷检测结果图

5 结语

为了识别小型透明注塑件缺陷,本文提出一种基于特征融合的缺陷检测技术。首先,通过高清工业相机对小型透明注塑件进行局部成像,并将图像统一缩放至800×640像素,从而降低产品尺寸对成像质量的影响;其次,通过将低层次的特征图下采样、高层次特征图上采样至同一尺寸大小,并通过局部响应归一化技术融合不同层次的特征图,提高缺陷区域的定位和识别精度;最后,采用预训练的VGG模型作为特征提取主干网络,通过缺陷区域生成网络和检测器实现缺陷区域的自动定位与检测。在300个推荐区域与交并比为0.5时,缺陷区域召回率100%;缺陷类别识别平均准确率98.49%,具有较高的实用价值。

[1] LIU J J, MACGREGOR J F. Modeling and optimization of product appearance: application to injection-molded plastic panels[J]. Industrial & Engineering Chemistry Research, 2005, 44(13):4687-4696.

[2] GAHLEITNER R, NIEL K S, FRANK S. Optical measurement system for characterizing plastic surfaces[C].Image Processing: Machine Vision Applications. International Society for Optics and Photonics, 2008,6813:68130T.

[3] GRUBER D P, MACHER J, HABA D, et al. Measurement of the visual perceptibility of sink marks on injection molding parts by a new fast processing model[J]. Polymer Testing, 2014,33(3): 7-12.

[4] SATORRES MARTÍNEZ S, GÓMEZ ORTEGA J, GÁMEZ GARCÍA J, et al. An industrial vision system for surface quality inspection of transparent parts[J]. International Journal of Advanced Manufacturing Technology, 2013,68(5-8):1123-1136.

[5] 贺秋伟.基于计算机视觉的微小尺寸精密检测理论与技术研究[D].长春:吉林大学,2007.

[6] 陈廉清,高立国,王龙山.基于亚像素定位和虚拟圆扫描的齿轮在线检测研究[J].光学技术,2008,34(S1):123-125.

[7] 张王黎.基于机器视觉的塑料制品缺陷检测算法研究[D]. 广州:华南理工大学, 2014.

[8] 杨威,毛霆,张云,等.注射制品表面缺陷在线检测与自动识别[J].模具工业,2013,39(7):7-12.

[9] LEE J Y, BONG W, LEE S, et al. Development of the Vision System and Inspection Algorithms for Surface Defect on the Injection Molding Case[M].Advances in Computer Science and Ubiquitous Computing. Springer, Singapore, 2016:963-970.

[10] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016:770-778.

[11] REN S, HE K, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2016,39(6):1137-1149.

[12] HE K, GKIOXARI G, DOLLÁR P, et al. Mask R-CNN[C]// Proceedings of the IEEE International Conference on Compu-ter Vision, 2017:2961-2969.

Research on Defect Detection Technology of Small Transparent Injection Molding Parts Based on Feature Fusion

Diao Simian1Huang Tianlun2,3Mao Ting3Wang Nan2Zhong Zhenyu2Zhang Yun3Zhou Huamin3

(1.Yejiawei Technology Co., Ltd. Shenzhen 518172, China 2. Institute of Intelligent Manufacturing, Guangdong Academy of Science/ Guangdong Key Laboratory of Modern Control Technology, Guangzhou 510070, China 3. School of Materials Science and Engineering, Huazhong University of Science and Technology/ State Key Laboratory of Material Processing and Die & Mold Technology, Wuhan 430074, China)

Aiming at the problem that the defect detection accuracy and recall rate of transparent injection molded parts are low due to the influence of imaging quality and product size in the imaging process of small transparent injection molded parts, a defect detection technology of small transparent injection molded parts based on feature fusion is proposed. Firstly, high-definition industrial camera and M5028-MPW2 lens are used to image the local area of small transparent injection molding parts to make up for the influence of size and ensure the imaging quality; Then, the feature fusion network is used to transform the down sampling of low-level high-resolution feature map and the up sampling of high-level strong semantic information feature map to the same size, and the local response normalization technology is used for fusion, so as to improve the positioning and recognition accuracy of defect area; Finally, the feature sharing region generation network and classification network are used to realize the automatic location and detection of defect location. The experimental results show that the technology can accurately detect the defects of small transparent injection molded parts. When the ratio of 300 recommended areas to intersection and merging is 0.5, the recall rate of defective areas is 100%; The average accuracy of defect classification is 98.49%, which has high practical value.

small injection molding parts; defect localization and recognition; feature fusion; feature sharing

广东省重点领域研发计划项目(2018B01010-8006);广东省科学院建设国内一流研究机构行动专项资金项目(2021GDASYL-20210103091)。

刁思勉,男,1971年生,博士,工程师,主要研究方向:产品缺陷检测技术。

黄天仑(通信作者),男,1991年生,博士,主要研究方向:机器视觉、深度学习。E-mail: tl.huang@giim.ac.cn

毛霆,男,1989年生,博士,主要研究方向:人工智能,机器视觉。

王楠,女,1989年生,硕士,主要研究方向:安全检测技术。

钟震宇,男,1971年生,博士,研究员,主要研究方向:深度学习。

张云,男,1981年生,博士,教授,主要研究方向:注塑成形工艺、智能制造。

周华民,男,1974年生,博士,教授,主要研究方向:智能成形工艺与装备、聚合物加工。

S225

A

1674-2605(2021)06-0001-06

10.3969/j.issn.1674-2605.2021.06.001