两类遥感图像深度神经网络预测方法及比较

2021-12-12赵理君

金 兴,唐 娉,赵理君

(1.中国科学院空天信息创新研究院,北京 100094;2.中国科学院大学 电子电气与通信工程学院,北京 100049)

0 引言

随着遥感数据的快速增长,遥感图像时间序列分析渐成趋势,但因卫星成像特点,高空间分辨率遥感图像难以获得不同区域时相间隔一致的遥感图像序列,因此,如何用图像处理的方法补全所需时相图像,以便用统一的方法分析遥感图像时间序列成为亟待解决的问题。

当所需时相缺失时,2种思路最为直接,一种是将别的时相的数据直接转换为所需时相,对应的方法也被称为色彩迁移的方法;另一种是用一组时相序列预测的方法。这2种思路各有优缺点,色彩迁移方法需要的条件比较简单,只需要2个时相的数据去学习映射的关系,但该方法假设了2个时相之间没有地物发生变化,只有光谱的变化,这与实际情况不完全符合。而时序预测的方法则需要多个时相的数据才可执行,但它可以对地物的变化进行建模与预测,缺点是数据条件要求较高。

基于影像色彩迁移的典型方法是生成对抗网络(GAN)中用于进行影像双向变换的CycleGAN,它是一种无监督学习的生成对抗网络方法,该网络中通过计算变换后影像(源域A到目标域B的变换)与重建影像(目标域B到源域A的变换)的循环一致性损失来约束影像的变换[1]。该方法主要用于2个不同时相影像的变换,如文物图像的修复与保护[2]、不同时段、季节、光照条件下拍摄照片的艺术风格转换[3]、地物信息提取[4]以及室内火焰图像场景的迁移[5]。

基于时相序列进行遥感影像预测的典型方法是循环神经网络(RNN)中用于处理时序影像数据的ConvLSTM,该方法通过其过去状态和当前的输入状态来确定网格中某个单元的未来状态。在输入到状态和状态到状态转换中使用卷积运算符来轻松实现。该方法主要用于时间序列预测,如归一化植被指数(NDVI)预测[6]和雷达回波图像的短期降雨预测[7]。

本文以影像色彩迁移及时序预测的角度为出发点,使用CycleGAN及ConvLSTM网络对遥感影像进行预测,通过比较CycleGAN及ConvLSTM网络预测结果并分析网络适用性,为补全卫星遥感观测所需时相的数据寻找一种合适的技术途径。本文实验表明,2种网络产生的预测结果与参考影像能够保持一致的空间及光谱特征。2种网络预测结果的结构相似度(SSIM)均达到0.99,均方根误差(RMSE)分别小于4个像素和2个像素。

本文的主要创新点如下:① 以2种不同的角度(色彩迁移、时序预测)为出发点,将CycleGAN及ConvLSTM网络首次应用到遥感影像预测领域;② 在不同区域无人机(UAV)数据集上对比了CycleGAN与ConvLSTM网络预测的结果,2种网络的预测结果都能与相应的参考影像保持较好的空间及光谱特征;③ 提供了一种新的弥补遥感卫星观测数据缺失的技术途径。CycleGAN网络受单时序影像缺失的程度较小,适用于时序影像缺失程度较大时的遥感影像预测。ConvLSTM网络能够利用多个时序影像的状态信息,但受单时序影像缺失程度较大,适用于时序影像缺失程度较小时的遥感影像预测。

1 CycleGAN及ConvLSTM网络简介

1.1 CycleGAN网络

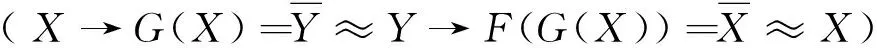

CycleGAN的目的是实现源域A(影像X)和目标域B(影像Y)之间的相互转换[8]。CycleGAN包含2个生成器G和F、2个对应的对抗判别器DY和DX及2个循环一致损失(前向循环一致损失及反向循环一致损失)。

(a) CycleGAN的映射

根据CycleGAN结构示意图,CycleGAN网络包含前向对抗目标、反向对抗目标和循环一致性损失3部分。前向对抗目标及反向对抗目标如式(1)和式(2)所示,循环一致性损失如式(3)所示,CycleGAN目标函数如式(4)所示:

LGAN(G,DY,X,Y)=EY~Pdata(Y)[lbDY(Y)]+

EX~Pdata(X)[lb(1-DY(G(X)))],

(1)

LGAN(F,DX,Y,X)=EX~Pdata(X)[lbDX(X)]+

EY~Pdata(Y)[lb(1-DX(F(Y)))],

(2)

(3)

LGAN(F,DX,Y,X))},

(4)

式中,X为源域A真实影像数据;Y为目标域B真实影像数据;~表示服从关系;Pdata(Y)和Pdata(X)分别为目标域影像及源域影像数据的分布;G(X)和F(Y)为预测后影像;E表示数学期望函数;μ1及μ2分别表示循环一致损失及对抗目标比例超参数。

此网络目的如下:① 学习生成器G从源域A(影像X)到目标域B(影像Y)的映射关系(G:A→B);② 学习生成器F从目标域B(影像Y)到源域A(影像X)的映射关系(F:B→A)。

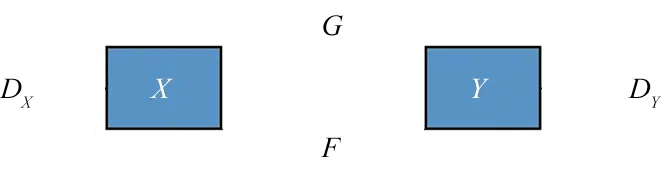

1.2 LSTM及ConvLSTM网络

长短时记忆网络(LSTM)属于循环神经网络(RNN),主要作用是能够利用影像的时序信息进行预测的一种方法[9-10]。其主要创新是细胞状态ct(网络信息传送带)充当状态信息的累加器,并通过几个自参数化控制门访问、写入和清除单元。每当有新输入xt时,如果输入门it(决定ct需要添加哪些信息)it被激活,它的信息将被累积到单元格。此外,如果忘记门ft(决定ct需要丢弃哪些信息)打开,则在此过程中可能“遗忘”过去的细胞状态ct-1ct-1。输出门ot(判断ct输出哪些状态特征)控制最新的细胞状态ct是否传播到最终隐状态ht(最终输出的状态特征),其结构如图2所示,忘记门ft、输入门itit、输出门ot、细胞状态ct及最终隐状态ht为:

ft=σ(Wf·[xt,ht-1]+bf),

(5)

it=σ(Wi·[xt,ht-1]+bi),

(6)

ot=σ(Wo·[xt,ht-1]+bo),

(7)

ct=ft*ct-1+it*tanh(Wc·[xt,ht-1]+bc),

(8)

ht=ot*tanh(ct),

(9)

式中,ct-1和ht-1表示过去的细胞状态及最终隐状态;Wf和bf表示忘记门的权重及偏向;Wi和bi表示输入门的权重及偏向;Wo及bo表示输出门的权重及偏向;Wc和bc表示细胞状态的权重及偏向;σ表示sigmoid激活函数。

图2 长短时记忆网络结构图Fig.2 Structure diagram of LSTM

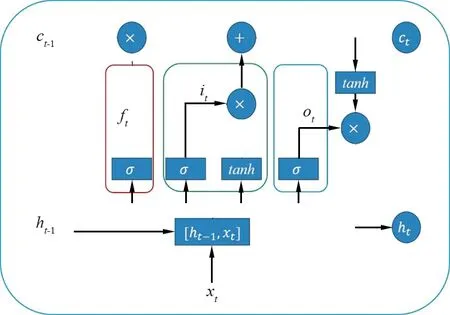

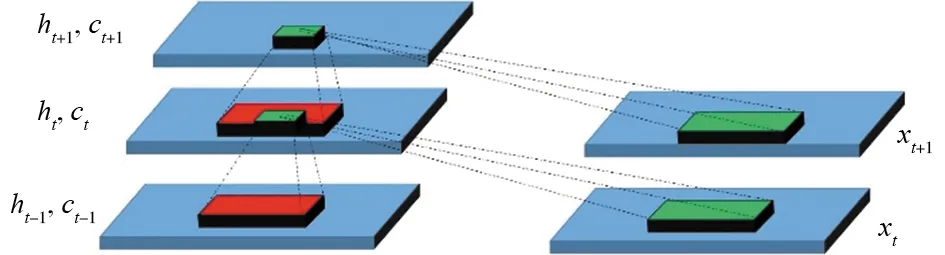

ConvLSTM的一个显著特点是所有输入状态x1-xt,细胞状态c1-ct,隐状态h1-ht为3D张量,其最后2个维度是空间维度(行和列)[11-12]。为了更好地了解输入和状态,可以将它们想象为站在空间网格上的向量。ConvLSTM通过其过去状态和当前输入状态来确定网格中某个单元的未来状态。这可以通过在状态到状态和输入到状态转换中使用卷积运算符来轻松实现[13]。该网络目的是学习不同状态信息层下时序影像之间的映射关系。其结构示意图如图3所示。

图3 卷积长短时记忆网络结构示意Fig.3 Structure diagram of ConvLSTM

1.3 影像质量评价方法

1.3.1 均方根误差

RMSE是一种基于像素点的统计方法[14],表示预测后影像与参考影像之间的像元误差,单位是pixel。在影像质量评价中,反映了预测后影像与参考影像之间像元的接近程度,值越小表明像元的接近程度越好,即:

(10)

式中,X(I,J)为预测后影像;Y(I,J)为参考影像,I,J表示影像像素行列的位置;M,N分别表示影像的宽度和高度。

1.3.2 结构相似度

Wang等人提出了SSIM评价方法。认为客观评价方法不能依赖于像素点间的简单统计,而应基于人类视觉特点来进行研究[15]。在影像质量评价中,用于衡量处理影像前后的相似度,值越大表明影像相似度越高。

SSIM由亮度信息L(X,Y)、对比度信息C(X,Y)和结构退化信息S(X,Y)组成。其中,X(I,J),Y(I,J)分别表示预测后影像和参考影像。为了增加结构相似度计算结果的稳定性,同时避免分式中分子或分母为零的情况,对亮度信息L(X,Y)、对比度信息C(X,Y)和结构退化信息S(X,Y)的公式增添参数C1,C2和C3,即:

(11)

(12)

(13)

SSIM(X,Y)=[L(X,Y)]α[C(X,Y)]β[S(X,Y)]γ,

(14)

式中,μX,σX分别为预测后影像X(I,J)的均值及标准差;μY,σY分别为参考影像Y(I,J)的均值及标准差;σXY为预测后影像X(I,J)与参考影像Y(I,J)之间的相关系数;α,β和γ控制L(X,Y),C(X,Y)和S(X,Y)的重要程度,取值为α=β=γ=1。C1,C2及C3取值为C1=(0.01L)2,C2=(0.03L)2,C3=(0.03L)2/2,L为影像像素的最大值,L=255。

2 实验数据与结果分析

2.1 实验数据说明

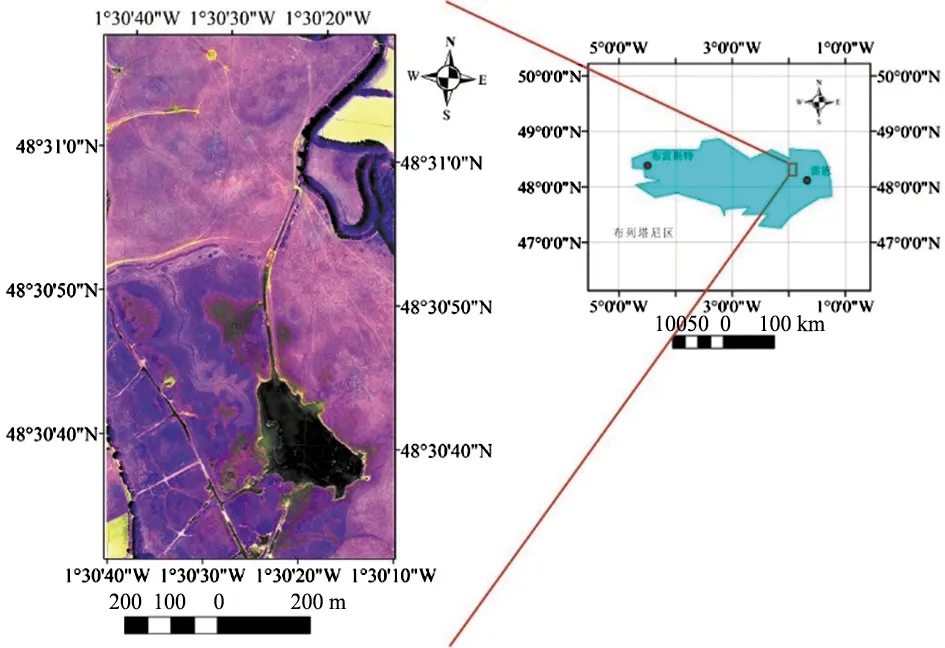

实验数据采用无人机(UAV)影像,无人机影像位置如图4所示。

图4 无人机影像的位置(1,2,4波段合成)Fig.4 Location of UAV image (1,2 and 4 band composition)

无人机影像位于圣米歇尔山上游的库斯农河平原(法国西部,北纬48.52°,西经1.53°)。库斯农河平原是一片面积达1.74 km2的水淹大草原[16]。影像投影类型为兰伯特投影,影像空间分辨率为0.02 m,影像波段数4个(绿色、红色、红边和近红外),影像尺寸为3 072 pixel×5 632 pixel。

2.2 实验训练与测试策略

2.2.1 CycleGAN网络训练与测试

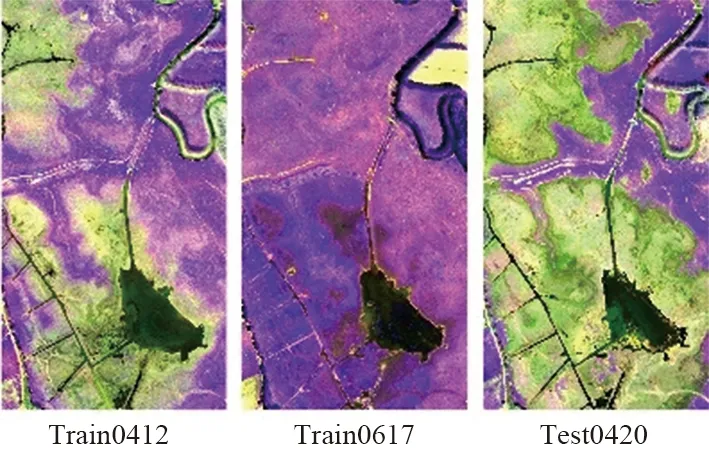

实验主要分为3组,每组实验包含二景训练影像和一景测试影像,实验目的是验证不同月份下CycleGAN网络的有效性及在相邻月份影像上的泛化能力。通过一对训练样本训练色彩转换模型,然后用到一景测试样本上。第1组进行2019年4—6月的色彩迁移模型实验,第2组进行2019年4—7月的色彩迁移模型实验,第3组进行2019年4—8月的色彩迁移模型实验。3组实验影像的名称及日期如表1所示。3组实验影像的视觉效果如图5所示。

(a) 第一组实验训练及测试对象

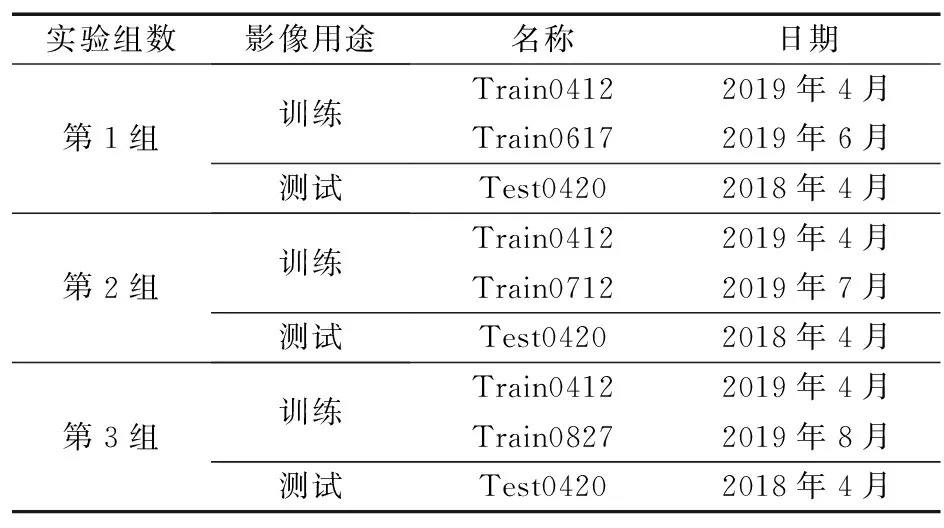

表1 CycleGAN实验影像的名称和日期

2.2.2 ConvLSTM网络训练与测试

ConvLSTM网络主要分为单元组预测和多元组预测2种方式。

单元组预测实验同CycleGAN网络训练与测试。多元组预测实验主要分为3组,每组实验包含一组训练影像和一组测试影像。第1组进行2019年6月影像预测实验,第2组进行2019年7月影像预测实验,第3组进行2019年8月影像预测实验。3组实验的目的是验证不同月份下ConvLSTM网络的有效性及在相邻月份影像上的泛化能力。3组实验影像的名称及日期如表2所示。3组实验影像的视觉效果如图6所示。

表2 ConvLSTM在多元组预测方式下实验影像的 名称和日期

2.3 实验细节描述

2.3.1 影像分块

由于影像尺寸的限制,输入整景影像(影像尺寸为3 072 pixel×5 632 pixel)将导致计算内存不足。为了解决这个问题,在实验训练及测试过程中需要对影像进行分块处理,本文中训练影像及测试影像被划分为264个块(影像块的尺寸为256 pixel×256 pixel),这样可以覆盖整景影像信息并减轻内存压力。

2.3.2 超参数选择

利用深度学习框架(Tensorflow)运行CycleGAN及ConvLSTM网络。为了提高网络计算效率,网络中的每层均在通用计算架构(CUDA)下运行[17]。在CycleGAN网络中,循环一致损失比例超参数μ1=350,对抗目标损失比例超参数μ2=1/32,网络优化器使用Adam,学习率设置为1e-4,网络循环次数(epoch)设置为200。在ConvLSTM网络中,网络使用3层堆叠的ConvLSTM卷积层,损失函数使用均方误差,网络优化器使用RMSProp,学习率设置为10-3,网络循环次数(epoch)设置为100。

2.4 实验结果主观评价

通过对影像进行分块及GPU上的加速[18-19],本文合理设置CycleGAN及ConvLSTM网络训练超参数,并在不同月份及循环次数下进行了3组实验。

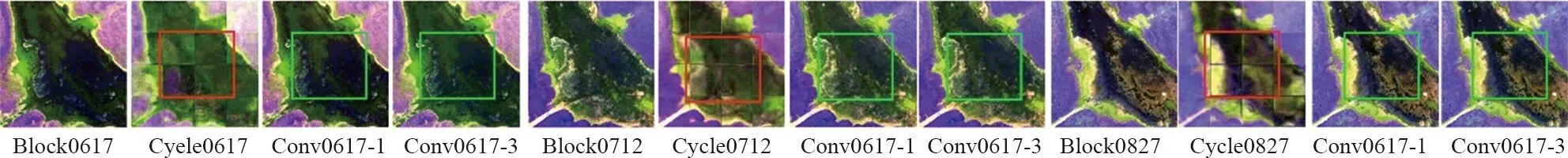

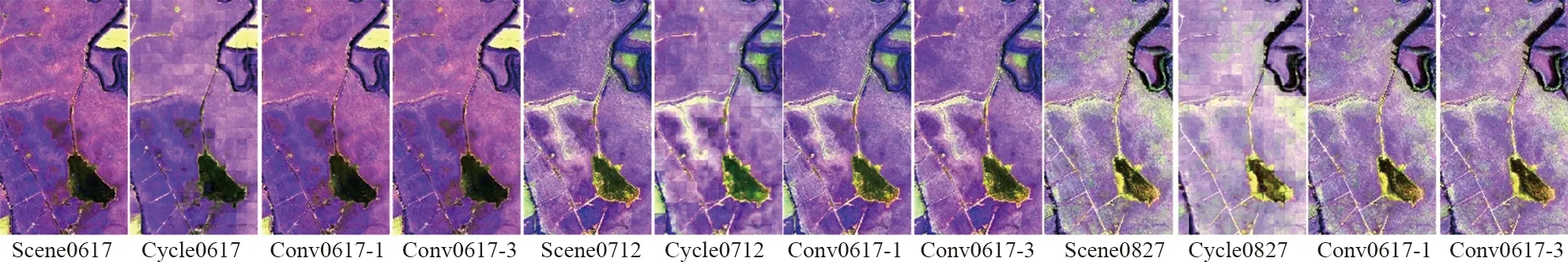

为了验证CycleGAN及ConvLSTM网络在影像预测中的有效性及相邻序列月份影像上的泛化能力。94%的训练样本块(250块)用于网络模型的训练,6%的训练样本块(14块)用于网络模型的验证,相邻序列中的同月影像用于网络模型的测试。最终不同月份及循环次数下的CycleGAN及ConvLSTM网络验证结果及测试结果如图7和图8所示。

(a) 6月生成结果,epoch=100 (b) 7月生成结果,epoch=100 (c) 8月生成结果,epoch=100

(a) 6月生成结果,epoch=100 (b) 7月生成结果,epoch=100 (c) 8月生成结果,epoch=100

从图7可以看出,CycleGAN网络在不同月份及循环次数下的验证结果与相应的参考影像之间存在细微的边缘分块效应(红色线框),ConvLSTM网络在不同月份及循环次数下的验证结果与相应的参考影像之间能够保持较好的空间及光谱特征(绿色线框)。从图8可以看出,CycleGAN及ConvLSTM网络在不同月份及循环次数下的测试结果与相应的参考影像之间能够保持较好的空间及光谱特征。

2.5 实验结果客观评价

CycleGAN及ConvLSTM网络预测结果的定量评价基于以下3个方面:① 像素误差图评价;② 定量指标表评价;③ 不同点位光谱曲线评价。

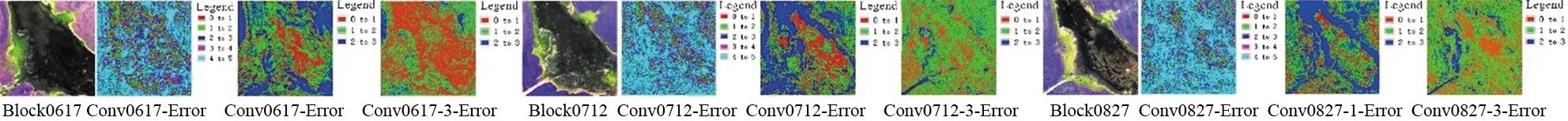

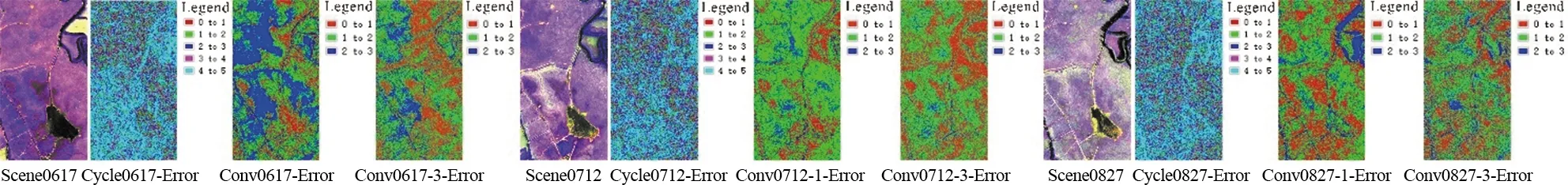

2.5.1 像素误差图评价

像素误差图主要衡量预测结果与参考影像之间的像素点在整体上的视觉接近程度。通过计算预测结果与参考影像的差值影像,在差值影像上以不同颜色体现像素点不同水平的误差。最终不同月份及循环次数下的CycleGAN及ConvLSTM网络验证结果及测试结果像素误差图如图9和图10所示。

(a) 6月像素误差图,epoch=100 (b) 7月生成结果,epoch=100 (c) 8月生成结果,epoch=100

(a) 6月像素误差图,epoch=100 (b) 7月生成结果,epoch=100 (c) 8月生成结果,epoch=100

从图9和图10可以看出,CycleGAN网络在不同月份及循环次数下的网络生成结果与相应的参考影像的像素误差图的整体像素误差范围为1~5个像素;ConvLSTM网络在不同月份及循环次数下的网络生成结果与相应的参考影像的像素误差图的整体像素误差范围为1~3个像素。

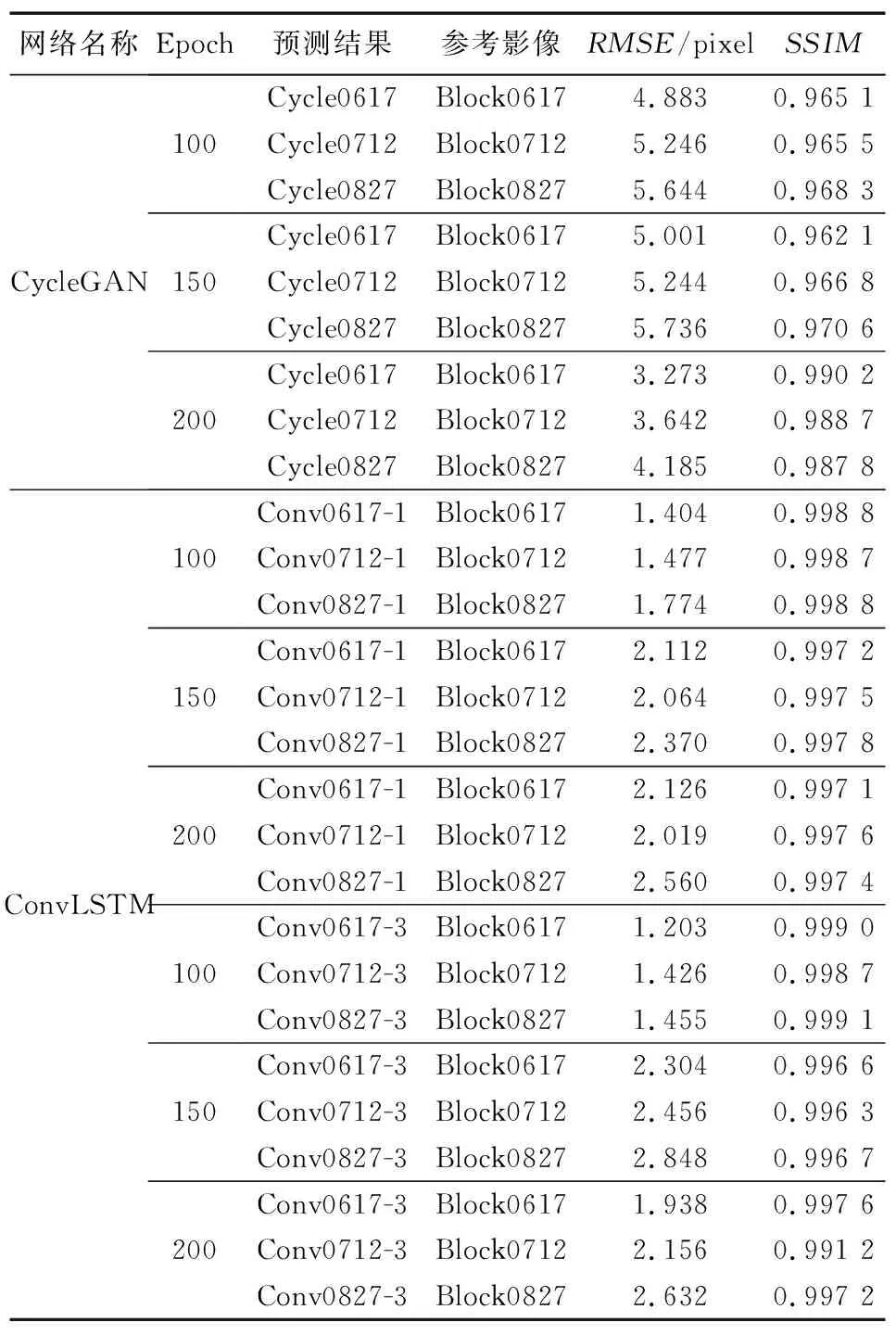

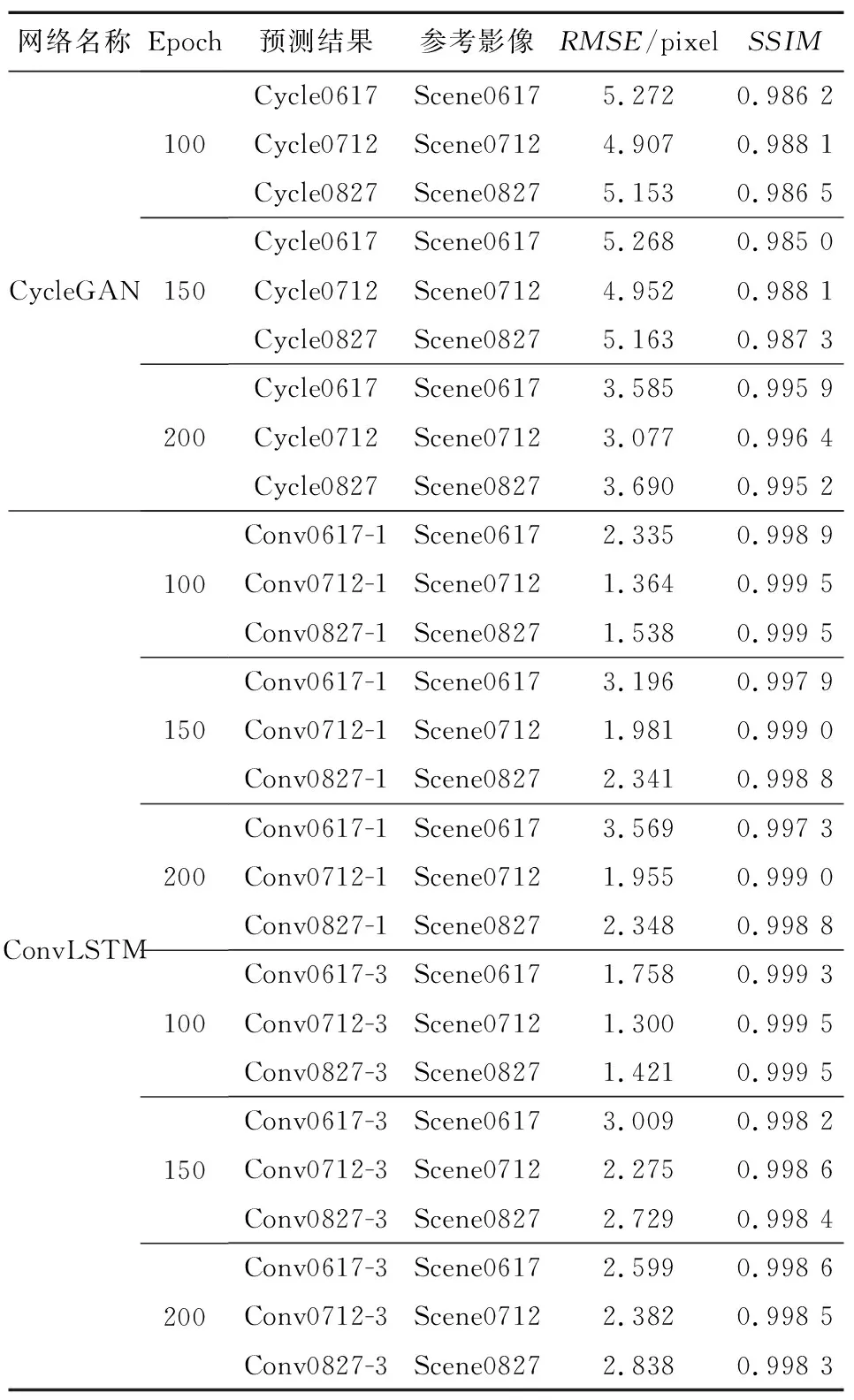

2.5.2 定量指标表

下面比较不同月份及循环次数下CycleGAN及ConvLSTM网络验证结果及测试结果的定量指标。最终CycleGAN及ConvLSTM网络验证结果及测试结果的定量指标如表3和表4所示。

从表3和表4可以看出,CycleGAN网络在不同月份及循环次数为200次时的网络生成结果与相应的参考影像之间的RMSE达到1~4个像素,SSIM达到99.5%;ConvLSTM网络在不同月份及循环次数为100次时的网络生成结果与相应的参考影像之间的RMSE达到1~2个像素,SSIM达到99.9%。

表3 CycleGAN及ConvLSTM网络验证结果的评价指标

表4 CycleGAN及ConvLSTM网络测试结果的评价指标

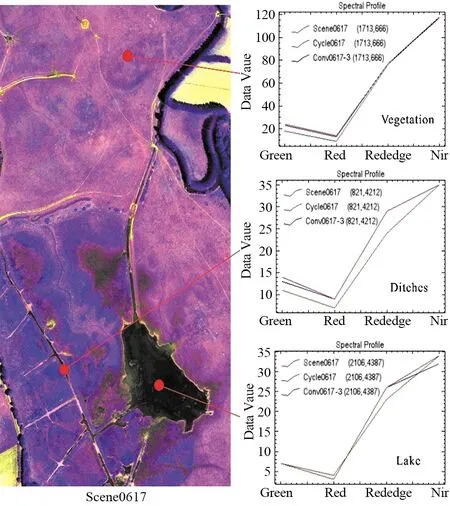

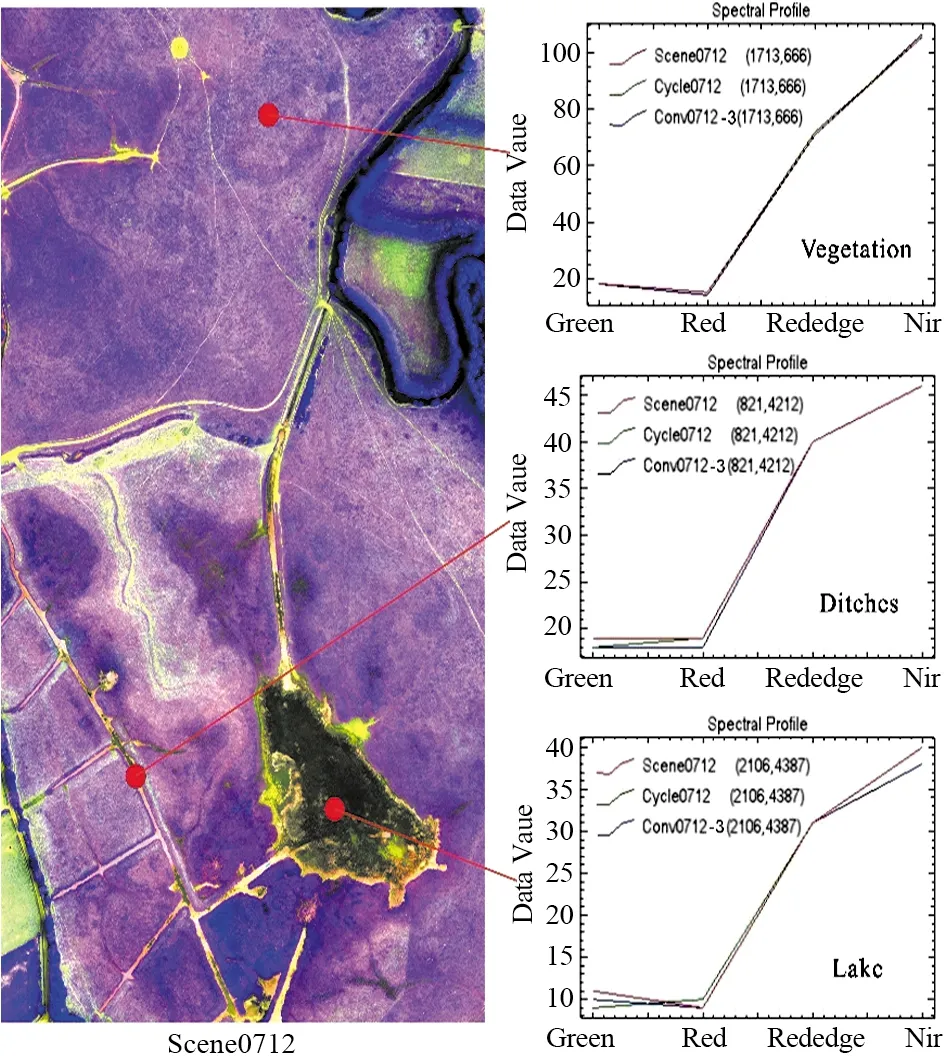

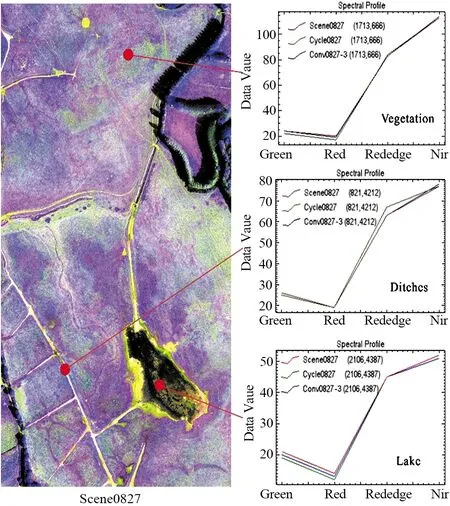

2.5.3 不同点位光谱曲线评价

下面比较2类网络在不同月份及最优的网络循环次数(CycleGAN:epoch=200,ConvLSTM:epoch=100)下的网络预测结果(CycleGAN:绿线,ConvLSTM:蓝线)与参考影像(红线)在植被点(1 713,666)、沟渠点(821,4 212)及湖泊点(2 106,4 387)的光谱特征。最终CycleGAN及ConvLSTM网络测试结果的点位光谱曲线如图11~图13所示。

不同点位的光谱曲线说明,CycleGAN及ConvLSTM网络预测结果能够与参考影像之间保持较好的空间及光谱特征。2种网络预测结果的RMSE分别小于4个像素和2个像素,2种网络预测结果的SSIM均达到0.99。ConvLSTM网络的整体性能优于CycleGAN网络,原因为ConvLSTM利用多个时序影像的状态信息。

图11 CycleGAN及ConvLSTM网络测试结果在 6月份的点位光谱曲线Fig.11 Point spectral curves of testing result in June of CycleGAN and ConvLSTM

图12 CycleGAN及ConvLSTM网络测试结果在 7月份的点位光谱曲线Fig.12 Point spectral curves of testing result in July of CycleGAN and ConvLSTM

图13 CycleGAN及ConvLSTM网络测试结果在 8月份的点位光谱曲线Fig.13 Point spectral curves of testing result in August of CycleGAN and ConvLSTM

3 结束语

采用CycleGAN色彩迁移方法及ConvLSTM网络遥感影像预测方法对生成所需时相的遥感图像能力进行了实验和验证,得出结论如下:

① CycleGAN网络的色彩迁移结果在视觉上与参考影像之间保持了较好的空间及光谱特征,局部存在细微边缘分块效应;ConvLSTM网络的预测结果在视觉上与参考影像之间保持较好的空间及光谱特征。

② CycleGAN网络可实现两景影像之间的双向自由转换,该网络受时序影像缺失的影响程度较小;ConvLSTM网络在预测时考虑了时序影像的状态信息,该网络受时序影像缺失的影响程度较大。

基于本文实验结果,在进行所需时相遥感影像预测时,需要根据时序影像缺失的程度进行不同网络的选择。当时序影像缺失程度大时,可选择CycleGAN网络进行色彩转换获得所需时相影像;当时序影像缺失程度小时,可选择ConvLSTM网络进行影像预测。当然,根据时序影像缺失的程度进行网络的选择并不是遥感影像预测唯一考虑的因素。因此,在未来的工作中对影响CycleGAN及ConvLSTM网络预测的因素做进一步的研究和分析。