基于深度学习的SAR与光学影像配准方法综述

2021-12-12魏泓安单小军霍连志

魏泓安,单小军,郑 柯,霍连志,唐 娉

(1.中国科学院大学 电子电气与通信工程学院,北京 100049;2.中国科学院空天信息创新研究院,北京 100094)

0 引言

影像配准是指从2幅或多幅影像中识别出相同或相似的结构并将其对应起来[1],异源影像配准则是影像来源或获取条件等不同的一种影像配准情况[2],相比于同源影像配准,异源影像往往包含较大的非线性差异。在遥感领域,影像配准是数据融合、目标识别等工作的关键前提,对异源遥感影像进行综合利用能够获取更加丰富的信息,光学与合成孔径雷达(SAR)影像各自存在优势与不足,将2种影像配准后提取信息将大大提高数据利用率,对后续应用有重要意义。

传统的影像配准通过比较所提取的影像特征或区域内像素的辐射强度的相似性进行配准,一般分为基于特征的方法和基于区域的方法[3]。基于特征的方法通常通过改进特征提取描述算子使其适应异源图像的差异,比如文献[4-7]等对SIFT[8]算子改进;或开发专门用于SAR与光学影像配准的特征提取描述方法,比如Ye等[9-10]提出的手工设计特征HOPC和CFOG;基于区域的配准方法关键是相似性度量的选择,主要分为基于信息理论的相似性度量[11-13]、基于辐射强度的相似性度量[14]和基于频率域的模态统一[15-16]等。

异源影像,尤其是SAR与光学这种成像机理迥异导致辐射和几何特征都有很大区别的影像,通常的配准方法所提取图像特征的相似性难以保证,因而难以提升图像配准的准确性。深度学习方法提供了新的特征提取工具。利用深度学习方法,无需手工设计特征提取和特征描述方法,基于特征相似性定义损失函数,驱动多层卷积神经网络提取到图像结构、纹理甚至语义等各个层级的适宜图像配准的深度特征,可准确地完成图像间非线性关系的估计,能更好地适应异源影像之间的差异,达到优异的配准效果。

近年来,异源影像配准得到了许多关注[2]并在医学影像[17]等领域迅速发展,在遥感领域虽有一些配准方面的综述[18]或关于深度学习的配准总结[19],但少有聚焦于SAR与光学影像配准的深度学习方法回顾。

根据是否直接从SAR与光学影像上提取待匹配特征,本文将基于深度学习的SAR与光学影像配准方法分为特征描述符学习(Feature Descriptor Learning)与风格迁移(Style Transfer)两大类,特征描述符学习方法直接使用深度学习网络提取2种影像上的特征及特征描述向量进行配准[20-23];风格迁移方法则将其中一种影像通过深度网络转换为与另一种影像模态特征相似的影像[24],统一模态后再通过传统或深度学习的方法提取特征进行配准[25]。

本文将基于深度学习的SAR与光学影像配准分为特征描述符学习和风格迁移2类对现有研究进行汇总,详细介绍了现有的可用于SAR与光学影像配准的公开数据集和自制数据集方法,对研究中用于衡量配准效果的评价指标进行梳理和分析,最后进行总结和未来可能的发展方向展望。

1 基于深度学习的SAR与光学影像配准方法分类

影像配准的主要途径是通过提取2幅影像的特征进行特征匹配找到对应同名地物匹配点的过程。基于深度学习的配准方法是通过提取图像深度特征进行特征匹配的过程。SAR与光学影像匹配的特征描述符学习方法通过深度神经网络学习提取2种影像上的深度特征描述符进行匹配;SAR与光学影像匹配的风格迁移方法重点是通过深度神经网络学习将一种模态影像转换为与另一种模态,然后再匹配。

1.1 特征描述符学习方法

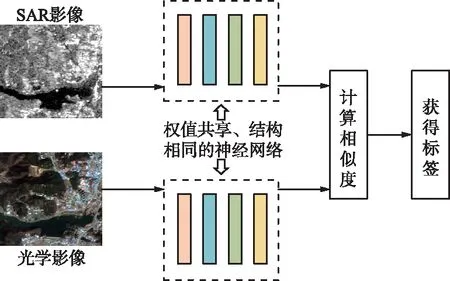

在特征描述符学习的深度神经网络配准方法中孪生网络[20](Siamese Network)及其变体是非常流行的网络框架,孪生网络结构如图1所示。孪生网络是基于2个人工神经网络建立的耦合构架,是“连体的神经网络”,神经网络的“连体”是通过共享权值来实现的。孪生网络的双流架构使其天然适用于图像配准的双输入任务,它以2个样本为输入,2个子网络各自接收一个输入,输出2个输入图像的特征描述符,通过计算特征描述符的相似性距离(或损失函数),例如欧式距离,以比较2个样本的相似程度。特征描述符学习方法的不同主要体现在特征提取器和特征相似度计算方法的不同上。

图1 孪生网络结构Fig.1 Architecture of Siamese Network

Zhang等[26]使用孪生网络对多源遥感图像进行配准,特征提取结构与HardNET[27]相似,使用7层卷积层步幅改为1以减少输出得分图的空间准确度损失,采用二元交叉熵作为网络损失进行优化,网络输出的得分图表示主从影像在大幅搜索影像各个点上的相似度得分,该得分将会作为匹配点选取的唯一标准。Ma等[28]采用预训练的VGG-16网络进行微调用来提取影像各个层特征,从深到浅对特征进行匹配,然后利用空间关系对配对结果约束进行位置调整以减小配准误差。Zhang等[29]同样使用孪生网络结构,使用VGG进行像素级深度稠密特征提取在高级抽象信息和低级信息保存之间获得更好的平衡。由于稠密特征相较于一般深度学习网络中的稀疏特征计算量大很多,该方法使用误差平方和(SSD)作为相似性度量在频域得到显著加速,结合softmax归一化和负难例挖掘取得了良好的配准效果。

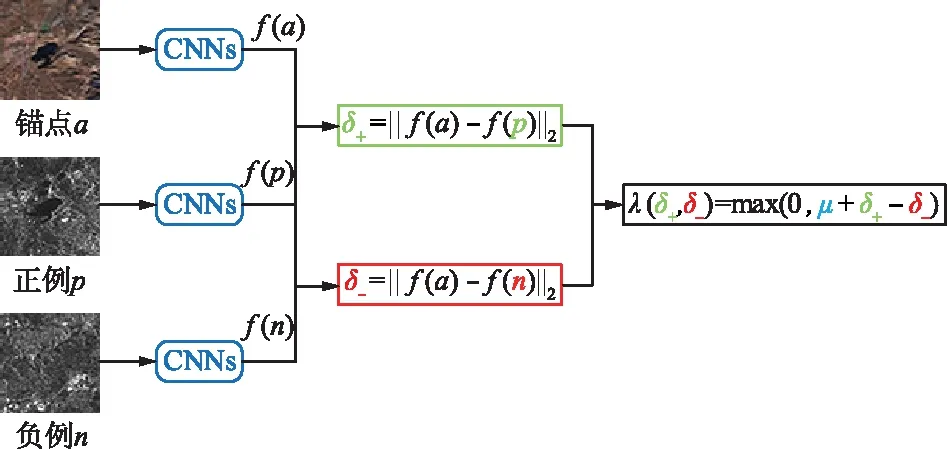

与孪生网络共享网络权重参数不同,伪孪生网络(Pseudo-Siamese Network)是指双支路网络结构相同却有独立权重参数的网络结构。一般认为,伪孪生网络可以学到特定于模态的特征,因而能在一定程度上更好地适应SAR与光学图像不同的特征表示,但也大大增加了数据量和计算负担。伪孪生神经网络如图2所示,两边可以是不同的神经网络(如一个是LSTM,一个是CNN),也可以是相同类型的神经网络。

图2 伪孪生网络结构Fig.2 A rchitecture of Pseudo Siamese Network

Hughes等[30]提出的用于SAR和光学图像稀疏图像匹配的三步框架包含3个子网络,分别实现粗匹配、精匹配和误匹配剔除3个步骤,实现端到端的异源大幅遥感影像配准。粗匹配和精匹配网络都采用伪孪生网络结构,粗匹配网络使用VGG-11骨架和二元交叉熵损失;精匹配网络使用多尺度特征提取、空间注意力特征降维和均方误差损失;误匹配剔除网络认为良好匹配的特征点在对应模态图像中有且仅有单一特征点与之相对,所以精匹配网络输出的热力图分布应表现为单一窄峰而不是多峰或广泛分布,使用多个卷积与池化层的组合,采用Sigmoid激活函数和二元交叉熵损失函数,将误匹配剔除任务化为热力图二分类问题,通过设置网络输出概率置信度过滤分布弥散的热力图从而达到误匹配剔除的目的。在训练和测试阶段,该研究中的网络组有不同的工作流程,训练时数据集首先输入精匹配网络,再由精匹配网络训练的结果训练粗匹配网络和误匹配剔除网络;预测时先将大幅影像输入进粗匹配网络得到可能适合匹配区域,再由精匹配网络预测配准点,最后经过误匹配剔除网络得到最终的高精度但稀疏的配准点。Mou等[21]采用伪孪生网络实现超高分辨率SAR与光学图像对的匹配,Hughes等[22]对其进行扩展,通过改进网络结构中双支路融合的部分,使用不同的训练策略,纠正了配准中存在的正偏差结果。Quan等[31]对光学和SAR影像分别设计了生成器和判别器来生成与原始图像对应的不同模态图像,从而获得大量的匹配光学SAR图像对,利用伪孪生网络结构和二元交叉熵损失优化网络进行配准。

Bürgmann等[32]使用改进的HardNET为基础在孪生网络双支路的结构上增加难负例支路构成三元损失,如图3所示。将锚点、与锚点匹配的正图像和与锚点不匹配的负图像同时输入网络,通过正负样本欧几里得距离之差加上特定余量来计算损失,赋予网络区分图像对是否匹配的能力。该方法使用了锚点交换技术,即正负例间距离小于锚点与负例间距离时锚点与正例交换,以此保证使用最难辨别的负例来训练网络达到更好的配准效果。

图3 三元损失孪生网络Fig.3 Triple loss Siamese Network

在不使用孪生网络的描述符学习方法中,为了减少缺乏数据集对深度学习匹配带来的影响,Hughes等[33]提出了一种半监督学习的方法对SAR与光学图像进行配准,该方法使用自动编码器对标记和未标记的描述符进行半监督学习,并使用对抗性损失来对齐描述符代表的隐空间。该网络由双支路自动编码器和判别器组成,自动编码器的编码部分基于VGG-11进行改进将输入图像进行特征提取获得描述符,解码器部分由卷积和转置卷积层构成对描述符进行重建,训练过程中获取所有图像的重建损失和带标签图像的匹配损失进行优化;判别器是一个3层的全连接网络,通过对隐代码施加连续先验分布来减小数据不足造成的影像,增加潜在空间的平滑性。

1.2 风格迁移方法

风格迁移类的图像配准方法是通过风格迁移将匹配图像实现模态统一后再进行配准的方法。风格迁移类图像配准方法包括2部分:第一部分是风格迁移,通常使用生成式对抗网络(Generative Adversarial Networks,GAN)[24];第二部分是使用传统或深度学习方法对统一模态后的影像进行配准。

风格迁移部分中的GSN与孪生网络类似,也是由2个网络组成的网络组,但GAN包含的2个网络是相互独立实现不同功能的,与传统GAN输入噪声不同,在风格迁移任务中生成器的输入往往是一种模态的图像,生成有另一种模态特征的合成图像输入到判别器中,判别输入图像是真实图像还是合成图像,通过2个网络的对抗让生成器生成更加逼真的异源图像,网络架构如图4所示。虽然雷达影像具有更高的地理定位精度,但现有研究几乎全部使用光学图像作为基准生成类SAR图像,原因在于风格迁移的过程很难真实的模拟光学影像丰富的光谱特征,并且SAR影像上的斑点噪声也不适合作为生成器的输入样本。

图4 风格迁移的生成式对抗网络Fig.4 Generative adversarial network on style transfer

Du等[25]提出了一个K-means聚类生成对抗网络(KCG-GAN),通过约束空间信息来提高合成的图像质量,该方法将SAR影像的K-means分割作为GAN的一个输入来控制空间信息,利用对抗损失结合特征匹配损失、L1损失和分割损失对网络进行训练,其中L1损失能够确保生成图像与原图像内容的一致性;特征匹配损失最小化判别器在识别图像对真假时在各层提取特征的差别,能够使训练更加稳定并且产生一个自然的高频结构来增加纹理细节。Merkle等[34]利用条件生成对抗网络(cGAN)[35]从光学影像生成类SAR影像来改善传统配准方法在SAR与光学图像配准上的表现。该方法首先使用土地覆盖类型辅助半手工选取适合进行匹配的区域,即几何外观大致相同并包含显著特征的区域,可以很大程度上避免由SAR成像机理造成的几何畸变对配准的影像;接下来利用具有U-net结构的cGAN从光学影像生成具有光学几何特征和SAR辐射特征的类SAR影像;最后使用传统的基于特征和强度的方法对真SAR和类SAR图像进行配准。

除利用GAN实现模态统一外,宋智礼等[36]基于VGG网络实现风格迁移算法,得到由浮动图像提供内容信息、基准图像提供风格信息的合成图像,再将之与基准图进行配准以获得更好的效果。该算法使用了16个卷积层和5个池化层,取消了全连接层,分别计算浮动图像与生成图像之间的内容差异和基准图像与生成图像之间的风格差异,并以最小化二者之和为目标构建损失函数训练网络。风格迁移后将原始浮动图像中没有明显纹理的区域替换到生成图像中去掉多余的纹理以免影响配准结果。最后,利用加速鲁棒性特征(SURF)[37]算法提取特征点,对最终的生成图像和基准图像进行图像配准。

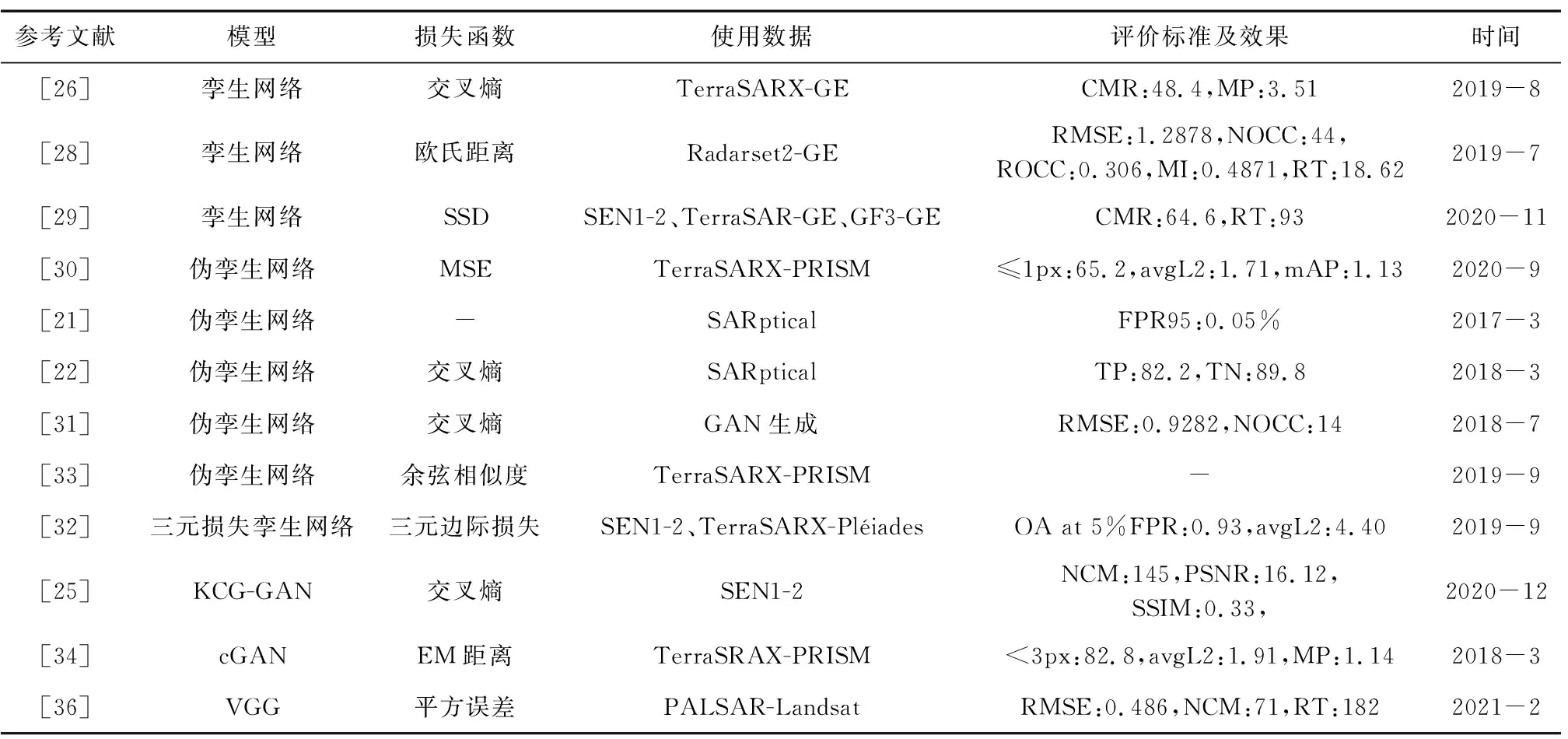

以上方法的模型、损失函数、使用数据、评价标准及效果和发表时间如表1所示。其中“使用数据”栏中的SEN1-2和SARptical为公开的用于配准的数据集,其他数据均为自制数据集,2种模态的数据中间用连接号相连,连接号前为SAR数据来源,连接号后为光学数据来源;表中“评价标准及效果”栏是原文中给出的。由于数据集不同、图像对数量不同等影响,该栏无法直观代表各方法的优劣。

表1 各方法对比

2 图像匹配训练数据集

基于深度学习的影像配准算法必须有数据集的支撑以训练特征描述符提取网络。由于数据获取和处理的不易,相对其他单模态或计算机视觉领域深度学习的公共数据集,现有的可开放获取的SAR与光学影像数据已配准的数据集数量较少,主要包括SEN1-2[38]系列、So2Sat LCZ42[39]系列等。上述系列数据集包含的数据皆为哨兵一号SAR影像和哨兵二号光学影像,这是由于哨兵一号、哨兵二号影像具有匹配度高、连续性好和免费获取的便利,因此图像匹配数据集大多来源于此。为了丰富训练数据的多样性、提高网络的泛化能力,很多学者也会选择自制数据集。接下来将从现有数据集和自制数据集两方面介绍基于深度学习的SAR与光学影像配准中数据集的使用情况。

2.1 现有数据集

现有用于影像配准的公开数据集中使用最广泛的是SEN1-2数据集[38]。该数据集中包含282 384对已配准的哨兵一号合成孔径雷达影像和哨兵二号光学影像,图像尺寸为256 pixel×256 pixel,位深为8位。SEN1-2数据集是首个包含超过100 000对图像对的SAR与光学遥感影像数据集,该数据集中的影像采样自全球大部分地区和国家,包含城市、耕地、林地、山地和水体等不同种类的地物,数据的丰富性使其能够赋予网络良好的泛化能力潜力,并且数据集按照季节和ROI区域进行组织划分可以容易地分成独立的训练和测试数据,支持对不可见数据进行无偏估计。多篇基于深度学习的SAR与光学影像配准研究[25,29]使用此数据集进行研究。

SEN1-2中哨兵一号C波段SAR影像的方位向分辨率为5 m,距离像分辨率为20 m,采用VV极化,利用恢复的轨道信息与30 m SRTM-DEM进行了精确的几何校正,SRTM-DEM缺失的部分采用ASTER DEM进行补充,为了使数据集能够满足不同的使用需求,没有对SAR影像进行斑点噪声去除。哨兵二号光学影像采用红、绿、蓝(波段4、3、2)三通道真彩色合成,与哨兵一号类似未对影像辐射强度进行进一步处理,采用原有的大气层顶辐射值来适应后续使用的不同需求。使用谷歌地球引擎(Google Earth Engine)对原始数据进行处理,处理步骤包括随机ROI采样、数据选择、图像镶嵌、图像导出、首次人工检查、瓦片化和二次人工检查。人工检查的作用是去除大面积无数据区域、厚云区域和强变形区域等以保证数据集的良好质量。

数据集SEN12MS[40]是在SEN1-2基础上对其进行扩展增加了MODIS土地覆盖数据形成的三元图像对数据集。该数据集包含180 662组已配准的哨兵一号双极化SAR数据、哨兵二号多光谱数据和MODIS衍生的土地覆盖类型图。与SEN1-2相似,SEN12MS数据集中的影像同样包含多种地物类型,数据采样自全球大部分地区和国家,并且按照四季和ROI区域进行组织划分。但数据格式不同,SEN1-2中的图像是8位的PNG格式,SEN12MS提供16位GeoTiffs格式数据,分辨率全部重采样至10 m,哨兵一号SAR数据包含VV和VH极化两通道,哨兵二号包含13个多光谱波段(B1,B2,B3,B4,B5,B6,B7,B8,B8a,B9,B10,B11,B12),MODIS土地覆盖数据包含IGBP、LCCS土地覆盖、LCCS土地利用和LCCS地表水文4个通道。数据集SEN12MS的数据处理在SEN1-2数据处理流程的基础上将多光谱无云数据提取进行细化,牺牲一部分数据数量来提高数据质量。

SEN12MS-CR数据集[41]又是在数据集SEN12MS基础上发展而来的。该数据集将SEN12MS中的MODIS土地覆盖数据换为有云的哨兵二号多光谱数据,用于去云深度神经网络的训练。数据集包含122 218组已配准的哨兵一号双极化SAR数据和哨兵二号无云、有云的多光谱数据,以16位的GeoTiffs格式提供。

除SEN系列外,2020年发布的So2Sat LCZ42数据集[39]同样使用哨兵一号、哨兵二号数据,包含400 673组32 pixel×32 pixel大小的已配准的SAR与光学图像对,此外还包含与其对应的局地气候区(Local Climate Zones,LCZ)分类标签,分布在全球不同国家和文化区域的42个城市。其中哨兵一号数据通过ESA SNAP软件进行处理,包括应用轨道文件、辐射校准、TOPSAR去脉冲、偏振斑点噪声去除和地形校正5个步骤;哨兵二号通过谷歌地球引擎和Matlab进行查询、评分和拼接3步处理。So2Sat LCZ42数据集提供h5格式数据,分为3个版本:版本1包含训练集和验证集,版本2增加了测试集,版本3增加了其他2种训练集测试集分割。

数据集SARptical[42]提供了更精细尺度上的数据,由2009—2013年间柏林区域的109张1 m分辨率Terra-SAR数据和9张20 cm分辨率Ultra CAM数据,分别使用差分SAR层析反演(D-TomoSAR)和光学多视图立体匹配估计来自SAR和光学数据的3-D点云进行匹配,匹配精度1~2 m,图像大小112 pixel×112 pixel。值得注意的是,由于无人机相对于卫星成像距离近成像频率高的特性造成了其影像角度的多样性,一张SAR影像可能对应多张不同角度的光学影像。虽然SARptical具有超高分辨率,但数据量较小,只有10 000对左右,并且图像之间有50%左右的重叠,另外数据获取范围局限在建筑物密集的城市区域地物类型单一,使其在深度学习应用中使用十分受限,没有SEN1-2数据集使用广泛。MOU等[21]和Hughes[22]等使用了此数据集。

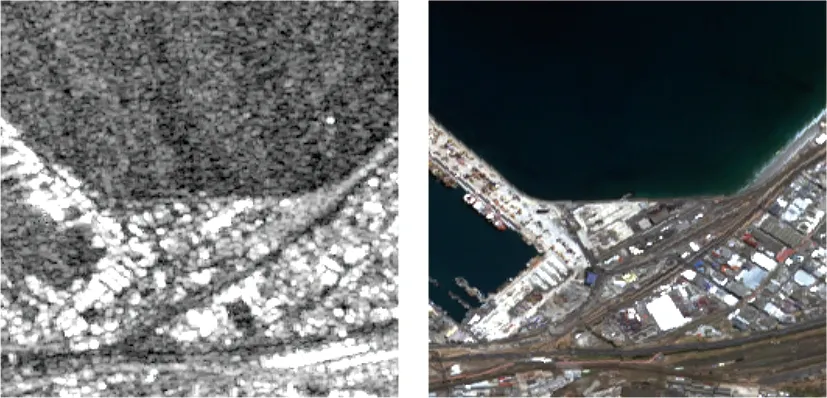

SEN1-2数据集和SARptical数据集的影像样例如图5所示。高分辨率城市地区的SAR影像往往伴随更加严重的几何畸变。从图5中可以看出,尺度更大、分辨率较低的SEN1-2数据集SAR与光学影像整体结构上的视觉相似度比小尺度、高分辨率的SARptical数据集高,使SEN-2数据集更加适合深度网络的配准任务。SEN1-2衍生数据集和So2Sat LCZ42数据集虽然包含配准的SAR与光学影像图像对,但却是为专门的任务开发,在配准方面实用性不高。目前研究中SEN1-2数据集和SARptical数据集仍为主要使用数据。现有公开数据集的影像来源、分辨率、图像对数量和图像尺寸等信息如表2所示,列出了现有用于影像配准的公开数据集信息。

(a) SEN1-2数据集样例

表2 公开数据集

2.2 自制数据集

由于公开的图像匹配数据集大多来源于哨兵一号、哨兵二号的影像,无法满足一些研究对数据来源多样性的需求,许多学者选择自制更符合研究要求的数据集。自制的途径有2种:一是将所研究的多光谱和SAR影像配准后裁剪生成训练数据集;二是利用生成式对抗网络将一个模态的数据转换成另一个模态生成数据集。

Merkle等[34]的自制数据集使用了46对正射校正,并利用Urban Atlas项目配准的2.5 m分辨率光学(PRISM)影像和1.25 m分辨率SAR(TerraSAR-X)影像,总体配准误差在3 m以内,覆盖欧洲13个城市的郊区、工业区和农村地区。为了获取更大的数据集,将PRISM数据重采样至3.75 m,将TerraSAR-X影像重采样至2.5,3.75 m分辨率,并且为了探索斑点噪声对匹配效果的影响,用Deledalle等[44]的方法进行了斑点噪声去除。Zhang等[26]采用3对大区域的谷歌地球光学影像与TerraSAR-X雷达影像制作数据集,其中2对数据为德国区域,图像分辨率为3 m,另一对为加拿大区域,图像分辨率为1.75 m。大区域图像经过粗配准、在主从影像上搜索特征点、精配准、选取更多高置信度配准点等处理步骤后,裁剪了30 178对65 pixel×65 pixel和85 pixel×85 pixel大小的图像对,组成配准的SAR与光学影像数据集。

利用GAN影像模态转换生成制作数据集的方法主要包括2种途径:一是将一种模态的影像风格迁移到另一种模态,再将相同模态的影像进行配准;二是用单幅影像生成与之相对应的另一模态影像组成配准影像对,进而生成跨模态配准数据集。Merkle等[34]采用第1种途径,利用小型已配准的SAR与光学数据集训练生成式对抗网络获得带有光学几何特征的人工类SAR影像后与真实SAR影响进行配准;Quan等[31]提出的生成匹配网络(Generative Matching Network,GMN)采用第2种途径,利用GAN为真实的光学和SAR影像生成其对应的不同模态模拟图像,其中采用生成损失、图像损失和重建损失分别从分布、像元和重建3个方面对网络进行优化,图像损失指生成图像与原始图像之间逐像元的欧氏距离,重建损失是指原始图像通过2个生成器重建的同模态图像与原始图像之间的差别,获得成对的配对和非配对SAR与光学影像带标签数据集。

3 图像匹配评价指标

基于深度学习的SAR与光学影像配准评价和传统方法图像配准的评价没有根本的不同,现有研究中一般通过3个方面的指标进行评价:均方根误差(Root Mean Square Error,RMSE)和互信息(Mutual Information,MI)、配准点数(Number of Correct Correspondences,NOCC)和配准率(Rate of Correct Correspondences,ROCC)以及配准效率。

均方根误差:评估配准精度,值越小代表配准效果越好。计算公式为

(1)

式中,N为用来评价配准精度的配准点对{(xi,yi),(x′i,y′i)}总数。文献[23,25,28,31,36]使用RMSE对配准效果进行评估。

互信息:代表2个数据集之间的统计相关性,可以作为一种图像对的相似性测量度量,评价配准精度[28]。2幅图像X,Y之间的MI计算公式为

MI(X,Y)=H(X)+H(Y)-H(X,Y),

(2)

(3)

(4)

式中,H(X),H(Y)分别为图像X,Y的信息熵;H(X,Y)为两图像的联合熵;N为图像的灰度级数;p为某一灰度级出现的概率。计算时可根据实际情况确定对数运算的底数,不同底数运算取得的熵值单位不同。

配准点数:评价配准方法的鲁棒性。配准点数是指配准方法在图像中获得的正确匹配的配准点。配准点数越多,得到精确的配准结果越容易。

配准率:评价配准方法鲁棒性的另一个指标,表示配准点数在总配准数中的比例。匹配结果中通常会有误匹配点。误匹配点数(Number of False Correspondences,NOFC)的多少影响配准的鲁棒性,因此,采用ROCC评价配准的鲁棒性。配准率是在配准点中去除误匹配后正确匹配点占配准点数的百分比,计算公式为:

(5)

配准点数与配准率是基于深度学习的SAR与光学影像配准结果评价中最常用的指标。Quan等[31]、宋智礼等[36]以及Shabanov等[45]统计了配准点数量;Zhang等[26,29]统计了配准率;Du等[25]和Ma等[28]等同时统计了配准点数和配准率。

文献[30]认为少数高质量配准点即可准确估计图像变换参数,因此在配准过程中加入非极大值抑制等步骤减少配准点数量,导致配准点数量无法直接用于判断配准效果的优劣。更精细的配准率评价统计了配准误差在1像元和3像元以内的配准率。

匹配效率通常用网络推理时间(Running Time)衡量,配准网络DDFN在GPU环境下对18 144对图像对匹配时间为93 s,远小于其他配准方法[29],证明其提出的FFT加速策略效果显著。

4 结束语

随着深度学习方法的不断发展,其在SAR与光学配准领域的应用获得了长足进步[46],从仅使用CNNs提取特征到端到端的自动配准网络组,配准效果得到了大幅度提高。但开发一个快速、准确提取异源图像配准点的网络仍面临以下挑战:

① 数据集仍然不足。SAR与光学配准网络的训练需要大量已配准的图像块,然而制作配准精度高、数据量大的已配准数据集需要对大幅原始数据进行手工配准裁剪等处理,耗费大量人力物力。SARptical数据集[42]和SEN1-2数据集[38]是现有研究中使用最广泛的数据集,但仍无法满足不同研究的多样性需求。

② 误匹配点难以剔除。由于遥感图像相对其他领域图像的复杂性以及异源影像的差异性,特征提取、描述和匹配相当困难,而且利用图像局部信息产生的特征之间的相似性作为匹配标准必然会产生一定数量的误匹配,这将会严重影响图像变换的准确性进而影响最终配准结果。

③ 匹配效率提升困难。由于异源数据在辐射、几何特征上的巨大差异导致网络参数增多,即使使用孪生网络同步更新双支路参数也会比同源数据消耗更多计算量,因此SAR与光学影响匹配的网络训练和预测效率难以得到提升。

针对以上问题,基于深度学习的SAR与光学影像配准将在以下方面寻求突破:① 开发能够使用非对应数据集的半监督[33]、无监督网络,或使用迁移学习等方法来适应数据集的不足;② 探索更加适合深度网络的误匹配剔除方式[30]代替传统RANSAC等方法对配准点进行优化;③ 优化网络结构减少参数或使用FFT等加速方法提高配准效率。