追踪过程中的无人机目标重定位方法研究

2021-12-03刘云平朱帅晖张婷婷

刘云平, 朱帅晖, 张婷婷, 许 军

(1.南京信息工程大学 自动化学院, 南京 210044; 2.陆军工程大学 指挥控制工程学院, 南京 210017)

1 引言

近年来,无人机作为成本低,机动性及可扩展性强的载体,在作战中利用计算机视觉进行目标追踪[1-3]成为热点问题。然而无人机在战场环境执行任务时面临着两大挑战,环境因素影响:严重遮挡、光照变化、距离突变等带来的目标丢失;目标与自身带来的挑战:目标的几何变形、旋转和无人机姿态变换等造成的追踪失败。

针对上述挑战,早期的学者们基于传统图像处理方法提出了多种追踪器,根据目标外观模型表达的不同,可分为生成模型和判别模型两类。生成模型广泛应用于高精确度的研究,如LIU等[3]提出了一种基于混合模型的在线学习追踪算法;叱干鹏飞等[4]提出了基于全局搜索的实时分布场目标追踪方法。而判别模型在高速性及节省资源上有明显优势,其代表算法即2014年Henriques等提出的核相关滤波算法Kernel Correlation Filter(KCF)[5]。ZHAO等[6]采用局部稀疏编码作为PF的外观模型,利用改进的模型捕捉目标尺度变化,加强了模型对多尺度目标的追踪能力。WANG等[7]通过研究局部模型,设计出一种感知目标局部信息的核相关滤波器算法,算法的鲁棒性获得了较大的提升。李健宁等[8]在多尺度下改进颜色特征有效提升了尺度变化下跟踪器的鲁棒性。随着深度学习的发展,先在大规模图像数据集上训练样本,再利用分类器识别追踪目标[9-10]也成为了热点方法之一。以上学者对算法的改进有效提高了追踪过程中的精确度,但在战场复杂环境下,上述方法缺乏对误差产生后解决方案的关注,存在短时间遮挡引起目标丢失,丢失后无法二次定位和尺寸误差持续积累,缺少校正等问题。同时为了应对无人机追踪的实际需求,目标丢失时无人机失去引导的问题也亟待解决。

本文针对上述问题,提出一种利用轨迹预测和空间感知重定位目标的无人机目标追踪方法,并设计仿真和实机追踪实验验证方法的有效性。

2 软件框架

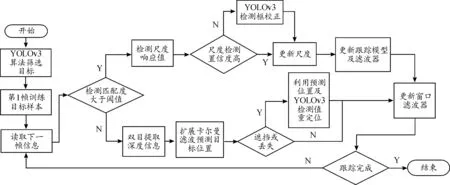

本文系统软件的算法实时追踪流程如图1所示。首先利用YOLOv3算法识别目标,并将框选区域用于KCF的样本训练;设置匹配度检测方程,匹配度不足则利用SGBM计算的位置信息进行扩展卡尔曼滤波预测目标位置;随后判断遮挡情况,利用预测位置及YOLOv3检测结果对遮挡目标重新定位。的当算法以高匹配度识别到目标时,则检测目标尺寸,通过YOLOv3校正后更新模型及滤波器,完成追踪过程。

图1 算法实时追踪流程框图

3 动态目标识别与追踪

3.1 动态识别优化

(1)

3.2 动态追踪优化

3.2.1双目立体视觉测距

传统KCF算法追踪窗口大小固定,当目标尺度迅速变化时,追踪窗口提取特征不充分,易产生大幅漂移和分类器模型信息错误的问题,引导无人机向错误方向飞行。本文采用双目立体视觉技术对目标进行空间定位和测距,保持相对位置的稳定性。步骤如图2所示,包括双目标定、立体校正、立体匹配、视差计算和深度计算。Matlab完成双目标定,得到相机的内外参数后,为满足实际飞行的实时性要求,采用Bouguet进行立体校正和局部立体匹配算法semi-global block matching(SGBM)生成视差图,计算方式如式(2)、式(3)所示:

(2)

(3)

式(3)中:R为旋转矩阵,T为平移矩阵;Rl和Rr分别为左右相机旋转一半的旋转矩阵;e1为主光轴方向;e2为主光轴正交方向;Rrect为左相机的左极点矩阵。通过上述旋转矩阵的变换,能将原双目立体图像平行配置并导入SGBM算法中计算视差。SGBM算法选取左右目图像的视差组成视差图,并设置能量函数求解最小值使其达到最优,原理如式(4)所示:

(4)

式(4)中:E(D)指视差图所对应的能量函数;p和q代表双目图像中的像素点;C(p,Dp)指p像素点视差为Dp时的代价;P1、P2为惩罚系数,分别作用于像素p相邻像素中视差值与p的视差值相差等于1和大于1的像素;I[]函数在[]内为真时返回1,否则返回0。在求解最小值后,获得的视差图噪声小,平滑度高,在中近距离能获得精确结果,处理过程及效果如图2所示。

图2 双目立体视觉测距流程及效果示意图

获取目标空间位置信息后,无人机通过差速驱动的方式进行运动,根据稳定距离区间[dmin,dmax]和测定距离Dd来调整无人机在目标物方向上的线速度。

(5)

式(5)中,V为无人机最大安全飞行速度,为常数。

3.2.2目标外观模型更新

在追踪过程中,为使每一时刻算法准确追踪目标,需实时保持目标外观模型的完整性,本文设计偏移误差Ed对预测框与目标位置的贴合度进行评估,将KCF算法预测的目标框体面积Sk与YOLO算法检测的目标大小Sy进行比较,比值作为面积误差;2种算法计算出的目标重叠度So作为重叠误差;当前时刻与前一时刻的2种误差变化量Ev作为误差修正值,最后由式(6)计算出位置误差Ed:

(6)

如果Ed高于阈值T,则通过YOLOv3当前帧与上一帧预测框的交并比(IOU)判断有无出现遮挡情况。IOU>0.5 判断为无遮挡,则提高更新率;IOU<0.5判断有遮挡,则保持原来的外观模型,并将学习率减小为0,等待YOLOv3的检测数据进行重定位。如果Ed低于一定的阈值T,则认为追踪过程不存在严重的位置偏差和目标外观遮挡,保持追踪过程不变,并进一步进行尺度检测。根据双目标定后的内外参数,定义距离与预测框大小匹配度k:

(7)

在k=-1时,则认为目标尺度的更新结果不可信,通过YOLOv3算法重新规划KCF算法追踪框。

3.2.3运动轨迹预测

目标丢失时,无人机缺少目标位置的引导极易导致目标脱离视野范围,本文利用扩展卡尔曼滤波器(extended kalman filter,EKF)对目标被遮挡时的位置信息进行预测。由于无人机追踪系统可看作恒定转率和速度模型(constant turn rate and velocity,CTRV),误差来源于直线加速度和偏航角加速度噪声,因此目标状态量可设为:

(8)

式(8)中:x、y为目标的横纵坐标,v为目标线速度,θ和ω为偏航角和偏航角速度。对目标状态量进行积分并加入迭代过程,可得到状态转移函数g:

(9)

目标的测量模型由双目相机获取,测量空间内数值Hk和加速度噪声uk可表达为

(10)

(11)

4 实验

4.1 实验平台与参数

本文设计了仿真测试并开发了实物样机对算法性能进行验证。在Windows 10系统下利用Matlab 2017a进行追踪算法仿真和结合EKF算法的路径预测仿真;在ubuntu18.04系统下利用ros-melodic和gazebo进行物理引擎下的追踪算法仿真。实机测试平台为850轴距六轴无人机。无人机搭载NVIDIA Jetson TX2开发板和ZED2双目相机。相机基线为12 cm,标定后可感知最大距离为20 m。组装后实机效果如图3所示。

图3 实验硬件平台图

4.2 数据集制作与识别效果

为保证YOLOv3在追踪任务执行中的可靠性,本研究选取作业无人机预先在实验场地拍摄的200张包含追踪目标的实景图片,结合100张仿真构建的无人机图片进行标注和训练,部分标注数据及识别效果如图4所示。

图4 部分标注数据及识别效果图

4.3 目标重定位验证

本文采用一架任务机和一架靶机进行目标丢失下的追踪实验,对比传统KCF算法与本文提出的算法在追踪任务中发生大面积遮挡时的情况,实验效果如图5所示。

由图5(a)24帧可看出:传统KCF能够在无干扰情况下完成追踪任务,但在图5(a)86帧下,目标受到红色遮挡物的大面积遮挡,追踪框发生了错误的位置偏移。即使图5(a)113帧下,目标已脱离遮挡范围,算法仍无法重新找回目标。

改进后的算法能够实时对目标位置及尺度进行判别并及时修正。图5(b)第18帧目标未被遮挡,算法正常实现追踪效果。图5(b)第52帧时,目标被红色遮挡物完全遮挡,算法停止模板和尺度的更新,等待YOLOv3对追踪目标进行重新初始化。在图5(b)第127帧下,目标脱离遮挡范围后 YOLOv3算法检测到目标位置及尺寸,重新初始化追踪窗口并继续完成目标追踪任务。

4.4 改进算法的无人机飞行验证

上述实验验证了追踪无人机能够有效的在视野范围内跟踪目标靶机,并在丢失后重新找回目标。为进一步验证所提算法能够有效引导无人机完成实际飞行任务,并具有足够的实时性、可靠性,本文将算法在850轴距6轴无人机平台进行了基于图像的追踪测试[13-15]。

如图6(a)所示,对追踪过程中的目标位置数据进行扩展卡尔曼滤波,预测值因测量值的波动在定位不准的A段产生小范围偏移,但仍能进行有效预测;而在平稳飞行的B段获得了稳定可靠的预测效果,因此整体可作为重定位时的信息补充;图6(b)为Matlab下完整算法的仿真效果,算法引导的任务机轨迹能够准确地追踪目标轨迹,并在定位不准时及时修正飞行轨迹;同样,算法在图6(c)gazebo的物理引擎测试下也取得了稳定的追踪效果。实机验证时,考虑无人机轴距与安全飞行要求,将任务机与靶机保持一定距离后开始任务。如图6(d)所示,实际环境对两机的飞行轨迹平滑度影响较大,但仍能看出任务机可有效追踪靶机。

图5 2种方法在目标遮挡下的追踪效果图

图6 仿真和实机追踪效果曲线

5 结论

从追踪任务中对目标的重定位和空间感知两个方面进行研究,利用YOLO算法对KFC算法进行初始化及校正,使算法能够在丢失后重新找回目标;利用双目立体视觉观测目标空间信息,保持无人机与目标靶机的相对距离并判断图像的目标尺度及位置,提高了算法精度;通过扩展卡尔曼滤波预测目标运动轨迹,提高了目标暂时丢失时无人机的持续追踪能力。实验结果表明该方法引导任务机追踪实时性强,追踪精度较高,具有很好的校正能力。同时,实验发现YOLO算法对目标存在过量重新选取问题,过多的采用预测值引导会造成无人机飞行抖动。后续将针对目标区域的自适应更新能力进行改进,减少重新初始化次数。