基于伦理嵌入的人工智能新型风险治理体系建构及治理路径解析

2021-09-06孙丽文李少帅

孙丽文 李少帅

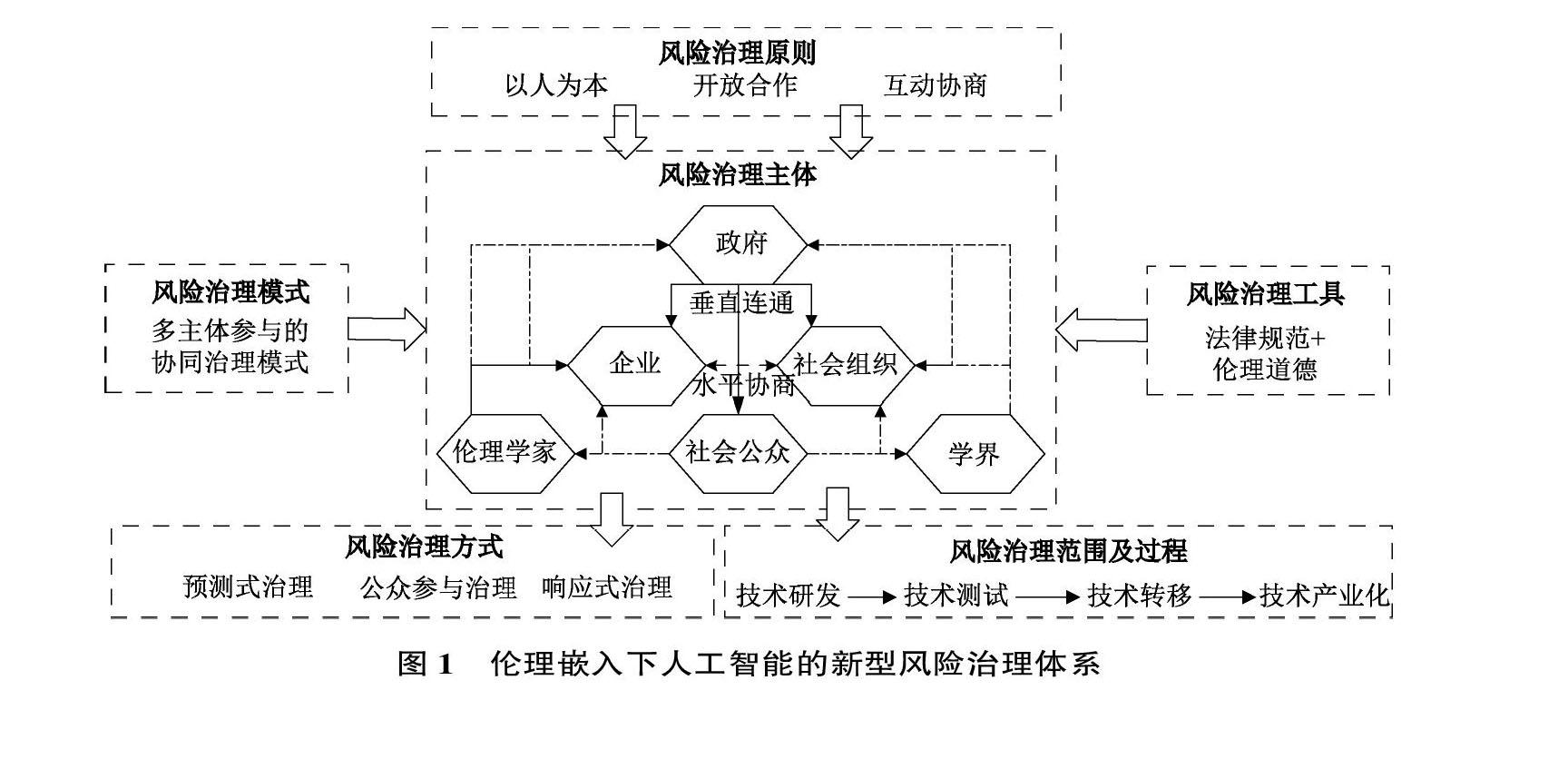

[摘 要] 人工智能在释放巨大潜能、产生经济价值和带动广泛的产业变革同时,也产生了诸多风险。而现有治理体系难以适应人工智能的高度开放性和不确定性,无法满足风险治理需求,同时人工智能技术应用引发的新兴风险治理议题超越了既有治理体系范围,传统风险治理体系急需向以伦理嵌入为关键支撑的新兴风险治理体系迁移。从伦理嵌入视角出发,构建了新型风险治理体系,摒弃了传统以政府为绝对主导的弊端,采取多主体参与的协同治理模式,强调风险治理主体之间的“垂直连通”和“水平协商”,并充分发挥伦理道德能动作用,将治理触角渗透进人工智能技术创新到规模化应用的诸多阶段,治理范围更加宽泛,治理方式更加灵活多样。同时,伦理道德通过内嵌于人工智能技术研发、技术测试、技术转移和技术产业化四个阶段,形成兼具分段治理和整体协同的风险治理路径。研究旨在降低人工智能风险等级,为发展负责任的人工智能提供理论指导和有益启示。

[关键词]风险治理;伦理嵌入;责任式创新;科技向善;人工智能

[中图分类号] F204[文献标识码]A[文章编号]1673-0461(2021)07-0022-07

一、引 言

作为21世纪最具深远影响的新兴技术[1],人工智能无疑拥有巨大的潜力和价值。人工智能技术的整体突破性创新使其跨越工业化应用红线,被广泛地应用于人类的生产生活实践,持续催生新商业模式、新经济业态,与实体经济融合程度也持续加深,成为极具发展前景的经济新动能。但在人工智能与社会生态系统交互性持续加深的同时,极具变革性的人工智能也引发了数据安全、隐私保护、算法歧视等风险问题 [2-3],加剧了人类和人工智能技术之间的矛盾。如何应对和化解人工智能风险危机,避免其陷入“科林格里奇困境”[4],实现经济效益和风险防范的合理平衡,成为目前对实践与研究都具有挑战性和突破性的议题。

现实层面,由人工智能引致的数据安全、隐私保护、算法歧视等风险已经成为国际社会近几年关注的焦点问题,并引发了全球范围内对人工智能技术创新及其产业化应用影响的伦理反思和讨论 [5-6],基于伦理嵌入的风险治理开始从幕后走向前台,成为应对和化解人工智能风险的关键考虑。在此背景下,从政府到企业界再到学术界,掀起探索制定人工智能伦理原则与框架的高潮。欧盟、OECD、G20、IEEE、英国、德国、谷歌、微软等均从各自的角度提出了相应的人工智能伦理原则或框架,共同加强人工智能知识的共享和可信人工智能的构建。虽然各界已经达成基于伦理观的人工智能风险治理共识,但是由于既有治理方法、治理工具等在面向人工智能等新兴技术风险治理时存在伦理缺失,对于基于伦理嵌入的风险治理原则、主体、模式、工具等关键问题仍缺乏系统性实践探索。

理论层面,人工智能技术创新及产业化应用的风险虽然同样引起了道德伦理和风险治理的相关讨论,但是整体理论研究进程明显滞后,难以成为风险治理实践的“及时雨”。当学者们将目光停留在如何将现有治理经验“移植”和“嫁接”于人工智能风险治理时,基于伦理嵌入视角的相关研究正不断开辟风险治理新空间,勾勒出适用于人工智能风险治理体系的新图景,由此可见,从理论而言,伦理嵌入下的风险治理是构建人工智能新型风险治理体系的关键支撑。目前,学者们围绕风险治理流程开展了探索性研究,闫坤如从技术研发与设计理论出发,认为人工智能风险与技术设计存在较强关联,当设计不完备、设计目的与实际结果和使用者需求不相符时都会产生风险,因此人工智能的研发设计应思索其是不是具有道德行动者地位和“道德嵌入”(moral embedding)合理性等问题,应强调设计者的责任意识和体现“科技向善”(technology for good)[7]。蒋洁认为需要从算法、数据和社会影响方面对人工智能风险进行系统性的评估,并且强化伦理对于风险治理的作用[8]。张富利基于复杂性范式,认为人工智能技术产业化过程因与资本的耦合而规避了深层次的伦理探讨,带来了硬规则的普遍适用,导致建立在创新与安全之上的传统治理范式难以应对,因此人工智能风险治理急需探索能容纳多维度的伦理治理范式[9]。虽然上述研究成果反映出风险治理不同节点需要关注的重点问题,但是依然无法形成完整且清晰的体系框架。对于伦理嵌入下的新型风险治理体系包含哪些要素?各要素主要功能是什么?新型风险治理体系如何发挥其作用?风险治理路径如何?诸多此类问题亟待深入研究。

基于此,本文从伦理视角出发,探索和构建基于伦理嵌入的人工智能新型风险治理体系,并且深度解析风险治理路径,促进人工智能经济效益与风险防控的动态平衡,以回应上述问题。

二、基于伦理嵌入的风险治理体系构建

(一)人工智能风险引发的治理挑战

作为引领新一轮科技革命和产业变革的战略性支撑力量,人工智能本身拥有溢出带动性极强的“头雁”效应,能够为众多行业领域带来深刻变革,同时在隐私、歧视、安全、责任、就业等方面的负外部性也引发了风险治理领域的严峻挑战[2]。

首先,人工智能具有极强的开放性,数字和智能时代的降临更使得基于代码的生产门槛大幅度降低 [10],这是人工智能技术创新与应用规律的必然,但同时高度的开放性也带来了风险的极大不确定性,而既有治理体系对此难以给出有效的具体方案。一方面,人工智能高度开放性的生产模式使得现有监管机构难以找到明确的监管实体,政府试图照搬先前全范围覆盖的事前管控方式已经不可能。另一方面,自上而下的科层制的治理结构既不能有效地将信息传递到相應的技术产业化主体,而且信息的不对称性还可能使得施力方向和监管方式难以把控,甚至导致风险治理的异化。可见,传统治理体系的僵化性难以应对人工智能开放性和不确定性所带来的严峻挑战,甚至可能导致人工智能成为公共危险的源头,酿成大规模的连锁性伤害,急需调整现有治理结构和治理逻辑,以加快形成能够匹配高度开放性和不确定性内在需求的新型风险治理体系。

其次,以因果关系为主线的治理逻辑极难适应以算法和数据为主体的人工智能应用情境。长期以来,人类通过实践总结建立起基于对自身行为因果的法律、行为规范等多种规制体系构成了现代治理的核心逻辑,即通过评估行为结果的影响性来对以后发生的行为进行定性和规制[11]。但是,因果关系逻辑却不能完全适用于人工智能风险治理,这是因为人工智能的真正价值并不在于模仿人类行为,而在于所具备的自主学习和决策能力,即人工智能技术并不是人类意志的充分表达,程序设计者给出的只是学习规则,最终决策权却在于海量规模数据训练后的人工智能算法,而该结果与程序设计者本身意志之间并不存在较强的直接因果关系,由此通过探究行为与后果之因果关系来规范人类行为的法律等规制体系遭遇窘境。

最后,人工智能风险治理挑战不仅体现在与既有治理体系的不匹配,更有新兴风险治理议题的模糊甚至空白,如数据隐私保护、算法安全、算法歧视以及滥用等新兴风险治理议题,在人工智能兴起之前这些问题并不存在,或者说并不突出,但是伴随人工智能技术创新和产业化应用的快速发展,新兴风险日渐凸显。既有治理体系在应对和化解人工智能风险时滞后和乏力,迫切需要发展新型治理工具和构建与之相适应的风险治理体系,以确保新兴技术朝着有利于人类发展的方向演进。

(二)伦理嵌入下人工智能风险治理体系构建

随着技术创新与科技政策交互性增强,科学和社会之间的关系从“科学与社会”(science and society)、“社会中的科学”(science in society)逐步向“科学伴随社会”(science with society)和“科学为了社会”(science for society)转变[12]。人工智能等新兴技术创新与应用的风险治理也逐渐从科学共同体的内部自治转向更加宽泛的社会道德伦理层面的治理[13]。21世纪以来,美国召开了一系列有关“科学与治理”的会议并发布了相关文件,将“治理”理念引入科技政策领域,用以描述科学、技术和政治间的不同特性、流动合作和互惠影响。此后,在生物医学技术的治理议题研究过程中,“伦理治理”(ethical governance)理念被提出,希望通过吸收“治理”的公正、民主的多元对话和协商机制,促使有关的各利益相关者都参与到努力解决科技发展和风险治理议题的过程中。

与之相关,国际社会各界也纷纷制定相应的伦理准则或者框架。如英国已经成立数据伦理和创新中心(CDEI),视伦理为人工智能创新管理的核心之一并考虑制定普适的人工智能伦理框架。欧盟人工智能三大支柱之一就是确保自身具备与人工智能发展应用相匹配的伦理及法律框架,为此欧盟委员会已经草拟了人工智能伦理指南(AI ethics guidelines)[14]。中国的人工智能顶层设计政策也要求制定促进人工智能发展的伦理规范。目前,国际社会组织已经达成了两个影响广泛的人工智能伦理共识:“阿西洛马人工智能原则”(Asilomar AI Principles)和国际电气电子工程师协会(IEEE)组织倡议的人工智能伦理标准,其中“阿西洛马人工智能原则”倡导安全、失败透明、审判透明、负责、与人类价值观一致性、保护隐私等伦理价值和伦理原则。2017年3月,IEEE在《IEEE机器人与自动化》杂志发表了名为“旨在推进人工智能和自治系统的伦理设计的 IEEE全球倡议书”,倡议建立人工智能伦理的设计原则和标准,并提出人权(human rights)、福祉(wellbeing)、问责(accountability)、透明(transparent)和慎用(use with caution)五原则。中国新一代人工智能治理原则也于2019年6月17日发布,提出和谐友好、公平公正、包容共享等八项基本原则,发展负责任的人工智能。通过对国内外人工智能主要伦理原则的论述,本文认为现有人工智能智能伦理原则虽然具体内容相异,但是其本质却相通,都强调维护人类根本利益和主体地位,借鉴其核心思想,同时结合人工智能风险治理的内在需求,本文认为伦理嵌入下人工智能风险治理需遵循以人为本、开放合作和互动协商的基本原则。

作为新兴风险治理范式 [15-16],基于伦理嵌入的风险治理不仅是对治理效果的短期考虑,更是对面向未来治理结构和治理逻辑的高屋建瓴,引导人工智能技术创新与应用向负责、安全、普惠的实践道路前进[17]。伦理嵌入下,风险治理不再以政府为绝对主导,而强调更广泛的风险治理主体参与,虽然政府在一定程度上依然发挥着重要作用,但是社会组织、企业、社会公众等逐渐成为风险治理的基本力量,以政府主导、社会协同、公众参与的治理体系格局正在形成 [18-19]。与传统科层制“自上而下”的风险治理不同,伦理嵌入的风险治理更加關注治理的上下融通和横向联结,因此主张采取“自上而下”和“自下而上”相联合,以及多主体参与的“水平协商”治理模式 [20]。伦理嵌入风险治理范式下,不再将法律规范等作为核心治理工具,而是在吸收“法治”(rule of law)的合理性基础上,进一步将风险治理重心转移至“人治”(rule of human),即以提升和规范利益相关者的伦理道德为出发点,充分激发伦理道德对风险治理的能动作用,其治理方式涵盖预测式治理、公众参与治理、响应式治理等 [21-22],更加灵活多样。同时,通过基于伦理嵌入的风险治理,可将治理触角渗透到从人工智能技术创新到产业化应用的诸多阶段,治理范围同既有风险治理体系相比更加宽泛。基于此,本文归纳出基于伦理嵌入的人工智能新型风险治理体系如图1所示。

三、基于伦理嵌入的风险治理路径解析

人工智能技术本身虽然并没有伦理道德品质,但技术研发者可通过算法设计、数据选择、模型优化等方式赋予其伦理价值,因此人工智能技术并非中立,其中饱含了人类太多对于现在和未来的思考及决定,为以伦理嵌入实施风险治理指明了方向,因此非常有必要对人工智能风险治理过程进行更加全面和深刻的伦理思考,将伦理嵌入到人工智能技术创新与应用的每个阶段。即在人工智能技术研发、技术测试、技术转移和技术产业化的每个阶段,根据其阶段性特征实施相应的规约方式,对其风险进行有效防范和控制。

(一)技术研发阶段的伦理设计

通过技术研发阶段的伦理设计能够使人工智能技术从诞生便负载一定的价值倾向,并符合特定的伦理道德考虑,让具体价值导向和伦理道德规范内化于人工智能技术结构之中,并通过相应的功能展现出来。不仅技术领先可行,能够实现经济效益的大幅增加,而且还要满足社会期望、道德伦理可接受,即实施责任式创新范式下的技术研发与创新。当技术的调解作用及其伦理对于风险治理的价值被发掘之后,技术研发能力较强的企业可对人工智能技术进行明确的伦理设计。菲贝克(Fi beck)认为道德化设计可分成隐性道德设计和显性道德设计,隐性道德设计努力避免不合理的调解作用,防止非道德的技术研发,显性道德设计则通过设计具有特定调解作用的技术,使倫理道德融于技术功能。由于隐性调解设计无法实施技术概念分析和技术原型开发,因此显性调解设计成为人工智能技术研发阶段的必要选择[23]。首先,对即将嵌入人工智能的目标价值进行分析,即技术概念解析。企业中的技术研发人员和伦理学家通过跨领域合作对人工智能技术研发进行全局性考虑,明晰技术研发过程中的价值合理性、规范冲突、人类主体地位以及其他潜在风险等问题,同时界定利益相关者,分析人工智能目标价值对其影响性,并且探讨伦理嵌入所引起道德领域的积极变化[24]。其次,把人工智能技术价值落实到具体架构内,包括物理载体、算法和接口,即技术原型开发。具体操作过程可借鉴洛克顿(Lockton)所提出的建筑模式、放错模式、劝导模式等6种技术道德化设计模式[25]。再次,把人工智能技术研发与应用场景相结合,确保经由伦理设计的价值规范能够充分发挥其风险防范作用。可通过企业技术研发人员的合理性想象、扩展建构性技术评估和应用场景模拟的方式提高风险防范能力[26]。最后,对经由伦理设计的人工智能技术价值规范的合理测评。需要注意和强调的是,人工智能技术研发设计必须保持治理主体之间的互动协商和开放合作,以便发挥各自的独特优势并结合实际应用情况不断对研发设计方案进行适应性调整优化。

(二)技术测试阶段的伦理评估

与技术研发阶段由企业的研发设计者主导并面向个体不同,技术测试阶段的伦理评估往往是由社会组织(如伦理委员会等)主导并面向社会群体层面,探讨如何以负责任的方式进行技术创新及风险治理[27-28]。因此,该阶段人工智能技术伦理评估本质上是对其道德伦理进行积极的分析和建构,并形成对风险治理具有实际操作意义的伦理评估准则。通常情形下伦理评估需要组建伦理委员会,预测和识别潜在风险、分析与澄清风险问题、开发与确定伦理解决方案,以及通过同行评议对解决方案进行审议,并就方案与政府机构、社会公众相互沟通以确定伦理评估结果。伦理评估需要如下具体环节:

首先,最大化预测和识别人工智能技术潜在风险危害。由于算法与数据是人工智能发展逻辑形成的根源,也是引发风险的重要因素,因此为全面合理地进行风险预测和识别,本文提出面向数据和算法的人工智能风险评估指标体系(见表1),该体系包括数据风险(数据安全风险、数据偏见风险)和算法风险(算法安全风险、可解释性风险和决策风险)在内的11项具体风险指标,用以辅助伦理委员会进行风险预测和识别,在实践中可根据实际情景设置各指标权重,灵活运用。其次,对已经识别出的风险进行伦理追溯,探索风险背后的价值冲突和伦理困境。再次,形成人工智能技术的共识框架并以此为基础提供伦理导向准则。在对风险背后价值冲突与伦理困境的追溯和确定后,需要进一步在不同利益相关者中形成基于伦理的风险治理共识框架。在此过程中,寻找开放、公平的协商平台或者对话空间成为关键举措。最后,通过同行评议的方式对框架的合理性以及新出现的风险进行实际考察和修正,并与政府机构、社会公众持续沟通。可见,该环节是风险信息不断增加和利益相关者逐步深度参与和反复协商的过程,需要保持伦理共识框架与实践的持续动态反馈。同时,整个技术测试阶段的伦理评估也为技术转移阶段的伦理调适营造了更加适宜的环境氛围。

(三)技术转移阶段的伦理调试

技术与社会之间是双向建构的,技术对社会道德伦理观念的调试没有明确导向性,本质上是适应和自适应相结合的过程,但是社会伦理可通过明确的导向性,造就技术的伦理角色[23]。因此,在人工智能技术转移阶段所采用的伦理调试

第一,由政府机构参与的制度调试。即通过国家法律强制手段推进和规范人工智能技术转移。制度调试需以风险治理为基本导向,采取“分级分类”和“标准认证”相联合的思路,一方面,人工智能技术创新及风险的快速迭代使专门的立法很难跟上风险治理步伐,因此应遵循分级分类的方式,在技术转移阶段建立法律约束与风险危害程度相匹配的监管机制,如避免过于严格和细致的法律要求,而应该采取先行先试、事后追责等轻监管模式;另一方面,制定和颁布人工智能技术及应用的标准和认证体系。如中国信息安全标准化技术委员会颁布的《信息安全技术 指纹识别系统技术要求》和《信息安全技术 虹膜识别系统技术要求》标准。在欧盟的《人工智能白皮书:通往卓越与信任的欧洲之路》中也明确提出对满足特定伦理标准的产品和服务提供监管部门的标签认证,以提高其在消费者心中的信誉。

第二,由社会组织和社会公众参与的舆论调试。在技术转移过程中,社会公众对技术的态势通常是一项新兴技术被倡导或禁止的重要因素[29]。社会组织和社会公众通过营造优良价值导向的社会氛围和舆论环境,使那些具有可用(available)、可靠(reliable)、可知(comprehensible)、可控(controllable)性质的人工智能技术能够实现更高程度和更高效率的转移效果,其相应智能产品和服务同样也会获得更好的社会评价和经济效益,从而实现良性增值循环。舆论调试可细分为舆论宣传和舆论监督两种方式,其中舆论宣传指的是借助公共媒体对社会价值(如可信、公正、透明等)宣扬,推动人工智能技术转移和应用的科技向善。舆论监督指的是通过公共媒体等以信息公开为核心的舆论引导,形成由社会公众参与的舆论监督氛围,对明显有悖于社会主导价值(如歧视、侵犯隐私等)的人工智能技术及转移进行遏制。

第三,由学界参与的教育调试。学界(教育、科研)通过建立健全覆盖全社会的技术安全认知和培训体系,为人工智能技术高质量转移提供智力和伦理道德保障。教育调试的具体方式可分为学校调试和学者调试,其中学校调试指建立适用于不同人群的有关人工智能科学认知的教育体系;学者调试指在学术界充分认识人工智能技术创新在理论和产业化应用层面的双重性,聚焦人工智能的风险治理议题,倡导“责任式创新”(responsible innovation),为人工智能技术创新可持续发展提供借鉴[22]。

(四)技术产业化阶段的伦理建构

该阶段是人工智能技术迈向大规模商业化进程中,对以伦理嵌入进行风险治理的实战化检验和体系建立。企业把经由伦理设计的人工智能技术广泛应用于研发设计、生产建造、供应管理、服务营销等具体流程之中,而作为人工智能产品和服务的终端使用者(社会公众等),既可以遵循经设计的使用规划,也可按照自身的道德伦理认知体系使用智能产品和接受智能服务。同时,政府机构、相关社会组织和学界也对人工智能技术应用实践中引发的风险进行审视和反思。可见,技术产业化阶段的伦理建构具有双重性,既有终端使用者、政府机构、社会组织和学界对具有明确道德指向性的人工智能产品和服务的认同和遵守,又有对人工智能技术基于特定道德理想与伦理追求的创造性建构。在此过程中,以基于伦理嵌入的风险治理体系通过理论和实践之间的正向迭代和多次循环得以持续改进优化,最终实现经济效益和风险防范的动态平衡。

通过上述分析发现,基于伦理嵌入的风险治理路径可归结为伦理设计、伦理评估、伦理调试和伦理建构,整体降低人工智能的风险等级,使人工智能更加安全和可控。本文归纳基于伦理嵌入的人工智能风险治理具体路径如图2所示。

四、结 语

在经历曲折发展后,人工智能技术终于突破工业化红线走向产业化应用。然而其产生的数据安全、隐私保护、算法歧视等风险问题,引发了深刻的风险治理挑战[9,11],传统风险治理体系急需向以伦理嵌入为关键支撑的新兴风险治理体系迁移。本

研究的价值体现在:聚焦人工智能风险治理体系与治理路径,从伦理嵌入视角出发,构建了囊括治理原则、主体、模式、工具及方式等在内的人工智能新型风险治理体系,并系统解析了基于伦理嵌入的风险治理路径,从而为风险治理体系迁移提供了有益启示。本文具体研究结论如下。

第一,基于伦理嵌入的新型风险治理体系更加适用于人工智能技术创新及治理。具体而言,基于伦理嵌入的风险治理摒弃了传统以政府为绝对主导的弊端,而采取多主体参与的协同治理模式,强调风险治理的“垂直连通”和“水平协商”,并充分发挥伦理道德能动作用,而非将诉诸立法作为治理重心,将治理触角渗透到人工智能技术创新到规模化应用的诸多阶段,治理范围更加宽泛,治理方式也更加灵活多样,更加匹配人工智能风险治理需求。第二,基于伦理嵌入的风险治理不仅作为有效的工具手段,更是风险治理的价值追求和美好愿景,即坚持人类利益至上、体现人文关怀,最大程度地实现治理的正义性及平等性,推动负责任的研究和确保科技向善[30]。第三,基于伦理嵌入的风险治理路径具有阶段性特征。①在技术研发阶段进行伦理设计,伦理学家和技术研发人员通过跨领域合作,通过“价值分析-框架内嵌-场景结合-评估设计”,使价值导向和伦理道德规范内化于人工智能技术结构之中,并通过相应的功能展现出来;②在技术测试阶段进行伦理评估,由社会组织(伦理委员会等)对风险进行预测和识别、伦理追溯并达成共识性框架,以及同行评议对防范风险框架的及时修订;③在技术转移阶段进行伦理调试,通过以政府机构参与的制度调试,以社会组织和社会公众参与的舆论调试、以学界参与的教育调试共同推动人工智能技术的责任式创新,实现人工智能产品及服务与社会价值系统的深度融合;④在技术产业化阶段进行伦理建构,政府机构、企业、社会公众、社会组织和学界共同参与,通过对具有明确道德指向性的人工智能产品及服务的认可和基于特定道德理想与伦理追求的创造性建构,以及理论和实践循环迭代持续优化风险治理体系,实现经济效益和风险防范的平衡。

[参考文献]

[1]TEECE DAVID J. Profiting from innovation in the digital economy: enabling technologies, standards, and licensing models in the wireless world[J]. Research policy,2018,47(8):1367-1387.

[2]张成岗.人工智能时代:技术发展、风险挑战与秩序重构[J].南京社会科学,2018(5):42-52.

[3]李侠.基于大数据的算法杀熟现象的政策应对措施[J].中国科技论坛,2019(1):3-5.

[4]JUTTA WEBER. Making worlds: epistemological, ontological and political dimensions of technoscience[J]. Poiesis & praxis, 2010, 7(1-2):17-36.

[5]EUROBAROMETER S. Social values, science and technology[R]. Eurobarometer Special Report,2005.

[6]ASHRAFIAN HUTAN. Artificial intelligence and robot responsibilities: innovating beyond rights[J]. Science & engineering ethics, 2015, 21(2):317-326.

[7]閆坤如.人工智能设计的风险及其规避[J].理论探索,2018(5):22-26.

[8]蒋洁.人工智能应用的风险评估与应对策略[J].图书与情报,2017(6):117-123.

[9]张富利.全球风险社会下人工智能的治理之道——复杂性范式与法律应对[J].学术论坛,2019,42(3):68-80.

[10]BENKLER YOCHAI. The wealth of networks: how social production transforms markets and freedom[M]. Yale University Press, 2006.

[11]贾开,蒋余浩.人工智能治理的三个基本问题:技术逻辑、风险挑战与公共政策选择[J].中国行政管理,2017(10):40-45.

[12]MEJLGAARD N, BLOCH C. Science in society in Europe[J]. Science and public, policy, 2012,39(6):695-700.

[13]CSONKA A L. Responsible science in societies[J]. Responsible innovation, 2014(57):12-35.

[14]THE EUROPEAN COUNCIL, THE COUNCIL, et al. Artificial intelligence for Europe [R]. European Commission, 2018.

[15]HESSEN J. Computer and communication ethics:encyclopedia of applied ethics[M]. Academic Press, 2012.

[16]程现昆.科技伦理研究論纲[M].北京:北京师范大学出版社,2011.

[17]梅亮,陈劲,吴欣桐.责任式创新范式下的新兴技术创新治理解析——以人工智能为例[J].技术经济,2018,37(1):1-7,43.

[18]樊春良,张新庆,陈琦.关于我国生命科学技术伦理治理机制的探讨[J].中国软科学,2008(8):58-65.

[19]王立,胡平.新时期下的伦理治理理念、内涵及路径分析[J].社会科学研究,2017(6):118-123.

[20]鲁传颖,约翰·马勒里.体制复合体理论视角下的人工智能全球治理进程[J].国际观察,2018(4):67-83.

[21]STILGOE J, OWEN R, MACNAGHTEN P. Developing a framework for responsible innovation[J]. Research policy, 2013, 42(9):1568-1580.

[22]梅亮,陈劲,李福嘉.责任式创新:“内涵-理论-方法”的整合框架[J].科学学研究,2018,36(3):521-530.

[23]王钰,程海东.人工智能技术伦理治理内在路径解析[J].自然辩证法通讯,2019,41(8):87-93.

[24]JEROEN V D H, MANDERSHUITS N. Valuesensitive design[J]. Interactions, 2009, 3(6):16-23.

[25]LOCKTON D, HARRISON D, STANTON N A. The design with intent method: a design tool for influencing user behavior [J]. Applied ergonomics, 2010, 41(3):382-392.

[26]VERBEEK P. Materializing moralitydesign ethics and technological mediation[J]. Technology and human values, 2006, 31(3):361-380.

[27]梅亮,陈劲.责任式创新:源起,归因解析与理论框架[J]. 管理世界, 2015(8):39-57.

[28]VAN DEN HOVEN J. Options for strengthening responsible research and innovation: report of the expert group on the state of art in Europe on responsible research and innovation[R]. Publications office of the European Union, 2013.

[29]JONAS H. The imperative of responsibility: in search of an ethics for the technological age [M]. University of Chicago Press, 1984.

[30]张成岗.人工智能的社会治理:构建公众从 “被负责任”到 “负责任”的 理论通道[J].中国科技论坛,2019(9):1-4.

Study on Avoiding New Risks of Artificial Intelligence and Analysis

on the Management Systems of AI on the Basis of Ethics

Sun Liwen, Li Shaoshuai

(School of Economics and Management,Hebei University of Technology, Tianjin 300401,China)

Abstract: Artificial intelligence is fulfilling its enormous potential, generating economic value, and even bringing a wide range of industrial evolution. At the same time, it also creates many risks. The existing management system cannot cope with the uncertainty and the endless possibilities of the AI, so it cannot meet the needs of minimizing the risks. Whats more, managing the new risks triggered by the application of artificial intelligence technology goes beyond the scope of the existing management system. So it is high time that the traditional riskmanagement system shift to a new way of management on the basis of ethics. The authors propose that the new management systems of AI application risks should be established on the basis of the ethics; the traditional system which relied too much on the government should be replaced by a collaborative management system participating by various parties; it should be emphasized that the participants should cooperate within one field as well as in transfield ways; professional ethics should be put into practice not only in technological innovation process but also in the mass application of the AI, therefore the ethics can be used in broader range and in a more flexible way. In this way, the new management system can be formed where ethics is used in the four different stages of AI development, such as the research and development, testing, technological conversion, and technological industrialization. The paper can help reduce the risk level of AI and provide theoretical guidance and enlightenment for developing responsible artificial intelligence.

Key words: risk management; ethics; responsible innovation; technology for good;

artificial intelligence

(責任编辑:李 萌)