基于1R1V感知信息融合的若干关键问题研究

2021-08-31刘堂胜朱祖伟官海兵

刘堂胜,朱祖伟,官海兵

(江西交通职业技术学院,江西南昌 330013)

0 引言

环境感知是自动驾驶汽车研究领域的关键技术之一,实现道路交通环境的准确感知是自动驾驶系统的基础和前提。目前主要应用于车辆环境感知的传感器有摄像头、毫米波雷达、激光雷达和超声波雷达等[1]。由于成本过高且在强光、雨雪等环境影响较大,激光雷达用于机动目标跟踪的研究相对较少[2-3];同时由于超声波雷达其探测距离过短,通常不超过5 m,无法满足车辆动态行驶过程中对环境感知范围的需求。毫米波雷达以其全天候的工作特点、较低的成本优势和较长的探测距离广泛应用于自动驾驶领域;摄像头具有丰富、高分辨率的图像信息,可以实现车道线检测、障碍物分类及交通标志识别等功能。然而,无论是毫米波雷达还是摄像头,都有其不可忽视的缺点。毫米波雷达易受杂波干扰,探测目标时会出现虚报、漏报现象;摄像头则易受光线、雨、雾等气候条件影响,不能保证全天候可靠地工作。因此,开展基于毫米波雷达和摄像头感知信息融合,提升感知系统的准确性和鲁棒性,成为自动驾驶汽车系统当今和未来的一个研究热点和重点。

1 多传感器概况

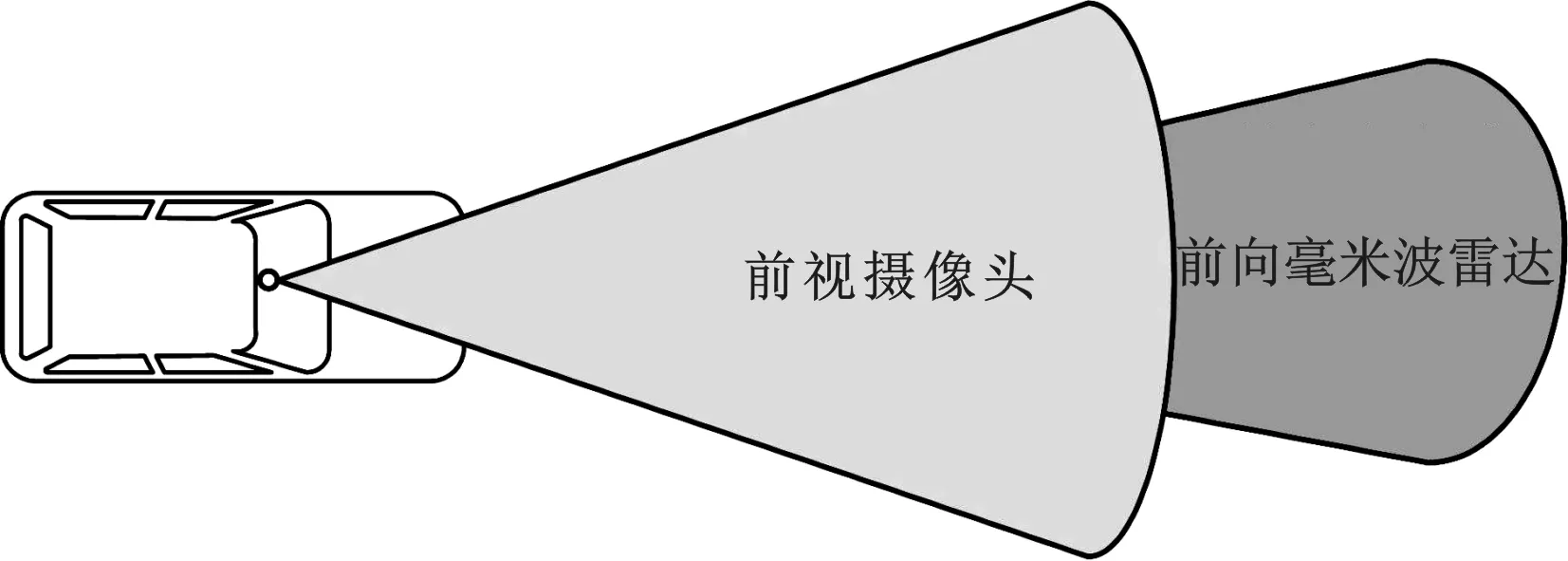

文中主要以毫米波雷达和摄像头这两种类型的传感器为研究对象,图1所示为两类传感器的覆盖区域图,简要介绍毫米波雷达和摄像头的工作特性,并重点分析1个前向毫米波雷达和1个前视摄像头(简称1R1V)在信息融合过程中的若干问题,以增强自动驾驶汽车在复杂环境背景下的目标感知能力。

图1 1R1V覆盖区域示意

1.1 毫米波雷达

毫米波雷达利用天线向外发射毫米波信号,通过接收器接收目标的回波信号,经过信号处理器对雷达信号进行处理后得到车身周围的目标信息,如目标的相对距离、相对速度、相对加速度、相对角度等[4]。

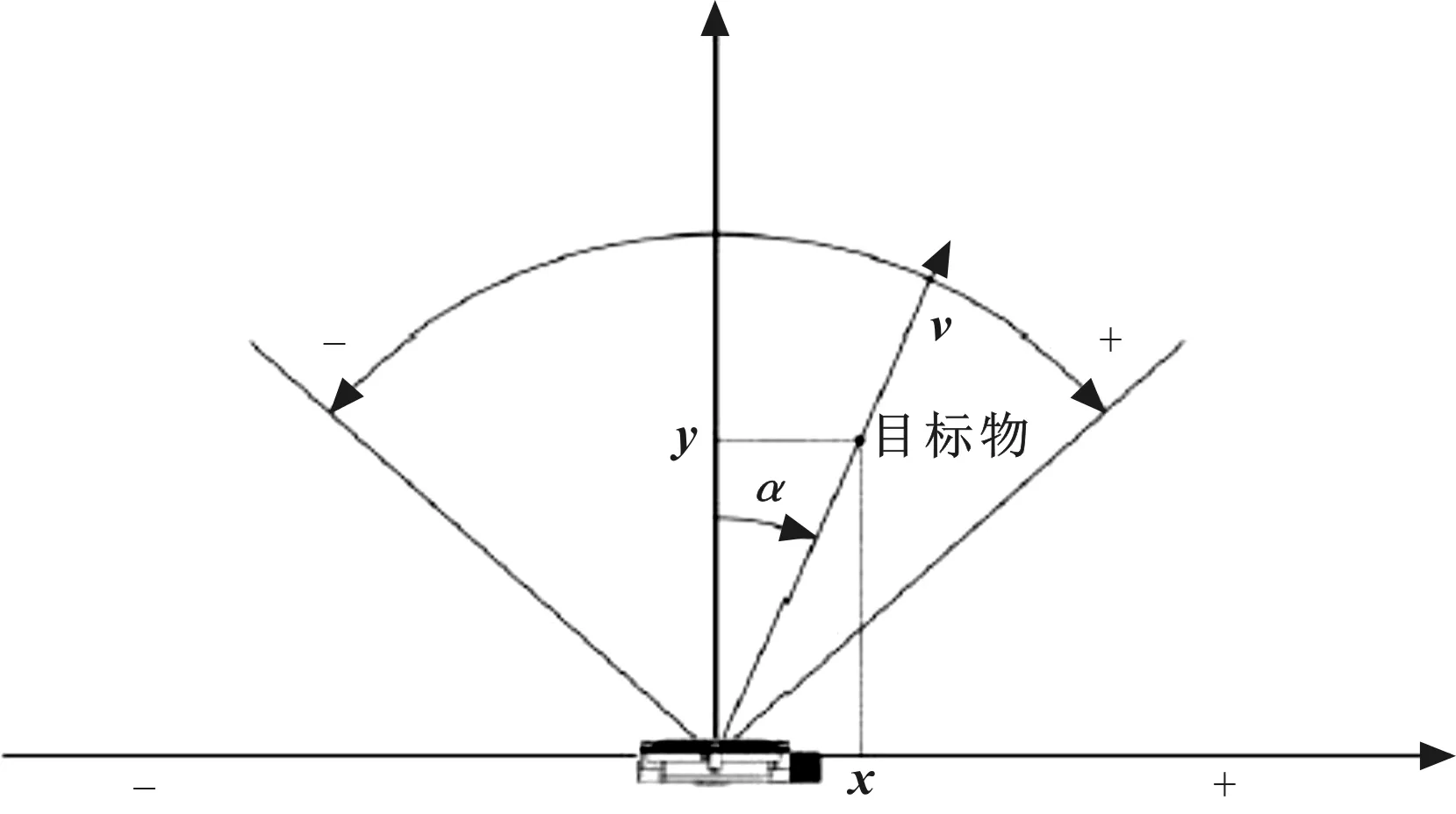

图2为毫米波雷达对应的坐标系,其中,距离x、y分别为探测目标距雷达中心位置的横向距离、纵向距离;速度v为探测目标运动的相对速度;角度α为探测目标距雷达的角度信息。

图2 毫米波雷达坐标系统

1.2 摄像头

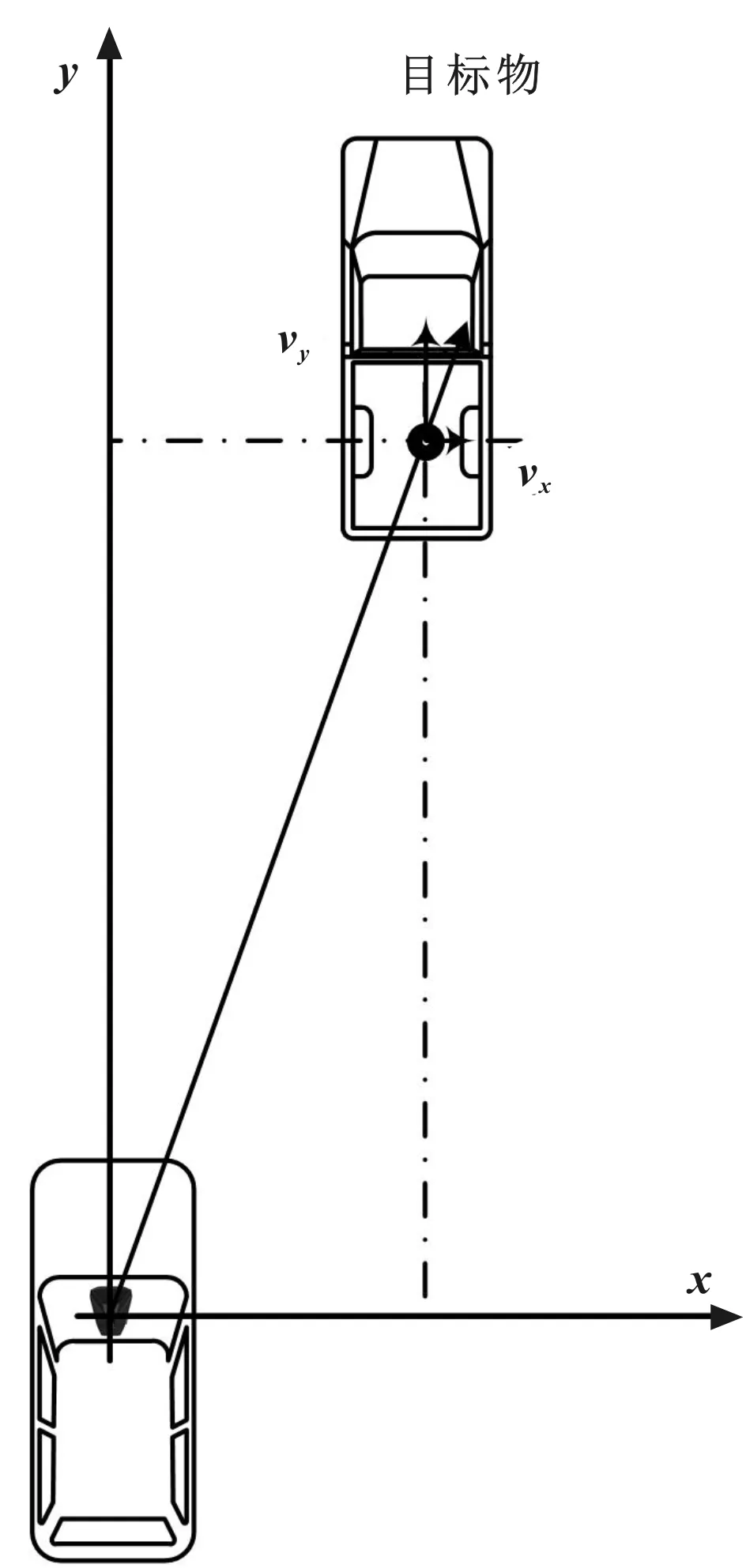

摄像头是利用被摄物体反射光线传播到镜头,经镜头传输到图像传感器等系列处理后生成摄像头感知范围内目标物的图像数字信号。如图3所示为摄像头坐标系统。

图3 摄像头坐标系统

通常表示目标物的基本信息有:目标物横向距离、纵向距离,目标物横向相对速度、纵向相对速度以及目标物类型(车、人、卡车等)。

2 1R1V感知信息融合系统架构

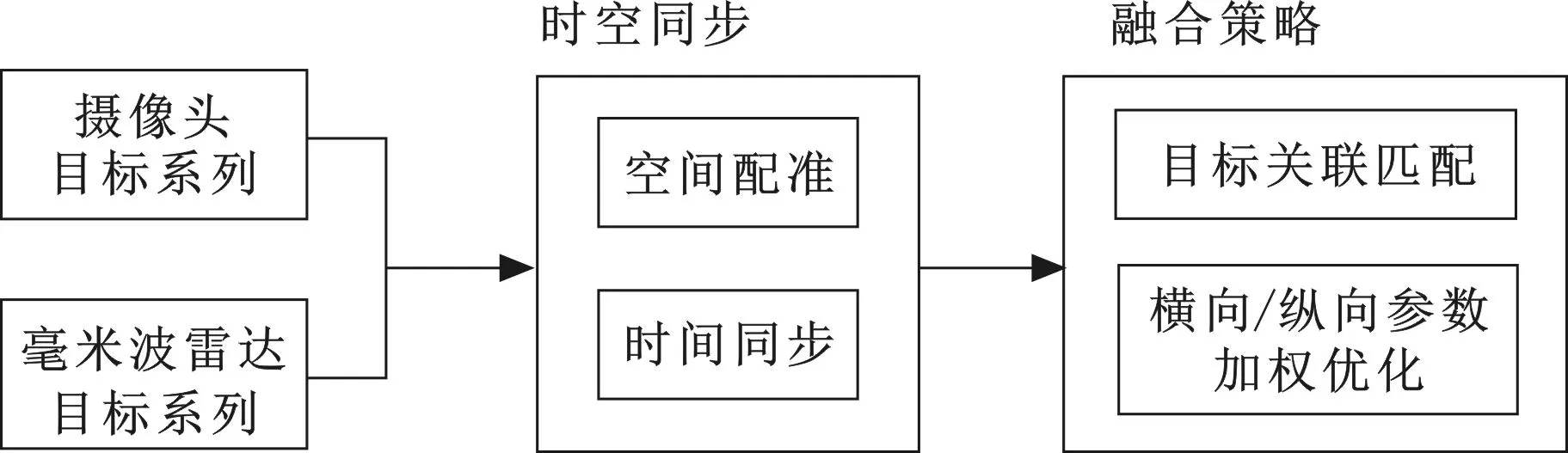

文中研究的1R1V感知信息融合系统主要包括毫米波雷达和摄像头的时空同步和融合策略两方面,而两种传感器的参数标定及数据预处理等内容不在文中讨论范围内。

1R1V感知信息融合系统框架如图4所示,在获取毫米波雷达和摄像头目标状态数据后,主要由两个步骤:

图4 1R1V感知信息融合系统框架示意

(1)时空同步

前向毫米波雷达一般安装于车辆前保险杠附近,而前视摄像头通常位于前挡风玻璃居中的上部,并且毫米波雷达和摄像头的采样点和采样周期不同步。因此,这两类传感器在数据融合前需要通过坐标变换等完成空间配准,以及利用匀加速模型等完成时间同步。

(2)融合策略

文中探讨的融合策略是根据毫米波雷达和摄像头的检测精度和信息类别等方面综合考虑,充分利用毫米波雷达在目标检测的纵向距离精度、相对速度等指标上的优势,结合摄像头在目标检测的分类、横向距离精度及车道线识别等方面的可靠性,利用卡尔曼滤波、加权融合等算法实现感知信息融合。

3 1R1V感知信息融合的若干关键部分

3.1 时空同步

时空同步是多传感器信息融合的重要前提条件,其可细分为空间配准、时间同步。

3.1.1 空间配准

如上文所述,毫米波雷达和摄像头目标物信息的输出是基于其各自建立的坐标系统,而在自动驾驶系统中,各传感器信息融合时较多采用同一坐标系统——车辆坐标系,各坐标系如图5所示。

图5 各传感器及车辆坐标系

由图5可知,毫米波雷达、摄像头坐标系与车辆坐标系之间存在空间上的关联关系,由毫米波雷达和摄像头坐标系均可先通过绕Z轴逆时针旋转90°,使毫米波雷达和摄像头坐标系的X、Y轴与车辆坐标系的X、Y轴指向一致。再根据毫米波雷达、摄像头在车辆上的安装位置,与车辆坐标系参考点在空间上的距离,分别通过在X、Y和Z轴上平移相应的距离,实现毫米波雷达坐标系、摄像头坐标系与车辆坐标系在空间上的配准。

以毫米波雷达为例,当需要将其感知的目标物位置[x,y,z]转换至车辆坐标系[x′,y′,z′]时,首先引入旋转矩阵Rz:

其次引入平移矩阵T:

转换后坐标值为:

3.1.2 时间同步

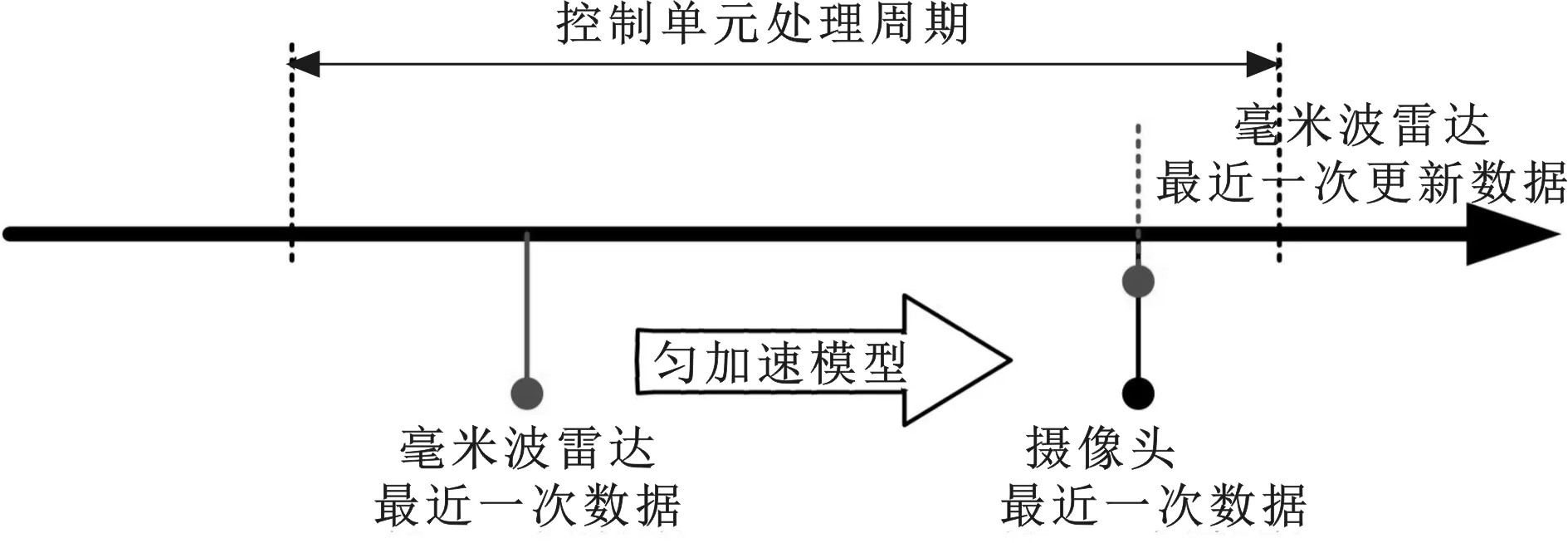

多传感器的时间同步主要指处理不同频率传感器同一时刻的数据。作为数据处理中心的控制单元一般以固定频率处理来自各传感器的数据,并可以提供一个公共的时间基准。当控制单元分别接收来自毫米波雷达和摄像头的目标数据时,可以近似将接收各自传感器数据的时刻作为相应传感器检测目标物的时间戳。由于毫米波雷达的采样周期一般是固定的,取50 ms;而摄像头的采样周期通常是不定的,取66~100 ms。因此,这两种类型的传感器总会存在一定的时间间隔。为更加精准地将这两种传感器的数据实现时间上的同步,并考虑数据的新鲜度。如图6所示,将控制单元当前处理周期内接收到毫米波雷达最近一次数据,利用匀加速模型将毫米波雷达数据的时间戳转换至与摄像头最近一次数据的时间戳保持一致,即完成毫米波雷达与摄像头数据的时间同步处理。

图6 传感器数据时间同步模型

传感器测定某一目标物可用以下状态参数描述:

[x,y,z,vx,vy,ax,ay]

在较短Δt时间间隔内,可按照匀加(减)速模型处理,其状态转换方程如下:

转换为矩阵形式如下:

3.2 融合策略

由于毫米波雷达在检测目标物的纵向距离、速度方面相较摄像头更有优势,而摄像头在目标物的横向距离、目标物分类及目标物3D尺寸检测上更佳,同时摄像头还能实现车道线检测。

以毫米波雷达和摄像头这两种传感器的性能为基础,充分发挥各类传感器的优势,设定融合过程中的系列参数,如图7所示的数据融合算法策略。完成1R1V感知信息的空间配准和时间同步后,此时可根据接收到的毫米波雷达和摄像头目标数据进行有效融合处理。首先是将毫米波雷达检测到的目标与摄像头检测到的目标之间进行匹配,即找到这两组测量目标中哪些是共同检测到的,哪些是单个传感器检测到的。这个过程主要包含关联门计算和求取最优匹配等部分。同时,对共同检测到的目标对象,可进一步根据两类传感器在检测目标属性方面的优劣,完成目标信息的修正,以获取更准确的目标状态信息。

图7 1R1V传感器数据融合算法架构示意

4 结束语

针对单一传感器在车辆前方目标检测上的不足,文中以目前主流的1R1V传感器方案为研究对象,研究探讨1R1V传感器在数据信息融合上的时空同步和融合策略方面的问题,为后续多种类型传感器信息融合提供一定基础。