桥式起重机部件多任务学习Mask R-CNN分割与关键点识别方法*

2021-04-23杨帆梁敏健杨宁祥彭晓军

杨帆 梁敏健 杨宁祥 彭晓军

学术研究

桥式起重机部件多任务学习Mask R-CNN分割与关键点识别方法*

杨帆1梁敏健2杨宁祥2彭晓军2

(1.华南理工大学机械与汽车工程学院,广东 广州 510640 2.广东省特种设备检测研究院珠海检测院,广东 珠海 519002)

起重机运行状态实时检测是工业安全生产的重要保障之一。针对起重机部件提出基于多任务学习Mask R-CNN的分割与关键点网络结构,该结构由Mask R-CNN定位框与区域语义分割网络、DeepLabCut关键点检测网络构成;在吊钩桥式起重机中采集数据进行测试,利用贪婪线性搜索算法与贝叶斯优化算法,搜索得到此模型的最优超参数组合为:学习率0.005,批数2,学习率策略为余弦衰减。该模型测试误差为2.46个像素点,测试AP可达95%,像素点误差反映到实际误差在5 cm以内,满足实际检测需求,可拓展应用于无人化、自动化起重机运行状态监测。

桥式起重机;关键点识别;深度学习;卷积神经网络;多任务学习;语义分割

0 引言

起重机是现代工业生产不可或缺的设备,其作业范围广、作业环境复杂、吊运对象多样,需要多机构同时操作、多工种协同作业。起重机在作业过程中危险因素较多,需实时监测其关键部件的运行状态,及时发现故障并发出预警信息。起重机关键部件监测方法主要有基于多物理传感器直接测量[1-3]、基于机器视觉传感[4-6]两大类,前者装置拆装不便,适应性较差;后者拆装方便,以高鲁棒性图像算法为基础,在满足精度误差范围内具备不同场景测量的高适应性。基于机器视觉传感的监测方法是基于图像传感器及图像处理算法,识别图像中起重机关键部件位置,并结合图像深度信息进行定量测量。文献[4]采用归一化互相关图匹配算法对起重机吊绳图像进行目标对象定位框识别,并作为Mean Shift跟踪的目标区域进行跟踪。文献[5]利用灰度化、二值化、边缘检测、霍夫变换等图像处理算法识别吊绳边缘,再根据相机小孔成像原理预测吊绳角度。上述研究均利用经典图像处理算法进行起重机部件识别,无法抽取高层图片信息,对场景变化及环境变化适应性差。相比于经典图像处理算法,深度学习模型具有图像高级语义特征理解力,对不同场景适应能力更强。为此,文献[6]利用深度学习检测算法YOLO[7]实现不同角度起重机图片吊钩定位,适应性较好,但算法仅适用于图像定位框识别任务,没有对起重机运行部件的关键点坐标信息及部件区域分割信息进行预测。

为此,本文应用Mask R-CNN结合多任务学习[8-9],接入多预测分支,构建多任务识别深度学习网络,实现桥式起重机关键部件定位框、区域语义分割与关键点的同时识别。

1 网络设计

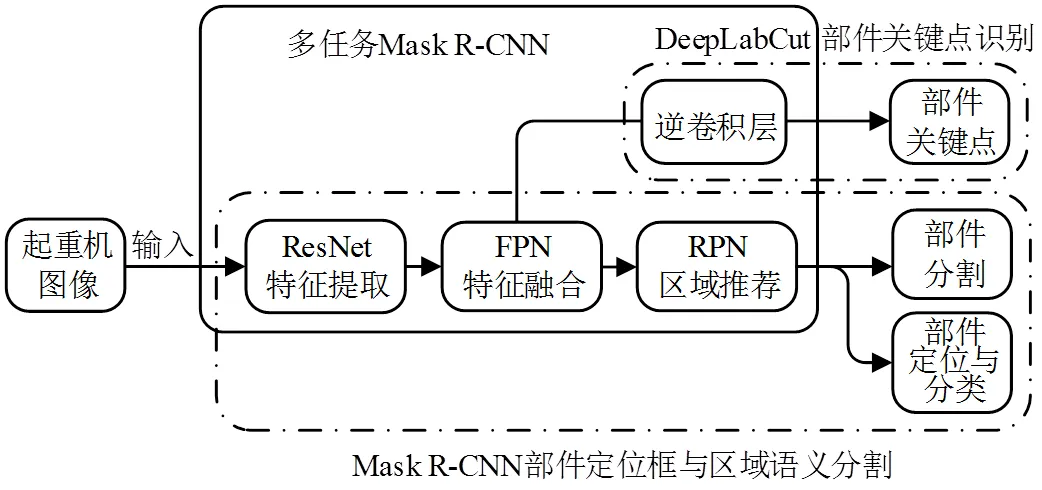

桥式起重机关键部件定位与关键点识别方法框架包括Mask R-CNN定位框与区域语义分割网络、DeepLabCut关键点检测网络,如图1所示。

1.1 Mask R-CNN定位框与区域语义分割网络

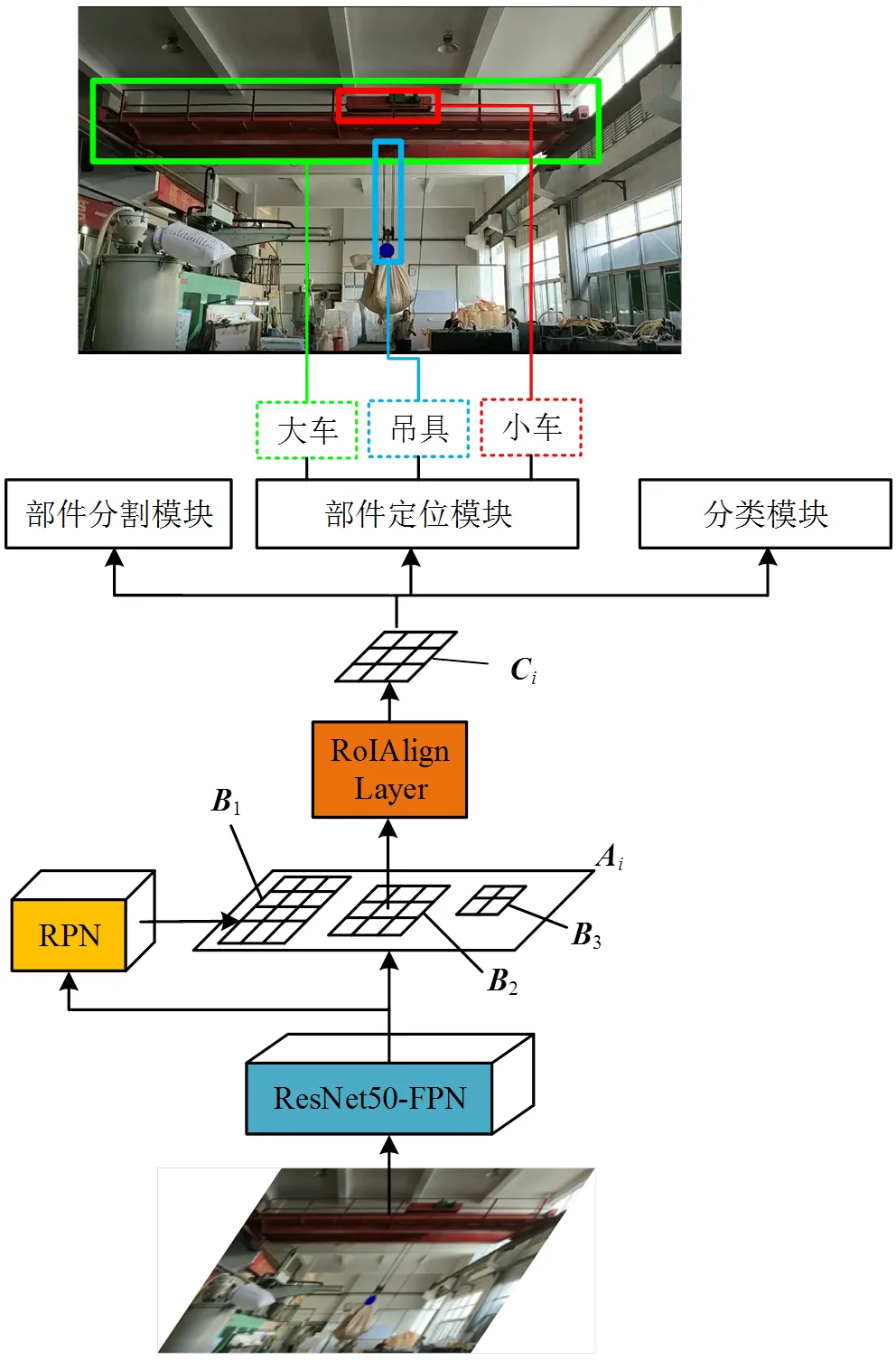

Mask R-CNN架构图如图2所示。输入图像经过预训练的ResNet50-FPN结构,融合ResNet50各层不同尺度的特征张量,输出特征图为不同分辨率的融合特征图(=1,…,4),即图像语义特征。

图1 桥式起重机关键部件定位与关键点检测方法框架图

图2 Mask R-CNN整体架构图

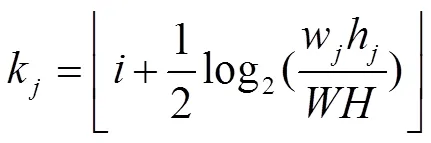

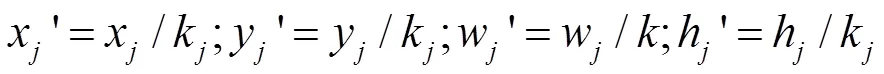

特征图输入感兴趣目标区域候选框生成网络(region proposal network, RPN)后,获得语义特征张量对应候选框区域的局部特征张量(=1,…,)。设输入图像的宽和高分别为,,若RPN输出某一RoI的宽与高分别为w,h,左上顶点的图像像素坐标为(x,y),且该RoI为特征张量通过RPN生成,则此图像上的RoI对应的局部特征张量为

每个局部特征张量输入感兴趣目标区域对齐层,即RoIAlign层,首先,该层均匀地将分割成7×7 = 49个子区域;然后,利用双线性插值法获得每个区域中心位置的插值,得到插值后张量;接着,对插值后张量进行最大值池化操作;最后,得到RoIAlign层的输出,区域对齐后的张量(= 1,…,)。

张量分别输入部件分割模块、部件定位模块和分类模块,以完成每个已分类的部件定位区域内的分割任务。

各预测模块的内部结构如图3所示。首先,部件定位模块与分类模块共用多个全连接(fully connected, FC)层以提取张量的语义信息矢量;然后,部件定位分支将语义信息矢量输入到4个神经元的FC层,获得第二次精炼的部件定位框回归预测值,,,;分类分支将矢量输入到3个神经元的FC层;接着,输入Softmax层获得小车、大车与吊具的预测概率p,p和p;最后,部件分割分支利用3×3×256卷积层与1×1×3卷积层对提取语义张量信息,再输入Sigmoid层,得到14×14×3掩码张量,张量的每一维度代表一个类别掩码区域的预测,张量的任意元素值表示该位置属于目标区域概率。

图3 预测模块内部结构图

分类分支、部件分割分支的输出分别输入交叉熵损失函数得到分类损失cls与部件分割损失函数mask;部件定位分支输出输入最小二乘回归损失函数得到定位框损失box,各损失之和即为Mask R-CNN总损失函数

1.2 DeepLabCut关键点检测网络

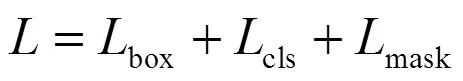

DeepLabCut关键点检测网络结构如图4所示。设图像中起重机关键点个数为,起重机图像输入ResNet网络获得特征图后,分别输入关键点空间概率分布预测分支、偏移量预测分支。

图4 DeepLabCut关键点检测网络结构

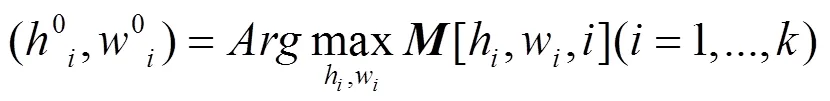

1)输入关键点空间概率分布预测分支,ResNet输出经尺度为3×3×的反卷积层,再通过Sigmoid层获得特征图×W×k,特征图中第维第(,)个元素的值表示原图第行,第列对应区域出现第个关键点的概率。故由特征图可初步得到每个关键点大致出现的区域:

2)语义特征张量输入偏移量预测分支,ResNet输出经3×3×2的反卷积层,输出偏移量回归张量×W×2k,则第个关键点(x,y)的预测输出为

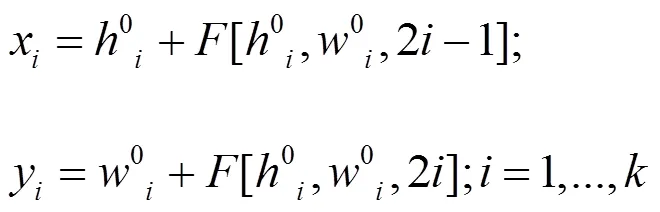

DeepLabCut的损失函数kpt为交叉熵损失函数,设out_n表示关键点分支通过Softmax层后的输出;p表示标签真值;ap指一个批次的所有样本量,则kpt表示为

1.3 多任务深度网络损失函数设计

边框预测、语义分割预测与关键点预测3类子任务应用于起重机实例对象的预测、识别。子任务之间具有同质性,可提高特征提取器的泛化性,最终提升各子任务预测准确性,并且通过公用骨干网络,减少算法时间复杂度与空间复杂度。

Mask R-CNN总损失函数添加DeepLab关键点分支损失函数项kpt得到多任务深度网络损失函数f=+kpt。最后利用Adam算法[11],最小化总损失函数f,训练获得最优网络参数。

2 实验与结果分析

本实验对象为广东省珠海市某厂房的通用式吊钩桥式起重机,选用MV-CA060-10GC、4 K分辨率工业相机为图像采集传感器;深度学习硬件设备为Nvidia 1080ti显卡,CPU为i7 8700, 32 GB内存。

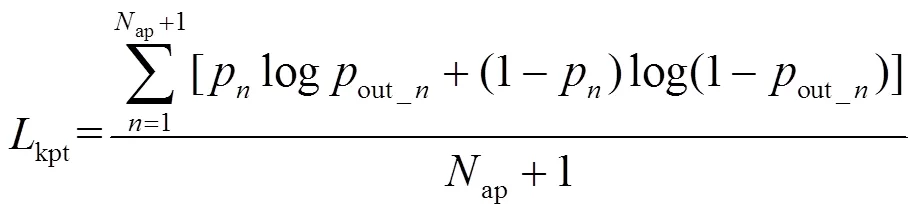

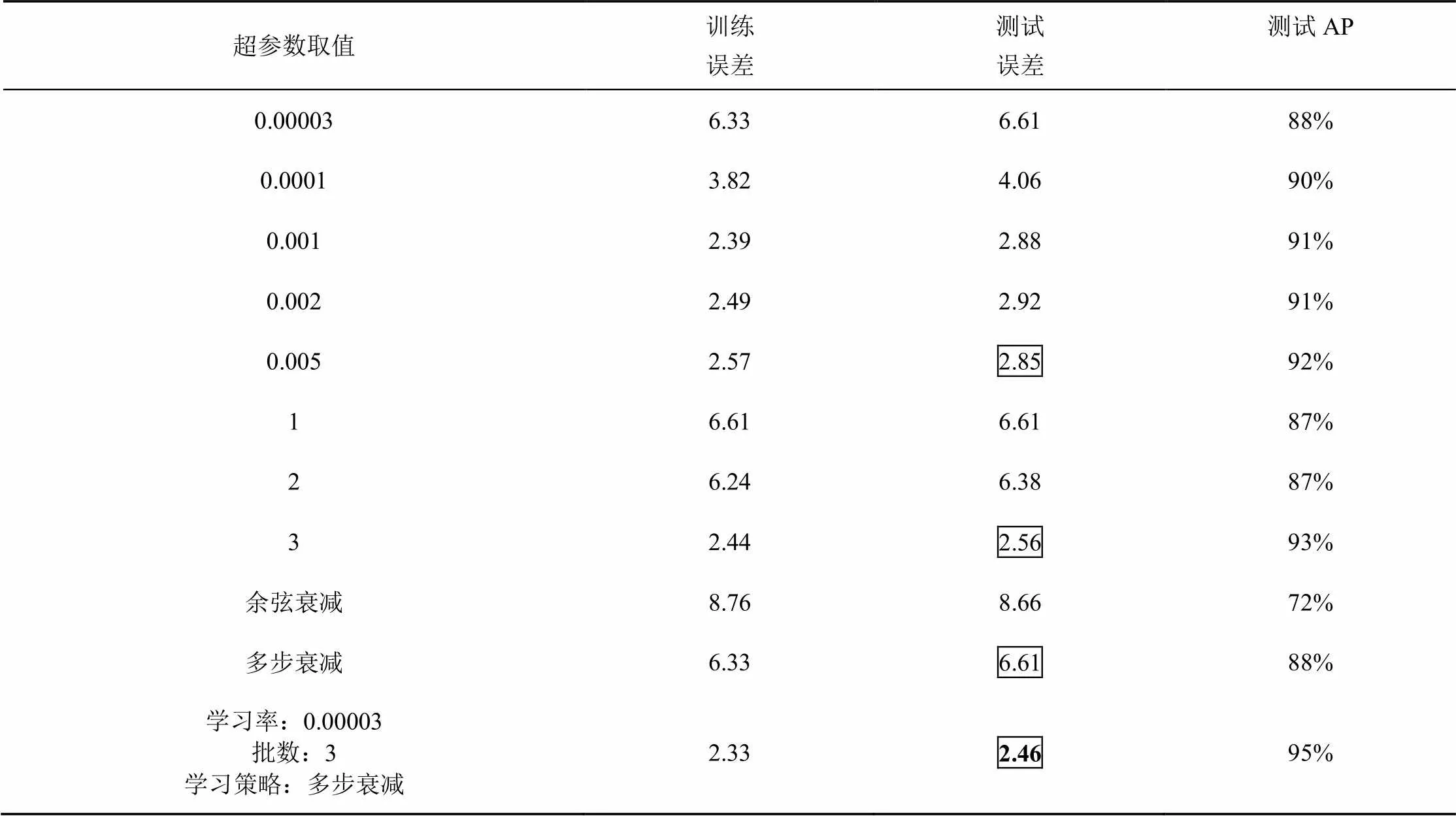

采集全天候起重机运行视频,并抽帧500张图像作为训练集,利用贪婪线性搜索算法,获得近似超参数最优组合。基本超参数组合为:学习率0.00003,批数1,学习率策略为多步衰减。在此基本超参数组合上,依次改变单个超参数的取值,不同组合下的误差结果如表1所示。

将单步搜索最优值对应超参数取值进行组合,得到近似最优组合:学习率为0.00003,批数为3,学习率策略为多步衰减,对应训练误差为2.33,测试误差为2.46。

表1 超参数优化效果

利用树状结构Parzen估计方法[14]获取超参数最优组合,这是一种贝叶斯优化算法,与贪婪线性搜索算法不同,它依据历史搜索结果,得出此次实验的超参数组合,从而提升搜索效率。搜索结果表明:最优组中的最优超参数组合为:学习率0.005,批数2,学习率策略为余弦衰减,对应的测试误差与训练误差分别为2.29与2.10。综合2种优化算法,最终得到最优超参数组合为:学习率0.005,批数2,学习率策略为余弦衰减,测试误差2.46个像素点,测试AP可达95%。最优训练效果下多任务深度网络语义分割与关键点识别效果如图5所示。实际测试结果表明基于多任务学习Mask R-CNN分割与关键点识别网络特征点检测实际误差在5 cm以内,满足实际检测需求。

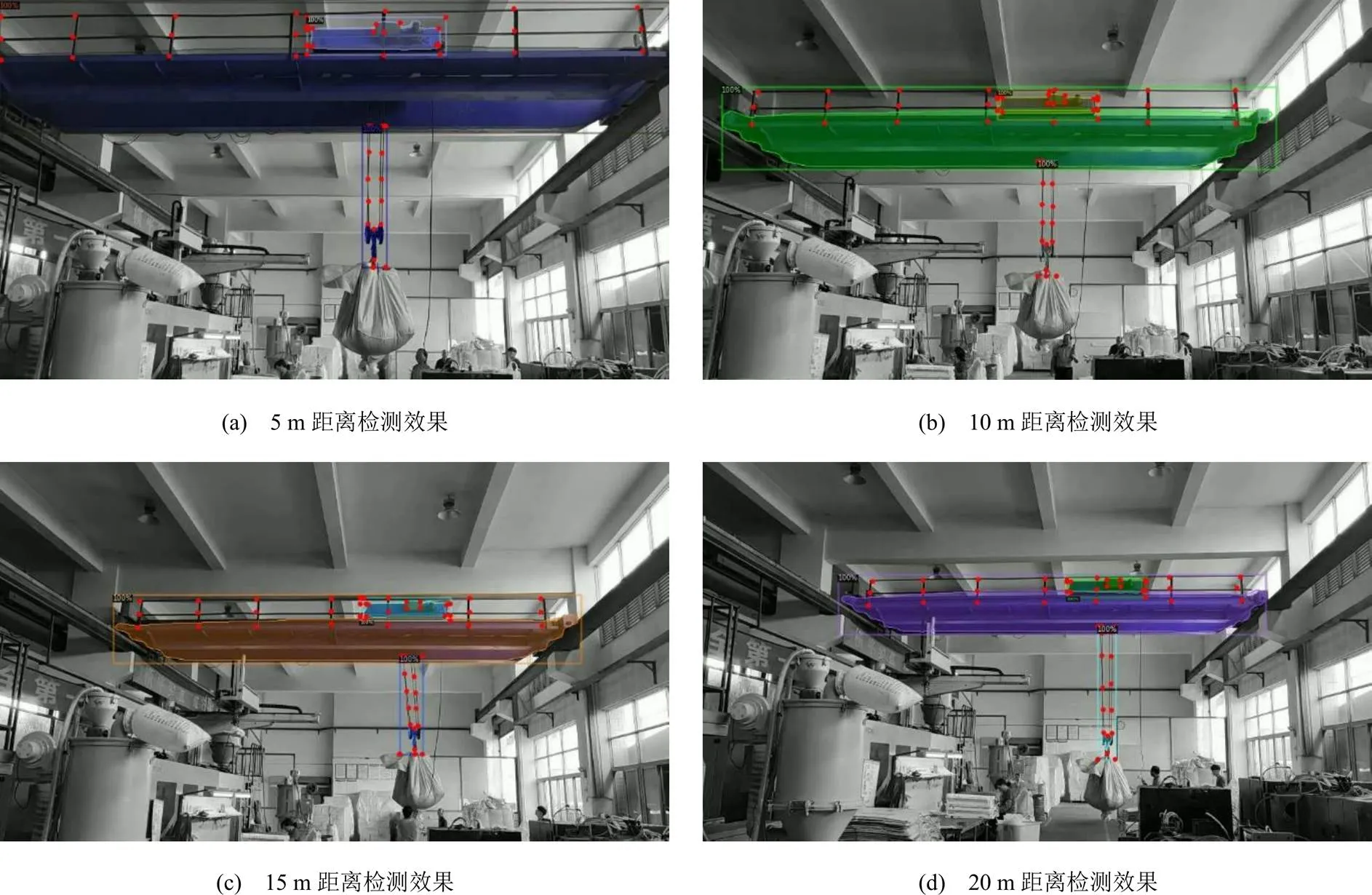

图5 多任务深度网络语义分割与关键点识别效果

3 结语

1)依据起重机日常运行状态检测信息,提出面向起重机部件的多任务学习Mask R-CNN分割与关键点识别网络,包括Mask R-CNN关键部件定位框与区域语义分割网络结构、DeepLabCut关键点检测网络结构;

2)利用贪婪线性搜索算法与贝叶斯优化算法,搜索此模型的最优超参数组合,训练收敛后,得到用于起重机大车、小车与吊具的定位框识别、区域实例分割与关键点识别最佳深度学习检测模型,测试误差2.46个像素点,测试AP可达95%,特征点实际检测误差在5 cm以内。

下一步可依据边缘计算理论,将加速算法模型部署在桥式起重机现场边缘端设备,构成云边端检测系统,实现起重机运行状态量实时测量。

[1] 张昊.基于物联网的门式起重机结构健康监测管理系统[D].南京:南京理工大学,2018

[2] 姜长城.门式起重机远程监测及诊断分析系统研发[D].南京:东南大学,2018.

[3] 罗伟.门式起重机管理中安全监控管理系统的应用[J].中国设备工程,2018(19):32-33.

[4] 陈洪志. 大型起重机臂架旁弯图像测量算法研究[D].广州:广东工业大学,2015.

[5] 李明聪.基于图像的嵌入式吊绳状态监测系统设计[D].大连:大连海事大学,2016.

[6] 张锐. 基于机器视觉的塔式起重机控制策略研究[D].合肥:合肥工业大学,2019.

[7] Redmon Joseph, Divvala Santosh, Girshick Ross, et al. You only look once: unified, real-time object detection[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas, America: Computer Vision Foundation, 2016. 779-788.

[8] He Kaiming, Gkioxari Georgia, Dollar Piotr, et al. Mask R-CNN[C]// IEEE international conference on computer vision. Venice, Italy: IEEE,2017.2961-2969.

[9] CARUANA R. Multitask Learning[J]. Machine Learning, 1997, 28(1):41-75.

[10] KINGMA D P, BA J. Adam: a method for stochastic optimization[J]. arXiv preprint arXiv:1412.6980, 2014.

[11] MOCKUS J, TIESIS V, ZILINSKAS A. The application of Bayesian methods for seeking the extremum[J]. In L.C.W. Dixon and G.P. Szego, editors, Towards Global Optimization, North Holland, New York, 1978, 2:117–129.

Multi-task Learning Mask R-CNN Segmentation and Key Point Recognition Method for Bridge Crane Components

Yang Fan1Liang Minjian2Yang Ningxiang2Peng Xiaojun2

(1.School of Mechanical and Automotive Engineering, South China University of Technology, Guangzhou 510640, China 2.Guangdong Institute of Special Equipment Inspection and Research Zhuhai Branch, Zhuhai 519002, China)

Real time detection of crane operation status is one of the important guarantees for industrial safety production. A segmentation and key point network structure based on multi task learning mask R-CNN is proposed R-CNN crane key parts positioning frame and regional semantic segmentation network, crane key point detection network based on DeepLabCut; in a hook crane to collect data for testing, using greedy linear search algorithm and Bayesian optimization algorithm, the optimal super parameter combination of this model is: learning rate 0.005, batch size 2, learning rate strategy is cosine decay . The test error of the model is 2.46 pixels, and the test AP is up to 95%. The pixel error can be reflected within 5 cm of the actual error, which can meet the actual detection needs, and can be extended to the unmanned and automatic crane operation state monitoring.

bridge crane; key point recognition; deep learning; convolutional neural networks; multi-task learning; semantic segmentation

TN911.73

A

1674-2605(2021)02-0003-05

10.3969/j.issn.1674-2605.2021.02.003

广东省特种设备检测研究院2019年度科技项目(2020JD09)

杨帆,男,1996年生,硕士研究生,主要研究方向:人工智能与精密检测技术研究。E-mail:201820100566@mail.scut.edu.cn