结构增强型生成对抗网络SAR图像超分辨率重建

2021-04-15闵锐,杨学志,董张玉,4,陈鲸

闵 锐,杨 学 志,董 张 玉,4,陈 鲸

(1.合肥工业大学计算机与信息学院,安徽 合肥 230009;2.工业安全与应急技术安徽省重点实验室,安徽 合肥 230009;3.合肥工业大学软件学院,安徽 合肥 230009;4.智能互联系统安徽省实验室,安徽 合肥 230009)

0 引言

SAR(Synthetic Aperture Radar)系统[1-3]具备全天时、全天候、多极化等优点,在遥感领域具有重要研究/应用价值,然而受系统设备以及成像过程不可抗干扰等因素影响,实际获取的SAR图像空间分辨率较低,难以满足应用需求。由于SAR系统硬件设备昂贵,目前一般从软件算法方向[4]提升SAR图像空间分辨率,重建后的SAR图像可更好用于目标识别分类[5]、灾害监测[6]等任务。

传统图像重建方法分为三大类:1)基于插值[7]的方法,如最近邻插值[8](Nearest Neighbor Interpolation,NNI)、双线性插值[9]和双三次(Bicubic)插值[10]算法,该类方法主要通过插值函数估计待插值位置像素值以完成图像重建,原理简单、重建速度快,但插值后图像质量较差、缺乏高频信息,导致重建图像纹理粗糙、边缘模糊;2)基于重建的方法,如凸集投影法[11](Projection Onto Convex Sets,POCS)、迭代反投影法[12](Iterative Back Projection,IBP)和最大后验概率法[13](Maximum A Posteriori,MAP),该类方法旨在通过正则化约束制约解空间,以寻求高分辨率图像近似估计,在图像边缘和细节重建方面比插值算法效果更好,但解不唯一且易受初始值影响;3)基于学习的方法[14],其核心为以学习的方式获取低分辨率到高分辨率图像的非线性映射关系,通过选取合适的学习方法获取重建模型,与基于重建的方法相比,该类方法通过训练样本获得额外先验知识,在重建图像高频细节信息部分效果更好。深度学习生成对抗网络(Generative Adversarial Network,GAN)[15]具有强大的特征提取和特征表达能力,基于GAN网络的超分辨率图像重建算法相比传统方法效果更好。例如:Legid等[16]首次将GAN网络用于图像重建,提出超分辨率生成对抗网络(Super-Resolution Generative Adversarial Network,SRGAN),不同于超分辨率卷积网络(Super-Resolution Convolutional Neural Network,SRCNN)[17-19],SRGAN网络具有生成和判别双网络,博弈对抗训练方式保证了生成网络重建图像质量随着判别网络性能增强而提升,效果显著优于传统方法;为进一步提升重建图像质量,Wang等[20]提出增强型超分辨率生成对抗网络(Enhanced Super-Resolution Generative Adversarial Network,ESRGAN)模型,该模型通过改进生成网络和感知域损失函数,有效增强了重建图像细节信息和视觉效果,进一步提升了生成对抗网络超分辨率重建优势,但仍存在重建图像边缘细节信息不足和局部“伪影”等问题。为解决此问题,本文提出一种基于生成对抗网络的SAR图像重建算法,以期有效增强重建图像边缘细节信息,改善“伪影”现象,并与其他算法进行比较,探索该算法在图像重建方面的优势。

1 研究方法

1.1 GAN原理

GAN是一种无监督深度学习模型,主要由生成器G(Generator)和判别器D(Discriminator)组成,G用于学习训练数据分布,从而产生符合真实数据分布的新样本数据,D用于判别G生成新样本真假,二者交替训练提升各自网络性能,形成博弈对抗关系,最终使整个网络达到“纳什均衡”[21]。GAN数学模型表达式为:

(1)

式中:E表示函数期望值;Pdata(x)为真实样本数据集;Pz(z)为先验数据集,z为随机噪声数据;D(G(z))表示D判别生成样本G(z)的真实概率,值越接近1,表示生成数据越接近真实样本,同理D(x)表示D判别真实样本x的真实概率。

GAN对抗训练流程为:1)初始化生成器G和判别器D参数;2)从真实样本Pdata(x)中随机采集n个样本x,从先验分布Pz(z)中随机采集n个噪声z,并通过生成器G生成n个生成样本G(z);3)固定生成器G,训练判别器D以尽可能准确判别真实样本和生成样本,循环多次更新D参数,增大D(x)数值,减小D(G(z))数值;4)固定判别器D,训练生成器G以尽可能缩小生成样本与真实样本差距,循环多次更新G参数,增大D(G(z))数值;5)重复步骤3)和步骤4),使得D(x)≈D(G(z))≈0.5,即网络最终达到“纳什均衡”。

1.2 结构增强型生成对抗网络框架

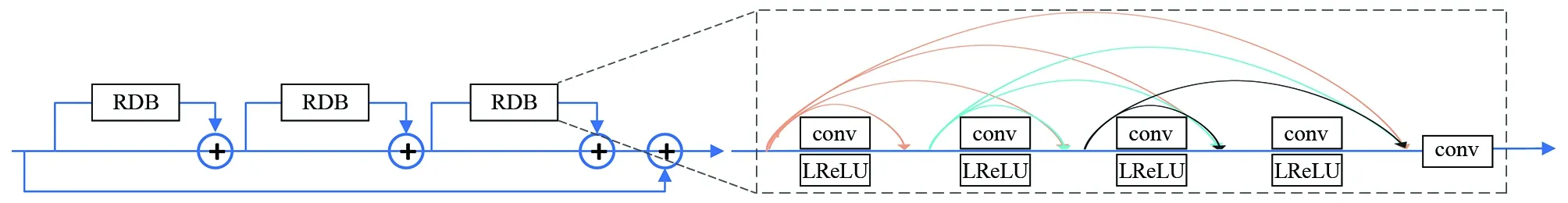

近现代图像超分辨率重建研究多围绕光学图像展开,鉴于成像后阶段SAR图像与光学灰度图像存储方式和通道数相同,二者存在一定相似性,本文参考ESRGAN[20]光学网络模型,对其重建SAR图像存在的边缘细节信息不足与“伪影”现象进行改进,提出一种结构增强型生成对抗网络(Enhanced Structural Generative Adversarial Network,ES-GAN)SAR图像重建算法,ES-GAN模型生成器网络结构按模块功能可分为特征提取模块A、特征增强模块B和上采样重建模块C(图1),各模块网络层参数如表1所示。

图1 ES-GAN生成器网络结构

表1 ES-GAN网络参数

(1)特征提取模块A,由第一个卷积层组成。基于“高频边缘细节信息倾向于被较小卷积核所提取,而较为粗糙的结构内容信息更适合较大尺寸卷积核提取”[22],为保留更多SAR图像边缘细节信息,同时降低计算复杂度,本文网络使用3×3小卷积核提取输入SAR图像特征信息。用ILR表示输入低分辨率SAR图像,fconv1表示第一个卷积过程,xconv1表示卷积输出结果,则模块A可表示为:

xconv1=fconv1(ILR)

(2)

(3)

xconv2=fconv2(xRRDB)

(4)

图2 RRDB模块结构

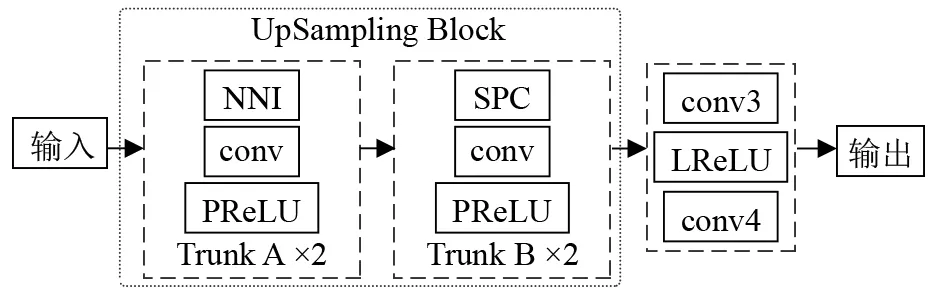

(3)上采样重建模块C,由上采样和第三个卷积层组成。不同于ESRGAN网络模型采用单一上采样方式,本文交替使用最近邻插值(NNI)和亚像素卷积(Sub-Pixel Convolution,SPC)方式进行上采样,NNI执行空域变换,SPC执行depth-to-space变换,二者交替有助于提升空间结构信息与深层抽象信息的交互融合,同时SPC上采样方式有助于降低参数量和时间复杂度。本文网络上采样重建模块结构如图3所示,其中,Trunk A和Trunk B分别代表NNI和SPC上采样模块,每个采样模块放大倍数scale=2,使用PReLU(Parametric Rectified Linear Unit)作为激活函数,因为PReLU函数能够使网络稀疏性更好,从而提升训练精度,同时在反向传播过程中能够保持较好的流动性,从而加快网络训练速度[23]。最后采用卷积网络将多通道特征图融合为单通道特征图并输出,进而参考Shang等[24]的研究提出模型上采样部分结构,采用LReLU函数提高模型特征融合过程中的非线性拟合性能。定义NNI上采样模块函数为fTrunkA,SPC上采样模块函数为fTrunkB,第3、4个卷积层函数分别为fconv3、fconv4,LReLU函数为fLReLU,最后模型输出ISR可表示为:

ISR=fconv4(fLReLU(fconv3(fTrunkB(fTrunkA(xconv1+xconv2)))))

(5)

图3 上采样重建模块结构

1.3 损失函数

(1)VGG感知损失LVGG:网络用VGG19模型进行预训练,φij表示VGG19模型中第i层池化层和第j层卷积层之间的特征映射图,(i,j)为相应特征图维度,低分辨率图像ILR尺寸为W×H,则定义LVGG为重建图像ISR与参考图像IHR之间的欧氏距离,公式为:

(6)

(7)

(3)像素损失Lpix:定义超分辨率放大尺寸为r,则重建图像ISR尺寸为rW×rH,Lpix可表示为:

(8)

(9)

综上,本文网络生成器总损失函数Ltotal公式为:

(10)

2 实验结果与分析

2.1 SAR数据集

(1)训练数据集:从哥白尼数据开放中心(https://scihub.copernicus.eu)下载125张哨兵-1B GRD级别SAR数据,空间分辨率为10 m,VH极化,重访周期6 d。对图像进行预处理:利用ENVI软件自动配准工具对SAR数据进行配准成像,配准误差小于1个像元;采用BM3D[25]滤波算法对SAR图像相干斑噪声进行降噪;将原图像裁剪为256×256大小。为使网络训练效果更佳,对有限数据集进行扩展:对预处理后的SAR图像进行0°、90°、180°、270°旋转及镜像操作,得到8倍增样本,最终得到1 000张256×256高分辨率参考图像IHR;再利用双三次插值算法对参考图像IHR4倍降采样,得到1 000张64×64低分辨率图像ILR。

(2)测试数据集:选取由分享网站(https://down.itsvse.com/item/15937.html)提供的TerraSAR-X卫星拍摄的3幅不同场景SAR图像(成像时间为直布罗陀:2008年3月,荷兰纳尔登:2009年3月,西班牙安达素尔:2013年3月),成像模式均为高分辨率聚束模式(High Resolution SpotLight,HS)、VV或HH单极化,分辨率为1 m×1 m,重访周期为11 d。由于图像中含有大量山体、农田和建筑等地物,内容和纹理信息丰富,适合作为验证图像。将3幅SAR图像裁剪为256×256大小,并选取其中10幅纹理细节丰富的SAR图像块,制作成测试数据集,如图4所示。

图4 测试数据集

2.2 实验环境及参数设置

本文实验环境为Window 10-64位操作系统,CPU为Intel(R) Xeon(R)Silver 4114 CPU@2.20 GHz 2.19 GHz,内存为128 GB RAM,GPU为NVIDIA Tesla P100-PCIE,显存16 GB,使用Pytorch框架搭建ES-GAN网络模型,实验统一进行放大倍数scale=4 的SAR图像超分辨率重建实验,并与传统双三次(Bicubic)插值、深度学习SRCNN和ESRGAN模型进行对比分析。生成器网络使用Adam优化器(β1=0.9,β2=0.000),初始化学习率为1×10-4,每批次数量为batch_size=32,最大迭代次数epochs=20 000,λ=0.02,η=0.05,ζ=0.005。

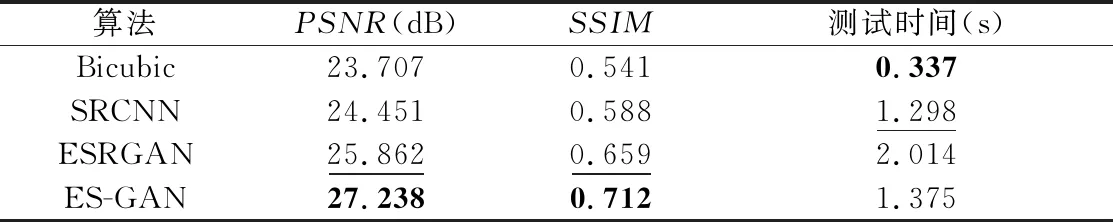

2.3 模型对比分析

选用峰值信噪比(PSNR)、结构相似性(SSIM)和测试时间作为算法评价指标,使用图4测试数据集对本文ES-GAN网络模型与Bicubic、SRCNN[16]、ESRGAN[18]超分辨率网络模型进行实验。依次采用各算法模型对测试数据集进行重建,并记录每幅重建图像的PSNR、SSIM和重建时间,PSNR和SSIM取10幅图像的平均值,测试时间求和,得到各算法最终评价指标(表2)。可以看出:1)Bicubic方法忽略了像素间的空间联系,导致其PSNR和SSIM最低;深度学习方法中,采用对抗训练方式的ESRGAN和ES-GAN模型重建指标更优;针对对抗训练方式所造成的“伪影”现象,ES-GAN模型从网络结构和损失函数两方面加以改进,故重建图像PSNR和SSIM最高,空间信息保持最好。2)Bicubic插值方法原理最简单,测试时间最短;深度学习方法中,ES-GAN与SRCNN模型测试时间大致相当,由于ES-GAN模型采用传统插值和亚像素卷积方式交替上采样,其比ESRGAN模型采用单一亚像素卷积上采样方式用时更短,算法效率更佳,更适合海量遥感卫星数据超分辨率重建。

表2 各模型评价指标对比

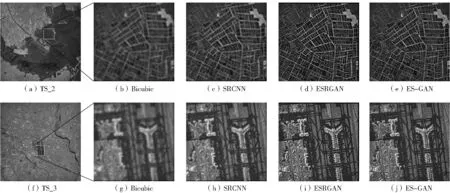

为进一步证明本文算法有效性,选取两幅纹理边缘信息丰富影像(TS_2和TS_3)的局部区域(图5a、图5f中白框部分)进行说明(图5)。对于TS_2影像而言,因插值算法忽略了像素间的空间联系,导致Bicubic重建图像视觉效果较模糊,像素间“锯齿”现象较严重(图5b);深度学习模型(图5c-图5e)中,ESRGAN和本文ES-GAN模型由于网络层数更多,对特征提取更充分,因此重建图像更加清晰,视觉效果更好,尤其是本文ES-GAN模型重建结果(图5e)边缘纹理更加清晰、真实,层次感更强,结构更合理,但ESRGAN模型重建结果(图5d)部分纹理出现错乱现象。上述分析结果对于TS_3影像同样适用。

图5 ES-GAN结果的定性对比

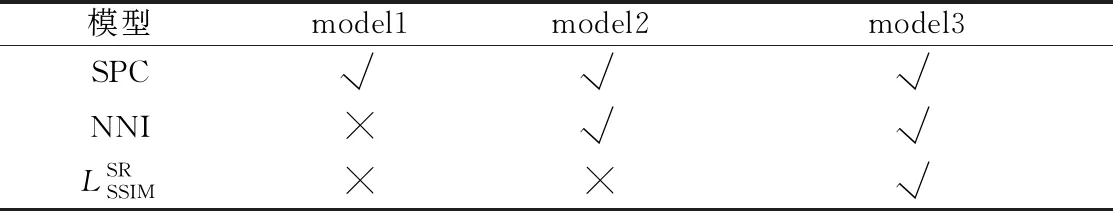

2.4 消融实验

表3 ES-GAN模型结构消融对比

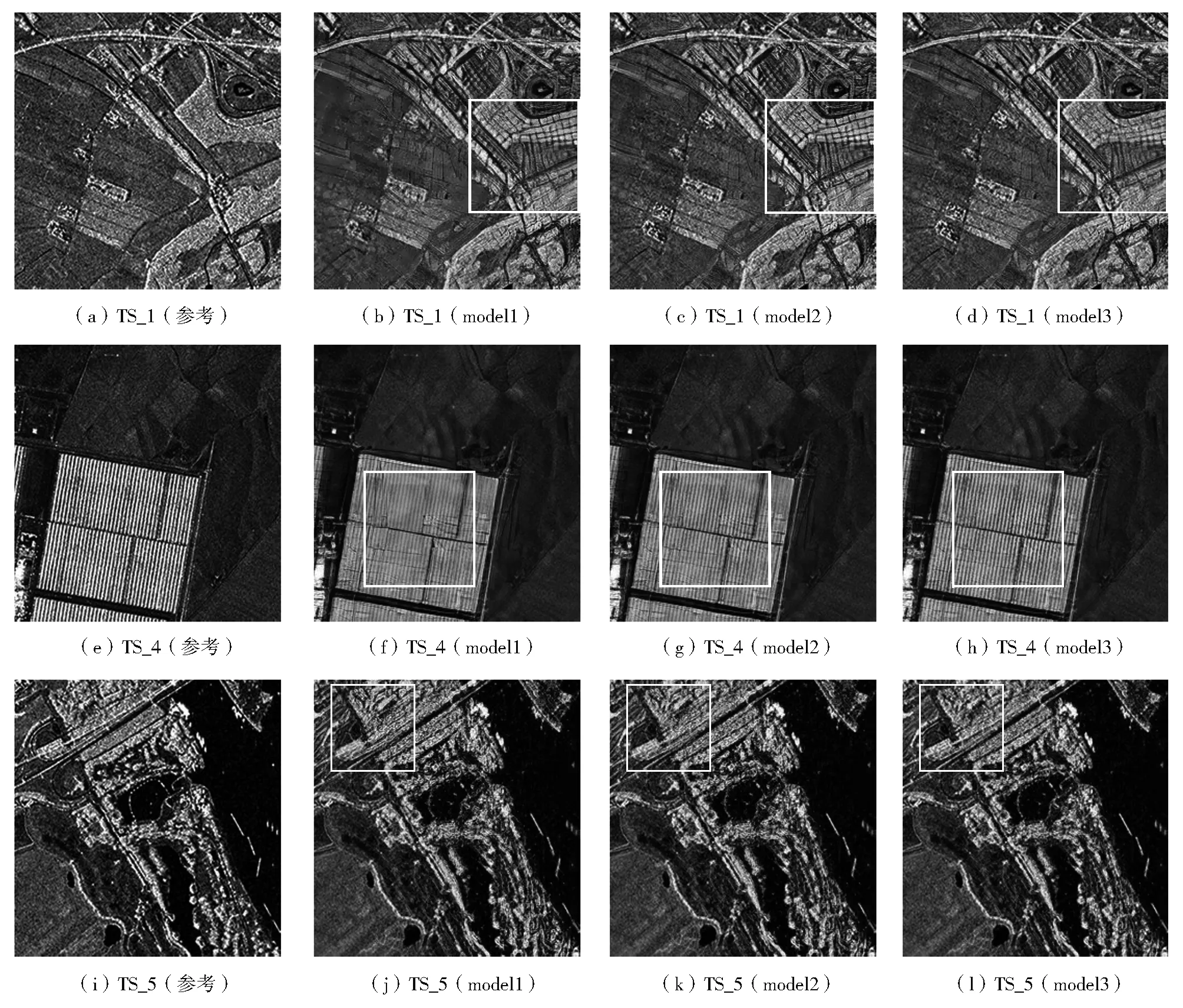

选用不同模式下的ES-GAN模型依次对测试数据集的10幅SAR图像进行重建,并选取纹理信息较丰富、结构层次感较强的3张重建图像(TS_1、TS_4和TS_5)进行效果对比(图6)。

(1)重建模块:对比图6中第二、三列子图发现,在损失函数相同的情况下,交替采用SPC和NNI进行上采样的第三列子图更清晰,边缘纹理细节更突出(如图6f和图6g框内部分),视觉效果明显优于仅采用SPC上采样的第二列子图;同时对比图6a-图6c及图6i-图6k中框内部分可以发现,重建图像均出现一定程度纹理错乱,图像结构与原图有明显差异,仍存在与参考图像结构纹理信息不符的“伪影”现象。

图6 ES-GAN消融实验效果

3 结论

本文在ESRGAN模型基础上对原网络结构和损失函数加以改进,提出一种结构增强型生成对抗网络SAR图像重建算法,该算法特点为:1)网络结构上,改进原网络上采样模块,采用NNI和SPC交替上采样方式,促进了空间深度信息交互融合,增强了重建图像边缘细节信息;2)损失函数上,在原网络损失函数基础上引入结构损失函数,通过每批次反向传播调节生成网络参数,达到缓解网络“伪影”目的。通过视觉效果和质量评价对算法有效性进行验证,结果表明:本文算法重建图像内容结构保持更好,纹理细节信息更丰富,证明了交替采样方式和结构损失函数对重建图像细节提升、缓解“伪影”现象的有效作用;本文算法对于结构内容单一图像的重建效果提升不明显,更适用于纹理信息丰富的SAR图像。本文仍存在不足之处:在数据验证方面,由于没有公开SAR图像超分辨率验证数据集,验证结果缺乏可比性;在图像处理上,对SAR图像固有的乘性光斑噪声、SAR图像存储方式等特性考虑不足,后续实验将进一步结合SAR图像自身特性,同时关注算法在灾害监测、目标识别等方面的实用价值。