基于双分支卷积神经网络的SAR与多光谱图像融合实验

2021-04-15吴佼华,杨学志,方帅,董张玉,4

吴 佼 华,杨 学 志,方 帅,董 张 玉,4

(1.合肥工业大学计算机与信息学院,安徽 合肥 230009;2.工业安全与应急技术安徽省重点实验室,安徽 合肥 230009;3.合肥工业大学软件学院,安徽 合肥 230009;4.智能互联系统安徽省实验室,安徽 合肥 230009)

0 引言

合成孔径雷达(Synthetic Aperture Radar,SAR)具有全天时、全天候、穿透力强等特点[1],其获取的高空间分辨率SAR图像中地物目标的反射特性受微波频率、反射角和极化方式影响,导致相同物体表现形式不同[2],不利于图像的解译;而多光谱(Multi-Spectral,MS)图像则可以反映地物目标的轮廓和光谱信息,但MS卫星传感器完全依赖于发光源,不能在夜间成像且易受恶劣天气影响,导致MS图像部分明显目标信息丢失。因此,对SAR和MS图像进行融合,能充分利用两者的互补信息,在保持光谱信息的基础上,增强MS图像的空间细节信息和目标的特征信息,融合图像可更好地用于灾害监测、地物分类、目标识别等后续任务。

传统的SAR和MS图像融合算法可分为3类:1)成分替换(Component Substitution,CS)法,主要有主成分分析(PCA)、IHS变换和Brovey等;该类算法实现简单,融合结果中SAR图像细节信息明显,但由于SAR图像与MS图像谱段范围存在较大差异,简单地将SAR图像替换为MS图像的主成分分量,融合结果会产生严重的光谱失真。2)多尺度分析(Multi-Resolution Analysis,MRA)法,包括小波(wavelet)法、金字塔变换、非下采样轮廓波变换(NSCT)、非下采样剪切波变换(NSST)等。例如:宋建社等[3]应用小波变换法融合SAR和MS图像,融合后图像的光谱得到改善,但存在伪影和边缘锯齿;苏志渊等[4]充分利用NSCT的平移不变性、多尺度性、多方向性和较强的轮廓信息表达能力,提出基于NSCT的SAR和MS图像融合算法,明显提高了融合效果。相比CS法,MRA法能有效抑制SAR图像的噪声,减少光谱畸变,但易受图像配准的影响,产生混叠和边缘伪影。3)混合法(hybrid method),即利用CS法分离MS图像的强度信息和光谱信息,应用MRA法将SAR和MS图像的强度分量融合以获得新的分量,最后逆变换新的分量和光谱信息得到融合图像,如Mercer等[5]采用基于混合IHS变换和小波变换的SAR和MS图像融合算法,将经过小波分解后的SAR图像的近似分量替换MS图像强度分量中的近似分量,以增强多光谱的空间细节信息;该算法能够获得更好的空间和光谱信息,但其中CS法仅限于能够进行空间变换的融合方法(如PCA和IHS)[6]。相对于传统算法,卷积神经网络(Convolution Neural Network,CNN)具有强大的特征提取和特征表达能力[7],因此,基于CNN的超分辨图像融合算法相继被提出。例如:Masi等[8]首次应用超分辨率卷积神经网络(SRCNN)[9]进行图像全色锐化(pan-sharpening),结果明显优于传统算法;Yang等[10]提出了PanNet网络,将图像融合任务拆分成光谱保持和空间保持两部分,实现融合图像光谱和空间质量的提升;Shao等[11]提出了RSIFNN网络并基于该网络实现图像全色锐化,分别对多光谱和全色图像进行特征提取,然后融合提取的深层特征并采用残差学习方式得到融合结果。基于以上研究,本文引入“特征提取—融合—重建”的空间细节融合方案,提出一种基于双分支CNN的SAR和MS图像融合算法,以期有效改善MS影像的空间信息,并与其他算法进行对比分析,探索深度学习在SAR和MS图像融合方面的优势。

1 研究方法

1.1 网络框架

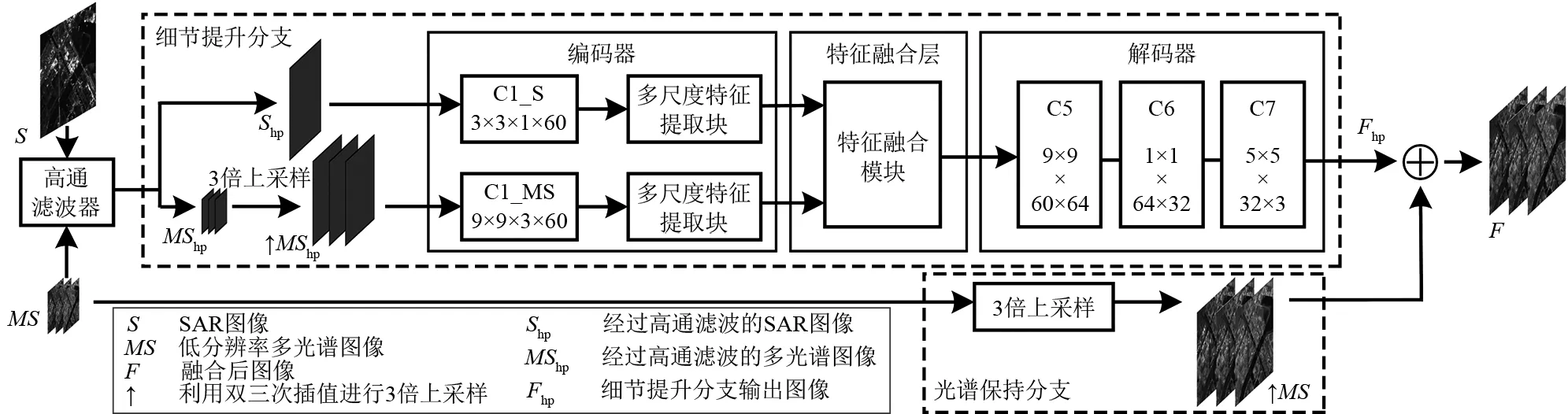

SAR图像与MS图像的成像机理和覆盖波段有所差异,图像信息相关性弱,甚至局部会出现负相关,通常的细节注入融合方法所得融合图像往往会出现颜色畸变。本文参考PanNet[10]的网络框架,提出一种基于双分支CNN的SAR和MS图像融合算法,将SAR和MS图像融合的任务拆分成细节提升分支和光谱保持分支(图1)。

图1 本文算法的网络框架

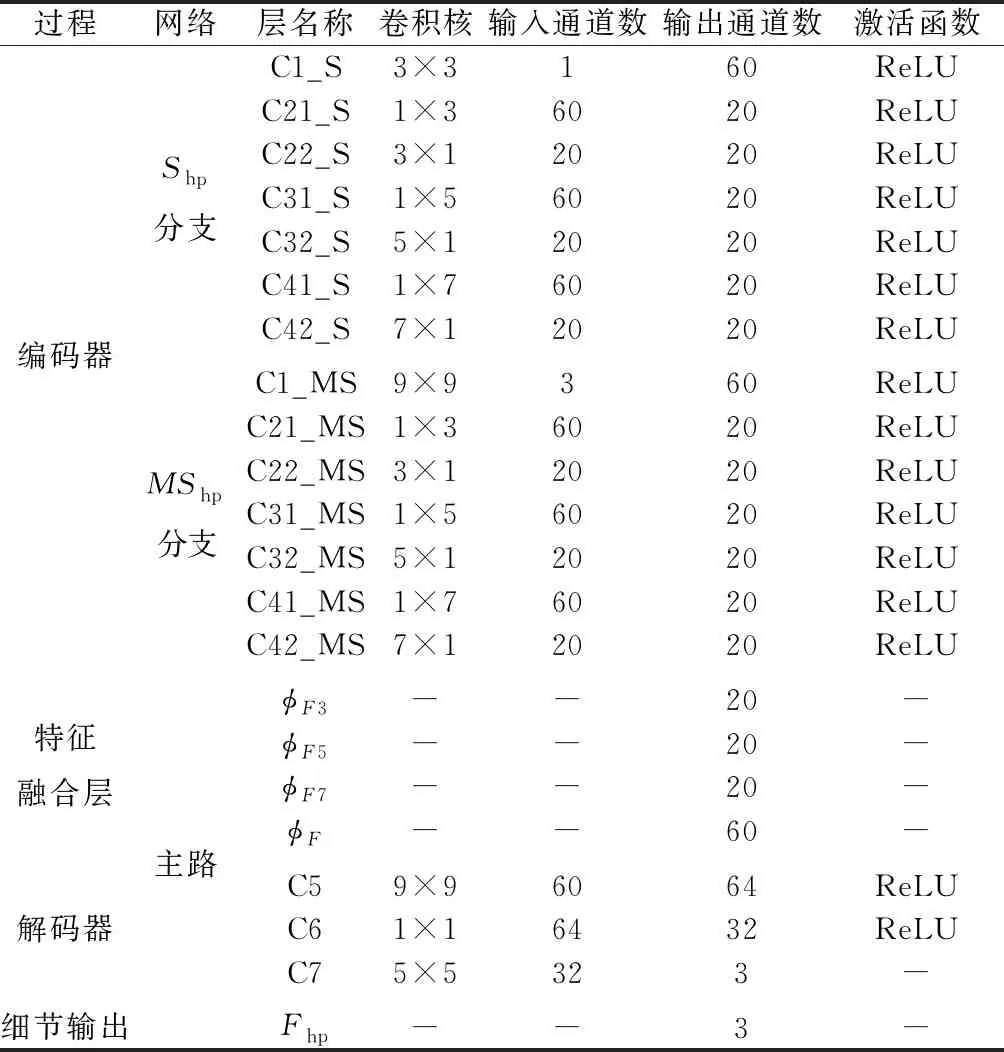

(1)细节提升分支。参考蔡婉婷[12]耦合多尺度网络的结构,将细节提升分支分为编码器、特征融合层和解码器3个模块,网络结构参数如表1所示。1)将原始SAR和MS图像经过高通滤波器得到图像的高频信息,并将MS图像高频信息上采样到SAR图像高频信息的同等分辨率;在编码器模块中,设计两个不同的特征提取网络,分别提取SAR和MS图像高频信息的深层特征。考虑到“具有较小尺度的特征会对较小尺寸的卷积核作出反应,而较粗糙结构倾向于被更大的卷积核提取”[12],本文采用不同尺寸的卷积核分别提取两幅图像高频信息的浅层特征。SAR图像的分辨率高,细节比MS图像丰富,对于SAR图像高频信息,本文使用3×3的卷积核提取小尺度的浅层特征,对于MS图像高频信息,则采用9×9卷积核提取大尺度的浅层特征;然后将浅层特征经过多尺度特征提取块(采用卷积分解[13]方式,将n×n的卷积核分解为1×n和n×1两个卷积核,以减少卷积计算量),得到多尺度的深层特征。2)在特征融合层模块中,对不同源图像的深层特征进行融合。先将编码器模块输出的不同尺度深层特征按同尺度特征进行像素相加,从而将SAR图像细节信息叠加到MS图像中,再将叠加融合后的所有特征图进行通道级联,作为解码器的输入,其过程如式(1)、式(2)所示。多尺度特征提取块和特征融合模块如图2所示。3)在解码器模块中,采用SRCNN[9]网络结构,将融合后的特征图映射回图像的空间信息。第一层是9×9卷积核,第二层是1×1卷积核,最后一层是5×5卷积核,经过三层卷积将特征通道维度降至3维。解码过程如式(3)所示。

表1 细节提升分支网络结构参数

φFi(Shp,↑MShp)=φSi(Shp)⊕φMSi(↑MShp)

(1)

φF(Shp,↑MShp)=C(φFi(Shp,↑MShp))

(2)

式中:φSi(Shp)和φMSi(↑MShp)分别表示采用i×i(i=3、5、7)卷积核通过卷积操作提取的SAR和MS图像的深层特征;⊕表示特征像素级叠加操作;φFi(Shp,↑MShp)表示采用像素叠加方式融合得到的特征图;C(·)表示特征图通道级联操作;φF(Shp,↑MShp)表示最终融合后的特征图。

Fhp=G(φF(Shp,↑MShp))

(3)

式中:Fhp表示细节提升分支输出的空间细节信息;G(·)表示解码器解码操作。

(2)光谱保持分支。采用跳线连接方式,将细节提升分支输出的细节信息叠加到上采样的MS图像,将MS图像的光谱信息传递到融合图像F中,得到最终的融合结果。其实现过程如下:

F=Fhp⊕↑MS

(4)

图2 多尺度特征提取块与特征融合模块

1.2 损失函数

本文的损失函数ltotal包括光谱损失lspectral和细节损失lspatial(式(5)),lspectral为融合图像F和参考图像GT的L2 范数,lspatial为细节提升分支输出的细节信息Fhp与SAR图像的高频信息Shp之间的L2范数。

(5)

2 实验与结果分析

2.1 实验区及数据

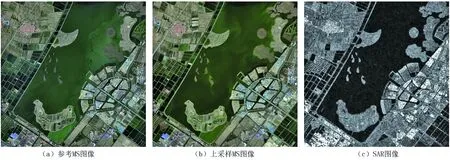

实验区为天津市郊区,地物类型丰富(包括农田、居民点、港口等)。研究数据包括从地理空间数据云[14]下载的Landsat8_OLI_TIRS卫星多光谱数据和哥白尼数据开放中心[15]下载的哨兵-1B GRD级别的SAR数据(表2)。实验前利用ENVI的自动配准工具进行SAR和MS图像配准,配准误差在1个像元内;SAR图像存在明显的相干斑噪声,采用BM3D[16]滤波方法对其进行降噪处理。

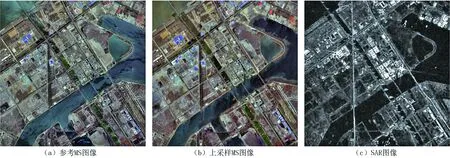

选取两组地物信息丰富且各具特点的感兴趣区域(图3、图4)进行算法有效性验证。第一组为天津乐乐岛附近,包含城市建筑、湖水、裸地、耕地等多类易混淆地物;第二组为渤海港口附近,包含大量农作物和桥梁建筑等地物,且SAR图像中含有MS图像中无法觉察的显著目标信息(如图4中的桥梁)。另外,由于不存在SAR和MS图像融合后的理想图像,为使本文的实验结果同时在光谱和细节方面有一个更好的参照,加入感兴趣区域的哨兵-2A多光谱数据(分辨率为10 m)作为参考MS图像。

表2 卫星数据参数

图3 第一组实验数据

图4 第二组实验数据

2.2 实验设置

本文实验环境为Window 10,64位操作系统,NVIDIA Quadro M2000-4G显卡,在tensorflow框架下搭建双分支卷积神经网络。训练批大小为100,迭代次数为30 000次,优化器选择Adam,学习率为0.001,动量衰减系数为0.9。从预处理后的SAR和MS影像中裁剪出9 600组大小分别为90×90和30×30的影像对用于网络训练,按照9∶1的比例选择8 640对作为训练集,960对作为验证集;裁剪2组大小分别为900×900和300×300的SAR和MS图像对作为测试集。网络训练开始时,训练数据经过Wald[17]协议进行预处理:原始MS图像作为参考图像GT,同时将原始SAR和MS图像对以双三次插值方式进行3倍上采样,得到S和MS图像对,最后将GT(30×30×3)、S(30×30×1)、MS(10×10×3)3组数据一起输入网络进行训练,平均训练时长为3.5 h。

2.3 参数λ实验

式(5)中的平衡参数λ对计算损失函数具有重要意义,故评价不同λ取值情况下,训练和验证阶段的损失函数随迭代次数增加的收敛情况(图5、图6,彩图见封3)。可以看出,随着λ值减小,总损失值(图5a、图6a)和光谱损失值(图5b、图6b)均减小,但λ值较小导致细节损失值(图5c、图5c)较大,为兼顾光谱损失和细节损失,该文选择λ值为1.0。

图5 训练阶段总损失、细节损失和光谱损失曲线

图6 验证阶段总损失、细节损失和光谱损失曲线

进一步引入相关系数CC、均方根误差RMSE(评价融合结果的光谱质量)、空间相关系数sCC[19](评价融合图像与SAR图像空间细节的相似性)和互信息MI[18](评价融合图像与源图像的相似程度),定量评价不同λ取值对于融合结果在空间信息改善和光谱保持方面的影响。由表3可以看出:随着λ值减小,CC、RMSE和MIMF结果较好,表明融合图像中包含更多的MS图像信息且MS图像的光谱信息保持较好,但sCC、MISF减小,表明融合图像中包含更少的SAR图像信息且SAR图像的细节信息保持较差,与图5和图6分析结果一致。当λ取值1.0时,CC、RMSE次优,光谱能基本保持,同时sCC增大,能注入更多的SAR图像细节信息,这时融合图像能兼顾光谱保持和细节提升。

表3 不同λ实验结果对应的指标

2.4 特征图可视化

为验证网络框架的有效性,深入分析网络的细节特征提取和特征融合效果,将SAR和MS图像提取的纹理特征图以及融合后的特征图进行可视化,图7为编码器阶段多尺度提取块中3×3卷积核尺度下输出的部分深层特征图,通道数为20。从所有通道特征图可以看出:SAR和MS图像的深层特征得到融合;从第18通道的深层特征图可以看出:SAR图像深层特征图中的局部特征清晰(左部分的耕地和右部分的岛屿轮廓),使得融合后特征图在这些局部区域的细节信息得到增强。

注:φMSi、φSi分别表示MS和SAR提取的纹理特征图,φFi表示融合后的特征图;数字表示特征图的序号。

2.5 不同融合方法比较

为验证本文算法在光谱保持和纹理提升方面的有效性,与传统算法IHS[21]、wavelet、IHS_NSST_SR[22]、NSCT_AVG[6]及深度学习算法RSIFNN[11]进行比较,对比算法的参数全部按照原始论文中的参数设置。

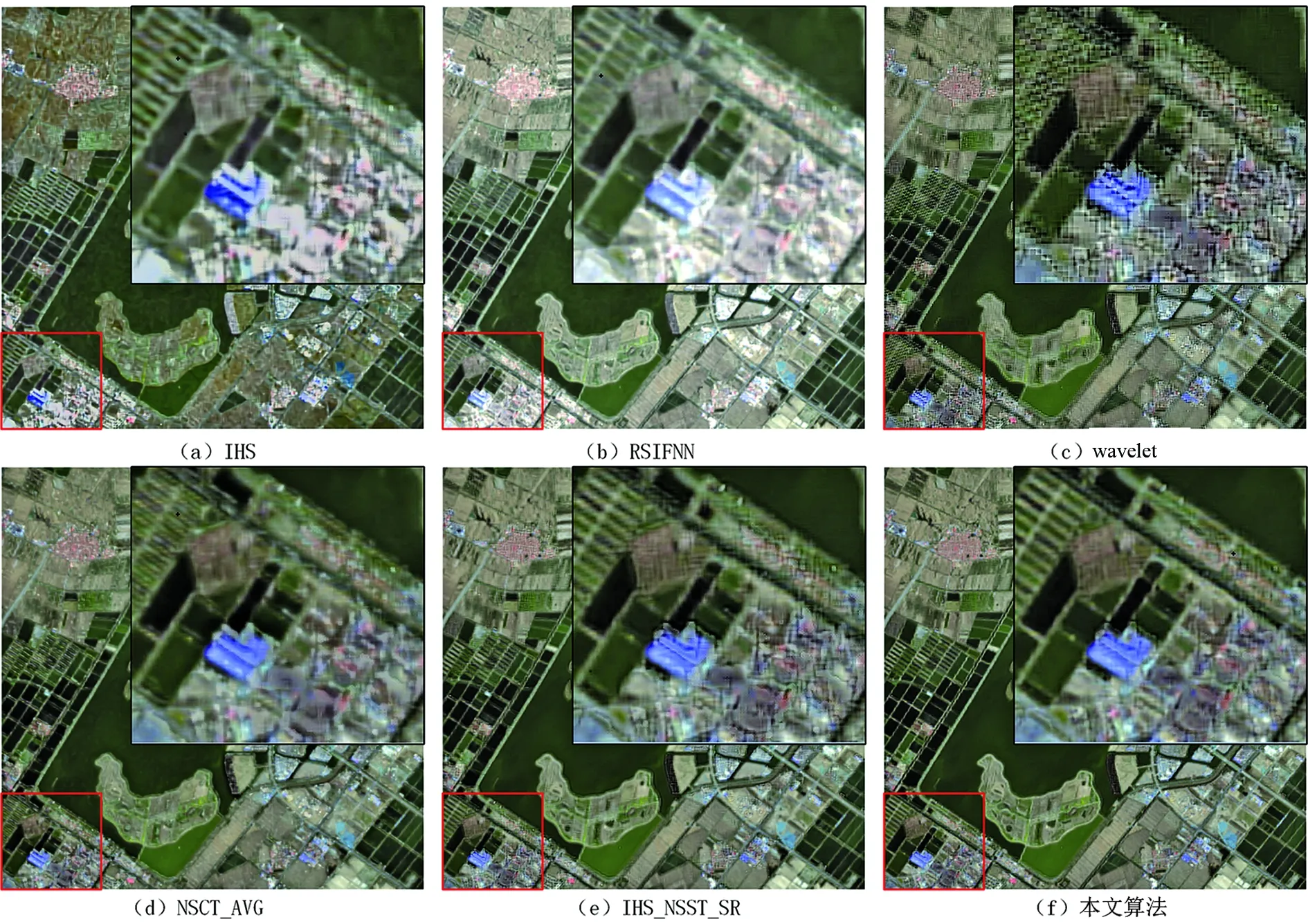

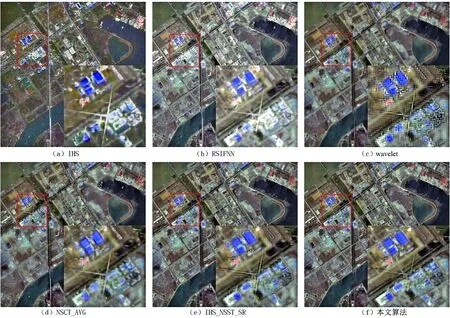

2.5.1 定性评价 由融合结果(图8)可以看出,相比原始上采样的MS图像,所有方法融合图像的空间细节都有所提升,但融合结果有所不同。以第一组实验数据为例:IHS算法(图8a)和RSIFNN融合算法(图8b)显著增强了MS图像的细节信息,但SAR图像细节信息加入过多,导致整体颜色失真,特别是图中岛屿和放大区域的建筑失真更为明显。wavelet、NSCT_AVG、IHS_NSST_SR及本文算法(图8c-图8f)都具有较好的光谱保持能力,但从感兴趣区域看,各方法的空间细节提升程度不同。wavelet方法融合图像细节信息有一定改善,但整体锯齿现象很明显,不利于后期目标结构与轮廓的提取;NSCT_AVG方法的高、低频融合规则选取不具普适性,耕地边界存在伪影,建筑区域细节模糊,融合不自然;IHS_NSST_SR方法在建筑区域纹理整体块状明显,且耕地的边界比本文算法模糊。本文基于多尺度CNN网络有效提取了SAR和MS图像的深层特征,并设计细节损失函数和光谱损失函数监督网络训练,通过学习的方式将SAR图像的细节信息平滑注入MS的各个波段中,在光谱保持和空间细节提升方面,既没有因注入SAR图像细节信息过多而产生颜色失真,也不存在边缘伪影和纹理呈现块状,融合图像增强了细节信息和目标显著信息(如放大区域两屋顶的边界)。第二组实验数据的融合结果(图9)与上述结果基本相同。

2.5.2 定量评价 进一步选取CC、RMSE、峰值信噪比(PSNR)和结构相似性(SSIM)[18](二者用于评价融合结果的空间细节质量)、相对平均光谱误差ERGAS[22](用于评价融合图像的整体效果)及算法测试时间对不同算法的融合结果进行对比(表4、表5)。从光谱评价指标CC和RMSE可以看出,IHS方法表现最差,表明主成分替换方法对于多源传感器图像融合存在明显的颜色失真;RSIFNN方法提取的SAR图像细节信息过多,也导致颜色扭曲;wavelet和NSCT_AVG方法在光谱质量方面有明显改善,但仍有提升空间;IHS_NSST_SR方法在光谱质量方面表现较好。从空间质量评价指标PSNR和SSIM可以看出,IHS和RSIFNN方法的PSNR较差,表明这两种方法融合结果中存在明显的图像失真;wavelet方法受小波变换方向约束,融合结果呈现锯齿状,在SSIM指标方面较差;NSCT_AVG和IHS_NSST_SR方法在细节信息保持方面有明显改善。从图像空间和光谱质量整体评价指标ERGAS可知,IHS和RSIFNN方法结果较差,源于两种方法中存在颜色畸变和图像失真现象,这与主观评价结果一致;wavelet和NSCT_AVG方法有显著提升,IHS_NSST_SR方法充分结合多分辨率分析和成分替换方法的优势,进一步提升整体评价质量。算法效率方面,IHS方法最简单,所用时间最短;本文算法和RSIFNN方法是深度学习方法,数据集数量和输入训练方式相同,训练时间(3.5 h左右)相当,但二者的测试时间明显小于传统的多尺度分析方法,适合海量卫星遥感数据融合处理。综上,本文算法在保持光谱信息的基础上,有效增强了MS图像的空间细节信息,提升了运算效率。

图8 第一组实验数据的融合结果

图9 第二组实验数据的融合结果

表4 第一组实验数据不同算法的评价结果

表5 第二组实验数据不同算法的评价结果

3 结论

为改善传统融合算法中存在的空间细节模糊和颜色失真问题,本文提出一种双分支CNN网络的SAR和MS图像融合算法,其特点为: 1)在网络结构方面,细节提升分支对图像的高频成分进行处理,增强了细节信息,光谱保持分支对MS图像进行上采样,保持和传递了光谱特性;2)在融合算法方面,利用CNN网络对SAR和MS图像的高频信息进行多尺度空间细节特征提取、融合和重建,得到清晰的细节信息,将两分支中的细节信息和光谱信息融合,得到高空间分辨率MS图像;3)在损失函数方面,光谱损失和细节损失能够有效监督网络训练,控制SAR图像细节信息平滑注入,实现光谱保持和空间细节提升之间的平衡。但本文算法只对哨兵-1B和Landsat8两种卫星数据进行了实验,未来可考虑其他SAR和MS实验数据集,以提高算法的普适性。