基于无人机影像与Mask R-CNN的单木树冠检测与分割

2021-03-31黄昕晰夏凯冯海林杨垠晖杜晓晨

黄昕晰,夏凯,冯海林,杨垠晖,杜晓晨

(浙江农林大学信息工程学院,浙江省林业智能监测与信息技术研究重点实验室,林业感知技术与智能装备国家林业局重点实验室,杭州 311300)

对树木的检测、分类、定位以及参数获取一直是林业资源调查的中心任务。传统的林业资源调查方式主要为人工实地考察测量和基于遥感影像进行影像目视解译这两种:前者需要耗费大量的人力物力、且精度由于人为因素难以得到保证[1-2];后者受分辨率以及云层影响,通常难以满足中小尺度区域的林业调查,且目视解译过程中往往需要比较大的时间成本[3-4]。虽然近年来激光雷达LiDAR在获取各项树木参数方面取得了不错的效果,但LiDAR传感器价格昂贵且数据处理过程复杂,与遥感影像相比成本较高[5]。

相比较于卫星遥感,无人机遥感因具有高分辨率、高时效性以及影像获取便捷等优势而作为一种新遥感影像获取途径被逐渐应用于林业资源调查中[6-8]。例如:刘文萍等[9]以银杏和梧桐为例,提出了基于无人机正射图像分析的胸径预测方法,为中小尺度林地调查提供了技术支撑;于东海等[10]对目标树木进行无人机倾斜摄影获取多角度航空影像从而测算树冠体积,为单木树冠几何参数的提取提供了参考;陈崇成等[11]使用无人机影像匹配点云数据对罗汉树和桂花树进行了单木冠层三维分割,得到了精度可靠的分割结果。以上研究均表明,无人机遥感技术在单木树冠的参数提取方面已得到应用,但从时间成本考虑仍缺乏快速提取相关树冠参数的手段。因此如何从遥感影像中快速准确地对城市中的树冠进行检测以及获取参数信息仍是目前城市林业资源调查领域研究的重点。

近年来,以卷积神经网络(convolutional neural network,CNN)为代表的深度学习技术高速发展,通过大量的数据训练以学习图像深层次的特征,其在图像识别、分类以及分割等各个领域都取得了良好的效果,同时在遥感领域的应用也逐渐展开。李梁等[12]使用改进特征金字塔以及在线困难样本挖掘策略优化Mask R-CNN算法后应用于航拍灾害的检测中,实现了对不同场景下各种灾害类型快速准确检测,为检测图像中存在目标尺寸大小不一和网络模型精度较低的问题提供了解决思路。李森森等[13]针对高分辨率图像在目标检测与分割中存在的特征提取困难和检测率较低的问题,利用分层跳连融合方式和设计自适应感兴趣区域改善图像特征提取,提高了遥感图像中多目标检测和分割的准确率。Weinstein等[14]使用半监督学习神经网络对遥感图像中的单个树冠进行检测,即利用一些标注数据和一部分未标注样本进行训练,以克服深度学习中训练数据缺乏的问题。以上研究均在不同程度上将深度学习算法与不同领域内容相结合,且通过不同途径使相关深度学习算法更适用于其领域,但将无人机遥感影像与深度学习算法结合应用于树冠检测与分割研究的尝试还比较少,因此如何将相关深度学习算法应用于树冠检测与分割领域仍然值得探究。

本研究使用无人机遥感技术获取银杏(Ginkgobiloba)遥感树木影像,将无人机影像数据作为训练数据集,并使用Mask R-CNN算法结合正射影像图对城市中不同场景下的银杏树木进行检测与分割并获取相关树冠参数,探究一种基于无人机影像与 Mask R-CNN算法相结合而快速准确地对银杏树木进行检测和获取相关参数的方法。

1 材料与方法

1.1 研究区域

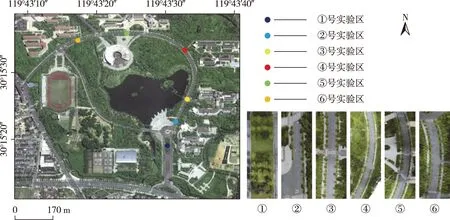

研究区域位于杭州临安浙江农林大学东湖校区内,地理坐标位于30°15′10″~30°15′30″N,119°43′10″~119°43′40″E。校园内银杏大道两侧分布了大量的银杏树木为研究提供了良好的数据来源。将银杏大道分为6个实验区域,选取②③④⑥号实验区以及①与⑤号实验区的一部分作为训练数据,①与⑤号实验区的剩余部分作为检验数据检测网络模型适用性,研究区域和实验区分布见图1。

图1 研究区域和实验区分布Fig.1 Distribution of the study area and experiment area

1.2 无人机影像

本研究的影像数据获取时间为2019年6—7月,在天气晴朗、风力较小的环境下使用大疆Inspire 2四旋翼无人机搭载大疆Zenmuse X5S云台相机进行数据采集。其中,云台所搭载的相机镜头规格为DJI MFT 15 mm,有效像素可达到2 080万,所获取的原始图片像素为5 280×3 956。采集时间一般设定在正午,以减少树冠阴影对后续预处理过程中正射影像图制作的影响;并在DJI GO 4软件中设置程序自动曝光模式与曝光补偿,结合过曝提示功能可以有效防止影像产生过曝现象。本实验设置航高30 m,航速约2 m/s,拍照间隔2 s,旁向重叠率与航向重叠率均为90%以获取具有一定重叠度的银杏树木无人机影像。

1.3 数据预处理

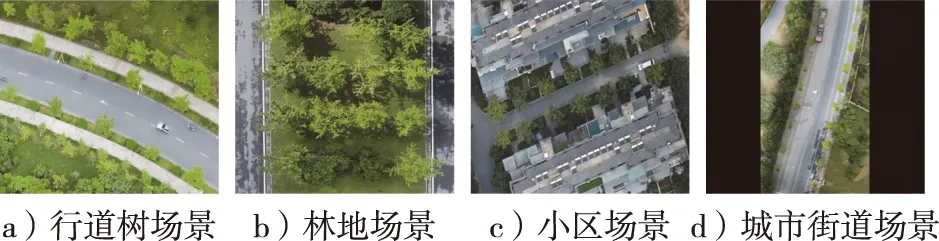

1.3.1 正射影像图

为了准确测量银杏树的冠幅与树冠面积,本研究使用俄罗斯Agisoft LLC公司生产的Agisoft Metashape 1.5.1软件对无人机影像进行预处理,输入带有地理位置坐标的无人机影像图生成数字正射影像图(DOM)。图2展示了本实验中用于验证模型适用性与预测精度所使用的4张正射影像图:a图由研究区域⑤号实验区的358张无人机影像图生成的行道树场景,与训练数据场景相似,除了拥有两侧行道树外,内侧拥有更复杂的树冠排列结构;b图由研究区域①号实验区218张无人机影像图生成的林地场景,其树冠间距较短,但排列整齐有序,适用于林业资源调查;c图由94张无人机影像图生成的小区场景,拥有包括建筑物等其他比较复杂的背景;d图为416张无人机影像图生成的城市街道场景,其含有其他不同种类的植物以及车辆和其他街道在内更为复杂的背景,但两侧排列间距较大,比较容易区分。同时,这4种场景也包含了城市中几种典型的环境背景,作为用于模型验证的检验数据具有一定的代表性。

图2 测试区域正射影像图Fig.2 Orthographic images of test area

1.3.2 数据标注

为制作银杏树冠检测与分割的网络训练模型,本实验选取②③④⑥号实验区以及①与⑤号实验区的一部分作为训练区域。在上述飞行参数旁向与航向重叠率均设置为90%而产生一些具有不同角度银杏树冠影像的情况下,使用图像标注程序Labelme3.3.6对89张无人机银杏影像里的350余棵银杏树目标进行多角度树冠轮廓标注,并将标注生成的json文件整合后加入网络模型训练数据集,以使网络模型更好地学习银杏树冠的图像特征。

1.4 树冠参数提取

本实验使用由美国环境系统研究所开发的ArcMap10.2软件对测试区域遥感影像进行目视解译以测量银杏冠幅与树冠面积的实测值。这种测量实际值的方式避免了实地测量中人为因素造成的误差影响,且在已有遥感影像图的情况下更为便捷。4个测试区域在ArcMap10.2软件中手绘出的边框与轮廓见图3所示。

图3 目视解译Fig.3 Visual interpretation

根据冠幅(树木南北和东西方向宽度的平均值)与树冠面积(树冠垂直投射在地平面上的面积)的定义,其中红色方框周长的1/4倍为冠幅值,黑色轮廓的面积为树冠面积值(图3)。测试区域实测树冠参数统计结果见表1。

表1 实测树冠参数统计Table 1 Statistics of measured crown parameters

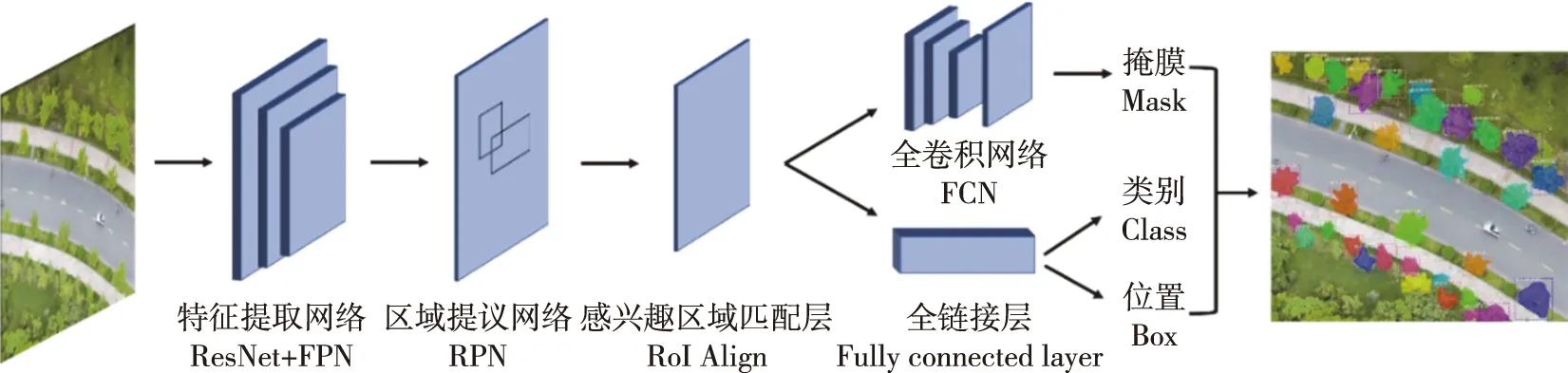

1.5 Mask R-CNN算法

Mask R-CNN是何凯明博士于2017年基于Faster R-CNN提出的目标检测和分割网络[15],其在Faster R-CNN基础上添加了一个mask预测分支,在进行矩形框目标检测的同时可以实现像素级的实例分割;并使用感兴趣区域匹配层RoI Align(region of interest align)代替感兴趣区域池化层RoI Pooling(region of interset pooling)以解决RoI Pooling两次量化过程中造成的候选框不匹配问题,提升候选框的精度;同时使用残差网络ResNet与特征金字塔网络FPN(feature pyramid network)结合更准确快速地进行特征提取,大大提升了检测性能[16-18]。

Mask R-CNN可以分为两部分:第一部分由Faster R-CNN组成,其执行从输入图像中提取特征图交付给区域生成网络RPN,由RPN扫描特征图并查找包含检测目标可能性较高的区域作为感兴趣区域(RoI),再通过RoI Align层统一候选框的尺度,最终使用全连接层对目标进行检测获得类别、位置和大小信息;第二部分则为Mask分支,由全卷积网络FCN组成,相较于传统卷积神经网络CNN,其在网络的末端卷积层进行反卷积将因通过多次卷积和池化后而变小的图像恢复到原始图像的大小,使得图像中每个像素都产生了一个预测达到了像素级别的分类来实现目标分割[19-20]。图4为研究使用的Mask R-CNN网络模型示意图。

图4 Mask R-CNN网络模型Fig.4 Mask R-CNN network model

2 结果与分析

2.1 实验及环境

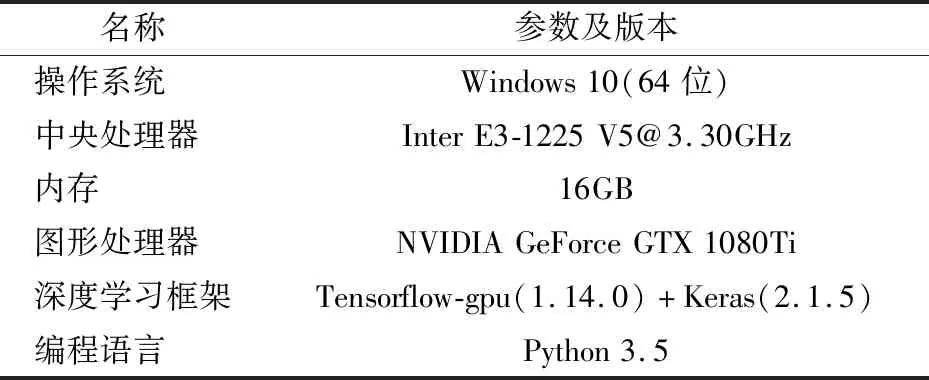

良好的网络模型通常需要大量的训练数据集以及长时间的迭代学习。本研究通过迁移学习的方式借助Microsoft coco数据集的预训练网络模型[21],将制作的带有标注文件的无人机影像加入数据集,从而使网络模型适用于无人机影像中银杏树木的目标检测与分割。在开展训练的过程中,设置epoch为12,每个epoch训练1 000步,总计12 000 步,在表2所列出的实验环境下训练时间约16 h。

表2 实验环境配置Table 2 Experimental environment configuration

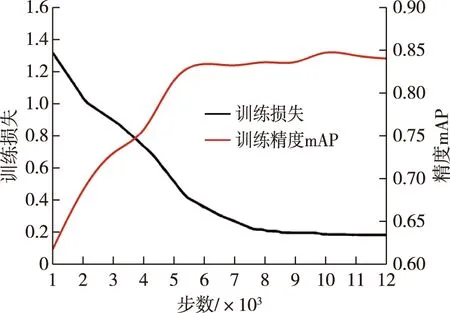

在训练过程中分别记录损失与平均精度均值(mAP),统计结果如图5所示。从图中可以看到,随着模型训练的不断深入,平均精度均值(平均精度均值计算方法见2.2节)与损失值逐步趋于稳定,说明模型已接近收敛。而相较于损失值为类别损失与坐标损失之和的目标检测,拥有Mask分支进行实例分割的Mask R-CNN的损失值还需加上掩膜损失[22]。计算公式如下:

L=Lclass+Lbox+Lmask

(1)

式中:L为总体损失值;Lclass为类别损失值;Lbox为坐标损失值;Lmask为掩膜损失值。

图5 模型训练损失与精度图Fig.5 Model training loss and accuracy diagram

2.2 实验结果

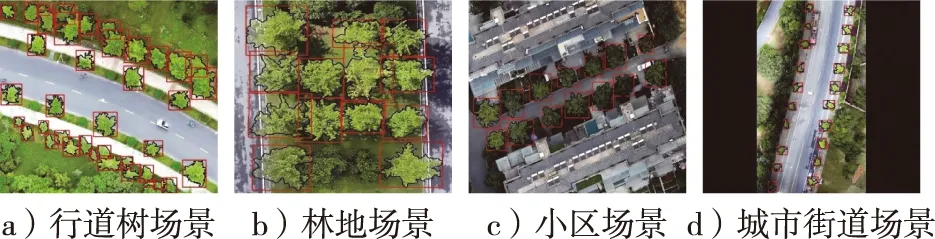

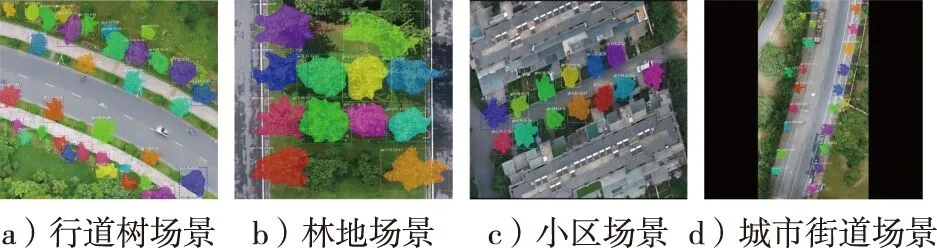

根据前面所述冠幅和树冠面积的定义,为了更好地体现研究对于林业资源调查的实际意义,本研究选用正射影像图作为测试数据,以对树冠进行检测与分割后提取冠幅与树冠面积值。同时,为了验证网络模型的普适性,本实验选取了4片不同场景类型的测试区域,分别为研究区域行道树场景、林地场景、小区场景以及城市街道场景。图6展示了不同场景下的网络模型测试结果。从图6可以看到,在大部分情况下对于银杏树冠位置能得到良好的检测结果,对于银杏树冠轮廓的勾绘也能获得较好的分割效果。

图6 检测与分割结果Fig.6 Detection and segmentation results

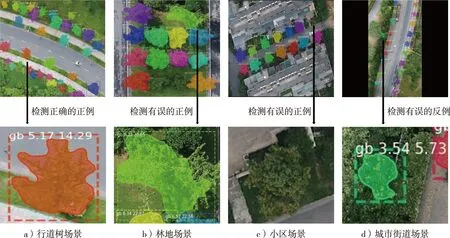

图7 检测与分割结果说明Fig.7 Description of detection and segmentation results

为了验证检测与分割结果的准确性,本研究使用交并比IoU(intersection over union)作为树冠检测与分割是否正确的依据,设置IoU阈值为0.5,即当IoU≥0.5时标记为正确检测的结果,当IoU<0.5时标记为错误检测的结果,IoU的计算公式如下:

(2)

式中:G(groundtrue)表示真实树冠像素区域;P(prediction)表示预测树冠像素区域。

此外,本研究采用查准率Pc(precision)、查全率R(recall)、F1-score、平均精度Pa(average precision)以及平均精度均值mAP(mean average precision)对网络模型的检测与分割结果进行评估[23],Pc、R、F1-score与mAP的值越高,代表检测与分割结果越准确。相关公式如下:

(3)

(4)

(5)

(6)

(7)

式中:Pt表示检测正确的正例,即树冠检测结果与真实情况相符;Nf表示检测错误的正例,即树冠真实情况未被正确检测;Pf表示检测错误的反例,即树冠检测结果与真实情况不符;C表示类别数,由于本研究针对单一银杏树种进行检测分割,所以类别数C为1,即平均精度与平均精度均值相当。

虽然4个不同场景的整体检测效果较好,但仍有一些错检和漏检情况出现。统计结果表明,在共计86个银杏树冠检测目标中,正确检测78个,出现漏检8个(树冠之间产生重叠现象、树冠颜色与其他树冠偏差过大、路灯等物体遮挡或是树冠面积过小等),错检4个(背景物体或植物与银杏树冠形状颜色非常相似)。以此结果进行各项评价指标的计算。图7展示了一个检测正确的结果以及一些错检漏检情况。从图7中可以看到,检测与分割结果包含了类别(gb代表银杏树)、定位坐标(中间数字段代表通过坐标计算出的树冠冠幅值)以及分割轮廓(最后数字段代表通过统计像素个数计算出的树冠面积值)信息。

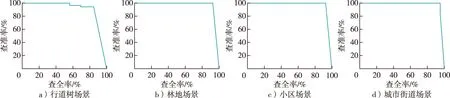

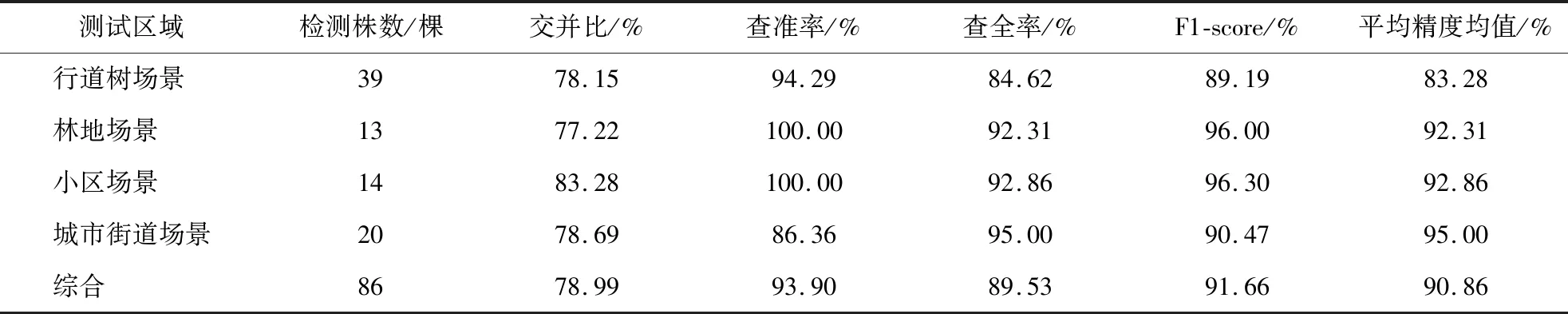

图8展示了4个不同场景的测试区域的查准率-查全率曲线,表3为对应的检测结果。从表3可以看出,总体的交并比为78.99%,查准率达到了93.9%,召回率达到89.53%,F1-score与平均精度均值mAP值分别为91.66%与90.86%。说明整体的预测准确率较高,训练所得网络模型可以对城市中不同场景下的银杏单木树冠进行良好的检测。

图8 查准率-查全率曲线图Fig.8 Precision-recall curve

表3 检测结果Table 3 Test results

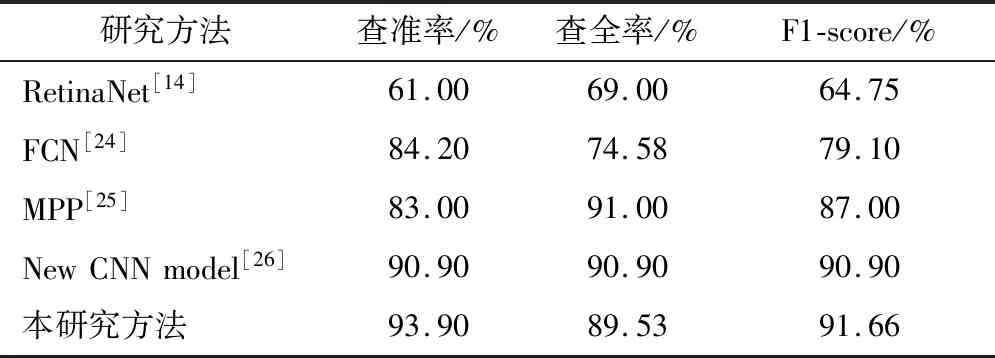

根据相关文献资料对近期树木检测研究结果进行对比,结果见表4。从表4可以看到,本研究查准率较高,而查全率虽然略微低于个别研究,但总体检测精度F1-score较高,说明本研究的方法可以较好地适用于树木检测。

表4 相关研究方法结果对比Table 4 Comparison of related research methods

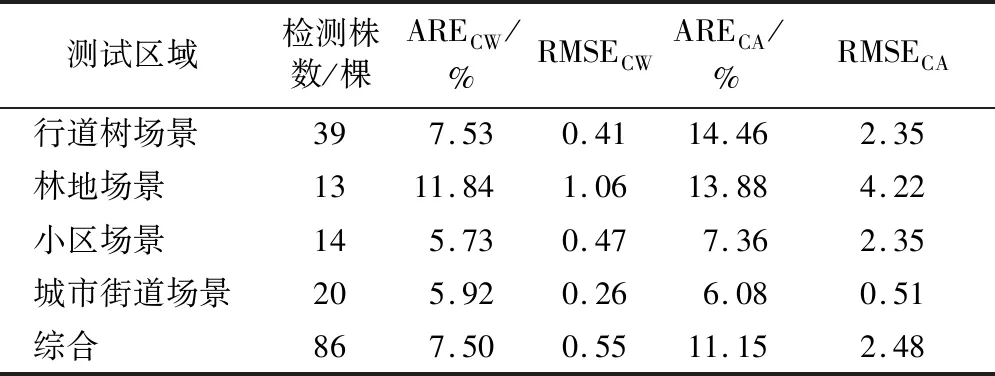

2.3 树冠参数精度评价

为了验证预测结果的可靠性,将所得实测值与预测银杏冠幅与树冠面积做比较,使用平均相对误差(ARE,式中记为EAR)与均方根误差(RMSE,式中记为ERMS)评价预测精度,ARE与RMSE越小,代表预测偏差越小,预测精度更高。相关公式如下:

(7)

(8)

根据图8统计得预测冠幅值与树冠面积,将之与目视解译所得实测冠幅值与树冠面积值作比较,计算各项精度指标如表5所示。可以发现冠幅(CW)的总体平均相对误差为7.5%,均方根误差为0.55,说明预测精度较好。树冠面积(CA)的总体平均相对误差为11.15%,均方根误差为2.48,虽然不如冠幅的预测精度,但考虑到树冠树梢的复杂性与多样性,这也达到了不错的预测效果。

表5 预测精度对比Table 5 Comparison of prediction accuracy

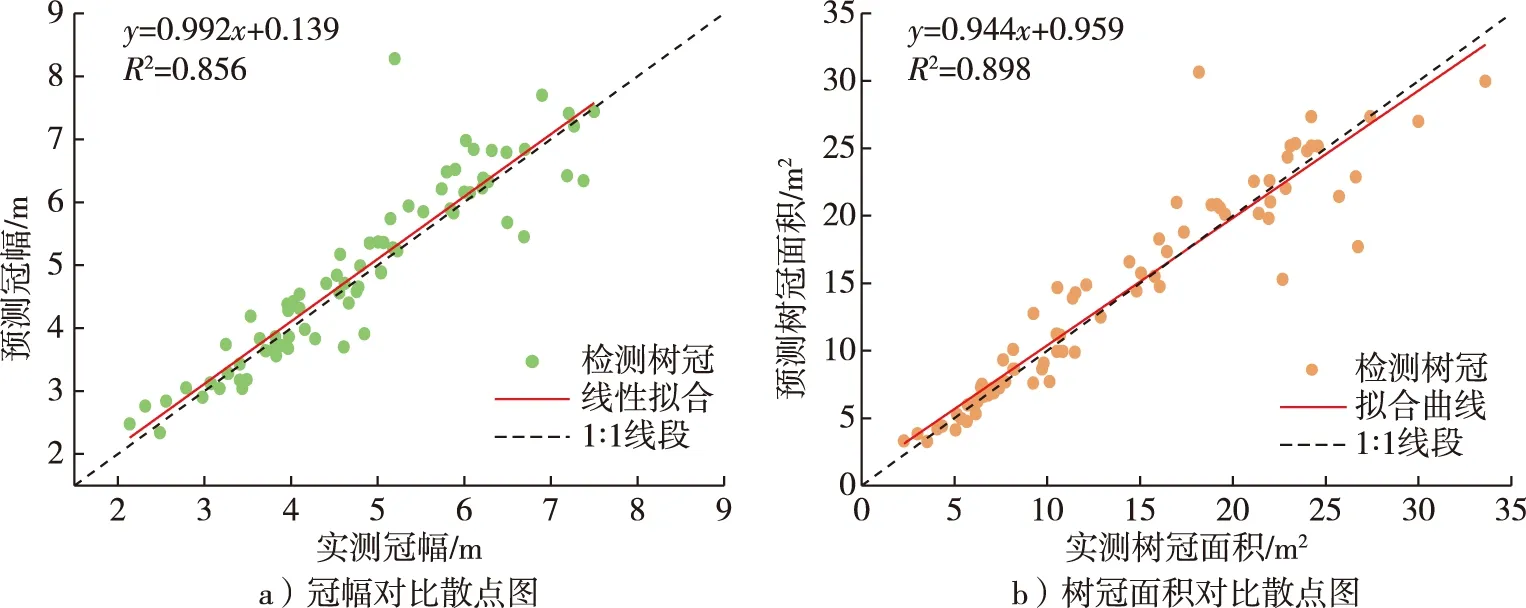

根据实测与预测的银杏冠幅与树冠面积,制作实测值与预测值分布关系图如图9。由图9可见,实测冠幅与预测冠幅的拟合决定系数R2达到0.856,实测树冠面积与预测树冠面积的拟合决定系数R2达到0.898。除极个别检测有误的异常点外,大部分散点均匀分布在1∶1线段两侧,且两根红色拟合线段均与1∶1线段接近,代表预测值接近实测值。

图9 实测值与预测值对比Fig.9 Comparison of measured values and predicted values

3 结 论

1)本研究将深度学习中的Mask R-CNN算法应用于无人机高分辨率影像的银杏单木树冠检测与轮廓描绘,总体F1-score与平均精度均值达到了91.66%与90.86%,取得了不错的检测与分割效果,且快速准确地获取了城市中不同场景下银杏树冠的冠幅与树冠面积,冠幅与树冠面积的预测决定系数R2分别达到了0.856与0.898,得到了较为精准的树冠参数结果,为树木资源评估提供了一种快速高效的解决方案。

2)使用无人机影像与Mask R-CNN算法结合获取树冠参数,不仅适用于银杏树冠,同样适用于城市中其他种类的树冠,特别是对于排列整齐的行道树检测效果较好。

3)无人机遥感与深度学习技术对于树冠的检测与分割目前仍处于探索阶段,实际研究中也同样存在一些问题与困难。因受时间和实验地点等条件的限制,本实验还存在一些错检和漏检现象。而且目前仅针对单一银杏树种进行检测,在今后研究中将着重考虑针对无人机树冠影像进行网络模型改进以及多树种的情况,更加有效地提取城市中树冠冠幅与树冠面积。