基于多传感融合的目标跟踪方法研究

2021-03-22刘志强张光林邱惠敏

刘志强,张光林,邱惠敏

(1.江苏大学 汽车与交通工程学院,江苏 镇江 212013;2.公安部交通管理科学研究所,江苏 无锡 214106)

对于先进驾驶员辅助系统(ADAS)和自主驾驶来说,单一传感器越来越不能满足人们对日益复杂的交通环境的安全要求[1],因此,基于多传感器融合的车辆避撞方法研究受到越来越多的关注。常见的环境感知传感器包括毫米波雷达、摄像头和激光雷达。摄像头价格低,可用于对目标进行分类,但很容易受到环境条件的影响,并且摄像头的测距精度很差。毫米波雷达具有较高的测距精度,受环境条件影响不大,但其角度分辨率较差,容易出现虚警。激光雷达的测量精度很高,利用它可以精确地获得目标的三维信息,然而较高的成本限制了其商业应用。

由于车辆的运动状态是一个非线性系统[2],传统的融合算法如“卡尔曼滤波[3-4]”“信息矩阵算法[5]”和“加权法[6]”只能处理线性系统,在非线性系统中就不再适用。为了处理非线性系统的状态估计,国内外专家提出了一些估计算法,如“扩展信息滤波(EIF)[7]”“无迹信息滤波(UIF)[8-9]”“联合概率数据关联算法(JPDA)[10-11]”等。EIF和UIF均忽略了泰勒级数展开的高级项,使截断误差对目标的局部估计产生较大影响,JPDA的联合事件数随着检测密度的增加而迅速增加,导致计算载荷出现组合爆炸现象[12]。

基于此,采用无人驾驶数据感知环境的典型配置[13]——毫米波雷达与摄像头组合方式对目标进行数据采集,并提出了基于GNN-DS的数据融合算法。利用全局最近邻算法(GNN)对目标量测信息进行数据关联,减少关联杂波对跟踪目标的影响,利用D-S证据理论对雷达和摄像头的量测数据进行组合优化,得到更精确的目标状态信息,保证系统对车辆目标的检测精度。

1 多传感器融合算法架构

摄像头和毫米波雷达传感器提供有效的车辆状态数据:毫米波雷达提供车辆位置和纵向速度数据(x,y,vy),摄像头提供车辆位置、大小和类型数据(x,y,width,type)。在融合中心对采集的车辆状态数据进行融合,获得完整的目标车辆信息(x,y,vy,width,type)。

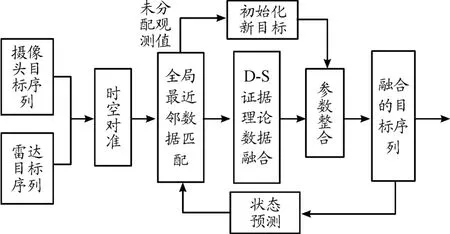

本文建立的融合模型在获得毫米波雷达和摄像头的目标状态数据后,按3个步骤展开(图1):

图1 融合算法流程框图

1)雷达和摄像头时空对准 由于毫米波雷达和摄像头的空间坐标系和采样周期不同,导致采集到的数据不在同一时空,因此需要在时空上进行对准。

2)多传感器数据匹配问题 由于雷达和摄像头对跟踪目标的探测精度存在差异,导致2个传感器探测到的感知目标与跟踪目标发生偏离。因此,采用全局最近邻算法(GNN)对雷达和摄像头获得的量测值与目标源进行数据匹配,确定哪些量测数据是由同一个跟踪目标产生。对于未分配观测值的目标车辆,需要建立一个新目标来初始化跟踪。

3)多传感器融合问题 雷达和摄像头分别探测到的感知对象与目标车辆匹配以后,将两者获得的量测数据进行数据融合,利用D-S证据理论合成公式进行数据融合,得到目标车辆最优的状态估计值。

2 摄像头和雷达的时空融合

2.1 空间融合

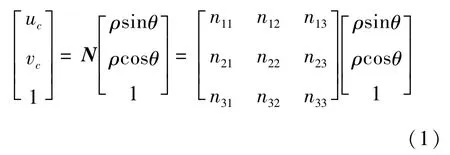

在对目标跟踪之前,需要将摄像头和雷达完成空间对准。摄像头坐标和毫米波雷达坐标如图2所示。

图2 摄像头和毫米波雷达空间坐标系

图2中,OXrYrZr表示雷达坐标系;O′XcYcZc表示摄像头坐标系;O″uv表示图像坐标;θ和ρ分别表示前方车辆相对于雷达的角度和距离;(uc,vc)和(ρ,θ)之间的矩阵变换由式(1)表示:

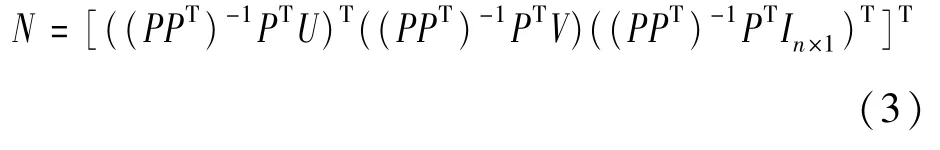

式中:N表示空间转换矩阵。其中前方目标车辆质心可由式(2)表示:

式中:f(u,v)表示像素坐标(u,v)的值。

最小二乘法计算的空间转换矩阵可由式(3)表示:

根据毫米波雷达采集的目标车辆状态数据,应用不同的N值,完成摄像头和毫米波雷达的空间对准。

2.2 时间同步

毫米波雷达和摄像头的采样频率不同,将导致获取的目标信息在时间上的错位。本文选用分段3次样条拟合插值法[14]同步传感器间的信息,如果传感器在某一采样周期完成了n+1次检查,其测量时间点可以化为(t0,t1,t2,…,tn),设f(ti)为ti时刻传感器的量测值,满足f(ti)=yi(i=1,2,…,n),将其组合成拟合插值函数s(t)。由于雷达具有较为稳定的采样频率,固定频率为20 Hz,摄像头的采样频率则会根据样本的数量而发生变化,基于此,本文将雷达的频率设定为基准,对摄像头的量测值建立3次样条函数,即实现了雷达和摄像头数据在时间上的同步。

3 多传感器数据匹配

本文采用全局最近邻算法(GNN)对毫米波雷达和摄像头采集的车辆信息数据与目标源进行数据匹配。

系统对目标车辆的状态估计均采用扩展卡尔曼滤波方法。对系统进行建模:

目标状态方程:

式中:Xi(k)表示k时刻目标i的状态向量;f[·]表示状态函数;v(k)表示协方差;Q(k)为零均值高斯白噪声的过程噪声;F表示f[·]的雅克比矩阵。假设在k-1时目标的状态已知。

雷达和摄像头的观测方程为

式中:Z1,i(k)和Z2,i(k)分别为k时刻雷达和摄像头对目标i的观测向量;h1[·]和h2[·]分别表示毫米波雷达和摄像头的观测函数;w1(k)和w2(k)分别表示毫米波雷达和摄像头的协方差R(k)为零均值高斯白噪声的测量噪声;H1、H2分别表示h1[·]和h2[·]的雅克比矩阵。

3.1 雷达数据匹配

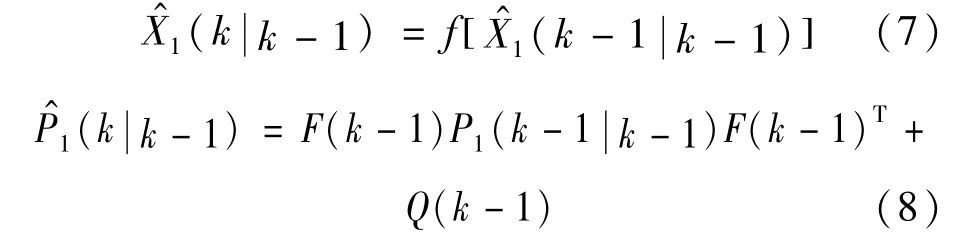

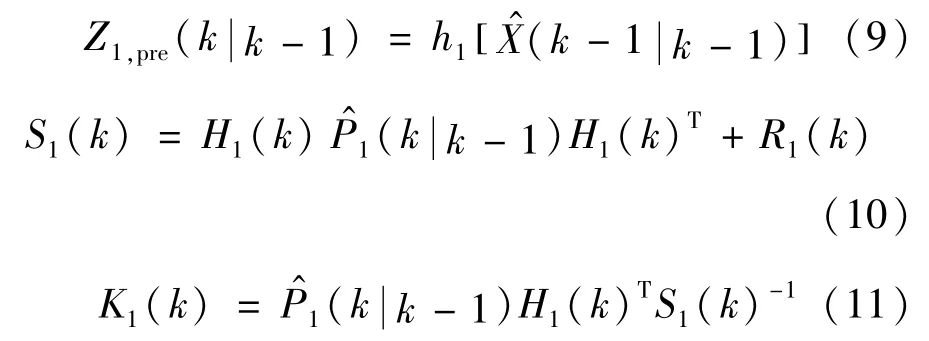

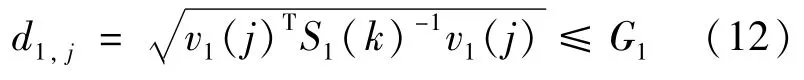

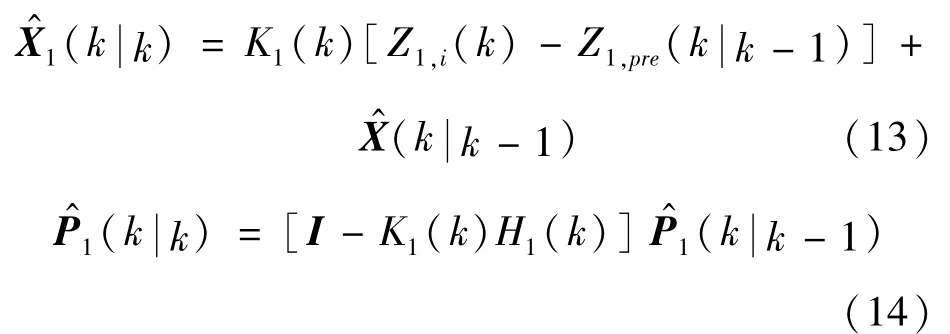

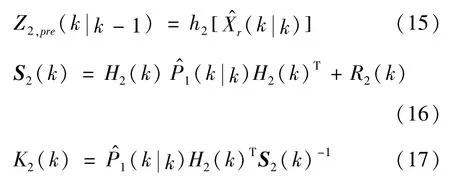

根据k-1时刻给出的目标状态,利用扩展卡尔曼滤波计算 k时刻目标的状态预测值以及预测误差协方差

根据式(7)和式(8)得到的k时刻目标的状态预测值以及预测误差协方差,计算雷达的量测预测值、信息协方差值S1(k)及卡尔曼增益K1(k)。

利用全局最近邻算法(GNN)[15]对k时刻的雷达目标序列与目标源进行匹配。确定雷达量测数据是否落入椭圆跟踪门内,则由椭圆跟踪门规则得到关联区域

将雷达与目标源的匹配量测数据输入到跟踪滤波器中,更新得到协方差矩阵和状态估计向量

式中,I为单位矩阵。

3.2 摄像头数据匹配

将雷达获得的状态估计向量和协方差矩阵作为摄像头的初始状态输入值,然后结合摄像头的量测数据进行预测,获得摄像头的一步预测状态估计 值、预测误差协方差矩阵S2(k)以及卡尔曼增益K2(k)。

同样利用全局最近邻算法(GNN)对k时刻的摄像头量测与目标源进行关联。确定摄像头量测是否落入椭圆跟踪门内,则需要满足的条件为

将摄像头得到的匹配观测值输入到跟踪滤波器中,更新得到其协方差矩阵和状态估计向量

4 基于DS证据理论数据融合模型

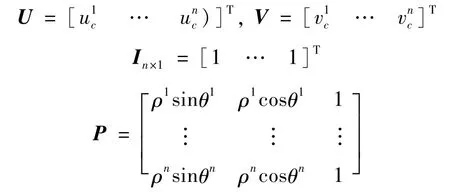

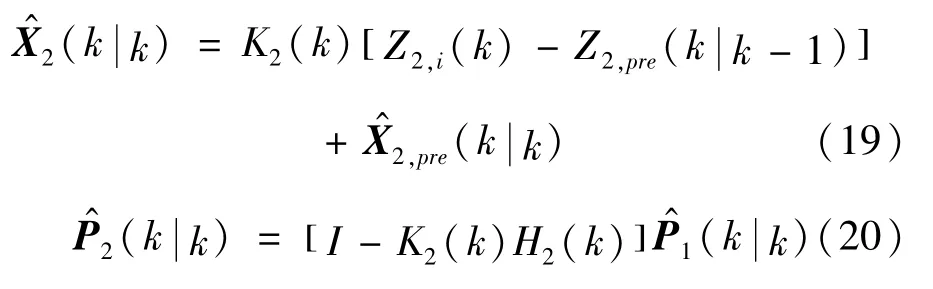

通过全局最近邻算法(GNN)分别对毫米波雷达和摄像头的量测值与目标源进行匹配,融合雷达和摄像头的状态估计值。通过D-S证据理论[16]优化组合雷达和摄像头的局部估计,从而得到目标车辆的最优估计值。

图3示出了D-S证据理论融合的流程框图,雷达和摄像头通过全局最近邻算法(GNN)获得k时刻的目标状态估计值,i=1,2和量测值,i=1,2,通过基本概率分配函数分别计算其概率分配值Ai,i=1,2和Bi,i=1,2,然后将概率分配值输入到融合中心进行融合和目标状态更新。

图3 D-S证据理论融合流程框图

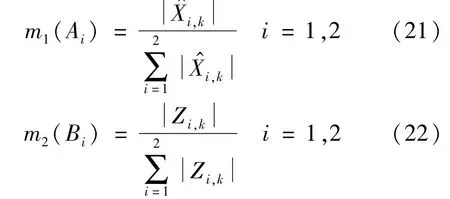

4.1 证据分类

式中:m1(Ai)表示k时刻雷达和摄像头状态预测值的基本概率赋值函数;m2(Bi)表示k时刻雷达和摄像头观测值的基本概率赋值函数。

4.2 获取权重系数

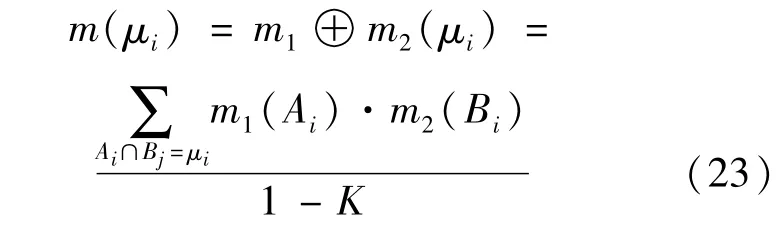

利用式(22)计算的基本概率赋值函数,通过Dempster合成公式计算得到其权重系数μi。

式中:μi为权重系数;为2组证据的冲突函数,其值表示2组量测证据间的相关程度,冲突值越大,说明2组量测证据间的相异性越大,相反,则表示2组量测证据间的相关性越大[17]。因此,对量测证据的数据融合可以按照实际情况来修改,从而得到融合后的权重系数μi。

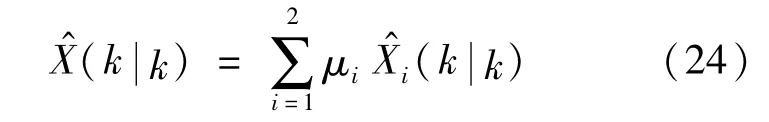

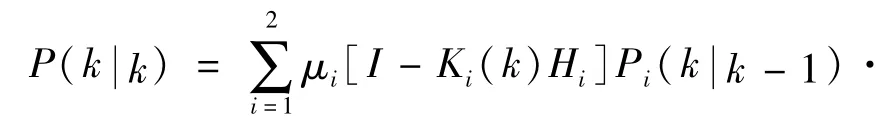

4.3 状态更新

通过以上得到的权重系数,可以得到综合状态更新方程

协方差更新方程

5 试验验证

在别克凯越轿车搭载德尔福76-77 GHz的ESR毫米波雷达和IFV-300智能摄像头对前方目标车辆进行数据采集(图4),同时利用Matlab中的可视化模块(GUI)和Simulink工具箱联合搭建目标车辆追踪验证平台[18](图5)。

图4 试验车辆及主要仪器安装示意图

图5 前方车辆识别验证平台示意图

为了更好地验证该融合算法,选定上午10∶00—12∶00进行实验,避免车辆高峰期时对试验造成不必要的影响,选取镇江市金港大道路段作为试验场地验证融合算法,实验路线如图6所示。

图6 实验路线

图7显示了采集的一段时间内目标车辆的横、纵向距离的状态估计结果。

图7 横、纵向距离状态估计结果

通过图7的融合轨迹可以看出,该融合算法可以得到较好的状态估计值,能够实时检测前方目标车辆,测量精度相对于单一传感器有了很大改善,有助于提高车辆的主动避撞性能。

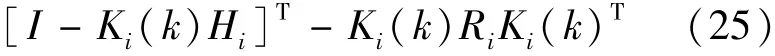

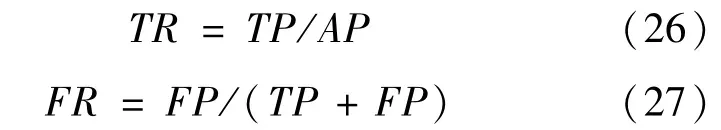

为了更好地验证该融合算法的准确性,应用目标跟踪领域的检测率(detection rate,DR)和误检率(false detection rate,FR)直观地展示该融合算法的检测精度[19],其表达式为

式中:TP表示融合算法检测出的车辆数;AP表示实际道路中的车辆总数;FP表示融合算法误检为车辆的数目。

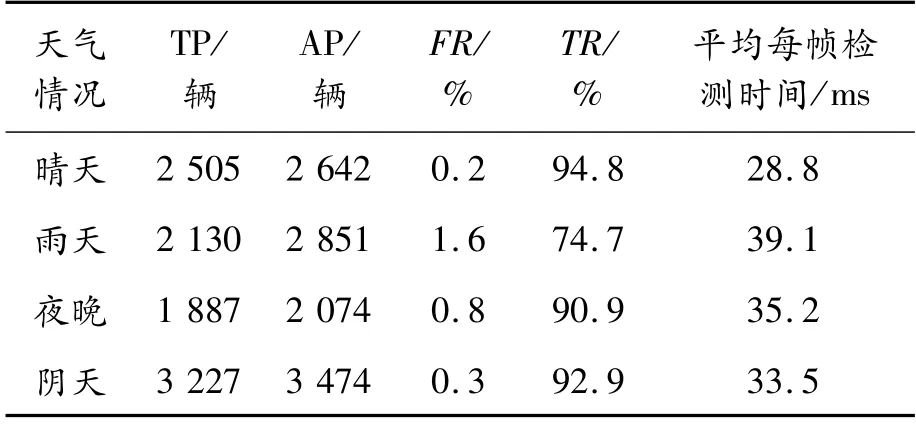

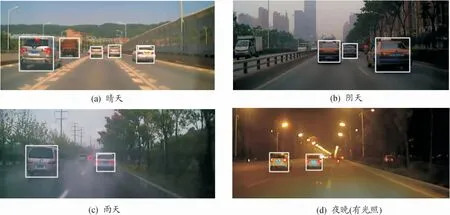

通过对不同天气情况(晴天、阴天、雨天、夜晚(有光照))下采集的4 910帧图像进行算法验证(表1)。

表1 不同天气情况下的车辆检测结果

从表1中可以看出,在视线良好的天气环境中,该融合算法可以有效地识别目标车辆,在晴天、阴天和光照良好的夜晚3种天气情况下,融合算法对目标车辆的平均检测率为92.8%,FR仅为0.4%,缩短了对每帧图像的运算时间,平均为32.5 ms/帧,满足系统对实时性的要求。图8为融合系统对前方车辆的检测结果。

图8 不同天气情况下的检测结果

6 结论

1)针对单一传感器前方目标车辆识别准确率低的问题,综合考虑成本和车载传感器特点,提出了一种基于毫米波雷达和摄像头进行信息融合的目标识别方法。

2)针对复杂环境下对目标车辆漏检和误检的问题,选择基于全局最近邻算法(GNN)对目标进行数据关联,并建立基于D-S证据理论算法对雷达和摄像头的局部估计值进行组合优化,得到目标车辆状态信息的最优估计值。

3)该融合算法在对目标车辆的横、纵向距离的状态估计方面较单一传感器有了明显改善,并且在不同天气条件下的平均检测率为88.3%,平均误检率为0.73%,有效地提升了检测准确率,实现了对动态目标的识别和跟踪。