面向对抗样本攻击的移动目标防御

2021-02-27王滨陈靓钱亚冠郭艳凯邵琦琦王佳敏

王滨,陈靓,钱亚冠,郭艳凯,邵琦琦,王佳敏

面向对抗样本攻击的移动目标防御

王滨1,2,3,陈靓1,钱亚冠1,郭艳凯1,邵琦琦1,王佳敏1

(1. 浙江科技学院大数据学院,浙江 杭州 310023; 2. 浙江大学电气工程学院,浙江 杭州 310058;3. 海康威视数字技术有限公司网络与信息安全实验室,浙江 杭州 310058)

深度神经网络已被成功应用于图像分类,但研究表明深度神经网络容易受到对抗样本的攻击。提出一种移动目标防御方法,通过Bayes-Stackelberg博弈策略动态切换模型,使攻击者无法持续获得一致信息,从而阻断其构建对抗样本。成员模型的差异性是提高移动目标防御效果的关键,将成员模型之间的梯度一致性作为度量,构建新的损失函数进行训练,可有效提高成员模型之间的差异性。实验结果表明,所提出的方法能够提高图像分类系统的移动目标防御性能,显著降低对抗样本的攻击成功率。

对抗样本;移动目标防御;Bayes-Stackelberg博弈

1 引言

随着人工智能的发展,基于深度神经网络(DNN)的图像分类技术被成功应用到多种任务中,如手写字体识别[1]、自动监控的对象分类[2]和自动驾驶[3]等。最近的研究表明,DNN存在严重的安全脆弱性,即在输入图像上添加一些精心设计的、不被人眼察觉的扰动,可欺骗DNN错误分类。这种添加了恶意扰动的样本被称为对抗样本[4]。对抗样本的出现限制了DNN在安全敏感领域的广泛应用。为了更好地防御对抗样本,研究人员提出对抗训练防御方法[5],将对抗样本注入训练数据,从而增强DNN的鲁棒性。Madry等[6]将对抗训练建模为最小−最大化对抗博弈,攻击者生成对抗样本最大化损失函数,而防守者在对抗样本存在的情况下最小化损失函数,从而提高模型的鲁棒性。

对抗训练方法需要生成对抗样本对分类模型进行数据增强。与对抗训练防御对抗样本不同,Sengupta等[7]借鉴移动目标防御[8](MTD,moving target defense)的思想,将多个DNN模型构建成基于MTD的图像分类系统,在运行过程中主动切换成员模型,以降低攻击者的攻击成功率,从而增强图像分类系统的鲁棒性。MTD主要是利用特定攻击在不同的成员模型上的攻击差异性,通过随机切换成员模型以增加攻击难度。但该工作的不足是:系统成员模型只使用简单的训练数据划分,选择不同的网络结构和权重参数等方法,本文的实验表明上述方法并不能有效地提高系统模型之间的差异性,因而实际的防御效果不佳。

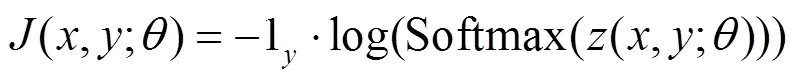

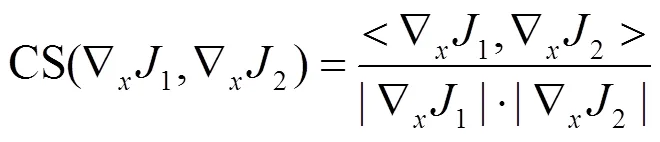

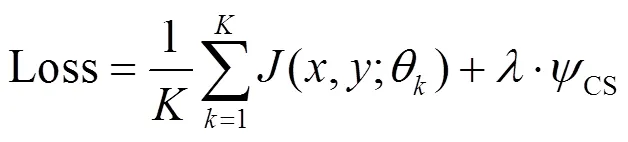

本文围绕如何提高模型之间的差异性这一关键问题,提出了差异性训练方法,利用模型梯度之间的相关性来衡量模型差异性,以进一步改进MTD的性能。为此,构造新的损失函数,在成员模型的平均交叉熵损失的基础上,增加模型差异性对数项,在最小化损失函数的同时,增大成员模型间的差异性。在此基础上,再利用Bayes-Stackelberg博弈,获得模型切换的最佳策略,从而有效地阻止对抗样本攻击。本文提出的改进移动目标防御被称为DT-MTD(differential training MTD),并在ILSVRC2012[9]的竞赛数据集上验证了差异性训练的有效性。实验结果表明,相比于未使用差异性训练的图像分类系统,本文提出的DT-MTD可更进一步提高图像分类系统的鲁棒性。

2 预备知识

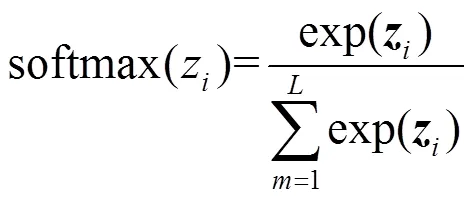

2.1 深度神经网络

2.2 对抗样本和威胁模型

2.3 基于梯度生成对抗样本

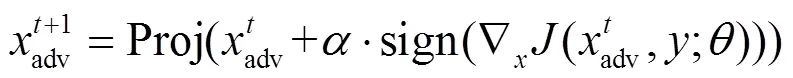

(1)FGSM

(2)PGD

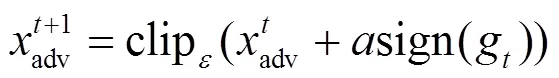

(3)MI-FGSM

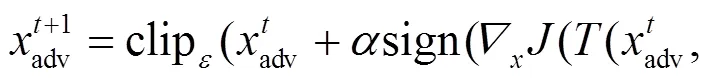

(4)M-DI2-FGSM

3 防御方法

本节介绍本文提出的差异性训练方法,在此基础上利用Bayes-Stackelberg博弈切换DNN,混淆攻击者获得的信息,使其难以选择合适的代理模型,从而提高图像分类系统的鲁棒性。

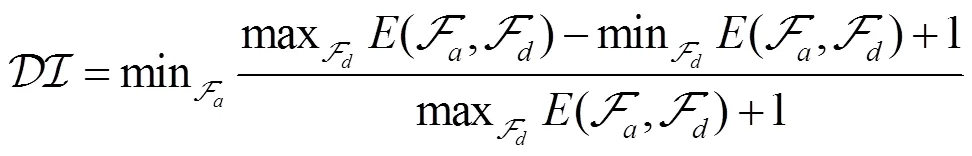

3.1 差异性训练

移动目标防御成功的关键是特定攻击在图像分类系统的成员模型上具有差异性,这种攻击差异性的定义为

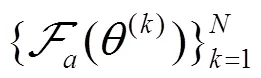

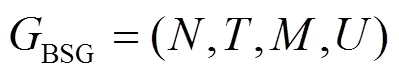

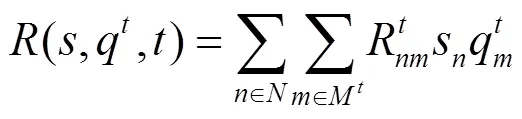

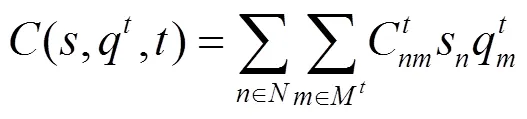

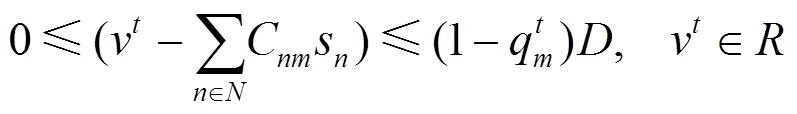

3.2 基于Bayes-Stackelberg博弈的模型切换

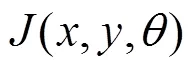

Stackelberg博弈[12]是一种非合作的、有先后次序的决策博弈,参与者包括先采取行动的领导者(leader)以及随后启动的跟随者(follower)。领导者和跟随者各自具有一个行动集合,参与者从集合中选择一个行动形成策略。领导者首先发布一个混合策略,追随者在领导者的策略下优化自身收益,回应一个纯策略。Bayes-Stackelberg博弈是将Stackelberg博弈扩展为多个类型的追随者,适用于信息安全中的博弈建模。把它应用到DT-MTD中,求解得到贝叶斯−纳什均衡,并将其作为最佳的模型切换策略。本文的领导者为图像分类系统的防御者,追随者为用户(包括正常用户和攻击者),防御者和追随者的目标都是最大化自己的收益。

4 实验评估

4.1 实验设置

本文实验使用ILSVRC2012的竞赛数据集,是ImageNet[14]的一个子集。将该数据集中的1.2×106张图像作为训练集,50 000张图像作为验证集,以及150 000张图像作为测试集,包含1 000个类别标注,本文使用训练集训练DT-MTD的成员模型,在测试集上进行验证,攻击者使用测试集生成对抗样本。实验使用带4个NVIDIA GeForce RTX 2080 Ti GPU的服务器,该服务器的操作系统是Ubuntu16.04.6 LTS,使用Python3.6、Ptorch1.2、PuLP2.1实现差异性训练和DOBSS算法的求解。

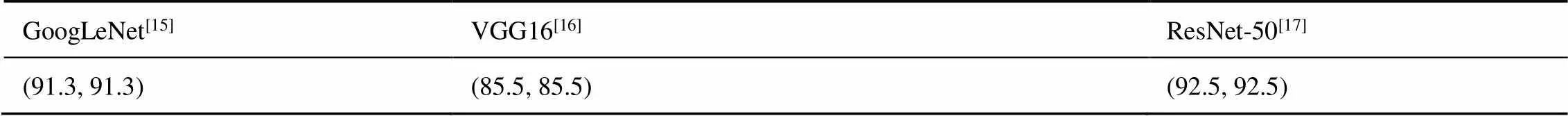

实验中的DT-MTD成员模型结构是{ GoogLeNet[15],VGG16[16],ResNet-50[17]},利用算法1进行差异性训练。表1是防御者与合法用户在ILSVRC2012数据集的测试集上的收益,如表1中的 (91.3, 91.3)表示当防御者使用成员模型GoogLeNet对干净图像进行分类时,防御者的收益和用户收益都是分类准确率91.3%。

算法1 差异性训练算法

6) end for

7) end for

表1 防御者和合法用户的博弈收益

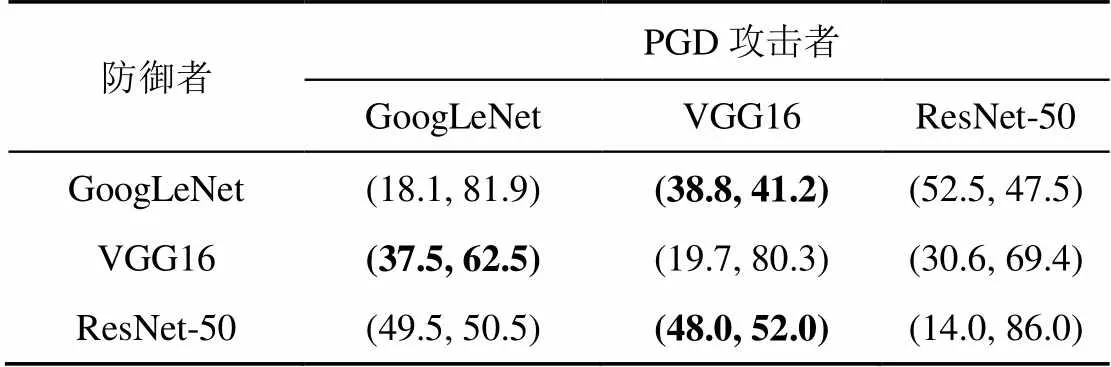

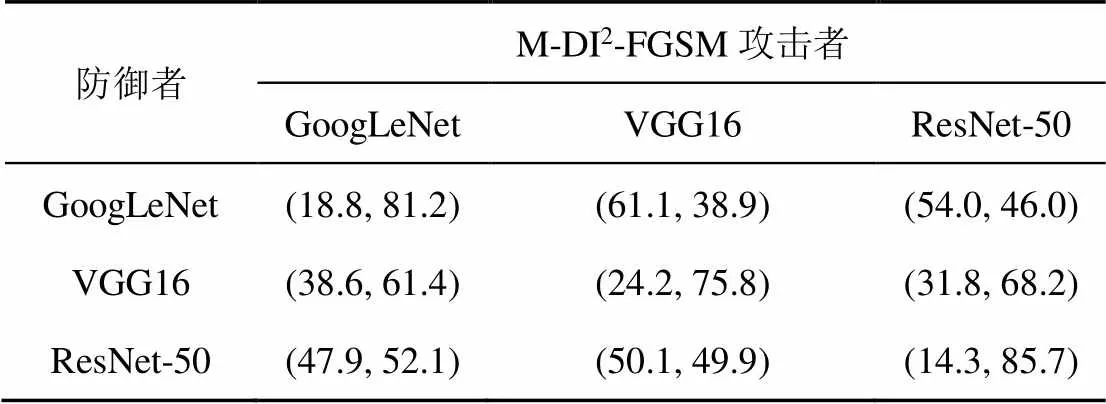

根据假设的威胁模型,攻击者知道DT-MTD的成员模型信息,可以构建出代理模型集合{ GoogLeNet,VGG16,ResNet-50 }。表2~表5是防御者和不同的攻击者(FGSM 、PGD、MI-FGSM和M-DI2-FGSM)之间的收益矩阵。以攻击者使用PGD生成对抗样本为例,表3是防御者与PGD攻击者的博弈收益。表3中数据(37.5, 62.5)表示攻击者在代理模型GoogLeNet上使用PGD生成对抗样本,攻击成员分类模型VGG16时,防御者的收益为对抗样本的分类准确率37.5%,攻击者的收益是对抗样本攻击成功率62.5%。从表3还可以发现基于特定代理模型生成的对抗样本,在不同成员模型上表现出攻击差异性,如表3中的第3列,代理模型VGG16基于PGD生成的对抗样本,对GoogLeNet的攻击成功率为41.2%,而对ResNet-50的攻击成功率为52.0%。这说明使用移动目标防御技术,切换成员模型可以降低攻击者的攻击成功率。

表2 防御者和FGSM攻击者的博弈收益

表3 防御者和PGD攻击者的博弈收益

表4 防御者和MI-FGSM攻击者的博弈收益

表5 防御者和M-DI2-FGSM攻击者的博弈收益

4.2 DT-MTD的鲁棒性分析

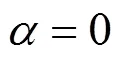

对于4.1节中防御者和用户的收益,可以通过求解式(11)得到防御者切换成员模型的策略和系统分类准确率。为了验证DT-MTD的防御对抗样本的有效性,在攻击者出现的先验概率下,将对抗样本攻击DT-MTD和单个成员模型的攻击成功率进行对比,实验结果如图1所示,其中(a)、(b)、(c)和(d)分别对应攻击者使用FGSM、PGD、MI-FGSM和M-DI2-FGSM生成的对抗样本攻击。

图1 不同的攻击者在不同概率下,使用DT-MTD的图像分类系统与单个成员模型的攻击成功率对比

Figure 1 Comparison of attack success rate of DT-MTD classification system with different attackers probability

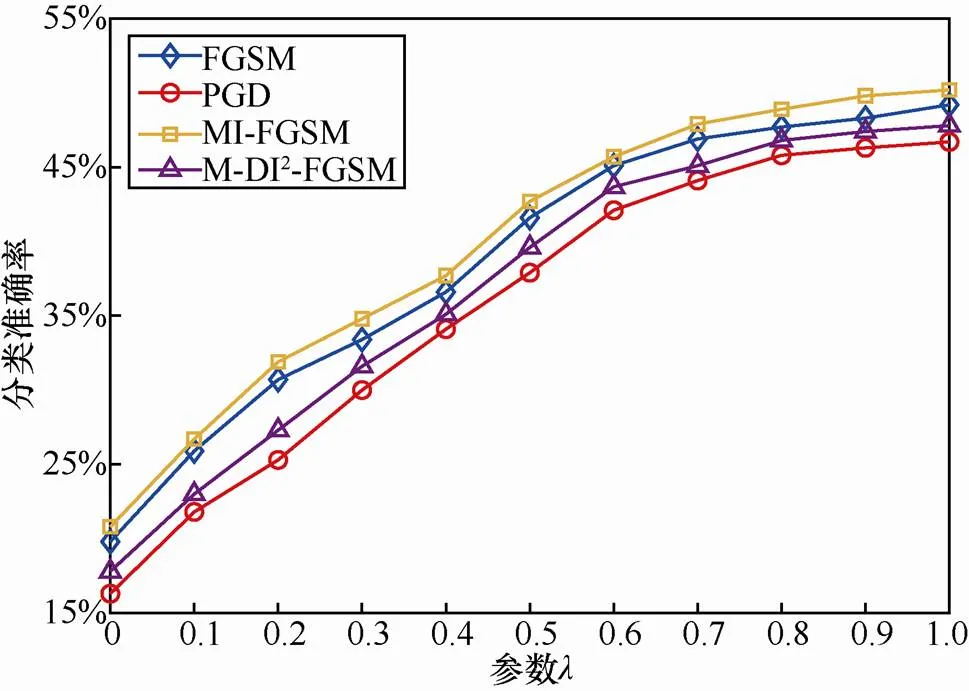

4.3 参数λ对DT-MTD性能的影响

图2 防御者的分类准确率λ与参数的关系

Figure 2 Relationship between defender's classification accuracy and parameter

表6 差异性训练参数λ值(0,0.2,…,1)对图像分类系统差分免疫的影响

5 结束语

本文首先介绍了深度学习安全问题领域的相关内容,探讨了图像分类系统基于Bayes- Stackelberg博弈的移动目标防御,通过分析图像分类系统的差分免疫,提出了差异性训练成员模型方法。实验表明,相比于成员模型未进行任何差异性处理,本文提出的差异性训练可以显著提高DNN的移动目标防御性能。未来的工作中,计划将移动目标防御与已有的防御技术相结合,进一步探索深度学习模型的安全性研究。

[1]HOLI G, JAIN D K. Convolutional neural network approach for extraction and recognition of digits from bank cheque images[M]//Emerging Research in Electronics, Computer Science and Technology. 2019: 331-341.

[2]FOMIN I S, BAKHSHIEV A V. Research on convolutional neural network for object classification in outdoor video surveillance system[C]//International Conference on Neuroinformatics. 2019: 221-229.

[3]BUYVAL A, GABDULLIN A, LYUBIMOV M. Road sign detection and localization based on camera and lidar data[C]//Eleventh International Conference on Machine Vision (ICMV 2018). 2019: 1104125.

[4]SZEGEDY C, ZAREMBA W, SUTSKEVER I, et al. Intriguing properties of neural networks[J]. arXiv preprint arXiv:1312.6199, 2013.

[5]GOODFELLOW I J, SHLENS J, SZEGEDY C. Explaining and harnessing adversarial examples[J]. arXiv preprint arXiv:1412.6572, 2014.

[6]MADRY A, MAKELOV A, SCHMIDT L, et al. Towards deep learning models resistant to adversarial attacks[J]. arXiv preprint arXiv:1706.06083, 2017.

[7]SENGUPTA S, CHAKRABORTI T, KAMBHAMPATI S. MTDeep: moving target defense to boost the security of deep neural nets against adversarial attacks[M]. Proc GameSec, 2019.

[8]ZHUANG R, DELOACH S A, OU X. Towards a theory of moving target defense[C]//Proceedings of the First ACM Workshop on Moving Target Defense. 2014: 31-40.

[9]RUSSAKOVSKY O, DENG J, SU H, et al. ImageNet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252.

[10]DONG Y, LIAO F, PANG T, et al. Boosting adversarial attacks with momentum[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018: 9185-9193.

[11]XIE C, ZHANG Z, ZHOU Y, et al. Improving transferability of adversarial examples with input diversity[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2019: 2730-2739.

[12]PARUCHURI P, PEARCE J P, TAMBE M, et al. An efficient heuristic approach for security against multiple adversaries[C]//In AAMAS. 2007.

[13]PARUCHURI P, PEARCE J P, MARECKI J, et al. Playing games for security: an efficient exact algorithm for solving Bayesian -Stackelberg games[C]//Proceedings of the 7th International Joint Conference on Autonomous Agents and Multiagent Systems- Volume 2. 2008: 895-902.

[14]DENG J, DONG W, SOCHER R, et al. ImageNet: a large-scale hierarchical image database[C]//IEEE Conference on Computer Vision & Pattern Recognition. IEEE, 2009.

[15]SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2015: 1-9.

[16]SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[J]. arXiv preprint arXiv:1409.1556, 2014.

[17]HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2016: 770-778.

Moving target defense against adversarial attacks

WANG Bin1,2,3, CHEN Liang1, QIAN Yaguan1, GUO Yankai1, SHAO Qiqi1, WANG Jiamin1

1. College of Science, Zhejiang University of Science and Technology, Hangzhou 310023, China 2. College of Electrical Engineering, Zhejiang University, Hangzhou 310058, China 3. Network and Information Security Laboratory, Hangzhou Hikvision Digital Technology Co., LTD, Hangzhou 310058, China

Deep neural network has been successfully applied to image classification, but recent research work shows that deep neural network is vulnerable to adversarial attacks. A moving target defense method was proposed by means of dynamic switching model with a Bayes-Stackelberg game strategy, which could prevent an attacker from continuously obtaining consistent information and thus blocked its construction of adversarial examples. To improve the defense effect of the proposed method, the gradient consistency among the member models was taken as a measure to construct a new loss function in training for improving the difference among the member models. Experimental results show that the proposed method can improve the moving target defense performance of the image classification system and significantly reduce the attack success rate against the adversarial examples.

adversarial examples, moving target defense, Bayes-Stackelberg game

TP393

A

10.11959/j.issn.2096−109x.2021012

2020−09−18;

2020−12−08

钱亚冠,qianyaguan@zust.edu.cn

国家重点研发计划(2018YFB2100400);国家电网公司总部科技项目(5700-202019187A-0-0-00);2019年度杭州市领军型创新团队项目

TheNational Key R&D Program of China (2018YFB2100400), Science and Technology Project of State Grid Corporation of China (5700-202019187A-0-0-00), Hangzhou City Leading Innovation Team Project in 2019

王滨, 陈靓, 钱亚冠, 等. 面向对抗样本攻击的移动目标防御[J]. 网络与信息安全学报, 2021, 7(1): 113-120.

WANG B, CHEN L, QIAN Y G, et al. Moving target defense against adversarial attacks[J]. Chinese Journal of Network and Information Security, 2021, 7(1): 113-120.

王滨(1978−),男,山东泗水人,海康威视数字技术有限公司研究员,主要研究方向为人工智能安全、物联网安全、密码学等。

陈靓(1995− ),男,江苏无锡人,浙江科技学院硕士生,主要研究方向为对抗深度学习、神经网络压缩。

钱亚冠(1976−),男,浙江嵊州人,博士,浙江科技学院副教授,主要研究方向为人工智能安全、机器学习与大数据处理、对抗性机器学习。

郭艳凯(1994− ),男,河南驻马店人,浙江科技学院硕士生,主要研究方向为深度学习图像处理、对抗深度学习。

邵琦琦(1997−),女,浙江永嘉人,浙江科技学院硕士生,主要研究方向为深度学习安全。

王佳敏(1993−),女,浙江新沂人,浙江科技学院硕士生,主要研究方向为深度学习安全。