基于双目融合网络的立体图像质量评价

2020-09-03李素梅韩永甜

李素梅,韩永甜,马 帅,韩 旭

基于双目融合网络的立体图像质量评价

李素梅,韩永甜,马 帅,韩 旭

(天津大学电气自动化与信息工程学院,天津 300072)

立体图像质量评价为3D技术的发展与应用提供了技术支撑.如何根据立体图像特点,构建更加符合立体视觉认知机制的立体图像质量评价模型,已成为该领域的关键问题之一.现有的立体图像质量评价方法要么先分别处理左右视图,然后结合左右视图质量得到立体图像质量分数;要么先对左右视图进行融合得到融合视图,然后评价平面的融合视图得到立体图像质量分数.事实上,大脑对立体视觉信号的处理是一个长期的复杂融合与处理的过程,并最终在视觉皮层完成对视觉信号的认知与判断.受大脑立体视觉认知机制的启发,本文提出一种基于双目融合网络的立体图像质量评价模型,实现了双目信息的多次融合与处理,模拟了大脑对双目信息进行处理和判决的视觉传导通路.所提出的双目融合网络包含左视图通道、右视图通道和融合通道,模拟立体视觉信息在视觉通路中的逐层并行处理过程;左右视图通道在网络中多次交互,模拟视觉通路中双目信息的多次融合与处理;网络末端的3个全连接层,模拟视觉信息经过视觉通路处理后复杂的质量判断过程.本文实验在两个公开立体图像库LIVE 3D PhaseⅠ和LIVE 3D PhaseⅡ上进行,实验结果表明,该方法在对称与非对称失真立体图像上均能取得更好的结果,且较其他方法具有更强的普适性.

图像质量评价;立体图像;立体视觉;双目融合

立体图像不仅带给人类身临其境的视觉感受,而且促进了各项立体技术的蓬勃发展.但任何处理技术都可能会造成立体图像的失真,从而影响人类对立体图像的视觉感知[1].有效的立体图像质量评价方法不仅可以实现立体图像质量的检测,而且可以进一步指导3D处理技术的改进.因此,建立一种有效的立体图像质量评价方法是十分必要的[2].

随着立体图像质量评价研究的不断深入,技术需求的不断提升,以及人类对视觉通路认知的不断加深,构造一种更加符合人脑视觉感知机理的质量评价模型已成为该领域的研究趋势.单纯将平面图像质量评价方法用于立体图像质量评价已不能满足需 求[3-4].经研究发现,来自于双眼的信息首先经过视觉通路的复杂融合与处理,然后大脑皮层对处理后的信息做出视觉感知与判断.为了模拟这种复杂的视觉感知机理,现有的立体图像质量评价方法主要有两类:一类[5-12]是首先对来自双眼的左右视图分别进行处理,然后考虑人眼的双目融合特性,最终对立体图像的质量进行判断;另一类[13-22]是首先考虑双目融合特性,对来自于双眼的左右视图进行融合,然后类似于平面图像质量评价方法,最终得到立体图像的质量等级.

事实上,双目视觉信息在通过视网膜之后首先在视觉通路中的视交叉神经处进行部分交叉,产生初步融合,部分交叉后的左右视觉信息分别通过左右外侧膝状体传输到初级视觉皮层进行融合,然后在其他视觉皮层中进行复杂的分层、并行的融合与处理,进而对融合处理后的图像质量进行判断[23-24].因此,上述两类方法都仅仅模拟了视觉通路的一部分.深度学习方法的出现,为更好地模拟视觉通路提供了可能,因为深度学习方法可以逐级分层地提取所处理信息的特征.

论文主要贡献总结如下.

(1)论文模拟立体图像在视觉通路中融合和处理相结合的方法,对立体图像质量进行客观评价,构建了一种包含3个通道的卷积神经网络模型.

(2)所提模型通过对左右视图的多次交互,模拟了视交叉神经中的初步融合与后续视觉皮质层的复杂融合与处理过程;模型中的多个卷积层与多个通道模拟了人脑对视觉信息的逐级分层次并行处理过程;模型中的3个全连接层模拟了复杂的质量决策过程.

1 视觉通路

在视觉通路中,大脑对来自双眼视觉信息的处理是一个复杂过程,图1[25]所示为视觉通路的简单描述模型.图2为视觉通路中的视觉信息传递过程.

图1 视觉通路模型

图2 视觉通路中的视觉信息传递过程

从图1、图2可以看出,来自双眼的视觉信息经过视网膜后通过双极细胞和视网膜节细胞(retinal ganglion cells,RGC)进行处理,其中视网膜节细胞中包含M细胞和P细胞,视网膜节细胞的轴突在视神经盘处汇聚成视神经.视觉信息通过视神经入颅,在视交叉处进行部分的交叉后延伸为视束.在视交叉中,来自双眼鼻侧的纤维交叉,加入对侧视束,而来自视网膜颞侧的纤维不进行交叉,进入同侧视束.因此,左侧视束内含有来自右眼鼻侧的纤维和左眼颞侧的纤维,右侧视束含有左眼鼻侧的纤维和右眼颞侧的纤维,在视交叉神经处,左右眼视觉信息完成了初步融合.左右侧视束经过外侧膝状体细胞(lateral geniculate nucleus,LGN)后进入初级视觉皮质V1,进行复杂的融合与处理.来自视网膜节细胞的M细胞通过腹侧LGN传导形成M 视觉通路.信息到达V1区域后经过复杂的分层处理最终投射到内侧颞区(medial temporal area,MT),然后投射到顶叶皮层. MT区域的细胞对运动十分敏感,经过M视觉通路处理后在顶叶皮层能够解析出视觉信息的位置.来自视网膜节细胞的P细胞通过背侧LGN形成P 视觉通路,经过V1区域后经过复杂的分层处理最终投射到视觉皮质的V4区域,然后投射到颞叶皮层.V4区域的细胞对颜色十分敏感,颞叶皮层对内容和细节十分敏感.经过P视觉通路处理后在颞叶皮层能够解析出视觉信息中的内容信息.同时在LGN层间存在一种K细胞,同样处理色彩信息,最终投射到V4区域[26].大脑通过顶叶颞叶等的处理最终获得视觉判断.

可见,双眼信息经过视觉通路最终得到质量等级的判断是一个复杂的融合处理与判断的过程.左右视图通过视交叉神经的简单融合后,由LGN传递到初级视觉皮质V1中,经过V1~V4、MT、IT等视觉皮质的融合与处理最终分析出视觉信息的质量.视觉信息在视觉皮质层中的处理是一个逐层分级的并行过程,不能由简单的一次融合进行模拟.

2 基于视觉通路的双目融合网络模型

图3为本文提出的双目融合网络模型.该网络模型包含3个通道:左视图通道、右视图通道和融合通道.左视图通道提取左视点特征,右视图通道提取右视点特征.左视图通道和右视图通道各包含4个卷积层和2个池化层.融合通道提取双目特征,包含4个卷积层、3个池化层和3个全连接层.网络输入为失真的立体图像对,立体图像对经过网络的分层融合与处理得到立体图像的质量分数.左右视图通道在经过每一个卷积层后,会在融合通道发生一次融合,本文采用了4次融合(①、②、③、④)的方案对立体图像质量进行评价.左、右视图通道和融合通道模拟了视觉通路中的并行处理机制.融合通道中的4次融合模拟了视交叉神经的初级融合与其他视觉皮层的复杂融合与处理过程.同时多层卷积神经网络也模拟了视觉皮层中的逐级分层处理机制.通过复杂的融合与处理后,网络通过3层全连接层模拟最终立体图像质量判断的过程.本文所提出的双目融合网络具体网络参数设置如表1所示.

网络中左右通道特征图的融合可以采取Concat和Eltwise两种方式实现.Eltwise方式将特征图逐像素点对应相加,Concat方式级联所有的特征图.本文采取Concat方式融合左右通道特征图.例如,若采用Concat融合方式进行特征图的融合,对于融合点④将会有3个输入,分别是来自左视图通道的384张特征图,来自右视图通道的384张特征图和来自融合通道的384张特征图.因此,对于融合点④将会有384+384+384=1152张特征图,作为融合通道Conv5的输入.来自左右通道和融合通道的特征图均被集中到融合点④,不同通道的特征图将被分配不同的权重,模拟双目融合的过程.若在特征图融合过程中采用Eltwise方式,融合点④将只有1个输入,该输入为左右视图通道和融合通道的384张特征图像素点对应相加的结果.这也就是说,来自左右通道的信息将会被网络分配相同的权重.根据双目融合与双目竞争机制,左右视图应该被分配不同的权重[27-28],显然,Eltwise方法并不符合双目融合与双目竞争机制.

图3 双目融合网络结构

表1 双目融合网络参数

Tab.1 Configurations of the proposed binocular fusion network

所提网络中的卷积操作可由式(1)表示.

3 实验与分析

3.1 数据库与性能指标

本文方法分别在LIVE 3D PhaseⅠ、LIVE 3D PhaseⅡ和天津大学(Tianjin University,TJU)立体图像库上进行网络性能的测试.其中,LIVE 3D PhaseⅠ包含20张原始参考立体图像对和365张对称失真的立体图像对.失真类型包括JPEG、JPEG 2000 (JP2K)、White Noise(WN)、Gaussian Blur(Blur)和Fast-Fading(FF).LIVE 3D PhaseⅡ包含8张原始参考立体图像对、120张对称失真立体图像对和240张非对称失真立体图像对.失真类型包括JPEG,JPEG 2000(JP2K)、White Noise(WN)、Gaussian Blur(Blur)和Fast-Fading(FF).TJU立体图像库包含4张原始参考立体图像对和403张非对称失真的立体图像对,包括JPEG、JP2K、WN、Blur、FF和视差失真6种失真类型.

为了评价所提出网络模型性能的优劣,论文采用3种常见的性能指标计算网络实际输出和主观DOMS值之间的相关程度,分别是皮尔逊线性相关系数(Pearson linear correlation coefficient,PLCC)、斯皮尔曼阶相关系数(Spearman rank order correlation coefficient,SROCC)和均方根误差(root mean square error,RMSE).PLCC和SROCC越接近1、RMSE越接近0,证明网络模型的评价效果越好.

3.2 整体性能分析

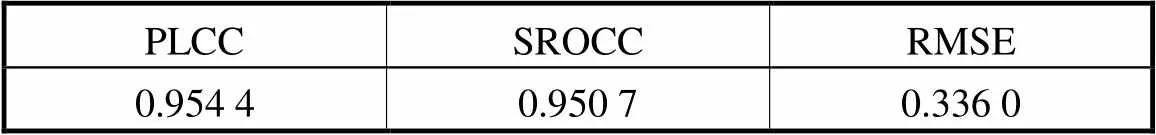

表2中给出所提出网络模型与其他13种先进立体图像质量评价方法的性能比较.这些方法中,文献[5-6,10-11]首先分别对左右视点进行处理,然后根据双目融合特性对得到的特征或分数进行融合.文献[13,15-22]首先对左右两个视点进行融合,然后对融合图像进行处理得到立体图像质量分数.上述两类方法均从不同角度模拟了视觉通路中左右视觉信息的一部分融合和处理过程.其中文献[5-6,19-20,22]采用传统的特征提取的方法,文献[15-17]采取了稀疏表示的方法,文献[10-11,13,18,21]同本文方法一样,采用了深度学习方法.从表2中可以清楚地看到,所提出方法在LIVE 3D PhaseⅠ上所有指标的效果均好于其他方法,在LIVE 3D PhaseⅡ,SROCC和RMSE均优于其他方法,只有PLCC的效果稍逊于Karimi等[16],但处于同一个数量级上.并且,所提出方法在LIVE 3D PhaseⅠ上的PLCC和SROCC均超过了0.96,在LIVE 3D PhaseⅡ上PLCC和SROCC均超过0.95.表3显示了所提出方法在TJU立体图像库上的评价效果,其PLCC和SROCC均超过了0.95.

从表2和表3中可以看出,所提方法无论是在对称失真还是非对称失真的立体图像上评价效果都很优秀,所提方法在对称失真和非对称失真数据库上的指标差值小于其他方法在2个数据库上的差值.以Xu等[5]的PLCC值为例,LIVE 3D PhaseⅠ上的值为0.9490,而在LIVE 3D PhasezⅡ上的值为0.9260,差值为0.0230,所提方法在2个数据库上的差值为0.0113.其他方法的差值甚至大于0.0230,这说明所提方法不仅能够很好地评价对称失真的立体图像,而且也更适用于评价非对称失真的立体图像.相比于对称失真的立体图像,评价非对称失真立体图像更加困难,只有更加符合人眼视觉认知机理的方法才能够有更好的结果.因此,相对于其他只模拟视觉通路中一部分的融合处理机制方法,所提出方法具有更强的普适性能,在对称失真和非对称失真的立体图像上具有较好的效果.这也证明了所提方法在一定程度上能够较好地模拟视觉通路中立体图像认知的复杂融合与处理过程.

表2 各种方法在LIVE 3D 图像数据库上的效果比较

Tab.2 Performance of the different methods on LIVE 3D image quality database

表3 本文方法在天津大学立体图像库上的性能

Tab.3 Performance of the proposed method on the Tian-jin University 3D image quality database

3.3 不同失真类型的评价效果

为了更加准确地评价所提网络的性能,表4比较了所提方法与其他方法在LIVE 3D PhaseⅠ和LIVE 3D PhaseⅡ上不同失真类型的PLCC评价结果.可以看到,本文的PLCC结果在不同失真类型上基本都处在前3名的位置,只有LIVE 3D PhaseⅡ数据库上JPEG和WN失真类型上PLCC表现稍差.因此所提方法具有较好的普适性能.

表4 各种方法在LIVE 3D图像库上不同失真类型的PLCC结果

3.4 不同融合次数网络性能比较

为了证明所提网络能够很好地模拟视觉通路中复杂的融合与处理过程,本文对有不同融合次数的网络,即有不同层数的网络进行了性能对比.图4显示了在LIVE 3D PhaseⅠ和LIVE 3D PhaseⅡ数据库中,有不同融合次数网络的PLCC与SROCC结果对比.其中,横坐标(1,2,3,4,5,6)表示在融合通道中存在次融合的网络结构,即左视图通道、右视图通道与融合通道各存在层卷积层.纵坐标为网络对应SROCC与PLCC值.从图4可以看到,无论在LIVE 3D PhaseⅠ还是LIVE 3D PhaseⅡ数据库上,所提出的4次融合网络的表现性能均为最佳.随着网络融合次数的增加,网络性能有所提升,这正反映出在视觉通路中图像的融合和处理是一个复杂的过程,不能简单地采用一次融合来模拟.但随着网络融合次数的增多,网络结构变得复杂,网络的评价效果反而变差,这可能是由于模型过于复杂而训练数据不足的原因.通过实验可以证明采用4次融合能够很好地模拟视觉通路中的融合与处理过程.

图4 不同融合次数网络结果对比

3.5 不同融合位置网络性能比较

表5比较了在不同位置发生融合的网络结构的表现性能.其中①表示只在融合点①处发生融合的网络结构,①②表示只在融合点①②处发生融合的网络结构,其余符号表示意义相同.从表5中可以看出,当网络具有相同的融合次数时,例如①和④,①②和③④,①②③和②③④,网络④、③④和②③④的结果要好于网络①、①②和①②③,甚至一次融合的网络④的结果要好于3次融合的①②③.这可能是由于随着网络层数的加深,网络学习到的特征更抽象,更能表示出图像中的关键性信息.因此更深层次的融合对评价准确性的贡献更大.但是网络③④、②③④和①②③④的评价效果要好于网络④,这也说明浅层的融合对网络性能的提升同样有帮助.

表5 不同融合位置性能比较

Tab.5 Performance of the proposed method at different fusion locations

3.6 不同融合方式网络性能比较

为了比较不同融合方式对网络性能的影响,表6展示了采用不同方式进行融合的网络性能的结果对比.从表6中可以看出,Concat融合方式要明显优于Eltwise的融合方式.Eltwise融合方式对于左右通道的特征图分配了相同的权重,而Concat融合方式通过网络的学习,左右通道的特征图会被分配不同的权重.在双目融合的过程中,左右视觉信号应该根据自己的能量刺激和对方的能量刺激自动调节,从而分配不同的权重[22].显然,Concat融合方式更加符合双目融合特性.通过网络的学习,左右视图通道的权重将被自动调节,这不仅适合于评价对称失真立体图像,更适合于评价双目竞争现象更为剧烈的非对称失真立体图像.这也是本文方法在对称和非对称失真立体图像上具有良好表现的原因之一.

表6 不同融合方式性能比较

Tab.6 Performance of the proposed method with differ-nt fusion ways

4 结 语

本文提出了一种能够更好地模拟视觉通路的立体图像质量评价模型.双目融合网络中的多通道结构、分层的卷积与左右视图的多次融合模拟了立体图像在视觉通路中并行的分层的复杂融合与处理的过程.网络中最后的全连接层模拟了对复杂处理后的信息进行综合并做出质量决策的过程.实验结果表明,本文所提出的双目融合网络在对称和非对称失真的立体图像上的表现都十分优秀,这也反映了本文提出的模型可以较好地模拟视觉通路中复杂的信息处理过程.

[1] Xing L,You J,Ebrahimi T,et al. Assessment of stereoscopic crosstalk perception[J]. IEEE Transactions on Multimedia,2012,14(2):326-337.

[2] Chen M,Cormack L K,Bovik A C. No-reference quality assessment of natural stereopairs[J]. IEEE Transactions on Image Processing,2013,22(9):3379-3391.

[3] You H,Xing L,Perkis A,et al. Perceptual quality assessment for stereoscopic images based on 2D image quality metrics and disparity analysis[C]// 5th International Workshop on Video Processing and Quality Metrics for Consumer Electronics. Scottsdale,Arizona,USA,2010:1-6.

[4] Bosc E,Repion R,Le Callet P,et al. Towards a new quality metric for 3-D synthesized view assessment[J]. IEEE Journal of Selected Topics in Signal Processing,2011,5(7):1332-1343.

[5] Xu X,Zhao Y,Ding Y. No-reference stereoscopic image quality assessment based on saliency-guided binocular feature consolidation[J]. Electronics Letters,2017,53(22):1468-1470.

[6] Ma J,An P,Shen L,et al. Reduced-reference stereoscopic image quality assessment using natural scene statistics and structural degradation[J]. IEEE Access,2018,6:2768-2780.

[7] Shao F,Li K,Lin W,et al. Using binocular feature combination for blind quality assessment of stereoscopic images[J]. IEEE Signal Processing Letters,2015,22(10):1548-1551.

[8] Jiang G,Shao F,Li K,et al. Joint structure-texture sparse coding for quality prediction of stereoscopic images[J]. Electronics Letters,2015,51(24):1994-1995.

[9] Shao F,Li K,Lin W,et al. Learning blind quality evaluator for stereoscopic images using joint sparse representation[J]. IEEE Transactions on Multimedia,2016,18(10):2104-2114.

[10] Yang J,Jiang B,Song H,et al. No-reference stereoimage quality assessment for multimedia analysis towards Internet-of-things[J]. IEEE Access,2018,6:7631-7640.

[11] Ding Y,Deng R,Xie X,et al. No-reference stereoscopic image quality assessment using convolutional neural network for adaptive feature extraction[J]. IEEE Access,2018,6:37595-37603.

[12] Lü Y,Yu M,Jiang G,et al. No-reference stereoscopic image quality assessment using binocular self-similarity and deep neural network[J]. Signal Processing:Image Communication,2016,47:346-357.

[13] Sang Q,Gu T,Li C,et al. Stereoscopic image quality assessment via convolutional neural networks[C]// International Smart Cities Conference. Wuxi,China,2017:1-2.

[14] Lu K,Liu X. Stereoscopic image quality assessment based on cyclopean image[C]// 2016 IEEE International Conference on Internet of Things(iThings)and IEEE Green Computing and Communications(GreenCom)and IEEE Cyber,Physical and Social Computing(CPSCom) and IEEE Smart Data(SmartData). Chengdu,China,2016:750-753.

[15] Lin Y,Yang J,Lu W,et al. Quality index for stereoscopic images by jointly evaluating cyclopean amplitude and cyclopean phase[J]. IEEE Journal of Selected Topics in Signal Processing,2017,11(1):89-101.

[16] Karimi M,Nejati M,Soroushmehr M R,et al. Blind stereo quality assessment based on learned features from binocular combined images[J]. IEEE Transactions on Multimedia,2017,19(11):2475-2489.

[17] Li S,Han X,Chang Y. Adaptive cyclopean image based stereoscopic image quality assessment using ensemble learning[J]. IEEE Transactions on Multimedia,2019,21(10):2616-2624.

[18] Yang J,Sim K,Gao X,et al. A blind stereoscopic image quality evaluator with segmented stacked autoencoders considering the whole visual perception route[J]. IEEE Transactions on Image Processing,2019,28(3):1314-1328.

[19] Li Y,Yang F,Wan W,et al. No-reference stereoscopic image quality assessment based on visual attention and perception[J]. IEEE Access,2019,7:46706-46716.

[20] Liu T,Lin C,Liu H,et al. Blind stereoscopic image quality assessment based on hierarchical learning[J]. IEEE Access,2019,7:8058-8069.

[21] Yang J,Sim K,Lu W,et al. Predicting stereoscopic image quality via stacked auto-encoders based on stereopsis formation[J]. IEEE Transactions on Multimedia,2019,21(7):1750-1761.

[22] Liu Y,Kong F,Zhen Z. Toward a quality predictor for stereoscopic images via analysis of human binocular visual perception[J]. IEEE Access,2019,7:69283-69291.

[23] 林崇德,杨治良,黄希庭. 心理学大辞典[M]. 上海:教育出版社,2003.

Lin Chongde,Yang Zhiliang,Huang Xiting. Psychological Dictionary[M]. Shanghai:Education Press,2003(in Chinese).

[24] Wilson-Pauwels L. Cranial Nerves[M]. Shelton:People’s Medical Publishing House Press,2010.

[25] Holden A L. Chapter 15 the Central Visual Pathways[EB/OL]. http://www. docin. com/p-1774332014. html,1977-11-01.

[26] Snowden R J,Thompson P,Troscianko T. Basic Vision:An Introduction to Visual Perception[M]. London:Oxford University Press,2006.

[27] Tong F,Meng M,Blake R. Neural bases of binocular rivalry[J]. Trends in Cognitiveences,2006,10(11):502-511.

[28] Ding J,Sperling G. A gain-control theory of binocular combination[J]. Proceedings of the National Academy of Sciences,2006,103(4):1141-1146.

Stereo Image Quality Assessment Based on Binocular Fusion Network

Li Sumei,Han Yongtian,Ma Shuai,Han Xu

(School of Electrical and Information Engineering,Tianjin University,Tianjin 300072,China)

Stereo image quality assessment provides technical support for the development and application of 3D technologies. The construction of a stereo image quality assessment model that is more in line with the stereo visual cognition mechanism based on the characteristics of stereo images has become one of the key issues in this field. Existing stereo image quality evaluation methods either process the left and right images respectively and then combine their quality to derive the stereo image quality score,or first fuse the left and right images to get the fusion image and then evaluate the planar fusion image to derive the stereo image quality score. In fact,the processing of stereo visual signals in the brain is a long-term process of complex fusion and processing,and finally completes the cognition and judgment of visual signals in the visual cortex. Inspired by the stereo visual transmission pathway in the brain,a stereo image quality assessment model based on the binocular fusion network is proposed in this study,which realizes multiple fusion and processing of binocular information,and simulates the brain’s visual pathway for processing and judging binocular information. The convolutional neural network model includes the left view channel,the right view channel and the fusion channel,which simulates the hierarchical and parallel processing of visual information in the visual pathway. The left and right view channels have multiple interactions in the network,which simulates the multiple fusion and processing in the visual pathway. Three fully connected layers are set at the end of the network,which simulates the complex quality judgment process after information fusion and processing in the visual pathway. Experiments are conducted on two public stereo image databases,namely LIVE 3D Phase I and LIVE 3D Phase II,and the experimental results show that the proposed method outperforms other methods in both symmetric and asymmetric distorted stereo images,and shows better universality.

image quality assessment;stereo image;stereo visual;binocular fusion

TN911.73

A

0493-2137(2020)10-1086-07

10.11784/tdxbz201908005

2019-08-03;

2019-12-21.

李素梅(1975— ),女,博士,副教授,lisumei@tju.edu.cn.

韩永甜,han_yt9@163.com.

国家自然科学基金资助项目(61571325,61002028,61520106002).

Supported by the National Natural Science Foundation ofChina(No. 61571325,No. 61002028,No. 61520106002).

(责任编辑:王晓燕)