基于多流高斯概率融合网络的病虫害细粒度识别

2020-08-12孔建磊金学波王小艺

孔建磊,金学波,陶 治,王小艺,林 森

基于多流高斯概率融合网络的病虫害细粒度识别

孔建磊1,2,3,金学波1,2,3※,陶 治1,王小艺1,2,3,林 森3,4

(1.北京工商大学人工智能学院,北京 100048;2.国家环境保护食品链污染防治重点实验室,北京 100048;3. 中国轻工业工业互联网与大数据重点实验室,北京 100048;4. 北京农业智能装备技术研究中心,北京 100097)

为解决由于现有深度迁移学习无法有效匹配实际农业场景部署应用,而导致大规模、多类别、细粒度的病虫害辨识准确低、泛化鲁棒差等问题,该研究利用农业物联网中多种设备终端获取12.2万张181类病虫害图像,并提出了基于多流概率融合网络MPFN(Multi-stream Gaussian Probability Fusion Network)的病虫害细粒度识别模型。该模型设计多流深度网络并行的细粒度特征提取层,挖掘可区分细微差异的不同级别局部特征表达,经过局部描述特征聚合层和高斯概率融合层的整合优化,发挥多模型融合信息互补及置信耦合的优势,既可以有效区分不同类病虫害的种间微小差异,又可容忍同类病虫害种内明显差异干扰。对比试验表明,该研究MPFN模型对各类病虫害的平均识别准确率达到 93.18%,性能优于其他粗粒度及细粒度深度学习方法;而平均单张处理时间为61ms,能够满足农业生产实践中物联网各终端病虫害细粒度图像识别需求,可为智能化病虫害预警防控提供技术应用参考,进而为保障农作物产量和品质安全提供基础。

农业;图像识别;病虫害;深度神经网络;特征聚合;高斯概率融合

0 引 言

农作物病虫害是引起大宗粮油作物减产、果蔬作物品质下降的主要原因之一。由于中国农作物及病虫害种类繁多、环境因素耦合、生产环节复杂,导致农作物生产周期中产生病虫害过程复杂多变,实时预警防控手段相对缺乏,安全控制处于被动应付境地。因此,如何准确快速识别出农作物病害类型、为防控治疗提供及时预警信息,是提升农作物产量和保证品质安全的关键环节,与“三农问题”密切关联,直接影响着区域农业生产和农村经济发展[1];随着物联网、云计算、人工智能等现代信息技术与农业深度融合,“智慧农业”通过实时信息感知、定量决策、智能生产控制和精准个性管理的全产业供应链实施,成为当今世界现代农业发展的大趋势[2]。而在农作物病虫害识别方面,“智慧农业”依托固定监控相机、移动装备及机器人、智能手机等终端构建的物联网体系,在实时采集获取大量高质量病虫害图像数据基础上[3],研究基于深度学习、迁移学习等方法的分类检测网络,可高效率、低成本地为广大农业生产者提供精准、可靠、实时的病虫害识别结果,逐渐成为国内外共同关注的研究焦点[4]。

为了保障深度网络模型的训练数据量和识别性能,许多研究针对特定农作物类别收集了大量作物病虫害公开数据集。Mohanty等[5]收集了包含14类作物、26种病害的PlantVillage数据集,具有54 306幅农作物叶部分的病害图像,并利用AlexNet和GoogleNet深度网络将对象分为38个对应类别,准确率高达99.35%。Konstantinos[6]则收集了苹果、土豆等25类蔬果的87 848张叶部病害图片,用以验证VGGNet(Visual Geometry Group Networks)[7]模型识别性能,准确率提高到99.53%。类似地,张建华等[8]则优化VGG-16模型,以适应棉花病害识别问题,性能达到 89.51%。为进一步解决复杂场景病虫害检测问题,Alvaro等[9]将番茄叶片病虫害识别从分类问题延伸到检测问题,将深度网络分类器与Faster R-CNN(Faster Region-Convolutional Neural Network)、SSD(Single Shot MultiBox Detector)结合构建检测模型,有效提高对灰霉病、粉虱等9种病虫害数据的识别及检测性能。为进一步保障深度网络有效训练,Wu等[10]收集了102类农作物害虫共计75 222张图像,并对19 000多张照片进行框标注,用以训练ResNet[11]分类器与YOLOv3(You Only Look Once-V3)检测网络结合模型,有效验证深度网络在农作物虫害分类及识别的显著效益。

上述研究为利用深度神经网络进行农作物叶片病虫害识别提供了参考和可行性,但高性能深度学习模型对数据依赖严重。而农业应用场景环境复杂且时空范围广阔,农作物病虫害图像数据采集充满不确定性和高难度性,这导致现有病虫害识别的应用困境:深度学习要求有大量图像数据支持,但即便有物联网及传感器设备信息技术支持,农业场景自身不趋向于形成如此规模的优质数据集合[12]。近些年来,可以从相关领域的海量标注数据中学习知识结构和模型参量,再直接改善小规模数据量级农作物病虫害识别性能的迁移学习正受到越来越多的关注[13-14]。虽然迁移学习可以加速模型训练,但依旧受限于复杂网络结构和海量拟合参数,因此不少研究使用不同轻量压缩策略优化神经元层次组合,降低深度网络参数量、提升深度网络对智能设备部署匹配性[15-16]。

目前,迁移学习及轻量化策略可有效压缩模型参量、减低设备内存资源,但复杂农业场景下农作物病虫害图像分类属于极具挑战的细粒度图像识别研究任务,存在着光照不均、遮挡密集、背景干扰、设备抖动模糊等诸多外在因素干扰,导致属于同类病虫害的不同图像样本差异很大,而病虫害存在生长变异情况,进一步导致同类病虫害不同阶段表征差异明显,形成“种内差异”细粒度特性;同时,不同种病虫害存在繁多的生物学亚种、亚类、子类的细致划分,各子类相互间存在一定生物形态及生活习性的相似,导致“种间相似”的细粒度辨识难题。而依托现有深度迁移学习方法并不能有效辨识上述实际农业场景应用中天然存在的病虫害细粒度特性,导致辨识准确率低、泛化鲁棒性等技术难题,长期限制着智慧农业物联网对病虫害决策管理性能提升[17]。需要通过有效方法来增强深度迁移网络的表示能力,学习微小的局部差异、有效挖掘农业领域的特定病虫害知识结构。常见方法分为强监督学习[18]和弱监督学习[19]两种。前者需要大量局部位置的区域框注释,过于依赖费时耗力的人工标记,导致其在实际应用中存在局限性[20]。而弱监督方法则倾向于自主提取局部特征、关注局部与整体间内在联系,已成为主流逐渐受到关注,在公开细粒度数据集及竞赛中涌现的、NTS-Net(Navigator-Teacher-Scrutinizer Network)[21]、FAST-MPN(Faster Training of Multi-global Covariance Pooling Networks)[22]、DFL(Discriminative Filter Bank Learning Networks)[23]等不断刷新目标识别的准确率,但迁移到病虫害识别应用的研究鲜有报道。只有少许学者根据农业场景病害图像识别需求,以强监督方式调整了相应深度网络模型[25-26],但距离实际场景中大规模病虫害辨识应用还有较大技术差距。

综上所述,国内外相关研究只适用于种类较少的病虫害细粒度识别,不解决规模较大、类别较多、精准高效的病虫害识别难题,且难以直接部署到“智慧农业”各移动终端。针对农作物病虫害细粒度识别的特殊性和困难性,本文利用农业物联网中多种图像采集设备获取181类病虫害图像数据集。在此基础上提出了一种多流深度网络并行的病虫害细粒度识别模型,挖掘可区分细微差异的不同级别局部特征表达,并结合特征聚合和高斯概率融合优化,整合多个弱监督模型的互补信息,获得高判别性和准确率的识别结果,为实际农业场景下大规模病虫害识别提供可行方案。

1 数据来源

1.1 数据样本

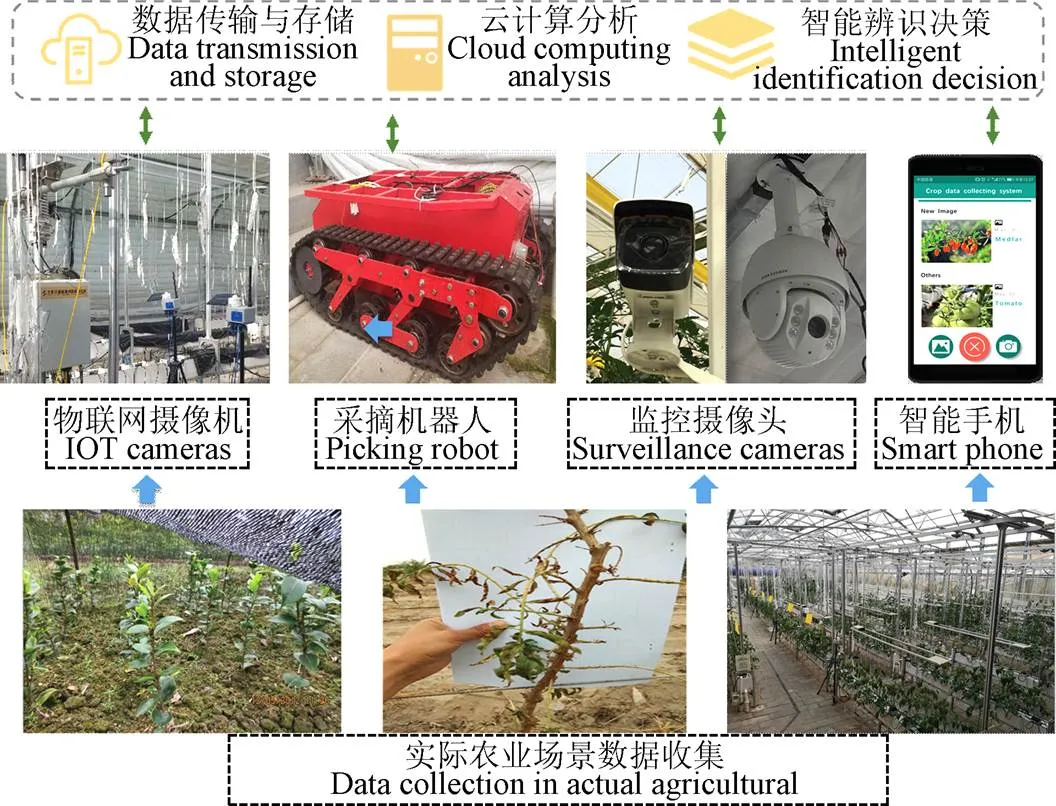

为了保证在实际农业环境中识别病虫害性能,本文图像数据的采集依托北京农业智能装备技术研究中心在全国各地部署的病虫害物联网监管系统。通过物联网摄像机、监控摄像、自动采摘装备、喷涂机器人及智能手机等设备采集病虫害图像数据,通过CAN/4G/WIFI等通讯形式将数据传输到后台云服务器,经过数据存储、数据处理及模型学习训练,及时返回病虫害细粒度识别结果和防控建议,更真实地反应灾情动态情况,系统结构如图1所示。

图1 病虫害监管系统示意图

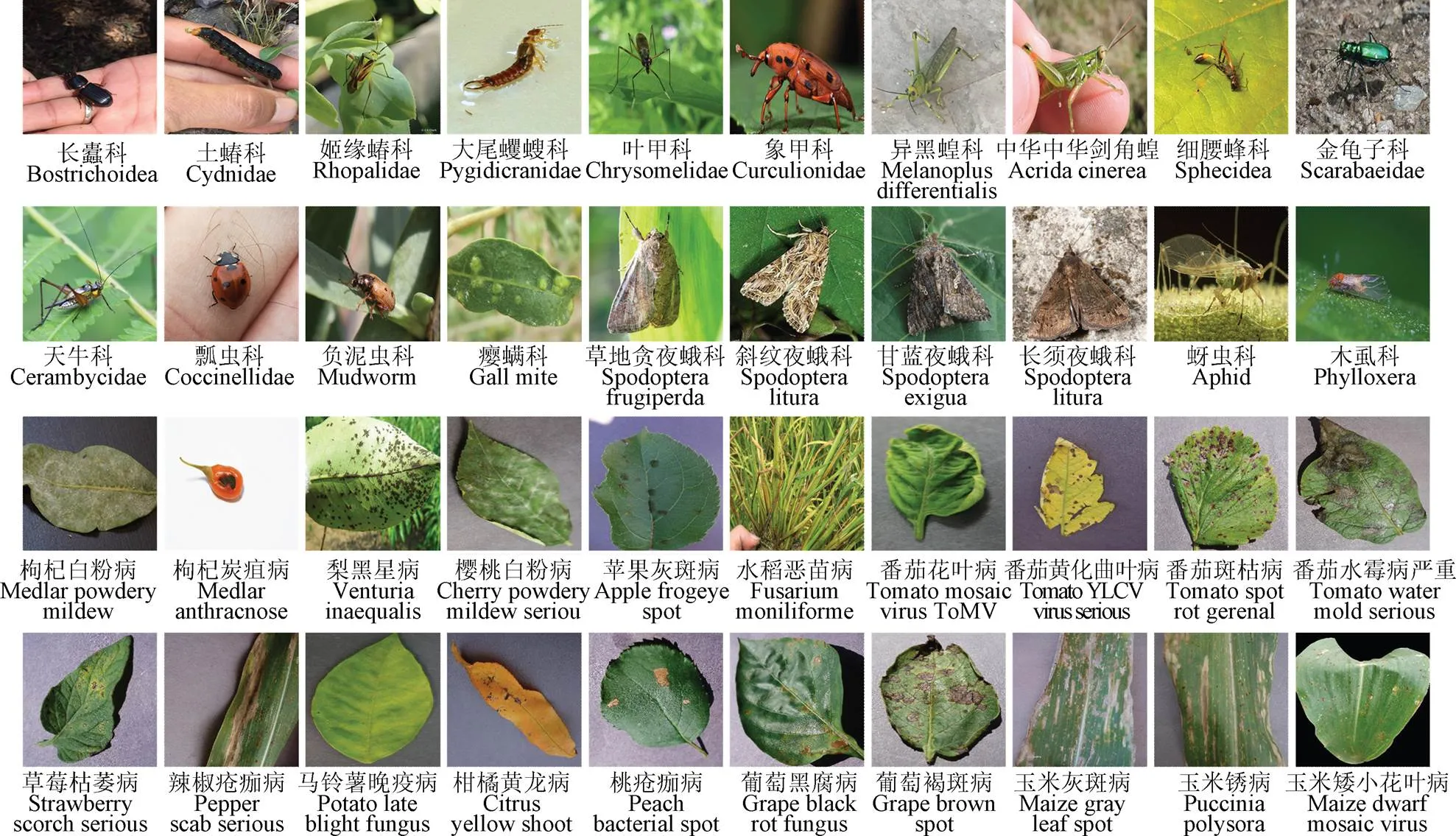

鉴于不同种类的病虫害分布具有区域性和季节性,本文病虫害样本的图像采集工作自2018年7月起至2019年12月,分时段进行,主要集中在北京、山东、宁夏等北方区域及湖南、湖北等南方区域。本工作采集有效的病虫害图像共计124 437张,考虑不同相机设备焦距、角度和光圈不同,将每张照片的分辨率限定为1 000×1 000像素。并将PlantVillage等公开数据集中有关数据进行梳理、提取及归入,构建全新的病虫害数据集,来自于苹果、樱桃、玉米、葡萄、水稻、柑橘、桃、辣椒、马铃薯、草莓、番茄、枸杞、小麦等共13种农作物,包括叶、花、果实、茎等多个植株部位,共计181个病虫害类别,部分病虫害类别的数据样本如图2所示。其中,病害涉及白粉病、炭疽病、黑星病、松锈病、灰斑病等,共计49类;虫害来自于长蠹科、土蝽科、姬缘椿科、大尾蠼螋科、叶甲科、象甲科、异黑蝗、天牛科、草地贪夜蛾科、瘿螨科等77个科属,共计132类,且每类病虫害包含不同的发病阶段图像样本。

图2 部分病虫害类别的数据样本

但考虑病害及虫害发生情况不同,本文获取的各类病害样本分布极不均匀,每个类别至少有100张图像样本,保证所有类别具有满足模型训练的基本数据量。而样本数量最多的是第54类草地贪夜蛾科(Spodoptera frugiperda),共计有效图像5 109张,其幼虫可大量啃食禾本科如水稻、甘蔗和玉米之类细粒禾榖及菊科、十字花科等多种农作物,易造成严重的经济损失。而病害图像数量最多为第180类番茄黄化曲叶病严重状态(Tomato YLCV Virus serious),有效样本2 826个,该病是一类具有孪生颗粒形态的植物DNA病毒,广泛分布于热带和亚热带地区,在番茄、南瓜等重要经济作物上经常造成毁灭性危害。本数据集包含了多方面细粒度因素,既有不同种类形态及环境的相似性,又存在同一物种的发育病变周期变化、植株组织、光照、等显著差异,虽可以一定程度描述真实农业环境复杂情况,也蕴含着细粒度病虫害的挑战性。

1.2 数据增强处理

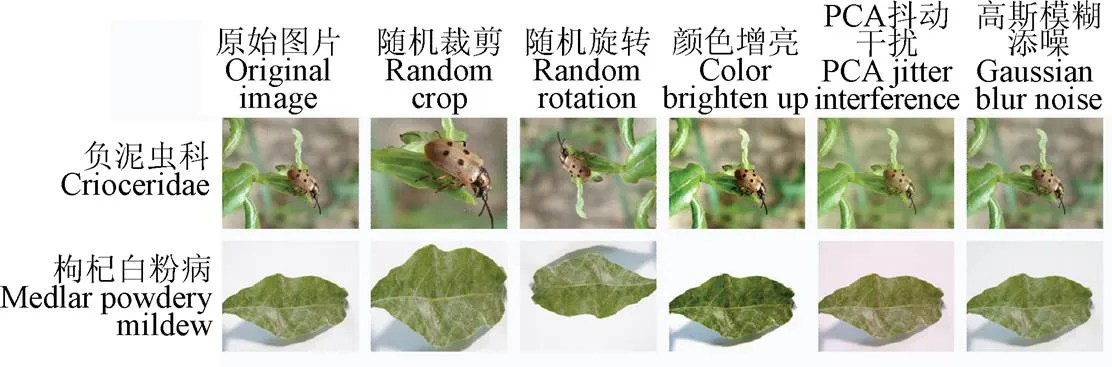

为了弥补样本分布不均匀对模型识别性能影响,以及避免网络过度拟合,本文在训练之前,对数量较少的样本数据进行增强处理。本文使用的增强方法主要包括5个步骤:1)随机裁剪:在较大图像的不同区域随机裁剪出局部图像,设长宽裁剪比例为[3/4,4/3]和[8%,100%]进行随机区域采样,然后将裁剪区域的像素大小调整为448×448;2)翻转:将部分图像沿着顺时针随机旋转90、180和270度,模拟真实农业场景角度差异情况,以提高变形适应性;3)HSV(Hue,Saturation,Value)增亮:以指数方式更改每个像素的饱和度S和亮度V分量,并保持色相H不变,以增加照明变化。S和V通道分别使用从[0.25,4]均匀得出的系数进行缩放;4)PCA(Principal Component Analysis)抖动干扰:计算RGB三色通道的计算均值和标准差,在整个训练集上计算协方差矩阵,并分解得到特征向量和特征值,得到PCA抖动增强数据;5)高斯模糊添噪:对图像添加椒盐噪声和高斯噪声,模拟拍摄不同清晰度的样来,减少图像噪声感染及细节层次。各增强方法的预处理效果如图3所示。

图3 各数据增强预处理效果

2 多流高斯融合网络

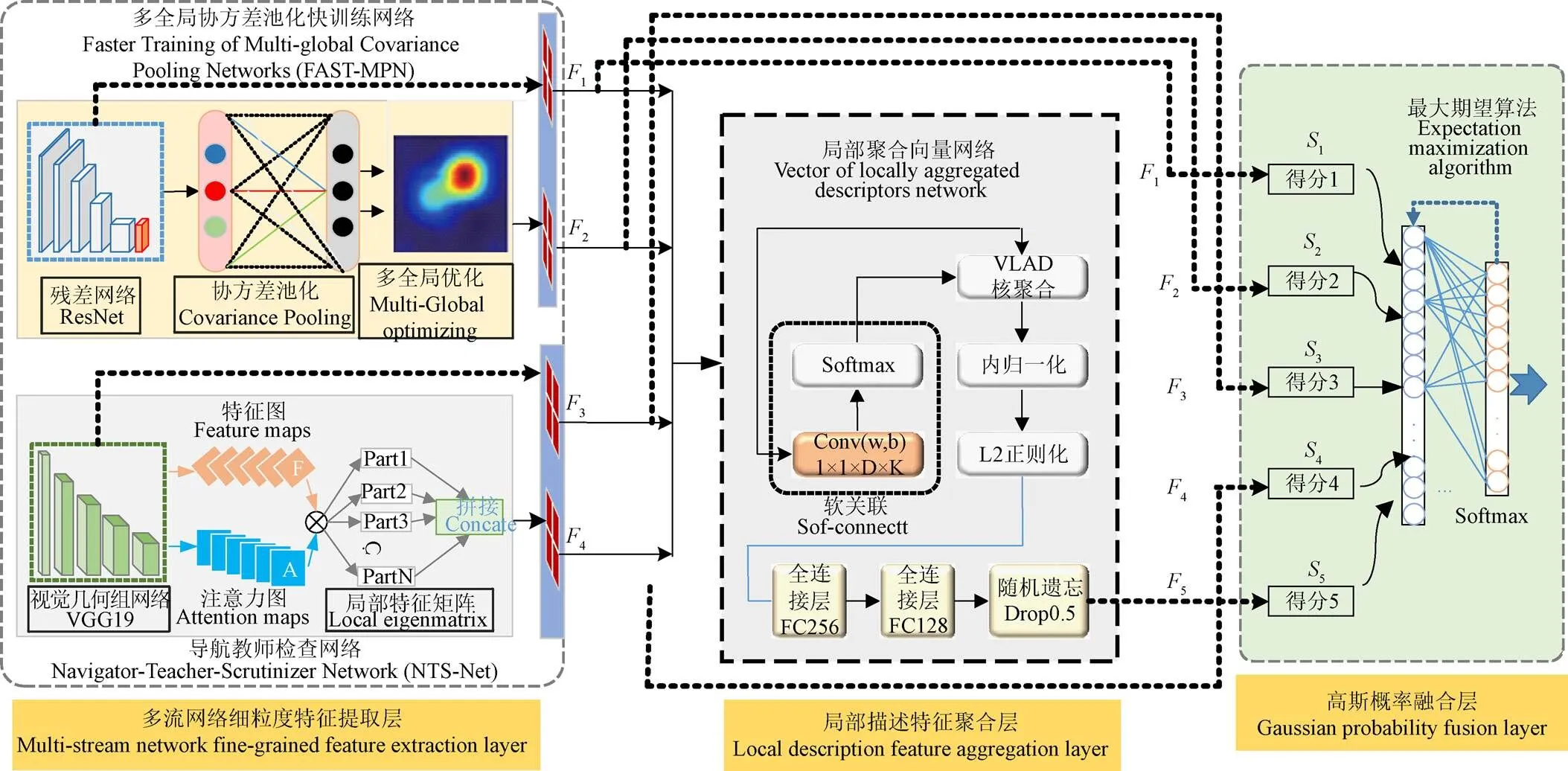

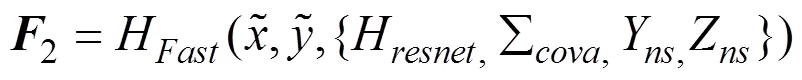

不同模型对不同病虫害识别能力存在差异,且多个模型对同一类识别偏好也存在不同,究其原因在于各模型所构造特征提取网络及概率决策存在固有差异。为了有效提取到图像的细粒度特征,本文综合多个无监督细粒度网络优势,构建多流并行的多维度特征提取结构,并设计了局部描述特征聚合层和高斯概率融合层,整合多模型的置信度结果,构建基于多流概率融合网络的农作物病虫害识别模型,发挥多模型融合互补及性能耦合的优势,提升辨识效率及鲁棒性,网络结构示意图如图4所示。

注:残差粗粒度特征F1,多全局协方差池化特征F2,视觉几何组粗粒度特征F3,细粒度局部特征F4,聚合特征向量F5,S1~S5表示各组成模型输出特征向量的概率得分(分别对应F1~F5).

2.1 多流网络细粒度特征提取层

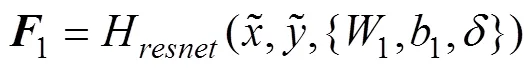

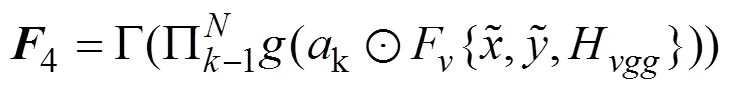

本研究MPFN网络模型的特征提取器由2个具有代表性的弱监督细粒度网络组成:FAST-MPN和NTS-Net。而2个细粒度模型的前置基础网络分别为ResNet50和VGG19,可以提取粗粒度的特征表达,本文在大规模通用数据集ImageNet上预训练这2个基础网络,再将其迁移到农作物病虫害数据集上进行训练,学习细粒度网络的模型参数及知识结构。本文对ResNet50模型进行了调整,去掉平均合并层、全卷积层和softmax层,使用3×3卷积代替输入中的7×7卷积,以降低计算成本,并允许输入更大的448×448尺寸的增强基准。同时,替换部分残差模块为Inception-v4[27]模块,且每个卷积层后和激活层前添加批处理归一化,改善单帧识别性能。得到残差粗粒度特征1。

而NTS-Net利用了VGG19网络为基础主干,将其输出的视觉几何组粗粒度特征3进行多次卷积和注意力叉操作,并行生成两幅结构大小相同的特征图和注意力图。而注意力图分成个,以反映第个局部对象的区域。将特征图与具有相同大小的每个注意图逐元素相乘,以生成个特征图,然后将其注入到局部特征提取函数()中,获得高判别性细粒度局部特征矩阵4

2.2 局部描述特征聚合层

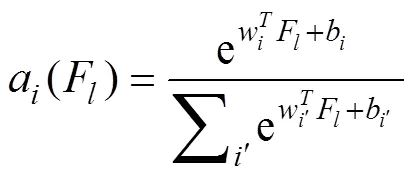

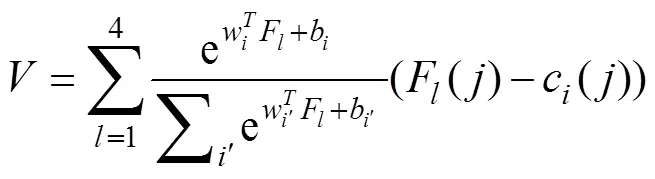

在特征提取之后,为了更好地进行分类,本文使用NetVLAD(Vector of Local Aggregated Descriptors Network)[28]对特征进行聚合;作为一种流行的用于图像识别和分类的描述符池化方法,NetVLAD捕获有关在图像上聚合的局部特征信息,并存储每个局部特征与其对应的聚类中心之间的残差总和;对每个图像的特征进行量化,并在最近的聚类中心聚合每个局部特征,量化后,特征空间被划分为多个单元子空间,其权重分配如下:

式中={1,2,3,4}对应多流特征提取层输出;代表第个聚类中心,′表示非聚类中心;w、b和w、b分别代表对应的训练阶段可更新参数;a(F)表示特征F对第个聚类中心的隶属关系;通过该软权重分配结合所有分量的特征和得到最终向量:

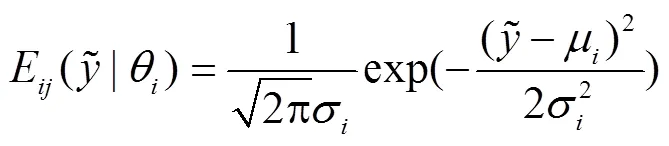

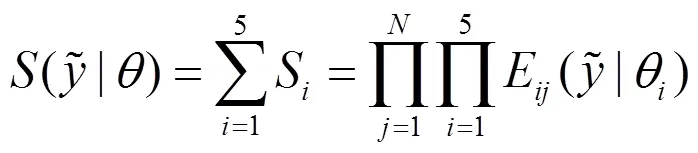

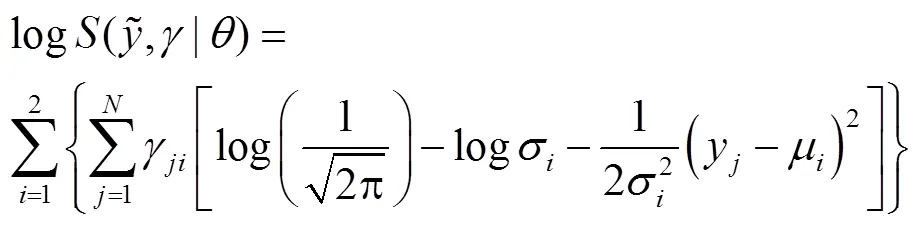

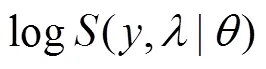

2.3 高斯概率融合层

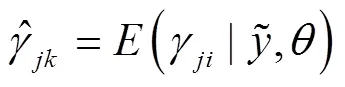

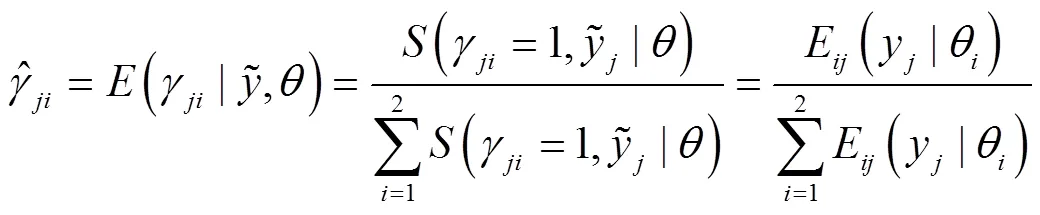

将前期提取、聚类的特征进行有效的融合是本文构建的融合模型的核心步骤;常见的融合方式有平均融合、拼接融合或者设置权重融合等线性融合方式,然而在实际的统计学分析中,本文融合模型MPFN的输出特征是符合正态分布的,因此对于其融合方式更加适用的是高斯融合方式;结合本地特征与试验经验,本文选择了高斯函数作为融合模块的融合函数;在此融合模块中,输入是多模型的各种特征,输出是高斯融合得到分类概率。而每个模型及其聚类后的输出预测概率:

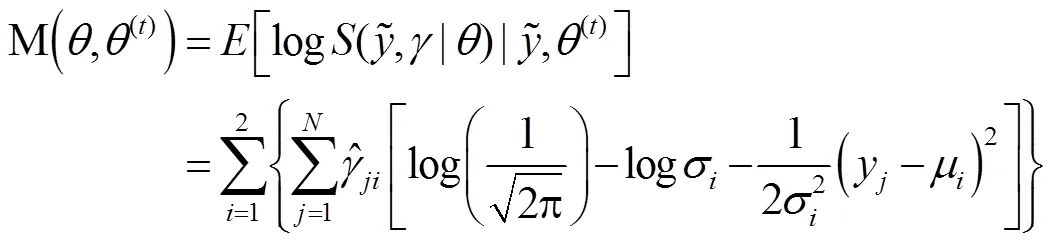

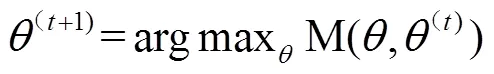

针对需要求解的超参数,本文使用最大期望算法(Expectation Maximization Algorithm)来迭代估计融合层参数。该算法分期望和估计2个步骤阶段。

否则,需要在每次迭代期间不断更新参数,迭代参数更新约束如下:

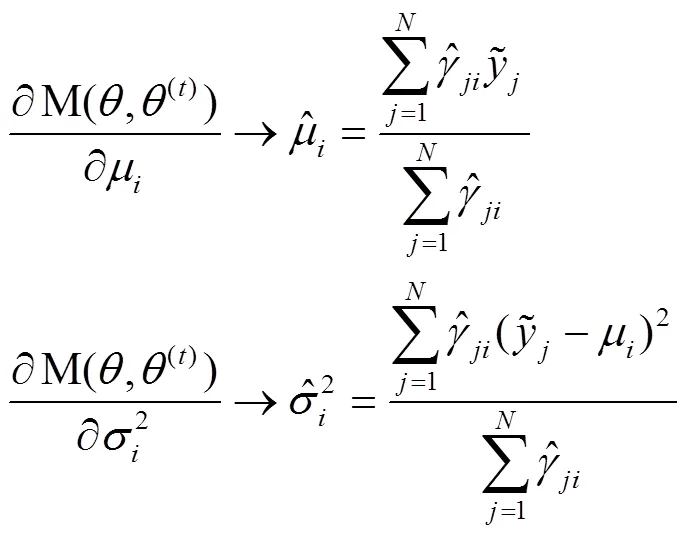

如果任何参数改变将不再导致M函数的进一步最小化,从而导致标记结果的最终估计,则终止从等式(10)到(13)这两步循环的整个过程;内部迭代循环位于用于参数估计的融合层内部,该循环在整个网络训练的每个外部前向循环中进行;因此,具有高斯混合优化的融合层是独立于其他层,但仍可以联合训练的方式通过整个概率融合模块进行相邻层反向传播梯度,与前端深度网络有效结合,达到端到端训练。通过上述操作,提出的融合模型从决策级角度获得了预测分数的整体表示,实际上是通过整合来自多流特征提取层每个组件模型与聚类层的多个先验概率,从而得出联合后验概率。最后,在融合层之后添加一个min-max归一化层和一个softmax层,以输出归一化的分类结果。当softmax算子获得预测概率时,交叉熵损失用于估计预测分数与真实标记之间的不一致程度;交叉熵损失的最佳解决方案是通过一些正则化约束将误差差距最小化到足够小的值;因此在训练过程中,本文优化了以下多部分损失函数:

3 结果与分析

3.1 试验环境设置

为了确保训练的可靠性,本文随机将病虫害数据集每类的10%(共11 433张)作为测试集,其余的113 004张作为训练和验证集,比例分别为80%和10%。在此划分基础上,本文以Ubuntu 16.04LTS为系统构建云服务器平台,该平台搭载双核Intel Core i7-8600@3.6 GHz x8 处理器、内存256 G及4×4T固态硬盘,显卡为4块NVIDIA Tesla p40 GPU,计算缓存为96 G,采用深度学习框架 Tensorflow1.4]和pytorch3.0。

3.2 试验结果比较

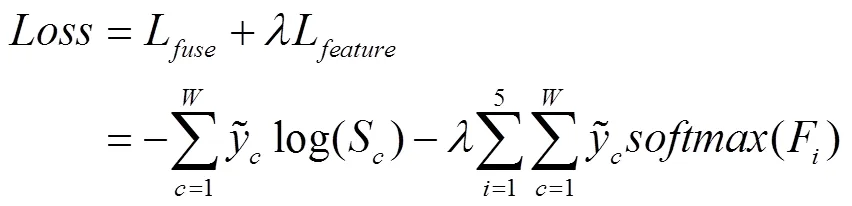

为验证MPFN模型性能优势,本文训练了多个对比模型,包括VGG19,ResNet50,Densenet121[29],SEnet[30]等多个粗粒度深度网络,以及基于VGG19、ResNet50前置网络的NTS-Net、FAST-MPN和DFL细粒度分类网络模型,评价参数采用平均精度均值(mean Average Precision,mAP)和平均单张识别时间(Average time of Single image Recognition,ASR),计算得到对比识别试验结果如表1所示。表中的精度代表识别正确的总数占测试集的百分比,时间表示单个测试图片所需的测试时间。

表1 对比试验结果

从表1中可以看出,对于细粒度病虫害而言,相比较细粒度模型,一般的深度神经网络识别出的精度并不是很高;与之对应的是,相比较单个细粒度模型,融合模型MPFN可以取得更好的识别结果,平均精度均值高达93.18%,比起FAST-MPN增加了5.6个百分点,比起NTS-Net也增加6.51个百分点。这说明有效融合策略将提升单个模型性能;而且在整体精度结果下,融合模型的平均单张识识别时间也只有61 ms,可以很好地解决细粒度病虫害图像识别问题,满足实际应用部署需求。

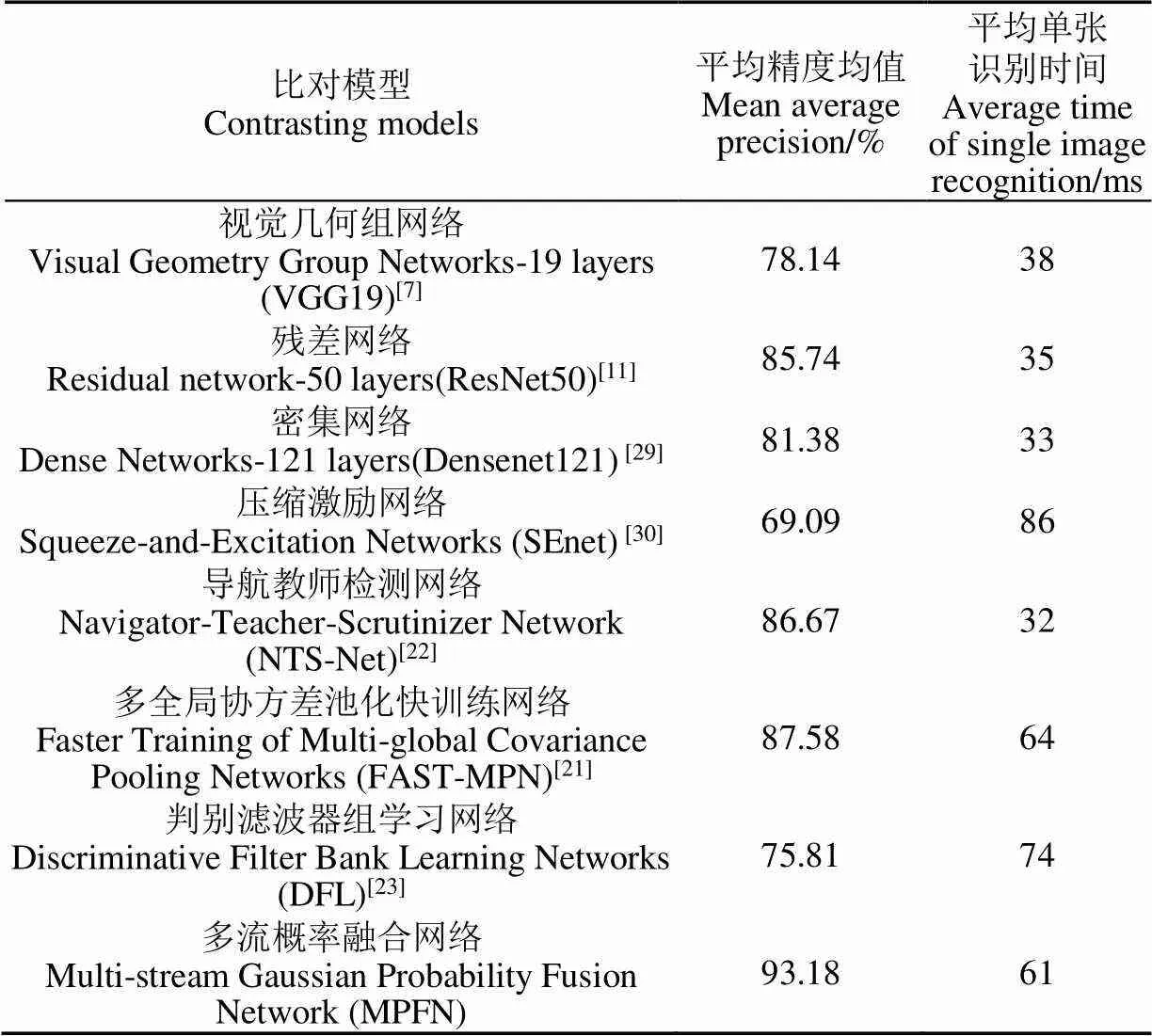

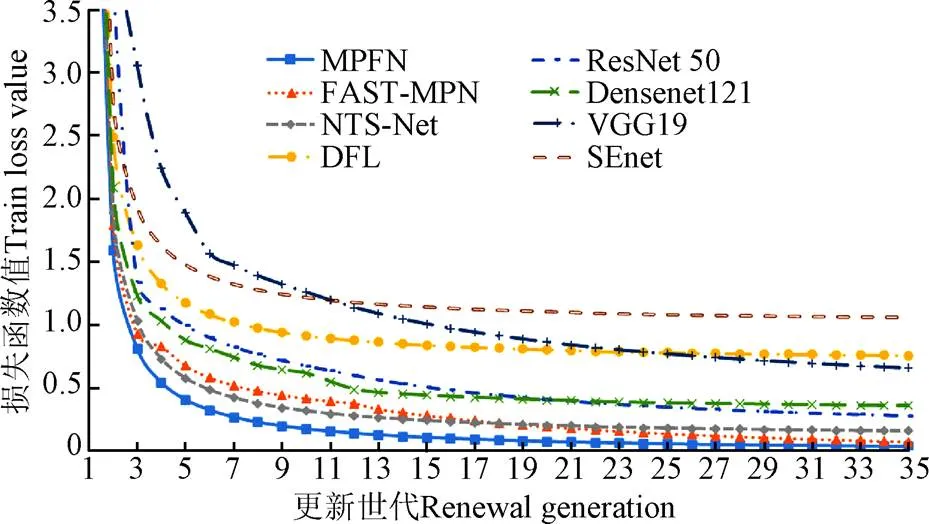

3.3 训练损失函数分析

为了进一步对比各模型的分类性能,本文对绘制损失函数结果,如图5所示。其他对比模型根据各文献提供,均使用Softmax交叉熵损失函数进行分析,而本模型使用式(14)的多部分损失函数进行计算。鉴于需要训练的病虫害数据有11.3万多张图片,依据试验服务器的硬件参数上限,设置训练批处理尺寸Batch_Size=400张,则完成一次更新世代(Update epoch)需要进行283次权重参数迭代(Iteration),迭代数量对应需要训练的批处理数量。经过35次更新世代(即9 900多次参数迭代),比较结果表明所有模型的损失函数趋势都有所降低,并均趋于收敛稳定。其中,ResNet 50,Densenet121和VGG19的损失函数在下降过程中波动较大,这说明传统粗粒度的深度学习网络对细粒度病虫害数据集较难适应,识别鲁棒性有待提升。而轻量化网络SEnet和细粒度网络DFL的损失函数虽然相对平稳,但其损失函数收敛值较大,对病虫害类别分辨能力相对低,并不适用于复杂环境下农作物病虫害细粒度识别应用。相比之下,NTS-Net和FAST-MPN的损失函数下降得更快、更平稳,这说明这2个网络的学习能力更强,选择其作为本文模型基础网络是科学合理的。最后,本文MPFN模型在训练损失方面取得较好结果,训练损失整体最小,而且收敛较快,对比其他模型及子模型可知,特征聚合融合和高斯概率融合可以在保障训练速度基础上,更有效提升模型的识别准确性和泛化鲁棒性,能够有效胜任实际场景应用的农作物病虫害细粒度识别工作。

图5 对比模型训练损失曲线

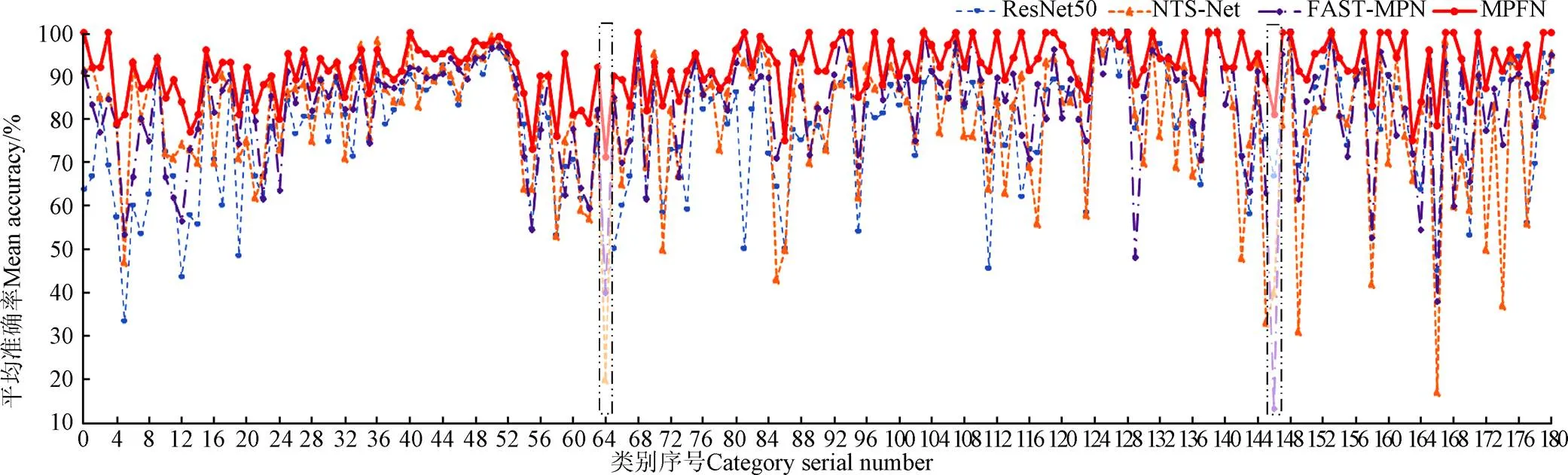

3.4 各类病虫害别辨识分析

根据试验得到的结果,对ResNet50,NTS-Net,Fast-MPN和融合模型的各个类别识别性能进行细致分析,如图6所示。单个模型对不同类别具有不同的识别能力,并且可以发现同一模型对于不同类别具有不同的准确性。尽管各个模型对不同类别具有不同的识别能力,但从融合模型的结果可以看出,融合模型结合并补充了不同图像的不同特征提取能力,从而提高每种图像的准确性。例如,ResNet50在类别0(长蠹科,Bostrichoidea)中的准确性为63.6%,在类别3(土蝽科,Cydnidae)中的准确性为69.2%;而Fast-MPN在类别0中的准确度为90.9%,在类别3中的准确度为84.6%;经过融合后,本文MPFN模型在类别0和类别3的准确性都高达100%,这说明本文融合策略可以使得单个模型对不同类别的识别能力的差异逐渐减小,有效排除模型间冗余,挖掘有效的细粒度特征描述能力,实现模型间输出觉得相互融合,从而提高了整体模型的辨识准确性。

图6 各模型对每类病虫害识别结果

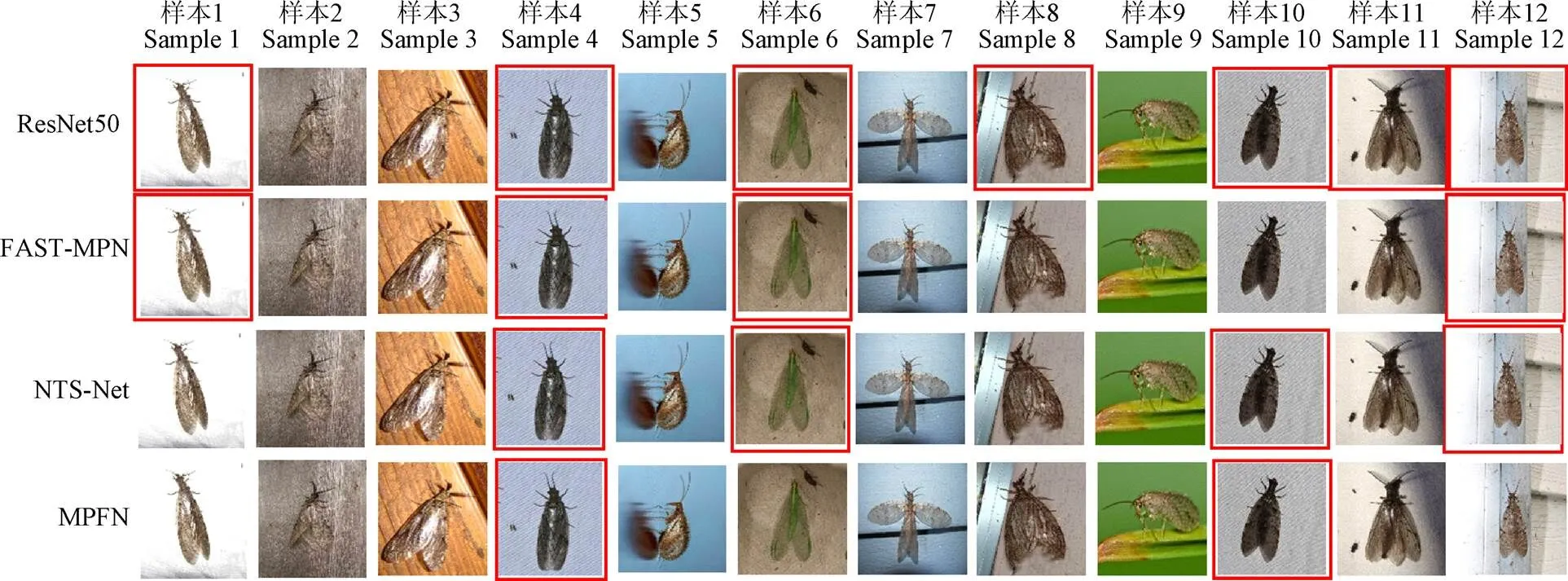

本文融合模型还具备从整体数据集中挖掘潜在关联知识能力,即使各个粗细粒度子模型在某些病虫害类别均表现很差,高斯概率融合可以有效解决弥补子模型都差影响最终结果也差的问题。例如,在类别5(叶甲科,Chrysomelidae)中,Resnet50、NTS-Net和Fast-MPN的准确性分别只有33.3%、47.1%和53.3%,这意味着和象甲科、拟象甲科形态相似的叶甲科,无法被常规模型进行有效细粒度区分,而本文模型则取得81.1%的准确率,相比子模型提高了27.8%~47.8%。类似的情况,在类别64(尺蠖蛾科,Geometridae)和类别146(樱桃叶白粉病害严重态,Cherry powdery mildew serious)更是明显,在尺蠖蛾科识别上,ResNet50、和Fast-MPN的识别准确性分别是有40.1%和40.3%,而NTS-Net准确率甚至只有20.5%,而融合后模型可以获得达到71.2%,效果明显提升,这也间接说明该病虫害类别的图像数据本身较难辨识。具体而言从数据观察,如图7所示,随机选取该类别12个图片样本进行对比分析,红色框柱的代表模型识别错误的图片,其余代表识别正确的图像,其他3个子模型识别时容易出错,而本文方法则明显提升识别性能、降低错误情况。

图7 尺蠖蛾科的各模型识别结果对比

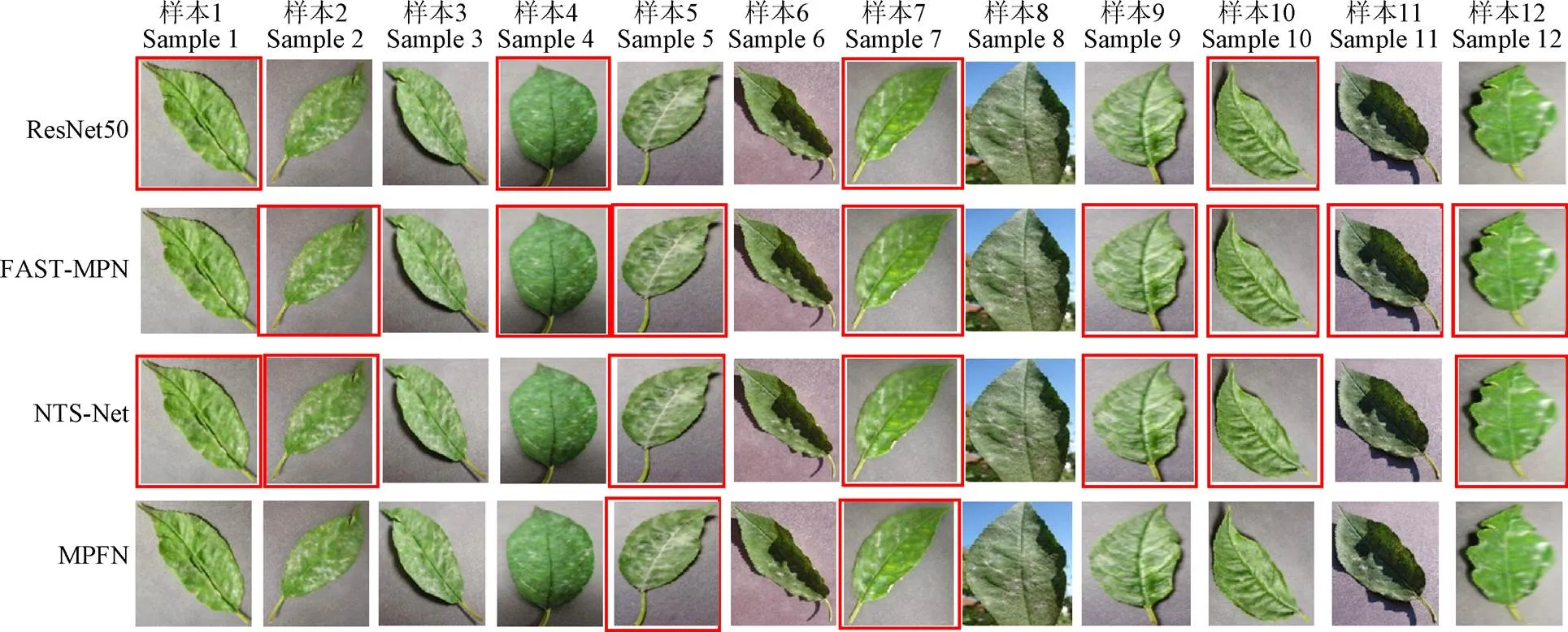

不同的是,在类别146的樱桃叶白粉病害辨识方面,粗粒度网络ResNet50识别率则依旧保持在66.7%,而细粒度的NTS-Net和Fast-MPN的识别率则降低到40%和13.3%,这说明在缺乏有效融合情况下,细粒度网络有时反而会限制深度神经网络的非线性拟合表征和分类辨识性能;结合上述2个类别对比分析,两个细粒度子模型在病害和虫害的表现正好相反,进一步揭示了不同模型对于不同病虫害类别的识别能力偏差较大,也在一定程度上反映单个模型在病虫害细粒度辨识上存在的鲁棒性、泛化性不足。而经过高斯概率融合优化后,本文模型识别率则高达81.1%,更加侧重于多模型的有机兼容,不会出现过大的误差是其核心优点之一(如图8所示)。

图8 樱桃叶白粉病害严重态的各模型识别结果对比

总的来说,从各类别病虫害辨识角度而言,由于本文融合策略提升了整个模型对所有类别识别精度,也加强了其泛化性和鲁棒性,更加适应实际农业场景下复杂细粒度辨识应用,保证总体精度更进一步提升。

4 结 论

针对复杂农业场景中广泛存在的病虫害及其难以被细粒度辨识的复杂问题,本文利用多种农业物联网设备采集12.2万张图像,构建适用于实际农业的181类病虫害细粒度数据集。在数据增强基础上,本文设计多流网络并行的粗细粒度特征提取结构,经过各个子模型特征向量的局部特征聚合分析和高斯概率融合,构建一种多流高斯概率融合网络的农作物病虫害细粒度识别模型(MPFN),经过最大期望算法迭代优化,可以实现端到端的模型训练和快速收敛。对比试验表明,本文模型具有较高的识别性能,平均精度高达93.18%,效率及鲁棒性能优于其他对比深度网络方法,而平均单张识别时间为61 ms,能够满足农业生产实践中物联网各终端病虫害细粒度识别需求,且对各类病虫害均能有效区分,具有更好的鲁棒性和泛化性,可对农户科学、合理、有效地预警防治植物病虫害起到积极的作用,也为细粒度识别拓展在实际农业生产应用提供理论和技术基础。

[1] 王翔宇,温皓杰,李鑫星等. 农业主要病害检测与预警技术研究进展分析[J]. 农业机械学报,2016,47(9):266-277.

Wang Xiangyu, Wen Haojie, Li Xinxing et al. Research progress analysis of mainly agricultural diseases detection and early warning technologies[J]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(9): 266-277. (in Chinese with English abstract)

[2] 赵春江. 智慧农业发展现状及战略目标研究[J]. 智慧农业,2019,1(1):1-7.

Zhao Chunjiang. State-of-the-art and recommended developmental strategic objectives of smart agriculture [J]. Smart Agriculture, 2019, 1(1): 1-7. (in Chinese with English abstract)

[3] Ramesh S, Rajaram B. Iot based crop disease identification system using optimization techniques[J]. ARPN J. Eng. Appl. Sci, 2018, 13: 1392-1395.

[4] 贾少鹏,高红菊,杭潇. 基于深度学习的农作物病虫害图像识别技术研究进展[J]. 农业机械学报,2019,50(S1):313-317.

Jia Shaopeng, Gao Hongju, Hang Xiao. Research progress on image recognition technology of crop pests and diseases based on deep learning[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(S1): 313-317. (in Chinese with English abstract)

[5] Mohanty S P, Hughes D P, Salathé M. Using deep learning for image-based plant disease detection[J]. Frontiers in Plant Science, 2016, 7: 1-10.

[6] Konstantinos F P. Deep learning models for plant disease detection and diagnosis[J]. Computers and Electronics in Agriculture, 2018, 145: 311-318.

[7] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[J]. arXiv preprint: 1409.1556, 2014.

[8] 张建华,孔繁涛,吴建寨,等. 基于改进VGG卷积神经网络的棉花病害识别模型[J]. 中国农业大学学报,2018,23(11):161-171.

Zhang Jianhua, Kong Fantao, Wu Jianzhai, et al. Cotton disease identification model based on improved VGG convolution neural network[J]. Journal of China Agricultural University, 2018, 23(11): 161-171. (in Chinese with English abstract)

[9] Alvaro F, Yoon S, Kim S C, et al. A robust deep-learning-based detector for real-time tomato plant diseases and pests recognition[J]. Sensors, 2017, 17(9): 2022.

[10] Wu X, Zhan C, Lai Y K, et al. Ip102: A large-scale benchmark dataset for insect pest recognition[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2019: 8787-8796.

[11] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2016: 770-778.

[12] Zheng Y Y, Kong J L, Jin X B, et al. CropDeep: the crop vision dataset for deep-learning-based classification and detection in precision agriculture[J]. Sensors, 2019, 19(5): 1058.

[13] 龙满生,欧阳春娟,刘欢,等. 基于卷积神经网络与迁移学习的油茶病害图像识别[J]. 农业工程学报,2018,34(18):194-201.

Long Mansheng, Ouyang Chunjuan, Liu Huan, et al. Image recognition of Camellia oleifera diseases based on convolutional neural network & transfer learning[J]. Transactions of the Chinese Society of Agricultural Engineering, 2018, 34(18): 194-201. (in Chinese with English abstract)

[14] 张博,张苗辉,陈运忠. 基于空间金字塔池化和深度卷积神经网络的作物害虫识别[J]. 农业工程学报,2019,35(19):209-215.

Zhang Bo, Zhang Miaohui, Chen Yunzhong. Crop pest identification based on spatial pyramid pooling and deep convolution neural network[J]. Transactions of the Chinese Society of Agricultural Engineering, 2019, 35(19): 209-215. (in Chinese with English abstract)

[15] 杨国国,鲍一丹,刘子毅. 基于图像显著性分析与卷积神经网络的茶园害虫定位与识别[J]. 农业工程学报,2017,33(6):156-162.

Yang Guoguo, Bao Yidan, Liu Ziyi. Localization and recognition of pests in tea plantation based on image saliency analysis and convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering, 2017, 33(6): 156-162. (in Chinese with English abstract)

[16] 刘洋,冯全,王书志. 基于轻量级CNN的植物病害识别方法及移动端应用[J]. 农业工程学报,2019,35(17):194-204.

Liu Yang, Feng Quan, Wang Shuzhi. Plant disease identification method based on lightweight CNN and mobile application[J].Transactions of the Chinese Society of Agricultural Engineering, 2019, 35(17): 194-204. (in Chinese with English abstract)

[17] Zheng Y Y, Kong J L, Jin X B, et al. Probability fusion decision framework of multiple deep neural networks for fine-grained visual classification[J]. IEEE Access, 2019, 7: 122740-122757.

[18] Wei X S, Wu J, Cui Q. Deep learning for fine-grained image analysis: A survey[J]. arXiv preprint:1907.03069, 2019.

[19] 边小勇,江沛龄,赵敏,等. 基于多分支神经网络模型的弱监督细粒度图像分类方法[J]. 计算机应用,2020,40(5):1295-1300.

Bian Xiaoyong, Jiang Peiling, Zhao Min, et al. Multi-branch neural network model based weakly supervised fine-grained image classification[J]. Journal of Computer Applications, 2020, 40(5): 1295-1300. (in Chinese with English abstract)

[20] Song K, Yang H, Yin Z. Multi-Scale attention deep neural network for fast accurate object detection[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2018, 29(10): 2972-2985.

[21] Yang Z, Luo T, Wang D, et al. Learning to navigate for fine-grained classification[C]//Proceedings of the European Conference on Computer Vision (ECCV). 2018: 420-435.

[22] Li P, Xie J, Wang Q, et al. Towards faster training of global covariance pooling networks by iterative matrix square root normalization[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 947-955.

[23] Wang Y, Morariu V I, Davis L S. Learning a discriminative filter bank within a CNN for fine-grained recognition[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 4148-4157

[24] 郭小清,范涛杰,舒欣. 基于改进Multi-Scale AlexNet的番茄叶部病害图像识别[J]. 农业工程学报,2019,35(13):162-169.

Guo Xiaoqing, Fan Taojie, Shu Xin. Tomato leaf diseases recognition based on improved Multi-Scale AlexNet [J]. Transactions of the Chinese Society of Agricultural Engineering, 2019, 35(13): 162-169. (in Chinese with English abstract)

[25] Amanda R, McCloskey P, Baranowski K, et al. A mobile-based deep learning model for cassava disease diagnosis[J]. Frontiers in plant science, 2019, 10: 272.

[26] Lin Z, Mu S, Huang F, et al. A unified matrix-based convolutional neural network for fine-grained image classification of wheat leaf diseases[J]. IEEE Access, 2019, 7: 11570-11590.

[27] Szegedy C, Ioffe S, Vanhoucke V, et al. Inception-v4, Inception-ResNet and the impact of residual connections on learning[J]. arXiv preprint:1602.07261, 2017.

[28] Arandjelovic R, Gronat P, et al. NetVLAD: CNN architecture for weakly supervised place recognition[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2016: 5297-5307.

[29] Huang G, Liu Z, Van D M, et al. Densely connected convolutional networks[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2017: 4700-4708.

[30] Hu J, Shen L, Sun G. Squeeze-and-excitation networks[C]// Proceedings of the IEEE conference on computer vision and pattern recognition, 2018: 7132-7141.

Fine-grained recognition of diseases and pests based on multi-stream Gaussian probability fusion network

Kong Jianlei1,2,3, Jin Xuebo1,2,3※, Tao Zhi1, Wang Xiaoyi1,2,3, Lin Sen3,4

(100048,; 2.100048,; 3.100048;4.100097,)

Accurate identification of diseases and insect pests has been the key link to the yield, quality and safety of crops in modern agriculture. However, the same category of diseases and insect pests showed obvious differences in intra-class representation and slight similarities in inter-class representation of various diseases, due to the influence of environmental conditions, disease cycle and damaged tissues. At present, the traditional deep transfer learning methods have been difficult to cope with large-scale, multi-class fine-grained identification of pests and diseases, particularly unsuitable to the practice in complicated scenes. This paper aims to apply multiple source cameras in agricultural Internet of Things (IoT) and different intelligent precision equipment, including picking robots and smart phones, to capture high resolution 122,000 images of insect pests and diseases, covering a total of 181 fine-grained categories, including 49 types pests and 77 types diseases on different plant parts of different crops. A fine-grained recognition model was then proposed for pests and diseases based on the Multi-Stream Gaussian Probability Fusion Network (MPFN). In detail, a data-augmented method was first employed to enlarge the dataset, and then to pretrain the basic VGG19 and ResNet networks on high-quality images, in order to learn common and domain knowledge, as well fine-tuning with professional skill. Next, the refined multiple deep learning networks, including Fast-MPN and NTS-Net with transfer learning, were applied to design a multi-stream feature extractor, utilizing the mixture-granularity information to exploit high-dimensionality features, thereby to distinguish interclass discrepancy and tolerate intra-class variances. Finally, an integrated optimization was developed combining the NetVLAD feature aggregation layer with the gaussian probability fusion layer, in order to fuse various components model with Gaussian distribution as a unified probability representation for the ultimate fine-grained recognition. The input of this module was the various features of multi-models, whereas, the output was the fused classification probability. The end-to-end implementation of framework included an inner loop about the expectation maximization algorithm within an outer loop with the gradient back-propagation optimization of the whole network, indicating multi-model fusion information complementation and confidence for the overall model. The experimental results demonstrated that the MPFN model presented the excellent performance in the average recognition accuracy rate of 93.18% for a total of 181 classes of pests and diseases, indicating 5.6 percentage points better than that of the coarse-grained and fine-grained deep learning methods. In terms of test time, the average processing time of the MPFN was 61ms, indicating the basic needs of fine-grained image recognition of pests and diseases at the terminals of the IoT and intelligent equipment. In the contradistinctive analysis, training loss curves and various sub-categories identification showed that the feature aggregation fusion and Gaussian probability fusion can greatly enhance the efficiency of model with the training speed, recognition accuracy and generalized robustness for fine-grained identification of crop pests and diseases in practical scenarios. Therefore, this work can provide a technical application reference for the intelligent recognition of pests and diseases in agricultural production. In the follow-up study, more images will be taken under natural conditions to develop a more robust MPFN model deployed on actual IoTs or equipment for the pre-warning, prevention, and control of crop pests and diseases in modern agriculture.

agriculture; image recognition; diseases and pests; deep neural network; feature aggregation; Gaussian probability fusion

孔建磊,金学波,陶治,等. 基于多流高斯概率融合网络的病虫害细粒度识别[J]. 农业工程学报,2020,36(13):148-157.doi:10.11975/j.issn.1002-6819.2020.13.018 http://www.tcsae.org

Kong Jianlei, Jin Xuebo, Tao Zhi, et al. Fine-grained recognition of diseases and pests based on multi-stream Gaussian probability fusion network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(13): 148-157. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2020.13.018 http://www.tcsae.org

2020-03-04

2020-04-02

国家重点研发计划(2017YFC1600605);北京市教育委员会科技计划一般项目(KM201910011010);国家自然基金项目(61673002, 61903009 );

孔建磊,博士,副教授,主要从事农业深度迁移学习和计算机视觉研究。Email:kongjianlei@btbu.edu.cn

金学波,博士,教授,主要从事信息融合、大数据分析、时序预测预警等研究。Email:jinxuebo@btbu.edu.cn

10.11975/j.issn.1002-6819.2020.13.018

S5-33,S24

A

1002-6819(2020)-13-0148-10