基于深度强化学习的OFDMA-PON三维资源分配研究与性能分析

2020-08-01顾家骅晏春平周怡君顾萍萍

陈 斌 顾家骅 朱 敏 晏春平 周怡君 顾萍萍

(1.东南大学 电子科学与工程学院,江苏 南京 210096;2.东南大学 移动通信国家重点实验室,江苏 南京 210096;3.太仓市同维电子有限公司 江苏 太仓 215400,4.东南大学 机械工程学院,江苏 南京 210096)

0 引言

随着各种新兴多媒体业务对网络带宽需求的日益增长,高效经济的无源光网络(PON)已经成为了“最后一公里”宽带接入的一种成熟技术,在全球范围内得到了广泛铺设[1].近年来,正交频分复用(OFDM)技术在光网络研究领域获得了令人瞩目的发展势头[2].OFDM技术利用正交性,将发送的信号划分为几十个,乃至数百个低速率、部分重叠但互不干扰的子载波信号[3].由于具有大容量、高效灵活的多地址访问、高频谱效率等优点,基于OFDM技术的正交频分多址无源光网络(OFDMA-PON)已经成为下一代光接入网络有前途的解决方案之一[2,3].

通常,OFDMA-PON中每个子载波所承载的比特率远低于单个波长的比特率,也远低于一个光网络单元(ONU)的平均速率[2].这就意味着,要为每个ONU提供所需的带宽,这就需要将多个子载波组合在一起,共同为该ONU提供载波服务.在可用频谱资源有限的情况下,服务于每一个ONU的子载波数量就要加以控制,否则会影响OFDMA-PON所提供的服务质量(QoS),如延迟性能.我们知道,采用高阶调制格式可以提高频谱利用率,有助于减少所需的子载波的数量,进而改善延迟性能[5].然而,为了保证一定的传输质量,高阶调制格式往往需要更多发射能量.据研究报道,ONU的功耗占OFDMA-PON能耗的60%至70%[6]. 在实际应用中,尽可能降低网络能耗,也是人们不断追求的目标之一. 因此,在OFDMA- PON中,考虑到调制格式配置的动态子载波分配(DSA)算法会极大地影响网络性能,如信道利用率、业务延迟和网络能耗等[4].

为了提高OFDMA-PON资源分配的效率,早期工作[3,4,7-9]主要基于二维资源的联合DSA算法被提出,即时隙(TS)和子载波(SC)的分配.文献[3]在OFDMA-PON提出了一种加权DSA调度算法来减少终端无线数据包延迟.文献[4]提出的算法在动态带宽分配上结合了流量预测技术来降低延迟.文献[7]针对OFDMA-PON的上行资源分配问题,利用离线调度框架来分析子载波信道利用率和总授权时间.文献[8]提出了一种在距离自适应OFDMA-PON中的公平感知DSA算法.文献[9]提出了一种异构OFDMA-PON中的动态带宽分配框架,并开发了基于权重分布的ONU调度新算法.但是,以上这些DSA算法都没有考虑子载波调制格式的灵活分配,也没有考虑ONU发射功率的优化配置.

文献[5]考虑了OFDMA-PON中时隙TS,子载波SC和调制格式这三维资源,通过在每个时隙中实现子载波和调制格式的最佳分配,来最小化ONU的发射功率.文献[6]同样研究了虚拟子载波(VS),TS和调制格式的联合分配,通过多维资源的灵活重配置来最大程度地节省能耗.文献[10]通过共享OFDM调制模块来提高波分复用正交频分复用-无源光网络(WDM-OFDM-PON)的能量效率.文献[11]提出一种距离自适应带宽分配方案,实现低成本大容量长距离OFDMA-PON.但是上述这些方案并未考虑OFDMA-PON所需满足的服务质量,如ONU请求业务延迟.

最近,深度强化学习(DRL)已成功地应用于资源管理的一些复杂决策问题,在提高通信网络性能方面引起了学术界和工业界的广泛关注.文献[12,13]中研究了5G网络中基于深度强化学习的切片准入策略,以最大程度地提高基础架构提供商的利润.文献[14]从广义的角度,针对网络多种资源优化配置问题,演变成“装箱”问题,并通过DRL工具来解决,以最大程度地减少工作延迟.文献[15]提出了一种基于DRL的C-RAN中的联合BBU布局和路由策略,以最大程度地利用资源.文献[16]提出了一种基于DRL的策略来提高弹性光网络环境下的网络整体性能.

在本文中,据我们所知,我们首次应用DRL技术来解决OFDMA-PON中的动态子载波分配DSA问题. 提出的基于DRL的DSA算法可以根据不同ONU请求的带宽需求,联合动态分配可用的子载波数量、时隙和调制格式,以最大程度地降低ONU功耗和ONU请求的延迟.

1 系统模型与问题建立

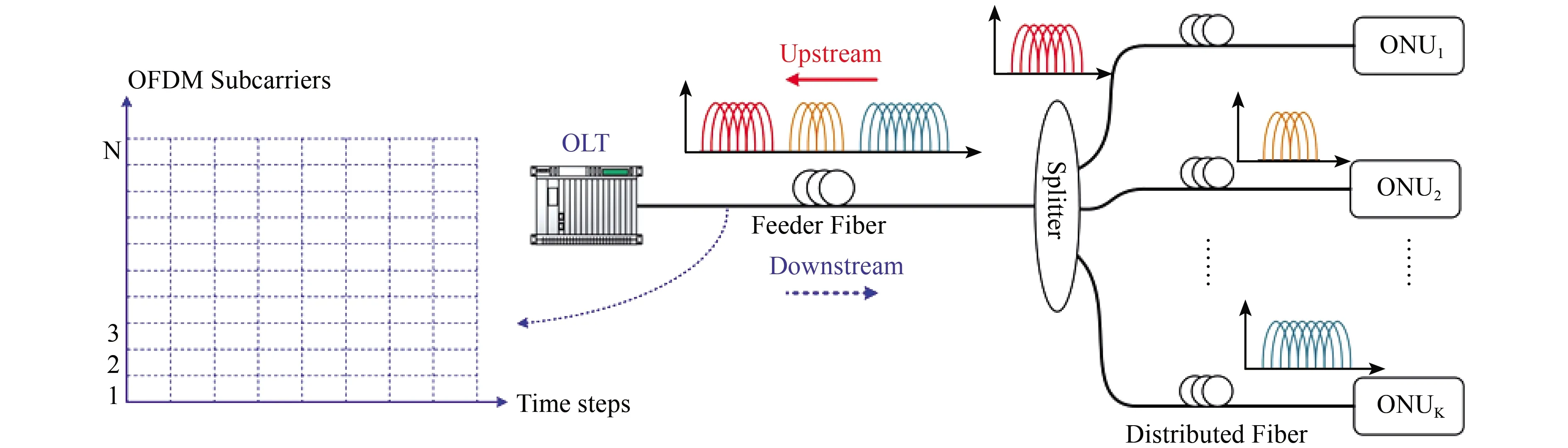

图1显示OFDMA-PON系统的物理架构. OFDMA-PON系统具有3个组成部分:位于中心局(CO)的光线路终端(OLT),基于光分离器(Splitter)的无源光分配网络(ODN)和位于用户端的多个ONU.OLT通过ODN将来自中心局的下行业务数据流广播给每个ONU.ONU有选择地接收由OLT广播的下行数据,并将其发送给用户.OLT通过ODN从每个ONU收集上行数据.上/下行数据业务通过多个OFDM子载波进行传输. 在本文中,我们专注于OFDMA-PON系统的上行链路传输,其中OFDM符号由正交子载波承载,为不同的ONU选择不同的调制格式,分配不同的时隙和子载波信道,每个子载波信道包括一个或多个子载波SC.

图1 OFDMA-PON系统结构

首先本文对OFDMA-PON系统进行建模,一共有N个子载波SC和K个ONU,并且每个SC在每个时隙内只能被一个ONU占用.一个ONU所使用的多个SC必须是相邻的,并且这些SC的开始/结束时间均相等.因此,如图2所示,可以将分配每个ONU的SC和TS资源,表示为一个矩形.而且,对于某一个ONU业务请求来说,采用不同的调制格式,所需的子载波的数量会发生变化,表示分配资源的矩形也会发生变化.因此,ONU的发射功率和整体平均延迟也将有所不同.例如,如果ONU选择一个低阶的调制格式,虽然ONU的发射功率会较低,但分配给该ONU的子载波数量就会增加,从而产生较高的业务延迟.反之亦然.由此可见,调制格式的不同选择,使得ONU的发射功率和ONU的平均延迟是相互联系的.要在OFDMA-PON中实现高效的DSA算法,需要谨慎的时隙TS,子载波SC和调制格式的联合分配.

图2 三个可选调制格式下的两个待处理的ONU请求的状态表示示例

bk表示为分配给第k个ONU的某种调制格式,同时也表示为在这种调制格式下,每一个OFDM调制符号所代表的比特数.bk取值为1,2,…,M,其中M是每个OFDM调制符号代表的最大比特数.这表明对应的调制格式是从BPSK到2M-QAM.本文假设分配给一个ONU的所有子载波的调制格式都相同.

如文献[6]中所述,电功率占ONU的总发射功率的很大一部分,因此本文也同样忽略了ONU的光功率.在一个时隙TS内,Pk表示第k个ONU支持给定误码率(BER)Pe下的bk比特/符号,单个子载波SC所需的发射功率[6]

(1)

(2)

其中Tk是第k个ONU请求的持续时间,ceil上取整函数表示为第k个ONU所需的子载波数,Rk是第k个ONU的数据速率请求(单位为比特),fSC是每一个子载波SC所占据的频谱带宽(单位为Hz). 式(2)可见bk的值越大,说明采用越高阶的调制格式,频谱利用率越大,所需的子载波频谱资源SC就越少,可以让更多的ONU业务请求得到SC资源分配,从而降低业务的平均延迟时间;但要满足一定的BER要求,所需要ONU信号发射功率也会增加(可由式(1)所示),反之亦然.

我们的优化目标是,为每一个ONUk∈{1,2,…,K}分配最优的bk,从而联合最小化ONU请求的平均等待时间和平均发射功率.

(3)

2 深度强化学习模型

如图3所示,深度强化学习方法是一个典型的马尔可夫决策过程[13].强化学习的目标是:给定一个马尔可夫决策过程,寻找最优策略.DRL中的学习者或决策者被称为代理,与代理交互的代理外的所有部分,被称为环境.代理选择某些动作,然后环境响应这些动作并向代理反映新的环境.代理和环境在一系列离散时间步骤中相互作用相互影响.具体地说,在每一个时间步t,代理会观察一些状态St,并在当前状态的基础上选择一个动作At.在一个时间步以后,作为该动作的结果,代理接收到新的奖励Rt+1,并且环境的状态转换为St+1.在马尔可夫决策过程中,St+1和Rt+1的每个可能值的概率仅取决于紧接在前的状态St和动作At.状态必须包括有关过去的代理和环境互动所有方面的信息.

图3 强化学习中基于深度神经网络(DNN)策略的代理-环境交互

本节利用DRL策略网络,经过不断地迭代训练,为每一个ONUk分配最优调制格式bk,以最大程度地减少ONU请求的平均业务延迟和平均功耗.DRL算法可以生成大量训练数据,同时将复杂的系统和决策建模为深度神经网络.下面将定义DRL策略网络的三要素:状态,动作和奖励.

状态:不同的图像表示系统的状态,包括当前已分配的系统资源情况,等待配置的ONU请求信息,以及在待办事项队列(Backlog Queue)中的候选配置的ONU请求信息.图2中最左边的图像表示已分配的ONU请求,并从当前时间步开始,持续T时间步,直到所有ONU请求配置完成.这些图像中的不同颜色表示不同的ONU请求.例如,图2的已分配方案中,红色图块表示已成功配置的2个TS、2个SC的ONU请求.等待配置的ONU请求图像表示采用不同的调制方式所需分配的SC和TS资源.例如,图2右侧为等待配置中的ONU请求图像,当采用不同调制格式时,所需的SC和TS资源要求也不同.ONU请求1(Request Slot 1)要求两个TS的持续时间,当采用BPSK调制格式时,需要4个SC资源,当采用4-QAM时,则需要2个SC资源,或采用8-QAM时,则仅仅需要1个SC资源.按照先来先处理的原则,按序处理Backlog Queue中最先到达的d个ONU请求,以使代理中的神经网络输入可以表示为有限且固定的状态(图2中d=2)[14].这样,不仅可以减少延迟,还可以限制动作空间,从而使强化学习更加有效.

动作:在每个时间步,代理中的调度程序可以调度d个ONU请求的任何子集,并有M种可选的调制格式(一个ONU请求仅选择一种调制格式).这就需要2^(d×M)的动作空间,这个动作空间非常大,可能会使强化学习非常具有挑战性.在图2中,为了大大降低动作空间的规模,可以允许调度程序在每个时间步执行多个动作.给定动作空间由{∅,1×1,1×2,…,i×j,…,d×M}表示,其中元素a=i×j表示调度程序选择第i个请求槽中ONU请求,并采用第j种调制格式,并试图把该请求的资源块放置在SC和TS资源图像中的适当位置;a=φ表示在当前时间步中调度程序选择到无效动作,即不选择任何ONU请求进行资源配置.当调度程序选择到无效动作或当前可用资源不能满足ONU请求时,时间步长向前移动一步,可用资源图像也向上移动一步.新到达的ONU请求将通知调度程序并同时对请求槽状态进行更新.

这样,调度程序可以在同一时间步执行多个动作,完成多个ONU请求的配置,使得动作空间保持线性(d×M)[14].

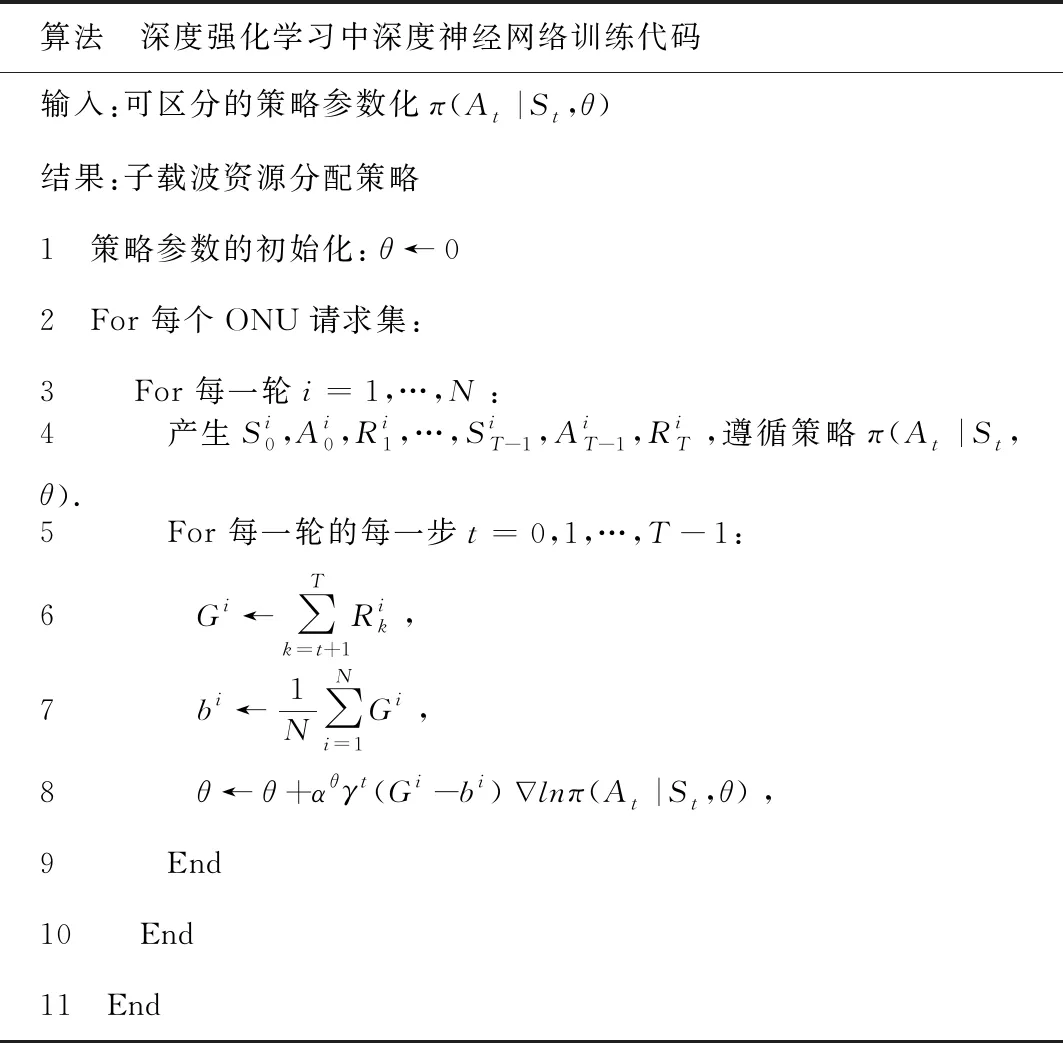

奖励:通过奖励来给代理提供反馈,以寻求实现所需目标的最佳策略.优化目标是通过为所有ONU请求联合分配时隙TS、子载波SC和调制格式,尽可能减少ONU请求的平均业务延迟和平均功耗.在单个时间步t中,强化学习奖励设置为

(4)

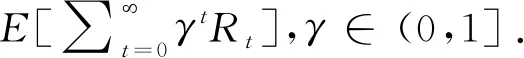

本文通过很多轮迭代来训练代理中的策略网络.在每一轮迭代中,固定数量的ONU请求到达并根据策略进行资源配置.当所有ONU请求都执行完成时,本轮训练终止.表1显示了深度神经网络训练算法的伪代码.为了训练出通用的策略,训练过程中随机生成多个ONU请求集(第2行),对每个ONU请求集进行多轮探索(第3行),使用当前探索策略,以得到可能的动作概率空间,选择某一种动作,并使用产生的奖励值来进一步改进探索策略.具体地说,我们记录每轮探索所有时间步的状态,动作和奖励信息,并使用这些值来计算每一轮探索每个时间步t的累积折扣奖励.

表1 训练算法伪代码

3 实验结果

3.1 仿真参数

仿真参数设置:ONU请求根据伯努利过程到达,到达率λ(即每个时间步到达一个新的ONU请求的概率)从0到 1变化,步长为0.1.本文考虑32个SC通道,总带宽为1.28 GHz,则每一个子载波SC通道带宽为0.04 GHz.每一个ONU请求可选择调制格式为4种:BPSK,4-QAM,8-QAM和16-QAM.优化目标中两个指标的权重设置为相同,α=β=0.5.ONU请求的持续时间设置为:80%ONU请求的持续时间在1t和3t之间均匀选择;而其余的20%ONU请求从10t到15t之间均匀选择.ONU的带宽需求Rk设置在(0.32,4.48)Gb/s范围内均匀分布.

在该算法中,本文使用具有33个神经元的完全连接的隐藏层和总共532323个参数的神经网络.DRL代理使用的“图像”长20个时间步,每次仿真持续50个时间步.在当前时间步,代理只调度最先达到的d个ONU请求(d=8),采用不同调制格式,同时也不断更新在待办事项队列中的ONU请求. 待办事项队列的长度设置为64个ONU请求.在每次训练迭代中,本文使用50个不同的请求集,并对每个请求集并行运行10个蒙特卡洛模拟进行探索.更新策略网络参数的学习率被设置为0.001.

提出的灵活选择调制格式的DRL方案与四种固定调制格式的基准方案进行比较:(1) 随机Random算法,它随机选择请求;(2) 最短请求优先算法(SRF)[6],它按ONU请求的持续时间升序排列,(3) Packer算法[17],它根据工作需求和资源可用性之间的排列顺序分配资源;(4) Teris算法[17],综合了SRF算法和Packer算法的优势.这四个基准启发性算法采用固定的调制格式,该调制格式是满足ONU最大带宽需求的最小阶调制格式,以此来尽可能减少发射功率.

3.2 仿真结果分析

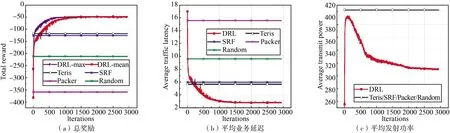

由于ONU的数据速率请求Rk∈[0.32,4.48]Gb/s,4种基准算法的固定调制格式被设置为16-QAM才能满足所有ONU的数据速率需求.图4比较了ONU请求到达率变化时的总奖励、业务延迟和发射功率.与Packer和Random算法相比,SRF算法在奖励和业务延迟方面均具有更好的性能.在低负载下,SRF性能类似于Packer算法.随着负载的增加,SRF和Packer算法之间的差异不断增加,SRF接近Teris.因为尽管Packer为大带宽需求的ONU保留的资源比SRF多,但大带宽需求的ONU却更多,这直接导致Packer的延迟性能最差.Teris结合了它们的优势,胜过SRF和Packer算法.如图4所示,在高负载条件下,DRL在这三个指标方面的表现要优于上述4种启发式算法.这是因为DRL学会了为不同带宽需求的ONU请求灵活分配调制格式的能力,以节省功率;并为将来的ONU请求保留一些资源,以降低ONU请求平均等待时间,因此总奖励也是最高的.

图4 ONU的数据速率请求Rk∈[0.32,4.48] Gb / s和α=β=0.5的测试结果

图5描述了当ONU请求到达率为1时,DRL代理如何学习训练迭代.在迭代开始时,DRL代理没有任何先验知识.DRL代理的行为类似于随机策略,并且行为比基准算法差.随着迭代的进行,DRLmax和DRLmean的值都随着DNN的连续训练而增加.经过约100次训练迭代后,DRL得知可以通过为一些小请求保留一些资源并使用更低阶的调制格式来增加总奖励,然后DRL继续尝试增加总奖励,直到经过1500次迭代后,DRLmax和DRLmean之间的差距越来越小并逐渐收敛到稳定值,这表明此时系统已达到最佳状态.图5(b)和(c)中的仿真结果表明,DRL方案实现了更好的ONU业务延迟,又尽可能地降低发射功率.值得一提的是,这四种基准启发性算法,不需要上述的迭代学习过程,但性能明显低于我们提出的基于DRL的DSA算法;同时,我们也看到,提出的DSA算法在迭代1500次之后就很快达到最佳状态,算法复杂度较低,收敛速度较快,所付出的时间成本在OFDMA-PON动态资源调度过程中可忽略不计.

图5 ONU的数据速率请求Rk∈[0.32,4.48] Gb/s和α=β=0.5的训练结果

4 结论

本文在OFDMA-PON中提出了一种基于DRL的新颖的三维DSA算法,联合配置了ONU请求的时隙TS,子载波SC和调制格式,该算法同时优化了ONU请求的平均延迟和平均功耗.从仿真结果可以看出,与SRF等四种基准调度算法相比,本文提出的基于DRL的DSA算法可以显着减少平均延迟和平均功耗,并且可以通过直接从经验自学策略中提高自身配置性能,是一种非常灵活的资源优化配置工具.