基于深度卷积神经网络的舰载机目标检测

2020-06-07朱兴动田少兵范加利陈化成

朱兴动,田少兵,黄 葵,范加利,王 正,陈化成

(1.海军航空大学岸防兵学院,山东烟台264001; 2.海军航空大学(青岛校区)舰面航空保障与场站管理系,山东青岛266041)

(∗通信作者电子邮箱745157824@qq.com)

0 引言

当前,计算机视觉技术发展迅速,图像目标检测已经广泛应用于军事国防领域。大力发展图像目标检测技术对于提升战斗力和人员装备安全有着至关重要的作用。现代航母是以舰载机为主要作战武器的大型水面舰艇,航母甲板面目标检测对于保障舰载机装备安全、提高飞机调运效率具有重要的意义。

传统的飞机目标检测算法主要有统计模式法、神经网络法、模板匹配法[1]等检测算法。这些算法大多提取原始图像中的特征组成特征向量,之后则利用适当的分类器进行检测和分类[2]。目前在图像识别领域中常用的特征提取算法有很多,如尺度不变特征转换(Scale-Invariant Feature Transform,SIFT)和梯度直方图(Histogram of Oriented Gradient,HOG)[3]。这类算法本质上是人工提取特征,主观干涉较多,提取过程较为复杂且精度难以提高,而且难以适应复杂多变的环境,泛化能力较差。

近些年来,深度学习在计算机视觉领域中迅速发展,基于深度卷积神经网络的目标检测得到了广泛的应用[4]。卷积神经网络因其参数共享、下采样、反向传播等处理方式,在目标检测方面的效果远超于传统的目标检测算法,在一定程度上保证了平移、旋转、尺度和光照不变性[5-6],而且能够对图像中的目标直接全面地获取特征,避免了人为的干扰,学习能力强、检测精度高。更快的区域卷积神经网络(Faster Region with Convolutional Neural Network,Faster R-CNN)[7-8]提出了区域建议网络(Region Proposal Network,RPN)取代了区域卷积神 经 网 络(Region with Convolutional Neural Network,RCNN)[9]、快 速 区 域 卷 积 神 经 网 络(Fast Region with Convolutional Neural Network,Fast R-CNN)[10]的选择性搜索算法,大幅降低了生成候选区域的时间开销,实现了真正意义上的端到端训练,识别精度高,使实时检测成为可能。文献[5]针对车辆检测应用中易受目标尺度和光照影响、泛化能力较差的问题,结合多尺度训练和难负样本挖掘策略对Faster RCNN算法进行改进,取得了良好的效果。文献[6]针对Faster R-CNN算法在小尺度坦克装甲车辆目标检测方面存在的问题,根据目标尺度不同在不同深度的卷积层上设置合理的滑动窗口,并提出选择性池化策略,改进后算法对多种尺度的坦克目标均取得了良好的检测效果。但是两者均未对遮挡目标检测进行改进,文献[8]针对遮挡目标检测效果差的问题,提出了局部标注和时空上下文策略,一定程度降低了遮挡对检测的影响。

目前,航母甲板面舰载机的状态主要有机翼折叠和展开两种。由于航母甲板面空间相对较小,舰载机之间通常遮挡区域较大,而大面积区域的遮挡常常造成飞机目标图像信息的严重损失,使得无法对目标进行准确的检测;且由于航母甲板面比较狭长,舰载机目标尺度差异容易对检测模型造成影响。对此,本文以Faster R-CNN算法为基础,提出排斥损失策略,即阻止候选区域平移到周围其他目标及其预测框,并结合多尺度训练策略,解决了较大部分遮挡的舰载机目标检测问题,对于光照和目标尺度的影响也具有良好的检测效果,提高了检测模型的鲁棒性,实现了对舰载机目标的准确检测。

1 Faster R-CNN基本原理

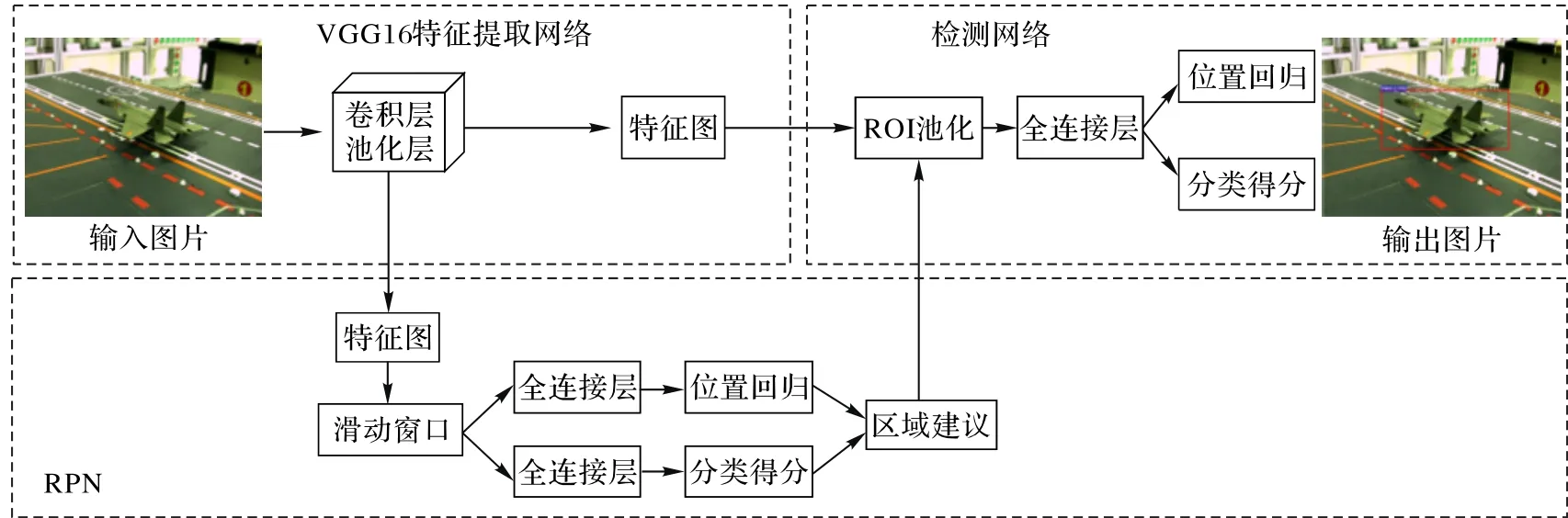

Faster R-CNN算法结构如图1所示,主要由特征提取网络、RPN和检测网络组成。特征提取网络采用VGG16网络结构,该网络输出的特征图由RPN网络和检测网络共享。

图1 Faster R-CNN算法结构Fig.1 Structureof Faster R-CNNalgorithm

1.1 特征提取网络

特征提取网络的主要作用是提取输入图像的深层卷积特征。VGG16网络由13个卷积层和4个池化层组成,卷积核大小均为3×3,池化核大小均为2×2,卷积层通过权值共享大大减少了网络的训练参数。通过对输入的图像多层卷积和池化,可以逐渐提取深层次的图像特征。该网络在最后一个卷积层输出图像特征,送入后续的网络进行目标的分类和回归。

1.2 RPN区域建议网络

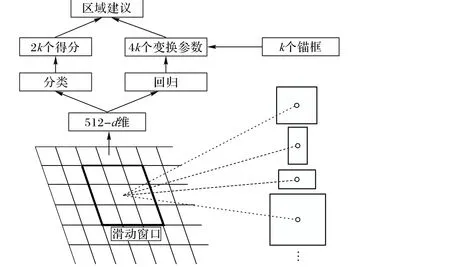

在VGG16网络最后一层卷积层之后添加一个3×3的卷积层和两个并行的全连接层来构建RPN。RPN的输入为原始图像所提取出的特征图,输出一系列的候选框及其是否为目标的得分。RPN结构示意图如图2所示。

RPN在卷积神经网络最后一个共享卷积层特征图上增加一个3×3滑动窗口,每个滑动窗口在原始图像上对应9个(本文中k=9)不同大小的锚框,尺度为128×128、256×256和512×512,比例为1∶1、1∶2和2∶1。滑动窗口在特征图上滑动时会映射成一个512维的特征向量,将该向量输入到后续两个并行的全连接网络中,一个使用softmax判定候选区域是目标还是背景,另一个计算该区域的坐标回归参数。因此一个全连接层输出2×9维向量,分别对应9个锚框目标和背景的得分,另一个全连接层输出4×9维向量,分别对应9个锚框相对于真实目标框的回归参数。

图2 RPN结构Fig.2 Structureof RPN

在训练RPN时,需要为每一个候选框都分配一个标签。本文分配标签的方法如下:

1)与某个目标真实区域有最大交并比(Intersection-over-Union,IoU)的候选框标记为正标签,这样可以保证每个真实区域至少对应一个正标签候选区域。

2)与任意目标真实区域IoU大于0.7的候选框标记为正标签。

3)与所有目标真实区域IoU小于0.3的候选框标记为负标签。

从得到的正负样本中随机抽取256个候选框组成一个小批量数据集用于模型训练,而且正负样本的比例为1∶1。若正样本不够,则随机补充一些负样本以满足256个候选框用于训练。

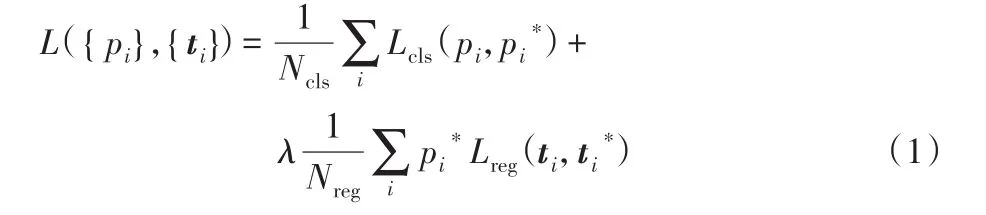

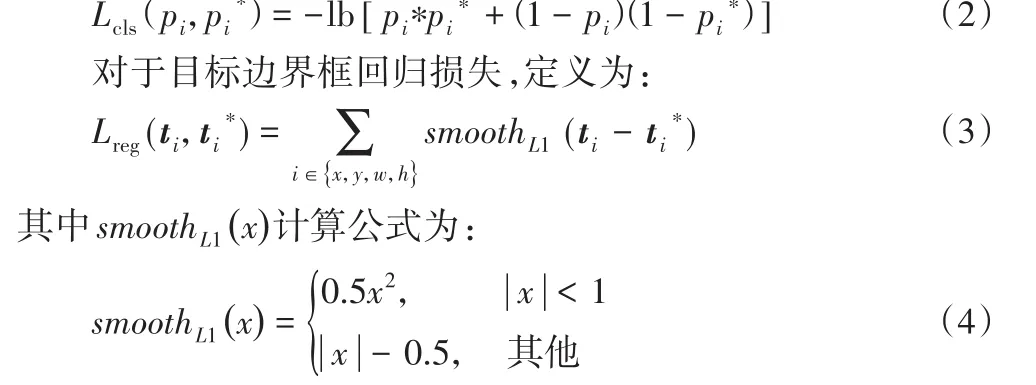

图像的损失函数定义为:

式中:i为第i个候选区域的索引,pi是第i个候选框是目标的概率。若候选框的标签为正样本,则pi∗为1,否则pi

∗为0。t i为预测目标边界框的4个坐标参数向量,t i*为对应的真实目标区域的4个坐标参数向量。分类损失Lcls是目标和非目标的对数损失,定义为:

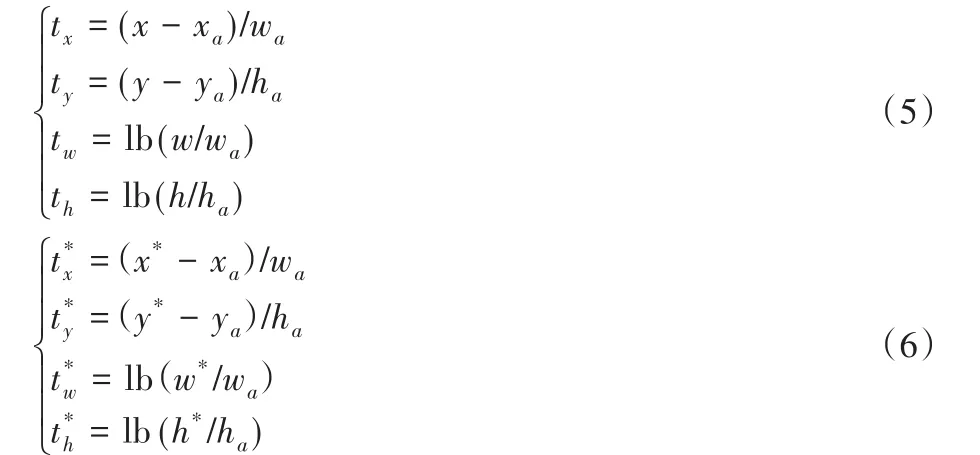

对于边界框,一般用4维向量(x,y,w,h)表示,用于目标边界框回归的4个坐标参数为:

其中:(x,y)表示预测的边界框的中心坐标,w和h为其宽和高;(xa,ya)为候选框的中心坐标,wa和ha为其宽和高;(x*,y*)为真实目标区域边界框的坐标,w*和h*为其宽和高。Ncls和Nreg为损失函数的归一化参数,实验中设置为256和2 400;λ用于平衡二者,实验中设置为10。

1.3 检测网络

检测网络由感兴趣区域(Regions Of Interest,ROI)池化层和两个并行的全连接网络构成。采用ROI的目的是将不同尺寸的候选框最后都统一到7×7的大小,实现了固定长度输出。输入全连接层的特征向量为7×7×512,分别输入分类层和回归层。分类层利用Softmax识别候选框的图像类别,回归层用于对候选框内的目标位置再次进行修正,综合分类层与回归层的输入可得到候选框区域更加准确的类别和位置信息,即最后的目标检测结果。

2 算法的改进

2.1 Faster R-CNN算法在舰载机目标检测中存在的问题

在实际应用场景中,由于航母甲板面空间狭小,甲板作业过程当中,各舰载机之间容易相互遮挡,当目标A与目标B重叠时,因为两架舰载机目标具有相似的外观特征,检测模型容易混淆。因此,A的预测框可能会转移到B,导致不准确的定位。而且在非极大值抑制(Non-Maximum Suppression,NMS)的过程中,可通过B的非极大值抑制来抑制来自目标A的候选区域边界框,使A变成漏检。而且,舰载机遮挡使检测模型对于NMS阈值比较敏感,较高的阈值会导致错误的检测,过低的阈值会引起漏检。

其次,由于航母甲板面狭长,远近舰载机目标尺度相差较大。原算法使用单一尺度对模型进行训练,存在部分较远目标漏检的情况。

2.2 排斥损失

针对Faster R-CNN在遮挡目标检测方面存在的问题,受磁铁吸引和排斥的特性启发,提出了排斥损失(Repulsion Loss,RepLoss)[11]。在排斥损失中,每个预测框不仅要求其接近其真实目标,而且要求远离其他目标的真实区域以及预测框[12],即RepLoss边界回归量由两个因素组成:目标的引力和其他周围目标的斥力。如图3中,当预测框平移到B是将会给予额外的惩罚,因此,RepLoss可以有效防止预测框移动到周围相邻的遮挡目标上,使得检测模型对遮挡目标更加鲁棒。

图3 排斥损失示意图Fig.3 Schematic diagram of repulsion loss

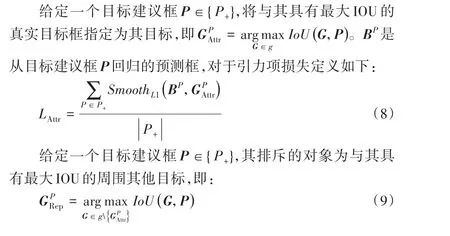

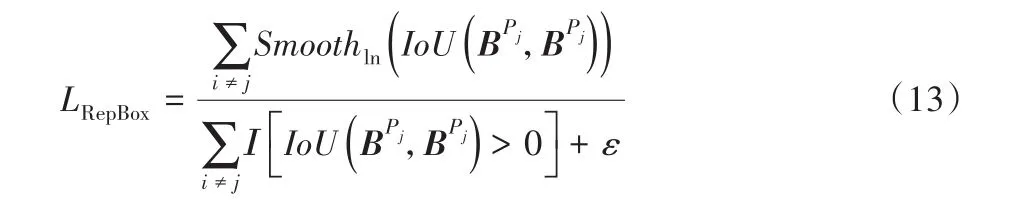

本文中定义排斥损失如下:

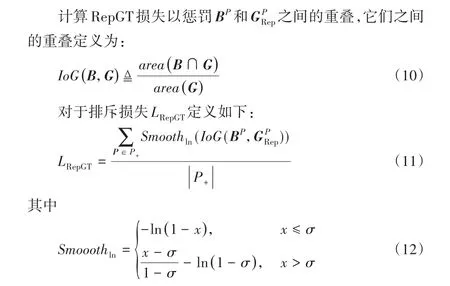

其中:LAttr是引力项,它要求预测框接近其真实目标;LRepGT和LRepBox是排斥项,分别要求预测框远离周围其他真实目标和其他目标的预测框;系数α和β作为平衡辅助损失的权重,实验中α和β和分别均设置为 0.5。设P=(l P,tP,wP,hP)和G=(l G,tG,wG,hG)为目标建议框和真实目标框,(l,t)代表它们左上角的坐标点,w和p分别为它们的宽度和高度。P+={P}是所有标签为正的目标建议框的集合,g={G}是一个图像中所有真实目标框的集合。是一个平滑的ln函数,σ∈[0,1)是调整排斥损失对异常值的敏感性的平滑参数,实验中设置为0.5。

NMS是大多数检测算法中必要的后续步骤,然而,NMS会对遮挡飞机目标检测结果产生显著影响。为了降低检测模型对NMS的敏感性,进一步提出了RepBox损失,其目的是排斥其他目标的目标建议框。根据每个目标的建议框,将建议集P+分为|g|个相互不相交的子集P+=P1∩P2∩…∩P|g|,然后对于从两个不同子集随机采样的两个建议框,其中期望其预测框B Pi和B Pj的重叠将尽可能小,其中i,j∈ 1,2,…,|g|并且i≠j。因此,计算RepBox损失为:

其中:Ι为判别函数;ε是一个很小的常数,防止除以0的情况。

则最终的损失函数定义为:

式中λ是用于平衡排斥损失与原Faster R-CNN模型损失的权重参数,取0.05。

2.3 多尺度训练

本文采用多尺度训练策略,原图像尺寸为1 024×768,将每张图片再增加两种尺寸,分别为600×600、800×800。每次训练迭代时随机选取每张图片三种尺度中的一种输入网络进行训练。训练出来的模型对目标尺度变化具有一定的鲁棒性。

3 实验分析

3.1 数据集

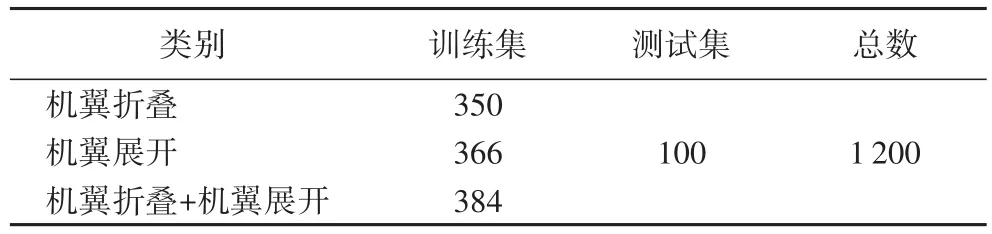

本文利用实验室条件采集了1 100张不同角度下航母甲板面舰载机的图像数据并将其转化为VOC2007数据集格式用于训练网络,每张图片中最多包含5架飞机,飞机的状态有两种:机翼折叠状态和机翼展开状态。此外还采集了100张不同程度遮挡和不同光照条件的图像用于测试本文改进后模型的有效性。数据集分配如表1所示。

3.2 实验环境

深度学习框架有很多,目前比较流行的有tensorflow、caffe、pytorch等。Tensorflow由于支持平台多,其张量从流图的一端流动到另一端计算过程更有利于模型的实现,具体实验环境如下所示:

硬件环境 CPU为Inter Core i7-9700,8 GB内存,GPU为GeFoece GTX 1660Ti。

软件环境 框架为Tensorflow,语言为Python,操作系统为Windows 10。

表1 实验数据集Tab.1 Experimental datasets

3.3 实验结果及分析

为了验证本文算法在解决遮挡问题时的有效性,引入召回率(recall)和准确率(precision)来评价改进模型的性能,precision反映的是被检测模型判定为正确目标中真正的正样本的比重,recall反映的是被检测模型正确判定为正确目标的正样本占总的正样本的比重。计算公式如下:

其中:TP(True Positive)表示检测正确的正样本;FN(False Negative)表示检测错误的负样本;FP(Flase Positive)表示检测错误的正样本。。

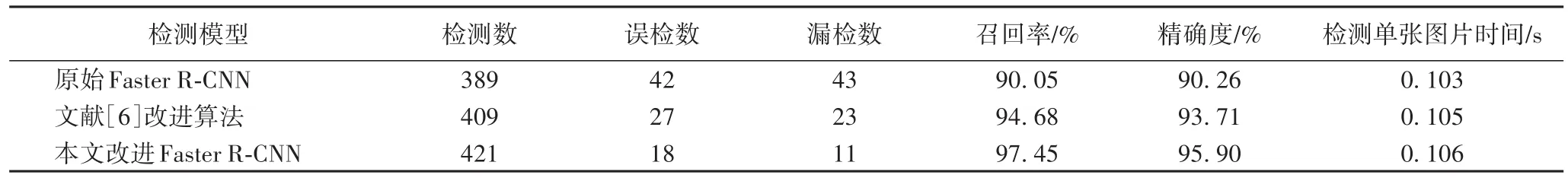

1)相同图片不同模型的检测性能对比。

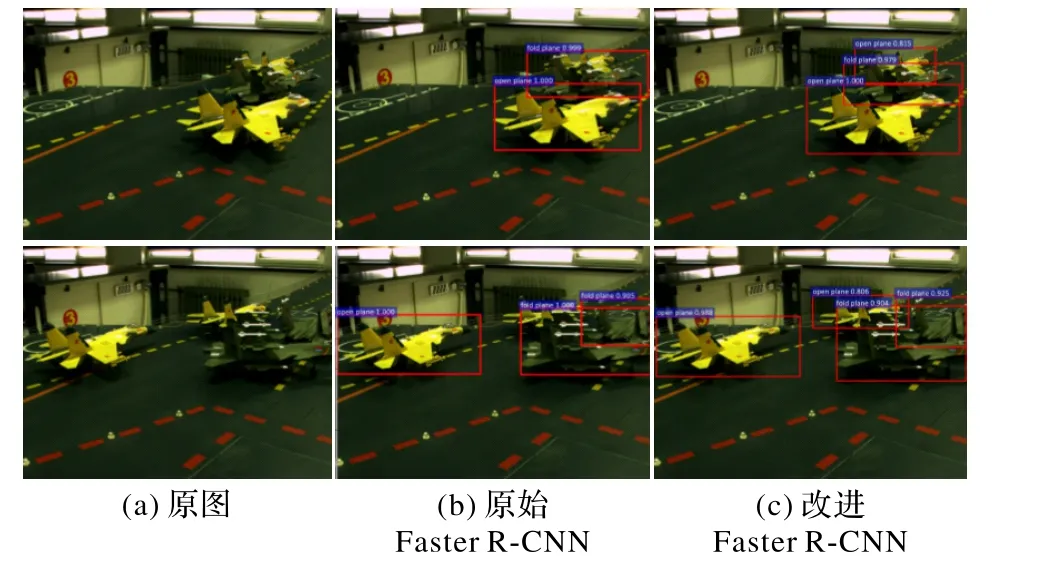

利用上述训练集分别用原始的Faster R-CNN模型、文献[6]中改进的Faster R-CNN算法和本文改进的Faster R-CNN模型进行训练,并对训练的模型使用100张测试集图片(总共包含432个飞机目标)进行检测性能测试,不同检测模型的性能参数如表2所示,检测效果如图4所示。

图4 两种模型检测效果与原图对比Fig.4 Comparison between thedetection resultsof twomodelsand the original images

表2 相同图片不同模型的检测性能Tab.2 Detection performanceof different models for thesamepicture

图4(b)和(c)分别为原始Faster R-CNN模型与本文提出的改进模型检测效果,结合表2与图4可以得出本文所提模型在精确率和召回率方面均高于原始FasterR-CNN模型和文献[6]中的改进模型,对遮挡程度比较大的舰载机目标也具有良好的检测效果。相对于原始Faster R-CNN模型,本文提出的改进模型召回率提升了约7个百分点,精确率提高了约6个百分点;相对于文献[6]中改进算法召回率提升了约3个百分点,精确率约提高了2个百分点,检测速度也满足了实时性要求。

2)不同光照下改进Faster R-CNN检测效果。

从上述100张测试集检测结果中选取不同光照条件的图片进行对比,检测结果如图5所示。图5(a)为光照较强的检测效果,图5(b)为光照较弱的检测效果,可以看出,对于不同光照条件,改进后模型都能够有效检测出舰载机目标,鲁棒性较高。

4 结语

本文针对航母甲板面遮挡舰载机目标检测难度大、且检测模型易受光照和目标尺度影响的问题,在原始Faster RCNN检测模型损失函数中加入了排斥损失策略进行改进,并结合多尺度训练策略,较好地解决了遮挡目标的检测问题,且对不同的光照条件和目标尺度均具有良好的检测效果,模型的鲁棒性较高,检测准确率和实时性能够满足实际需要。

由于目前缺乏大型的航母甲板面舰载机图像数据集,导致本文中用于训练的图像数据较少,如何利用小样本数据集对网络进行高效的训练,今后仍需研究,且本文提出的模型对硬件要求较高,如何在保证达到实际需要的前提下降低硬件平台要求,也是一个值得研究的问题。